【腾讯云HAI域探秘】体验半小时在HAI上跑起Segment Anything

原创【腾讯云HAI域探秘】体验半小时在HAI上跑起Segment Anything

原创今年是人工智能发展的大年,各种先进的模型层出不穷。从年前的Chatgpt,4月份的Segment Anything,到最近的多模态AI大模型Gemini。作为一个人工智能的小白,当然想尝试体验一下模型的魅力。找一块GPU或者从云上找资源,然后就是找合适的镜像,给系统apt各种补丁,安装合适python版本,安装pytorch框架,pip各种包,git源代码,download模型,一套组合拳下来,费工、费时、费钱不说,还经常被各种底层固件、驱动的版本,操作的权限问题,软件版本兼容问题,莫名其妙的环境报错,龟速的下载速度劝退。即使撑到了最后,体验大模型的激情早已不在了。每当这个时候,深深体会到GPU不等于算力,在GPU和AI之间还需要一个桥梁,让开发者能够集中精力在自己关心的事情上,而不是首先要成为一个环境搭建高手。碰巧腾讯云和CSDN联合推出“腾讯云高性能应用服务 HAI 新品先锋体验官”活动,打动我的是:HAI要在GPU和AI之间架起一座桥梁。

一、腾讯云高性能应用服务HAI

首先HAI被定义为腾讯云高性能应用服务,这个理念就比提供云算力服务器的更为先进。HAI不仅仅是提供GPU算力,还会在AI开发全流程中,为开发者和用户提供优质服务,让开发者集中注意力在模型、算法、应用上面,而不用过多的去关心环境问题。

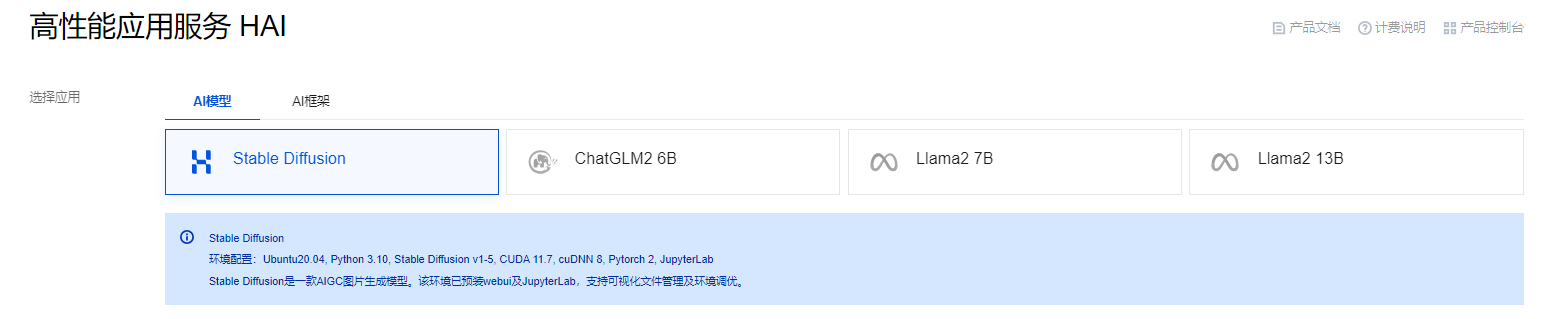

“体验活动”提供了在HAI上构建StableDiffusion、ChatGLM等热门模型的应用环境,以及构建好的Pytorch环境,完成训练和推理的例程。为了更好地测试HAI,笔者想体验下其他的模型案例。于是想起4月份想搭建Segment Anything,最终被劝退的经历,于是想在HAI上把它跑起来。

二、在HAI上跑起Segment Anything

“打开冰箱门、把大象放进去、关上冰箱门”。按照HAI的设想,完成这件事情也只需要三步:申请HAI资源、下载源代码和模型并执行、销毁资源☺。

正式操作之前,先查找下相关资料,https://gitee.com/mirrors/segment-anything。

根据ReadMe的介绍,需要做的工作有:拿源码、安装依赖、下载预训练好的模型、运行demo。指令,下载地址也都很齐全,开干。

一)申请HAI资源

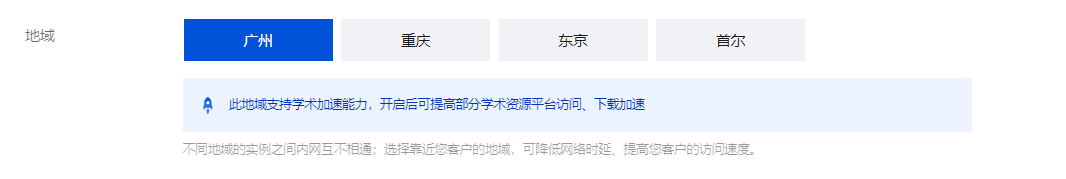

因为Segment Anything是基于pytorch的,且需要git源代码和下载模型。所以选择HAL如下,应用选择:AI框架Pytorch2.0.0;地域:东京(尽管可能操作的响应会慢一点,但下载速度有保证);算力方案选择基础性(先尝试一下,不行再上进阶型),其余的按默认选型。然后点“立即购买”按钮,等待几分钟完成环境的创建。

二)下载源代码和模型并执行

这个过程因为HAI,变得简单、丝滑。

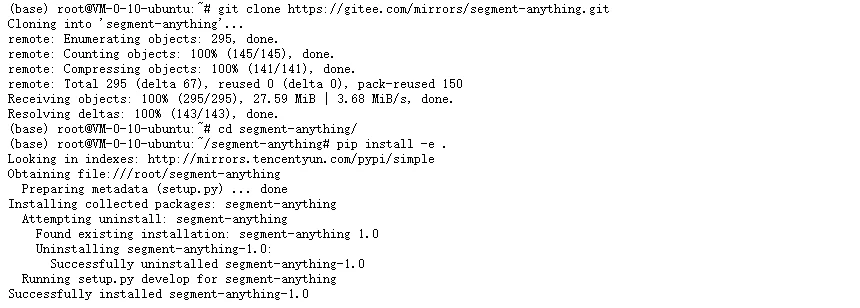

1、下载segment-anything

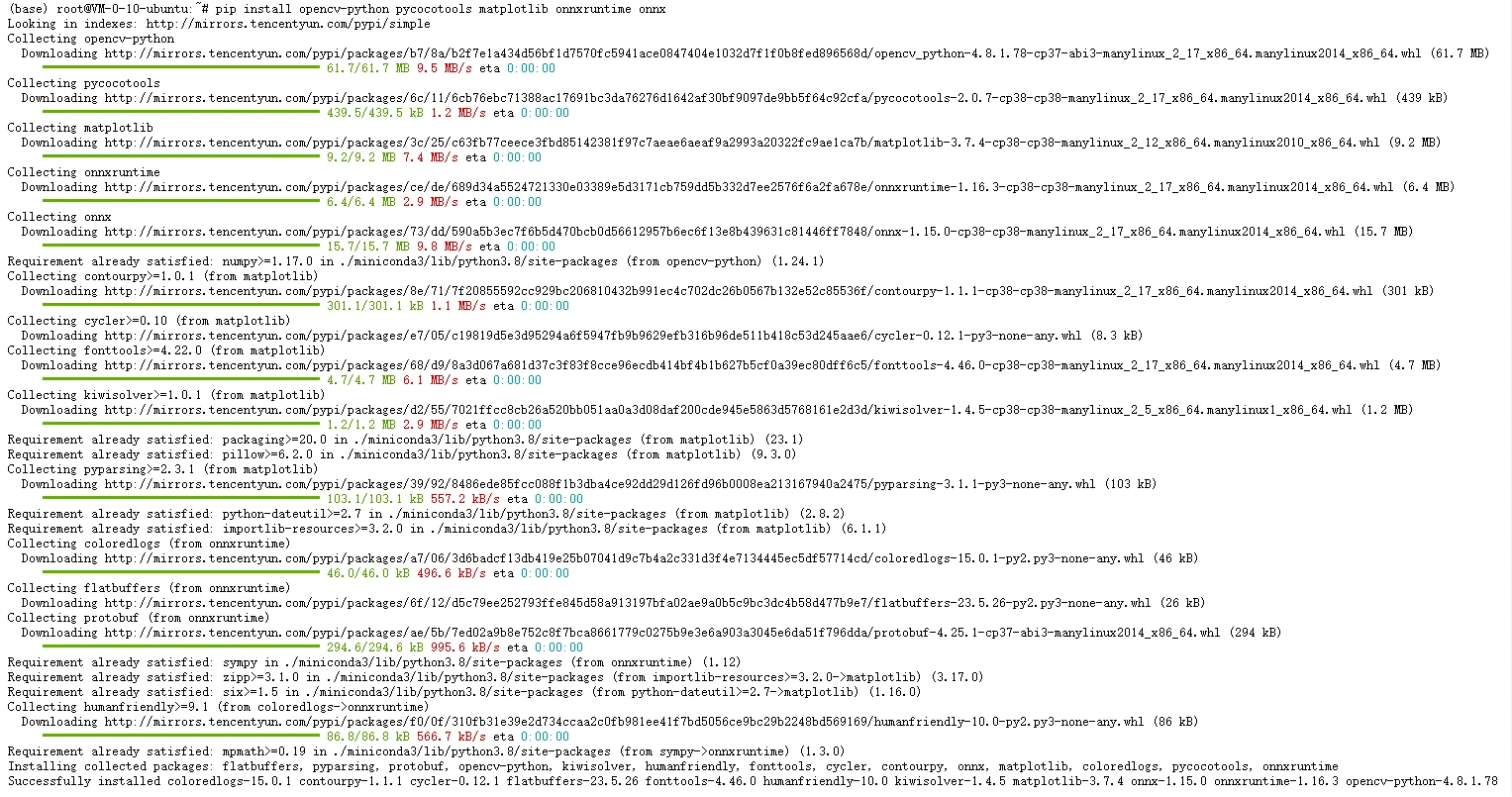

2、安装依赖

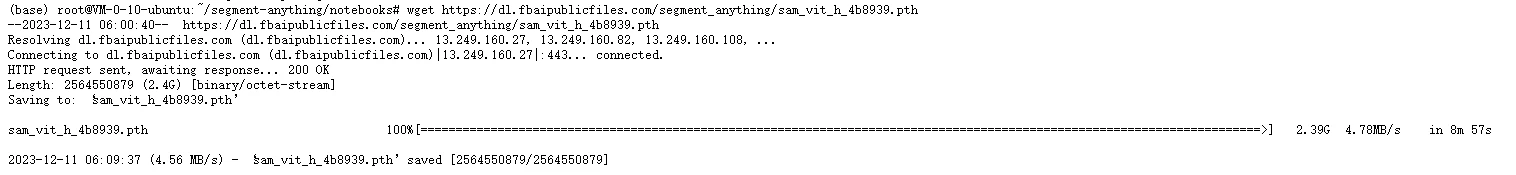

3、下载模型

4、运行例程

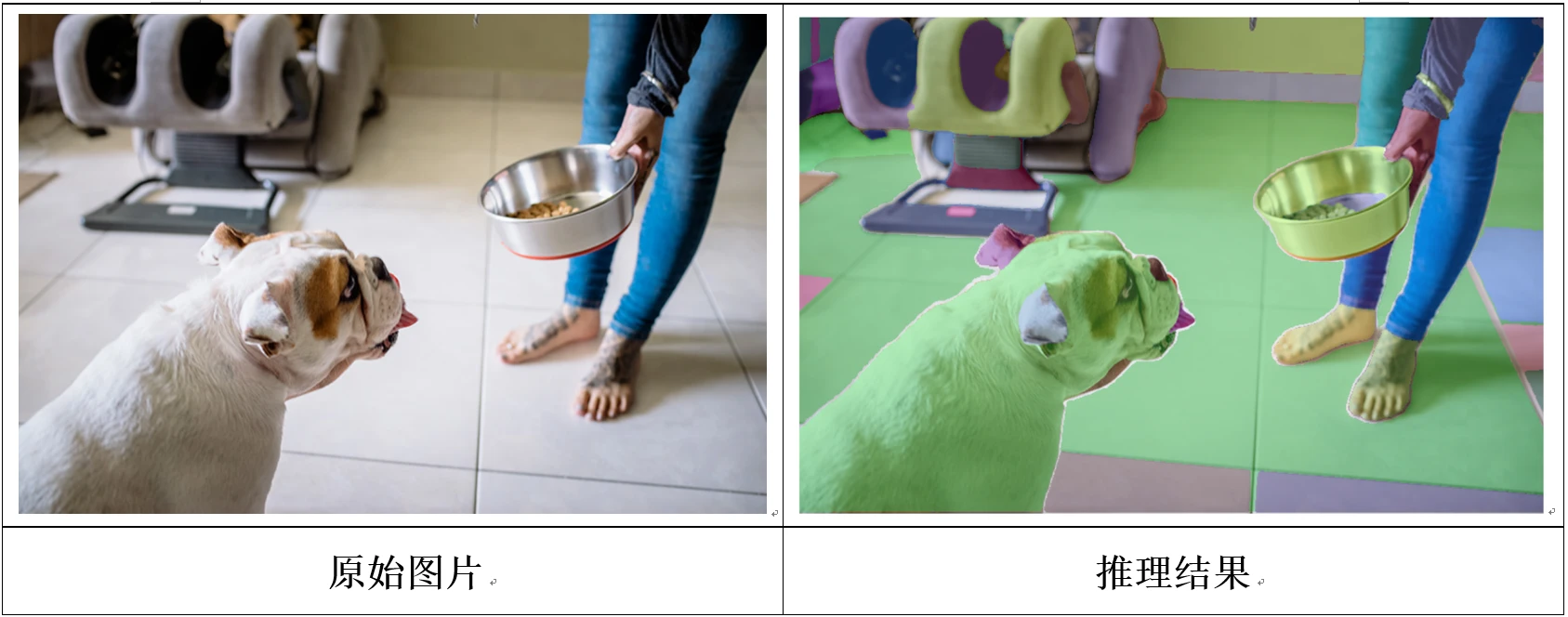

运行notebooks目录下的“automatic_mask_generator_example.ipynb”,

5、运行结果:

三)销毁资源

销毁资源很简单, 就不赘述了。

三、体会

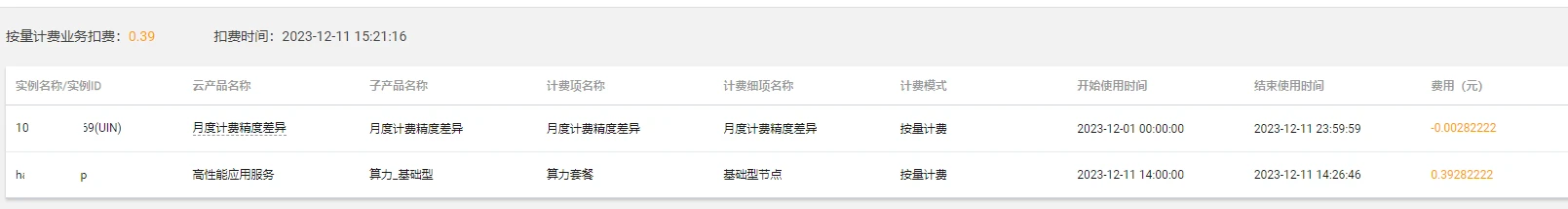

这可能是学习AI以来,最顺畅的一次体验了,完成上述工作,实际耗时26分钟,花费0.39元。

半个小时不到就把demo顺利的跑起来了,节省了大量的时间和精力,这样就可以把注意力集中到代码学习、参数调整、业务应用开发等事情上了。

尽管前期体验HAI自带例程时,遇到过速度慢,界面显示,链接失效等问题,但基本上都可以在一个合理的时间完成实验。

HAI还是个AI新生,但短短2个月时间,已经完善了很多功能,取得了长足的进步。提供了更多的大模型、并对大模型的运行效率进行了优化;增加了更多的算力、特别是海外算力,让下载模型更顺畅;实例的开、关机,保留镜像功能;学术加速功能,还有更多的功能开发中,相信HAI的未来会更好。

1、HAI目前提供多种大模型

HAL还对大模型再部署和运行的效率做了优化,切实践行给客户赋能。

2、开通算力的地区在增多,还上线了学术加速功能

四、建议

一)大模型是现在的趋势,HAI需要发挥自己的优势,持续做工作,以便开发者能更简便、更高效的基于大模型开发自己应用,并能快速部署,和持续改进。

二)提供更多、更好用的算力资源

1、提供更多的种类的GPU算力,并增加算力的资源数,并进行合理的地域性布局,方便开发者使用。

2、保持GPU卡固件、驱动、操作系统、软件包的版本尽量新,并做好适配性验证,减少开发者版本、环境的问题。

3、除了pytorch、tensorflow外,支持更多的AI框架,特别是国产框架。

三)做好AI全流程服务

1、建立自己的模型仓库、数据集仓库,并在各地算力中心建立备份,以提高访问资源的速度。

2、提供镜像定制功能,让用户或开发者能够定制自己的镜像。

3、完善工具链,给AI全流程提供工具,比如增加标注工具等。

4、开发流水线workflow工具,流水线覆盖数据标注、数据处理、模型开发/训练、模型评估、应用开发、应用评估等AI全流程。帮助开发者基于实际业务场景开发和部署AI应用。

5、和腾讯已有的存储等云服务结合起来,给开发者和用户带来更多更优质的服务。

四)建设好社区,吸引更多的小伙伴去了解HAI、体验HAI、使用HAI。同时也将开发者将自己的需求、体验、取得的成果,分项到社区,回馈社区。开展更多的社区活动,给开发者提供免费的代金券,举办大模型部署优化、AI应用等方面比赛,或者为AI比赛打榜提供算力支持。

原创声明:本文系作者授权腾讯云开发者社区发表,未经许可,不得转载。

如有侵权,请联系 cloudcommunity@tencent.com 删除。

原创声明:本文系作者授权腾讯云开发者社区发表,未经许可,不得转载。

如有侵权,请联系 cloudcommunity@tencent.com 删除。