[Nature Communications | 论文简读] 用于人工神经网络持续学习的大脑启发回放

[Nature Communications | 论文简读] 用于人工神经网络持续学习的大脑启发回放

智能生信

发布于 2022-12-29 17:41:26

发布于 2022-12-29 17:41:26

简读分享 | 乔剑博 编辑 | 李仲深

论文题目

Brain-inspired replay for continual learning with artificial neural networks

论文摘要

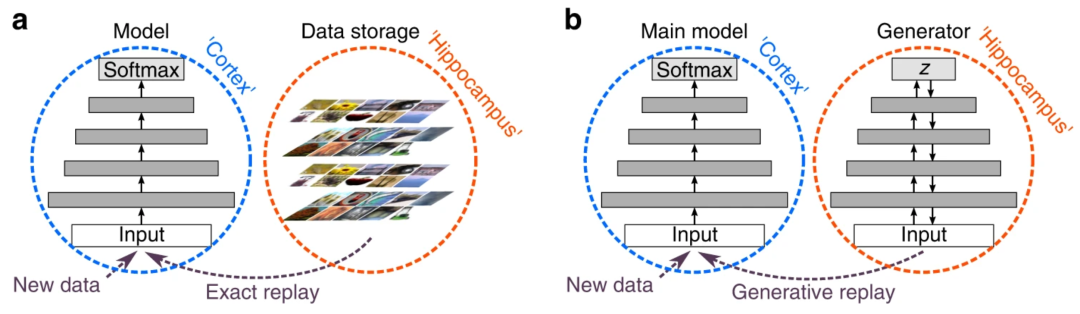

人工神经网络遭受灾难性遗忘。与人类不同,当这些网络接受新事物的训练时,它们会迅速忘记之前学到的东西。在大脑中,一种被认为对保护记忆很重要的机制是代表这些记忆的神经元活动模式的重新激活。在人工神经网络中,这种记忆重放可以实现为“生成重放”,即使在类增量学习场景中,它也可以成功地——而且出人意料地有效地——防止对toy示例的灾难性遗忘。然而,将生成重放扩展到具有许多任务或复杂输入的复杂问题是一项挑战。作者提出了一种新的、受大脑启发的回放变体,其中回放由网络自身生成的内部或隐藏表示,上下文调制的反馈连接。作者的方法在不存储数据的情况下在具有挑战性的持续学习基准(例如,CIFAR-100 上的类增量学习)上实现了最先进的性能,并且它提供了一种在大脑中重播的新模型。

论文链接

https://www.nature.com/articles/s41467-020-17866-2

本文参与 腾讯云自媒体同步曝光计划,分享自微信公众号。

原始发表:2022-12-26,如有侵权请联系 cloudcommunity@tencent.com 删除

评论

登录后参与评论

推荐阅读