Anchor Free的孪生目标跟踪

- 以DCF和SiamFC为主的跟踪器,构建多尺度金字塔,将搜索区域缩放到多个比例,选择最高得分对应的尺度,这种方式是最不精确的同时先验的固定长宽比不适合现实任务;

- 以ATOM为主的跟踪器,借鉴IOUNet,通过IOU的梯度迭代来细化box,提升精度的同时带来了较多的超参数以及时间上的消耗;

- 以SiamRPN为主的追踪器,通过RPN预设anchor来回归框,这类方法虽然很高效,但是anchor的设定不但会引入模糊的相似性得分,而且anchor的设置需要有大量的数据分布先验信息,与通用跟踪的目的不符合。

本文主要记录用Anchor Free的思想来解决上述目标跟踪状态估计中存在的问题。目前比较主流的都是基于FCOS和CenterNet两种无锚框方式展开的。

1.FCOS类

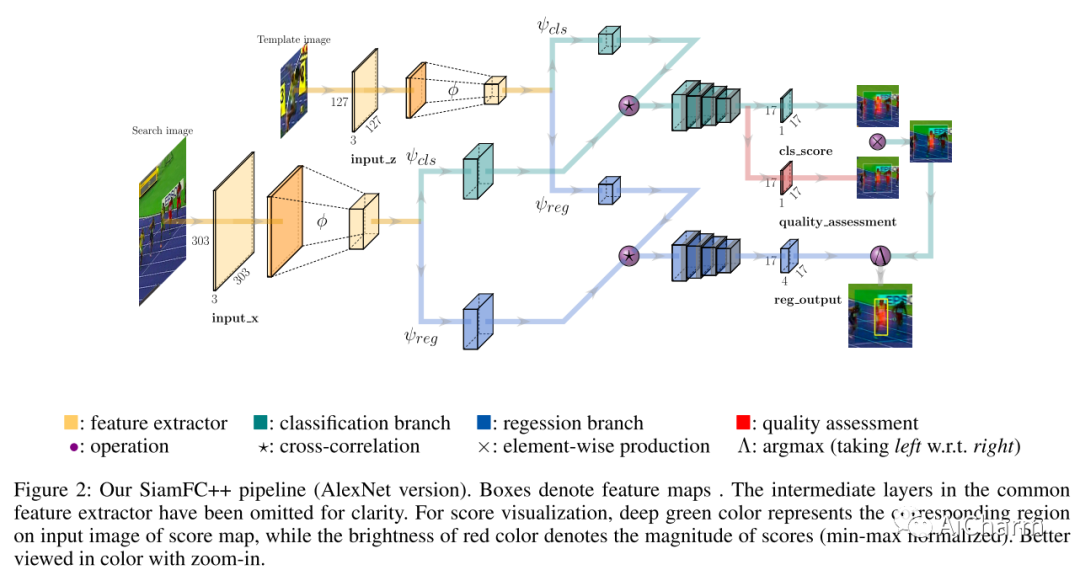

SiamFC++: Towards Robust and Accurate Visual

Tracking with Target Estimation Guidelines

针对siam网络分析了之前的工作不合理的地方,提出了4条guidelines:

G1:decomposition of classification and state estimation:跟踪任务可以分解为分类与状态估计。分类影响鲁棒性,状态估计影响精确性。多尺度金字塔的方式忽略了状态估计所以精确性很低;

G2:non-ambiguous scoring:分类得分应该直接表示为目标在视野中存在的置信度分数,而不是像预定义的anchor那样匹配anchor和目标,这样容易产False positive;

G3:prior knowledge-free:跟踪器不应该依赖过多的先验知识(如尺度/长宽比)。现有的方法普遍存在对数据分布先验知识的依赖,阻碍了其泛化能力;

G4:estimation quality assessment:不能直接使用分类置信度来评价状态估计,需要使用独立于分类的质量评估方式。(如RPN系列直接就是选择分类置信度最高的位置进行边框预测,而ATOM,DIMP则另外加入了IOU信息来指导边框调整)

作者依据这4条guidelines设计了SiamFC++,将目标检测中的Anchor Free的FCOS应用到Siamese框架中,整体结构如下,细节部分可以去开头我在b站的专栏。

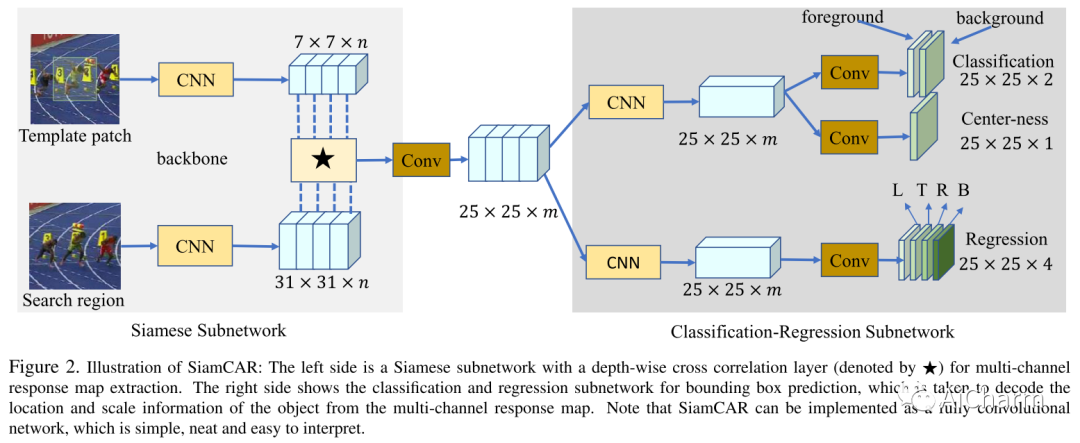

SiamCAR: Siamese Fully Convolutional Classification and Regression for Visual Tracking

这一篇和SiamFC++很类似,这里仅标注一些实践细节的差异。

- backbone采用了改造的resnet50;

- multi-stage融合对相关结果拼接用1*1卷积降维/融合,而不是像siamrpn++那样对相关后的分类预测响应图加权相加;

- 分类和回归均由一个相关引出,而不是每个分支对应一个相关。这样计算量更小效率更高,而性能差不多;

- inference阶段为了避免抖动取了中心点周围top-k的均值作为最终结果。

细节同样参照开头b站专栏。

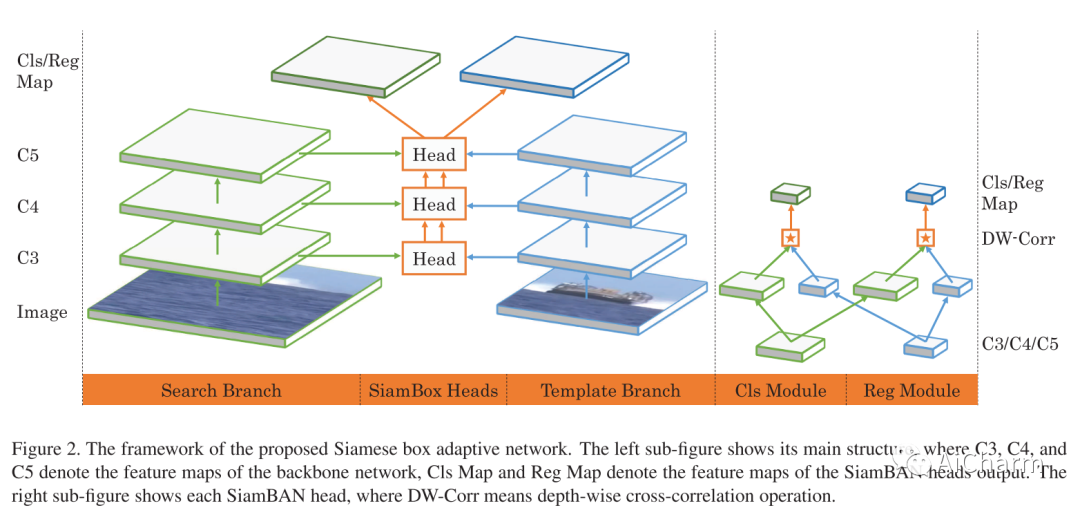

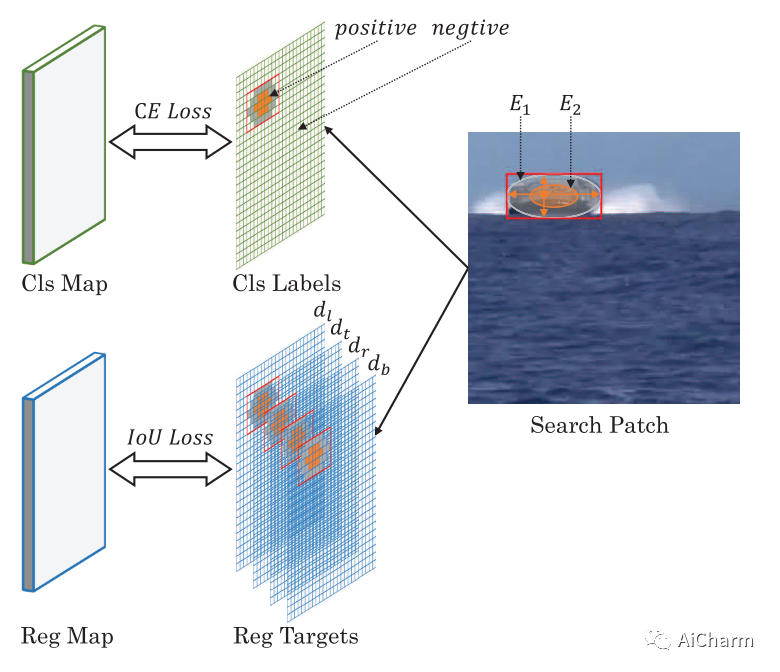

Siamese Box Adaptive Network for Visual Tracking

同样是FCOS的应用,比较insight的地方是打标签的时候使用椭圆标签,两个椭圆,小椭圆E2内的点是positive,大椭圆E1外的点是negative,两个椭圆中间的部分为ignore。椭圆标签能够更紧凑地标注正负样本,并且设置了缓冲(ignore)以忽略模棱两可的样本。

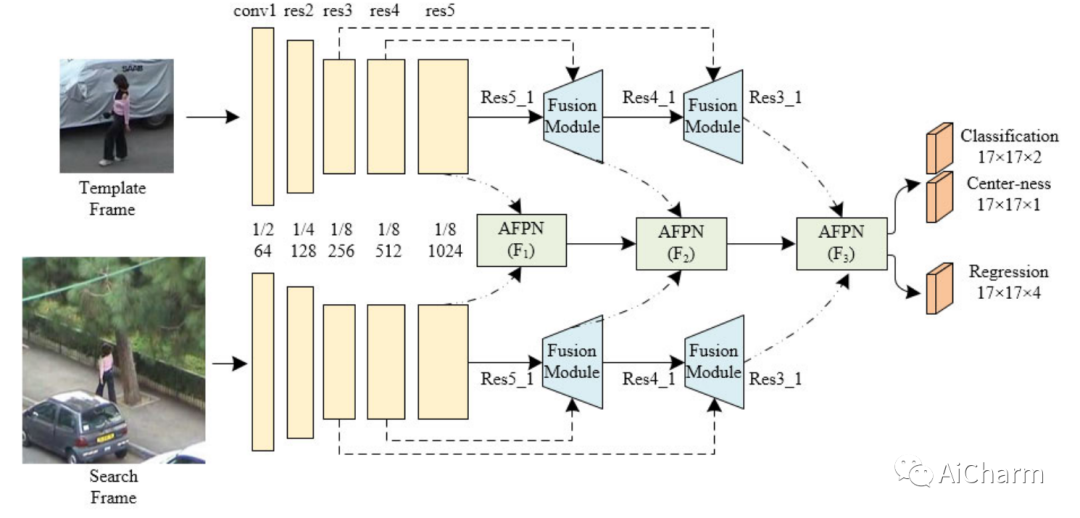

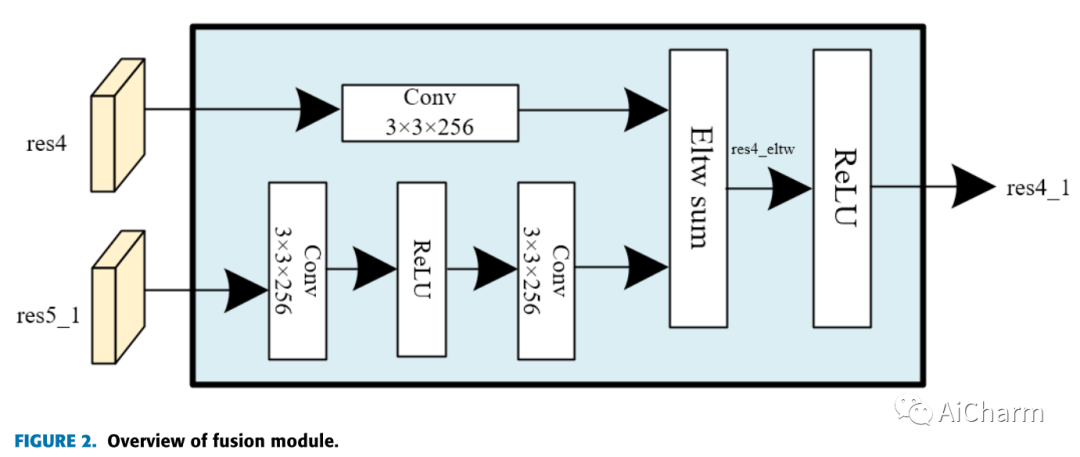

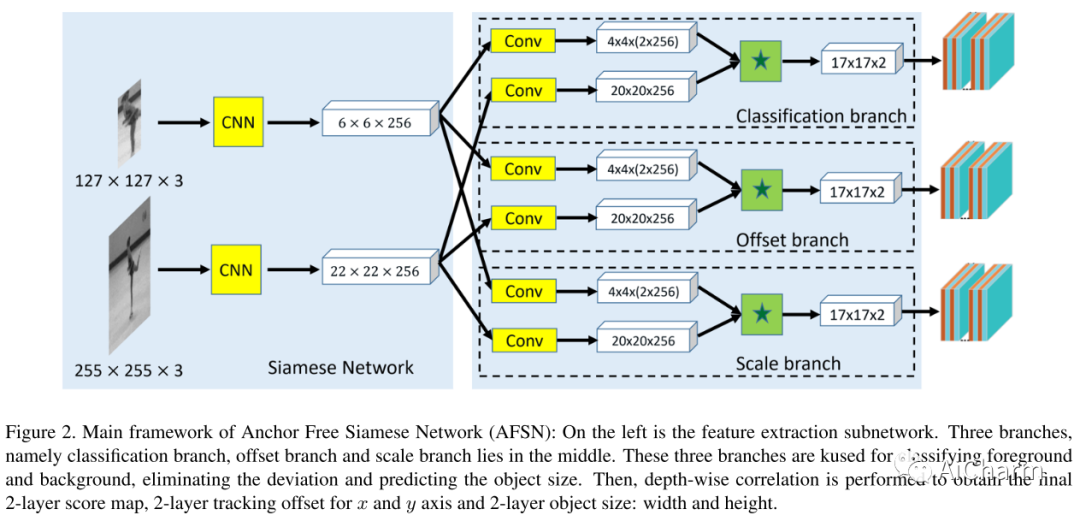

Fully Conventional Anchor-Free Siamese Networks

for Object Tracking

将FCOS与级联结构结合,另一个就是分配GT到AFPN层时采用了FCOS一样的思路(划分[0,64], [64,128], [128,∞])

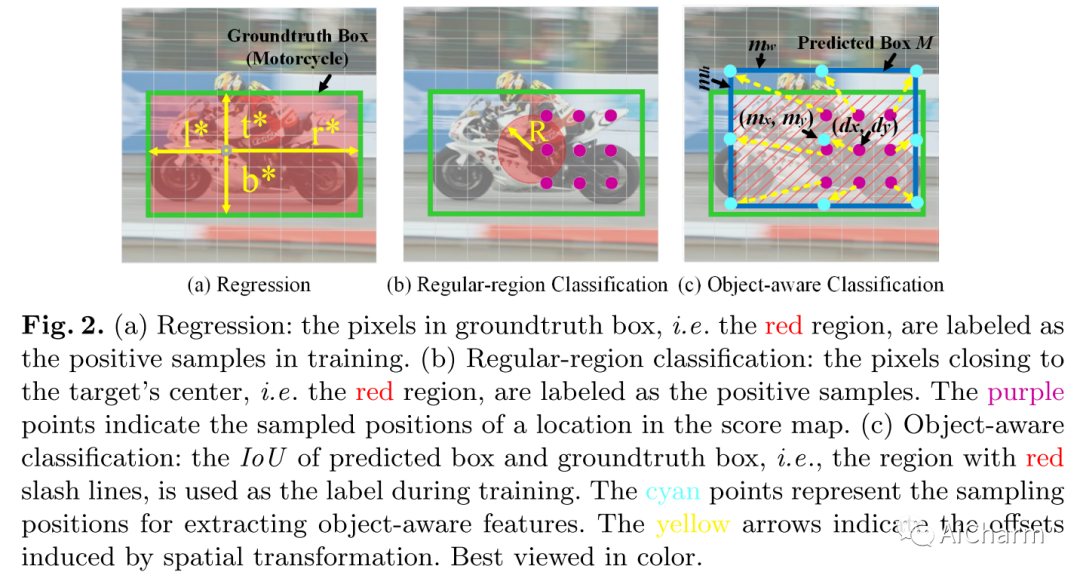

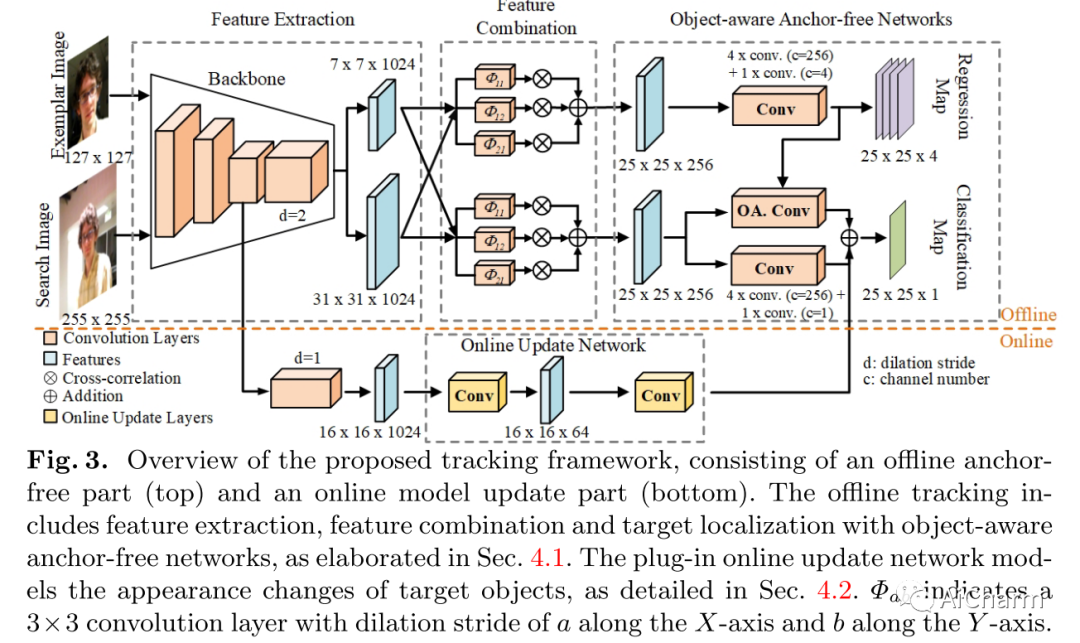

Ocean: Object-aware Anchor-free Tracking

- anchor-base方法对于弱预测的修正能力较差,因为训练时只考虑了IOU大于阈值的anchor的回归,对于跟踪过程中如果出现overlap很小的anchor很难去refine。而anchor-free可以针对每个点进行预测;

- 作者设计了一个feature alignment module来从预测框中学习object-aware feature(图2c),从而对物体尺度敏感;

- 特征融合上采用xy轴膨胀系数不同的膨胀卷积进行融合,不同膨胀的卷积可以捕获不同尺度的特征,提高最终融合特征的尺度不变性。

CenterNet类

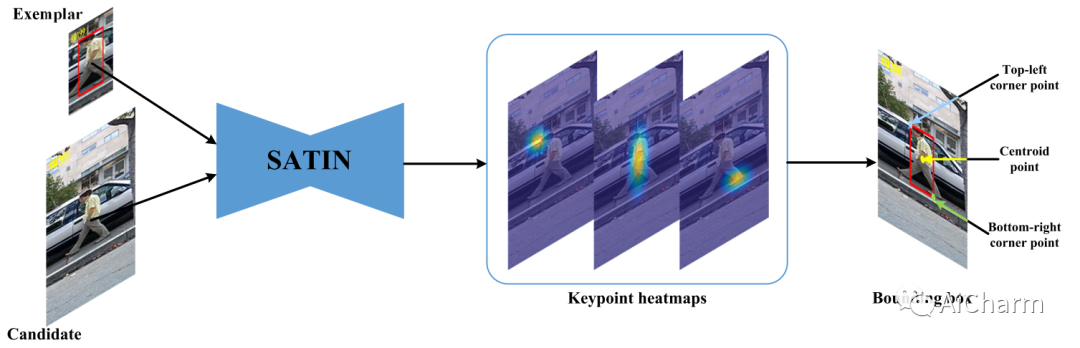

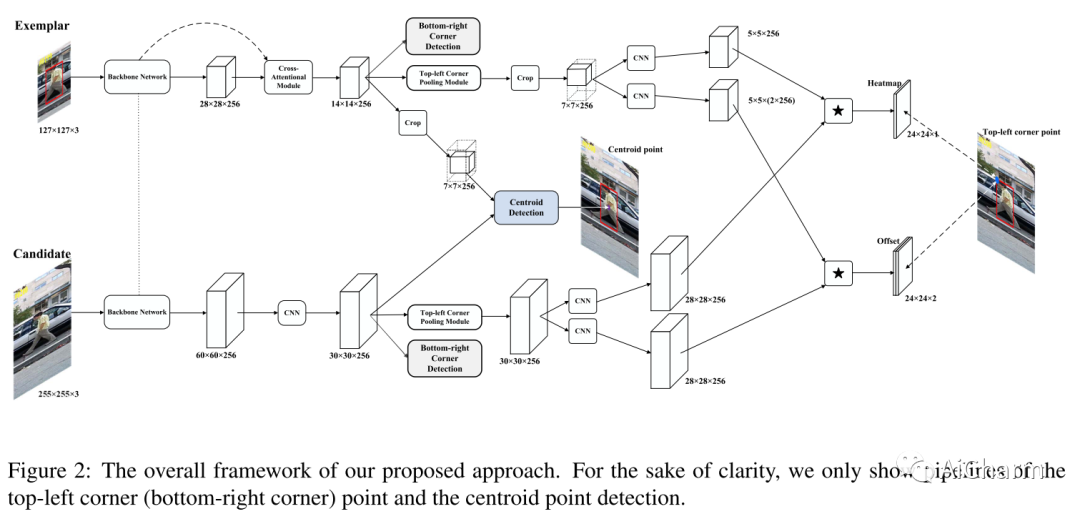

Siamese Attentional Keypoint Network for High

Performance Visual Tracking

这篇将CenterNet和CornerNet结合到跟踪中,分别预测中心点和两个角点,以及运用了CBAM注意力机制强化上下文信息,应该是第一个将CenterNet/CornerNet用进来的,遗憾的是性能没有刷的很高。细节同样参照开头b站专栏。

Accurate Anchor Free Tracking

这篇就是比较典型的CenterNet模式了,预测中心点,中心偏移以及宽高。

作者另外设计了backbone,最后在VOT2018性能虽然比siamrpn++略低但是速度是它的3.9倍(136FPS v.s. 35FPS)。

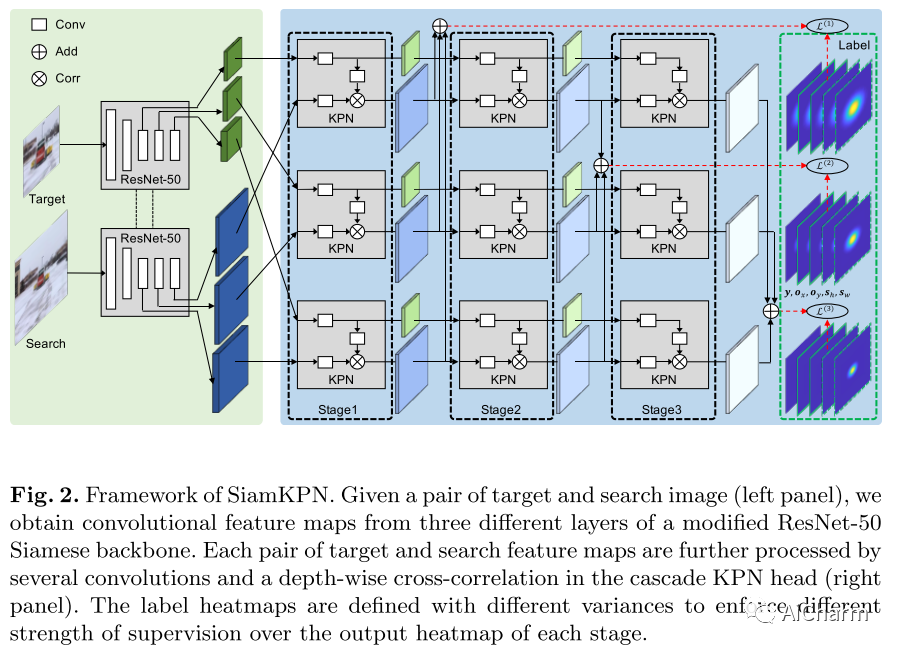

Siamese Keypoint Prediction Network for Visual

Object Tracking

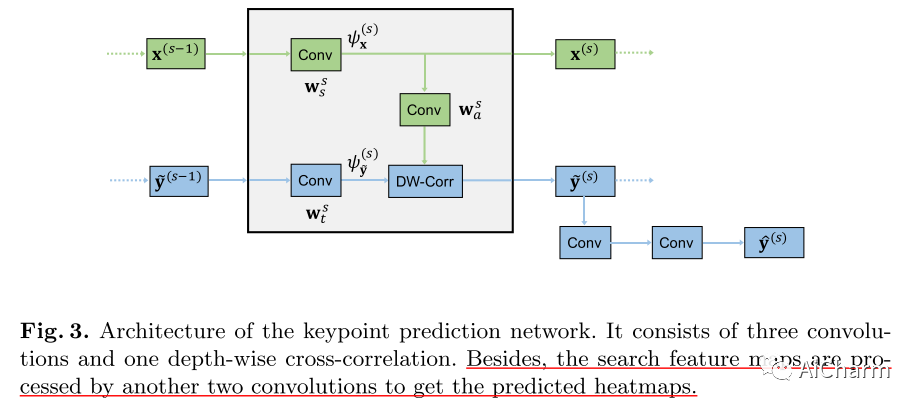

这一篇将casscade的思想结合在centernet类的siamese跟踪器中,看上面图2结构已经很清晰了,KPN结构如下:

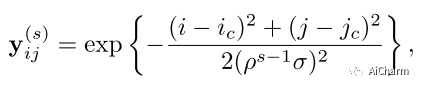

还有一个需要关注的就是每个stage训练的时候分类标签的高斯方差不一样,遵循的原则就是越高的stage峰值越收束。目的即随着级联的进行,监管信号越来越严格。

3.其他

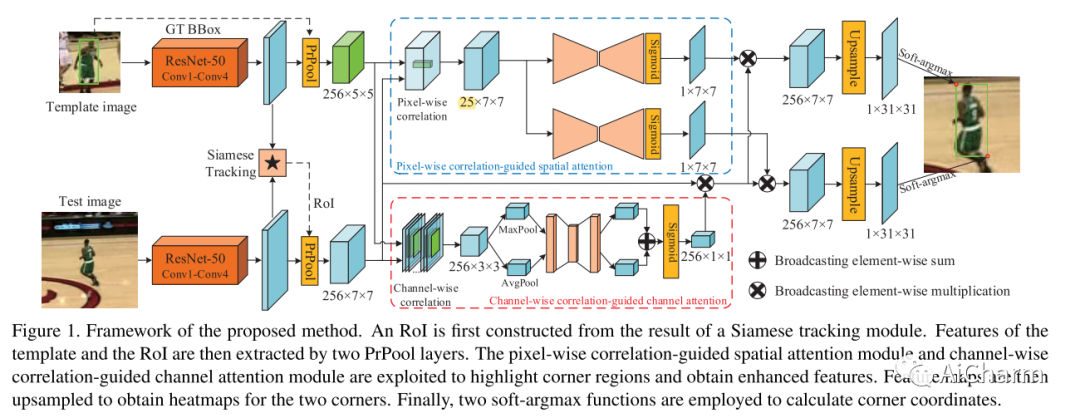

Correlation-Guided Attention for Corner Detection

Based Visual Tracking

作者为了解决跟踪中回归框估计不准确的问题,引入角点检测来得到更紧致的回归框。分析了之前一些角点检测方法在目标跟踪中无法取得好性能的原因,并提出了两阶段的correlation-guided attentional corner detection (CGACD)方法。第一阶段使用siamese网络得到目标区域的粗略ROI,第二阶段通过空间和通道两个correlation-guided attention来探索模板和ROI之间的关系,突出角点区域进行检测。速度可以达到70FPS。

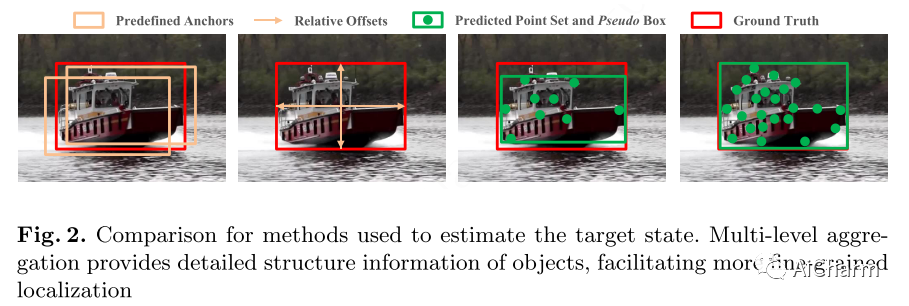

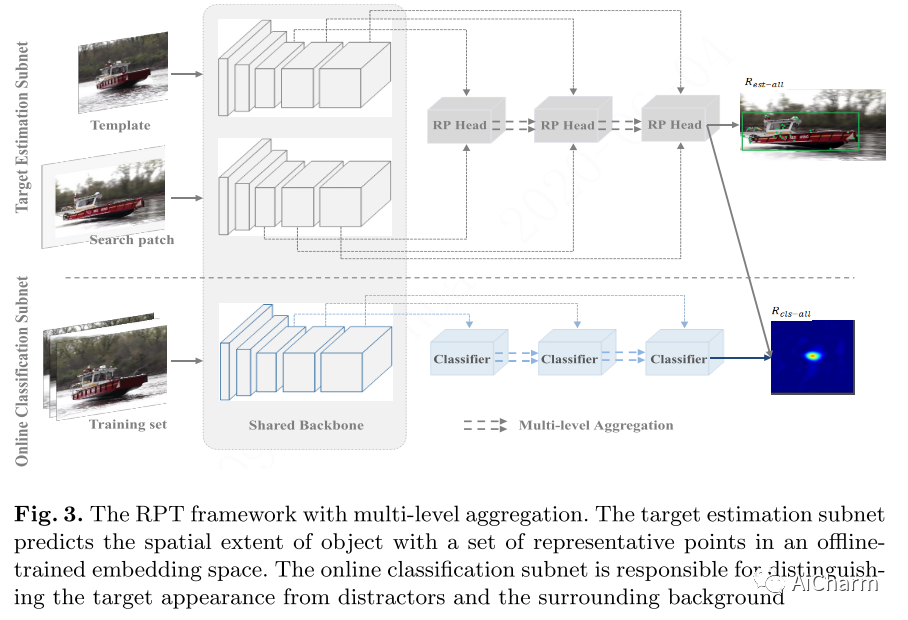

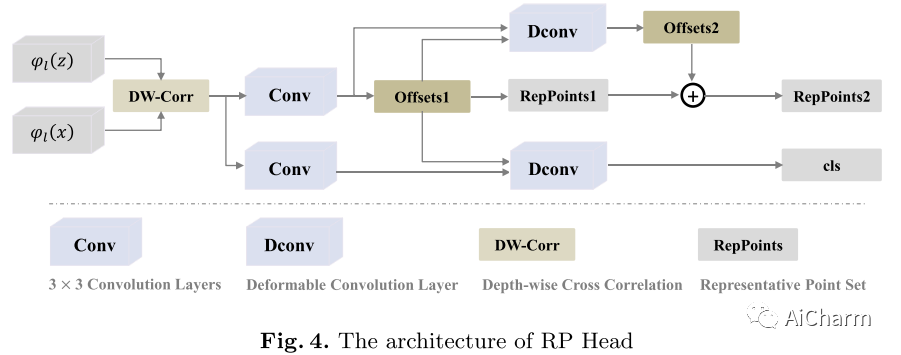

RPT: Learning Point Set Representation for

Siamese Visual Tracking

现有的跟踪方法往往采用矩形框或四边形来表示目标的状态(位置和大小),这种方式忽略了目标自身会变化的特点(形变、姿态变化),因此作者受启发自Reppoints检测方法,采用表示点(Representative Points)方法来描述目标的外观特征,学习表示点的特征,根据表示点的分布确定目标的状态,实现更精确的目标状态估计。

具体可以参考原作者在知乎的解读,该方法取得了VOT2020-ST的冠军。

本文参与 腾讯云自媒体同步曝光计划,分享自微信公众号。

原始发表:2023-03-08,如有侵权请联系 cloudcommunity@tencent.com 删除

评论

登录后参与评论

推荐阅读