多加一倍GPU,大模型训练时间能省一半吗?

这是鹅最近被问到最多的问题。

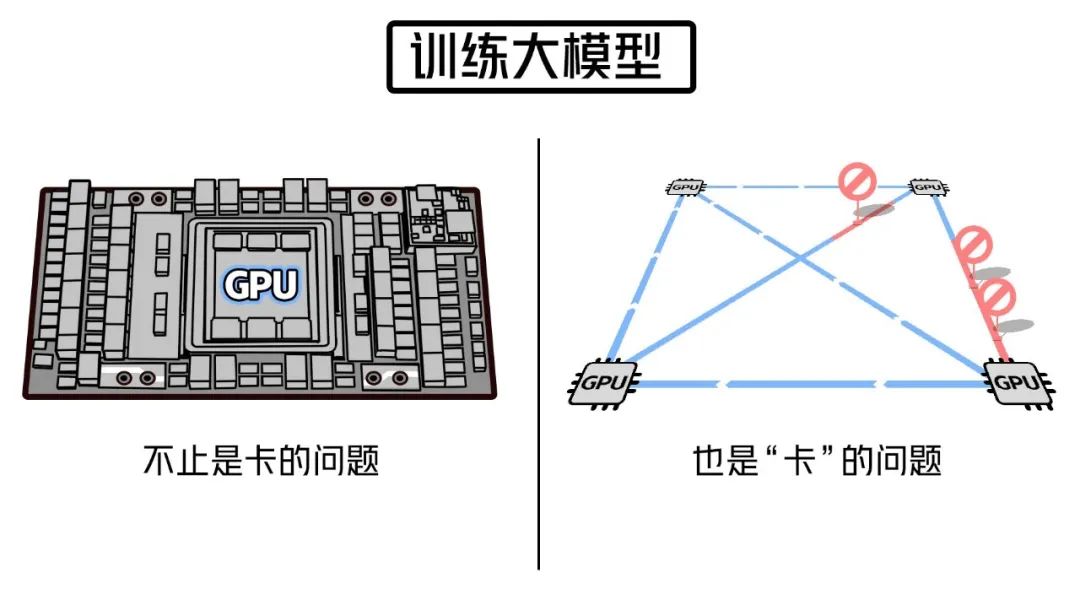

训练大模型离不开超大规模算力,GPU当然是核心。

没卡万万不行。但只要有卡就万事大吉了吗?

其实,当我们谈论算力时,GPU卡只是角色之一。

庞大的训练任务,需要由大量GPU服务器组成的算力集群协作完成。

这些服务器通过机间网络相连接,不断交换海量数据。

集群每次计算的背后,服务器间的同步通信量高达百GB。

如果网络性能跟不上,单卡再强,也只能“干等着”。

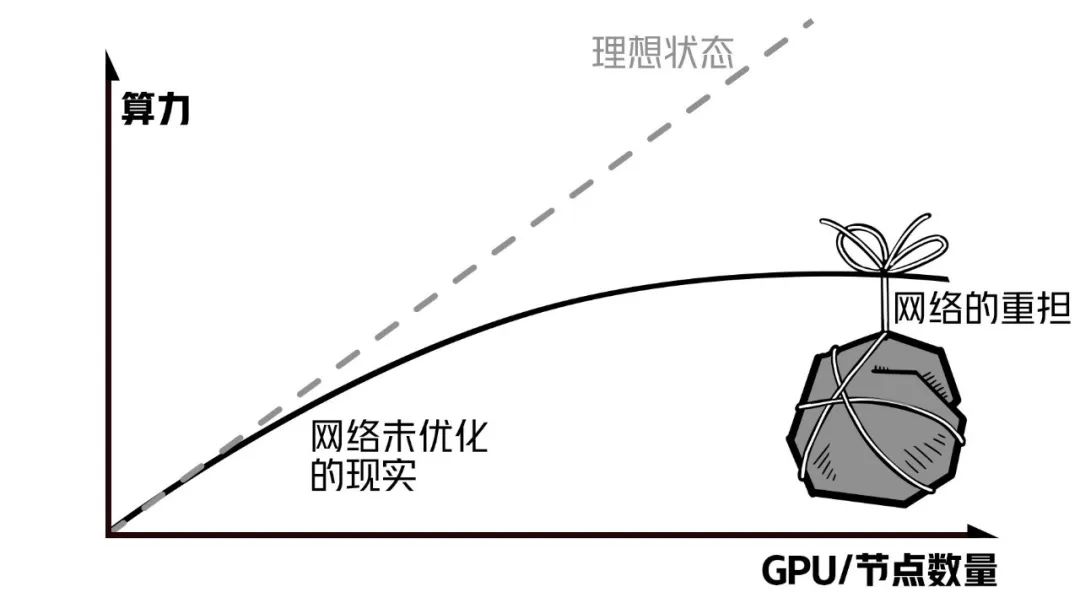

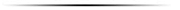

而且,随着集群规模扩大,网络带来的算力损耗还会更大。

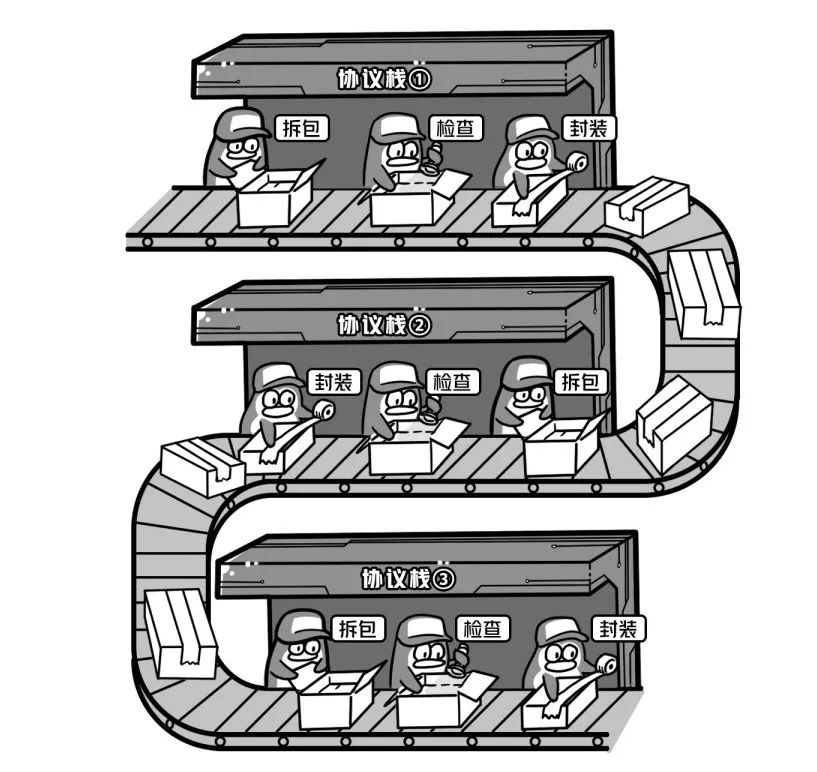

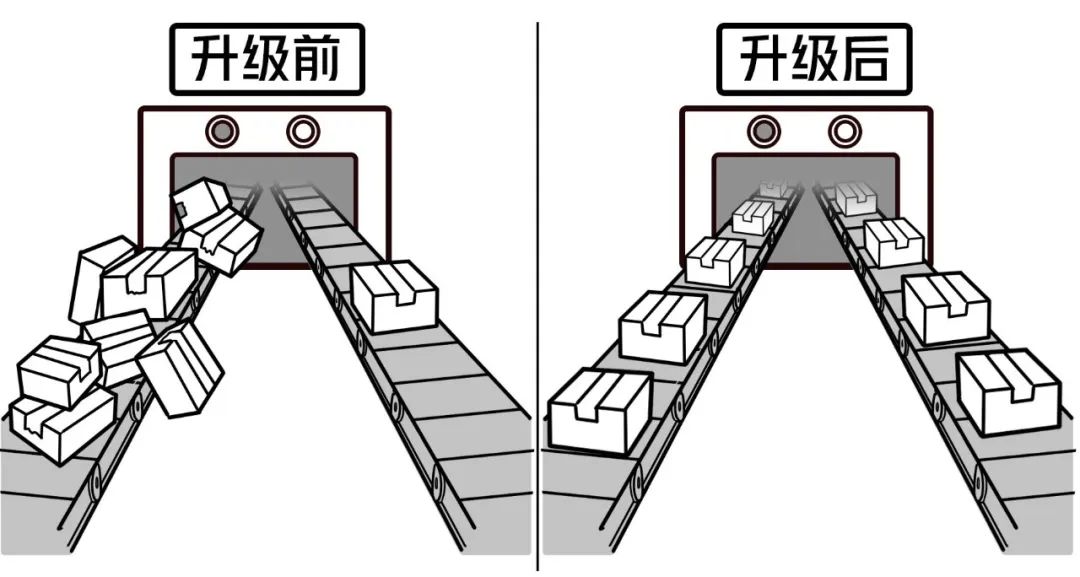

传统的网络架构,在传输时会经过多层协议栈:

需要反复停下来检查、分拣和打包,通信效率很低。

为解决这一问题,业界通常会引入RDMA技术:

它就像点对点的高速传送带,支持服务器内存间直接通信。

中间环节少了,自然省下不少资源开销。

为了让机间网络的性能跟上突飞猛进的GPU 卡,光靠RDMA还远远不够。

鹅厂死磕网络技术多年,研发了高性能计算网络“星脉”:

//网络带宽、拓扑架构

“带宽”相当于路的宽度,“拓扑”则是节点设备间的连接方式。

前者决定了能同时传输多少数据,后者决定了组网规模有多大。

3.2Tbps带宽、支持10万卡集群组网

——这两项硬指标,星脉都做到了业界最强。

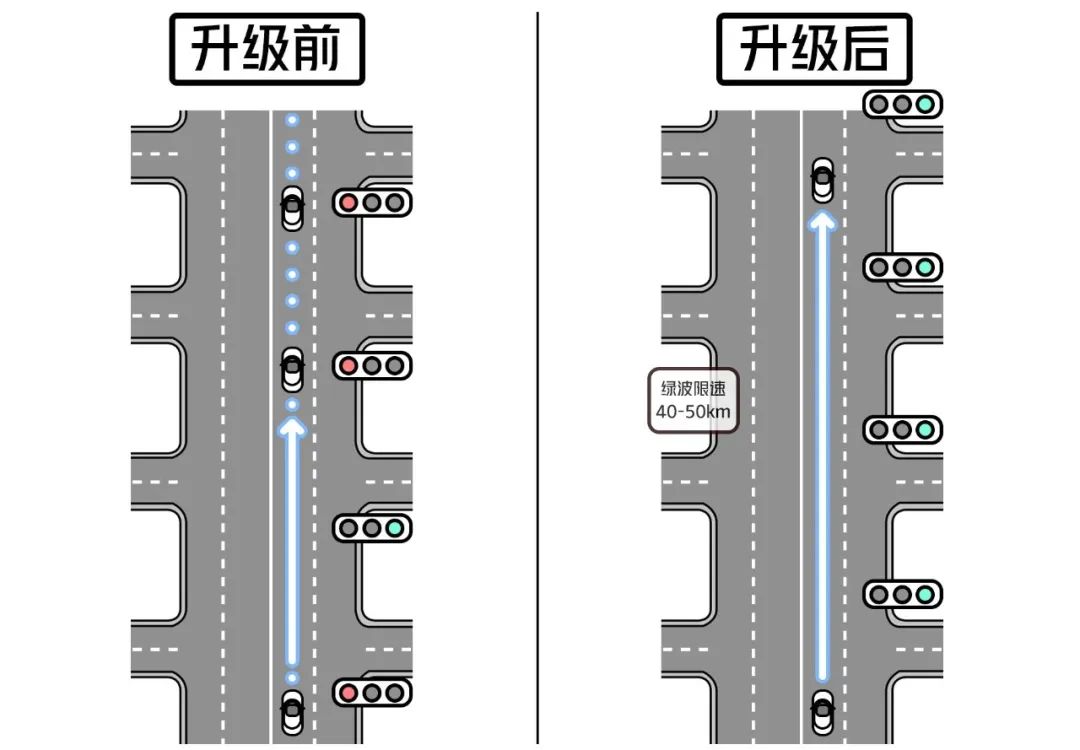

//升级网络协议

网络协议,就像网络世界里的“交通规则”。

星脉引入了腾讯自研端网协同协议TiTa,内嵌拥塞控制算法。

它不仅能控制数据发送速率,还能自动设置数据传输的优先级:

按导航给的“推荐速度”行驶,通过每个路口都是绿灯。

这项优化,让星脉的时延降到10us ~ 40us、丢包率降到0。

//计算网络联合优化

对分布式架构而言,想要把资源用足,需要实现“负载均衡”:

把任务更均匀地分到每台服务器、每条路径上。

通过几项联合优化,星脉的负载利用率提升至超过90%:

一是,多轨道流量亲和性规划。

它就像智能分配的物流系统,确保每条线路都得到充分利用。

既不会闲下来、也不会忙到爆。

二是,引入腾讯自研TCCL高效集合通信库。

它支持全局网络路由、拓扑感知亲和性调度。

就像智能导航,预先规划行驶路线、并根据路况动态调整。

通过这些技术创新,星脉让大模型通信性能提升了10倍。

搭载星脉的新一代HCC高性能计算集群,

万亿参数大模型训练时间已经加速至4天。

传输距离会带来通信损耗,是客观的物理定律。

但通过一点一滴的网络技术突破,我们尽力让集群算力输出更加接近线性。

每个备受关注的技术趋势背后,都经过了数十年研发。

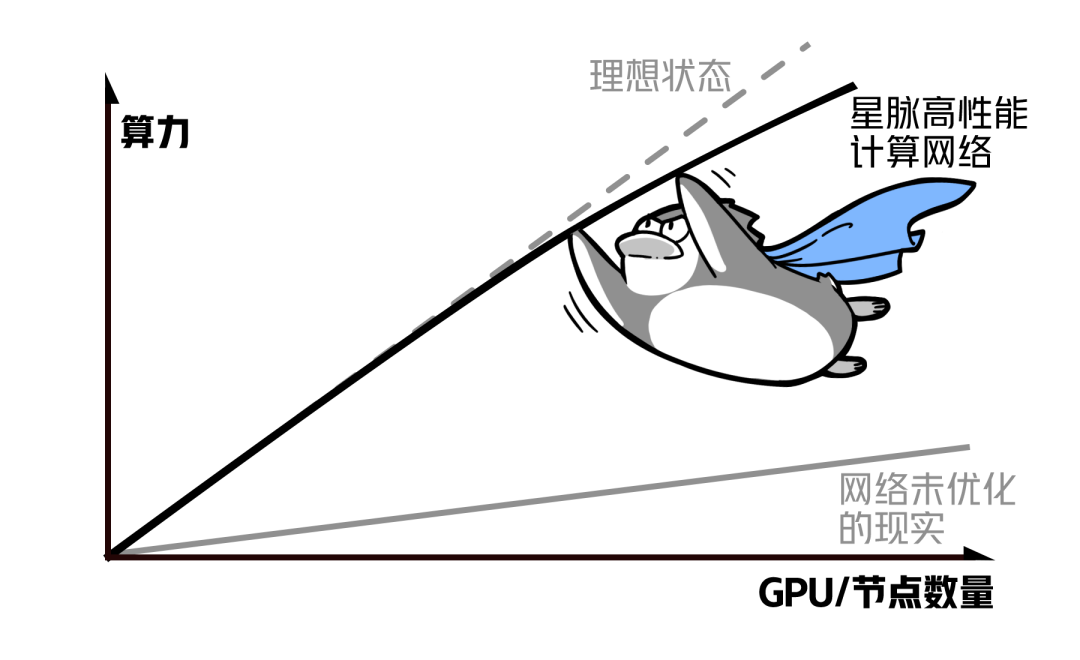

从最早服务QQ、到服务云上海量用户、到构筑大模型算力集群,

鹅厂自研的网络架构,已经完成三代技术演进。

未来,我们也会继续投入基础技术,

为各行各业的数智化转型提供有力支撑。

欢迎关注公众账号“鹅厂网事”,我们给你提供最新的行业动态信息、腾讯网络最接地气的干货分享。

注1:凡注明来自“鹅厂网事”的文字和图片等作品,版权均属于“深圳市腾讯计算机系统有限公司”所有,未经官方授权,不得使用,如有违反,一经查实,将保留追究权利;

注2:本文图片部分来自互联网,如涉及相关版权问题,请联系:sandyshuang@tencent.com或 mianyang@tencent.com

/

关

注

我

们

/

/ 鹅厂网事/

分享鹅厂网络的那些事

本文参与 腾讯云自媒体同步曝光计划,分享自微信公众号。

原始发表:2023-06-29,如有侵权请联系 cloudcommunity@tencent.com 删除

评论

登录后参与评论

推荐阅读