两篇近期多元时间序列分类工作解读

这篇文章带大家读两篇近期多元时间序列分类工作。一篇是TodyNet: Temporal Dynamic Graph Neural Network for Multivariate Time Series Classification,通过动态图学习的方式刻画多变量之间的关系,指导多元时间序列分类;另一篇是Enhancing Multivariate Time Series Classifiers through Self-Attention and Relative Positioning Infusion,在卷积时间序列分类网络的基础上,引入了注意力机制,提升多元序列分类小姑偶。

1

TodyNet:动态图建模

论文标题:TodyNet: Temporal Dynamic Graph Neural Network for Multivariate Time Series Classification

下载地址:https://arxiv.org/pdf/2304.05078v1.pdf

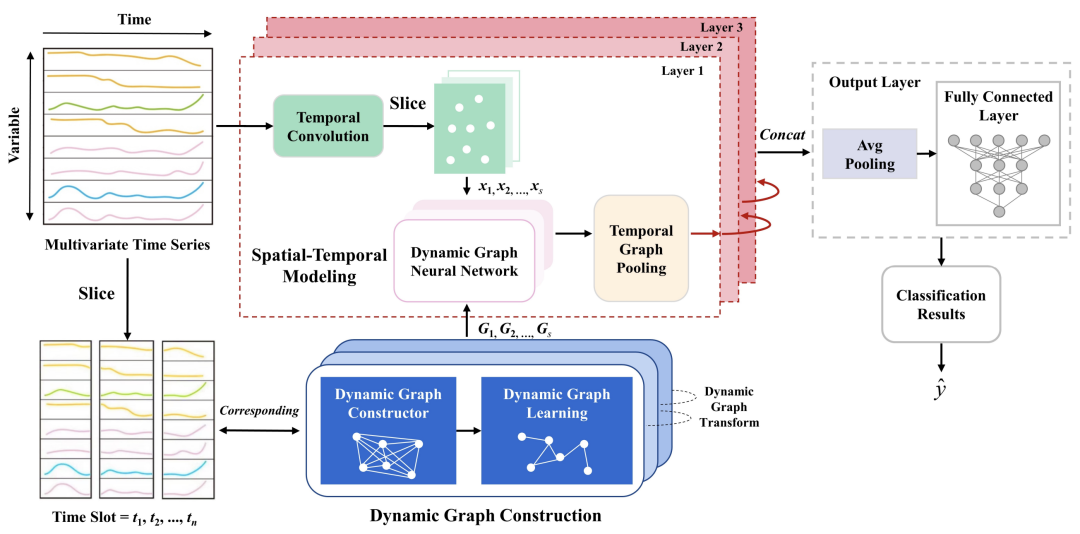

多元时间序列分类相比单元时间序列分类,一个难点在于复杂的多变量、多序列间关系。为了解决这个问题,TodyNet提出了一种动态图学习的方式,并在pooling阶段设计了一种层次pooling方法生成用于分类的表示。

动态图学习的目的,是为了建模各个时间步各个变量之间的关系。之前的一些时空预测方法中,主要利用静态图的思路,即各个节点之间的关系是不随着时间变化的。而动态图在每个时间步,有一个不同的图结构。本文采用自动学习每个时间步图结构的方法,对于每个变量,在每个时间步,为其指定2个可学习的向量,然后使用两个节点向量之间内积再取top的方式,建立两个节点之间的连边,为每个时间步自动学习一个图结构。

为了实现动态图时间步之间的信息流动,文中采用了一种Dynamic Graph Transform的方式。整个过程如下图所示。将同一个节点的不同时刻看成是不同的节点,把相邻两个时刻的对位节点之间加一个边,以此融合不同时刻动态图的信息。具体实现上,在第二个时刻的图中,将第一个时刻各个图节点的表示进行对位融合,直接进行embedding操作,而不是显示建立连边。

多元时间序列中,最后需要把各个变量的向量做pooling,一般采用mean pooling、max pooling等方式。这种方法在多元时序建模中会损失一定信息。为了保留更多有效信息,本文采用了一种层次pooling的方式,现将变量聚类,然后类内逐层进行pooling,实现更精细化的信息传递。

2

GTA&TPS:FCN中引入注意力机制

论文标题:Enhancing Multivariate Time Series Classifiers through Self-Attention and Relative Positioning Infusion

下载地址:https://arxiv.org/pdf/2302.06683v2.pdf

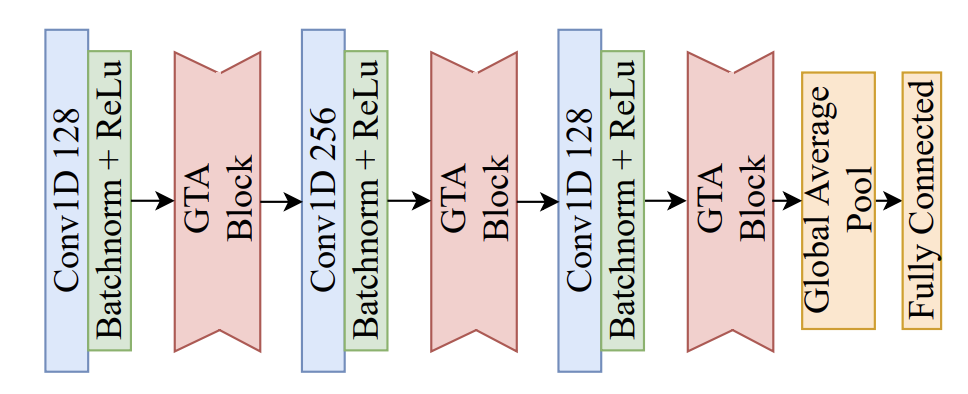

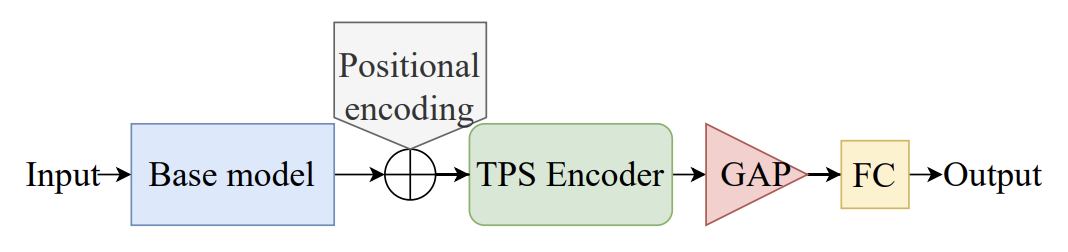

本文提出了在基于深度学习的多元时间序列分类模型中,引入Global Temporal Attention(GTA)和Temporal Pseudo-gaussian augmented Self-attention(TPS)两种注意力机制,实现进一步的效果提升。

GTA模块主要弥补基本的分类注意力机制只考虑自身信息的问题。分类问题中一般的注意力计算方法,是将时间序列中每个时间点的值分别进行映射后取softmax,得到各个时间点对分类的重要程度,再根据这个权重进行原始序列信息的过滤。这种基础方法在计算每个时间点的attention值时,只考虑了自身的信息,没有考虑整个序列的全局信息。为了引入全局信息,GTA修改了注意力计算方法,对原始序列进行一次映射后,在时间维度上进行一次信息融合,得到每个时刻考虑全局信息的注意力打分。

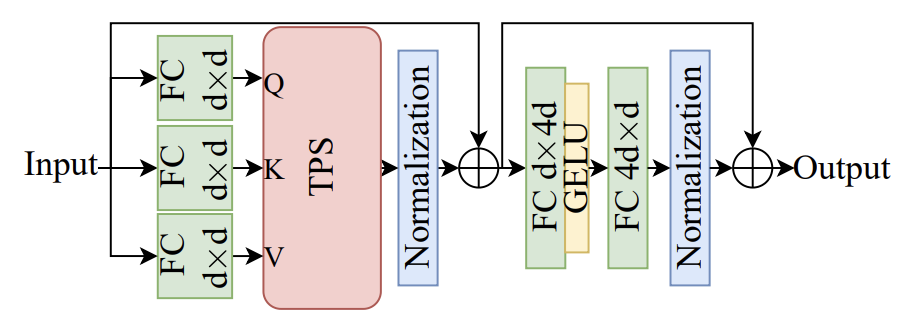

TPS模块主要将自注意力机制引入时间序列分类中,并对自注意力机制进行了改造。在计算attention时,原始的自注意力机制只考虑对应位置的相似性,TPS进一步考虑了时间点位置的信息,在attention计算中,增加每个节点对自身邻居时间步节点信息的考虑,与当前节点距离越近的时间步会得到更多attention。这种方式其实和以前的LSTM+Transformer、CNN+Transformer类似,都是在self-attention底层增加了一个考虑时序关联性的组件,只不过本文采用的方式是根据相对位置直接修改attention计算逻辑。

下面为本文提出的方法和各个其他SOTA方法的效果对比:

本文参与 腾讯云自媒体同步曝光计划,分享自微信公众号。

原始发表:2023-06-02,如有侵权请联系 cloudcommunity@tencent.com 删除

评论

登录后参与评论

推荐阅读