深度强化学习:详解优化器加上REINFORCE算法迭代求解【组合优化】

深度强化学习:详解优化器加上REINFORCE算法迭代求解【组合优化】

汀丶人工智能

发布于 2023-10-11 17:40:13

发布于 2023-10-11 17:40:13

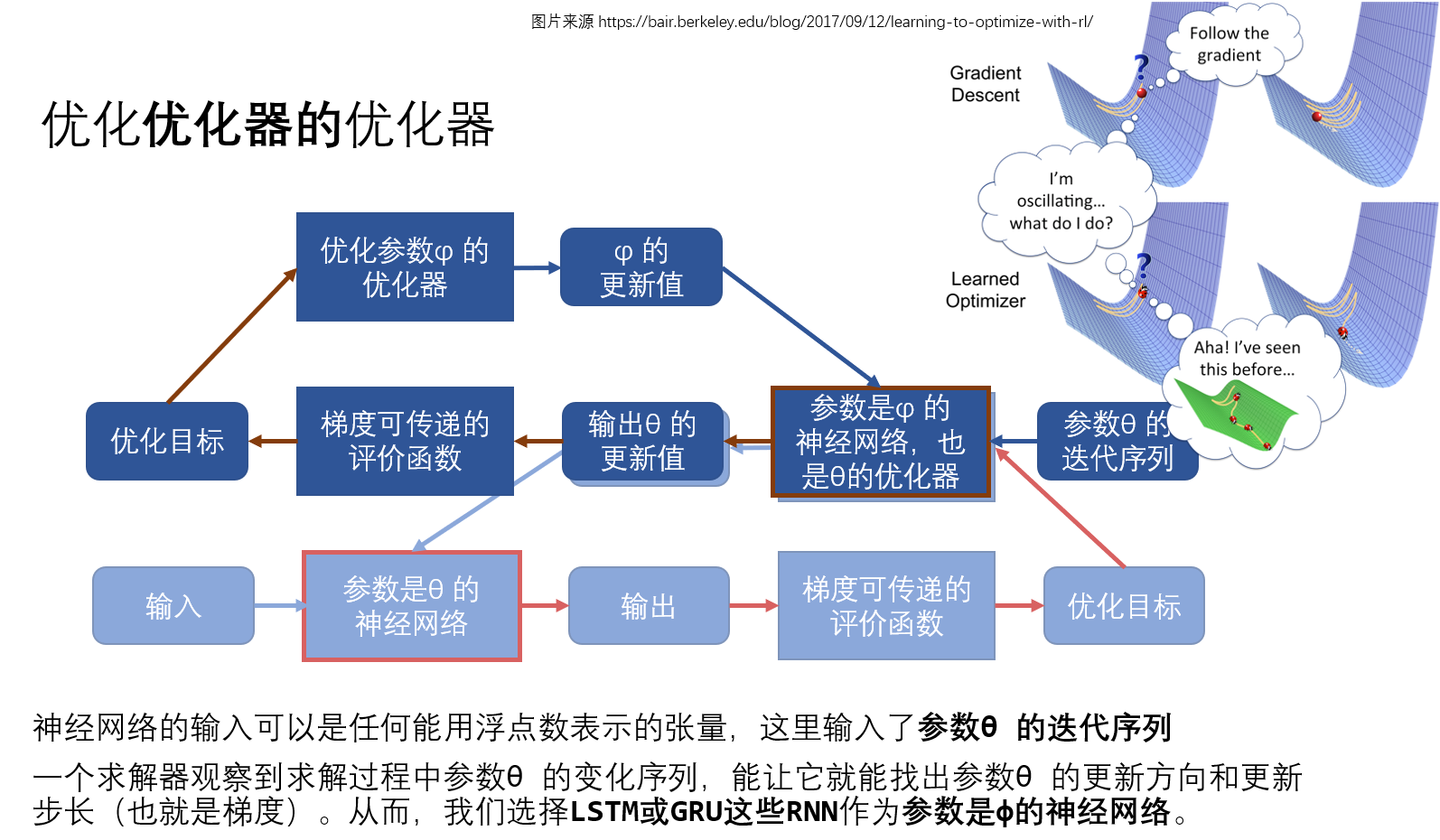

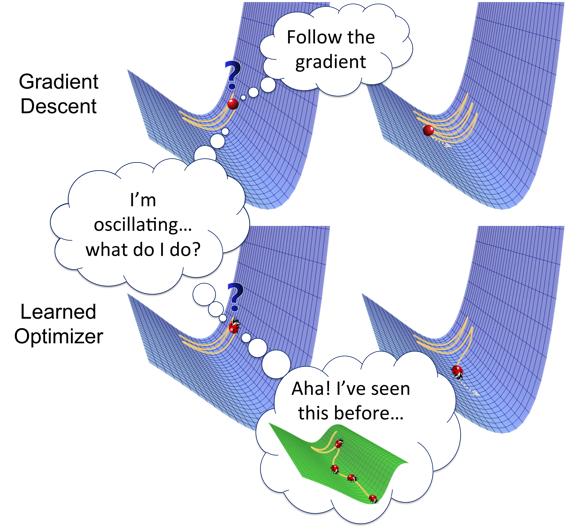

优化优化器的优化器 Learning to optimize,惊讶于它在解组合优化问题上有优势。

想要看公式,可以阅读与之相关 3 篇论文有:

- Learning to Optimize (伯克利 ICML)

- Learning to Optimize Neural Nets (对上一篇论文做了很小的补充)

- Learning to Optimize: A Primer and A Benchmark

更多解读,可以看:

https://bair.berkeley.edu/blog/2017/09/12/learning-to-optimize-with-rl/

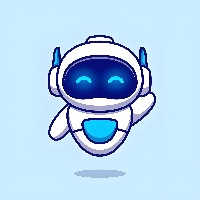

参数θ的优化器,将根据从神经网络一路传递出来的梯度去更新θ,用于最大化评价函数。 对于拟合标签的任务,损失函数的负值就是评价函数。损失函数输出的误差越小,神经网络的输出的评价就越高。

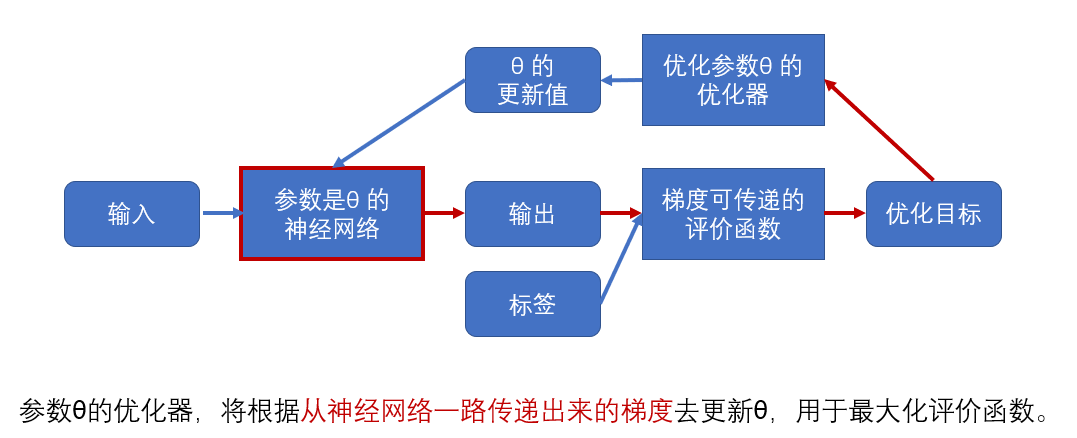

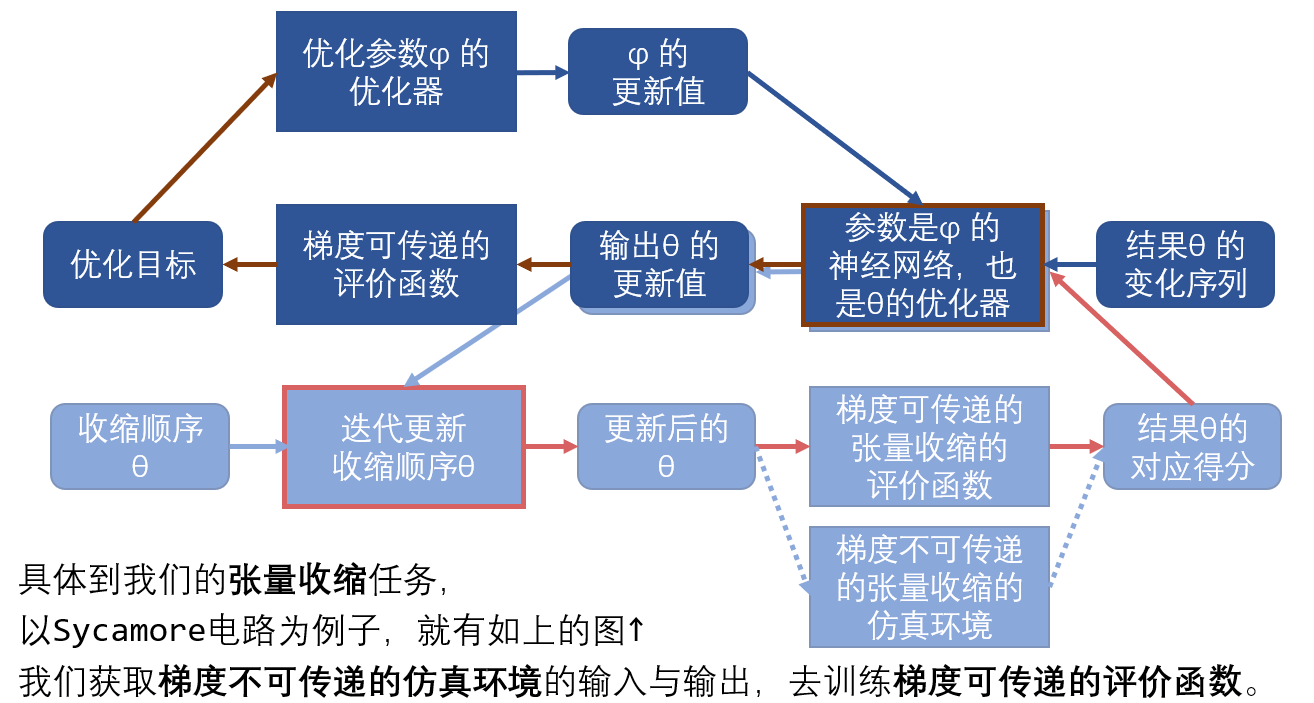

现在我把优化参数θ(天蓝色)的过程重新写一遍,(不画出 不涉及梯度传递的标签) 然后改成优化参数φ(海蓝色)水平翻转后放在上面

我们任务需要训练的神经网络就是参数为θ 的神经网络。 优化参数为θ 的神经网络的优化器就是参数为φ 的神经网络。 我们把相同的组件重合起来,就得到上面这张图了。

神经网络的输入可以是任何能用浮点数表示的张量,这里输入了参数θ 的变化序列。

一个求解器观察到求解过程中参数θ 的变化序列,能让它就能找出参数θ 的更新方向和更新步长(也就是梯度)。从而,我们选择 LSTM 或 GRU 这些 RNN 作为参数是φ的神经网络。

参数θ 或者参数φ 的迭代过程,可以建模成一个连续决策过程(MDPs)

- 状态:当前时刻的要求解的参数

- 动作:参数的更新量 (梯度 * 步长)

- 策略:更新参数的优化器

- 价值函数:固定迭代步数的目标函数求和,得到 cumulative rewards,这里可以采样多条轨迹,然后用 REINFORCE 算法求出价期望作为优化目标。

三张图理解「优化优化器的优化器」加上 REINFORCE 算法迭代求解,到这里就讲完了,感兴趣的可以去读原论文。欢迎来腾讯 QQ 的群 **深度强化学习 ElegantRL 1163106809 讨论强化学习。**群人数常年接近 2000 人上限,经常清人,不过没关系,想起来就再加回来吧。

对应的代码还在施工中。https://github.com/AI4Finance-Foundation/ElegantRL_Solver

想要看公式,可以阅读与之相关 3 篇论文有:

- Learning to Optimize (伯克利 ICML)

- Learning to Optimize Neural Nets (对上一篇论文做了很小的补充)

- Learning to Optimize: A Primer and A Benchmark

想要看作者团队自己的解读,可以看:

https://bair.berkeley.edu/blog/2017/09/12/learning-to-optimize-with-rl/

下面是一些例子,对这些任务熟悉的人可以接着往下看:

具体到某个任务,举无向图的最大割问题为例,这是一个可以提供梯度可传递的价值函数的例子,有:

举量子电路模型的张量收缩问题为例,这是一个无法提供梯度可传递的价值函数的例子,有:

以 Sycamore 电路为例子,就有如上的图↑

我们获取梯度不可传递的仿真环境的输入与输出,去训练梯度可传递的评价函数。这样就拓宽这个算法的使用场景了。

本文参与 腾讯云自媒体同步曝光计划,分享自作者个人站点/博客。

原始发表:2023-07-18,如有侵权请联系 cloudcommunity@tencent.com 删除

评论

登录后参与评论

推荐阅读

目录