AAAI 2023 | 探索使用 CLIP 来评估图像的外观和感觉

AAAI 2023 | 探索使用 CLIP 来评估图像的外观和感觉

用户1324186

发布于 2024-05-11 17:32:12

发布于 2024-05-11 17:32:12

来源:AAAI 2023 论文题目:Exploring CLIP for Assessing the Look and Feel of Images 论文链接:https://doi.org/10.1609/aaai.v37i2.25353 论文作者:Jianyi Wang, Kelvin C.K. Chan, Chen Change Loy 内容整理:黄海涛 对视觉内容的感知是计算机视觉中长期存在的问题。许多数学模型被提出以用来评估图像的外观或质量。尽管此类工具在量化噪声和模糊程度等退化方面非常有效,但这种量化与人类感受并不是非常一致。当涉及到对视觉内容的更抽象的感知时,现有的方法只能依赖于监督模型,这些模型是通过大量用户研究收集的标记数据进行显式训练的。在本文中,超越了传统的范式,探索了对比语言图像预训练(CLIP)模型中封装的丰富的视觉语言,用于评估图像的质量感知(外观)和抽象感知(感觉),而无需明确的任务特定性训练。特别是,本文讨论了有效的提示设计,并展示了一种反义词提示配对策略来利用先验知识。还提供有关数据集和图像质量评估 (IQA) 基准的广泛实验。实验结果表明,CLIP 捕获了有意义的先验,可以很好地推广到不同的感知评估。

目录

- 介绍

- 将CLIP用于视觉感知

- 扩展 CLIP 以实现视觉感知

- 质量感知

- 抽象感知

- 讨论

- 提示设计

- 局限性

- 总结

介绍

外观和感觉是人类解释图像时的两个影响因素,而对这两个元素的理解一直是计算机视觉中长期存在的问题。图像的外观通常与直接影响内容的可量化属性相关,例如曝光度和噪声水平。相比之下,图像的感觉是一个与内容无关的抽象概念,不能轻易量化,例如情感和美学。

本文首次尝试调查 CLIP 在具有挑战性但有意义的感知评估任务中的潜力。作者从深入研究提示的选择开始探索,以便最大限度地减少由于语言歧义而导致的潜在模糊性。为此,引入了一种提示配对策略,其中成对采用反义词提示(例如“好照片”和“坏照片”)。根据作者的策略,表明 CLIP 可以直接应用于视觉感知评估,无需任何特定于任务的微调。对于质量感知,证明了 CLIP 能够通过简单地使用“好”和“坏”作为提示来评估图像的整体质量,并在常见的 IQA 数据集中实现与人类感知的高度相关性,对于抽象感知,证明了 CLIP 能够在令人满意的程度上评估图像的感觉。

将CLIP用于视觉感知

扩展 CLIP 以实现视觉感知

反义词提示配对

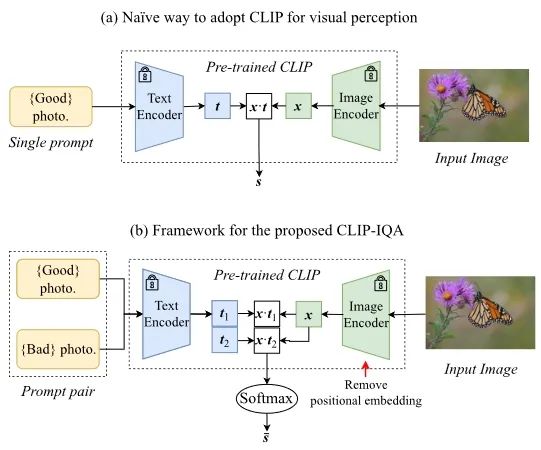

如下图所示,利用 CLIP 进行感知评估的一种直接方法是直接计算给定提示(例如“好照片”)和给定图像的特征表示之间的余弦相似度。具体来说,令

和

分别为图像和提示的特征(矢量形式),其中

是通道数。最终预测得分

计算如下:

图1

但是因为语言歧义,这种方法对于感知评估来说并不可行。比如,“a rich image”既可以指内容丰富的图像,也可以指与财富相关的图像。

为了解决这个问题,本文提出了一种简单而有效的即时配对策略。为了减少歧义,对每个预测采用一对反义词提示(例如“好照片”和“坏照片”)。设

和

为两个含义相反的提示的特征,首先计算余弦相似度

使用 Softmax 计算最终得分

:

当使用一对形容词时,一个提示的歧义性会因其反义词而减少,因为任务现在被转换为二元分类,其中最终得分被视为相对相似性。特别是,较大的

表示与

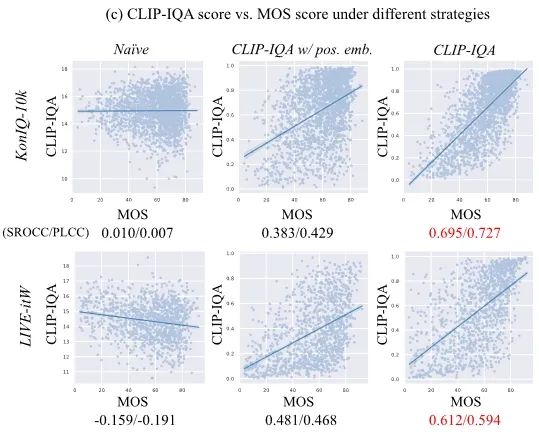

的相应属性更接近。如下图所示,本文提出的反义词提示配对显着提高了 CLIP 的性能——这个方法预测的分数与人类标记的 MOS 分数更加一致,这反映在更高的斯皮尔曼等级相关系数 (SROCC) 和皮尔逊线性相关系数 (PLCC)上。

图2

去除位置嵌入

CLIP 的另一个限制是需要固定大小的输入。特别是,基于ResNet-50的CLIP需要尺寸为224×224的图像。这样的要求在感知评估中是不利的,因为调整大小和裁剪操作可能会给输入图像带来额外的扭曲,从而改变最终分数。例如,调整大小操作会导致对图像分辨率不敏感,因此与分辨率相关的评估可能是徒劳的。

上述限制是由可学习的位置嵌入造成的,其大小在构造时是固定的。与广泛使用位置嵌入的现有研究不同,作者推测位置嵌入对感知评估的影响很小,因为这项任务的主要焦点是捕捉图像和给定描述之间的感知关系。因此,作者建议删除位置嵌入以放宽尺寸限制。

质量感知

CLIP-IQA 对整体质量的感知

为了评估整体质量,只需使用最常见的反义词之一

作为 CLIP-IQA 的配对提示。

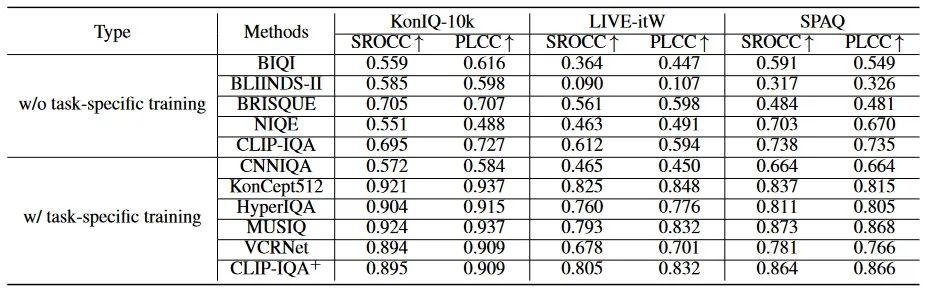

通过对三个广泛使用的 NR-IQA 基准进行实验,包括用于真实相机畸变的 LIVE-itW和 KonIQ10k以及用于智能手机摄影的 SPAQ。

表1

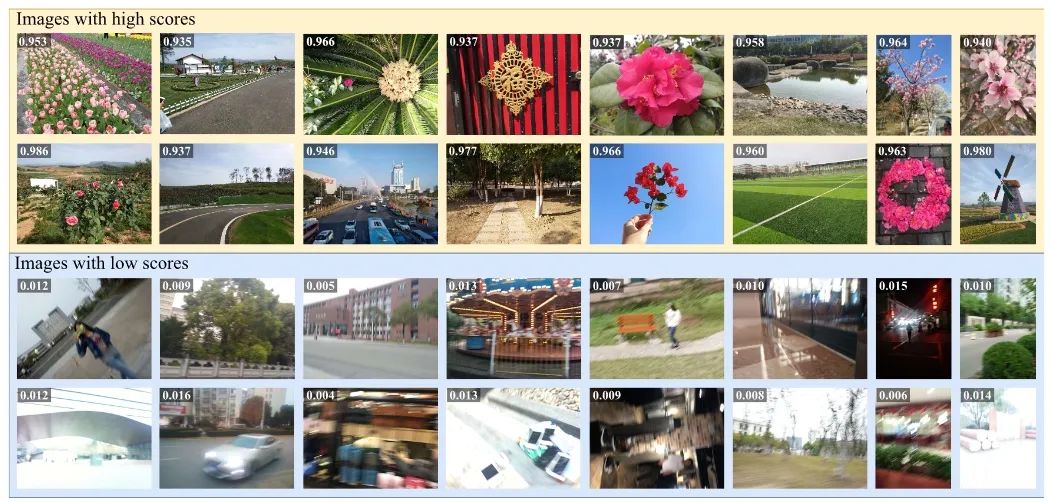

实验结果如上表所示,无需手工制作特征,CLIP-IQA 与 BRISQUE 相当,并在所有三个基准上超越所有其他非学习方法。此外,即使没有特定任务的训练,CLIP-IQA 的性能也优于需要注释训练的 CNNIQA。CLIP-IQA 令人惊讶的良好性能验证了其在 NR-IQA 任务中的潜力。在下图中,展示了分别从 CLIP-IQA 获得高分和低分的两组图像。据观察,CLIP-IQA 能够区分不同质量的图像。

图3

CLIP-IQA 提供细粒度的质量

人们通常不会对图像进行单一评分,而是从多个角度来判断图像,例如亮度、噪声和清晰度。为了测试能力,只需分别用想要评估的属性及其反义词替换“好”和“坏”。例如,可以使用“明亮的照片”和“黑暗的照片”来作为评估图像亮度时的提示。值得注意的是,与大多数基于学习的方法不同,CLIP-IQA 不需要高质量注释。因此,CLIP-IQA不仅限于带注释的标签,还能够评估用户所需的任意属性。

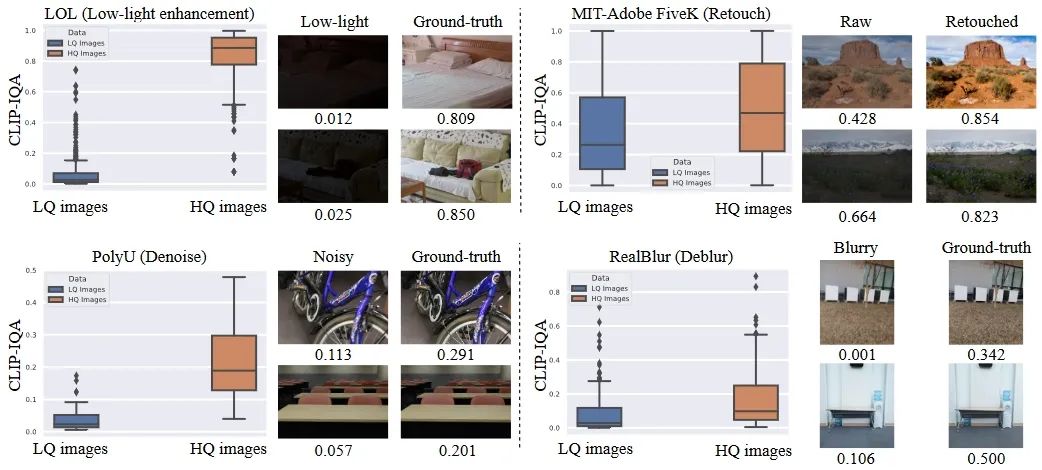

为了确认其现实世界的适用性,本文在四个非合成基准上应用了 CLIP-IQA:LOL用于低光增强,PolyU用于降噪,MIT-Adobe FiveK 用于修饰,RealBlur 用于去模糊。对于每个数据集,独立地将 CLIP-IQA 应用于低质量图像和高质量图像(即真实值),并比较它们的质量得分。如下图所示,高质量图像的质量分数明显高于低质量图像,表明 CLIPIQA 能够识别细粒度的质量。

图4

抽象感知

虽然情感和美学很容易被人类理解,但对这些概念的理解对于机器来说并非易事。本文在 AVA 数据集上进行实验,此数据集包含超过 250,000 张内容广泛的图像。

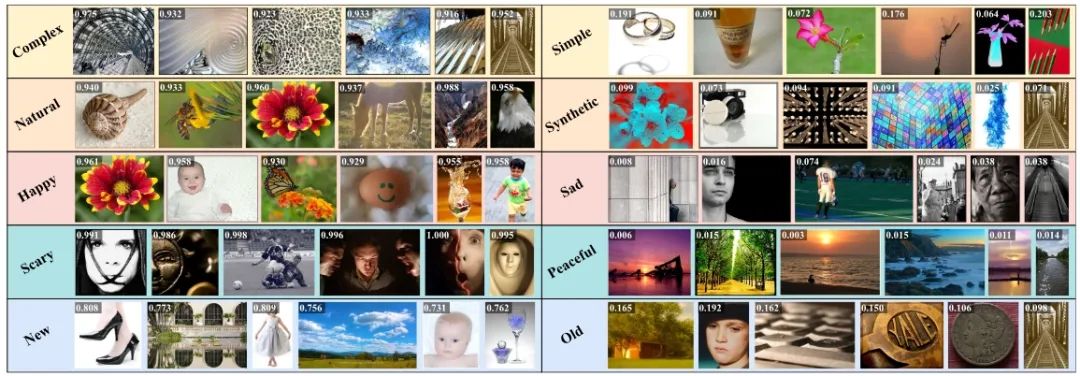

使用与人类情感和艺术感觉相关的五个属性来评估 CLIP-IQA 的性能,即复杂/简单、自然/合成、快乐/悲伤、恐怖/和平和新/旧。对于每个属性,计算每个图像的分数,并根据分数对图像进行排序。在下图中,显示了每个属性的最佳得分和最差得分图像。据观察,CLPIQA 能够感知图像的抽象方面。与质量属性类似,CLIP-IQA 能够从不同角度评估图像。例如,复杂类别中的最后一张图像也是合成的且旧的。这种细粒度的抽象理解再次证明了 CLIP 在视觉语言预训练期间捕获的先验信息的有效性。

图5

讨论

提示设计

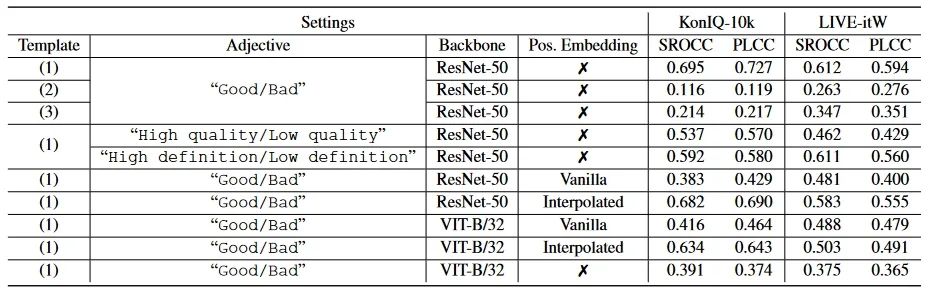

首先,观察到提示模板的选择对 CLIP-IQA 有显着影响。本文比较了现有文献中三种不同模板选择的性能(1)“[文本]照片。”,(2)“[文本]的照片。”,(3)“照片中有[文字]。”。如下表所示,使用不同模板时可以观察到明显的差异。在这项工作中,采用“[文字]照片”。

表2

接下来,用上述模板来研究形容词的影响。同样,性能也随所选择的形容词变化。例如,在评估图像的整体质量时,“好/坏”比“高质量/低质量”和“高清晰度/低清晰度”与人类感知具有更好的相关性。作者推测这种现象表明不常见形容词的表现较差。在此指出,由于同义词的存在,这一挑战在感知评估中尤其值得注意,对提示选择的敏感性表明需要对提示设计有更全面的理解。

局限性

尽管 CLIP-IQA 的表现令人鼓舞,但仍有一些挑战尚未解决。首先,CLIP-IQA 对提示的选择很敏感。因此,开发更加系统的提示选择非常重要。

其次,通过视觉语言对的训练,CLIP能够理解日常交流中广泛使用的单词和短语。然而,对于 CLIP 来说,识别人类对话中相对不常见的专业术语(例如“长曝光”、“三分法”、“浅景深”)仍然是一个不小的问题。尽管如此,这个问题可以通过使用这样的对来预训练 CLIP 来缓解。

第三,虽然探索显示了 CLIP 在没有明确的特定任务训练的情况下在多功能视觉感知任务上的能力,但由于 CLIP 中缺乏特定于任务的架构设计,CLIP-IQA 和现有特定任务方法之间仍然存在性能差距。作者相信特定任务设计和视觉语言先验的融合将取得有希望的性能,并将成为感知评估任务的新方向。

总结

CLIP 卓越的多功能性引起了计算机视觉研究人员的极大兴趣。本文与现有工作不同,研究了 CLIP 在感知主观属性方面的有效性。通过本文的探索,发现 CLIP 在进行适当的修改后,能够理解图像的质量和抽象感知。通过为基于 CLIP 的感知评估提供坚实的基础,本文的研究和讨论可以促进各个领域的未来发展,例如复杂的提示、更好的普遍性以及 CLIP 先验的有效采用。

本文参与 腾讯云自媒体同步曝光计划,分享自微信公众号。

原始发表:2024-05-05,如有侵权请联系 cloudcommunity@tencent.com 删除

评论

登录后参与评论

推荐阅读

目录