本机部署大语言模型:Ollama和OpenWebUI实现各大模型的人工智能自由

原创本机部署大语言模型:Ollama和OpenWebUI实现各大模型的人工智能自由

原创

星哥玩云

发布于 2024-05-14 09:39:58

发布于 2024-05-14 09:39:58

本机部署大语言模型:Ollama和OpenWebUI实现各大模型的人工智能自由

本篇文章介绍在window系统下,安装Ollama并且安装gemma(谷歌大模型)、llama2(脸书大模型)、qwen(阿里大模型)等大模型的教程,实现类似免费ChatGPT的web界面

OllamaFengmian

安装之后的web界面

image-20240514091912366

什么是Ollama

Ollama是一个开源项目,旨在让用户能够轻松地在其本地计算机上运行大型语言模型(LLM),是一个开源的大型语言模型服务。它支持各种LLM,包括Llama 3、Mistral和Gemma。

提供了类似OpenAI的API接口和聊天界面,可以非常方便地部署最新版本的GPT模型并通过接口使用。支持热加载模型文件,无需重新启动即可切换不同的模型。

img

Ollama官网: https://ollama.com/

Ollama GitHub仓库:https://github.com/ollama/ollama

Ollama文档:https://github.com/ollama/ollama/blob/main/docs/api.md

Ollama的优势

易用性:

1.Ollama的API设计简洁明了,即使是初学者也可以轻松上手。 2.提供类似OpenAI的简单内容生成接口,极易上手使用。 3.类似ChatGPT的的聊天界面,无需开发直接与模型聊天。

灵活性:

1.支持多种LLM,如Llama 2、Code Llama、Mistral、Gemma 等,并允许用户根据特定需求定制和创建自己的模型。 2.支持热切换模型,灵活多变。

可控性:

1.可以本地运行LLM,因此用户可以完全控制自己的数据和隐私。 2.可定制模型参数、数据目录和其他设置。

经济性:

1.与使用云服务相比,本地运行LLM可以更省钱。

离线能力:

1.可让您离线运行LLM,这对于隐私和安全非常重要。

安装Ollama

本次安装环境为:Windows11,当然其他系统也可以支持。

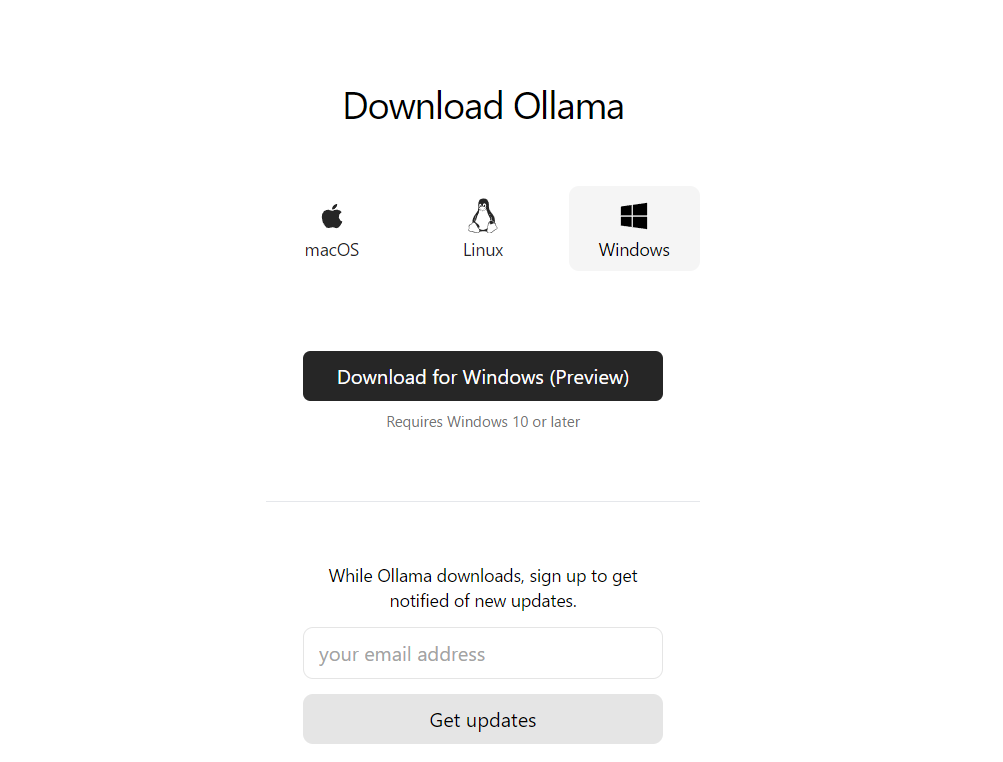

下载Ollama

Ollama下载地址:https://ollama.com/download

image-20240511151054662

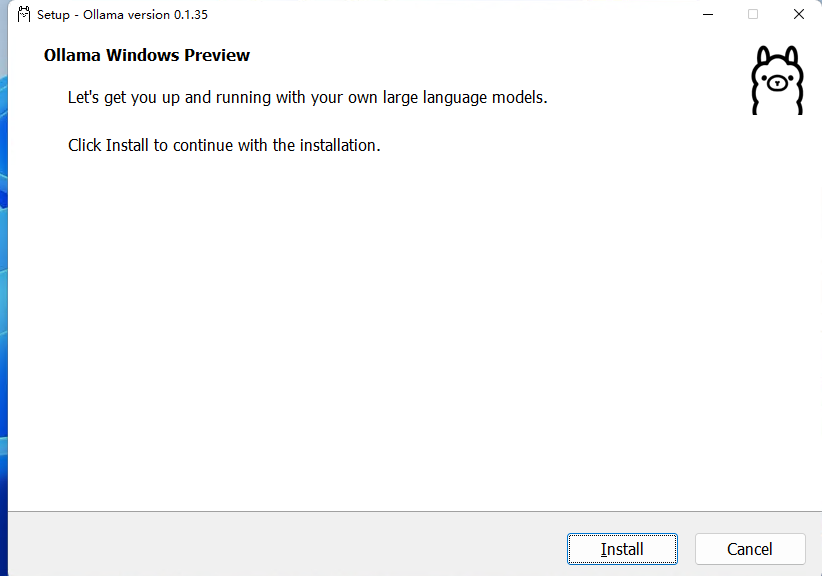

安装Ollama

安装也比较方便,双击打开 install

image-20240511151331009

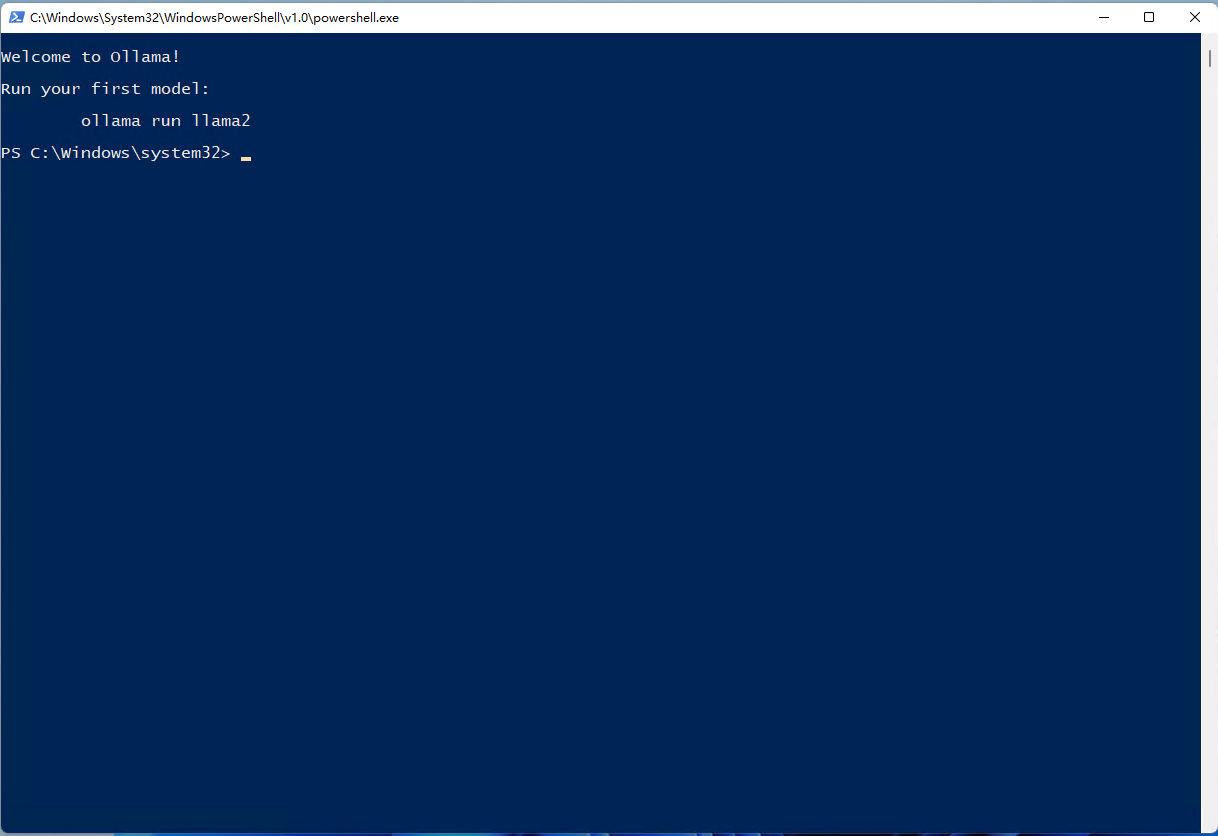

安装完成没有提示,我们打开一个终端,本文以Windows PowerShell为例,大家也可以使用其他的:

image-20240511151503523

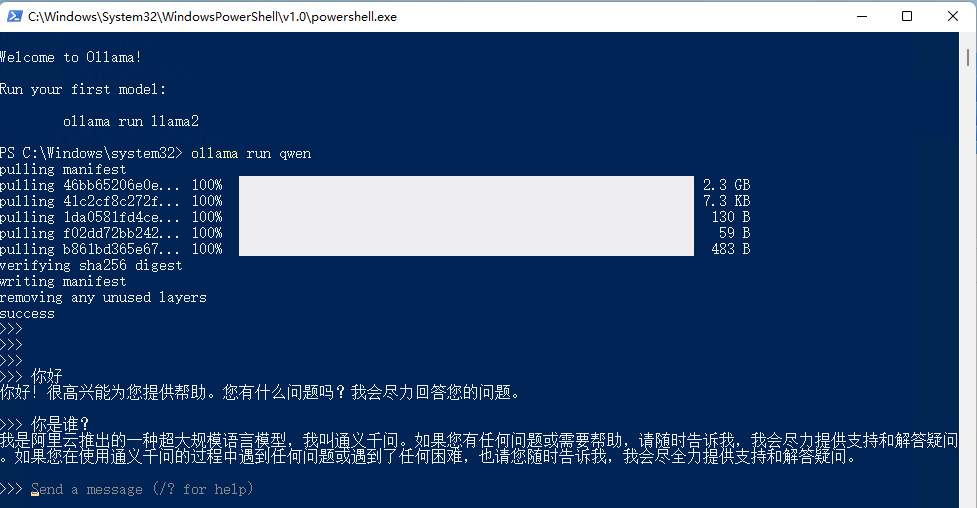

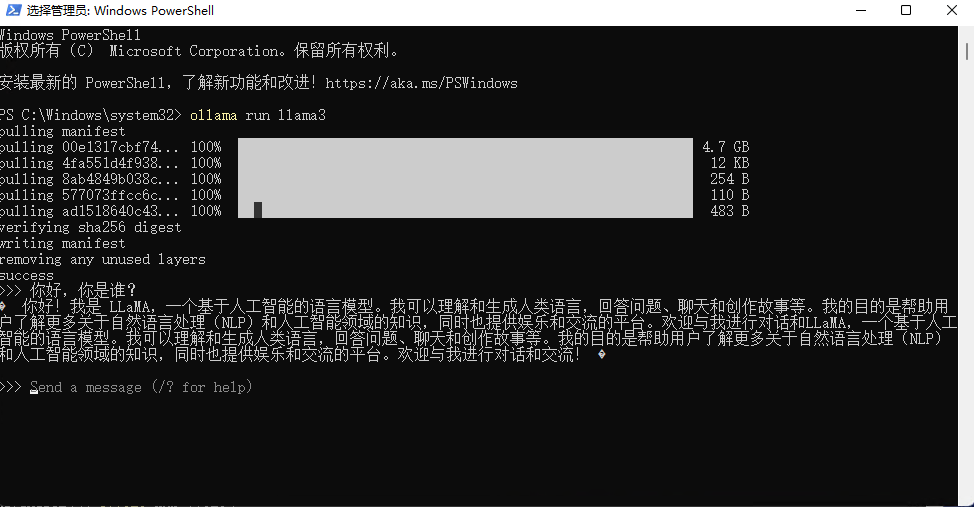

现在Ollama已经安装完了,我们需要在终端中输入下方命令运行一个大语言模型进行测试,这里以对在中文方面表现相对好些的千问为例,大家也可以使用其他的模型。

ollama run qwen

image-20240511151819825

安装成功,随便问几个问题。

image-20240511151923267

修改路径

可以看到,系统正在下载qwen的模型(并保存在C盘,C:\Users.ollama\models 如果想更改默认路径,可以通过设置OLLAMA_MODELS进行修改,然后重启终端,重启ollama服务。)

setx OLLAMA_MODELS "D:\ollama\model"安装Open WebUI

Open WebUI是一个用于在本地运行大型语言模型(LLM)的开源Web界面。

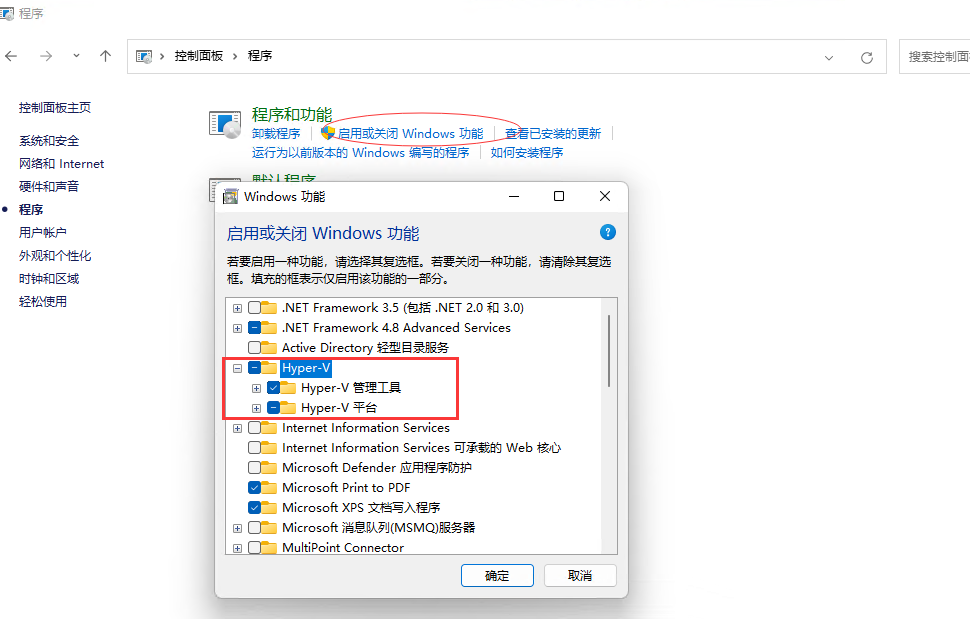

在window下安装docker

1.启动Hyper-v

打开控制面板,在程序与功能页面选择启用或Windows功能

image-20240511153112805

然后,重启计算机。

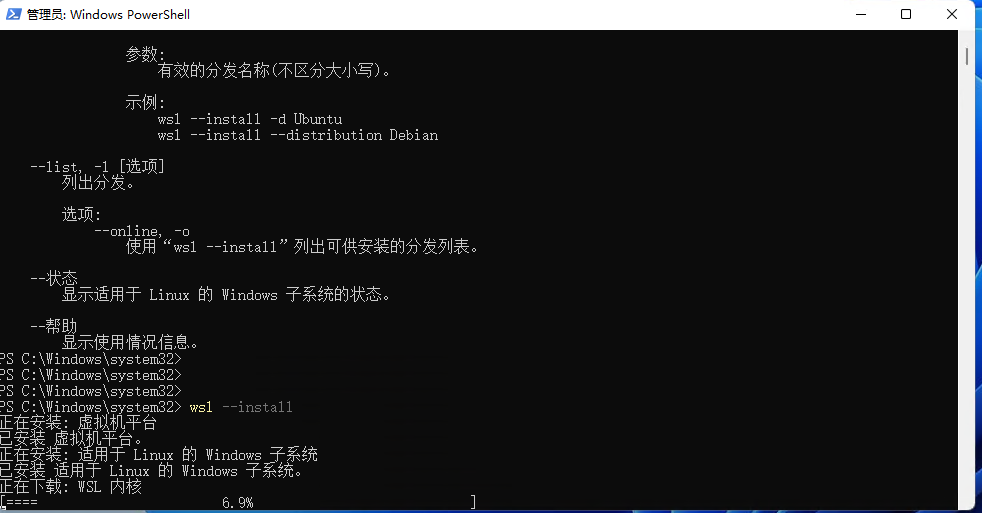

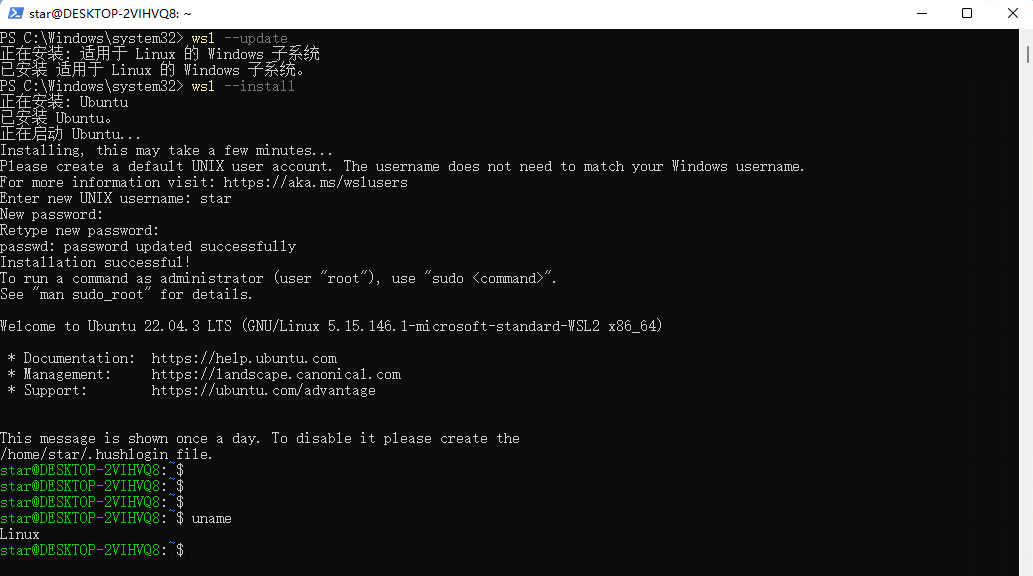

2.安装WSL

打开 powershell,以管理员的身份启动命令窗口,输入

wsl --update

wsl --install如果不是已管理员身份启动则会报错:请求的操作需要提升

image-20240511154319596

然后再次重启电脑。

image-20240511172942703

3.下载Docker软件

点击下载链接:https://docs.docker.com/desktop/install/windows-install/

image-20240511153811506

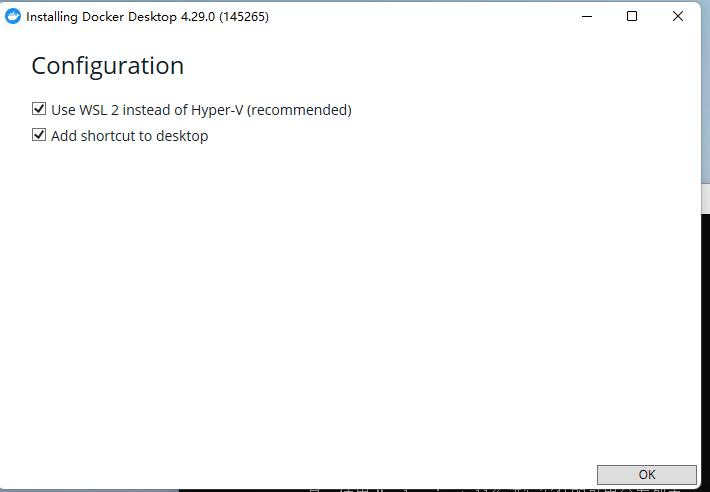

4.安装Docker

image-20240511155742842

使用Docker部署Open WebUI

在Open WebUI的github页面 https://github.com/open-webui/open-webui

可以看到,如果你的Ollama和Open WebUI在同一台主机,那使用下面显示的这一行命令就可以在本地快速进行部署:

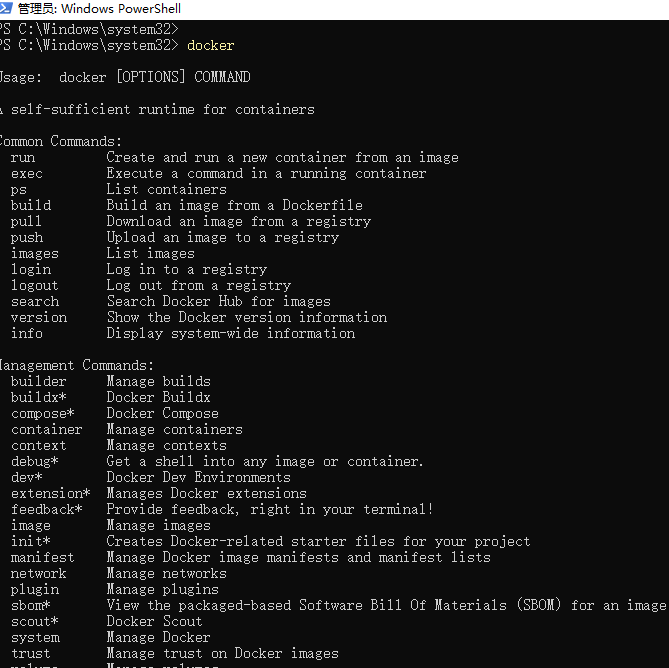

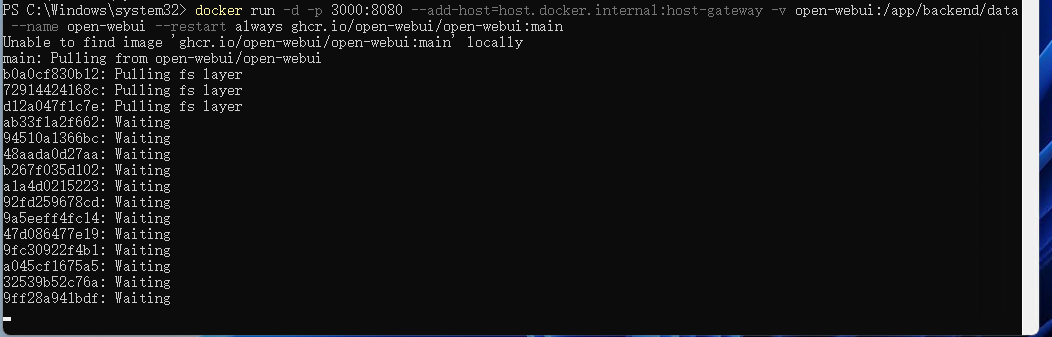

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main现在我们打开终端,比如powershell,然后输入docker,回车

image-20240511173724816

然后将上边在docker中部署Open WebUI的命令复制后粘贴到终端中,回车。

docker安装open-webui

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

image-20240511173828471

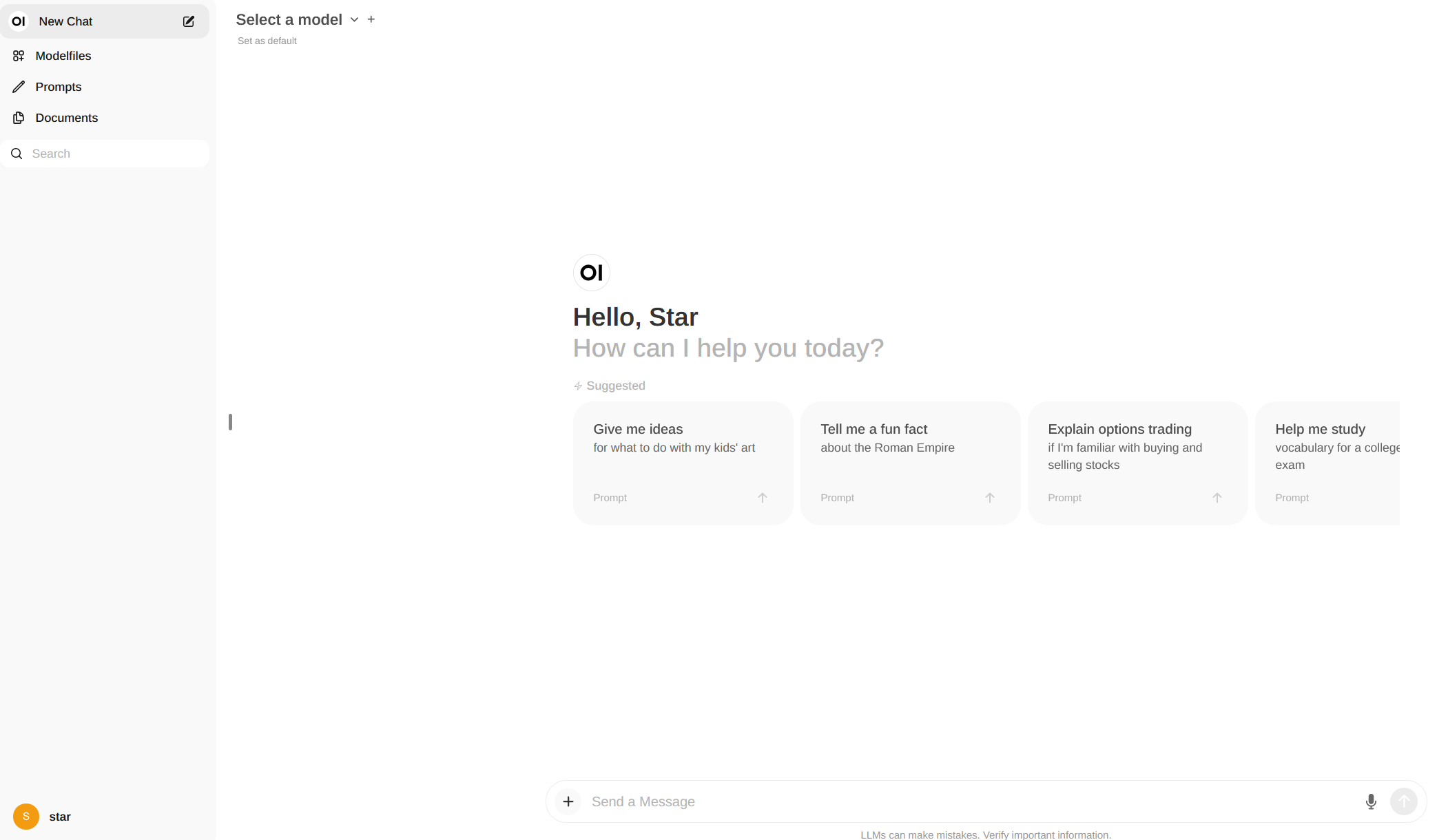

使用Open WebUI

安装完成后,在Docker Desktop中可以看到Open WebUI的web界面地址为:https://localhost:3000

或者内网IP+端口,这样局域网的其他人也可以访问到

image-20240511175350983

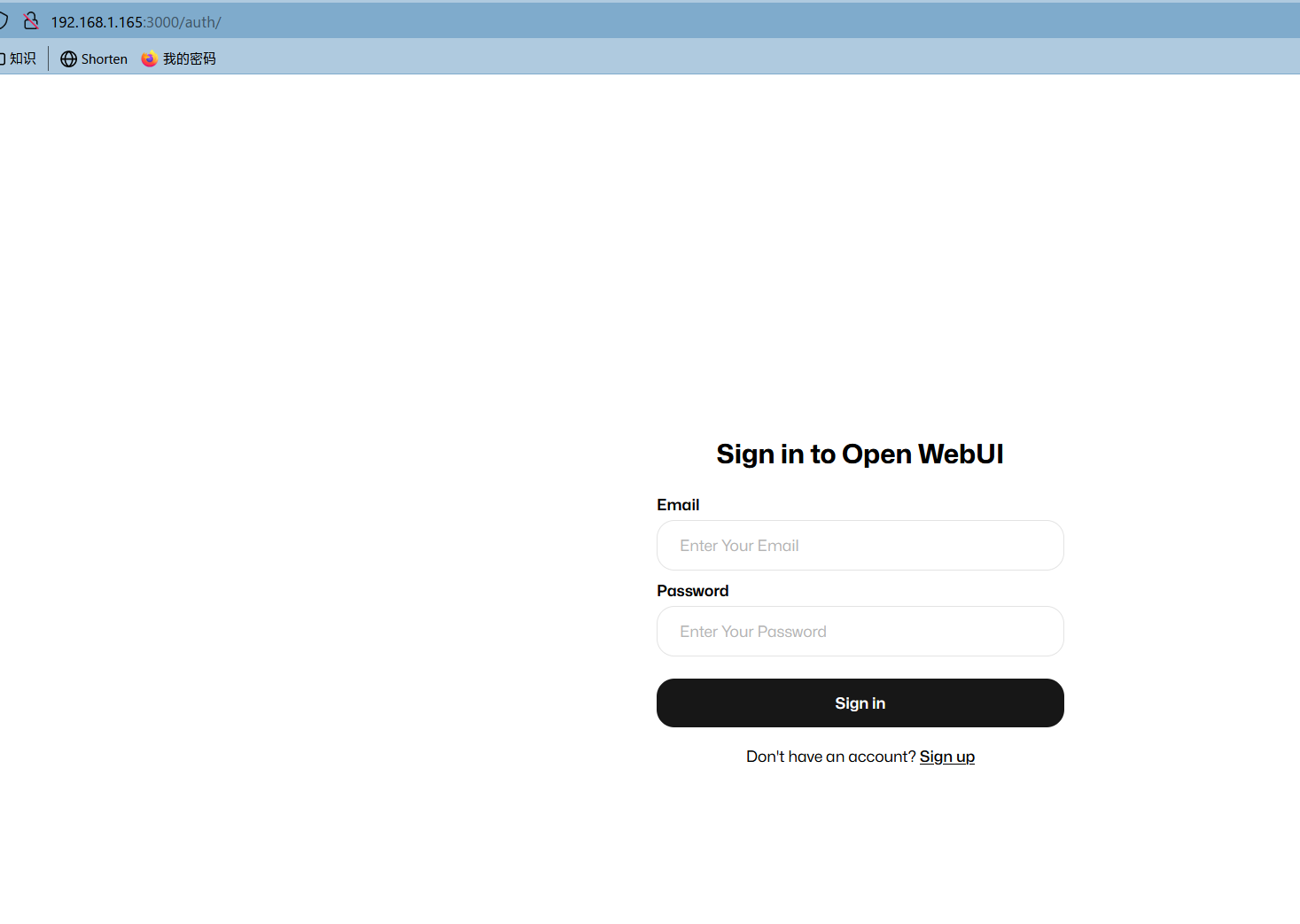

注册账号点击 sign up

登录

image-20240511175608965

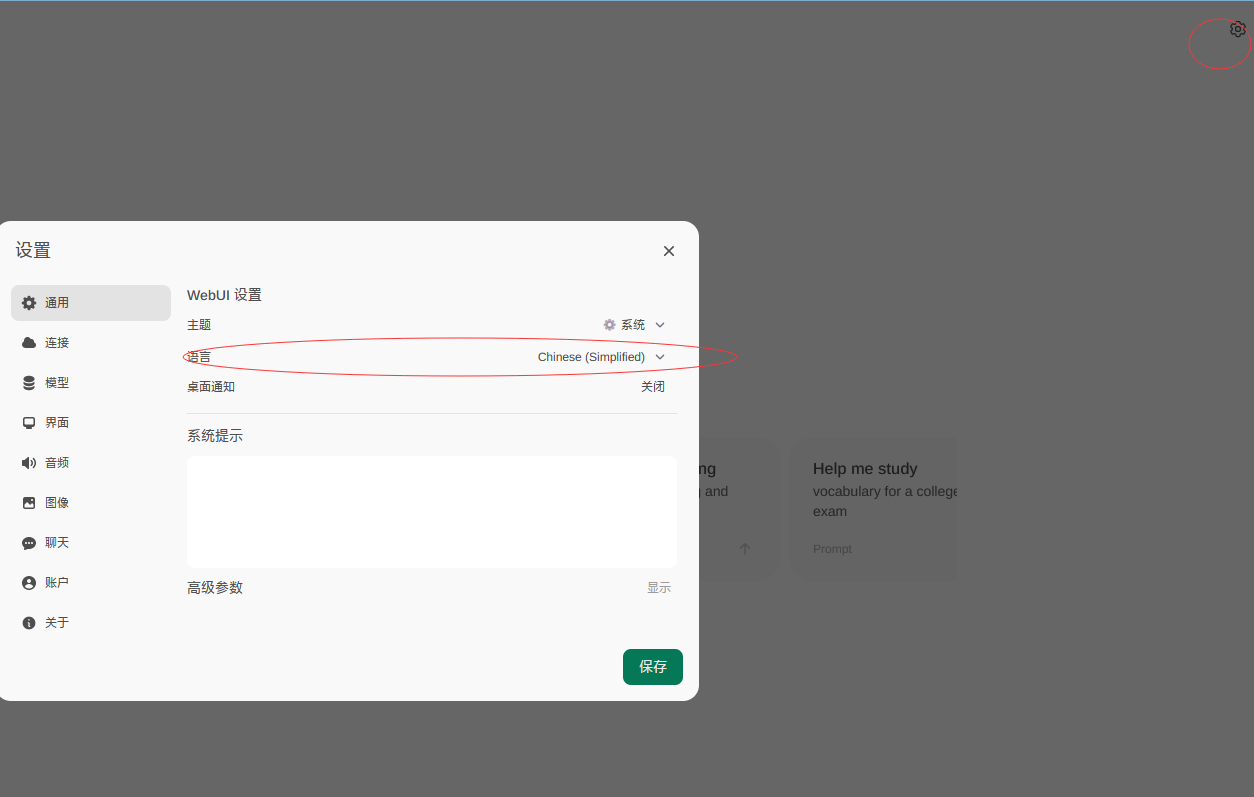

设置为简体中文

点击右上角的设置,可以修改当前界面的语言为简体中文:然后点击保存即可。

image-20240511175737460

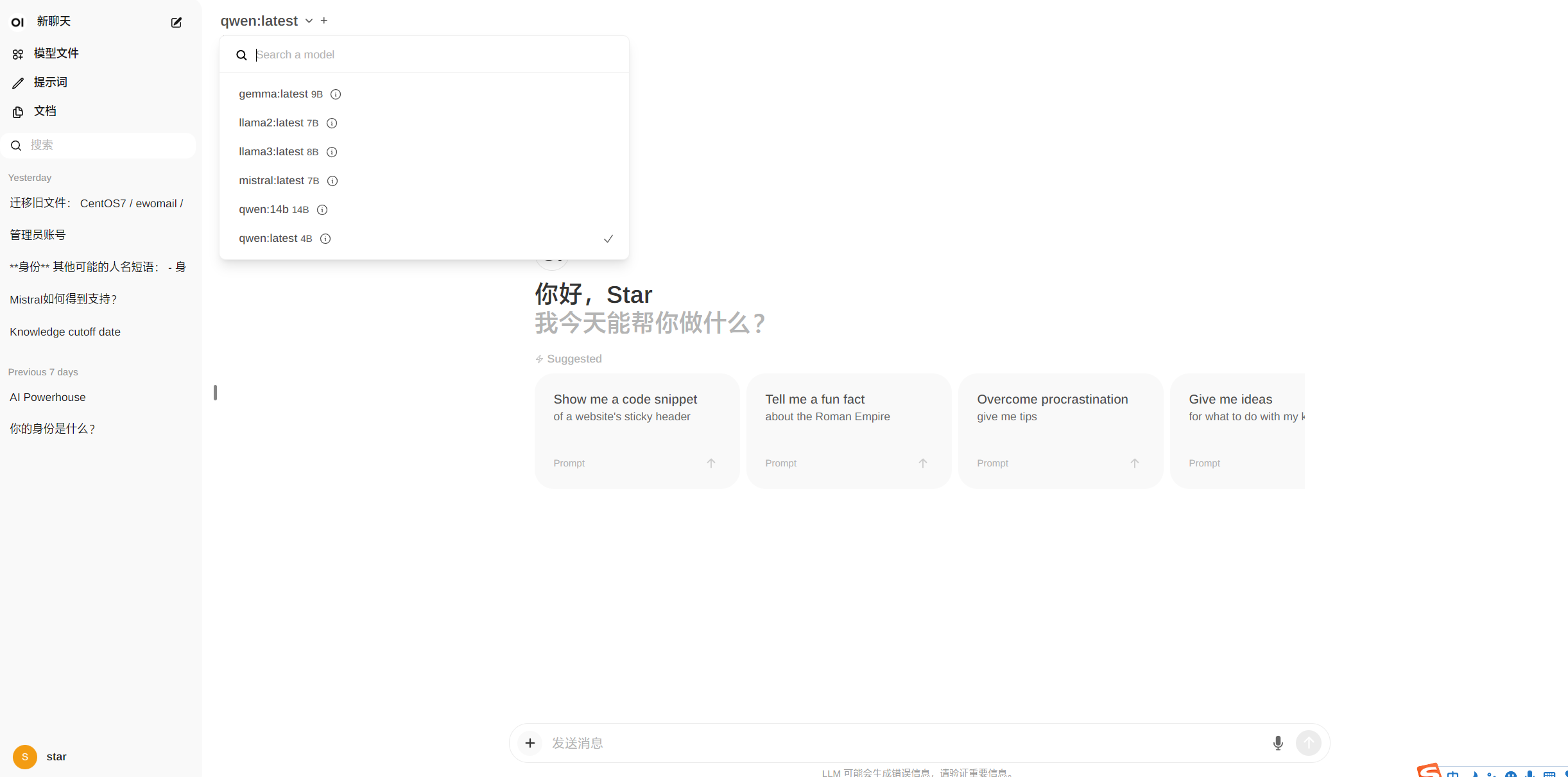

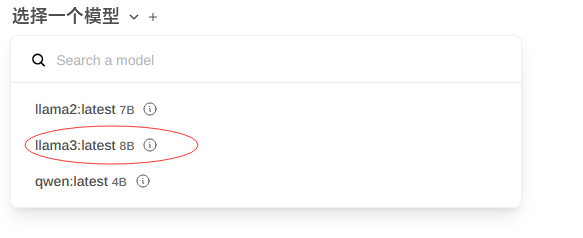

点击上方选择一个模型旁边的加号+可以增加大模型,点击下拉按钮可以选择当前使用哪一个已安装的模型,接下来就可以愉快的跟ai聊天了!

image-20240511175902435

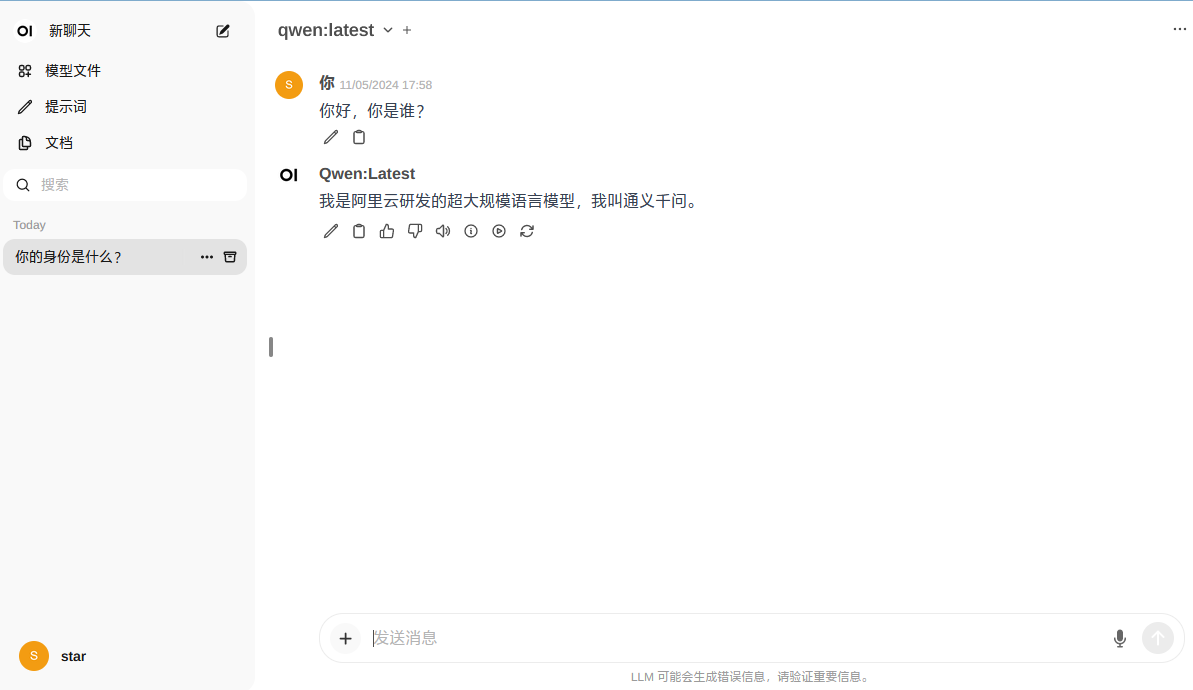

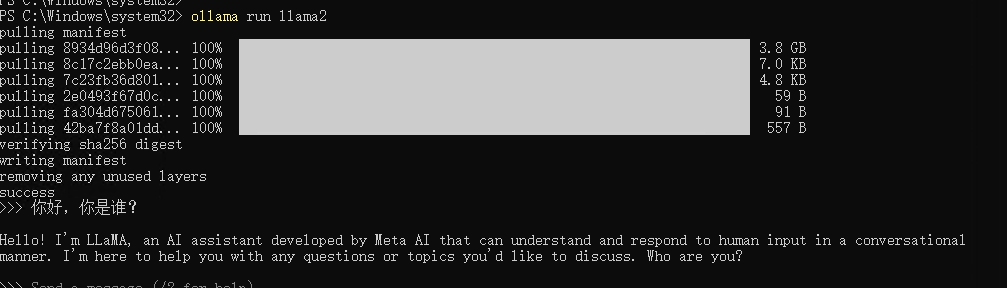

使用llama2(3.8G)

在power shell中输入

ollama run llama2安装完成如图:

image-20240511180531152

在Open WebUI中会新增一个llama2:latest 7B

image-20240511180736354

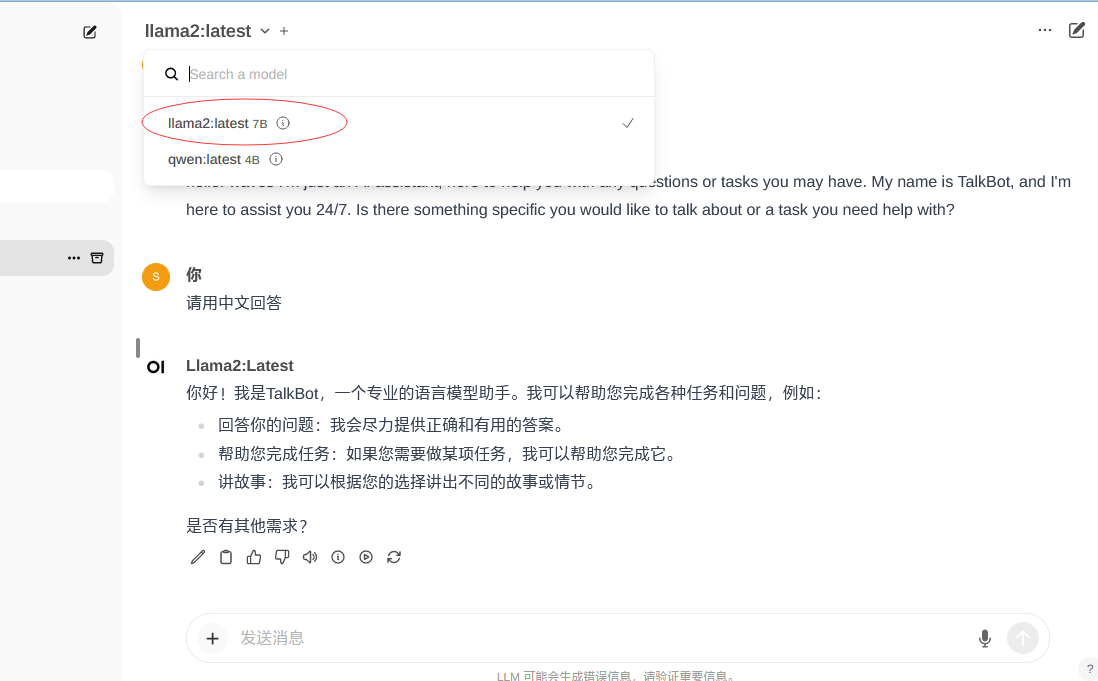

使用llama3(4.7G)

ollama run llama3

image-20240513110343869

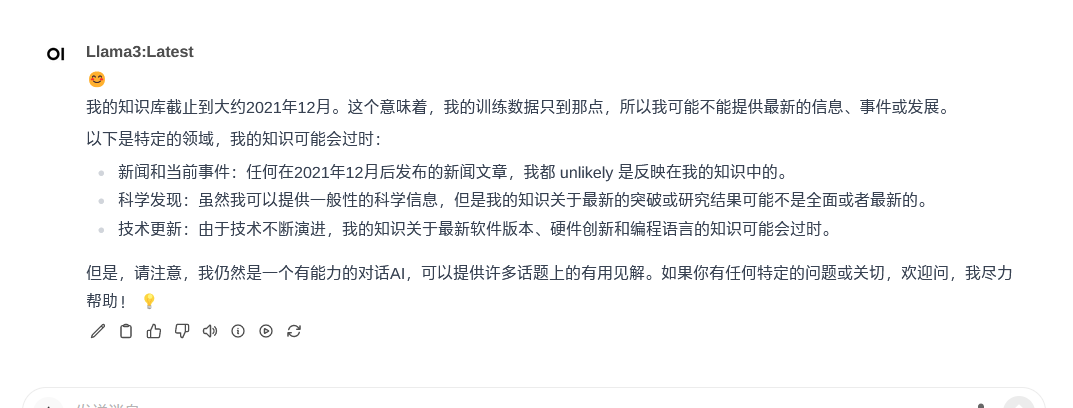

在Open WebUI中会新增一个llama3:latest 8B

image-20240513110414767

image-20240513110526936

使用Mistral(4.1G)

Mistral 7B 是 Mistral AI 发布的 70 亿参数语言模型。 Mistral 7B 是一种精心设计的语言模型,可提供高效和高性能以支持实际应用程序。 由于效率的提高,该模型适用于需要快速响应的实时应用。 发布时,Mistral 7B 在所有评估基准中均优于最佳开源 13B 模型 (Llama 2)。

安装:

ollama run mistral

image-20240513111621060

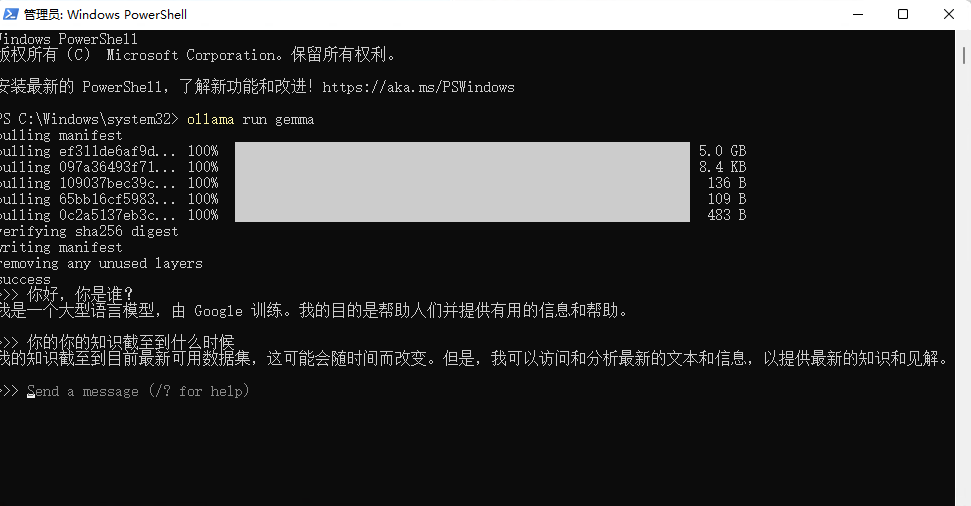

使用gemma(5.0G)

ollama run gemma

image-20240513112439003

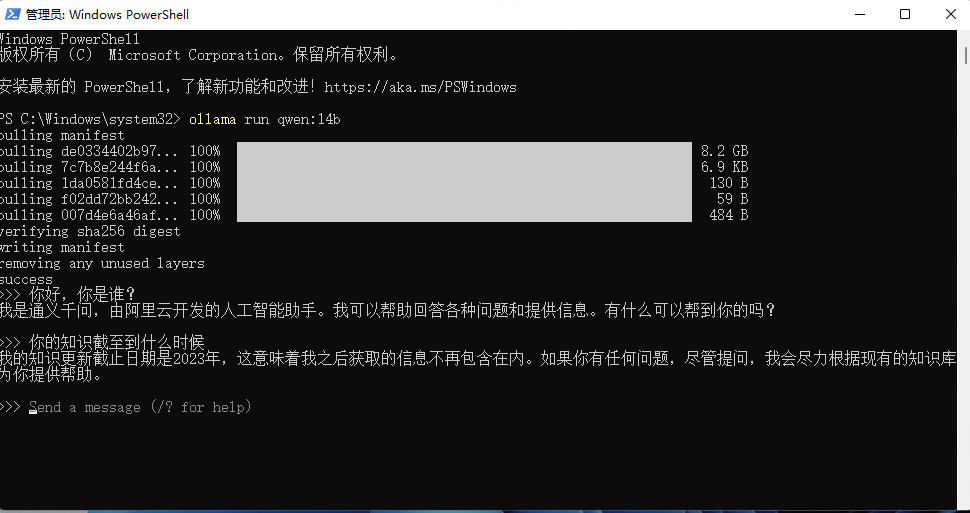

使用qwen:14b(8.2G)

ollama run qwen:14b

image-20240513113857374

结语

安装Ollama完成之后就可以在本地愉快的使用大模型了。

例如支持gemma(谷歌大模型)、llama2(脸书大模型)、qwen(阿里大模型)等70+主流大模型,还在不断增加。

原创声明:本文系作者授权腾讯云开发者社区发表,未经许可,不得转载。

如有侵权,请联系 cloudcommunity@tencent.com 删除。

原创声明:本文系作者授权腾讯云开发者社区发表,未经许可,不得转载。

如有侵权,请联系 cloudcommunity@tencent.com 删除。

评论

登录后参与评论

推荐阅读

目录