智谱AI推出GLM-4,性能逼近ChatGPT-4

原创智谱AI推出GLM-4,性能逼近ChatGPT-4

原创

存内计算开发者

发布于 2024-06-14 17:06:30

发布于 2024-06-14 17:06:30

随着人工智能技术的持续发展,神经网络的参数数量已经从Alexnet的6000万个增长到OpenAI GPT-3的1750亿个,人工智能已进入大模型时代。ChatGPT、GLM-4、Claude3等大模型不断涌现,本文将详细介绍智谱AI所推出的GLM-4大模型,分析其背景、性能、应用等。

- 发展背景

在大模型时代已经到来的今天,国内外诸多企业和高校已经投身到新一代大模型的研发中。例如美国人工智能研究公司OpenAI持续推出了多个人工智能大模型,极大地便利了人们的生活,而国内厂商也在加快研发,逐渐展露头角。例如,北京智谱华章科技有限公司(简称“智谱AI”)致力于打造新一代认知智能大模型,专注于中文认知大模型。智谱AI合作研发了中英双语千亿级超大规模预训练模型GLM-130B,并基于此推出对话模型ChatGLM,开源单卡版模型ChatGLM-6B。同时,公司团队还打造了AIGC模型及产品矩阵,包括AI提效助手智谱清言、高效率代码模型CodeGeeX、多模态理解模型CogVLM和文生图模型CogView等。此外公司践行Model as a Service(MaaS)的市场理念,推出大模型MaaS开放平台,打造高效率、通用化的“模型即服务”AI开发新范式[1]。2024年6月5日,智谱AI推出第四代GLM系列开源模型GLM-4-9B,并对大模型Maas开放平台进行了一系列更新,这是一种参数量低于10B(100亿)的小模型,但是在某些方面的性能却能比肩ChatGPT-4。今天,我们将聚焦于GLM-4这款由智谱AI推出的国内大模型,详细分析其性能和应用等。

图 1 智谱AI公司logo(图源:智谱AI)

- 性能介绍

2024年1月16日,智谱AI发布基座大模型GLM-4,其性能实现超进化,性能评测相比上一代提升接近60%,整体评测结果逼近GPT-4,且在处理长文本、多模态任务和智能体(Agent)能力方面表现出色。

图 2 GLM-4与ChatGPT4对比(图源:智谱AI)

在以下四个能力方面的更新,是GLM-4最大的亮点:

1)多模态能力:推出了CogView3代,效果超过开源SD模型,逼近 DALLE-3;

2)ALL Tools能力:GLM-4能自主理解复杂指令,自由调用WebGLM搜索增强、Code Interpreter代码解释器和多模态生成能力,完成复杂任务;

3)GLMs个性化智能体定制:用户可以通过智谱清言官方网站创建属于自己的GLM智能体,无需编程基础;

4)MaaS平台和API:GLM-4登陆了Maas平台,提供API访问,支持开发者内测Assistant API[2]。

图 3 GLM-4多模态能力展示(图源:智谱AI)

具体来说:1)在处理长文本方面,GLM-4可以支持128k的上下文窗口长度,单次提示词可以处理的文本可以达到300页。在“大海捞针”测试中,GLM-4能够在128K文本长度内实现几乎100%的精度召回,没有出现长上下文全局信息因为失焦而导致的精度下降问题;2)在多模态能力方面,GLM-4可以结合文本、图像、代码等多种类型的数据来完成复杂的任务;3)GLM-4强大的智能体能力可以根据用户意图自动理解、规划复杂指令,并自由调用各种工具来完成任务。这种智能体能力使得GLM-4在实际应用中具有更高的灵活性和实用性[3]。

图 4 GLM-4各能力对比图(图源:智谱AI)

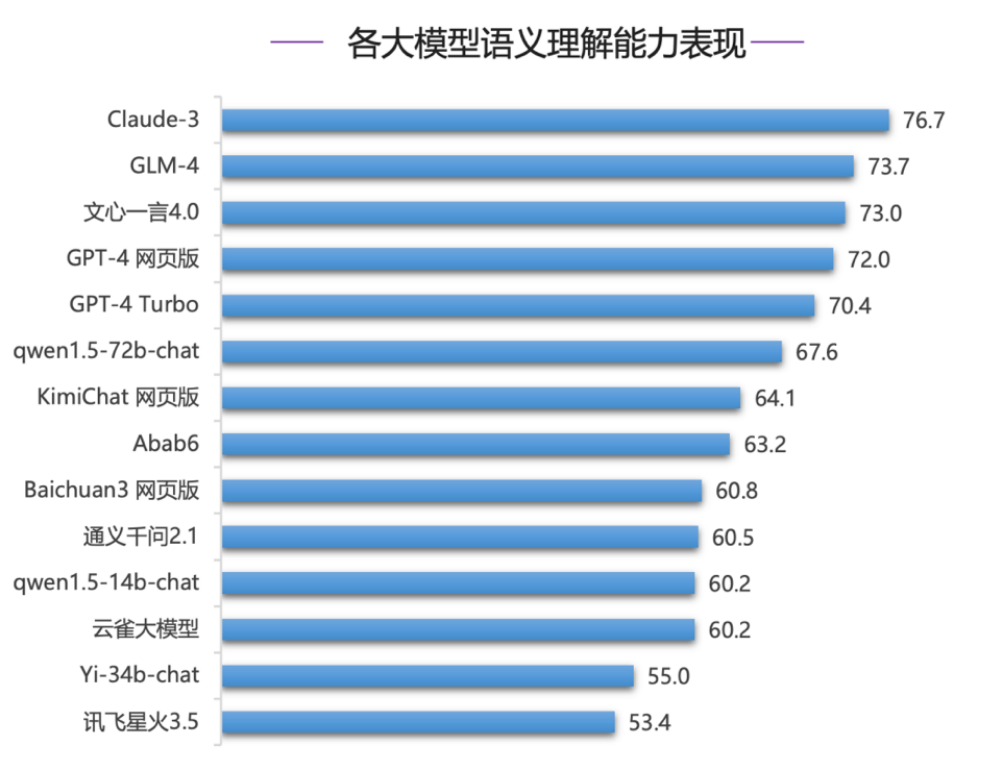

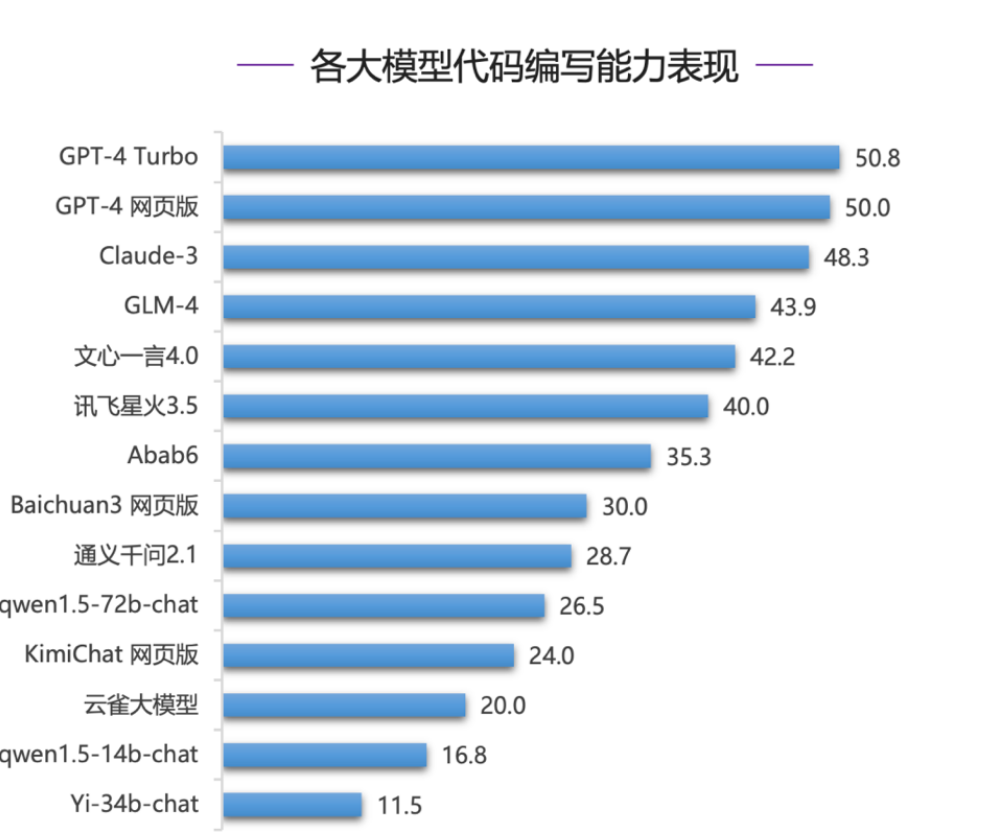

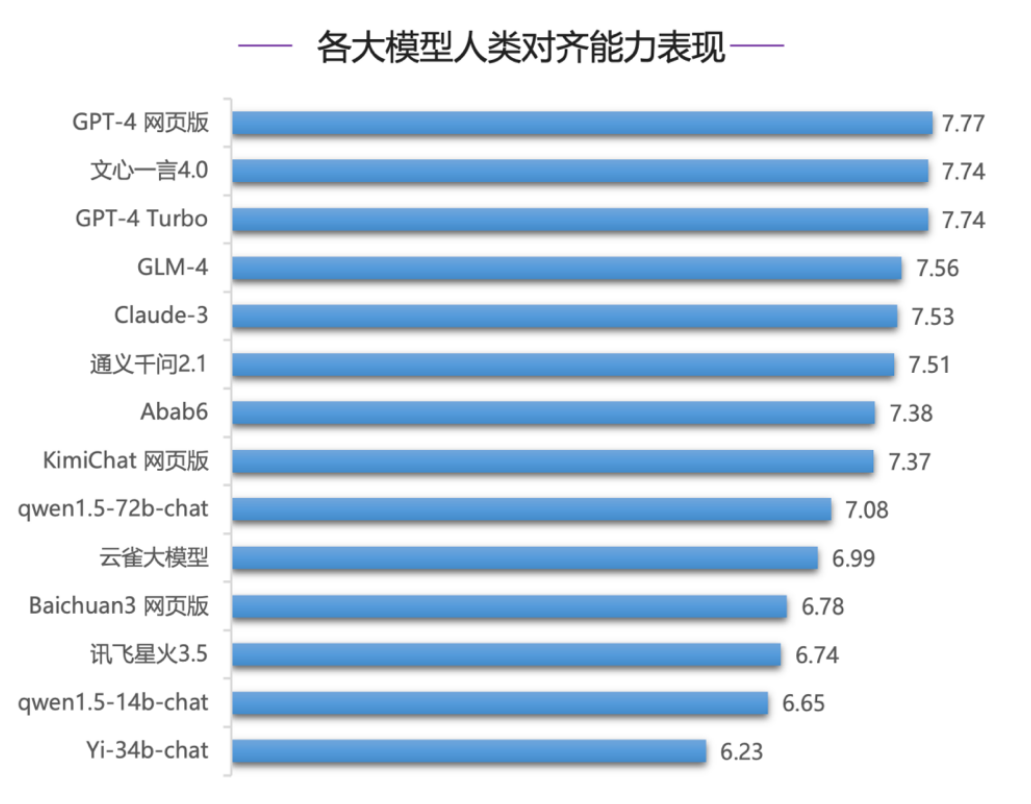

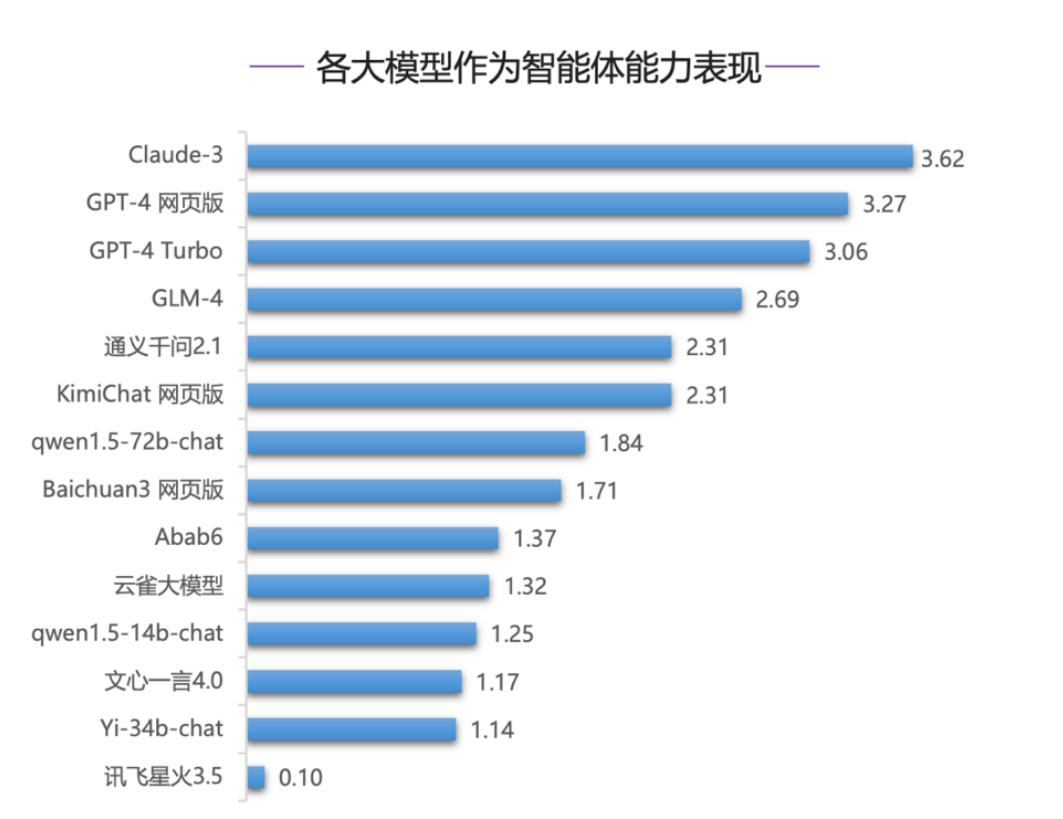

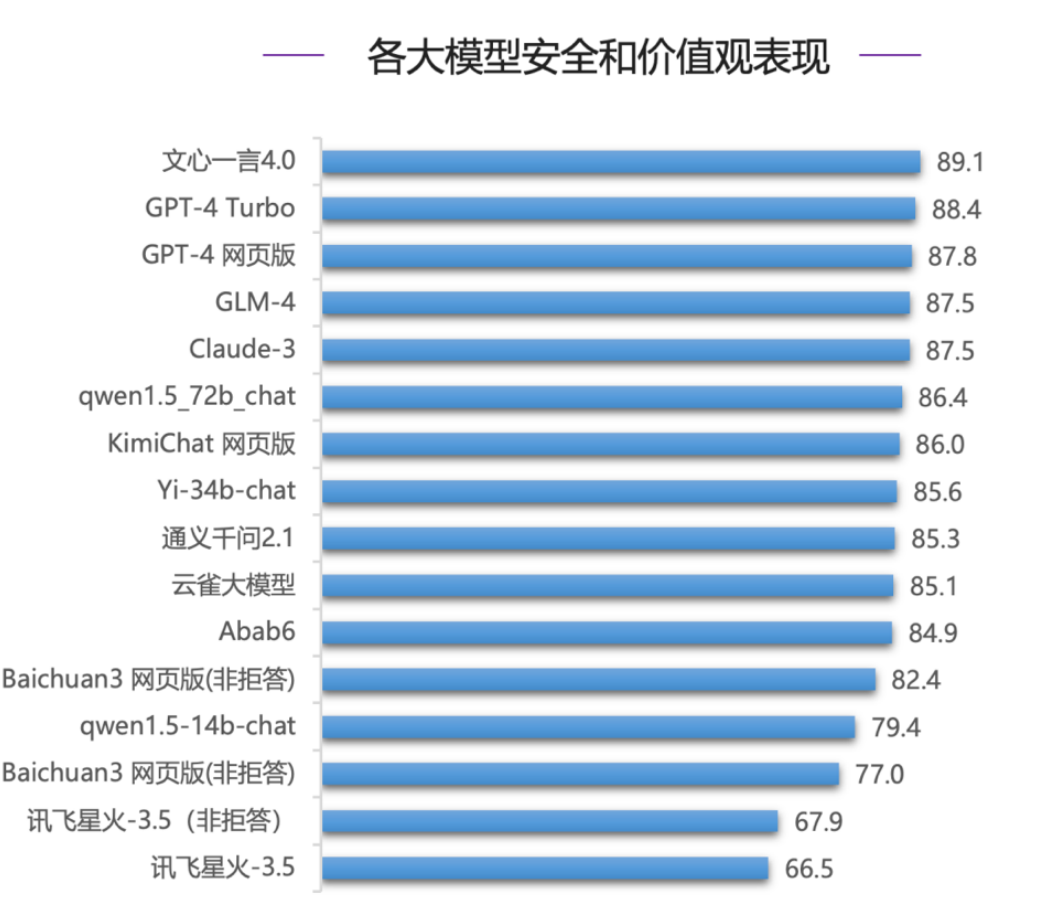

在2024年3月发布的《SuperBench大模型综合能力测评报告》[4]中,清华大学基础模型研究中心对14个海内外具有代表性的模型进行了测试,在测评结果中,GLM-4表现亮眼,与国际一流模型水平接近,且差距已经逐渐缩小。

在大模型语义理解能力表现层面,GLM-4超过GPT-4位居第二位,但是与Claude-3有3分差距。

图 5 各大模型语义理解能力表现

在大模型代码编写能力评测层面,GPT-4系列模型、Claude-3模型在代码通过率上明显领先, GLM-4表现突出,综合得分达到43.9;然而,国内大模型即使是表现最好的GLM-4在代码的一次通过率上仍只有50%左右,代码生成任务对目前的大模型来说仍是一大挑战。

图 6 各大模型代码编写能力表现

在大模型人类对齐能力评测中,GPT-4网页版占据榜首,GLM-4表现优异,超越Claude-3,位列第四。

图 7 各大模型人类对齐能力表现

在作为智能体能力评测中,国内模型整体稍微落后,GLM-4在国内模型中表现最好,但与榜首的Claude-3仍有差距。

图 8 各大模型作为智能体能力表现

在安全能力评测中GLM-4和Claude-3同分,并列第四,与GPT-4评测得分十分接近。

图 9 各大模型安全和价值观能力表现

- 应用前景

基于上述GLM-4大模型的特点,它拥有着广阔的应用前景。GLM-4系列模型提供了多种版本可供用户选择,可主要分为在线版(chatglm.cn)和端侧版(GLM-4-9B)。

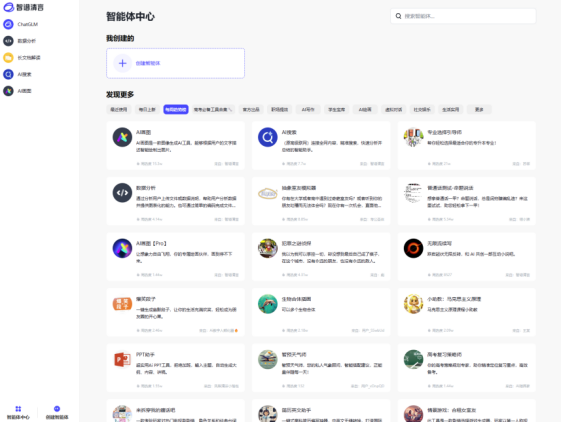

相比于其他同类在线大模型,在线版GLM-4具备更高的个性化程度。在智谱清言的网站上,提供了一系列基于GLM模型定制的智能体(即提供预设提示词和知识库配置的大模型)供用户选择符合使用场景的预设使用。

图10 智谱清言网站内的智能体中心

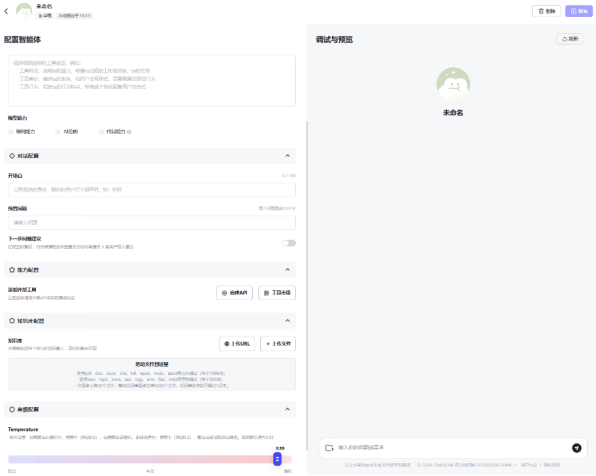

图11 用户自定义智能体界面

用户也可以根据自己的需求配置个性化的智能体。智谱清言允许用户对知识库、输出随机性、外部API能力进行进一步配置,结合GLM-4模型本身的强大功能,可以进一步匹配大模型工具与用户的适用场景。

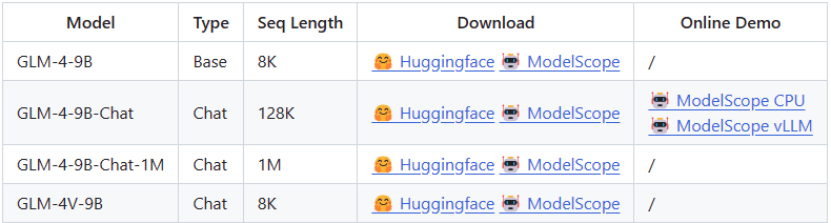

GLM-4的端侧版本在个性化程度和能力上同样具有优势,在语义、数学、推理、代码和知识等多方面的数据集测评中,GLM-4-9B及其人类偏好对齐的版本GLM-4-9B-Chat均表现出超越此前已被证明很强的端侧大模型Llama-3-8B的卓越性能。GLM-4的端侧版本根据模型种类、token序列回溯长度和是否具备多模态处理能力分为了多个版本,适应不同用户、不同硬件资源情况条件下的部署的需求。该模型提供了INT4版本,可以在显存不足的本地环境(8G显存设备)中配置使用[5]。相关资源可前往GitHub仓库(https://github.com/THUDM/GLM-4?tab=readme-ov-file)下载和配置。

图12 GLM-4-9B模型列表

本地部署模型还意味着用户可结合使用场景,对模型进行重新训练或微调,使GLM-4-9B模型如虎添翼。借助GLM-4-9B的强大长文本、指令遵循能力,使用者可以将其用作智能客服/聊天机器人,或进行实施文本分析,帮助社交媒体监控、新闻分析等领域工作者快速处理需求[6]。

出于个人隐私的考量,端侧模型因无需上传用户信息至云端服务器,而越来越受到人们青睐,如何以更低的参数量实现相近的效果,或是以相同的参数量实现更好的性能,都是端侧大模型面临的挑战,在这一问题上,GLM-4-9B已经提供了让人满意的阶段性答卷。我们也希望能早日看到大模型部署在存算一体芯片等极具潜力的端侧神经网络加速器上,为用户提供便捷、隐私的大模型服务。

参考文献

[1]智谱AI官网(https://www.zhipuai.cn/).

[2]极客公园.智谱 AI 推出新一代基座大模型 GLM-4,能力逼近 GPT-4,配备多模态、长文本和智能体(https://www.geekpark.net/news/330441).

[3]北京日报客户端1-17.孙奇茹. 中文能力比肩GPT-4,国产大模型GLM-4上线(https://www.tsinghua.edu.cn/info/1182/109397.htm).

[4]SuperBench大模型综合能力评测报告(https://blog.csdn.net/cf2suds8x8f0v/article/details/137942965).

[5]bilibili专栏- 低显存本地搭建chatglm int4量化版(作者:时之纪元).

[6]公众号专栏- GLM-4最新开源版本硬核测评!Datawhale成员万字测评(一)(作者:Datawhale).

原创声明:本文系作者授权腾讯云开发者社区发表,未经许可,不得转载。

如有侵权,请联系 cloudcommunity@tencent.com 删除。

原创声明:本文系作者授权腾讯云开发者社区发表,未经许可,不得转载。

如有侵权,请联系 cloudcommunity@tencent.com 删除。

评论

登录后参与评论

推荐阅读