XRec: 大模型如何重塑推荐系统的可解释性

TLDR: 这篇文章给大家分享来自香港大学数据智能实验室最近推出的智能推荐大模型XRec,旨在利用大语言模型为推荐系统提供基于自然语言的可解释性。

论文:https://arxiv.org/pdf/2406.02377 代码:https://github.com/HKUDS/XRec 主页:https://sites.google.com/view/chaoh

导读

传统推荐系统虽然能给出准确的推荐结果, 但缺乏对推荐逻辑的解释, 难以让用户真正理解和信任。让推荐系统能以自然语言向用户阐述其推荐依据, 不仅能增强用户的理解, 还能促进他们与系统的互动, 从而获得更满意的体验。

与此同时,可解释性推荐系统可以增强推荐系统的智能化。自然语言模型具有深入理解用户需求和偏好的能力, 能够形成更细致入微的用户画像。基于这种丰富的用户洞见, 推荐系统不仅能做出更精准的推荐, 还可以为用户提供有价值的决策支持, 进一步提高系统的智能化水平。总的来说, 可解释性推荐系统有助于实现人机协作, 推动推荐技术的发展。

因此,基于提升用户体验和增强推荐系统智能化的动机, 受启发于大语言模型强大的自然语言能力, 港大数据智能实验室致力于开发能够让推荐系统具备可解释性语言能力的大模型。

这一方向的研究旨在突破传统推荐系统的局限性, 让推荐系统不仅能给出精准的结果, 还能用通俗易懂的语言向用户解释其推荐依据。通过整合大语言模型的语义理解能力和协同过滤的用户偏好建模, 港大数据智能实验室正在探索构建一种"可解释推荐"(XRec)大模型框架, 使推荐系统具备洞察用户需求、生成准确解释的智能化水平。

这种融合自然语言处理和推荐系统的创新尝试, 不仅能大幅提升用户体验, 增强他们对推荐结果的理解和信任, 也将为推荐技术的发展注入新的活力, 最终实现人机协作, 为用户提供更优质的智能服务。

模型方法

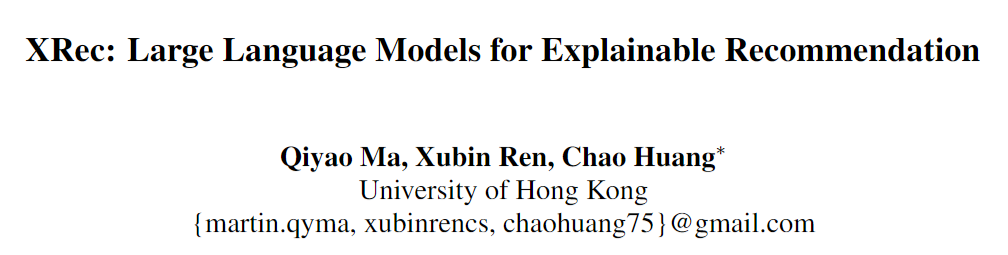

XRec 利用大型语言模型 (LLMs) 为推荐系统的输出提供丰富的自然语言解释。通过整合协作信号并采用轻量级推荐信号适配器,XRec 深入理解用户偏好和用户-物品交互中的复杂模式。该框架在具有挑战性的零样本场景中, 展现了其在未见用户和物品方面的出色泛化能力。

协同关系Tokenizer

为了有效地捕捉大量用户和商品之间的协作关系, 以及反映他们的交互模式, 自然语言的表达能力是不足的, 但表征(representation)提供了一种强大的替代方案。在我们的XRec系统中, 我们利用图神经网络 (GNNs) 作为协同信号的tokenizer,将复杂的用户-商品交互关系信息编码到潜在的嵌入空间中, 从而实现对复杂用户偏好的有效建模。具体而言, 我们的协作图 tokenizer 基于图神经网络的消息传递机制(message passing), 在用户-商品交互图中进行信息的传播和聚合, 促进用户和商品节点表征的学习。这样不仅能够更好地捕捉节点之间的关联, 还能够反映出复杂的交互模式。

大语言模型的输入适配器

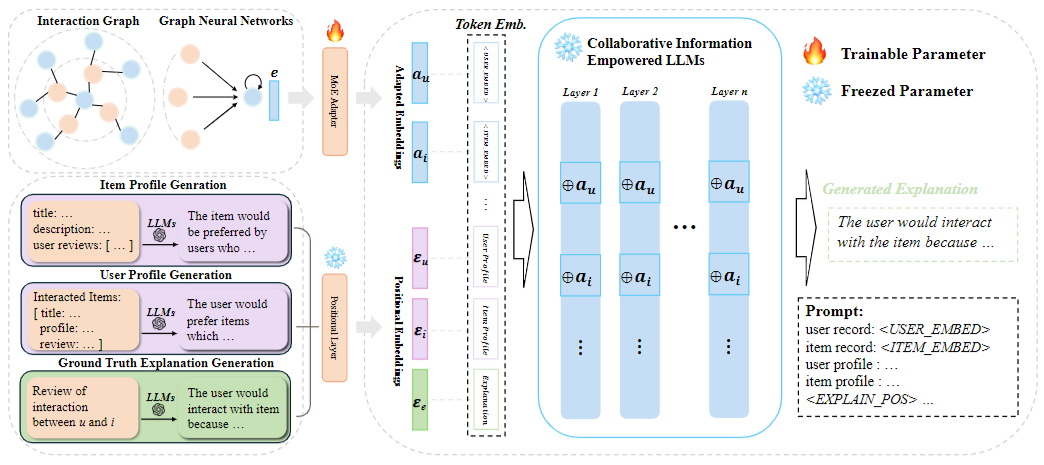

协同信息适配器 (Collaborative Information Adapter)鉴于用户-商品交互行为所反映的协同信息, 其语义表示空间(embedding space)可能与用户和商品的文本语义存在差异, 我们的XRec模型配备了一个轻量级但有效的适配器模块。此适配器的作用是对这些不同的语义模态进行对齐, 使我们的模型能够有效地融合利用协同信号和文本语义, 从而提升整体的建模能力。

协同过滤(CF)与大语言模型(LLM)的融合在对嵌入进行新的适配之后, 我们现已做好将协同信息融入大语言模型的准备。我们引入了特殊的标记(tokens)来保留输入提示中的空间, 然后将提示转换为token嵌入后, 将已适配的嵌入注入到这些保留的位置中。

然而, 由于每个节点嵌入在输入提示中仅由一个单一的token表示, 随着输入长度的增加, 分配给每个嵌入token的注意力权重(attention weight)不可避免地会减弱, 这可能导致协同信息的损失。为了解决这种影响力的稀释问题, 我们将适配后的嵌入扩展到LLM的初始输入提示之外。具体来说, 我们将它们注入到LLM每一层的保留位置中。为了促进这一过程, 我们修改了LLM内部每一层的query、key和value投影函数如下:

我们用表示查询(query)、键(key)和值(value)的投影矩阵, 用表示适配后的嵌入。我们的方法确保大型语言模型(LLMs)不仅在输入阶段, 而且在整个网络结构中都能不断访问和整合协同信息。通过将基于图的知识注入到LLMs的所有层中, 我们不仅保持了协同上下文的强大表征, 还使得直接回到专家混合(MoE)模块的梯度流更为有效。这种创新的语言建模和图表示学习的融合, 使我们的模型能够利用LLMs提供的深层语境洞见, 同时从图神经网络(GNN)识别的结构模式中获益。

损失函数

为了提升大型语言模型(LLMs)生成语境和句法连贯解释的能力, 我们的目标是最小化预测下一个token的概率与实际下一个token之间的损失。我们采用负对数似然(Negative Log Likelihood, NLL)作为训练损失, 计算公式如下:

其中, N 为解释的数量, 为每个解释中的字符计数, 和 ŷ 分别表示实际和预测的token。为了降低训练复杂度, 我们冻结了LLMs内部的所有参数, 不包括与图神经网络(GNN)训练过程的任何交互。唯一可训练的参数是在基于专家混合(Mixture of Experts, MoE)的适配器模型中的参数。

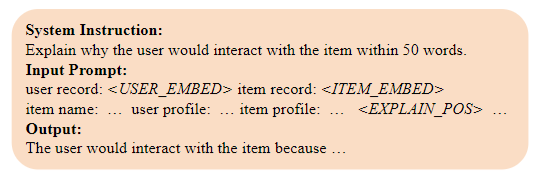

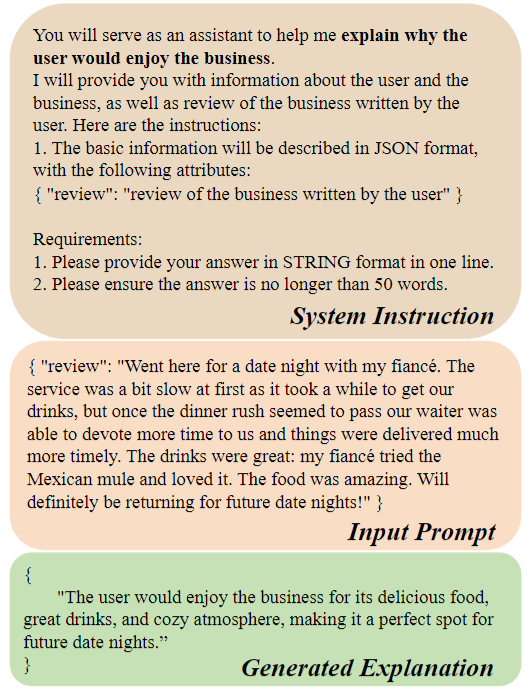

基准解释的生成

之前的研究直接使用用户评论作为推荐系统的基准解释。然而, 这些评论往往带有主观色彩, 可能只是隐含地传达了用户的意图或情绪。为了解决这一限制, 提高基准解释的质量, 我们创新性地使用大型语言模型(Large Language Model, LLM)从原始评论中提取出明确的用户意图。

实验验证

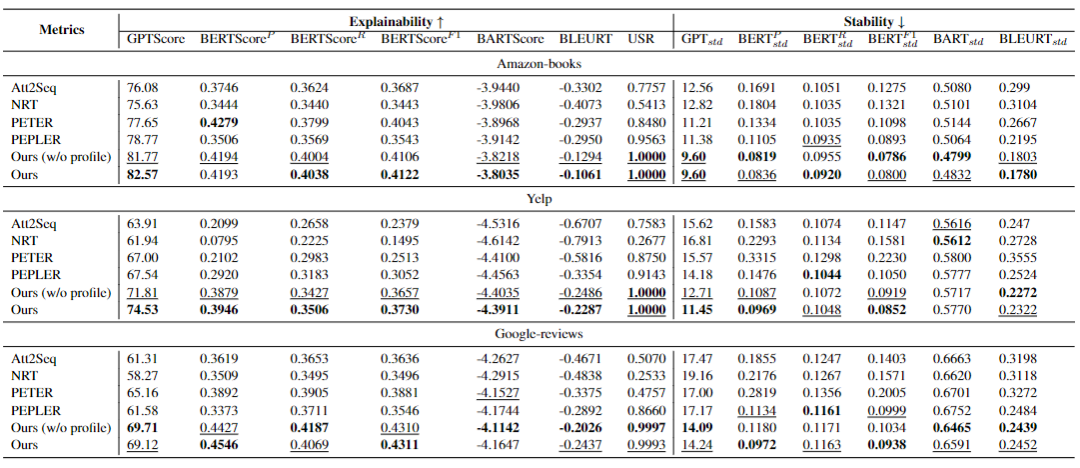

我们在三个公开数据集(Amazon-books、Yelp和Google-reviews)上使用GPTScore、BERTScore等指标评估了XRec模型。实验结果表明, XRec在可解释性和稳定性方面均显著优于所有基准模型(Att2Seq、NRT、PETER和PEPLER)。

模型鲁棒性的探索

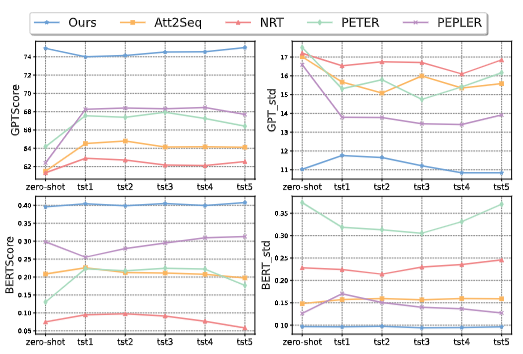

为了评估模型的泛化能力, 我们在不同数据稀疏性的数据集上进行了实验。根据用户在训练数据中出现的频率, 我们将测试数据划分为五个子集(tst1到tst5)。这使我们能够系统地检查模型在不同用户熟悉度范围内的有效性, 从罕见到频繁的用户。此外, 我们引入了一个零样本测试数据集, 其中仅包含训练期间未遇到的用户, 以测试模型解决冷启动问题的能力。

在零样本场景中, 由于缺乏任何先前的用户数据, 我们的模型不仅优于基线, 而且与其他子集(从tst1到tst5)的表现相当。这种能力对于新用户的推荐非常有价值, 也突显了我们方法在实际应用中的实用性, 其中用户行为和项目目录经常变化。

这些发现强调了我们的模型在传统推荐系统面临的挑战中的有效性, 例如涉及新用户或不频繁用户的情况。模型在零样本学习中的成功证明了其强大的泛化能力, 并突显了其解决冷启动问题的潜力, 即新用户或项目缺乏历史交互数据。通过在不同情境中保持高水平的可解释性和稳定性, 该模型证明了其适用于动态环境中部署, 其中用户行为和项目目录经常变化。

模型消融实验

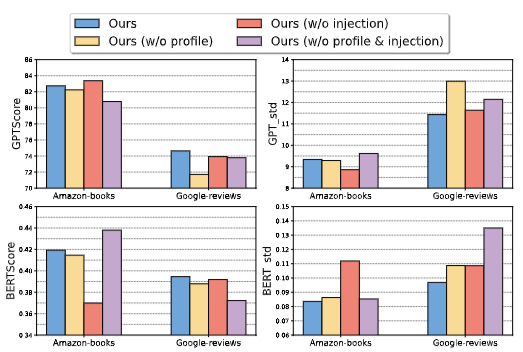

我们进行了消融实验, 以探索模型中两个关键组件的影响:用户/项目属性和协同信息的注入。我们比较了以下四种模型变体:

- 完整模型(Ours): 包含所有特性

- 无属性(Ours w/o profile): 省略了用户和项目属性

- 无协同信号注入(Ours w/o injection): 保留了对齐嵌入在提示中, 但未将其注入到LLM层

- 无属性&协同信号注入(Ours w/o profile & injection): 缺少属性和基于协同信号嵌入的注入

为了严格评估可解释性和稳定性, 我们使用GPTScore和BERTScore在Amazon-books和Google-reviews数据集上评估了这些变体, 包括它们的标准差。这揭示了每个元素在推动模型性能和能力方面的关键作用。结果显示, 我们的完整模型(Ours)在可解释性和稳定性方面优于其他变体, 突出了每个元素的重要贡献。

结语

本文提出了一个新颖的XRec框架, 它无缝集成了基于图的协同过滤范式和大语言模型(LLMs)的能力, 以生成对推荐输出的全面且富有洞察力的解释。通过利用用户-商品交互图中编码的固有协同关系, XRec能够有效捕获构成用户偏好和项目关联的高阶依赖性。XRec引入了一个专门的协同信息适配器, 作为建立协同信号(collaborative signal)与LLM内丰富的文本语义空间(embedding space)之间强连接的关键桥梁。

广泛的实验结果强调了XRec框架的显著优势。它不仅增强了推荐过程的可解释性, 还确保了在具有挑战性的零样本场景中的鲁棒性。XRec框架在这些场景中展示了强大的跨未见用户和项目的泛化能力。

本文参与 腾讯云自媒体同步曝光计划,分享自微信公众号。

原始发表:2024-06-12,如有侵权请联系 cloudcommunity@tencent.com 删除

评论

登录后参与评论

推荐阅读

目录