突破性进展:简单有效的新型Masked扩散模型革新语言生成,与自回归模型媲美

突破性进展:简单有效的新型Masked扩散模型革新语言生成,与自回归模型媲美

zenRRan

发布于 2024-06-18 17:00:54

发布于 2024-06-18 17:00:54

论文:Simple and Effective Masked Diffusion Language Models 链接:https://arxiv.org/pdf/2406.07524 代码:https://github.com/kuleshov-group/mdlm

1. 这篇文章想解决什么问题?

文章旨在解决扩散模型(diffusion models)在生成高质量图像方面表现出色,但在语言建模(language modeling)任务中与自回归(autoregressive, AR)方法存在显著性能差距的问题。作者指出,尽管扩散模型在生成离散数据(如文本、生物序列和图)方面具有潜力,但在语言建模的性能上,与AR方法相比,先前工作的扩散模型报告了较大的对数似然差距。

2. 论文用什么方法解决什么问题?

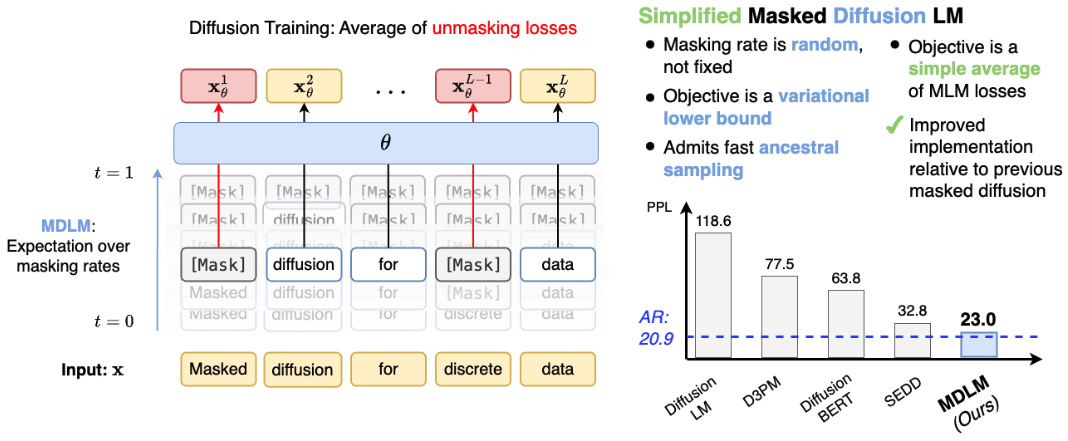

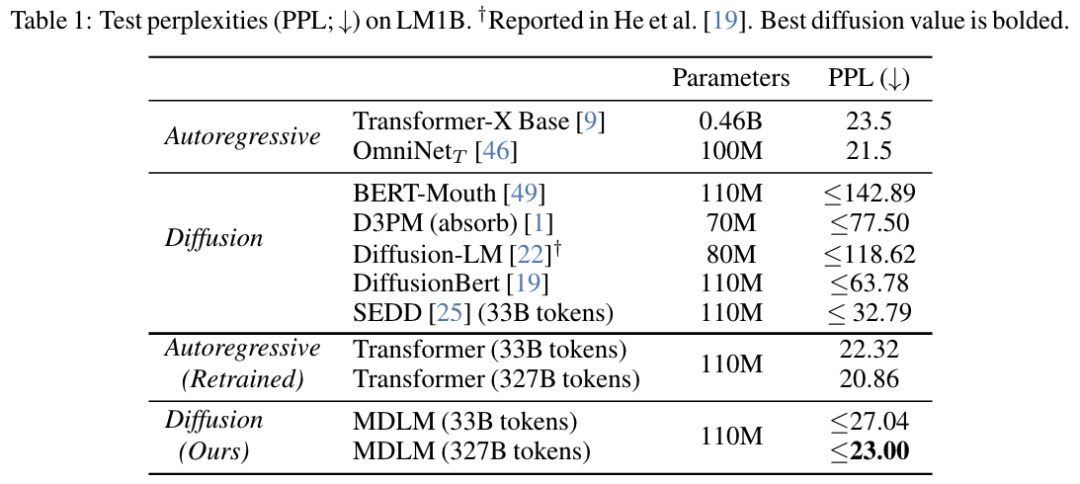

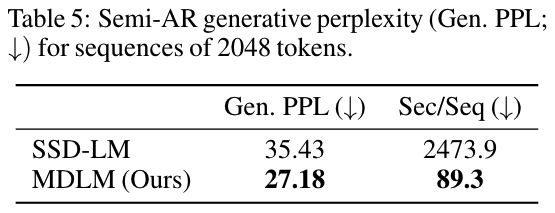

文章提出了一种简单的掩蔽扩散语言模型(Masked Diffusion Language Models, MDLM),并结合有效的训练策略来提高性能。作者开发了一个经过良好工程实现的MDLM,显著提高了离散扩散对数似然,并进一步通过一种基于替换的参数化(SUBS)来改进反向扩散过程,从而导出一个简化的、Rao-Blackwellized的连续时间变分下界(ELBO),提高了紧度和性能。此外,该目标具有简单的形式,是掩蔽语言建模(MLM)损失的加权平均,可以用于训练仅编码器的语言模型,这些模型具有高效采样器,包括能够像传统语言模型那样半自回归生成任意长度文本的采样器。

3. 论文做了哪些实验?

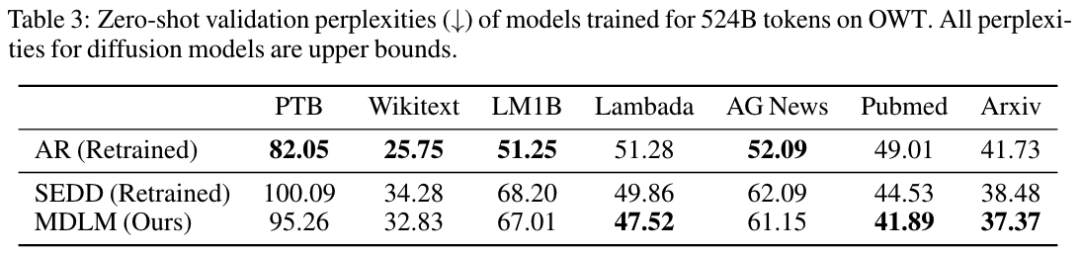

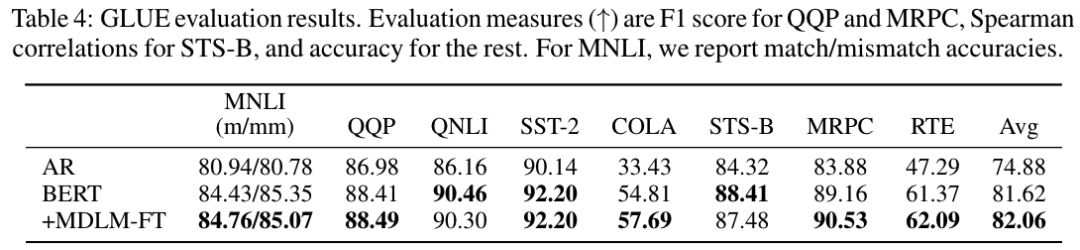

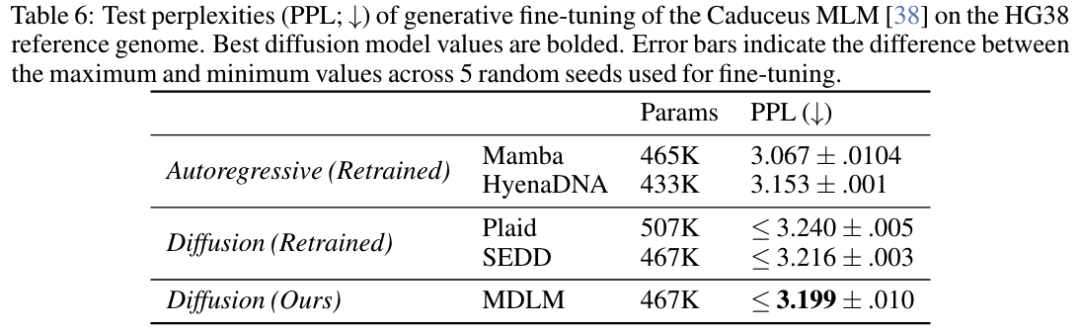

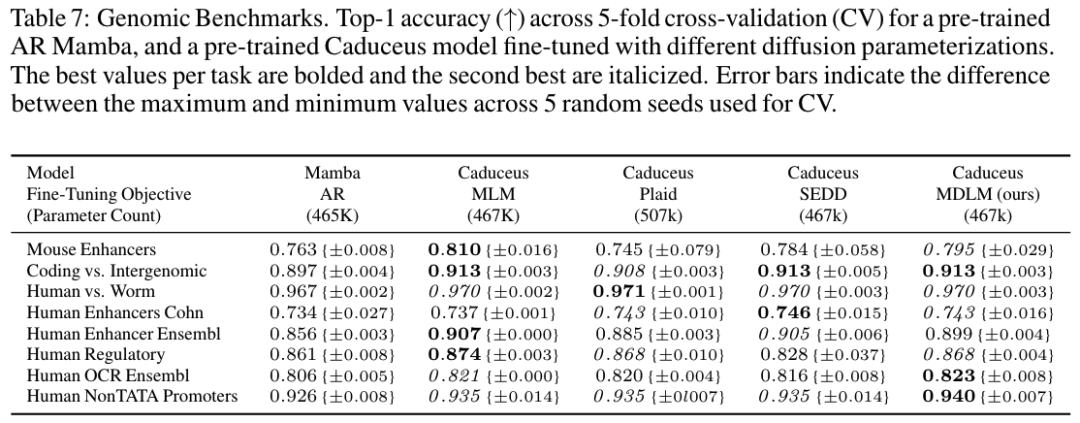

作者在语言建模基准测试中评估了MDLM,包括LM1B、OWT和DNA数据集。他们还对MDLM进行了零样本(zero-shot)评估,以测试模型在未见过的数据集上的泛化能力。此外,作者还在GLUE基准测试中评估了通过MDLM微调的BERT模型在下游任务上的表现。在基因组序列建模方面,作者预训练了DNA序列模型,并观察到与经典BERT风格训练相比,下游性能相似或更高,同时还引入了传统掩蔽DNA语言模型所缺乏的生成能力。

4. 论文或者方法有哪些局限性,未来工作是什么?

文章中提到,尽管MDLM在语言建模基准测试中取得了新的最佳性能,并且接近AR模型的困惑度(perplexity),但与AR模型相比,MDLM的性能仍有提升空间。此外,文章还提到了通过简单的工程选择显著提高了性能,这表明未来可能有更多的改进空间。关于未来工作,作者提到了将框架扩展到非语言领域的可能性,例如在生物序列建模方面的应用。文章还提到了在不同噪声方案下评估MDLM,并探讨了连续时间框架对于性能的影响。

文章的贡献在于提出了一个简单的MDLM框架,并通过有效的训练策略和简化的变分下界目标,显著提高了扩散模型在语言建模任务中的性能。此外,作者还提供了代码,以促进社区进一步的研究和开发。

kimi+人工共同完成

本文参与 腾讯云自媒体同步曝光计划,分享自微信公众号。

原始发表:2024-06-12,如有侵权请联系 cloudcommunity@tencent.com 删除

评论

登录后参与评论

推荐阅读

目录