ACL 2024 | 构建超关系知识图谱(KG),增强大模型多跳/Multi-hop QA问答能力!

ACL 2024 | 构建超关系知识图谱(KG),增强大模型多跳/Multi-hop QA问答能力!

ShuYini

发布于 2024-06-19 19:23:12

发布于 2024-06-19 19:23:12

点击上方“AINLPer“,设为星标

更多干货,第一时间送达

引言

对于非结构化文本,大模型 (LLM) 比较擅长回答简单(单跳)问题。然而,随着问题的复杂性增加,LLM 的性能会下降。本文作者认为其主要原因是,大模型在理解复杂问题和从原始文本中筛选、聚合非结构化信息过程中出现了性能问题。

为此,本文作者为了能让LLMs能够轻松回答复杂的多跳问题(Multi-hop QA),本文提出了HOLMES方法,该方法创建了一个以查询为中心的上下文感知超关系知识图谱(KG),经过剪枝该图谱只包含与查询相关的信息,并作为LLM的唯一输入,Multi-hop QA效果具有大幅提升。与最先进的方法相比,最高可节约67%Token,并在多个测试集上取得了一致性的提升。

https://arxiv.org/pdf/2406.06027

背景介绍

多跳问答 (MHQA) 是NLP领域中一项重要挑战。假如我们要提取某公司董事出现的相关数据信息。当面对单跳问题:过去十二个月举行了多少次董事会会议?利用当前大模型的能力,可以非常容易回答。然而,当面对多跳问题:过去十二个月中投票分歧最大的董事会会议,议程是什么,谁投了反对票,以及会议以多少票通过或未通过?回答该问题需要一系列的关联步骤。

其中,首先,要确定投票分歧最大的会议;接下来,确定该会议的主要议程;然后,列出投票反对的成员;最后,计算会议以多少票通过或未通过。「每一个步骤不仅需要检索更多信息,还需要对上下文和各个实体之间的关系有细致的理解」。这种复杂性凸显了 MHQA 的挑战性,其目标是浏览多层信息以找到答案。

当前的大模型可以看作是一个强大的工具,可以应用于各种NLP任务。然而,尽管 LLM 实力雄厚,但当其面临多跳QA任务时,往往会力不从心。本文作者认为,其主要原因是大模型在理解复杂问题和从原始文本中筛选、聚合非结构化信息过程中出现了性能问题。

为了解决该问题,有研究人员提出了StructQA,旨在从原始文本中提取 KG 三元组形式的结构化知识,并将其与 Chain-ofThought (CoT) 推理相结合。然而,提取的 KG 三元组不依赖于查询请求,并且缺乏这些事实有效的上下文。举个例子,对于KG三元组{title:“Apple”,relation:“价格上涨”,object:“10%”},如果没有额外的上下文,很难确定出实体”Apple“指的是水果还是公司,除此之外,StructQA 将提取的 KG 三元组和原始文本作为 LLM 的输入,导致Prompt明显变长和信息冗余。

为此,本文作者提出了HOLMES方法,该方法创建一个以查询为中心的上下文感知KG,并将其用作 LLM 的唯一输入,无需输入原始文本。

HOLMES方法

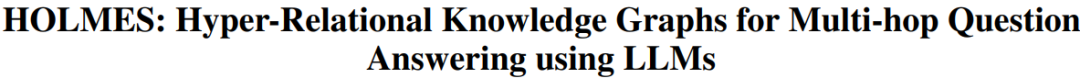

HOLMES的核心思想是识别包含多跳请求答案的文档子集,然后从中提取上下文感知的结构化信息。其核心步骤如下图所示:

「首先」,步骤1.a,其主要构建一个实体-文档图(Entity-Document Graph),该图只有两个节点:实体和文档,且通过一个单一的关系链接到一起。

「然后」,通过从查询中识别命名实体并使用它们进行广度优先搜索,利用大型语言模型直接从原始文本生成三元组。进一步将这些三元组增强为包含源文档标题的超关系四元组,为模型提供必要的上下文信息。在遍历过程中,以当前实体节点作为主语或宾语来过滤超四元组,并将对应实体添加到遍历队列中。超关系知识图谱如上图2所示。

「接着」,构建请求对齐图架构,如图1.b所示。该步其主要原因是,前面步骤构建的超关系图谱可能会存在无用的关系,该步骤是为了消除这些无关的影响。这里使用两种来源来填充这个架构:一是通过推理查询派生架构元素;二是利用领域内问题派生的辅助图架构来丰富架构。最后通过修剪过程,使用查询对齐的图架构来精炼超关系知识图,以提取最相关的组成部分,从而提高大型语言模型在生成答案时的效率和有效性。

「最后」,将修剪后的超关系知识图谱中的每个超三元组转换为自然语言句子,并通过特定的符号连接成长句子。然后,根据与知识架构的相似度得分,将句子按降序排列形成输入提示,确保与查询最相关的信息最接近查询。

实验结果

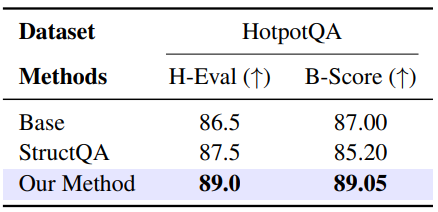

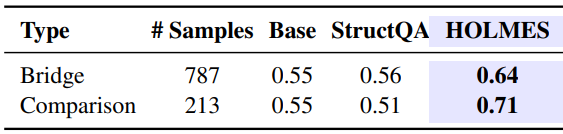

如下图所示,在多跳推理评估过程中,可以发现本文实验结果甚至优于采用 CoT 机制的 SoTA StructQA。

由于生成模型能够产生长篇答案,因此对预测答案进行语义评估非常重要。本文使用了BertScore和人类评估者来评判预测答案的正确性。可见本文提出的方法在两个评估指标上相比于基线都有1-2点的提升。

投稿或寻求报道联系:ainlperbot

「资料整理不易,点个再看、赞吧」

本文参与 腾讯云自媒体同步曝光计划,分享自微信公众号。

原始发表:2024-06-13,如有侵权请联系 cloudcommunity@tencent.com 删除

评论

登录后参与评论

推荐阅读

目录