Drug Discov Today|利用深度注意力神经网络推进药物发现

在快速发展的药物发现领域,传统方法的局限性日益凸显。尽管大量资金投入到新药研发中,但近90%的潜在候选药物在临床试验阶段失败,这主要是由于临床疗效不佳、药代动力学特性不理想或存在不良副作用等原因。为了应对这些挑战,科研人员正在探索利用人工智能(AI)和机器学习(ML)技术来加速药物发现进程、降低成本并提高成功率。特别是深度学习(DL)技术,在管理庞大的数据集、提高预测准确性以及简化复杂工作流程方面展现出了非凡的能力。

近期,那不勒斯费德里科二世大学的药物化学教授Antonio Lavecchia在Drug Discovery Today上发表综述Advancing drug discovery with deep attention neural networks。

本文重点介绍了基于注意力的药物发现架构的最新进展,揭示了这些开创性方法错综复杂的细微差别。首先阐明了注意力机制的核心原理及其扩展架构,包括GAT、Transformer、BERT、GPT和BART。随后,深入探讨了这些架构在新药设计、分子性质预测 (MPP)、CPI、DTI和DTA预测中的应用。最后,重点介绍了这一快速发展领域的最新进展,指出了研究空白,并概述了未来的发展方向。

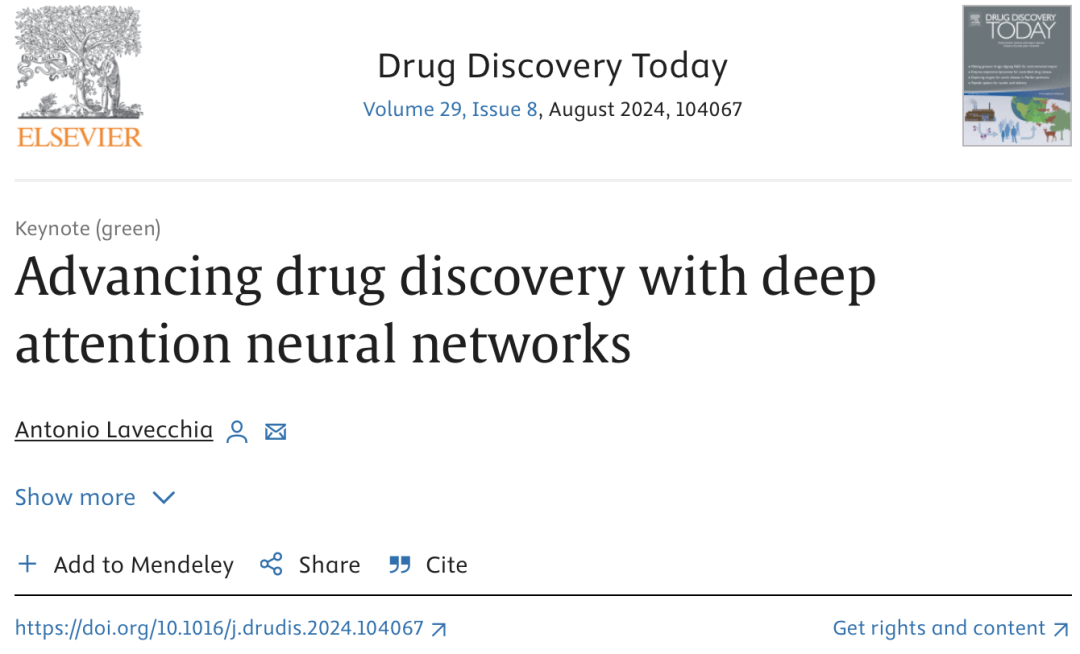

图1 药物发现过程的示意图,涵盖从疾病鉴定到药物商业化的所有阶段。

近年来,深度注意力神经网络在药物发现中的应用受到了广泛关注。这些网络,包括图注意力网络(GATs)、转换器(Transformers)、双向编码器表征(BERT)、生成预训练转换器(GPT)以及双向和自动回归转换器(BART),正逐步成为推动药物发现领域变革的重要力量。它们通过注意力机制,能够自主评估复杂数据中的关键区域,提高预测准确性,并为新药设计提供关键见解。

注意机制的理论原则

受人类认知过程的启发,注意力机制在深度神经网络中得到了广泛应用。注意力机制允许模型在处理复杂数据时,优先关注重要信息,忽略不重要的部分,从而提高模型的效率和准确性。在AI领域,注意力机制主要分为两种形式:自我注意和多头注意。自我注意机制通过计算序列中每个元素对其他元素的影响,生成每个元素的表征,进而捕捉数据中的长距离依赖关系。多头注意机制则通过并行处理多个注意力头,捕捉数据的多个方面,进一步提高模型的泛化能力。

图2 缩放点积注意力(a)和多头注意力(b)模型的示意图。

在药物发现领域,分子结构复杂且多变,传统方法难以准确捕捉分子间的相互作用。而注意力机制则能够评估分子结构中关键区域的重要性,从而提高药物筛选和优化的准确性。此外,注意力机制还能够帮助研究人员直观显示每个原子对分子性质的影响,促进对药物结构与性质关系的深入理解。

图注意力网络(GATs)在药物发现中的应用

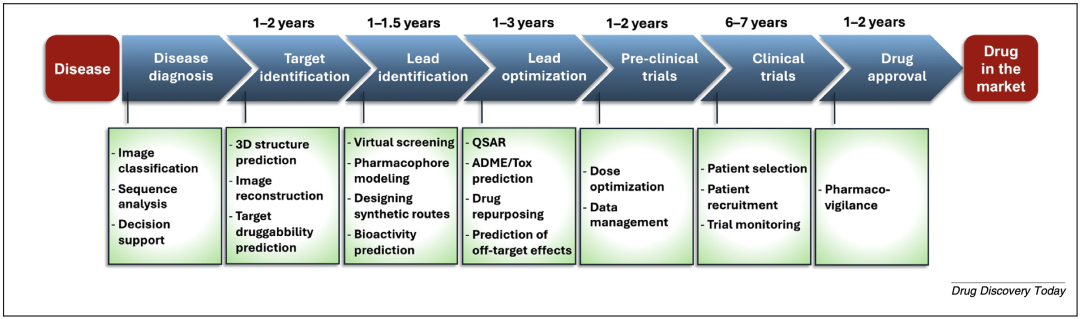

图注意力网络(GATs)是图卷积网络(GCNs)的一种发展,它将注意力机制融入图形学习中,以重建节点特征。GATs无需对拉普拉斯矩阵进行正交分解,能够处理有向图,并假定图是对称的。通过捕捉相邻节点对中心节点的重要性,GATs有效管理有向图,增强了模型的空间描述能力和对节点贡献的理解。在药物发现领域,GATs广泛应用于分子性质预测(MPP)和药物-靶点相互作用(DTI)预测等任务。

图3 GAT的说明

例如,基于GAT的模型ATMOL通过自监督学习方法,利用图掩蔽和注意力机制进行分子表示学习和性质预测。同样,FP-GNN利用GAT提取分子特征,并结合各种分子指纹,实现精确的MPP预测。在DTI预测方面,EDC-DTI利用GAT从同质和异质网络中获得药物和靶点的综合特征,提高了DTI预测的准确性。

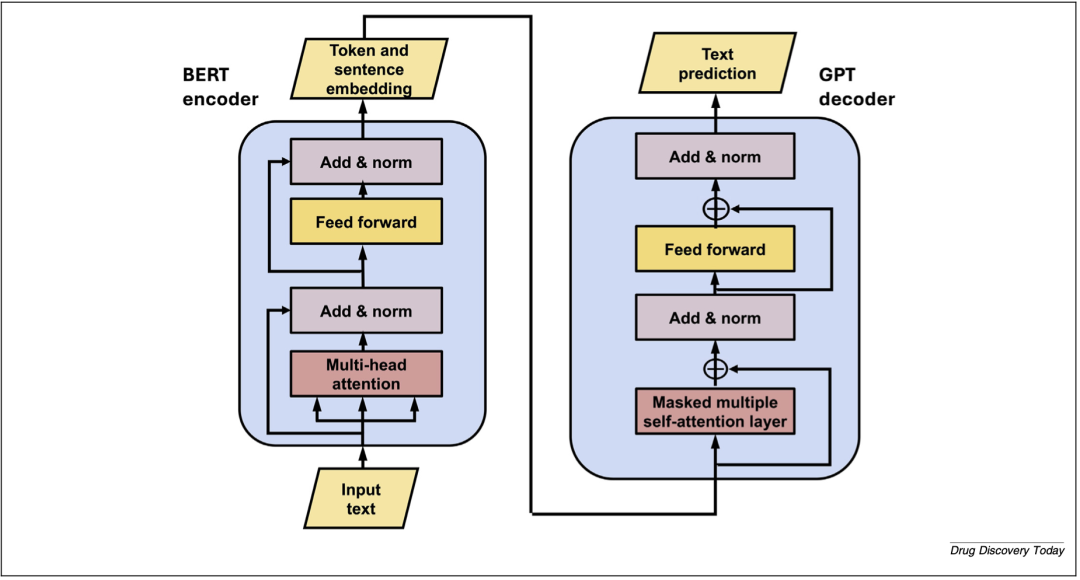

转换器(Transformers)在药物发现中的应用

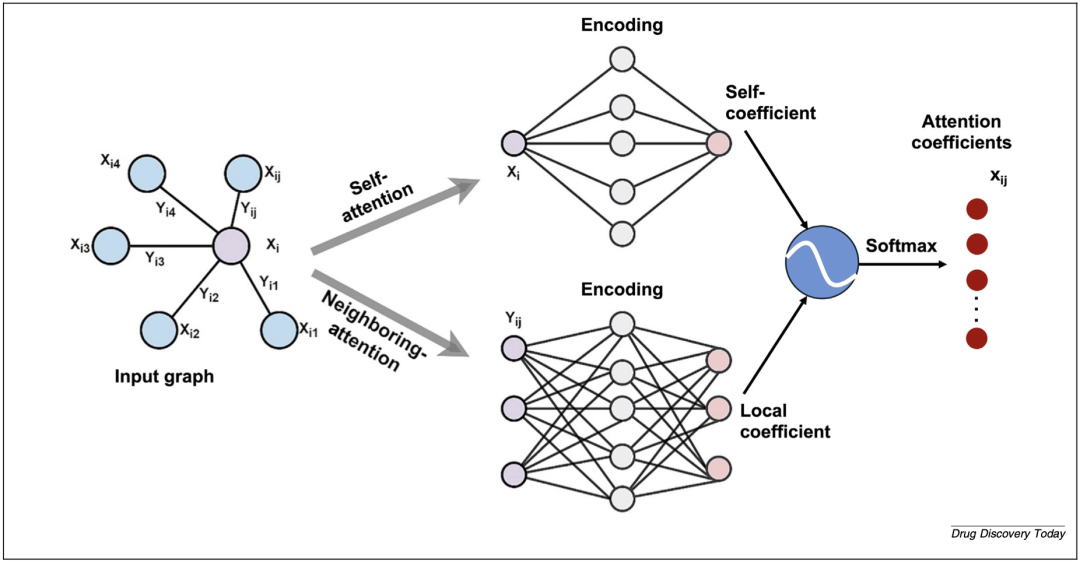

Vaswani等人于2017年引入的Transformers模型是一种seq2seq模型,主要用于将输入序列转换为输出序列。通过利用注意力机制,Transformers能够实现并行处理,减少计算时间,并促进对长距离依赖关系的学习。在药物发现领域,Transformers广泛应用于新药设计和各种药物特性预测任务。

图4 Transformer架构:一个通用的seq2seq模型,带有编码器-解码器模块,用于反应预测和分子优化等任务。

例如,TransVAE采用基于SMILES的VAE和注意力层,生成符合特定性质的分子。MCMG则通过强化学习改进的条件转换器,生成具有特定生物活性的分子。在MPP预测方面,SMILES-Transformers利用Transformer模型作为自动编码器,将分子嵌入到MPP任务中。在DTI预测方面,MolTrans采用邻域交互方案,利用Transformer编码器捕捉蛋白质表征,提高了DTI预测的准确性。

双向编码器表征(BERT)在药物发现中的应用

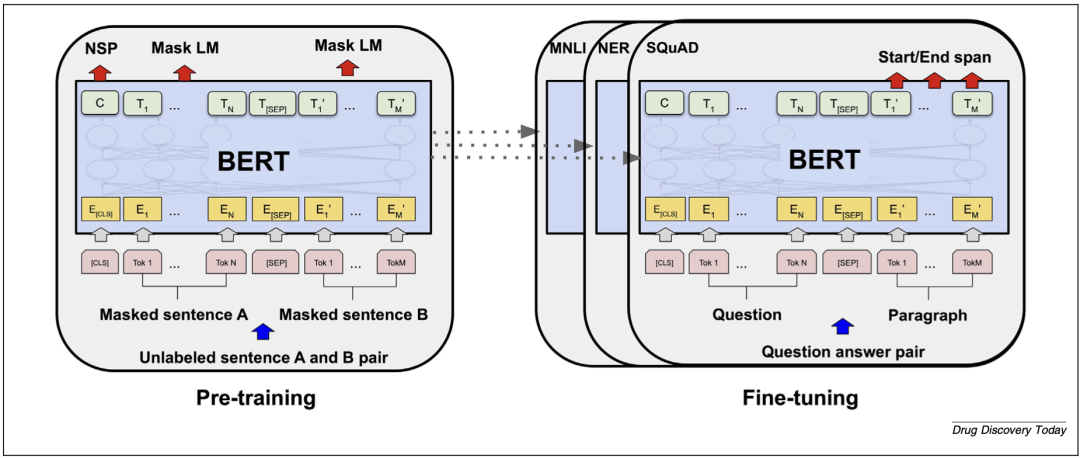

谷歌于2018年推出的BERT模型是NLP领域的一项变革性进展,它通过双向理解句子语义,提高了下游任务的准确性。在药物发现领域,BERT模型被广泛应用于新药设计、MPP预测和CPI预测等任务。

图5 BERT预培训和微调流程。

例如,Blanchard等人探讨了BERT架构在优化任务中增强从头药物设计的能力。SMILES-BERT通过大量无标记数据预训练分子SMILES表示,提高了下游MPP任务的性能。在CPI预测方面,MDL-CPI将BERT和CNN用于序列蛋白质特征提取,将GNN用于结构化合物特征提取,通过多视角学习方法提高了CPI预测的准确性。

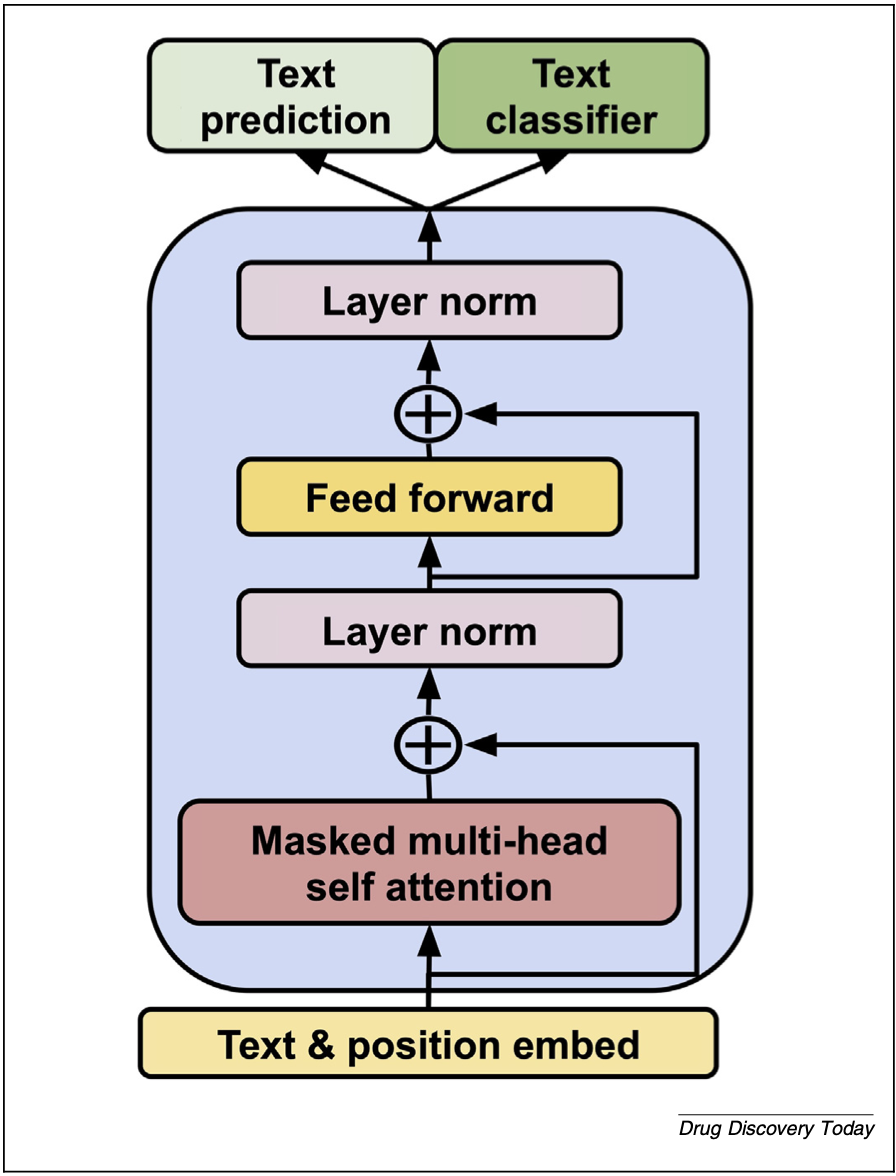

生成式预训练转换器(GPT)在药物发现中的应用

GPT是OpenAI在NLP领域取得的一项重要进展,它通过预训练阶段从大量互联网文本中学习,能够生成格式一致的文本。在药物发现领域,GPT模型被广泛应用于新药设计任务,通过生成具有所需特性的新型分子来加速药物发现进程。

图6 GPT架构

例如,MolGPT和SMILESGPT等模型利用GPT架构生成潜在候选药物,并通过微调提高结合能力。ChatGPT和DrugChat等应用则进一步扩展了GPT在药物发现中的应用范围,通过交互式问答和文本解释等方式提供个性化建议。

双向和自回归变换器(BART)在药物发现中的应用

BART是一个带有双向编码器和自回归解码器的seq2seq模型,通过预训练技术提高文本生成任务的性能。在药物发现领域,BART模型被成功应用于反应预测、分子优化以及MPP和生物活性预测等任务。

图7 BART单编码器-解码器网络架构。

例如,BARTSmiles采用BART架构在大型数据集上进行预训练,并在MoleculeNet数据集和合成预测方面表现出优异性能。MOLGEN则将领域识别预训练与自我反馈范式相结合,生成化学上有效的分子,解决了分子幻觉等难题。

挑战与未来展望

深度注意力神经网络正逐步成为推动药物发现领域变革的重要力量。通过注意力机制,这些网络能够自主评估复杂数据中的关键区域,提高预测准确性,并为新药设计提供关键见解。

尽管深度注意力神经网络在药物发现领域取得了显著进展,但仍面临诸多挑战。首先,将注意力机制整合到DL模型中,确定最佳形式和粒度是一个复杂的问题。其次,生物医学数据的质量、数量和可访问性限制了模型的有效性。此外,DL模型的复杂性和计算资源需求也对实际应用提出了挑战。

未来的研究将致力于解决这些挑战,提高模型的准确性和效率。一方面,多视角学习将整合各种数据类型,提高药物发现的预测准确性。另一方面,轻量级、高效的模型和算法将进一步降低能耗和对环境的影响。同时,开发稳健、可解释的模型仍是当务之急,以确保药物发现的可靠性和安全性。

深度注意力神经网络正逐步成为推动药物发现领域变革的重要力量。通过注意力机制,这些网络能够自主评估复杂数据中的关键区域,提高预测准确性,并为新药设计提供关键见解。尽管仍面临诸多挑战,但随着技术的不断进步和应用场景的不断拓展,深度注意力神经网络将在药物发现中发挥越来越重要的作用。

参考资料:

https://doi.org/10.1016/j.drudis.2024.104067

本文参与 腾讯云自媒体同步曝光计划,分享自微信公众号。

原始发表:2024-07-09,如有侵权请联系 cloudcommunity@tencent.com 删除

评论

登录后参与评论

推荐阅读