如何使用多模态知识图谱嵌入:整合图像与文本

原创在信息爆炸的时代,知识图谱(Knowledge Graph, KG)作为一种重要的信息组织方式,被广泛应用于推荐系统、智能问答和信息检索等领域。然而,传统的知识图谱主要依赖于结构化数据(如实体和关系),难以充分利用丰富的非结构化数据(如文本和图像)。为了解决这一问题,多模态知识图谱嵌入(Multimodal Knowledge Graph Embedding)应运而生。

多模态知识图谱嵌入的目标是将不同模态(如文本和图像)信息整合到一个统一的向量空间中,既能保留知识图谱的结构信息,又能利用非结构化数据的潜在信息。这一过程不仅提升了模型的表示能力,还能增强下游任务的性能。

知识图谱嵌入基础

知识图谱嵌入简介

知识图谱嵌入技术的目标是将实体和关系映射到低维向量空间中。常见的方法包括TransE、DistMult、ComplEx等。

嵌入方法 | 描述 |

|---|---|

TransE | 通过“头 + 关系 = 尾”的方式进行嵌入。 |

DistMult | 使用双线性模型,适合对称关系。 |

ComplEx | 使用复数向量,可以处理复杂的关系模式。 |

嵌入模型的训练

嵌入模型的训练通常采用负采样和优化目标函数。例如,TransE模型的损失函数为:

\text{loss} = \sum_{(h, r, t) \in \text{positive}} \max(0, \gamma - f(h, r, t)) + \sum_{(h, r, t) \in \text{negative}} \max(0, f(h, r, t) + \gamma)

其中, f(h, r, t) 是由模型定义的评分函数。

多模态知识图谱的概念

多模态数据的定义

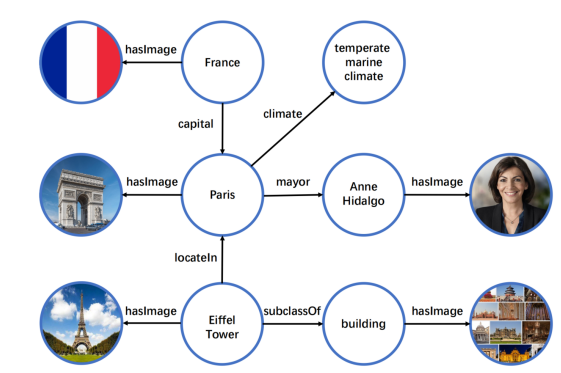

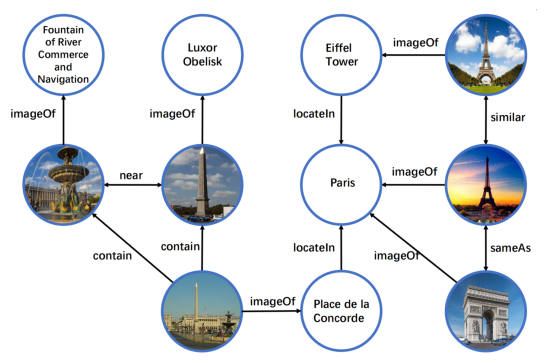

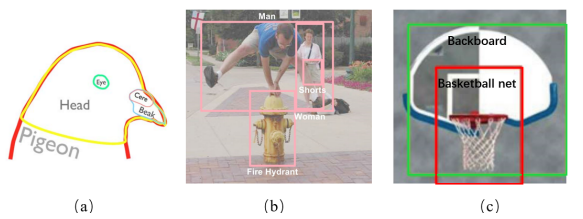

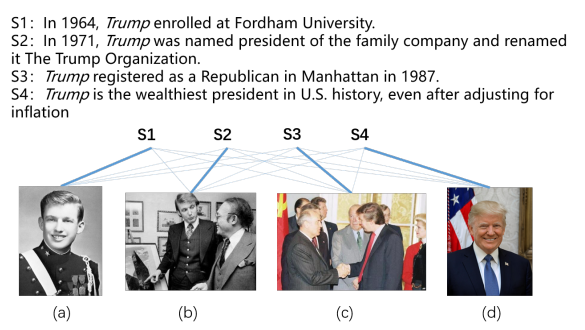

多模态数据是指同时包含多种数据类型(如文本、图像、音频等)的信息。在知识图谱中,实体可能会有图像描述和文本描述,这些信息可以用来增强嵌入表示。

模态 | 描述 |

|---|---|

文本 | 实体的文本描述,如定义、属性等。 |

图像 | 实体的视觉信息,如照片、图标等。 |

多模态知识图谱的构建

多模态知识图谱的构建需要整合来自不同来源的信息。例如,可以通过图像识别技术提取图像特征,通过自然语言处理技术提取文本特征,然后将这些特征与知识图谱中的实体和关系进行关联。

构建步骤 | 描述 |

|---|---|

数据收集 | 收集包含文本和图像的多模态数据。 |

特征提取 | 使用深度学习方法提取图像和文本特征。 |

构建知识图谱 | 将特征与知识图谱中的实体和关系结合。 |

多模态知识图谱嵌入的方法

特征提取

使用卷积神经网络(CNN)提取图像特征,使用预训练的语言模型(如BERT)提取文本特征。

import torch

from transformers import BertTokenizer, BertModel

from torchvision import models

# 文本特征提取

tokenizer = BertTokenizer.from_pretrained('bert-base-uncased')

bert_model = BertModel.from_pretrained('bert-base-uncased')

def extract_text_features(text):

inputs = tokenizer(text, return_tensors='pt')

outputs = bert_model(**inputs)

return outputs.last_hidden_state.mean(dim=1)

# 图像特征提取

cnn_model = models.resnet50(pretrained=True)

cnn_model.eval()

def extract_image_features(image):

image = preprocess_image(image) # 图像预处理函数

with torch.no_grad():

features = cnn_model(image)

return features多模态融合

将提取的文本特征和图像特征进行融合,通常可以使用简单的拼接或更复杂的融合方法(如加权平均、注意力机制等)。

def fuse_features(text_features, image_features):

return torch.cat((text_features, image_features), dim=1)嵌入模型的训练

设计嵌入模型,利用融合后的特征进行知识图谱的嵌入。

import torch.nn as nn

class MultimodalEmbedding(nn.Module):

def __init__(self, embedding_dim):

super(MultimodalEmbedding, self).__init__()

self.fc = nn.Linear(embedding_dim * 2, embedding_dim) # 融合特征后降维

def forward(self, text_features, image_features):

fused_features = fuse_features(text_features, image_features)

return self.fc(fused_features)实例分析与代码实现

数据准备

使用一个公开的数据集(如Flickr30k)进行实验,数据集包含图像及其相关文本描述。

import pandas as pd

# 读取数据集

data = pd.read_csv('flickr30k.csv')

images = data['image_path'].tolist()

texts = data['text_description'].tolist()特征提取与融合

对每个样本提取文本和图像特征,并进行融合。

text_features_list = []

image_features_list = []

for text, image_path in zip(texts, images):

text_features = extract_text_features(text)

image_features = extract_image_features(image_path)

text_features_list.append(text_features)

image_features_list.append(image_features)

# 转为张量

text_features_tensor = torch.stack(text_features_list)

image_features_tensor = torch.stack(image_features_list)

# 融合特征

multimodal_features = fuse_features(text_features_tensor, image_features_tensor)训练模型

使用训练集对多模态嵌入模型进行训练。

model = MultimodalEmbedding(embedding_dim=256)

optimizer = torch.optim.Adam(model.parameters(), lr=0.001)

for epoch in range(10):

model.train()

optimizer.zero_grad()

embeddings = model(text_features_tensor, image_features_tensor)

# 计算损失...

loss.backward()

optimizer.step()评估模型

使用评估指标(如准确率、F1-score等)评估模型的性能。

model.eval()

with torch.no_grad():

embeddings = model(text_features_tensor, image_features_tensor)

# 计算评估指标...代码部署

环境准备

使用Docker构建适合多模态模型训练的环境。

# Dockerfile

FROM python:3.8-slim

RUN pip install torch torchvision transformers pandas

COPY . /app

WORKDIR /app

CMD ["python", "train_model.py"]然后构建和运行Docker容器:

docker build -t multimodal-kg .

docker run multimodal-kg训练脚本设计

整合数据处理、模型构建和训练过程。

import pandas as pd

import torch

import torch.nn as nn

import torch.optim as optim

from torchvision import models, transforms

from transformers import BertTokenizer, BertModel

# 数据加载

data = pd.read_csv("flickr30k.csv")

images = data['image_path'].tolist()

texts = data['text_description'].tolist()

# 数据预处理

# 图像预处理

def preprocess_image(image_path):

transform = transforms.Compose([

transforms.Resize((224, 224)),

transforms.ToTensor(),

transforms.Normalize(mean=[0.485, 0.456, 0.406], std=[0.229, 0.224, 0.225]),

])

image = Image.open(image_path).convert('RGB')

return transform(image).unsqueeze(0) # 增加批次维度

# 文本特征提取

tokenizer = BertTokenizer.from_pretrained('bert-base-uncased')

bert_model = BertModel.from_pretrained('bert-base-uncased')

def extract_text_features(text):

inputs = tokenizer(text, return_tensors='pt')

outputs = bert_model(**inputs)

return outputs.last_hidden_state.mean(dim=1)

# 图像特征提取

cnn_model = models.resnet50(pretrained=True)

cnn_model.eval()

def extract_image_features(image_path):

image = preprocess_image(image_path)

with torch.no_grad():

features = cnn_model(image)

return features

# 模型构建

class MultimodalEmbedding(nn.Module):

def __init__(self, embedding_dim):

super(MultimodalEmbedding, self).__init__()

self.fc = nn.Linear(embedding_dim * 2, embedding_dim) # 融合特征后降维

self.embedding_dim = embedding_dim

def forward(self, text_features, image_features):

fused_features = torch.cat((text_features, image_features), dim=1)

return self.fc(fused_features)

# 初始化模型和优化器

model = MultimodalEmbedding(embedding_dim=256)

optimizer = optim.Adam(model.parameters(), lr=0.001)

criterion = nn.MSELoss() # 假设有目标值

# 训练过程

for epoch in range(10):

model.train()

total_loss = 0

for text, image_path in zip(texts, images):

text_features = extract_text_features(text)

image_features = extract_image_features(image_path)

# 假设有一个目标向量

target = torch.randn(1, 256) # 目标值需替换为真实值

optimizer.zero_grad()

embeddings = model(text_features, image_features)

loss = criterion(embeddings, target)

loss.backward()

optimizer.step()

total_loss += loss.item()

print(f'Epoch [{epoch+1}/10], Loss: {total_loss / len(texts):.4f}')监控与评估

使用TensorBoard进行监控,以便及时调整超参数。

import pandas as pd

import torch

import torch.nn as nn

import torch.optim as optim

from torchvision import models, transforms

from transformers import BertTokenizer, BertModel

from torch.utils.tensorboard import SummaryWriter

from PIL import Image

# 数据加载

data = pd.read_csv("flickr30k.csv")

images = data['image_path'].tolist()

texts = data['text_description'].tolist()

# 数据预处理

def preprocess_image(image_path):

transform = transforms.Compose([

transforms.Resize((224, 224)),

transforms.ToTensor(),

transforms.Normalize(mean=[0.485, 0.456, 0.406], std=[0.229, 0.224, 0.225]),

])

image = Image.open(image_path).convert('RGB')

return transform(image).unsqueeze(0)

# 文本特征提取

tokenizer = BertTokenizer.from_pretrained('bert-base-uncased')

bert_model = BertModel.from_pretrained('bert-base-uncased')

def extract_text_features(text):

inputs = tokenizer(text, return_tensors='pt', padding=True, truncation=True)

outputs = bert_model(**inputs)

return outputs.last_hidden_state.mean(dim=1)

# 图像特征提取

cnn_model = models.resnet50(pretrained=True)

cnn_model.eval()

def extract_image_features(image_path):

image = preprocess_image(image_path)

with torch.no_grad():

features = cnn_model(image)

return features

# 模型构建

class MultimodalEmbedding(nn.Module):

def __init__(self, embedding_dim):

super(MultimodalEmbedding, self).__init__()

self.fc = nn.Linear(embedding_dim * 2, embedding_dim)

def forward(self, text_features, image_features):

fused_features = torch.cat((text_features, image_features), dim=1)

return self.fc(fused_features)

# 初始化模型、优化器和TensorBoard

model = MultimodalEmbedding(embedding_dim=256)

optimizer = optim.Adam(model.parameters(), lr=0.001)

criterion = nn.MSELoss() # 假设有目标值

writer = SummaryWriter()

# 训练过程

num_epochs = 10

for epoch in range(num_epochs):

model.train()

total_loss = 0

for text, image_path in zip(texts, images):

text_features = extract_text_features(text)

image_features = extract_image_features(image_path)

# 假设有一个目标向量

target = torch.randn(1, 256) # 目标值需替换为真实值

optimizer.zero_grad()

embeddings = model(text_features, image_features)

loss = criterion(embeddings, target)

loss.backward()

optimizer.step()

total_loss += loss.item()

average_loss = total_loss / len(texts)

writer.add_scalar('Loss/train', average_loss, epoch)

print(f'Epoch [{epoch+1}/{num_epochs}], Loss: {average_loss:.4f}')

# 关闭TensorBoard

writer.close()

扩展多模态

在当前多模态知识图谱嵌入研究中,文本和图像是最常见的模态。未来可以探索将其他模态(如音频和视频)纳入知识图谱嵌入中,以丰富信息表达。例如,在医疗领域,音频诊断(如医生的口述)和视频记录(如手术过程)可以为知识图谱提供额外的上下文信息。研究者可以开发新的特征提取方法,如使用声音识别技术从音频中提取特征,或通过时序卷积网络(TCN)处理视频信息。这种扩展将大幅提升模型的综合性能,使其能够处理更加复杂和多样化的任务。

应用于不同领域

多模态知识图谱嵌入在特定领域的应用研究将是未来的重要方向。例如,在医疗领域,可以将多模态嵌入应用于临床决策支持系统,结合患者的电子健康记录、医学影像和医生的文字记录,提高疾病诊断的准确性。在金融领域,通过整合市场数据、新闻报道和社交媒体信息,可以更好地预测股票市场动态。研究者可以针对不同领域开发定制化的模型和算法,以解决特定领域的挑战,如数据稀缺、噪声干扰和隐私保护等问题。

实时更新

动态知识图谱的实时更新是应对信息流动性带来的挑战的关键。研究者可以探索增量学习和在线学习的方法,使得模型能够在新信息到达时快速调整。例如,使用流式数据处理技术和流行的图数据库,可以实时更新知识图谱中的实体和关系。此外,利用自适应算法动态调整嵌入向量,将有助于提高模型在动态环境中的表现。实时更新的多模态知识图谱可以更好地适应快速变化的现实世界,为下游应用提供更及时和准确的信息。

原创声明:本文系作者授权腾讯云开发者社区发表,未经许可,不得转载。

如有侵权,请联系 cloudcommunity@tencent.com 删除。

原创声明:本文系作者授权腾讯云开发者社区发表,未经许可,不得转载。

如有侵权,请联系 cloudcommunity@tencent.com 删除。

评论

登录后参与评论

推荐阅读

目录