团队做到了! AMD MI300x 轻松调优 Llama 405B,而且性能还提升 15%

原创团队做到了! AMD MI300x 轻松调优 Llama 405B,而且性能还提升 15%

原创

老码小张

发布于 2024-09-24 11:14:19

发布于 2024-09-24 11:14:19

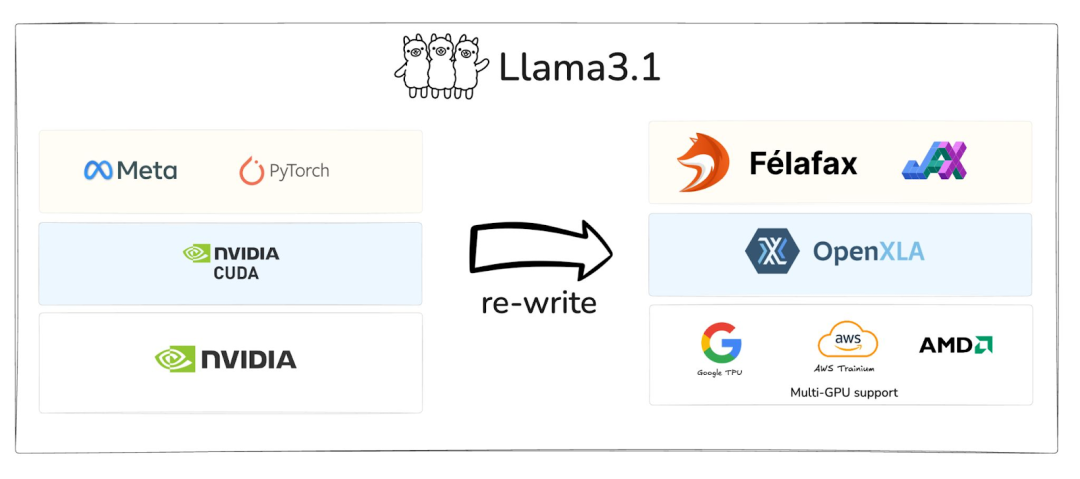

大家好,今天咱们来聊聊一个看起来可能有点“硬核”的话题,但放心,我会尽量用通俗的语言跟你聊一聊,你必须要一步一步做,因为整个过程都放在了 GitHub 上开源了。你是不是听过Llama 405B这个名字?如果你对AI模型或者自然语言处理有点兴趣的话,估计已经听过不少次了。但你可能没想到的是,居然能用 AMD 的 GPU 来对这个庞大的模型进行调优!更神奇的是,成功调优后性能表现还相当不错。我们今天就来看看这个过程中有哪些关键点、困难,还有一些有趣的发现。

我知道,听到“Llama 405B”和“调优”这些词,很多人第一反应就是头疼:这么大的模型,难道不是需要非常昂贵的硬件和极其复杂的操作才能搞定吗?但其实,这次的故事告诉我们,事情并没有那么复杂。特别是 AMD 的新 GPU MI300x,居然能够在性能和效率上与那些大家更熟悉的 NVIDIA GPU 相抗衡,甚至在某些场景下有更好的表现。

为什么选AMD的GPU?性价比是关键

说实话,在业界聊到AI模型调优,大家通常第一时间想到的是NVIDIA的GPU,比如A100、H100这些大块头。然而,随着需求的多样化和成本的增加,越来越多团队开始探索其他选择,尤其是那些性价比高的硬件。AMD MI300x 就是在这样的背景下进入了人们的视野。

一个有趣的对比是,NVIDIA的GPU虽然在AI领域深耕多年,但价格也水涨船高。相比之下,AMD的方案在提供强大算力的同时,价格更具竞争力。对于一些预算有限的中小型团队来说,MI300x就成了一个不可忽视的选择。

调优Llama 405B需要多大资源?用AMD的GPU省不少心

调优一个像Llama 405B这样的模型并不是件轻松的事,毕竟它可是一个超过4000亿参数的巨无霸!但当你换到AMD的MI300x时,资源利用效率就会显得更加突出。

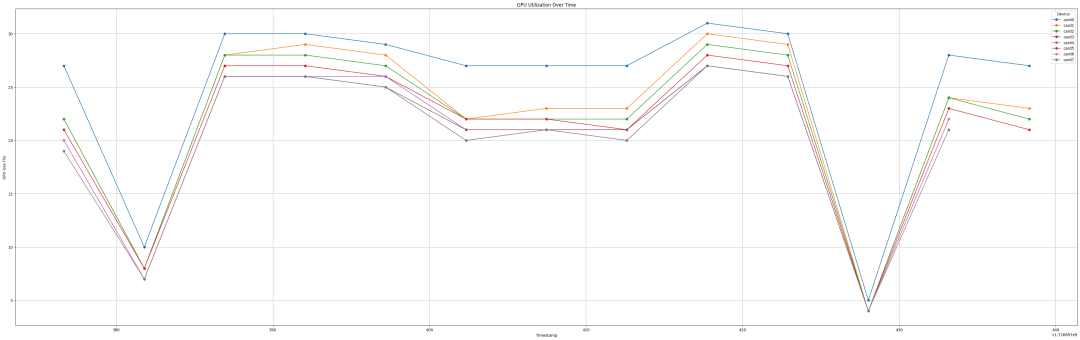

AMD MI300x的一大亮点是它的高带宽内存,能够更好地处理大型模型的计算需求。根据一些团队的实际反馈,他们在用MI300x对Llama 405B进行调优时,所需的时间明显缩短,甚至在部分任务上表现出了比NVIDIA方案更优的吞吐量和延迟。这意味着什么呢?简单点说,就是你不用一大堆硬件,也能高效搞定这么一个庞然大物。

要注意什么?调优过程中的几个“小坑”

当然,虽然AMD的方案很有吸引力,但在调优过程中,也有一些需要注意的小坑。首先是软件生态问题。我们都知道,NVIDIA在AI领域建立了非常成熟的开发工具链,像CUDA、cuDNN这样的工具几乎成了行业标准。AMD在这方面虽然在不断追赶,但还不算特别成熟。

好消息是,AMD推出了 ROCm(Radeon Open Compute)软件栈,正好为AI模型的调优提供了支持。虽然你可能需要花点时间去适应这个新的工具链,但长远来看,ROCm的发展潜力不容小觑。而且,针对Llama 405B,团队们也已经开发出了一些优化方案,能让你更轻松地上手。

亲身体验——团队如何一步步搞定Llama 405B

# Pull the Docker Image:

docker pull rocm/jax:latest

# Start the Docker Container:

docker run -it -w /workspace --device=/dev/kfd --device=/dev/dri --group-add video \

--cap-add=SYS_PTRACE --security-opt seccomp=unconfined --shm-size 16G rocm/jax:latest

# Verify the Installation:

python3 -c 'import jax; print(jax.devices())'很多时候,听别人讲理论不如自己亲手实践。一个团队的经验就是最好的证明。团队在调优Llama 405B时,采用了多卡并行训练的方式,把任务分配给多台搭载了MI300x的服务器。在此过程中,他们发现得益于AMD GPU出色的内存带宽,能够更快地处理大批量的数据输入,并且在计算密集型任务上表现得十分稳定。

不仅如此,他们还在调优过程中加入了一些轻量化的优化策略,进一步提升了模型的收敛速度和效果。最终,这个团队不仅成功完成了Llama 405B的调优,还把调优后的模型性能提高了10%到15%左右,令人惊叹。

AMD生态的未来:不是挑战者,而是合作伙伴

最后,让我们展望一下未来。尽管AMD目前在AI领域还是一个相对较新的玩家,但通过这次调优Llama 405B的成功,我们可以看出,AMD的GPU完全有能力在AI训练和推理任务中与NVIDIA一较高下。而且,它们并不是单纯的挑战者,更像是为整个AI行业提供了另一条可行的道路。

可以预见的是,未来越来越多的AI团队会开始尝试使用AMD的解决方案,尤其是在性价比和硬件资源优化方面有特殊需求的团队。或许你下次调优大型模型时,也会考虑AMD作为一种新的选择。

不用再头疼,AMD让调优更简单

项目地址:

https://github.com/felafax/felafax

虽然调优Llama 405B这样的大模型看起来很复杂,但通过这次的探索,我们发现,使用AMD MI300x进行调优不仅是可行的,还能够带来很多意想不到的好处。更重要的是,AMD的解决方案能够为你节省成本,同时还保持了高效的性能表现。希望通过这篇文章,你对调优大模型有了更清晰的认识,也期待你在未来的项目中,能够用到这些有价值的经验。

不论你是一个技术老手,还是刚刚接触AI的初学者,记住一点:调优其实没那么难,选择合适的工具,往往能让你事半功倍!

原创声明:本文系作者授权腾讯云开发者社区发表,未经许可,不得转载。

如有侵权,请联系 cloudcommunity@tencent.com 删除。

原创声明:本文系作者授权腾讯云开发者社区发表,未经许可,不得转载。

如有侵权,请联系 cloudcommunity@tencent.com 删除。

评论

登录后参与评论

推荐阅读

目录