Text to image论文精读PDF-GAN

原创Text to image论文精读PDF-GAN

原创

2024好事发生

在文章开始之前,推荐一篇值得阅读的好文章!感兴趣的也可以去看一下,并关注作者!

文章讲解了(1)fork进程写时复制机制。(2)redis的四种持久化方式。其中redis淘汰策略可以通过maxmemory-policy参数来选择。默认是禁止淘汰,如果数据达到了最大内存限制,在向redis中写入数据时会报错。redis有四种持久化技术,其中有三种需要fork进程。这就涉及到内核fork进程写时复制机制。进程是通过页表操作内存的,fork复制的是页表而不是物理内存,它和父进程指向相同的内存块。

好事文章地址:https://cloud.tencent.com/developer/article/2467251

好了,开始今天的主题:

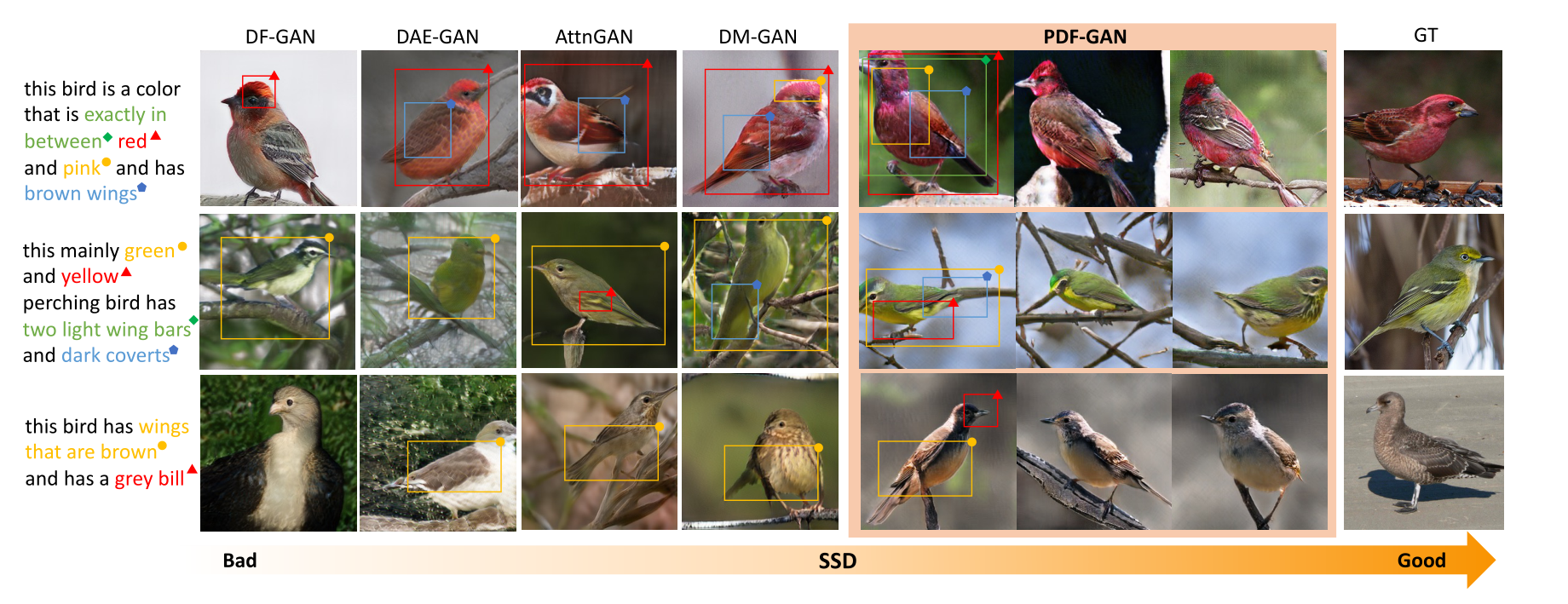

SSD,全称为Semantic Similarity Distance,是一种基于CLIP的新度量方式,是西交利物浦大学学者提出的一种新的文本生成图像度量指标,受益于所提出的度量,作者进一步设计了并行深度融合生成对抗网络(PDF-GAN),它可以融合不同粒度的语义信息并捕获准确的语义。文章22年10月在arcxiv发表。 论文地址:https://arxiv.org/abs/2210.15235

本篇文章是阅读这篇论文的精读笔记。

一、原文摘要

从给定文本中生成一致且高质量的图像对于视觉语言理解至关重要。尽管在生成高质量图像方面取得了令人印象深刻的结果,但文本图像一致性仍然是现有基于GAN的方法中的一个主要问题。特别地,最流行的度量R精度可能不能准确地反映文本图像的一致性,这常常导致生成的图像中的语义非常误导。尽管其意义重大,但如何设计出一个更好的文本图像一致性度量,在社区中仍处于探索之中,这一点令人惊讶。

在本文中,我们进一步开发了一种新的基于CLIP的度量,称为语义相似度距离(SSD),该度量既从分布角度理论上建立,又在基准数据集上进行了实证验证。受益于所提出的度量,我们进一步设计了并行深度融合生成对抗网络(PDF-GAN),它可以融合不同粒度的语义信息并捕获准确的语义。配备了两个新颖的即插即用组件:硬否定句构造器和语义投影,所提出的PDF-GAN可以缓解不一致的语义并弥合文本-图像语义差距。一系列实验表明,与当前最先进的方法相比,我们的PDF-GAN可以显著提高文本图像的一致性,同时在CUB和COCO数据集上保持良好的图像质量。

二、为什么提出SSD?

根据文本描述生成图像,通常称为文本到图像生成(T2I),是一项具有挑战性的任务,需要生成高质量的图像并保持文本图像的一致性。

尽管RiFeGAN、SegAttnGAN、DF-GAN取得了高质量的分数,在从文本描述生成高质量图像方面取得了令人印象深刻的成果,但他们仍然难以在复杂的语义中保持文本图像的一致性。一旦文本描述变得更加复杂,生成的图像的语义可能会与文本不匹配。

基于此作者提出了一种新的基于CLIP的文本图像一致性度量,称为语义相似度距离(SSD)。

三、介绍与创新点

对于T2I合成任务,CLIP提供了一个联合语言视觉嵌入空间,可以直接测量图像和文本的语义分布之间的相似性。我们的SSD是通过结合两个阶级矩项设计的:

- 一阶矩项直接测量文本图像的语义相似性,反映生成的图像和文本之间的语义偏差;

- 二阶矩项评估了以文本为条件的合成图像和真实图像之间语义变化的差异,表明生成的图像中的语义多样性也应该与真实图像中的一致。二阶矩项可以为精确的语义带来更多的可信度,在总体一致性和详细一致性之间平衡评估。

在理论方面,作者表明SSD的基本原理植根于使用修正的Wasserstein距离来测量两个分布的散度。还表明,它可以与最近的两个指标密切相关,即CLIPScore(CS)(Hessel等人2021)和Conditional Frechet Inception Distance(CFID)(Soloveitchik等人2021),且在测量语义一致性方面表现出更理想的特性。

通过实验,作者发现:

- 不同层次的语义信息可以显著帮助文本图像的一致性。然而,语义差距将导致对抗性损失和语义感知损失之间的优化冲突,因此,随意地添加语义感知损失会削弱语义监督,导致文本图像一致性的不良表现。

- 用于鉴别的不匹配样本通常利用成批样本或来自其他类别的随机样本,这可能导致文本图像一致性的下降。

根据上述发现,我们提出了一种新的一阶段T2I生成框架,命名为PDF-GAN。

文章创新点如下:

- 引入了一种新的度量——语义相似度距离(Semantic Similarity Distance),它可以评估文本图像的相似度以及生成图像与受文本约束的真实图像之间的语义变化差异。SSD理论上是有根据的,可以在不同的数据集上进行交叉比较。

- 提出了一个新的框架——并行深度融合生成对抗网络(PDF-GAN),具有语义感知损失和PFM,以融合不同层次的语义信息。

- 设计了一个HNSC,用于挖掘hard negative文本样本,并设计了SProj,用于缓解语义差距,增强文本图像一致性。

四、文本生成图像专用域定量指标

4.1、R-precision(R分数)

目前文本生成图像专用域合成度量有R-precision(R分数),其通过评估生成的图像是否比其他99个随机采样的文本更符合给定文本来判断文本图像的一致性。这种度量可能不能准确反映文本和图像之间的直接一致性。

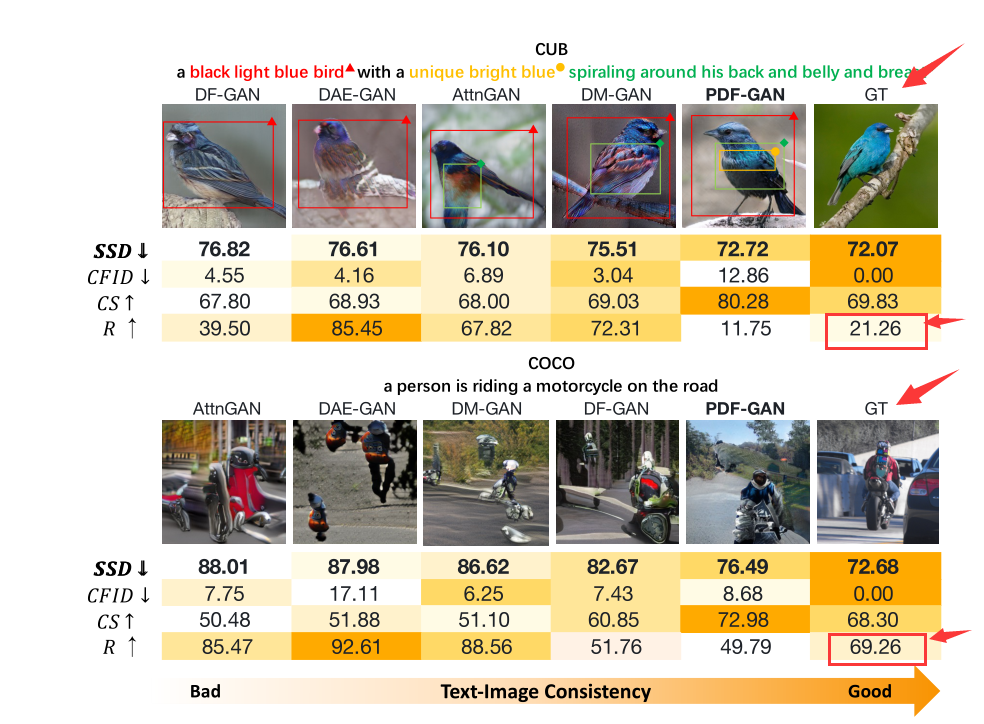

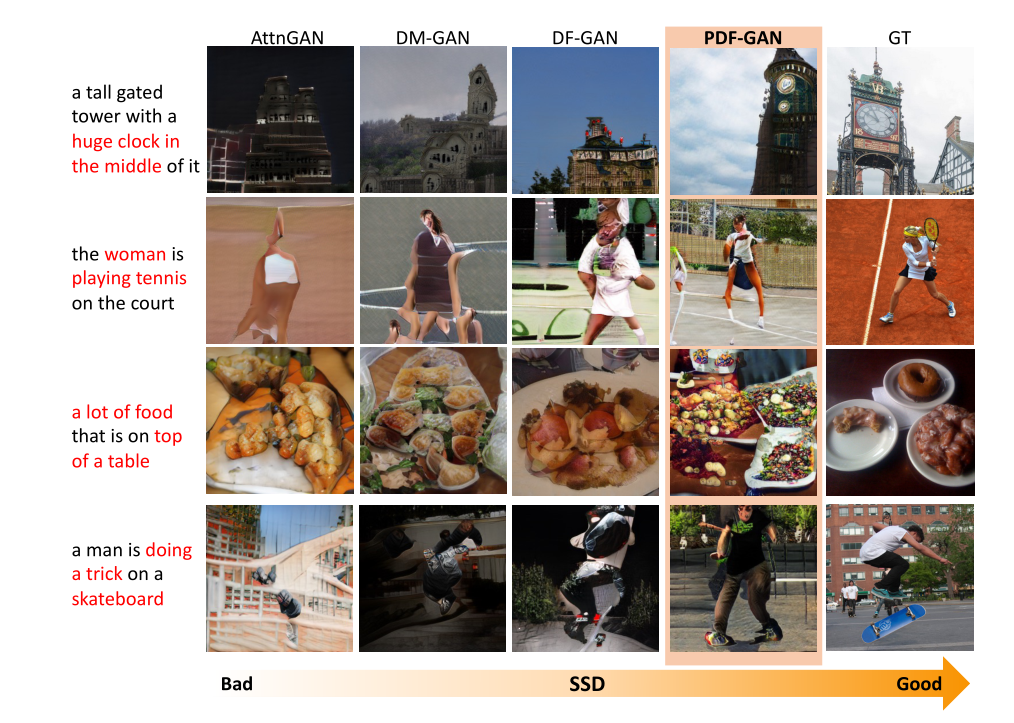

如上图所示,GT表示真实图像,可以看到,在有些情况下,真实图像反而得不到很好的R分数,这会在生成的图像中产生非常误导的语义。

4.2、SOA(语义对象准确度)

另外一种专用评估指标:语义对象准确度(SOA)(Hinz、Heinrich和Wermter 2020)是最近提出的一种专门用于评估多对象文本图像一致性的度量标准,在不评估对象属性和关系的情况下,仍然无法测量整个语义一致性。更严重的是,SOA不能应用于通常只有一个对象出现在生成的图像中的数据集,如CUB。为了缓解这些问题,研究人员必须依靠人类评估。然而,该过程通常成本高昂,并且其设置在不同的方法中差异很大,这使得它更难在实际场景中应用。

4.3、其他

CS(Hessel等人2021)设计用于图像字幕,但剪辑嵌入的余弦相似性可能不会明确将属性绑定到对象,并忽略语义变化(Ramesh等人2022)。

通过条件分布,CFID(Soloveitchik等人2021)评估了文本条件下的假图像和真实图像分布之间的距离。然而,直接对齐假分布和真实分布可能会使真实图像中的冗余部分不匹配,即文本未指定的内容。这严重影响了CFID在测量文本图像一致性方面的效果。

五、Parallel Deep Fusion GAN(PDF-GAN)

通过配备硬否定句构造器(HNSC)和语义投影(SProj)构造:并行深度融合生成对抗网络(PDF-GAN)

PDF-GAN通过使用并行融合模块(PFM)融合不同层次的语义信息。对于语义监督,采用了全局和局部鉴别器、语义感知损失和对比损失。为了更准确和稳健地捕获文本中的语义信息,HNSC创建了稳定和可控的硬否定样本,SProj可以通过约束语义优化方向来克服语义差距。

5.1、PDF-GAN框架结构

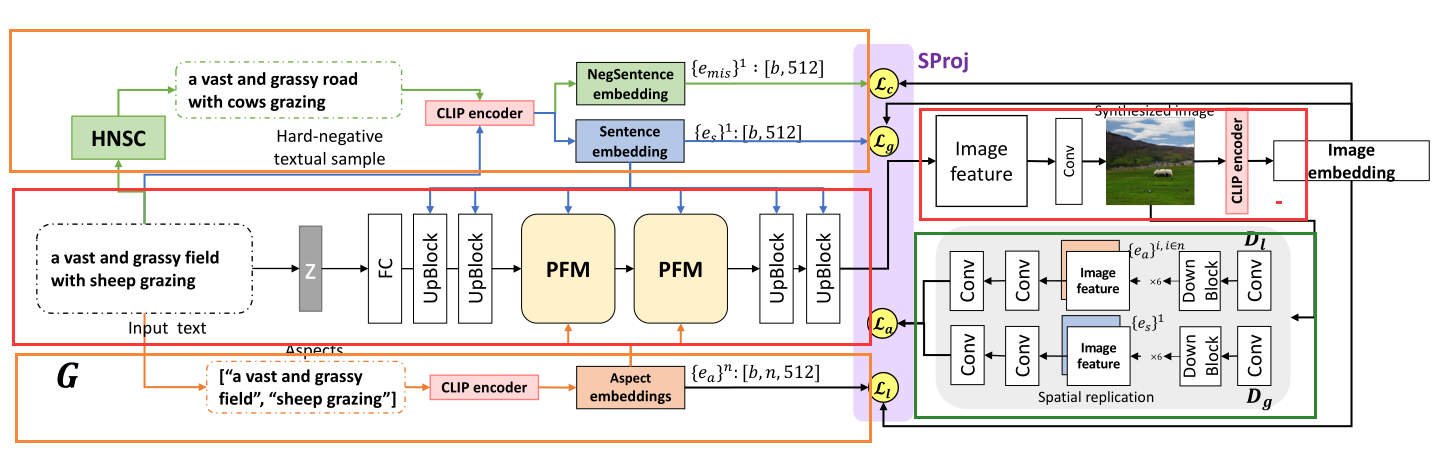

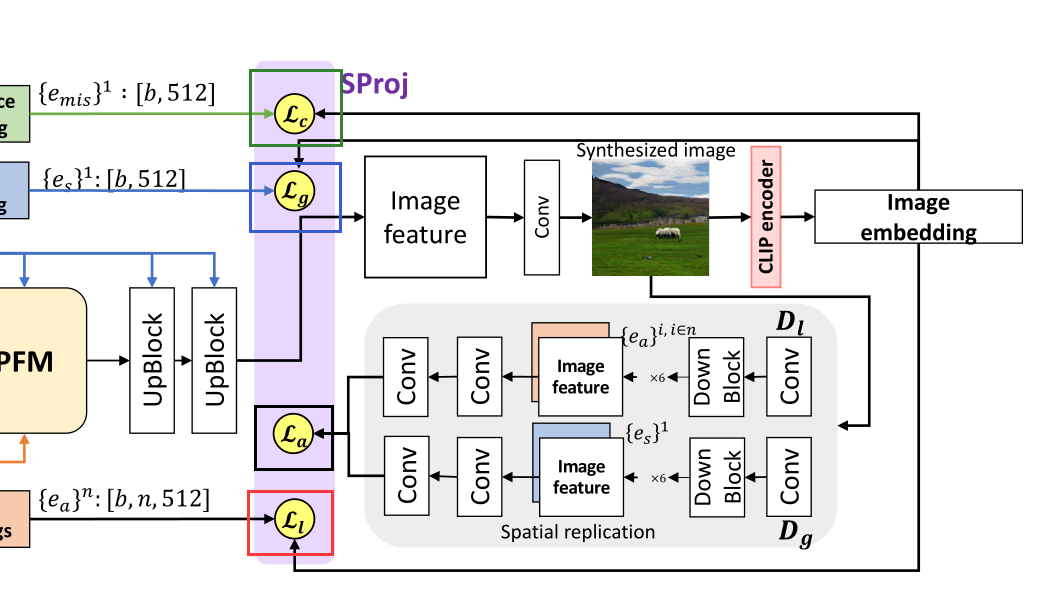

模型结构如下图所示:

可以看到,大致框架也可以分为三大部分:

- 使用了HNSC、CLIP的文本编码器部分(橙色框标记出)

- 使用了PFM,深度融合句子嵌入、方面嵌入指导图像生成的生成器部分(红色框标记出)

- 鉴别器部分(绿色框标记出)

5.2、文本编码器部分

SSD说明:在不同级别使用文本数据可以提高文本图像的一致性。 CLIP被用作编码器,将图像和文本映射到联合语义空间中。

全局级特征{eg}1{eg}1是文本描述嵌入;局部级特征{el}n{el}n是文本方面嵌入;{emis}1{emis}1是否定句嵌入。

HNSC: 硬否定句构造器HNSC通过根据词性(POS)随机替换给定描述中的标记来构造硬否定句样本。名词、动词和形容词被其他名词、动词或形容词取代。例如,对于文本“这只鸟尾巴上是蓝色的,有一个长长的尖嘴”,HNSC将随机地用POS替换一定百分比的单词(将“蓝色”改为“红色”,将“尾巴”改为”头部”等)。从数据集中收集替换候选。HNSC产生稳定和可控的硬否定文本样本,迫使鉴别器学习精确的语义。

5.3、生成器

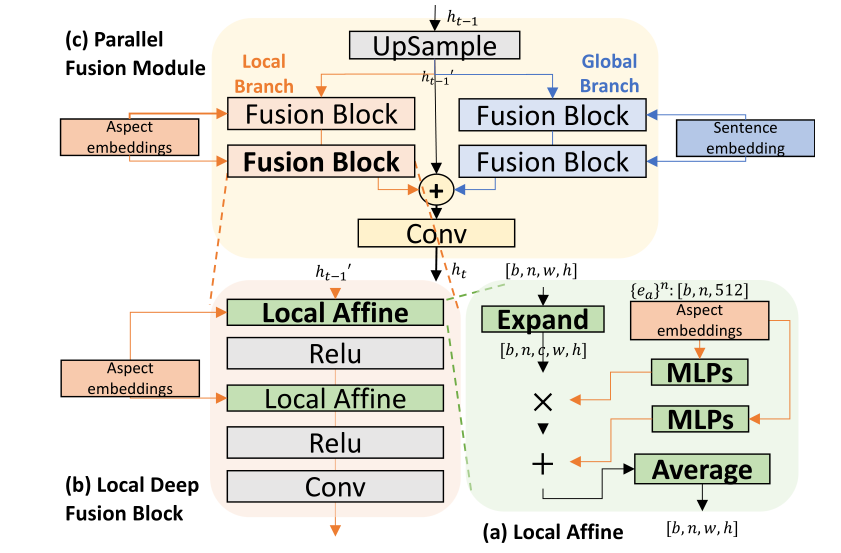

在生成器G中,作者提出了PFM,用于全局和局部特征之间的有效融合。

PFM:Parallel Fusion Module

PFM将先前步骤的输出作为输入,将{eg}1{eg}1和{el}n{el}n作为条件,输入ht−1ht−1首先上采样到ht−1′ht−1′,然后在两组条件下进行深度融合(DF),深度融合之后,来自两个分支的融合特征通过信道连接,然后经过卷积层并输出为htht。

htht再经过两组MLP分别学习由局部语义调节的尺度和偏差,变为ht+1′ht+1′(论文图中错误标注成了t-1)首先扩展到正确的形状,然后缩放并偏置。条件特征被平均并传递给后续处理器。

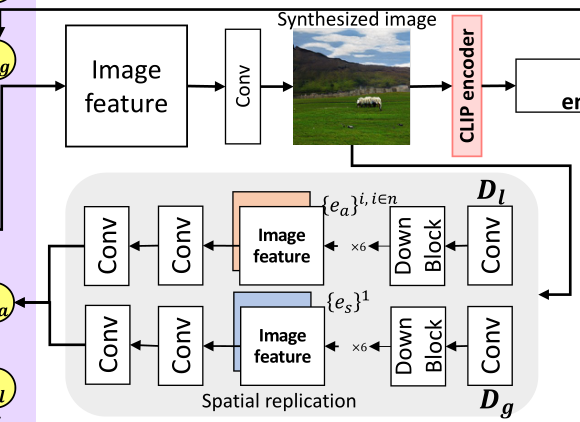

5.4、鉴别器

为了捕获全局和局部级别的语义信息,鉴别器使用了双线鉴别,一线用的是图像特征(Image feature)+文本方面嵌入(Aspect embeddings),另外一线用的是图像特征(Image feature)+文本句子嵌入(Sentence embeddings),然后将其最后卷积、联结进行判别。

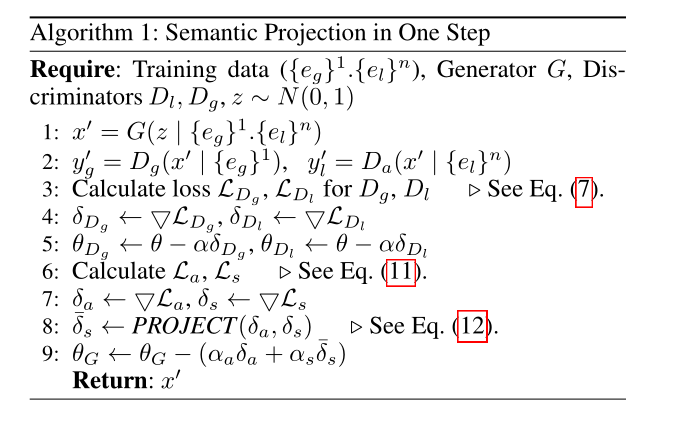

SProj:SProj用于缓解语义差距,通过约束语义优化方向来克服语义差距,从而增强文本图像一致性,SProj受GEM持续学习的启发将最小化La和Ls视为两项任务,不交替训练两项任务,而是同时优化它们。在每个步骤中,在我们计算了La和Ls的梯度δa和δs之后,在我们处理两个任务的反向传播之前,我们对δs进行PROJECT。如果存在方向冲突,语义优化方向δs将被重新投影到一个新的方向δs,在该方向δs中,它可以在不放大La的情况下优化Ls伪代码如下:

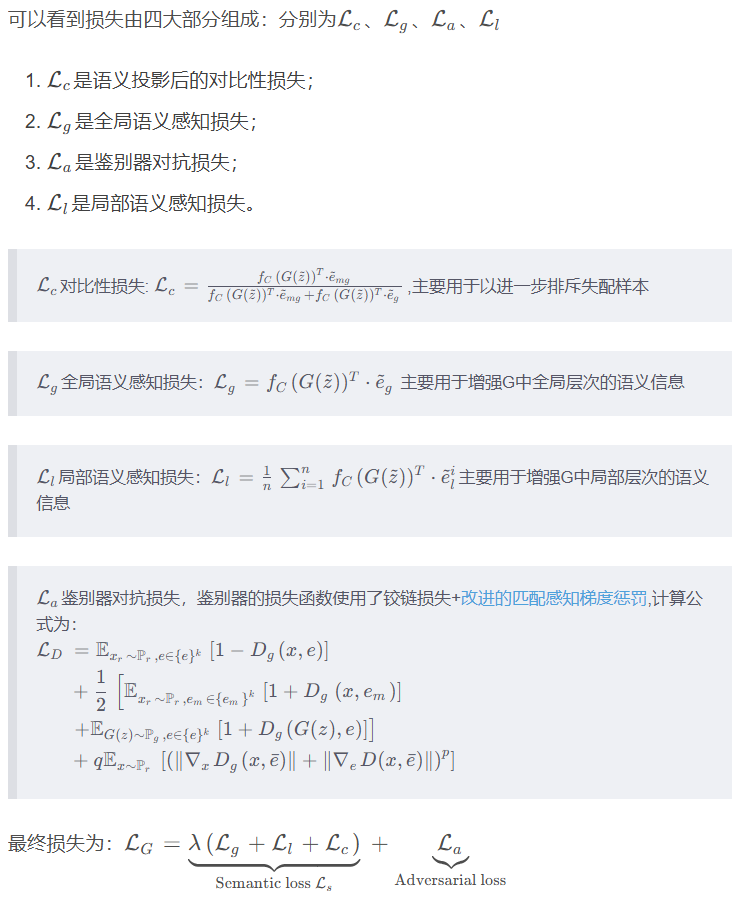

5.5、损失函数

六、实验

6.1、实验设置

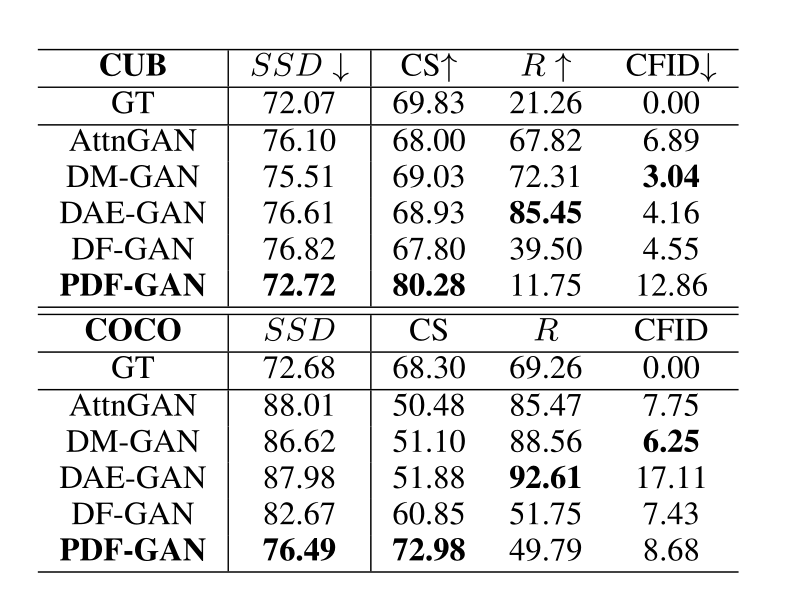

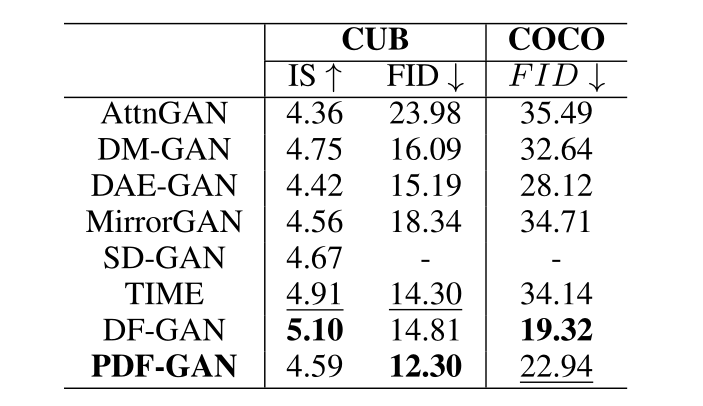

数据集:CUB、COCO 定量评估:专用评估指标有SSD(本文提出),R分数、CS,和CFID。标准评估指标(公认性更强)有Inception Score(IS)和 Fréchet Inception Distance(FID) ,IS未用于评估COCO,因为它对COCO的效果不好。所有度量都是在30K个生成的图像上计算的。

6.2、实验结果

在CUB上通过AttnGAN、DM-GAN、DAE-GAN、DF-GAN和PDF-GAN的合成实例:

在COCO上通过AttnGAN、DMGAN、DF-GAN和PDF-GAN合成T2I的实例:

CUB和COCO上SSD、CS、R和CF ID的文本图像一致性结果:

CUB和COCO上FID和IS的得分结果:

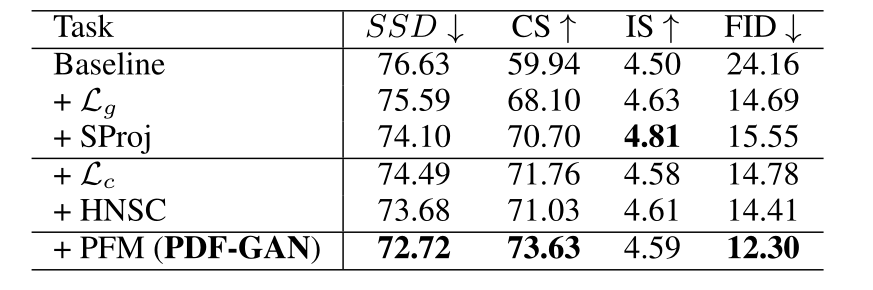

消融研究:

七、总结

本文提出了一种新的度量SSD以更好地评估文本图像的一致性,理论分析和实证研究都表明,SSD确实能够反映文本到图像生成中的语义一致性。

另外,本文还设计了一个名为PDF-GAN的新框架,以及两个即插即用模块,可以进一步增强文本图像的一致性,在基准数据集上的实验定性和定量地证实了SSD的有效性以及PDF-GAN的优势。

原创声明:本文系作者授权腾讯云开发者社区发表,未经许可,不得转载。

如有侵权,请联系 cloudcommunity@tencent.com 删除。

原创声明:本文系作者授权腾讯云开发者社区发表,未经许可,不得转载。

如有侵权,请联系 cloudcommunity@tencent.com 删除。