每日学术速递12.28

CV - 计算机视觉 | ML - 机器学习 | RL - 强化学习 | NLP 自然语言处理

Power by Kimi&苏神 编辑丨AiCharm

Subjects: cs.CV

1.Video-Panda: Parameter-efficient Alignment for Encoder-free Video-Language Models

标题:Video-Panda:无编码器视频语言模型的参数高效对齐

作者: Jinhui Yi, Syed Talal Wasim, Yanan Luo, Muzammal Naseer, Juergen Gall

文章链接:https://arxiv.org/abs/2412.18609

项目代码:https://github.com/jh-yi/Video-Panda

摘要:

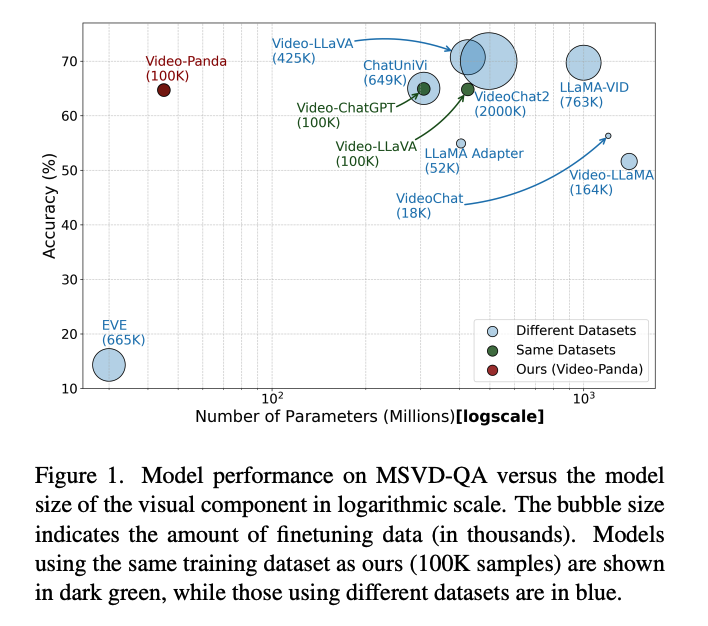

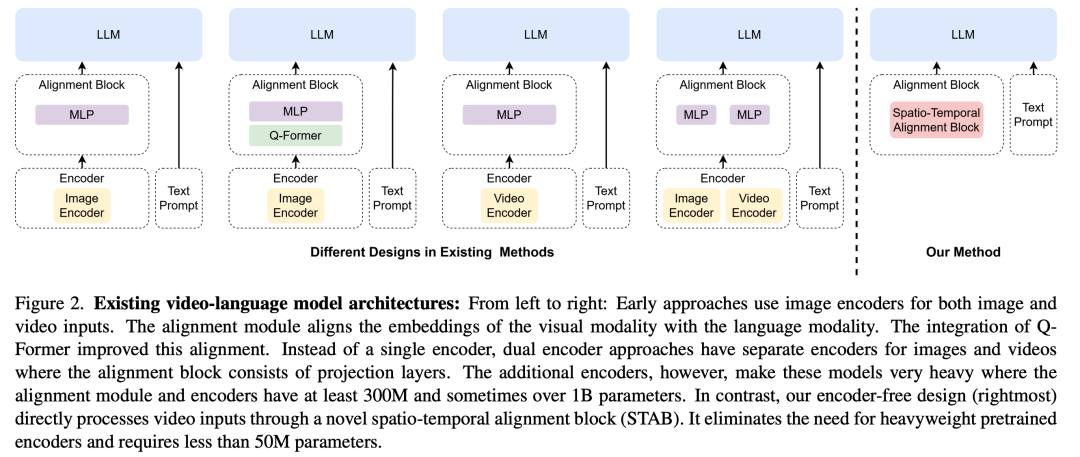

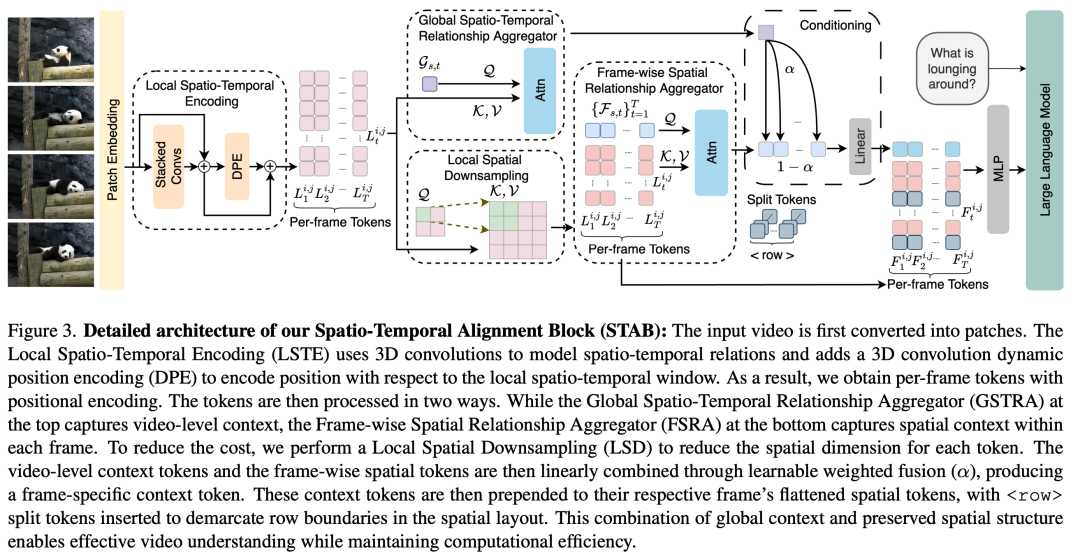

我们提出了一种有效的无编码器视频语言理解方法,可以实现有竞争力的性能,同时显着减少计算开销。当前的视频语言模型通常依赖于重量级图像编码器(300M-1.1B 参数)或视频编码器(1B-1.4B 参数),在处理多帧视频时会产生巨大的计算负担。我们的方法引入了一种新颖的时空对齐块(STAB),它可以直接处理视频输入,无需预先训练的编码器,同时仅使用 45M 参数进行视觉处理 - 与传统方法相比,至少减少了 6.5 × 。 STAB 架构结合了用于细粒度特征提取的本地时空编码、通过学习注意力进行高效空间下采样以及用于建模帧级和视频级关系的单独机制。我们的模型在标准基准上实现了与基于编码器的开放式视频问答方法相当或更好的性能。细粒度视频问答评估证明了我们模型的有效性,在正确性和时间理解等关键方面优于基于编码器的方法 Video-ChatGPT 和 Video-LLaVA。广泛的消融研究验证了我们的架构选择,并证明了我们的时空建模方法的有效性,同时实现比以前的方法快 3-4 × 的处理速度。

这篇论文试图解决什么问题?

这篇论文试图解决视频语言理解领域中存在的两个主要问题:

- 计算开销大:当前的视频语言模型通常依赖于重量级的图像编码器(参数量从300M到1.1B)或视频编码器(参数量从1B到1.4B)。这些大型编码器在处理多帧视频时需要反复通过编码器,造成了巨大的计算负担。

- 视频理解的复杂性:现有方法将图像语言架构简单适配到视频理解上时,会导致在仅训练视频数据时性能显著下降。这表明有效的视频语言模型需要能够捕捉视频内容中独特的时空关系的特殊架构,而不是将视频简单视为图像序列。

为了解决这些问题,论文提出了一种新颖的无编码器(encoder-free)视频语言模型,该模型通过显著减少计算开销的同时保持了竞争性能。关键方法是引入了一个专门的时空对齐块(Spatio-Temporal Alignment Block, STAB),它直接处理视频输入,无需预训练的编码器,并且仅使用45M参数进行视觉处理,相比传统方法减少了至少6.5倍的参数量。

论文如何解决这个问题?

论文通过提出一个新颖的无编码器(encoder-free)视频语言模型来解决视频语言理解中的计算开销大和视频理解复杂性问题。具体解决方案包括以下几个关键点:

- Spatio-Temporal Alignment Block (STAB):

- 引入了一个专门的时空对齐块(STAB),该模块直接处理视频输入,无需依赖预训练的视觉编码器。

- STAB结合了局部时空编码(Local Spatio-Temporal Encoding)用于细粒度特征提取,通过学习注意力机制进行高效的空间下采样,以及分别建模帧级和视频级关系的不同机制。

- 参数效率:

- STAB仅使用45M参数进行视觉处理,相比传统方法减少了至少6.5倍的参数量,显著降低了模型的计算负担。

- 性能保持或提升:

- 尽管参数量大大减少,但该模型在开放式视频问答(open-ended video question answering)任务上达到了与基于编码器的方法相当或更优的性能。

- 处理速度提升:

- STAB处理视频的速度比基于编码器的方法快3-4倍,这对于实际应用来说是一个显著的优势。

- 训练策略:

- 采用了分阶段的训练策略,包括初始对齐阶段、视觉-语言集成阶段和指令调优阶段,以确保稳定优化和有效知识转移。

- 架构设计:

- STAB的设计包括多个组件,如局部时空编码(LSTE)、全局时空关系聚合器(GSTRA)和帧级空间关系聚合器(FSRA),这些组件共同工作以捕捉视频内容中的独特时空关系。

通过这些解决方案,论文成功地开发了一个既高效又准确的视频语言模型,能够在保持竞争力的同时显著减少计算资源的需求。

论文做了哪些实验?

- 数据集和实现细节:

- 使用了三个阶段的训练数据集,包括从WebVid数据集中采样的351K视频-文本对(Valley数据集的50%),完整的Valley数据集(702K对),以及额外的100K视频-文本指令数据集(VideoChatGPT数据集)。

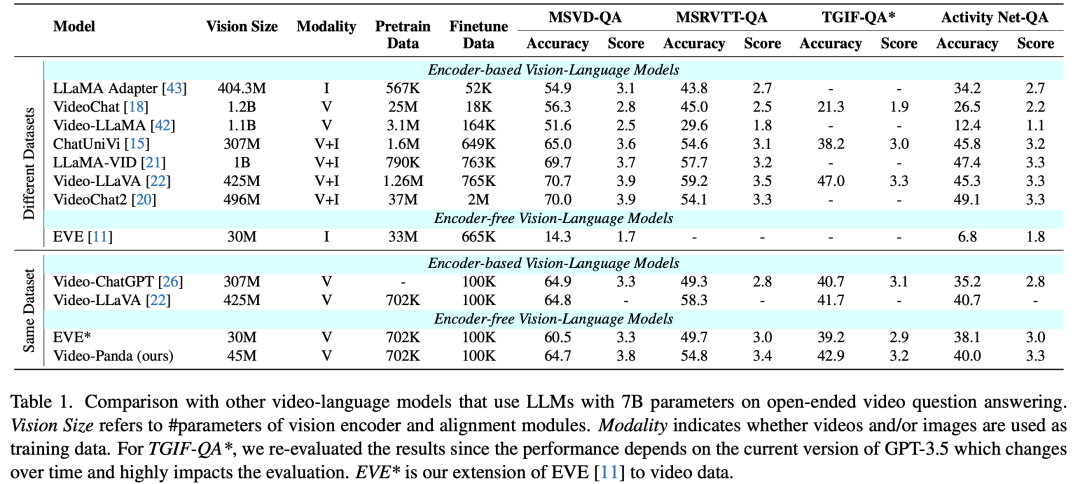

- 在四个开放式视频问答(VideoQA)数据集上评估模型:MSRVTT-QA、MSVD-QA、TGIF-QA和ActivityNet-QA。

- 定量评估:

- 开放式视频问答:比较了Video-Panda模型与其他基于相同数据集训练的方法以及使用更多或其他数据进行训练的方法的性能。

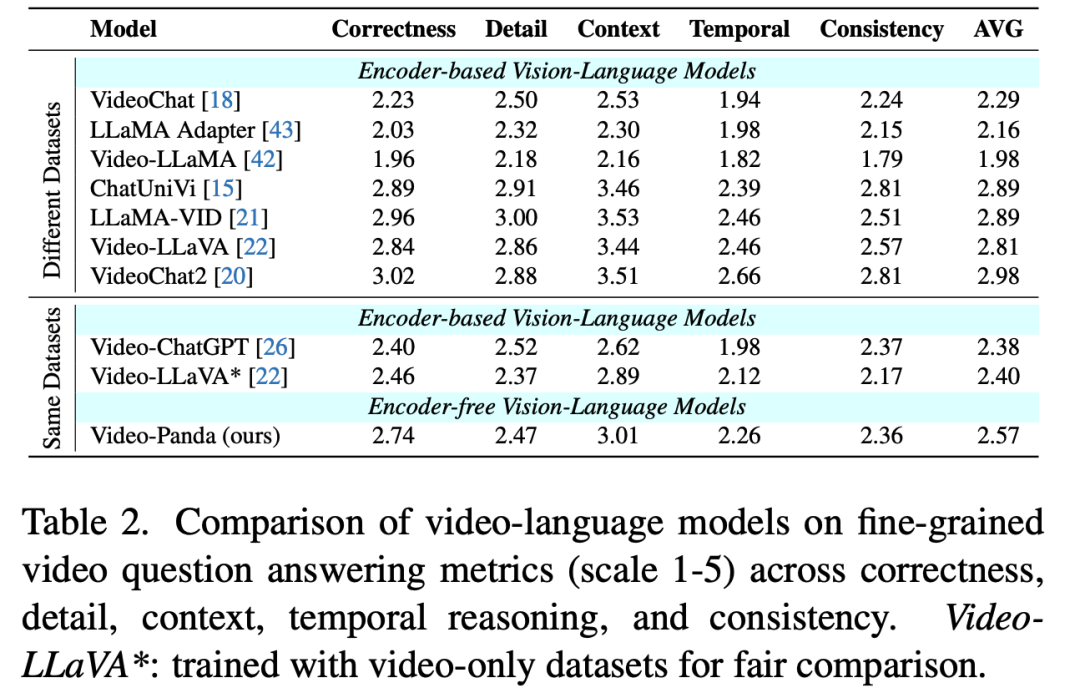

- 细粒度视频问答:使用Video-ChatGPT引入的基准测试评估模型在五个维度上的表现:正确性、细节、上下文理解、时间理解和一致性。

- 参数和推理时间比较:

- 比较了Video-Panda模型与其他模型在参数数量和推理时间上的差异。

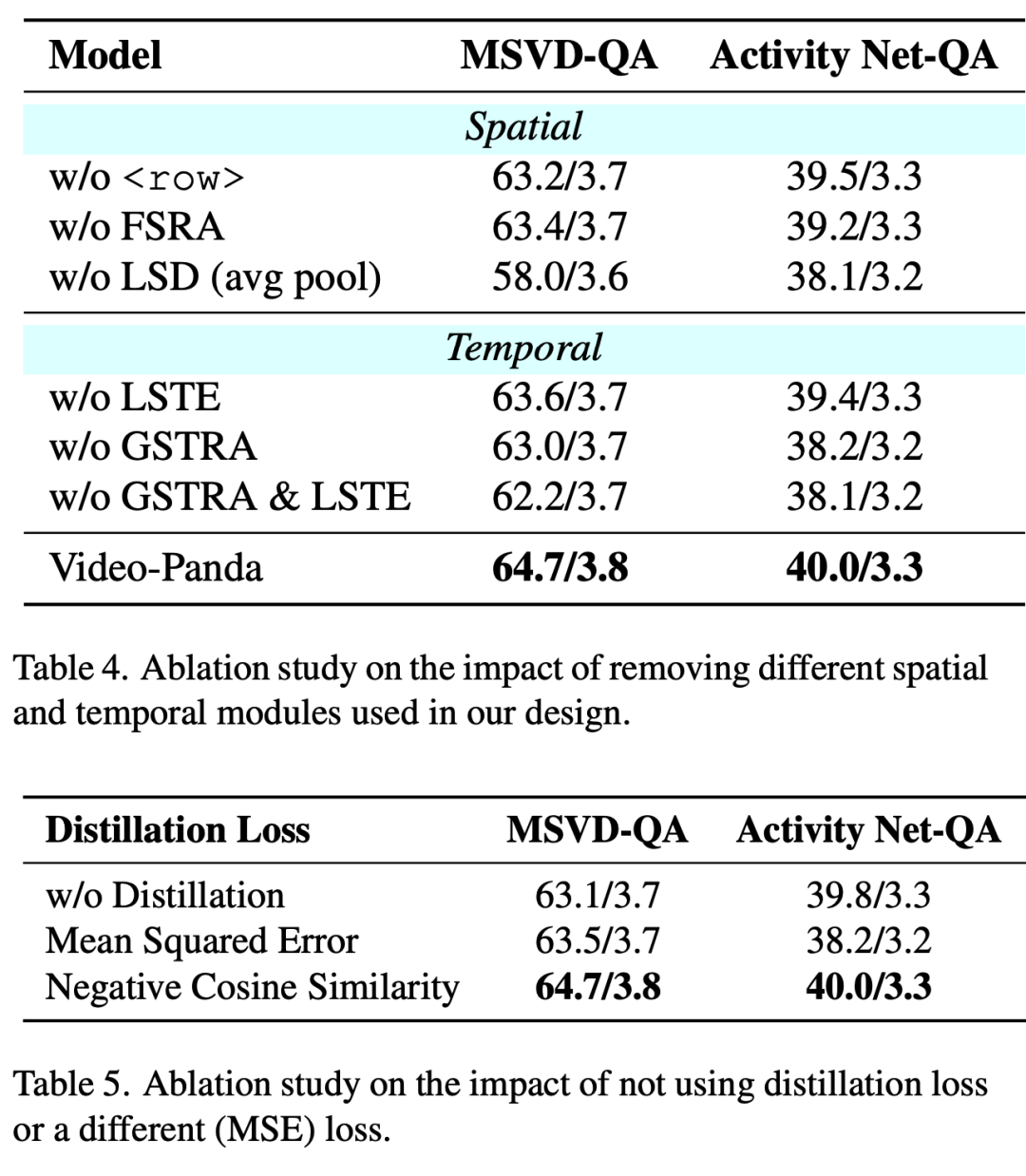

- 分析和消融研究:

- 对模型的不同架构组件、蒸馏损失函数以及空间和时间聚合器的影响进行了消融研究。

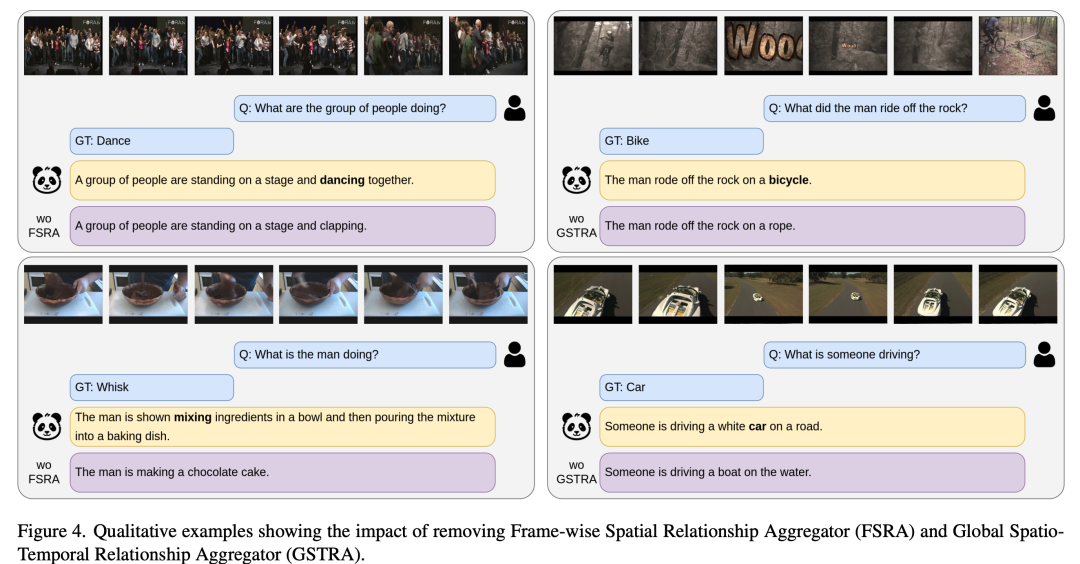

- 提供了定性的例子来展示FSRA和GSTRA组件在准确视觉理解中的关键作用。

这些实验全面评估了Video-Panda模型在视频语言理解任务上的性能,并与现有的基于编码器的方法进行了比较,展示了其在参数效率、处理速度和理解能力方面的优势。

论文的主要内容:

论文中进行了一系列实验来评估提出的Video-Panda模型的性能,这些实验包括:

- 数据集和实现细节:

- 使用了三个阶段的训练数据集,包括从WebVid数据集中采样的351K视频-文本对(Valley数据集的50%),完整的Valley数据集(702K对),以及额外的100K视频-文本指令数据集(VideoChatGPT数据集)。

- 在四个开放式视频问答(VideoQA)数据集上评估模型:MSRVTT-QA、MSVD-QA、TGIF-QA和ActivityNet-QA。

- 定量评估:

- 开放式视频问答:比较了Video-Panda模型与其他基于相同数据集训练的方法以及使用更多或其他数据进行训练的方法的性能。

- 细粒度视频问答:使用Video-ChatGPT引入的基准测试评估模型在五个维度上的表现:正确性、细节、上下文理解、时间理解和一致性。

- 参数和推理时间比较:

- 比较了Video-Panda模型与其他模型在参数数量和推理时间上的差异。

- 分析和消融研究:

- 对模型的不同架构组件、蒸馏损失函数以及空间和时间聚合器的影响进行了消融研究。

- 提供了定性的例子来展示FSRA和GSTRA组件在准确视觉理解中的关键作用。

这些实验全面评估了Video-Panda模型在视频语言理解任务上的性能,并与现有的基于编码器的方法进行了比较,展示了其在参数效率、处理速度和理解能力方面的优势。

2.DrivingGPT: Unifying Driving World Modeling and Planning with Multi-modal Autoregressive Transformers

标题:DrivingGPT:通过多模态自回归变压器统一驾驶世界建模和规划

作者:Yuntao Chen, Yuqi Wang, Zhaoxiang Zhang

文章链接:https://arxiv.org/abs/2412.18607

项目代码:https://rogerchern.github.io/DrivingGPT/

摘要:

基于世界模型的搜索和规划被广泛认为是通向人类水平物理智能的一条有希望的道路。然而,当前的驾驶世界模型主要依赖于视频扩散模型,该模型专注于视觉生成,但缺乏结合动作等其他模式的灵活性。相比之下,自回归变压器在多模态数据建模方面表现出了卓越的能力。我们的工作旨在将驾驶模型仿真和轨迹规划统一为单个序列建模问题。我们引入了一种基于交错图像和动作标记的多模态驾驶语言,并开发 DrivingGPT 以通过标准的下一个标记预测来学习联合世界建模和规划。我们的 DrivingGPT 在动作条件视频生成和端到端规划方面都表现出强大的性能,超越了大规模 nuPlan 和 NAVSIM 基准的强大基线。

这篇论文试图解决什么问题?

这篇论文试图解决的主要问题是将自动驾驶中的驾驶世界建模(world modeling)和规划(planning)统一到一个可微分的框架中,以实现更高效和有效的决策制定。具体来说,论文中提到以下几个关键点:

- 驾驶世界模型的局限性:当前的驾驶世界模型主要依赖于视频扩散模型,这些模型在视觉生成方面表现出色,但缺乏整合其他模态(如动作)的灵活性。

- 世界建模与规划的整合问题:尽管驾驶世界模型取得了进展,但将世界建模和规划无缝整合到一个可微分框架中的挑战仍然存在,限制了可微分模型基础规划的潜力。

- 多模态数据处理:为了克服上述限制,论文探索了自然处理多模态输入和输出并能实现端到端可微分规划的替代架构,特别是自回归变换器(autoregressive transformers),它们在广泛的任务中展示了出色的建模能力。

- 驾驶任务的统一建模:论文提出了一种基于交错图像和动作令牌的多模态驾驶语言,并开发了DrivingGPT模型,通过标准的下一个令牌预测来同时学习联合世界建模和规划。

总结来说,论文的核心目标是利用自回归变换器的建模能力,将视觉驾驶世界建模和端到端驾驶轨迹规划统一为一个序列建模问题,并通过实验验证了这种方法在大规模真实世界数据集上的有效性。

论文如何解决这个问题?

1. 多模态驾驶语言的构建

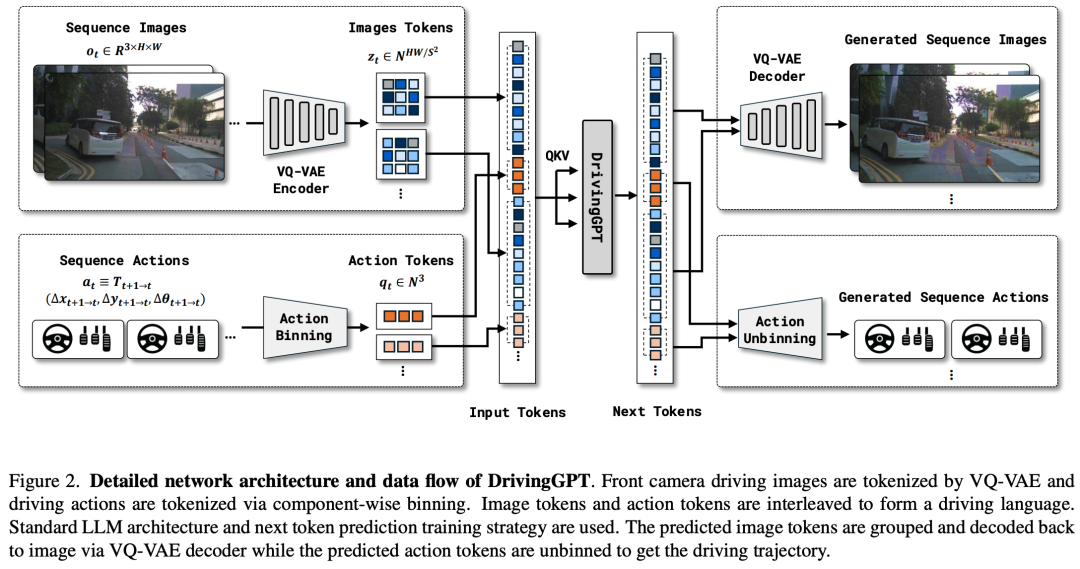

- 视觉令牌化(Observation Tokenization):使用预训练的VQ-VAE将驾驶视频帧转换为离散的图像令牌。

- 动作令牌化(Action Tokenization):将驾驶轨迹转换为帧到帧的相对动作,并将这些动作量化到离散的桶中,形成动作令牌。

- 统一的视觉-动作序列建模:将图像令牌和动作令牌交错组合,形成一个统一的驾驶语言,并利用自回归变换器进行下一个令牌预测。

2. DrivingGPT模型的设计

- Llama-like架构:采用类似Llama的架构,使用帧级别的1D旋转嵌入(rotary embeddings)来建模多模态驾驶语言。

- 标准下一个令牌预测:通过标准的下一个令牌预测训练策略,使模型能够同时学习世界建模和规划任务。

3. 端到端规划和世界建模的联合学习

- 整合动作到轨迹:由于模型使用的是帧到帧的相对动作,需要将这些相对动作整合回绝对驾驶轨迹。

- 通过连续乘以相对姿态矩阵来获得绝对姿态,并将绝对姿态转换回绝对动作。

4. 实验验证

- 大规模数据集:在大规模的真实世界数据集nuPlan和NAVSIM上进行实验,验证模型在动作条件视频生成和端到端规划任务上的性能。

- 性能对比:与现有的强基线进行比较,展示DrivingGPT在视频生成质量和规划性能上的优势。

5. 消融研究

- 不同视觉标记器的比较:评估不同视觉标记器对世界模型视觉预测质量的影响。

- 规划性能的影响因素:研究数据质量和数量对端到端规划性能的影响,以及位置嵌入对动作的重要性。

通过这些步骤,论文成功地将驾驶世界建模和规划任务统一到了一个模型中,并通过实验验证了这种方法的有效性。这种方法不仅提高了视频生成的质量和规划的准确性,还为未来可微分模型基础规划的探索奠定了基础

论文做了哪些实验?

1. 实施细节

- 训练:描述了模型训练时使用的图像尺寸、VQ-VAE的下采样率、图像和动作的词汇表大小、优化器设置、学习率、权重衰减、动量等参数。

- 推理:说明了图像令牌的采样策略,包括温度参数和top-k策略,以及如何生成长时间视频序列。

2. 数据集和指标

- nuPlan:包含1282小时的驾驶场景数据,用于评估模型。

- NAVSIM:由nuPlan数据重新采样得到,用于快速测试和评估。

- 规划指标:使用PDMS(Predictive Driver Model Score)评估端到端规划性能,包括NC、DAC、TTC、Comfort和EP五个子指标。

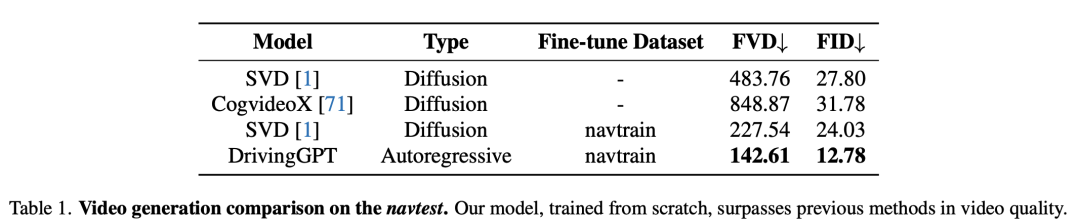

- 世界建模指标:使用FVD(Frechet Video Distance)和FID(Frechet Inception Distance)评估视频生成质量。

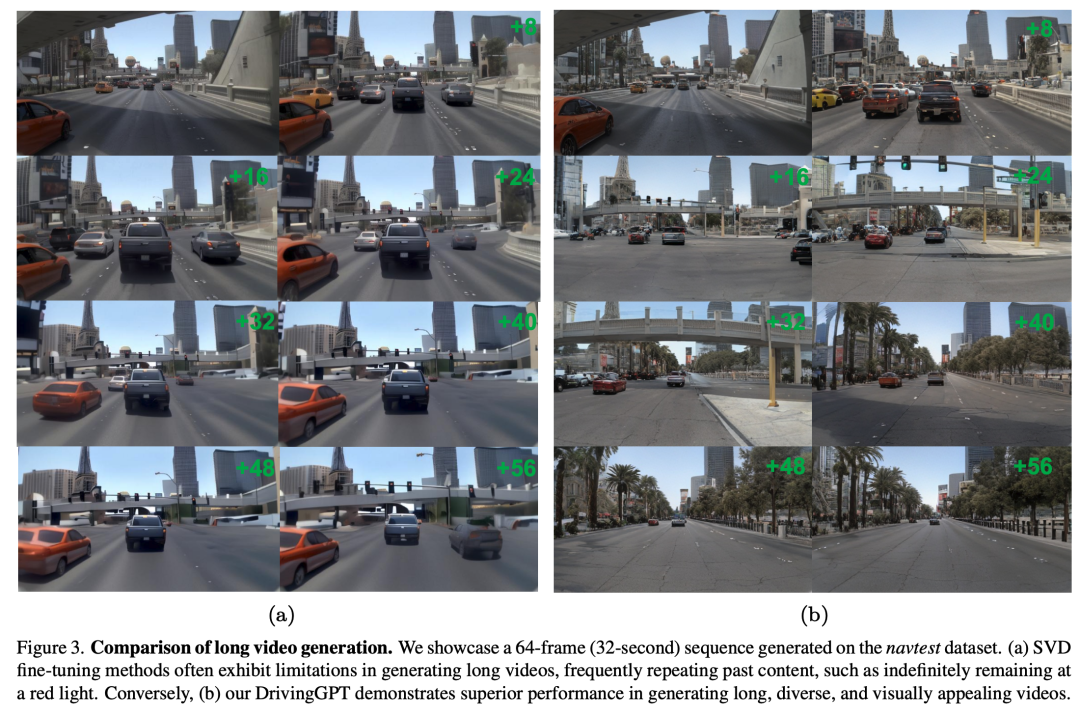

3. 视频生成

- 与现有方法的比较:在navtest数据集上与几种方法进行了视频生成质量的定量比较。

- 长视频生成:评估模型生成超过64帧的长视频序列的能力,并与SVD方法进行了比较。

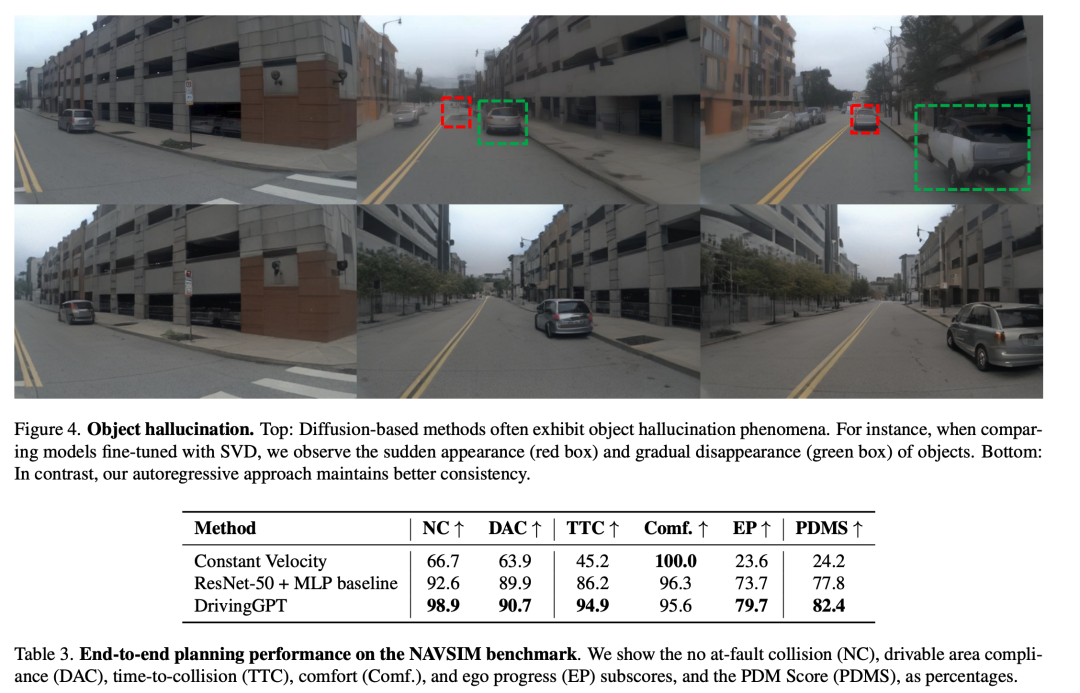

- 减少对象幻觉:展示了自回归模型在减少对象突然消失或出现现象方面的优势。

4. 端到端规划

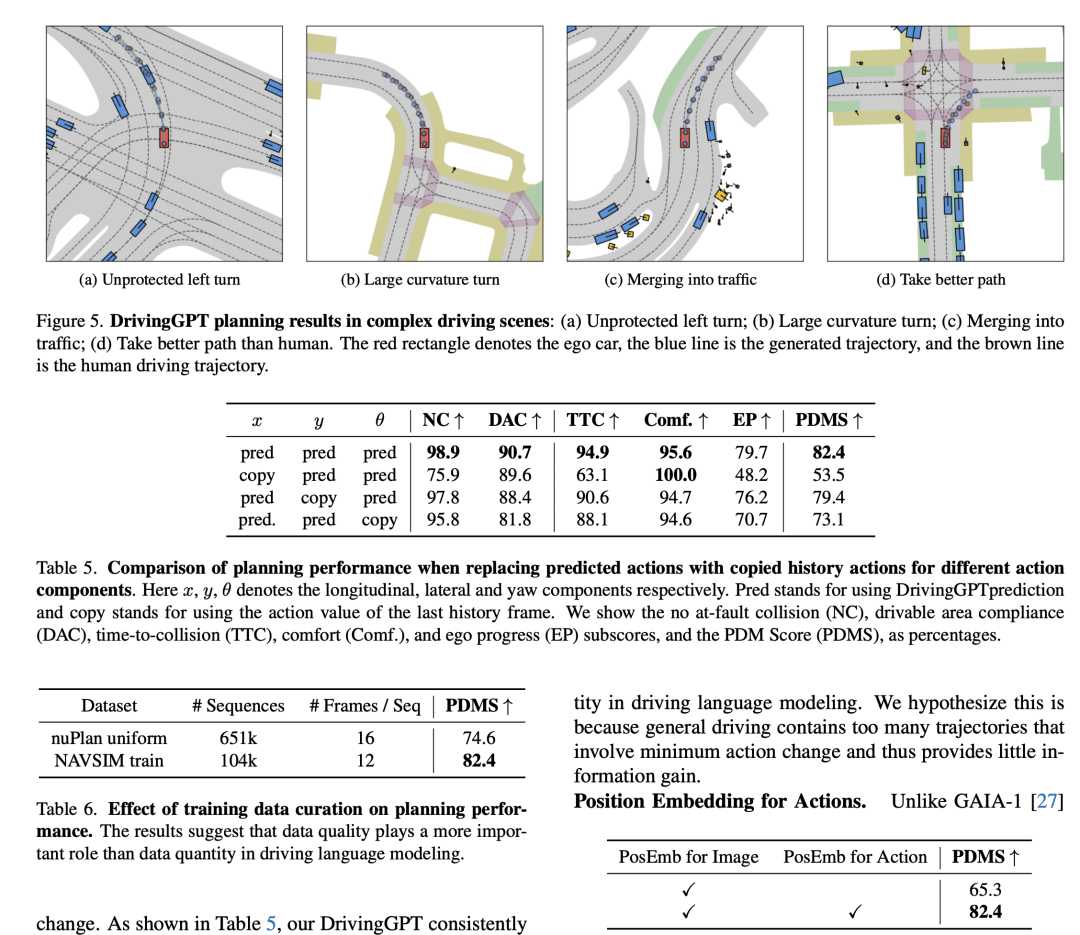

- 在NAVSIM基准测试上的评估:展示了DrivingGPT在更具挑战性的NAVSIM基准测试中的规划性能,并与基线模型进行了比较。

5. 消融研究

- 不同视觉标记器的比较:评估了不同视觉标记器对视频生成质量的影响。

- 规划解决方案的学习与复制:探讨了DrivingGPT是否真正学习了驾驶还是仅仅复制了历史驾驶动作。

- 训练数据策划对规划的影响:研究了数据质量与数量对端到端规划性能的影响。

- 动作的位置嵌入:分析了对动作应用位置嵌入对规划性能的影响。

这些实验全面评估了DrivingGPT模型在视频生成和端到端规划任务上的性能,并与现有技术进行了比较,证明了其在统一建模和规划方面的有效性和优越性。

论文的主要内容:

本文提出了一种名为DrivingGPT的模型,旨在通过多模态自回归变换器统一自动驾驶中的驾驶世界建模和规划问题。以下是论文的主要内容总结:

1. 问题定义

- 论文指出当前驾驶世界模型主要依赖于视频扩散模型,这些模型在视觉生成方面表现出色,但缺乏整合动作等其他模态数据的灵活性。

- 将驾驶规划和世界建模整合到一个可微分框架中的挑战尚未得到有效解决。

2. 方法论

- 提出了一种基于交错图像和动作令牌的多模态驾驶语言。

- 开发了DrivingGPT模型,利用标准下一个令牌预测来同时学习世界建模和规划任务。

3. 模型架构

- 使用预训练的VQ-VAE将图像离散化为令牌,并把驾驶动作量化为离散动作令牌。

- 设计了类似Llama的架构,采用帧级别的1D旋转嵌入来建模多模态驾驶语言。

4. 实验

- 在nuPlan和NAVSIM这两个大规模真实世界数据集上进行了实验。

- 验证了DrivingGPT在动作条件视频生成和端到端规划任务上的性能,并与现有技术进行了比较。

5. 消融研究

- 探讨了不同视觉标记器、数据质量和数量对规划性能的影响,以及位置嵌入对动作的重要性。

6. 结论

- DrivingGPT证明了统一学习世界建模和规划的可行性,并为未来可微分模型基础规划的探索奠定了基础。

总体而言,论文提出了一种创新的方法来整合自动驾驶中的驾驶世界建模和规划任务,并展示了通过多模态自回归变换器进行端到端学习的潜力。

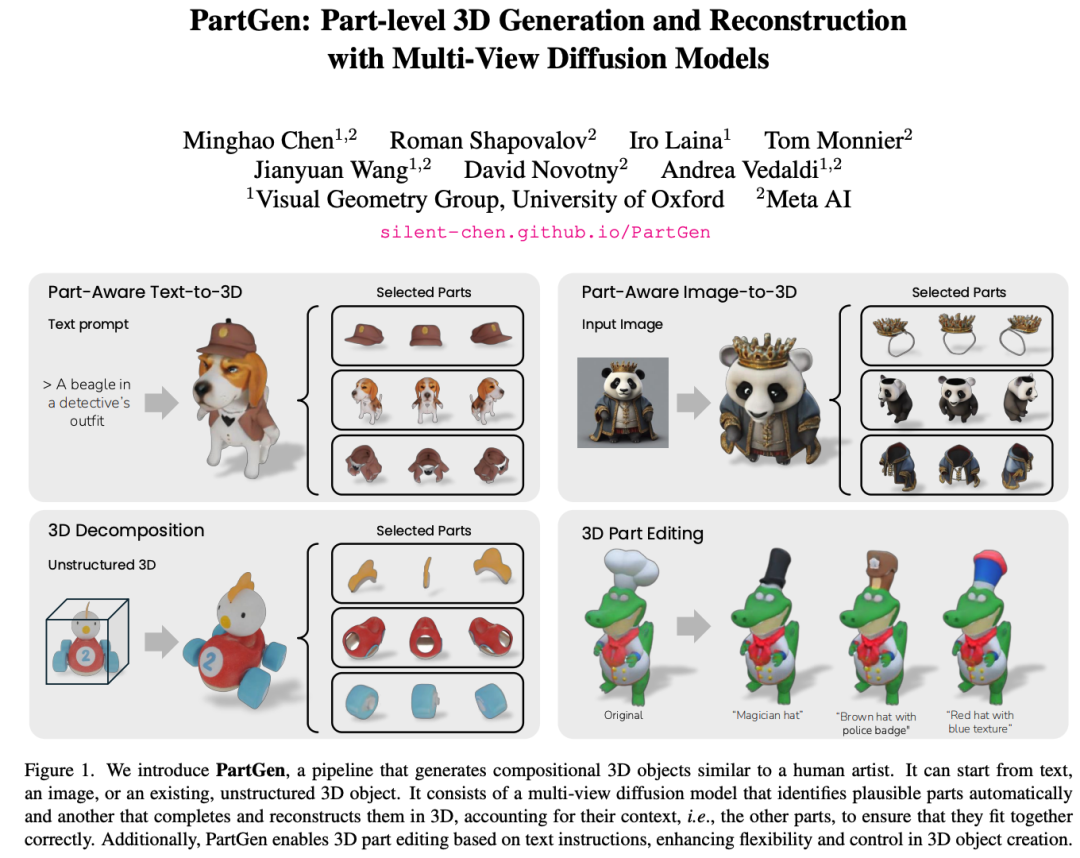

3.PartGen: Part-level 3D Generation and Reconstruction with Multi-View Diffusion Models

标题:PartGen:使用多视图扩散模型进行零件级 3D 生成和重建

作者:Minghao Chen, Roman Shapovalov, Iro Laina, Tom Monnier, Jianyuan Wang, David Novotny, Andrea Vedaldi

文章链接:https://arxiv.org/abs/2412.18608

项目代码:https://silent-chen.github.io/PartGen/

摘要:

文本或图像转 3D 生成器和 3D 扫描仪现在可以生成具有高质量形状和纹理的 3D 资源。这些资产通常由单个融合表示组成,例如隐式神经场、高斯混合或网格,没有任何有用的结构。然而,大多数应用程序和创意工作流程要求资产由几个可以独立操作的有意义的部分组成。为了解决这一差距,我们引入了 PartGen,这是一种新颖的方法,可以从文本、图像或非结构化 3D 对象开始生成由有意义的部分组成的 3D 对象。首先,给定生成或渲染的 3D 对象的多个视图,多视图扩散模型会提取一组合理且视图一致的部分分割,将对象划分为多个部分。然后,第二个多视图扩散模型分别获取每个部分,填充遮挡,并通过将这些完成的视图馈送到 3D 重建网络来使用这些完整视图进行 3D 重建。此完成过程考虑整个对象的上下文,以确保各个部分紧密结合。生成补全模型可以弥补由于遮挡而缺失的信息;在极端情况下,它可以根据输入的 3D 资源幻化出完全不可见的部分。我们在生成的和真实的 3D 资产上评估了我们的方法,并表明它的性能大大优于分割和部分提取基线。我们还展示了 3D 零件编辑等下游应用程序。

这篇论文试图解决什么问题?

这篇论文介绍了一个名为PartGen的管道,旨在解决3D对象生成和重建中结构化表示的问题。具体来说,论文试图解决以下几个关键问题:

- 从文本、图像或非结构化3D对象生成有意义的部分组成的3D对象:现有的3D生成器和3D扫描仪可以生成高质量的形状和纹理资产,但这些资产通常是单一的、融合的表示形式,如隐式神经场、高斯混合或网格,缺乏有用的结构。PartGen旨在从文本、图像或非结构化的3D对象开始,生成由有意义的部分组成的3D对象。

- 自动分割3D对象为部分:由于不同的艺术家可能会以不同的方式分解同一个对象,因此对于任何给定的3D对象都没有“金标准”的分割。PartGen通过使用多视图扩散模型来提取可能且视图一致的部分分割集,将对象划分为部分。

- 提取高质量、完整的3D部分:即使这些部分从3D对象的外部只能部分看到或根本看不到,PartGen也能够完成这些部分的提取。这涉及到完成这些部分甚至完全基于输入的3D资产想象出不可见的部分。

- 处理分割和完成的歧义性:由于分割和完成任务的高度歧义性,PartGen基于3D生成模型来模拟这种歧义性,允许通过重新采样模型来获得多个合理的分割。

总的来说,PartGen通过结合多视图扩散模型和3D重建网络,提供了一种从不同输入模态生成结构化3D对象的新方法,并展示了其在3D部分编辑等下游应用中的潜力。

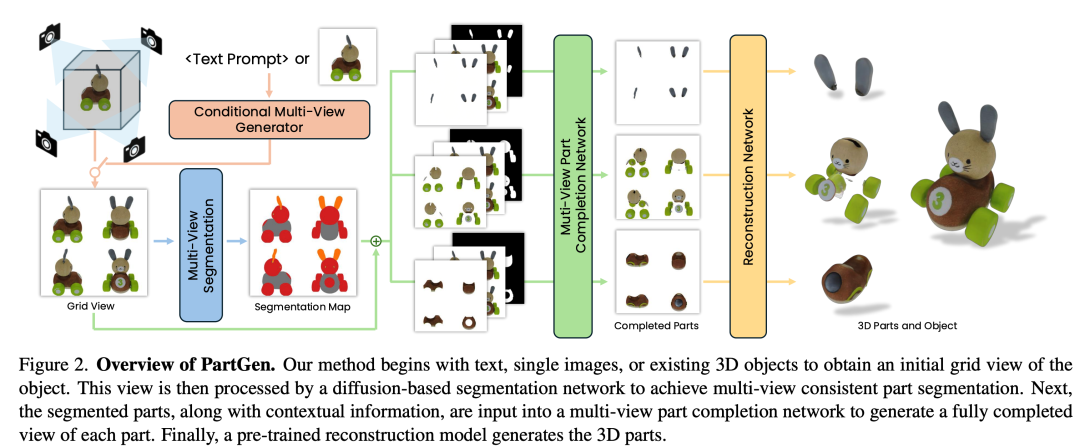

论文如何解决这个问题?

论文通过提出PartGen这一方法来解决3D对象的结构化生成和重建问题,具体解决方案包含以下几个关键步骤:

1. 多视图部分分割(Multi-view part segmentation)

- 问题定义:将对象分解为部分的问题被定义为一个多视图分割任务,而不是直接的3D分割问题。

- 方法:使用一个多视图图像生成器(Φseg),该生成器被微调以输出一个颜色编码的多视图分割图,其中每个部分被分配一个唯一的颜色。

- 训练:在艺术家创建的数据集上训练此模型,以捕捉3D艺术家如何将对象分解为部分。

- 测试时提取:通过多次运行Φseg并量化输出图像来获得不同的分割。

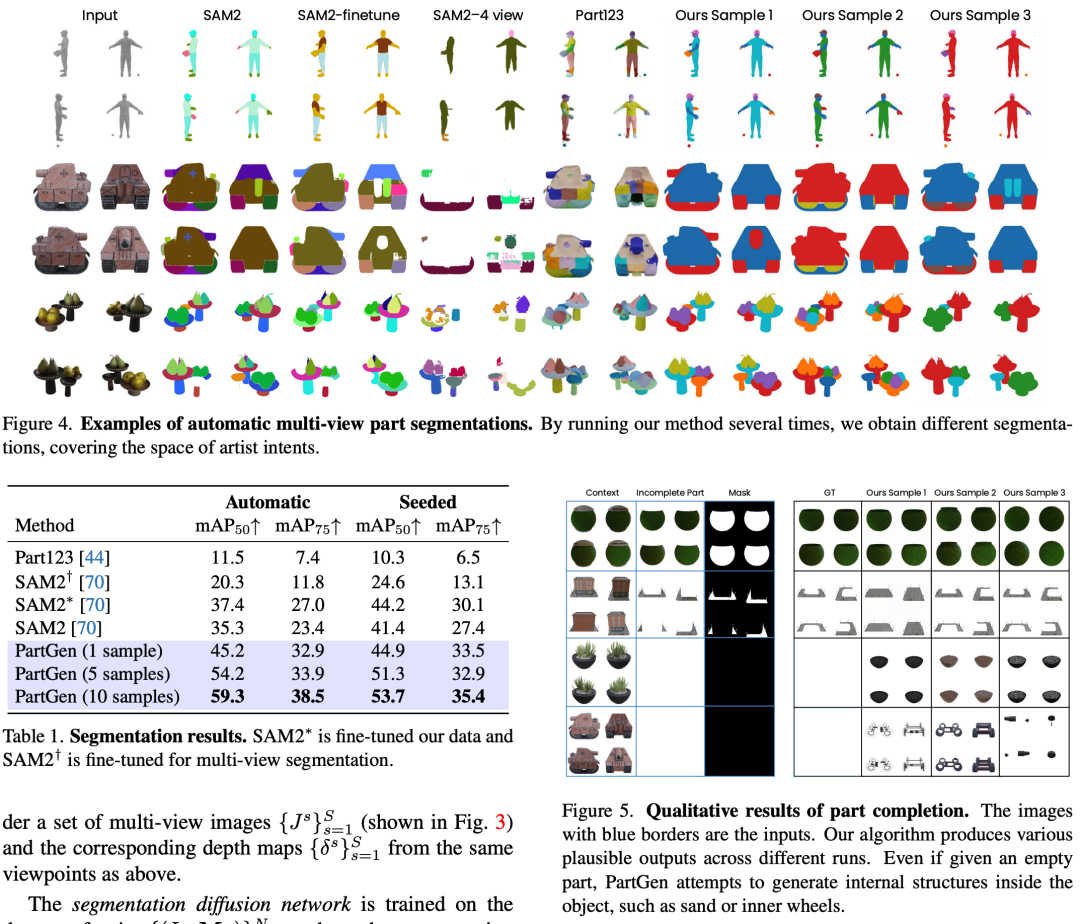

2. 上下文部分补全(Contextual part completion)

- 问题定义:将分割的部分转换为完整的3D部分重建的问题。

- 方法:再次使用多视图生成器(Φ),这次是为了完成部分的视图,考虑到整个对象的上下文。

- 训练:提供被掩蔽的图像、未掩蔽的图像和掩蔽本身作为条件,以微调模型。

- 实现细节:网络架构与部分分割类似,但扩展了条件输入。

3. 部分重建(Part reconstruction)

- 方法:使用重建模型(RM)直接从完成的多视图部分图像中重建3D部分。

- 实现细节:不需要特别的微调,任何高质量的重建模型都可以直接应用于这一流程。

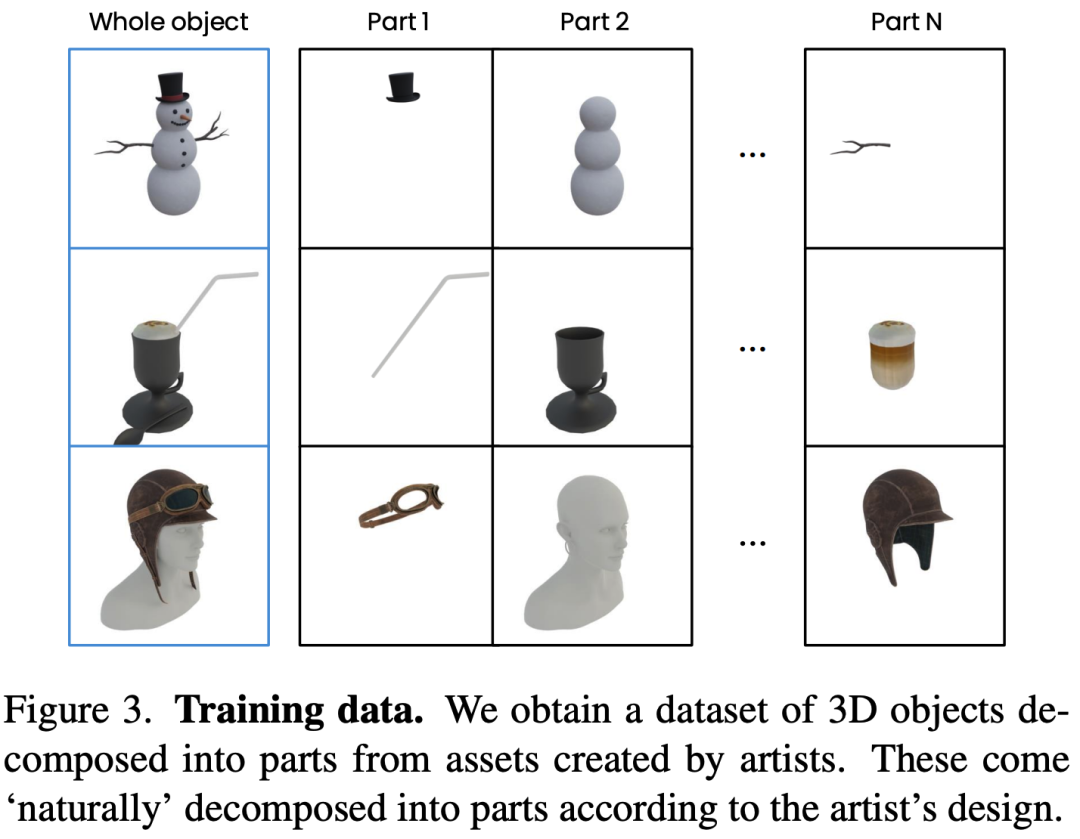

4. 训练数据(Training data)

- 数据集构建:从艺术家创建的3D资产中构建数据集,每个资产被存储为GLTF场景,包含多个通常与语义部分对应的水密网格。

5. 应用(Applications)

- 文本到3D生成:将PartGen应用于基于文本提示的3D对象生成。

- 图像到3D生成:基于图像提示的3D对象生成。

- 真实世界3D对象分解:将PartGen应用于真实世界3D扫描对象的分解。

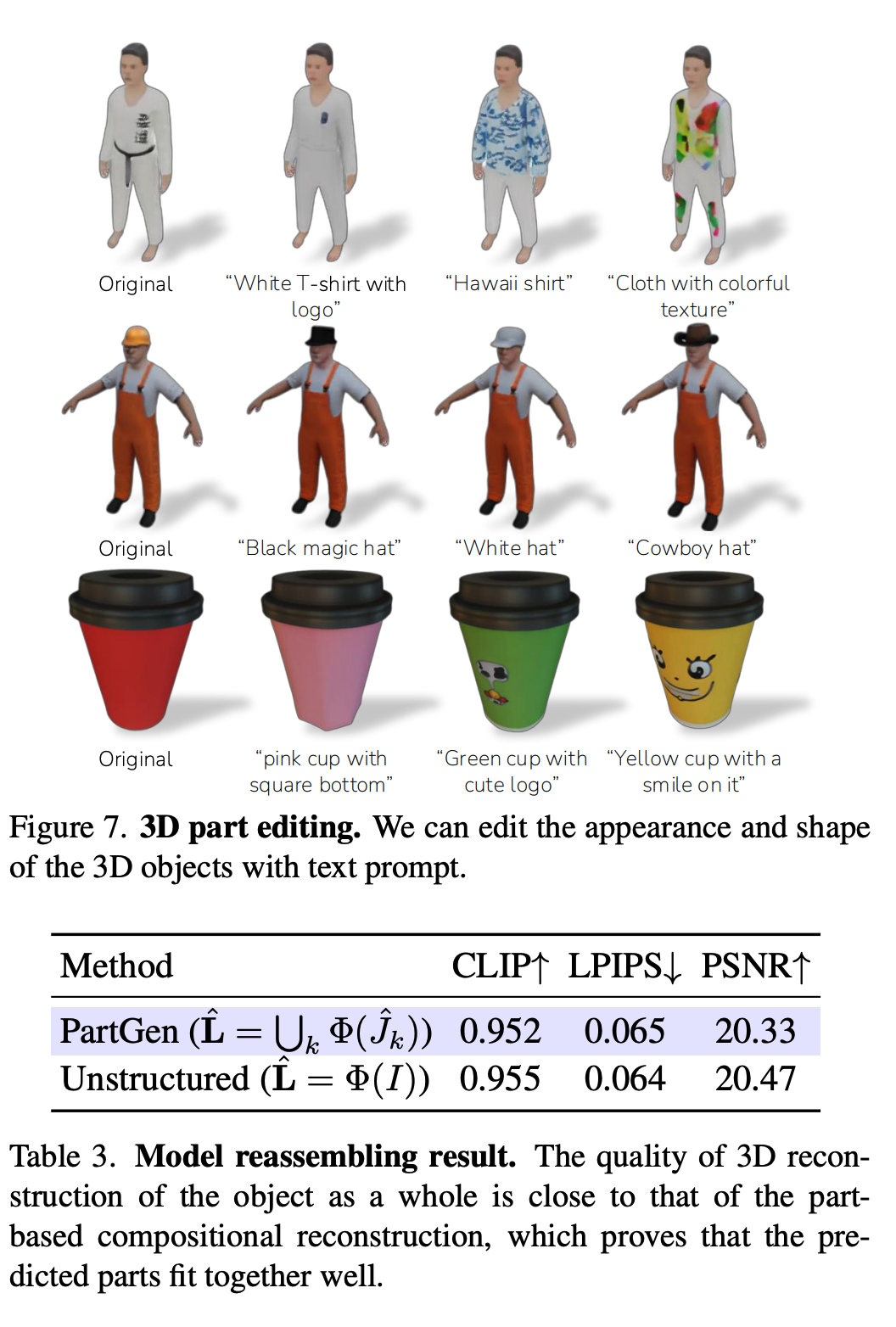

- 3D部分编辑:展示了基于文本输入编辑3D对象形状和纹理的能力。

通过这些步骤,PartGen能够从文本、图像或非结构化的3D对象生成具有明确部分的3D对象,并在需要时对这些部分进行编辑和操作。这种方法为3D对象的生成和重建提供了一种新颖的、结构化的方法,使其更适合专业工作流程。

论文做了哪些实验?

论文中进行了一系列实验来评估PartGen方法的性能,具体包括以下几个方面:

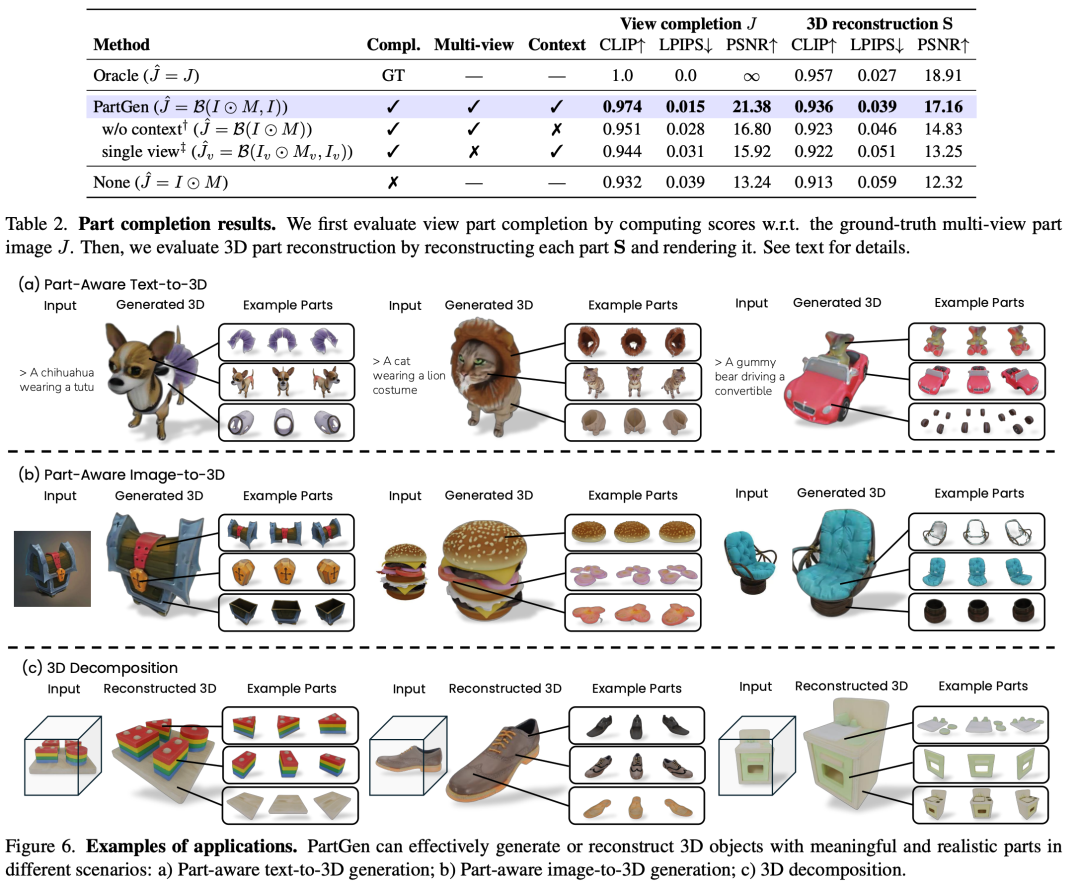

1. 部分分割(Part Segmentation)

- 评估协议:设置了自动部分分割和种子分割两个设置。自动部分分割要求方法从多视图图像I中输出所有部分M1, ..., MS,而种子分割则假设用户提供一个特定掩码的点作为额外输入。

- 基线:使用原始和微调的SAM2作为多视图分割的基线。

- 结果:PartGen在mAP(平均精度均值)结果上明显高于其他方法,包括在我们数据上微调的SAM2。

2. 部分补全和重建(Part Completion and Reconstruction)

- 评估协议:使用峰值信噪比(PSNR)、学习感知图像补丁相似性(LPIPS)和CLIP相似性来评估补全算法的性能,并评估预测补全的质量。

- 基线:与几个基线进行比较,包括不进行补全、省略上下文、独立完成单视图等。

- 结果:PartGen在多个指标上均优于基线,证明了联合多视图推理和上下文部分补全的重要性。

3. 部件重新组装(Reassembling Parts)

- 评估协议:从3D对象L的多视图图像I开始,运行分割算法获得分割(M^1,...,M^SM^1,...,M^S),重建每个3D部分,并重新组装3D对象L^L^。

- 结果:PartGen的方法与直接使用重建模型(L^=Φ(I)L^=Φ(I))重建对象的性能相当,额外的好处是产生结构化为部分的重建。

4. 应用(Applications)

- 文本到3D生成:展示了PartGen在基于文本提示的3D对象生成方面的有效性。

- 图像到3D生成:展示了PartGen在基于图像提示的3D对象生成方面的有效性。

- 真实世界3D对象分解:展示了PartGen在分解真实世界3D扫描对象方面的有效性。

- 3D部分编辑:展示了一旦3D部分被分解,它们可以根据文本输入进行进一步修改的能力。

这些实验全面评估了PartGen在不同输入模态下的性能,并展示了其在3D对象创建和编辑中的灵活性和控制能力。通过这些实验,论文证明了PartGen是一种有前景的方法,用于生成在专业工作流程中更有用的3D资产。

论文的主要内容:

这篇论文介绍了PartGen,这是一个用于3D对象的生成和重建的管道,它可以从文本、图像或非结构化的3D对象生成具有明确部分的3D对象。以下是论文的主要内容总结:

- 问题定义:论文指出现有的3D生成器和扫描仪产生的资产缺乏有用的结构,这限制了它们在专业环境中的可用性。PartGen旨在通过生成有意义的部分来解决这个问题。

- 方法介绍:PartGen包括两个主要的多视图扩散模型,一个用于自动分割3D对象为部分,另一个用于完成和重建这些部分,确保它们能够正确地组合在一起。

- 多视图部分分割:PartGen将3D对象分解为部分的问题视为一个多视图分割任务,通过微调多视图图像生成器来预测每个部分的颜色编码分割图。

- 上下文部分补全:对于部分重建,PartGen使用多视图生成器来补全被遮挡的部分,同时考虑整个对象的上下文,以确保部分能够正确地整合。

- 部分重建:补全的部分视图被送入3D重建网络,以生成完整的3D部分。

- 训练数据:PartGen使用由艺术家创建的140k个3D资产的数据集进行训练,这些资产被分解为多个部分,为模型提供了训练所需的标注数据。

- 实验:论文通过一系列实验评估了PartGen在分割、补全和重建任务上的性能,并展示了其在不同输入模态下的应用,包括文本到3D生成、图像到3D生成、真实世界3D对象分解和3D部分编辑。

- 应用:PartGen不仅能够生成3D对象,还能够基于文本指令进行3D部分编辑,增加了3D对象创建的灵活性和控制能力。

- 结论:PartGen是一个有前景的方法,用于生成在专业工作流程中更有用的3D资产,能够重建甚至不可见的3D部分,利用特别设计的多视图扩散先验。

总体而言,PartGen通过结合多视图扩散模型和3D重建网络,提供了一种从不同输入模态生成结构化3D对象的新方法,并展示了其在3D部分编辑等下游应用中的潜力。

本文参与 腾讯云自媒体同步曝光计划,分享自微信公众号。

原始发表:2024-12-28,如有侵权请联系 cloudcommunity@tencent.com 删除

评论

登录后参与评论

推荐阅读

目录