具身智能中VLA(视觉-语言-动作)技术论文解读

原创具身智能中VLA(视觉-语言-动作)技术论文解读

原创

languageX

发布于 2025-04-29 15:01:53

发布于 2025-04-29 15:01:53

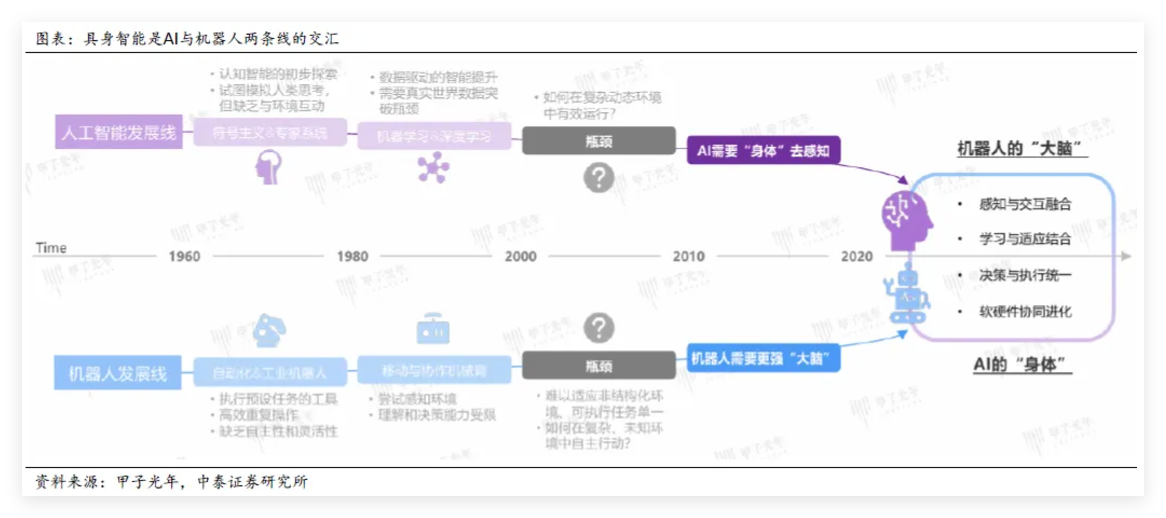

上个月的“全球首场人机马拉松”的赛事,可以说是具身智能技术发展的一个小里程碑。不过机器人们的躺平,摔倒,瘫痪,掉头等突发状况也直观暴露了当前具身智能技术的瓶颈:大脑和四肢协调能力、续航能力、环境感知与决策等问题,所以在复杂环境的长距离运动对机器人的“身体”(硬件)与“大脑”(算法)都还是一个很大的挑战。

不过这场马拉松也说明了技术突破不是实验室里的静态迭代出来的,而是需要在真实世界的复杂场景中“跌撞奔跑”。

正好最近在看VLA(Vision-Language-Action)模型相关技术,VLA的核心目标就是解决感知、语言和行动之间的断层问题。

本文主要和大家讨论下VLA相关技术~

1. 大语言模型(LLM-Large Language Model)

大语言模型大家肯定不陌生了,前年年初在我独到的技术见解:LLM的演进与发展中我也做过比较详细的介绍,本文就不再介绍。其中聊到过ChatGPT的出现让自然语言任务做到了"统一"。之前是一个模型解决一个问题,LLM是一个模型可以解决自然语言的"所有"问题。

2. 视觉-语言模型(Vision-Language Model)

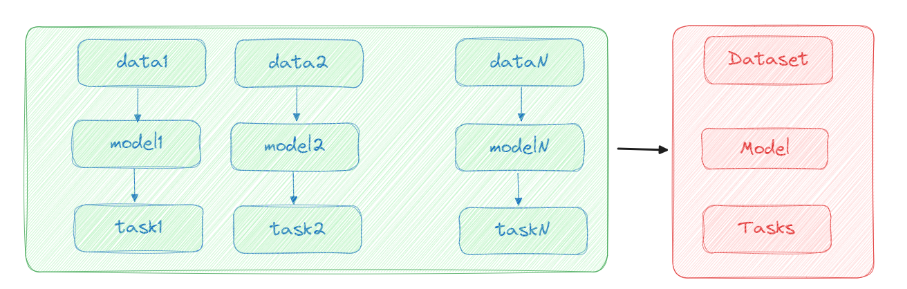

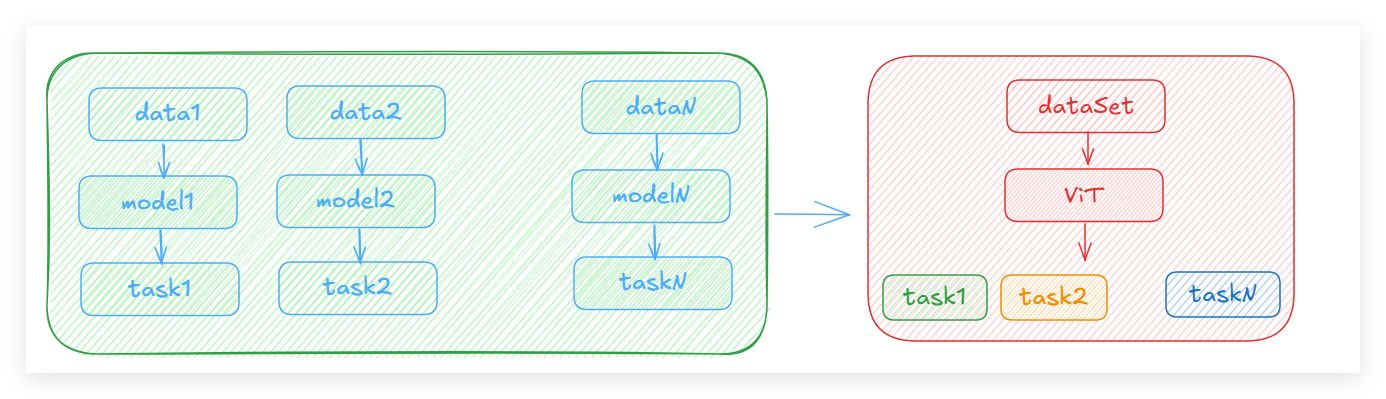

计算机视觉任务最常见的就是图像/视频的分类,检测,分割,生成等,在Transformer应用到CV之前,由于CNN提取特征的泛化能力并没有很好,也是针对每类需求场景去训练一个模型。

ViT(Vision Transformer)的出现将Transformer技术引入到计算机视觉领域,让视觉编码器或者说特征表达的效果更好,基座模型可以很好的泛化到下游任务。

VLM则是从单模态到多模态的融合。比如CLIP技术通过对比学习将文本特征和图像特征对齐;BLIP引入QFormer模块做模态间对齐,以及目前主流的MMLM视觉编码器--VL适配器--大语言模型,比如Qwen-VL。

现在大家更常用的说法是多模态大模型,VLM其实也是多模态大模型,只是MMLM的概念要更泛,它可以是融合了计算机视觉,音频,自然语言等多个模态的跨域。本文不做过多介绍。

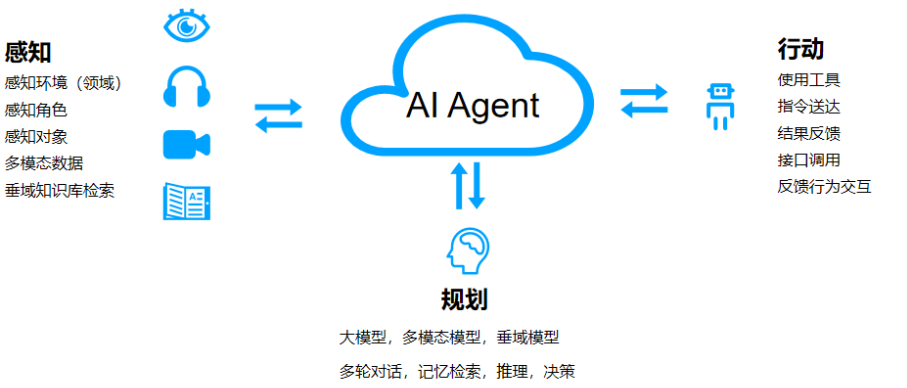

3. 智能体(Agent)

Agent在前年AIAgent:我不是只有AI脑!中也有比较详细的介绍。现在Agent的文章更是铺天盖地,出现的产品也不少。甚至大模型的工具调用协议MCP,Agent之间的协议A2A都已经出现,发展还是太快。

我们可以认为Agent目前已经有四个阶段:

- 单个Agent

- 多Agent协作(单集群上)

- Agent调用工具服务(MCP)

- Agent之间的分布式调用(A2A)

但是Agent本质核心不变:感知,决策,行动,反思

4. 具身智能

上面谈到智能体需要感知环境、自主决策并执行任务。LLM连个本体都没有,执行任务就是调用服务~落地场景始终还是在软件层面。而具身智能则是天生Agent圣体~

具身智能的三要素:

“本体”,即硬件载体

“智能”,即大模型、语音、图像、控制、导航等算法;

“环境”,即本体所交互的物理世界。

本体、智能、环境的高度耦合才是高级智能的基础。

具身和智能两条线,在具身智能上汇合了。

目前具身大模型可以分为两大流派,一类是端到端大模型,一类是分层具身大模型。

1)端到端大模型:能够直接实现从人类指令到机械臂执行,即输入图像及文本指令,输出夹爪末端动作。

2)分层具身大模型:不同层次模型协作,上层大模型进行感知与决策,底层硬件层和中间响应快的小模型进行决策的分解与执行。

目前,由于受数据制约难以达到性能要求,端到端大模型尚未成为主流选择,更多厂商还是选择以分层模型为机器人的具身智能。

分层端到端模型

在分层端到端模型方案中,机器人的四大板块(感知、规划决策、控制和执行),逐渐被类人化地划分为负责解决高层次认知或决策问题(high level)的“大脑”,以及负责基础层面的功能性问题(low level)的“小脑”。

两大系统各司其职又互相合作,“大脑”负责解析任务需求,整合来自传感器的信息,进行任务的细化和策略规划;“小脑” 则专注于精细的运动控制,确保在“大脑”制定的策略指导下,机器人能够准确无误地执行动作并进行必要的调整。目前较为普遍的方向是,机器人的“大脑”由大模型来担任,"小脑”则依然为底层控制算法。

大脑的主流方案主要是:VLM(视觉-语言模型),VLA(视觉-语言-动作),MMLM(多模态大模型),大脑也逐步往端到端演进了。

“小脑”运动控制包括基于模型的控制方法和基于学习的控制方法两个大类。

传统的基于模型的控制方法:通过建立机器人的运动学和动力学模型,进行运动轨迹规划和平衡控制。这一类方法的特点是身体控制稳健,但步频较慢,且整体开发较为复杂,成本高,不利于产品快速迭代。基于模型的控制方法具体包括ZMP判据及预观控制、混杂零动态规划方法、虚拟模型解耦控制、模型预测控制+全身控制(MPC+WBC)等。

基于学习的控制方式主要是通过自主学习的方式,也就是强化学习通过精心设计学习目标,机器人不断在环境中探索逐渐发现最大化奖励的方式学习到最优的执行策略,效果依赖于仿真环境。

到这儿终于引入我们的主题VLA。

5. VLA(Vision Language Acition)

前面介绍了LLM 和 VLM,如果我们将机器人可以执行的动作列举出function,那先利用VLM将机器人看到的利用自然语言描述传递给LLM直接输出下一步的动作,调用function执行不就好了?

但是VLM使用的训练数据是通用,往往针对机器人的Action输出效果很差。机器人是需要知道每个自由度的输出值,而且不同的机器人类别比如机械手,四足机器人,机器狗等,他们的Action是相差很大的。

因此需要基于VLA技术,Vision-Language-Action。下面基于一些经典的VLA Models论文来进行介绍。

5.1 Aloha & Mobile Aloha

先介绍下Aloha机器人。

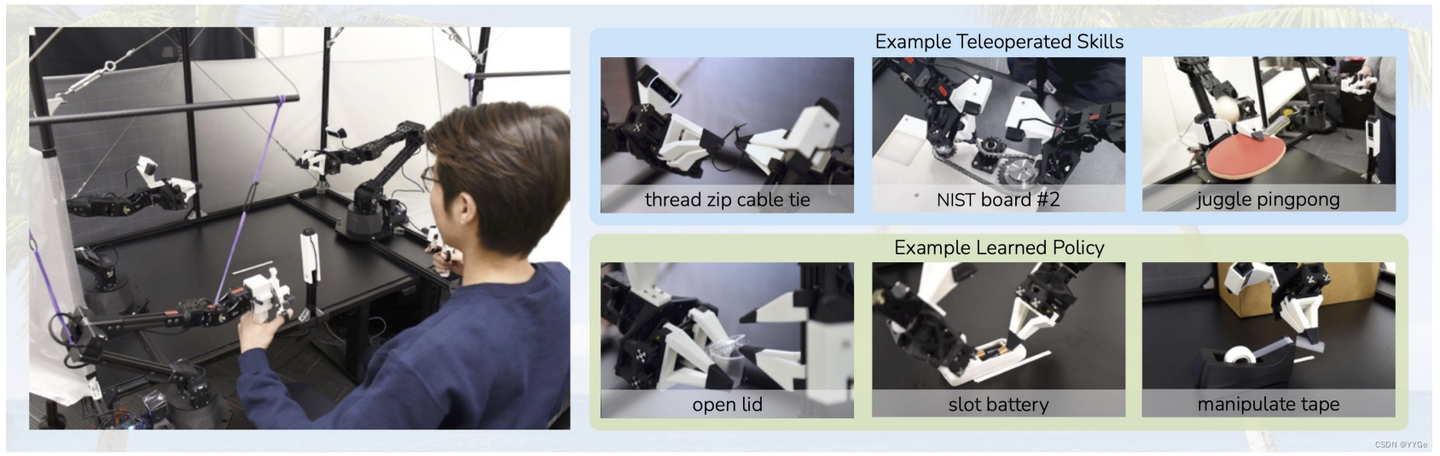

ALOHA(A Low-cost Open-source Hardware System for Bimanual Teleoperation)是斯坦福大学团队开发的低成本开源双臂远程操作机器人系统。

2023年底一代Aloha,专注在桌面远程操作,整套系统成本约3.2万美元。如下图人类通过反向驱动领导机器人进行远程操作,让机器人模仿运动,支持精细任务比如剥鸡蛋壳。

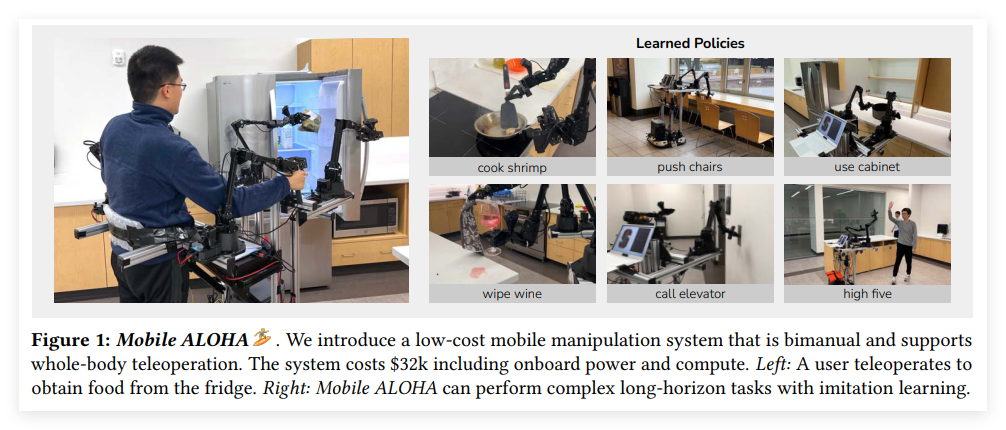

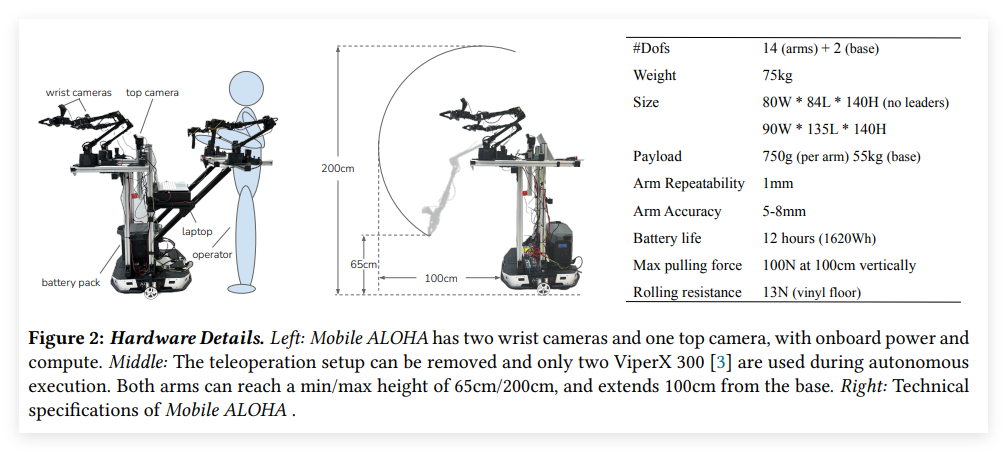

2024年1月的Mobile ALOPA,新增了机器人移动底盘,可以基于人控制进行移动操作如下图,通过协同进行数据采集以及模型训练,提升任务准确性。

5.1.1 ALOHA

论文: Learning Fine-Grained Bimanual Manipulation with Low-Cost Hardware

论文地址:https://arxiv.org/abs/2304.13705

项目地址:https://tonyzhaozh.github.io/aloha/

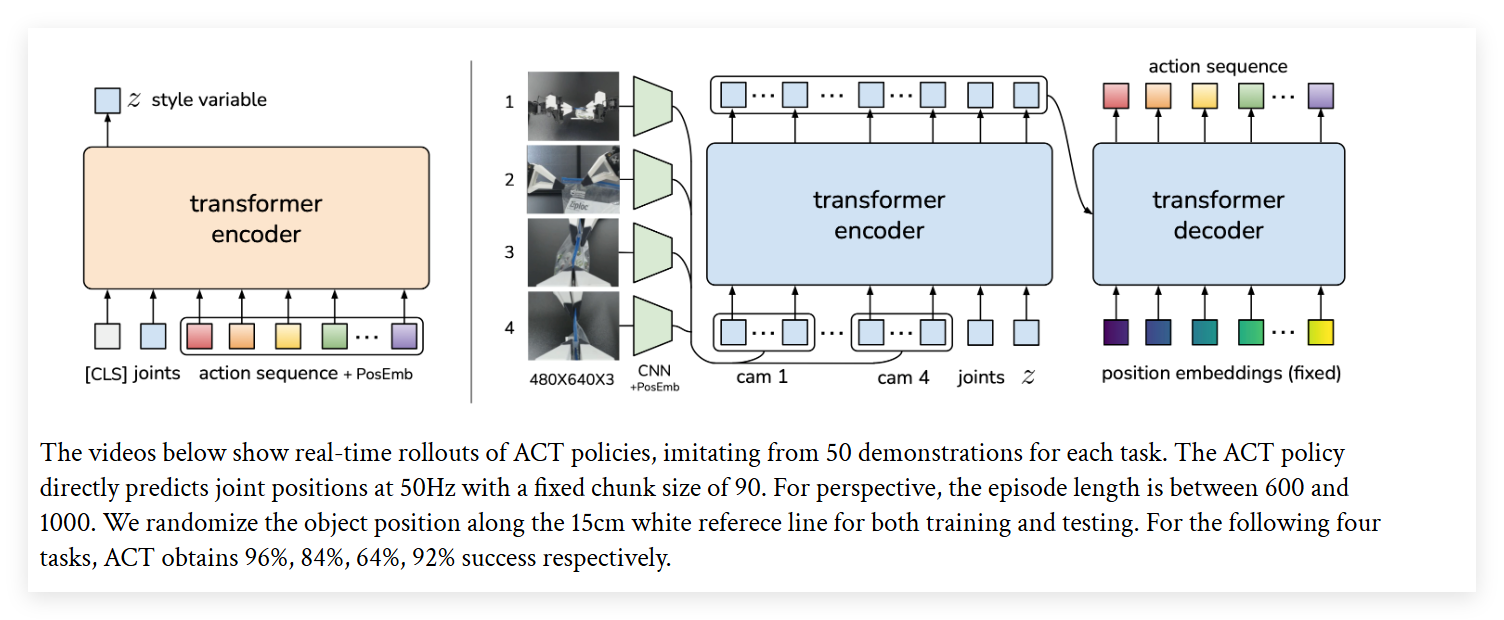

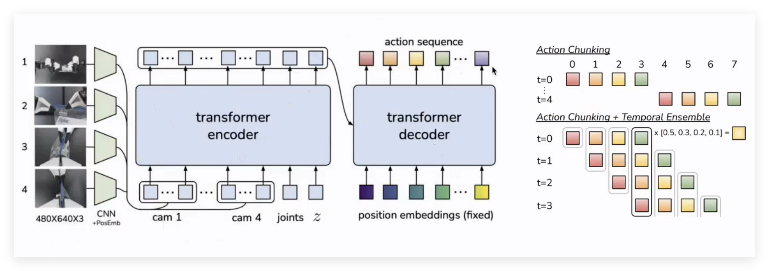

ALOHA的核心算法是基于Transformer架构的模型学习算法ACT(Action Chunking with Transformers)

硬件项目和数据介绍:

硬件是有两个主动臂(leader),两个从动臂(follower),每个机械臂都是6个自由度,两个从动臂上分别装有一个对称的二指夹爪。整个平台包含四个相机,两个在从动臂的腕部,一个在上方,一个在前方,分别朝向操作台的中心。因此,在收集到数据,分别包含:4个视角的图像(480*640),从动臂的关节角((6DOF臂+1DOF夹爪)*2)和主动臂的关节角((6DOF臂+1DOF夹爪)*2)。

在训练过程中,从动臂的关节角和图像一起组成的输入给模型的观测值,而主动臂的关节角则作为了动作标签。

首先了解Compounding error:在测试时,若agent遇到训练集里从未见过的输入,那么很有可能给出具有一定误差的预测值,这可能会导致agent进入更加没有见过的状态,进而一步一步的产生越来越大的预测误差。

为了减小compounding error,ACT使用了action chunking,也就是多步作为一个组合输出,这样存储和执行都提升了效率。但是这也带来一个问题,就是每间隔几步一个输出,会出现不连贯的现象。所以ACT又增加了temporal ensemble技术。如下图:

Actoin chunking: 每个时刻输出多步action,减少累计error

Temporal Ensemble: 每个时刻的输出都基于历史时刻的输出进行计算,增加平滑度

题外话:而这种预测多步和平滑思路,在cv序列生成的项目中其实算主流思路,所以技术果然是相通的...所以,之前做cv的同学们~咱们的技术都是没白学的...

5.1.2 Mobile ALOHA

论文:Mobile ALOHA: Learning Bimanual Mobile Manipulation with Low-Cost Whole-Body Teleoperation

论文地址:https://arxiv.org/pdf/2401.02117

Mobile ALOHA 是可移动的,硬件配备有 2 个腕部摄像头,和 1 个顶部摄像头,并配有移动电源和本地计算模块,在其自主执行时只使用 2 个 ViperX 300。两只手臂的最低 / 最高高度分别为 65 厘米 /200 厘米,并可以从底座向四周最长能够伸出 100 厘米。

另外ALOHA非常伟大,开源了软硬件代码以及数据集!!

https://mobile-aloha.github.io/cn.html

5.2 RT-1

论文: Robotics Transformer 1

论文地址:https://robotics-transformer.github.io/assets/rt1.pdf

上文中LLM和VLM已经验证了多样化数据对多任务基座模型训练的重要性和可行性。而在机器人领域长期面临数据稀缺与泛化力差的问题。

2022年12月13日,谷歌开源了RT-1面向机器人垂直领域的通用大模型。

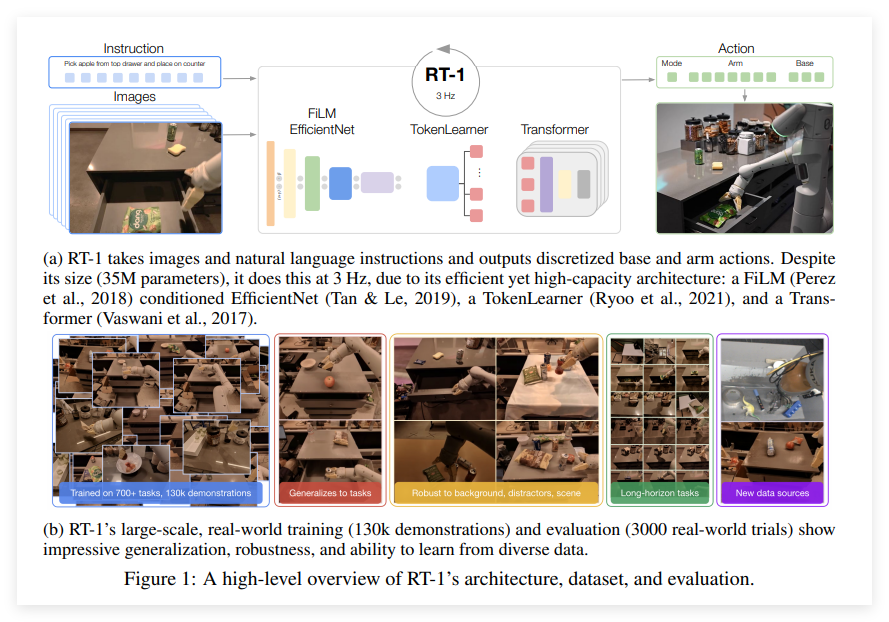

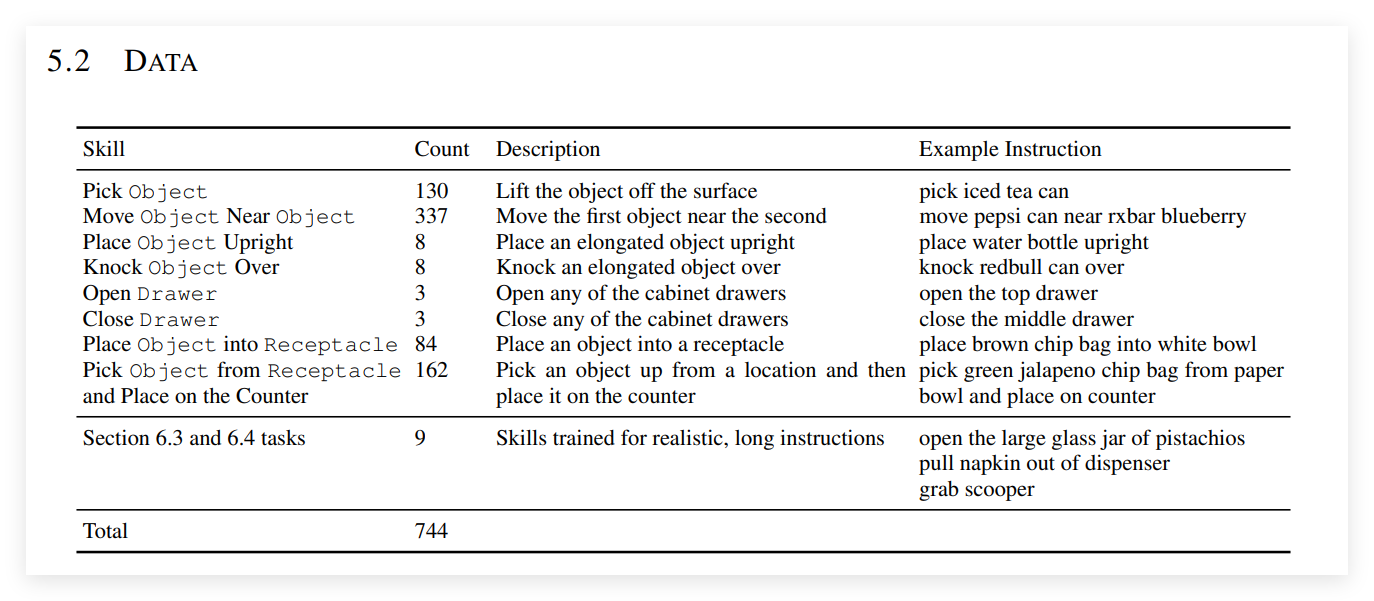

RT-1可以97%的准确率让机械臂在厨房中执行700多项常见任务,并拥有了一定的泛化性。而这个模型是谷歌Research一个16人团队基于13台机器人、17个月内收集的13万个任务片段,涵盖700+项任务(如拾取、放置、开门等),数据集规模达130k个episode!

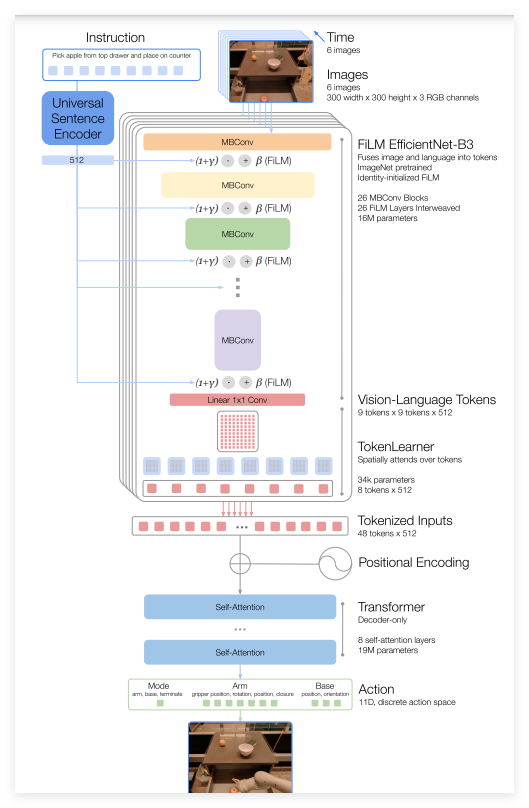

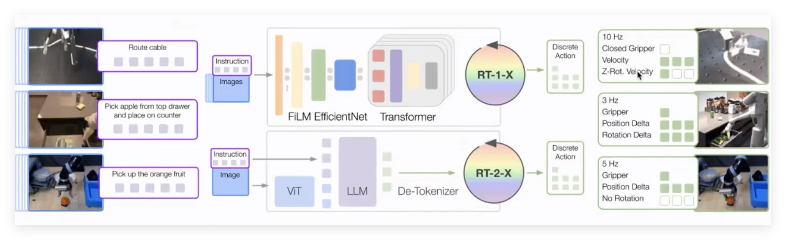

谷歌的RT1是收集了专门针对机器人任务的数据,然后输出可运行指令Action,下图是具体的模型框架

RT-1基于Transformer结构,模型输入是历史的图像序列,以及文本任务描述,然后通过预训练的 FiLM调节的EfficientNet 模型将它们编码,并通过 TokenLearner 对其进行压缩得到Tokenized inputs,最后再通过一个Decoder-only的Transformer输出Action。 这里的输出是11维离散值。

输出的11D的Action包括:手臂运动的七个维度(x、y、z、滚动、俯仰、偏航、夹具打开)、底座运动的三个维度(x、y、偏航)以及在三种模式之间切换的一个离散维度:控制手臂、底座或终止行动。

5.3 Octo

论文: Octo: An Open-Source Generalist Robot Policy

论文地址 :https://arxiv.org/abs/2405.15223

Octo论文的作者分别来自加州大学伯克利分校、斯坦福大学、卡内基梅隆大学和谷歌Deepmind的Octo模型团队。

RT-1聚焦于多任务学习,而Octo更强调通用性与跨机器人泛化能力,是首个开源通用机器人策略的项目。

Octo开源通用机器人策略是基于800k多样化的机器人轨迹数据集Open X-Embodiment dataset进行预训练。Octo支持灵活的任务和观察定义,并且可以快速地针对新的观察和动作空间进行微调。

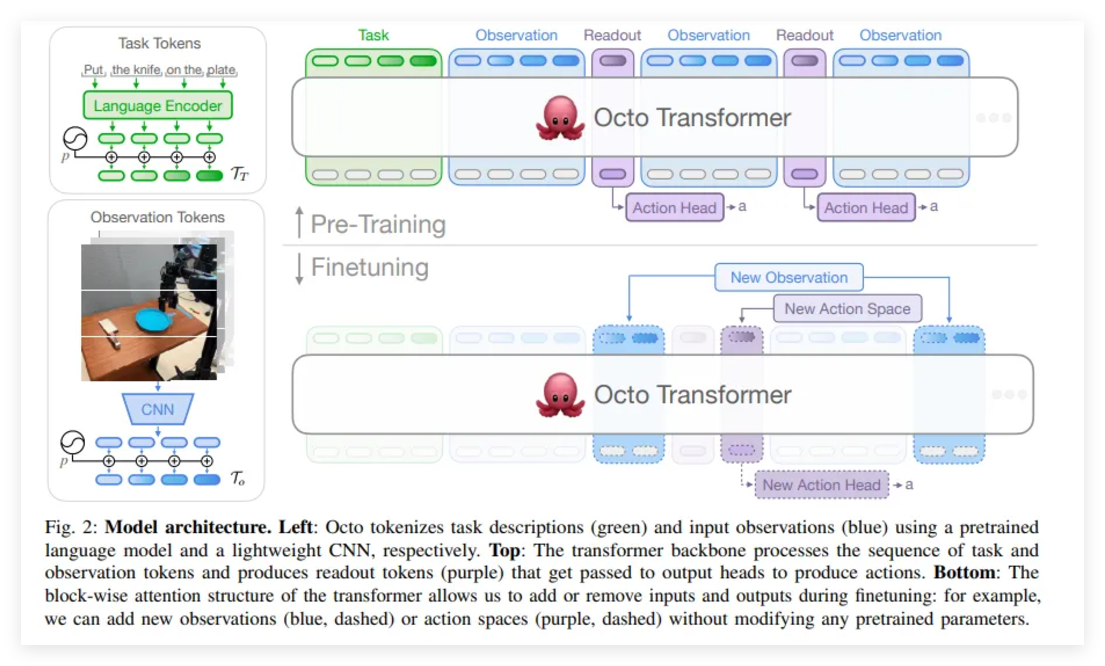

Octo算法模块:

输入: 文本任务基于Language Encoder进行编码;图像或传感器输入基于CNN进行编码

主干网络: Transformer结构,处理输入的token序列,并输出对应的embedding

输出头: 基于Transformer输出解码为机器人动作

对于finetune任务,不需要改变原始网络,只需增删输入输出即可。

其中模型输出头是采用diffusion过程对机器人动作进行建模。它将一个初始的高斯噪声向量解码为连续的机器人动作,解码过程通过多步的逐步去噪来实现。每一步去噪过程由浅层MLP实现,它以当前步的输出、Transformer输出的embedding、以及步骤编号作为输入。通过这种方式,模型能输出一段连续的未来机器人动作序列。

再多说一次数据集~

Octo训练中使用的Open X-Embodiment数据集于2023年10月正式开源。后面RT-会再次介绍。

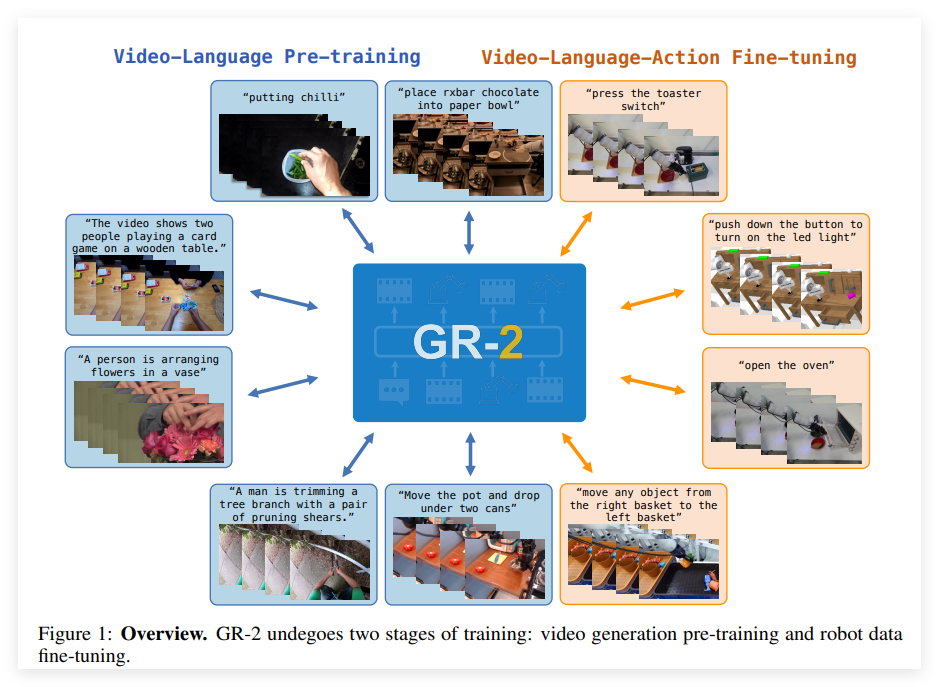

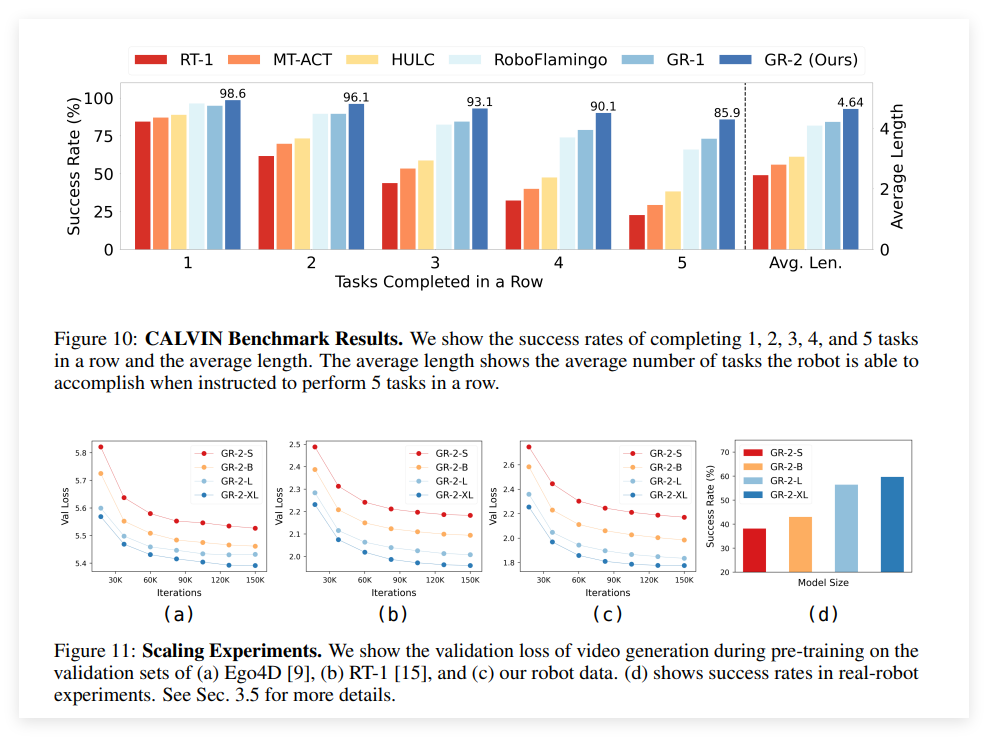

5.4 GR-1,GR-2

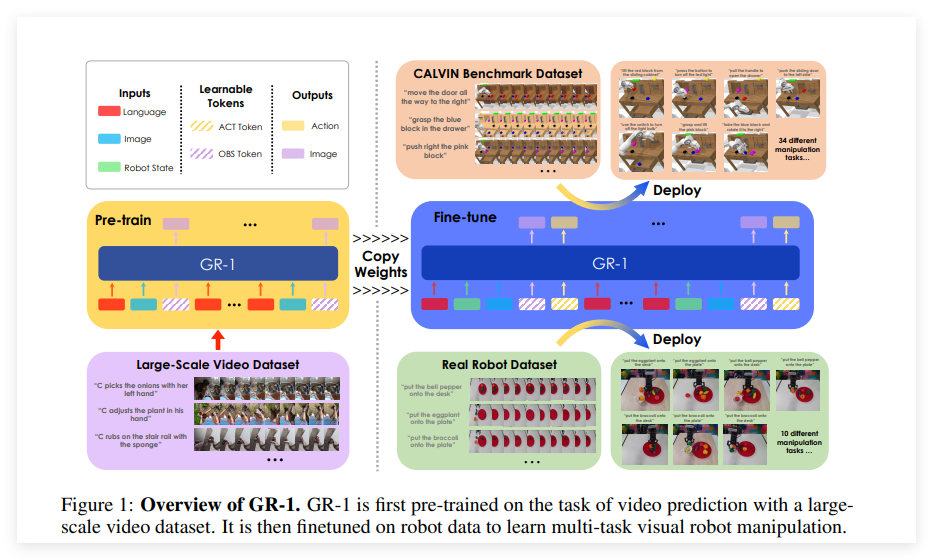

GR系列是字节跳动的VLA模型,是类似多模态大模型的训练思路,同样基于Transformer框架,但是增加了对未来帧的预测。GR-1基于80 万视频片段(800 万帧)和 文本编码器进行预训练;而GR-2 基于3800 万视频片段(超 500 亿 token)上预训练,支持 100 多项任务,平均成功率 97.7%

GR-1

论文:UNLEASHING

LARGE-SCALE VIDEO GENERATIVE

PRE-TRAINING FOR VISUAL ROBOT MANIPULATION

时间:2023.12

论文地址:https://arxiv.org/abs/2312.13139

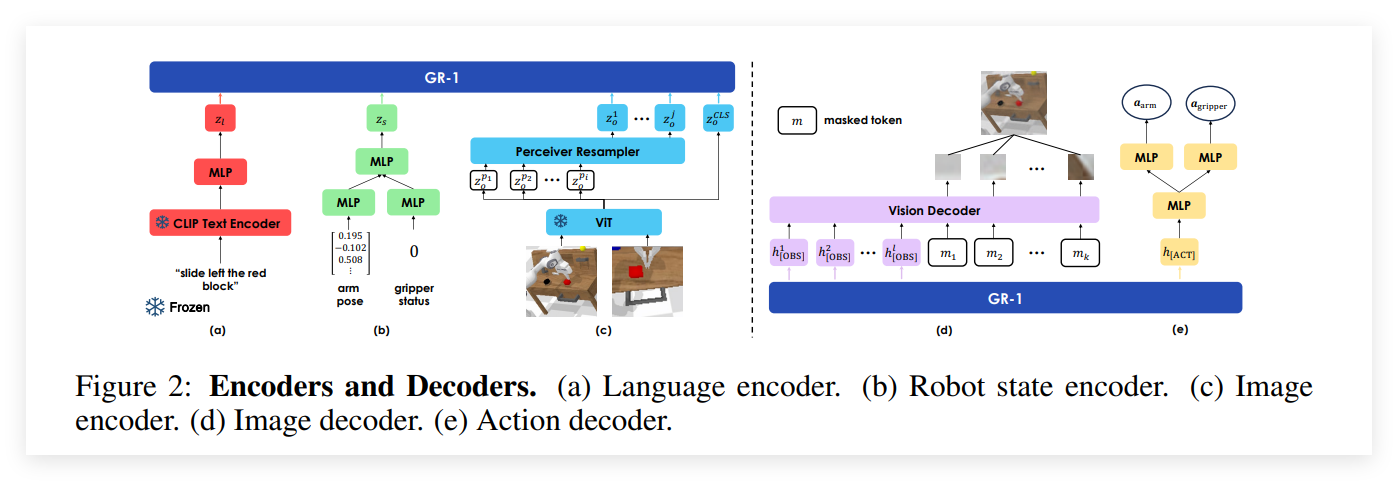

GR-1的模型训练框架:

可以看出训练思路是非常巧妙的:

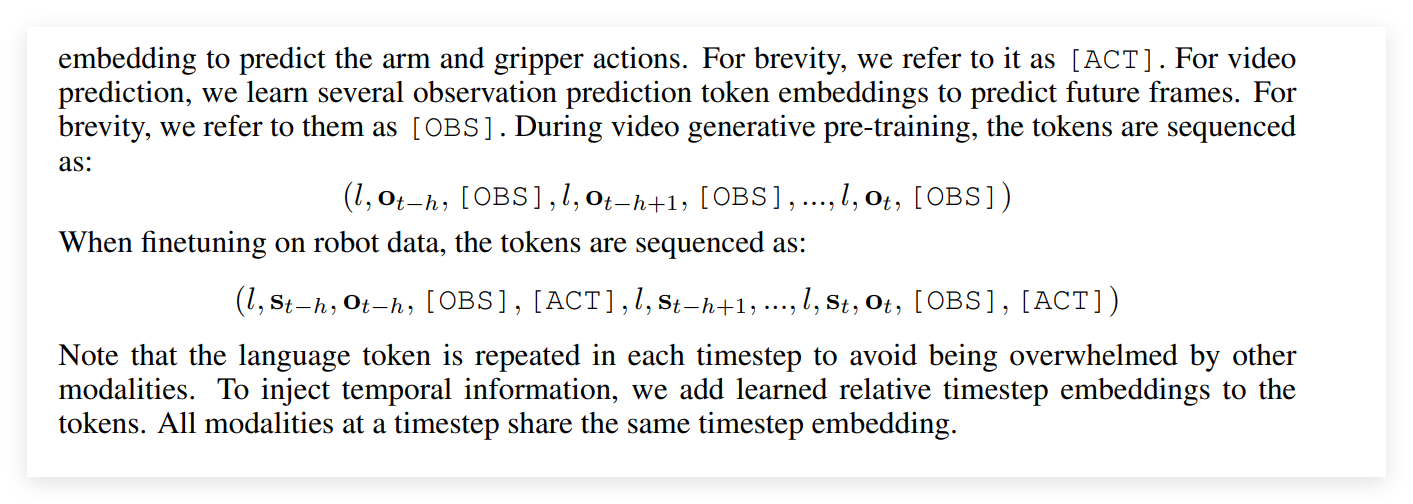

第一阶段:上图左侧,先基于大量的视频-文本数据(多模态模型训练的数据复用了..)获得一个预训练模型,这里训练任务是基于图像-文本对预测下一帧(这里文本是重复使用的,视频是不能看到未来帧,需要mask)

第二阶段:上图右侧,使用真实的机器人数据进行微调,这里输入需要增加ACT token,同样输出需要增加预测的Action。

通过两阶段,就能得到机器人领域的预测未来帧和动作的模型。

其中文本指令的embedding使用的LM-encoder然后基于CLIP对齐,图像的embedding使用的ViT,机器人状态(包括末端执行器的 6D 姿态和夹爪的二进制状态的embedding使用MLP。三种编码都需要通过处理进行维度对齐输入GR-1。

输出的帧预测使用Vision Decoder,loss使用的MSE, Actoin预测仍然使用MLP,机械臂的动作因为是连续的loss使用的Smooth-L1,夹爪是两个状态值,使用BCE。

GR-在CALVIN测试集上进行实验,多任务学习、零次未见场景泛化、小数据集和zero-shot语言泛化等方面都达到SOTA 。

GR-2

论文: GR-2: A Generative Video-Language-Action Model with Web-Scale Knowledge for Robot Manipulation

时间:2024.10

论文地址:https://arxiv.org/pdf/2410.06158

训练思路和GR-1一样依然是VLM预训练,然后基于finetune得到VAL。预训练阶段图像预测使用了VQGAN。微调阶段为了确保机器人手臂准确地跟随轨迹,字节开发了一种全身控制(WBC)算法,该算法采用轨迹优化进行运动跟踪

模型参数规模有 30M (GR-2-S), 95M (GR-2-B),312M (GR-2-L), and 719M (GR-2-XL)

Scaling Law这一影响深远的理论在GR-2上也有所体现,首先数据量上从GR-1的80w视频片段增加到3800 万视频片段。在上图的scaling实验可以看出随着模型参数的增加,效果也逐步提升。

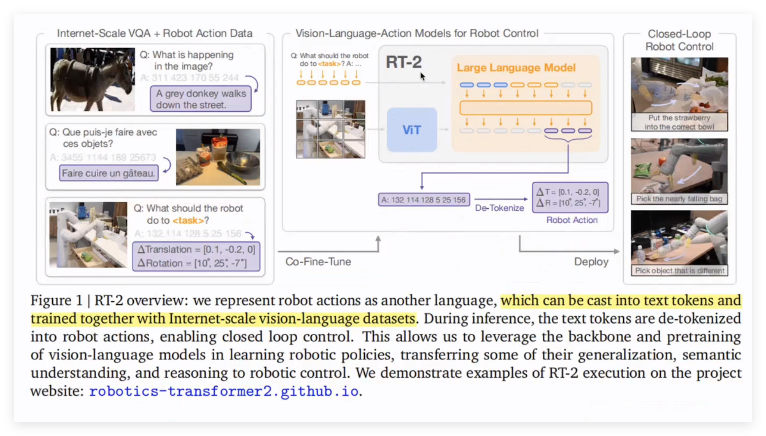

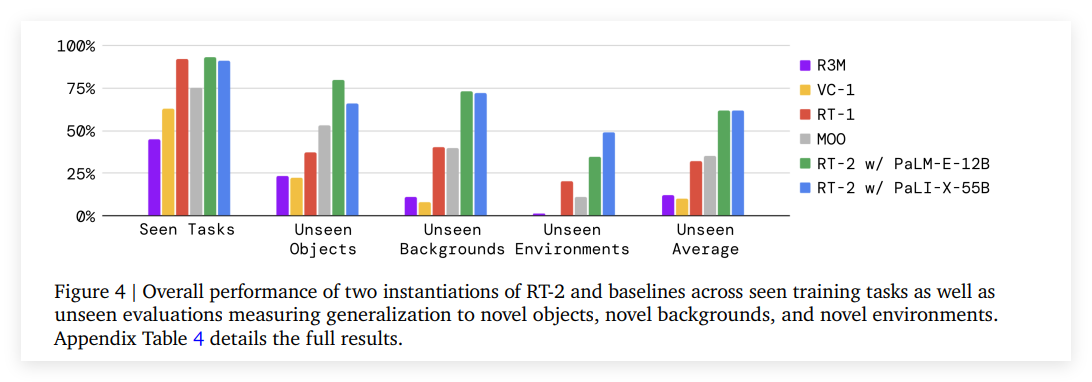

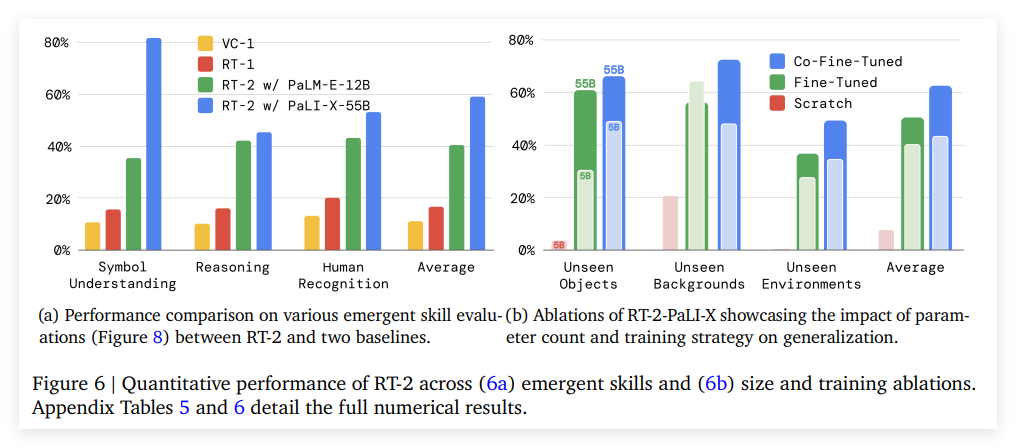

5.5 RT-2, RT-X, openVLA

前面介绍过谷歌在2022年的RT-1论文,收集大量的机器人数据, 将Transformer 应用机器人的操纵任务上。但是由于RT-1数据的局限性,RT-1只能接受在数据库中出现过的指令,指令的基本结构为“动作 + 目标物体 + 目标位置”,在RT-1数据库中这些基本结构可以互相交换排列组合,但超出这个范围RT-1就搞不定了~

为了扩展对外界环境认知的,RT-2来了,2023年谷歌的DeepMind 团队又基于互联网上数据训练视觉-语言模型(VLM),使其能够学习到更多关于视觉和语 言的映射关系,然后用RT-1的机器人数据人任务数据上微调,提出VLA模型RT-2 。

但是RT-2的微调数据任务的action还是太简单了,只有抓取,移动,控制。所以谷歌联合多个实验室,经过大半年提出Open X Embodiment数据集,Action动作集扩大到527,并提出RT-X~

下面介绍RT-2和RT-X

RT-2

论文: RT-2: Vision-Language-Action Models Transfer Web Knowledge to Robotic Control

论文地址:https://arxiv.org/pdf/2307.15818.pdf

RT-2使用的VLM基础框架是google自己的PaLI-X 和 PaLM-E。

VLM大家比较熟悉,输出的是文本token,所以在VLA里需要Finetune为Action token。RT-2的动作空间包括用于终止的特殊离散状态,机械臂执行器的6D数据(位置位移和旋转位移),夹爪开关状态。除终止指令外,连续维度被离散为256个二进制数,动作可以用8个整数表示。

为了使用这些离散化的动作将VLM微调为VLA,需要将模型现有离散化的token与离散化的动作分区联系起来。保留原始vocab的 256 个 token 作为 action token。选择何种 token 取决于每个 VLM 所使用的特定分词方法。为了定义 VLM 微调的目标,只需将每个维度的 action 转换为 text token,就能将动作向量转换成一个字符串:“terminate Δpos𝑥 Δpos𝑦 Δpos𝑧 Δrot𝑥 Δrot𝑦 Δrot𝑧 gripper_extension”。

在实验中微调的两个VLM模型,PaLI-X 和 PaLM-E 使用了不同的离散化方法。在 PaLI-X 模型中,1000 以内的整数都有一个唯一的 token,因此只需将 action bins 与代表相应整数的token相关联。而 PaLM-E 模型没有提供这种方便的数字表示法,因此只需覆盖 256 个使用频率最低的token来表示动作词汇(action vocabulary)。用动作 token 覆盖现有token来训练 VLM 是一种 symbol tuning,这在之前的工作中已被证明对 VLM 非常有效。

了解以上流程后,整理流程就是现基于VLM让模型具有通过看到的环境下达文本动作的能力,再基于机器人执行动作数据训练端到端训练一个VLA模型,让输出的文本token 是机器人可直接执行的动作空间。

其中注意,RT-2 与标准 VLM 之间的一个重要区别是,RT-2 必须输出有效的动作token才能在真实机器人上执行。因此,为确保 RT-2 在解码过程中输出有效的动作token,对其输出词汇进行了限制,即只有在提示该模型执行机器人动作任务时,才能对有效的动作token进行采样,而在标准视觉语言任务中,该模型仍可输出全部自然语言token。

RT-2介绍了如何通过将 VLM 预训练与机器人数据相结合来训练VLA模型,验证了再机器人领域能够利用VLM模型的能力来提升VLA模型的泛化能力。

RT-X

论文:RT-X :Open X-Embodiment: Robotic Learning Datasets and RT-X Models

论文地址:https://arxiv.org/abs/2310.0886

RT-X基于Open X-Embodiment数据集来训练RT-1和RT-2,RT-2-X泛化能力从27.3%提高至75.8%。

重点介绍下Open X-Embodiment数据集。OXE由谷歌DeepMind联合斯坦福大学、上海交通大学等21家国际知名机构共同发布,整合了全球60个现有机器人数据集,涵盖22种不同形态的机器人(如单臂、双臂、四足机器人),包含超过100万条轨迹和527项技能,是目前规模最大的开源真实机器人数据集。

Open X-Embodiment和RT-X 有点像当年CV界的ImageNet和它公开的训练数据...

汇总下RT系列的项目地址:

RT-1,https://robotics-transformer1.github.io/

RT-2,https://robotics-transformer2.github.io/

RT-X,https://robotics-transformer-x.github.io/

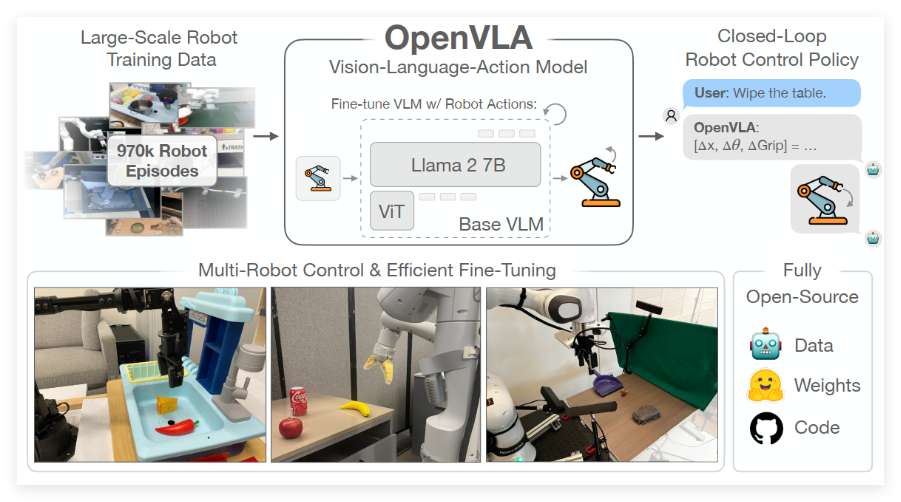

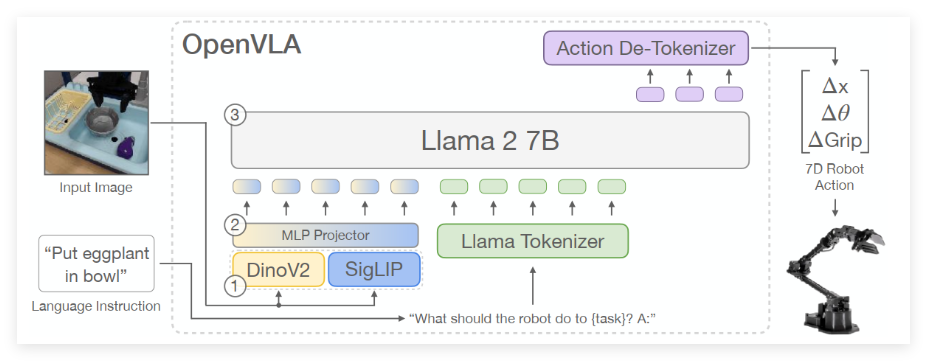

openVLA

论文:OpenVLA: An Open-Source Vision-Language-Action Model

论文地址:https://arxiv.org/abs/2406.09246v3

代码:https://github.com/openvla/openvla

openVLA是开源版的RT-2,OpenVLA的目标:建立一个开源、通用的VLA模型,支持有效微调,推动机器人技术发

RT-2提出了VLA模型,openVLA也同样具有里程碑意义,因为他开源了通用机器人VLA模型和训练代码。

框架相对比较清晰:

视觉模块使用了Dinov2(空间表征能力)和SigLip(语义嵌入能力),在通过MLP整合特征;

语言模块使用了Llama2-7B, 通过权重共享对齐视觉-语言表征;

动作模块使用了一个动作token生成器--Action De-Tokenizer。

其中输出模块和RT-2思路也一致,将每个动作离散化,并归一化到(-1,1)区间,离散化到255个区间,还有一个终止token。(Llama2模型中预留了256个空白的token),每个时间步长的每一个动作都由7个token组成,分别是:∆pos_x,∆pos_y,∆pos_z,∆rot_x,∆rot_y,∆rot_z,∆gripper,其中:∆pos代表了每个关节xyz轴上的位置,∆rot则代表了每个关节在xyz轴上的旋转角度,∆gripper则代表了末端夹爪的状态。

OpenVLA模型通过自回归的方式依次生成每个时间步长的动作,优点是可以使生成的动作更加精确,并且具有一定应对动态环境的能力,但也导致了推理延迟。

论文实验效果看,OpenVLA在通用物体操作任务上的表现十分出色,在29个任务和多种机器人形态上,其绝对任务成功率比封闭模型RT-2-X(55B)高出16.5%,同时参数数量减少了7倍。

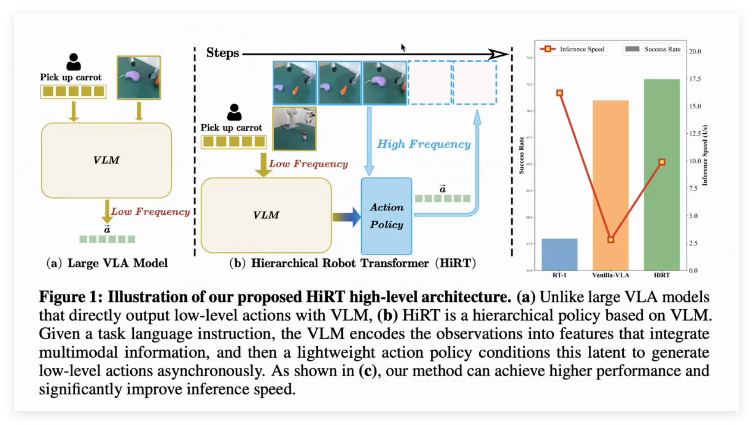

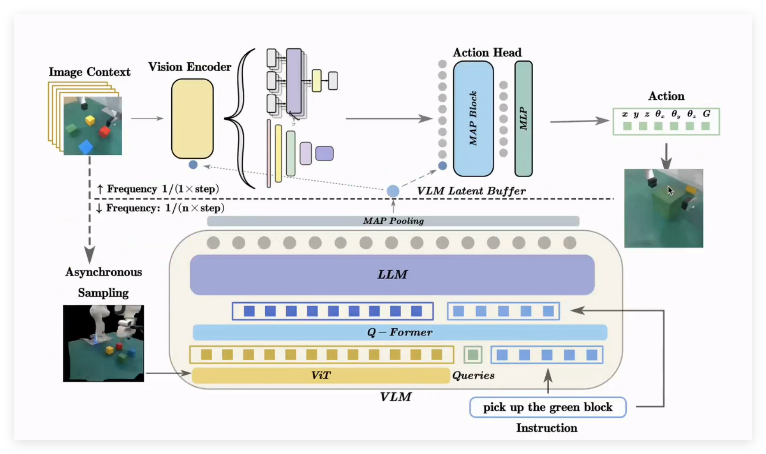

5.6 HiRT,pi0, NV-Groot

论文:HiRT: Enhancing Robotic Control with Hierarchical Robot Transformers

论文地址:https://arxiv.org/pdf/2410.05273

清华和伯克利等大学提出的HiRT,使用了人类认知的“双过程理论”(Dual Process Theory),通过分层异步架构使用 VLM 低频运行(提取长期特征),而高频策略独立执行动作,平衡性能与速度。

系统2:理解模块,慢速分析:利用 VLM 提取高层次、缓慢变化的语义特征(如任务规划、场景理解)。

系统1:执行模块,快速决策:通过轻量级视觉策略实时生成低层动作,受系统2的语义特征指导。

如上图,下方是低频理解模版,通过异步采样,作为VLM的输入,增强对延迟特征的鲁棒性;上方是高频执行模块,使用条件决策:

视觉编码器条件化:

FiLM 层(CNN 架构):在 EfficientNet 的隐藏层中,通过仿射变换注入 VLM 特征。

交叉注意力(Transformer 架构):在自注意力层后插入跨注意力,对齐视觉 编码特征与 VLM 特征。

动作头条件化:将 VLM 特征作为前缀提示,通过注意力机制与视觉 token 结合,解码为低层动作(如末端位姿)。

论文也做了消融实验:

条件策略:移除 FiLM 或交叉注意力会导致成功率下降 10-20%。

异步采样:随机采样历史图像训练使动态任务成功率提升 15%。

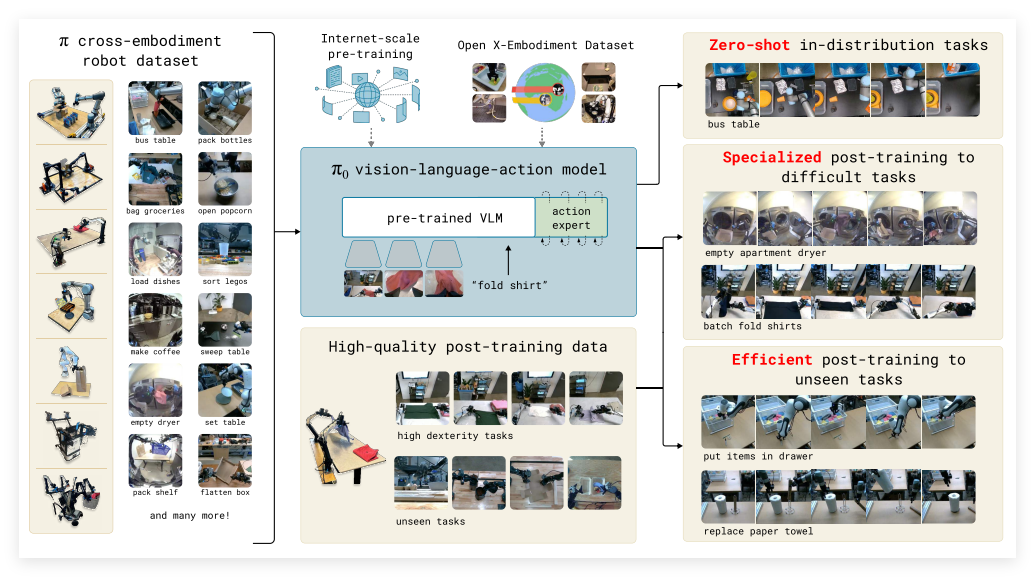

pi0

先聊Karol Hausman和他的公司Physical Intelligence。

Physical Intelligence(简称PI)是一家总部位于美国旧金山的具身智能初创公司,成立于2024年3月,目标是做具备通用性的机器人基础模型(Robot Foundation Model)。

PI的创始人是深度参与了RT系列模型研发的谷歌机器人科学家Karol Hausman,他从谷歌拉出一支团队,声称要为全球机器人造一个通用大脑,Hausman为从谷歌“拉出”的这支团队,起了一个很接地气的名字——Physical Intelligence,直译过来是「物理智能」,他们的公司LOGO,也是直接用的数学中那个用来表示圆周率的π。

PI创始团队,核心创始成员包括:

Sergey Levine:UC Berkeley 电子工程与计算机科学系副教授, 机器人学习领域全球最顶级的 researcher 之一,曾参与 Google RT2 模型的开发

Karol Hausman:前Google DeepMind科学家,斯坦福大学兼职教授,主导了Google RT系列机器人模型研发

Chelsea Finn:斯坦福大学计算机科学与电子工程系的助理教授, Google Deepmind 科学家,曾主导ALOHA项目

Brian Ichter:前Google DeepMind机器人科学家

π0不是一款机器人,而是PI团队花费八个月时间造出的一个通用机器人基础模型,PI团队希望,这个模型可以让人们像使用ChatGPT这样的chatbot一样,便捷地使用机器人。

PI团队这里所说的机器人是任意品牌、任意形态的机器人,可以让这些机器人执行通用任务,也可以通过微调让这些机器人在专业场景执行专业任务。

具体而言,这一模型训练过程可以分为以下四步:

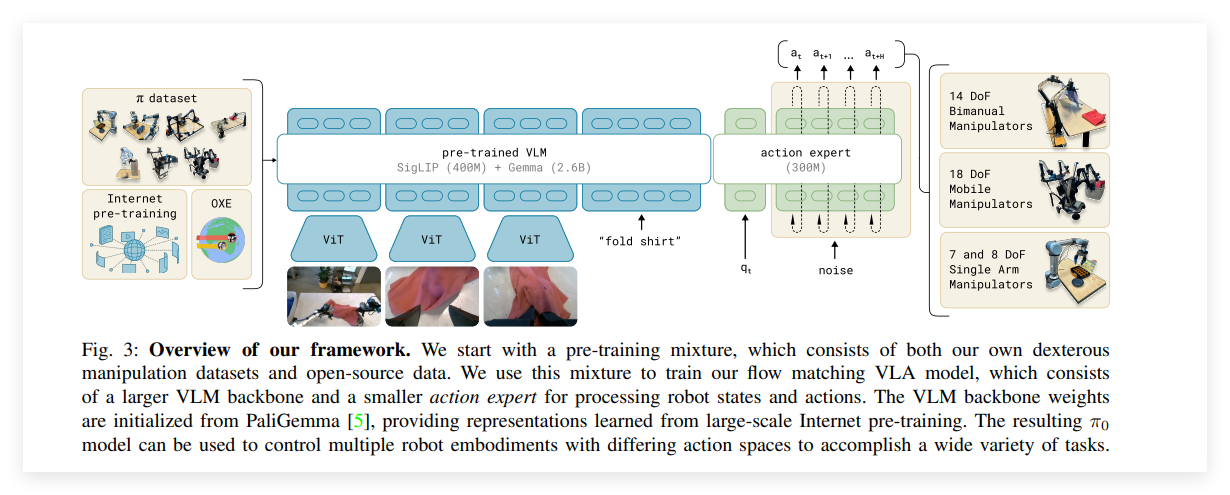

第一,从OpenAI的GPT-4V、谷歌的Gemini这样的预训练视觉语言模型(VLM)中继承语义知识和视觉理解能力,PI团队基于此获得的30亿参数的VLM进行再调整,以适应机器人的实时灵活控制;

第二,基于PI团队自研的流匹配(flow matching)算法,为VLM模型提供连续动作输出,以使其可以实现50次/s的频率输出运动控制指令;

第三,基于开源的机器人数据集和互联网数据训练的VLM,PI团队形成了自己的视觉-语言-动作流匹配模型,并通过自采集的高质量机器人数据对这一模型进行后续训练;

第四,针对复杂、灵巧任务,对模型进行微调。

基于这四步,经过八个月的研发,PI团队搞出了第一版机器人通用大脑,π0。

2024年10月末,PI发布π0;2025年2月4日,PI宣布开源π0。

论文:π0: A Vision-Language-Action Flow Model for General Robot Control

论文地址:https://arxiv.org/abs/2410.24164

项目:https://www.physicalintelligence.company/blog/pi0

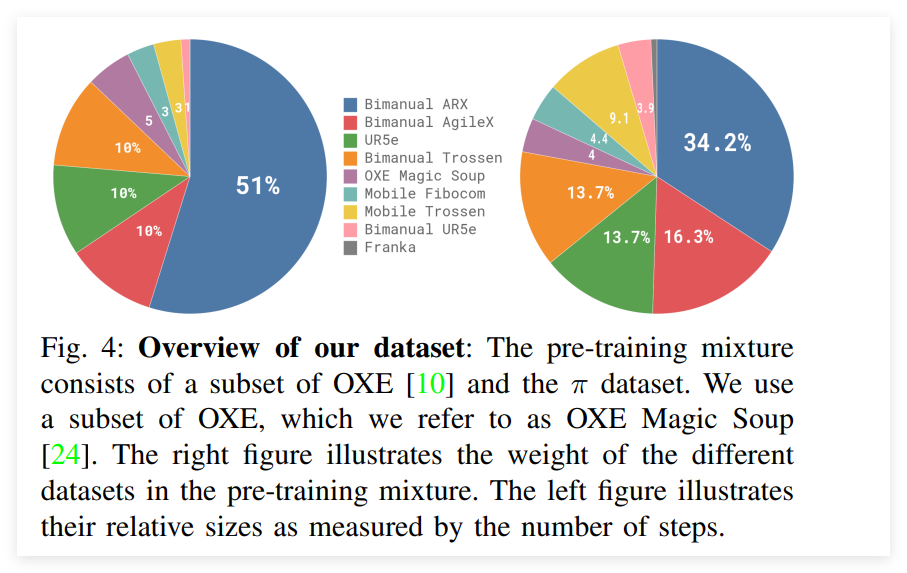

训练数据

π0使用的预训练数据 9.1% 来自开源数据集:例如OXE、Bridge v2、DROID,这些数据集中的机器人和任务通常仅有1-2个摄像头,并使用2-10Hz低频控制,但涵盖比较广泛的对象和环境。

另外的90.9%为自采集数据:共9.03亿步,其中包括单臂机器人1.06亿步、双臂机器人7.97亿步),涵盖7种不同的机器人配置(覆盖单臂、双臂、移动操作器等多种机器人形态)和68个复合型任务(如"清桌"需处理餐具、垃圾等多类物品,行为复杂度远超传统"名词+动词"式任务定义),以训练机器人完成更灵巧和复杂的任务。

并对训练数据进行了一系列处理:对于任务量较大的任务,π0使用公式n0.43来降低其权重(n为任务数量),避免对模型训练产生偏差。

另外,为了使数据结构统一,所有机器人的状态数据被对齐为最大维度(18维,包括两个6-DoF的机械臂、两个夹爪、一个移动底盘和一个垂直驱动的躯干),图像数据默认包括三个视角。将不同自由度机器人的动作映射到统一空间,实现跨平台适配。

而后,进入微调阶段,则需要更专业、更高质量的数据,与机器人需要掌握的特定任务匹配。

从此次π0的实践看,不同的任务对数据集的需求差异很大,简单任务仅需5小时数据,复杂任务(如衣物折叠)需超100小时。

训练

π0是一种基于 预训练视觉语言模型(VLM) 和 流匹配模型(Flow Matching) 的新型架构。自研的action expert采用了条件流匹配(Conditional Flow Matching)技术和动作分块算法(Action Chunk),使得模型能够以50Hz的高频率生成连续的动作分布,从而精准控制机器人执行复杂且高度灵巧的任务。

Flow Matching算法:目标是通过学习连续动作分布,生成符合目标概率路径的动作序列。其核心思想是将动作生成问题转化为向量场回归问题,通过优化向量场参数,使生成的动作轨迹逼近目标分布,和相比传统扩散模型,无需复杂的网络结构降低计算成本。

条件流匹配,是在流匹配过程中引入任务条件(如文本指令),通过交叉注意力机制动态调整动作生成方向。

Action Chunk算法:动作分块通过将连续动作序列划分为离散的“块”(Chunk),解决长时序动作的局部优化与全局一致性平衡问题,提升复杂任务的执行精度。

流匹配生成连续动作分布,动作分块将其离散化并优化局部细节,形成“全局-局部”协同框架。

π0通过流匹配与动作分块的协同设计,实现了高频、高精度、高泛化的机器人动作生成。流匹配解决连续动作分布建模问题,动作分块优化长时序任务执行效率,两者结合为通用机器人控制提供了新范式

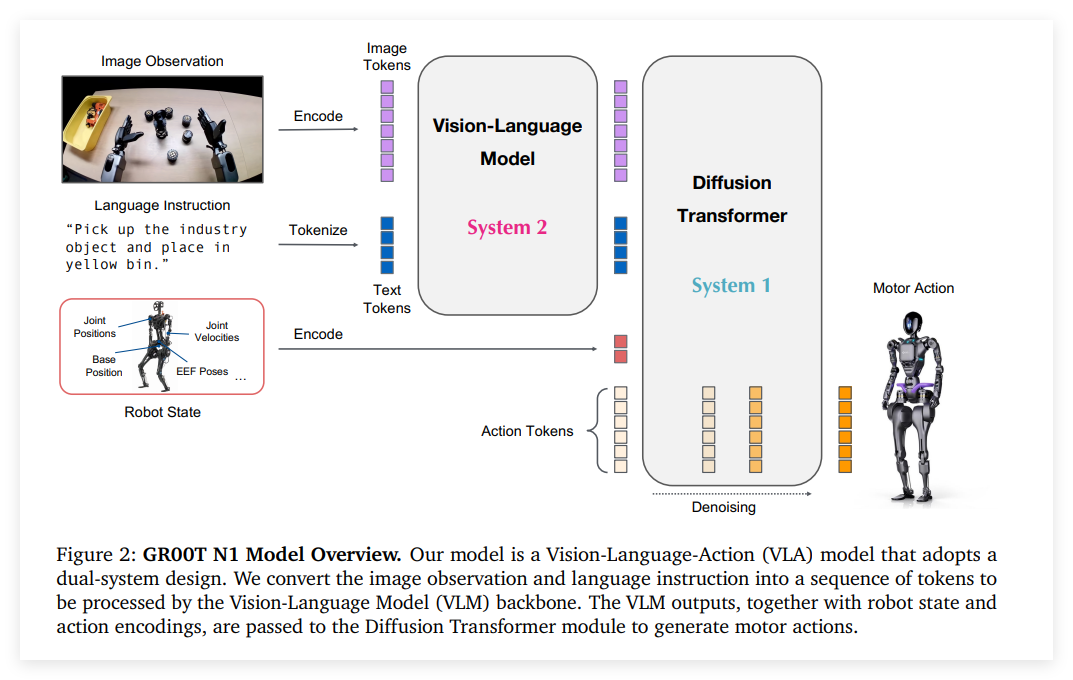

NVIDIA Groot N1

GROOT N1是英伟达于2025年3月发布的全球首个开源、可定制的通用人形机器人基础模型,旨在通过多模态融合与双系统分层架构设计,推动机器人技术从“狭隘专家”向“通用智能体”转型。

论文:GR00T N1: An Open Foundation Model for Generalist Humanoid Robots

论文链接:https://d1qx31qr3h6wln.cloudfront.net/publications/GR00T%20N1%20Whitepaper.pdf

代码:https://github.com/NVIDIA/Isaac-GR00T

机器人需要两个关键要素:聪明的大脑,灵活的身体。我们在规划好路径后,行动过程中还需要快速决策,应对多变的环境背景。

GR00T N1是一个视觉-语言-动作(VLA)模型,它采用了一种双系统架构:

(1)"理解"系统(System 2):这部分是一个视觉-语言模型,就像是机器人的"思考中枢",每秒运行10次,负责解释环境并理解任务目标。

(2)"行动"系统(System 1):这部分是一个基于扩散变换器的模块,就像是机器人的"运动中枢",每秒运行120次,负责生成流畅的运动动作。

这两个系统紧密结合,共同训练,让机器人能够将"理解"转化为"行动"。和HiRT思路有点像,都是低频理解高频行动,但是HiRT是异步分层架构,N1是双系统架构。

训练数据

NVIDIA的团队使用了数据金字塔策略,金字塔分为三层:

(1)底层:大量的网络数据和人类视频,提供通用的视觉文本能力

(2)中层:通过物理模拟和神经模型生成的合成数据

(3)顶层:在真实机器人硬件上收集的数据

另外,他们还开发了一种方法,可以从没有动作标签的视频(比如人类操作视频)中提取"潜在动作",这样就可以将这些视频也用于训练机器人的动作生成。

他们还利用预训练的视频生成模型,将88小时的真实机器人数据扩展到了827小时!这就像是给机器人创造了大量"假想"但非常真实的训练场景。

预训练数据集的完整统计信息:

真实机器人数据:262.3M 帧,3,288.8 小时;

人类视频数据:181.3M 帧,2,517.0 小时;

仿真数据:125.5M 帧,1,742.6 小时;

神经轨迹数据:23.8M 帧,827.3 小时。

总计:592.9M 帧,8,375.7 小时。

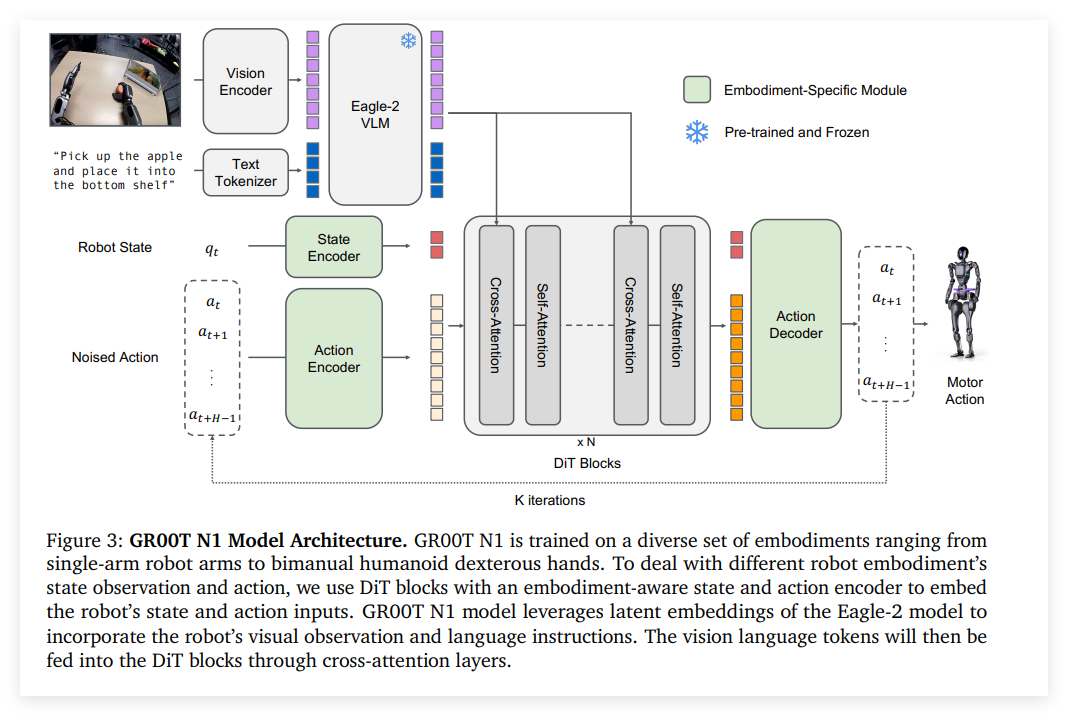

训练模型

视觉语言模块

VLM模型是通过预训练的 Eagle-2 。Eagle-2 基于 SmoILM2语言模型和 SigLIP-2图像编码器微调。图像以 224×224 分辨率编码,经像素重排(pixel shuffle)生成每帧 64 个图像标记。这些标记与文本通过VLM的LLM组件联合编码,并通过视觉-语言任务对齐。

状态与动作编码器

为处理不同机器人形态的变长状态和动作维度,N1为每种形态设计独立的 MLP,将其映射到共享的嵌入空间。动作编码器MLP还将扩散时间步(diffusion timestep) 与含噪声的动作向量联合编码。

扩散变换器模块

动作生成模块是基于扩散变换器(DiT)改进,由交替的 交叉注意力块 和 自注意力块 组成,最后通过Action Decoder输出动作。

ROOT N1通过双系统架构与多模态数据融合,在仿真与真实场景中均展现出显著优势:

仿真性能:任务成功率提升11.6%,动态环境适应性突出16;

真实部署:数据效率提升40%,工业场景效率提高30%46;

跨平台能力:支持多形态机器人适配,降低开发成本38。

VIDIA GROOT N1的开源内容涵盖模型架构、训练数据、仿真工具链及开发框架,为开发者提供从仿真到部署的完整解决方案,加速通用机器人技术的商业化进程。

5.7 Diffiusion policy

论文:Diffusion Policy: Visuomotor Policy Learning via Action Diffusion

论文地址:https://arxiv.org/pdf/2303.04137

论文指出机器人学习领域,强化学习(RL)和模仿学习(IL)是两种主流的学习路径。

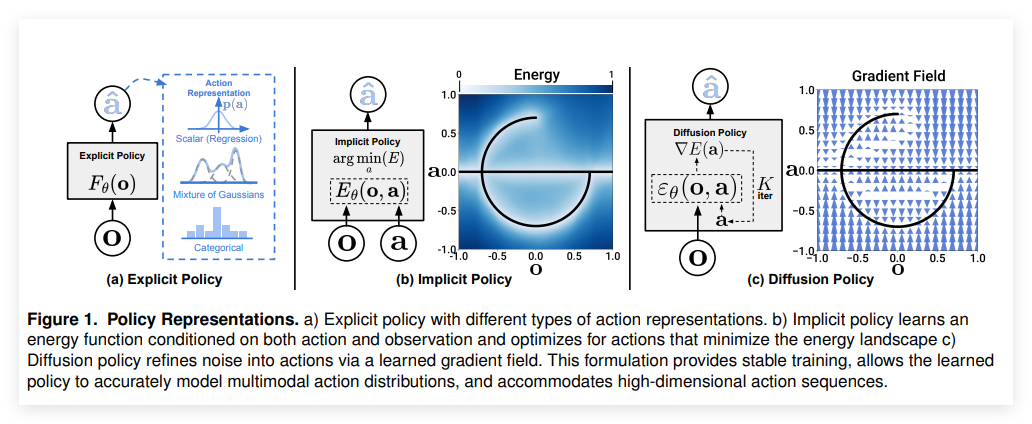

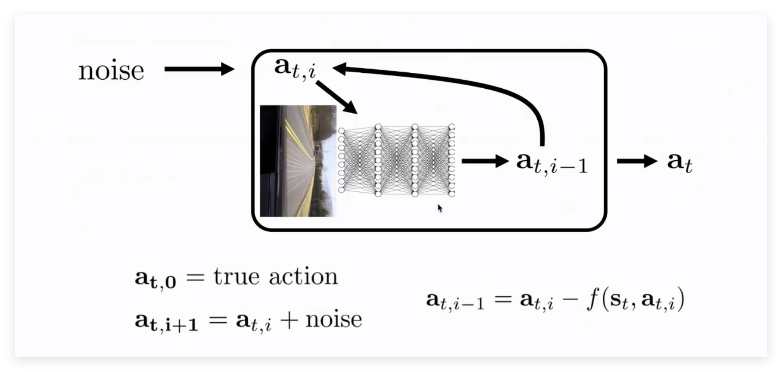

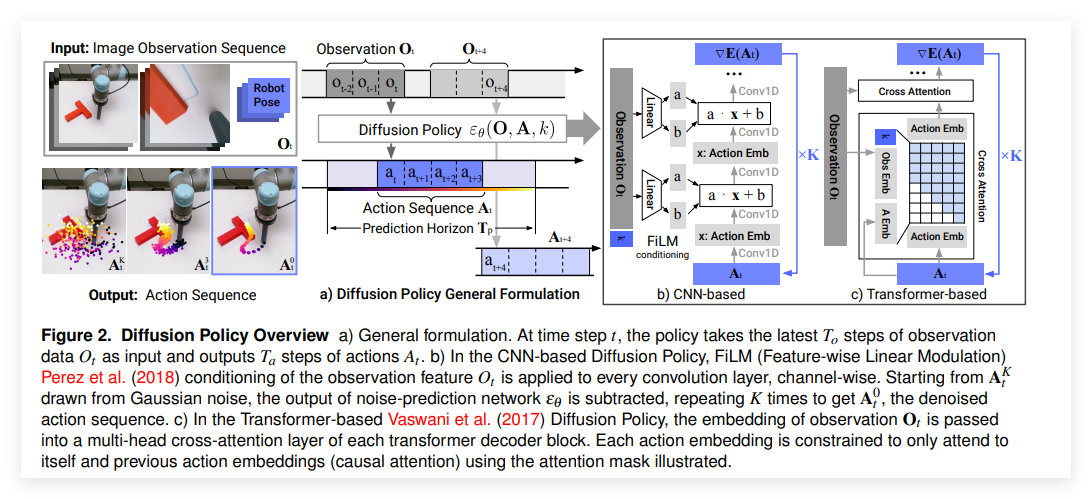

而在IL中,之前主流的方法是显示策略(Explicit Policy)和隐示策略(Implicit Policy)。从显式到隐式的策略转换是为了更好地捕捉多模态分布。为了更好地应对动作预测问题,论文提出了一种扩散策略(Difussion Policy),如下图所示。

在Difussion Policy中,论文提出了两种生成方式:基于CNN的和基于Transformer。

论文在训练过程中使用了一些关键技术对效果增强:

Closed-loop action-sequence prediction:扩散策略预测多个时间步的动作,使得机器人在执行一系列动作后重新规划,保持长远规划和响应能力之间的平衡。

Visual observation conditioning:视觉信息被作为条件输入,而不是与动作同时被处理,这样减少了计算负担,提高了推理速度,适用于实时控制。

Time-series difussion transformer:通过新的基于Transformer的扩散网络来代替传统的CNN网络,避免了过度平滑的问题,使得扩散策略在需要高频率动作调整的任务中表现更好。

5.8 Prediction with Action

论文标题:Prediction with Action: Visual Policy Learning via Joint Denoising Process

论文地址:https://arxiv.org/pdf/2411.18179

发表日期:2024年11月

作者:Yanjiang Guo, Yucheng Hu, Jianke Zhang, Yen-Jen Wang, Xiaoyu Chen, Chaochao Lu, Jianyu Chen

发表单位:Tsinghua University, Shanghai Qizhi Institute, Shanghai AI Lab, University of California, Berkeley

开源代码及数据集链接:https://sites.google.com/view/pad-paper

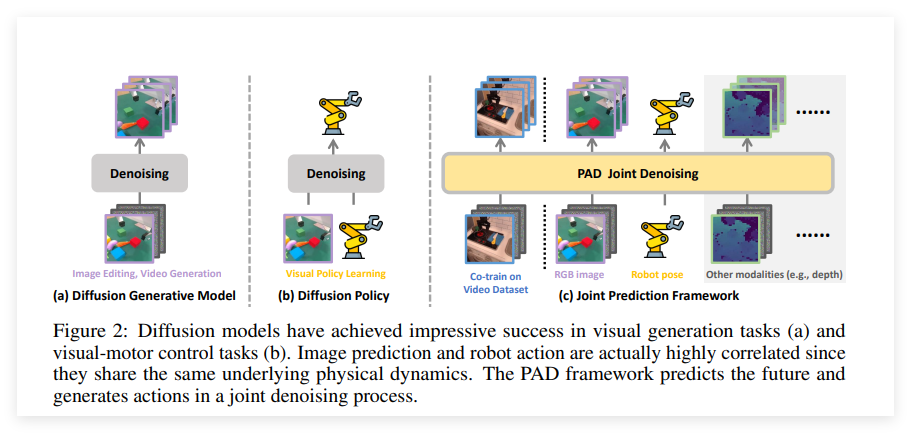

扩散模型在视觉生成任务(a)和视觉-运动控制任务(b)中已经取得了令人瞩目的成功。但是图像预测和机器人动作实际上是高度相关的,因为它们共享相同的底层物理动力学。

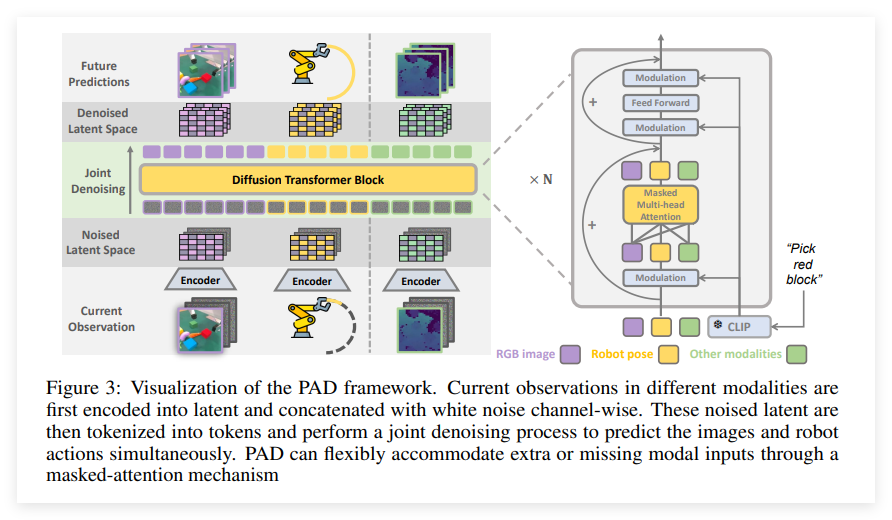

PAD框架通过联合去噪过程将图像预测和机器人动作结合起来。PAD利用Diffusion Transformers集成图像和机器人状态,从而实现对未来图像和机器人动作的同步预测。

如上图所示,PAD框架中,主要关注RGB图像和机器人动作两个模态,该框架也可以扩展到其他模态,如深度图像。每个观察模态通过Encoder后,对潜特征进行加噪,通过Diffusion Transformer Block进行去噪。

其中PAD框架先初始化未来观测为白噪声,并通过联合去噪过程重构未来观测帧和机器人动作。论文将条件潜在变量和噪声潜在变量在通道维度上进行拼接,然后通过多个DiT层预测未来帧的潜在表示。与仅仅预测单步未来不同,PAD可以预测多个未来步骤,从而实现k步计划和闭环控制。

在MetaWorld基准测试中,PAD显著超越了所有对比基线方法,成功率达到72.5%,而次优方法仅为57.4%。

结束

以上介绍了近年来VLA技术的主要技术论文,当然还有很多技术没有列举,后续会再更新。2025年来看,VLA将长链式的端到端VLA系统拆分为视觉语言理解(VLM)与动作执行两个子模块,也正在成为一个重要探索方向。

例如,Pi提出了高低层推理结合的π0.5结构,Figure AI推出了双系统架构的Helix模型,智元机器人则通过VLM与MoE结合构建了Villa架构的Go-1模型。这些工作表明,在提升泛化性、推理能力和执行效率方面,模块化设计正在展现出独特优势。

未来,随着模型规模、任务复杂度的不断增长,如何更好地协同感知、推理与执行,肯定会成为推动VLA系统演进的核心课题~

参考:

AI工具

https://zhuanlan.zhihu.com/p/30154387154

https://zhuanlan.zhihu.com/p/678057591

https://blog.csdn.net/weixin_39653948/article/details/135567073

https://zhuanlan.zhihu.com/p/717294861

https://zhuanlan.zhihu.com/p/11883552553

原创声明:本文系作者授权腾讯云开发者社区发表,未经许可,不得转载。

如有侵权,请联系 cloudcommunity@tencent.com 删除。

原创声明:本文系作者授权腾讯云开发者社区发表,未经许可,不得转载。

如有侵权,请联系 cloudcommunity@tencent.com 删除。

评论

登录后参与评论

推荐阅读

目录