AI大模型真的能理解物理现实么?论基础模型中的通用表征融合与物理实相的涌现

原创AI大模型真的能理解物理现实么?论基础模型中的通用表征融合与物理实相的涌现

原创

走向未来

发布于 2026-01-12 09:23:00

发布于 2026-01-12 09:23:00

物质的柏拉图形式:基础模型中的通用表征融合与物理实相的涌现

走向未来

人工智能正在经历一场从任务特定模型向通用基础模型的范式转移。在语言和视觉领域,这一转变已催生了对表征融合现象的深刻观察——即随着模型性能的提升,它们对世界的内在表达趋于一致。MIT最近发表了篇论文《Universally Converging Representations of Matter Across Scientific Foundation Models》(该论文可以从走向未来知识星球中获取。),深入探讨了这一现象在科学领域的惊人涌现。通过对涵盖字符串、图、3D原子坐标和蛋白质序列等多种模态的近60个科学模型进行严苛分析,我们发现:不同架构、不同训练数据的模型正在收敛于一种通用的物质表征。这表明,人工智能正在学习一种超越特定数据模态的、底层的物理实相柏拉图形式。本文将从表征对齐的实证分析、潜在空间的几何结构、基础模型状态的诊断标准、架构与数据的辩证关系以及未来科学发现的战略影响等维度,对这一具有里程碑意义的发现进行深度剖析。

1.jpg

1. 科学AI的黎明与表征融合的必然性

1.1 从专用势函数到通用基础模型

在过去的几十年里,计算化学和材料科学一直依赖于手工设计的特征和特定任务的势函数。从经典的力场到早期的机器学习势函数(MLIP),每一个模型都是为了解决特定的化学空间或物理性质而定制的。然而,随着Transformer架构的崛起和海量科学数据的积累,一种全新的范式正在形成:科学基础模型(Scientific Foundation Models)。这些模型在大规模数据集上进行预训练,旨在学习物质的通用特征,从而能够泛化到未曾见过的下游任务中。

正如大语言模型(LLM)通过阅读海量文本掌握了语言的深层结构,科学基础模型正试图通过学习原子和分子的排列组合,掌握支配物质世界的物理定律。核心问题随之而来:这些由不同实验室开发、使用完全不同输入模态(如SMILES字符串 vs 3D点云)、基于不同数学架构(如等变神经网络 vs 纯Transformer)构建的模型,它们究竟学到了什么?它们是在盲人摸象般地学习物质世界的不同侧面,还是正在共同逼近一个客观存在的、统一的物理真理?

1.2 柏拉图表征假说在科学界的验证

在计算机视觉和自然语言处理领域,柏拉图表征假说(Platonic Representation Hypothesis)认为,随着模型变得越来越强大,它们对现实世界的表征将不可避免地收敛于同一个统计模型——即现实世界的真实结构。

本文的深度分析表明,这一假说在自然科学领域不仅成立,而且表现得尤为深刻。通过对59个最先进的科学模型(包括MACE、Orb、Equiformer V2、ESM、GPT等)进行系统性地大脑解剖,我们观察到了惊人的表征对齐(Representational Alignment)。这种对齐不仅发生在同类模型之间,更跨越了巨大的模态鸿沟。这标志着人工智能正在从单纯的数据拟合迈向物理理解,一个统一的、数字化的物质世界观正在硅基芯片中诞生。

2.jpg

2 跨越模态的共鸣:表征对齐的深度证据

2.1 模态的巴别塔被推倒

长期以来,科学界认为分子的不同描述方式(如一维的SMILES字符串、二维的分子图、三维的原子坐标)之间存在着难以逾越的信息鸿沟。然而,研究结果彻底颠覆了这一认知。

在QM9小分子数据集的分析中,我们发现基于3D原子坐标的机器学习势函数(如MACE、Orb)与基于SMILES字符串的语言模型(如ChemBERTa、Molformer)之间存在显著的表征对齐。更令人震撼的是,即便是完全没有经过化学特定训练的通用大语言模型(如DeepSeek、GPT-4系列),当被输入SMILES字符串时,其内部表征也与专业的3D化学模型展现出了非平凡的相似性。

这一发现揭示了一个深刻的真理:物质的本质属性是客观存在的,不以描述它的语言为转移。无论是通过复杂的量子力学坐标描述,还是通过简化的文本符号描述,只要模型足够强大,它们最终都会捕捉到隐藏在这些符号背后的同一套化学拓扑结构和电子相互作用规律。SMILES字符串虽然丢失了构象几何信息,但它隐含的图拓扑结构足以让强大的模型重构出与3D模型极其相似的潜在空间几何。

3.jpg

2.2 蛋白质领域的强对齐现象

在生物大分子领域,这种融合现象甚至比小分子领域更为剧烈。分析显示,蛋白质序列模型(如ESM系列)与蛋白质结构模型(如AlphaFold类架构)之间的表征对齐程度,几乎是小分子领域最佳对齐案例的两倍。

这表明,在大规模进化的蛋白质序列数据中,自然选择已经将结构和功能的约束深深地编码进了氨基酸的排列顺序中。ESM等序列模型通过无监督学习,实际上已经隐式地学会了蛋白质折叠的物理约束。这种序列即结构的深层联系,使得序列模型和结构模型的潜在空间在数学上高度同构,进一步佐证了生物物理学规律在AI表征中的统一性。

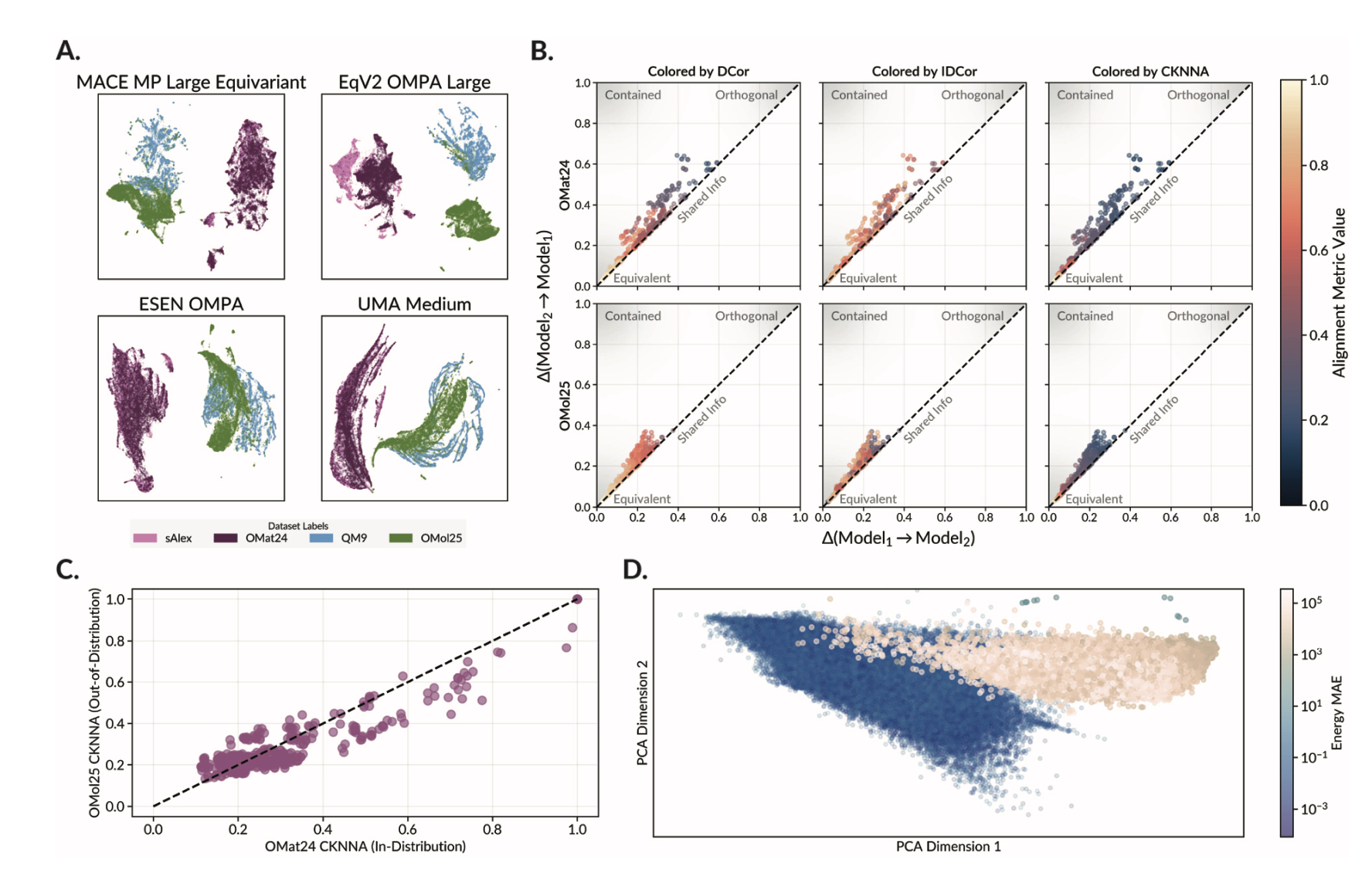

2.3 性能即真理:向最优解的渐进收敛

表征融合并非随机发生的,它是由性能驱动的必然结果。图表分析清晰地展示了一个趋势:随着模型在总能量预测任务(Energy Regression)上的平均绝对误差(MAE)降低,它们的表征与当前最先进模型(如UMA Medium或Orb V3 Conservative)的相似度呈现出单调上升的趋势。

这不仅是一个统计相关性,更是一个物理隐喻。在势能面的预测中,客观的物理现实(Ground Truth)是唯一的。随着模型预测能力的提升,它们必须更准确地捕捉原子间的相互作用、电子云的分布以及量子力学的多体效应。因此,高性能模型的潜在空间不再是任意的数学构造,而是被迫向真实的物理流形收敛。那些偏离了这一收敛轨迹的模型,往往也是在物理预测上表现不佳的模型。

3 物理实相的几何学:潜在空间解析

3.1 固有维度的统计收敛

为了量化物理实相的复杂性,我们引入了固有维度(Intrinsic Dimensionality, Id)这一概念。令人惊讶的是,尽管这些模型的参数量从几百万到数千亿不等,架构天差地别,但它们对同一类物质(如QM9中的分子)的表征的固有维度却惊人地一致,通常收敛在5到10之间。

这一数值具有极高的物理意义。它暗示了支配有机小分子化学空间的有效自由度是有限且低维的。相比之下,包含非平衡态结构和更复杂化学环境的OMat24和OMol25数据集,其表征的固有维度显著更高(接近10-15)。这说明AI模型不仅学到了数据,还准确感知到了数据背后物理系统的复杂度。不同模型对同一物理系统给出了几乎相同的维度估算,这是它们共享同一套物理世界观的有力数学证据。

4.jpg

3.2 等变性与不变性的几何印记

在深入分析架构对表征的影响时,我们发现了一个有趣的现象:等变模型(Equivariant Models,如MACE, Equiformer V2)的表征固有维度始终高于不变模型(Invariant Models,如SchNet)。

这是因为等变模型在其潜在空间中保留了关于旋转方向的信息,这增加了表征的信息容量和维度。而不变模型则将所有旋转构象坍缩为同一个点。这种差异表明,架构的归纳偏置(Inductive Bias)虽然不改变模型对物理本质的理解,但会深刻影响其潜在空间的拓扑结构。然而,即便存在这种维度的系统性差异,高性能的等变模型与高性能的不变模型在全局几何结构上依然保持着高度的对齐,说明它们抓住了相同的化学核心。

4 诊断基础性:从对齐看泛化

4.1 基础模型的试金石

如何判断一个模型是否真正达到了基础模型的层级?仅看训练集上的精度是远远不够的。本文提出了一种全新的诊断标准:基于表征对齐的泛化分析。

一个真正的科学基础模型,应该在分布内(In-Distribution)数据上与其他高性能模型高度对齐,而在分布外(Out-of-Distribution)数据上依然保持某种程度的一致性或合理的退化行为。

4.2 失败的两种模式:发散与坍缩

通过信息不平衡(Information Imbalance)分析,我们识别出了模型失败的两种截然不同的模式,这为诊断模型的成熟度提供了绝佳的工具:

- 局部的发散(分布内): 在分布内数据(如OMat24材料)上,表现较差的模型往往彼此之间对齐度极低。这表明它们陷入了各自不同的、非泛化的局部极小值(Local Sub-optima)。它们记住了数据的不同噪声或虚假相关性,因此在潜在空间中分道扬镳。相比之下,高性能模型则如同百川归海,无论出身如何,都汇聚到了同一个真理区域。

- 流形的坍缩(分布外): 当面对分布外数据(如OMol25大分子)时,许多在小分子上表现尚可的模型展现出了另一种病态——它们彼此高度对齐,但性能极差。这是因为它们都坍缩到了由模型架构决定的默认流形上,丢失了关键的化学信息。这种无知的一致性表明模型已经无法从数据中提取有效特征,只能退回到架构本身的先验结构中。

4.3 案例研究:OMat24与OMol25的分野

对OMat24(无机材料)的分析显示,当前最先进的材料模型(如UMA, Orb V3)已经展现出了强烈的基础模型特征,形成了紧密的收敛核心。然而,对于OMol25(复杂大分子),大多数现有模型仍处于架构主导的阶段,尚未形成数据主导的统一理解。这揭示了当前科学AI的一个关键瓶颈:对于复杂、非平衡态的化学空间,我们的数据覆盖度仍显不足,模型尚未完全通过相变点,达到通用的基础状态。

5 架构与数据的辩证法:苦涩的教训重演

5.1 数据主导 vs 架构主导

本研究揭示了一个深刻的二元对立规律:在分布内(In-Distribution),数据是王;在分布外(Out-of-Distribution),架构是王。

对于分布内的数据,训练数据源是决定表征结构的第一要素。使用相同数据训练的不同架构模型(如eSEN与Equiformer V2),其相似度往往高于使用不同数据训练的同一架构模型。这强调了高质量、高多样性数据在构建基础模型中的决定性作用。

然而,在面对未知领域时,模型的归纳偏置(Inductive Bias)开始接管。这时,架构设计的优劣成为了模型能否保持鲁棒性的关键。

5.2 Orb V3与MACE的启示:软约束的胜利

在架构设计上,本文对比了严格遵守旋转等变性的MACE模型和采用近似对称性及正则化手段的Orb V3模型。MACE代表了物理严谨性的极致,将对称性硬编码入网络结构;而Orb V3 Conservative则代表了计算效率与物理约束的平衡,通过Equigrad正则化在训练中软性地强加物理一致性。

令人振奋的发现是,Orb V3 Conservative不仅在性能上足以匹敌甚至超越许多严格等变模型,而且其表征与严格等变模型的对齐度极高。这验证了机器学习领域的苦涩教训(The Bitter Lesson):随着数据量和计算规模的增加,通用的、计算高效的架构配合适当的正则化(软归纳偏置),往往能战胜人为设计的复杂硬约束。

这意味着,未来的科学基础模型可能不需要极其昂贵的O(N^3)或更高复杂度的等变操作。通过扩大规模并施加物理守恒定律作为损失函数(Loss Function),我们可以在更廉价的架构(如标准Transformer或GNN)中涌现出对物理对称性的深刻理解。这对AI芯片的设计和推理基础设施的构建具有巨大的经济意义。

6 战略启示与未来展望

6.1 加速科学发现的引擎

表征融合现象的确认为科学发现的加速提供了清晰的路径。既然高性能模型都收敛于同一表征,我们可以利用这一特性进行模型蒸馏(Model Distillation)。

我们可以训练一个巨大、昂贵但在物理上极其准确的教师模型(Teacher Model),让它探索并收敛到物理实相的潜在空间。然后,我们可以训练轻量级的学生模型(Student Model),不仅学习输出结果,还直接模仿教师模型的潜在空间表征。研究表明,这种表征层面的对齐可以极大地加速生成式模型的训练。未来,在新药研发或合金设计中,我们可以在极短的时间内,用轻量级模型生成符合高精度物理规律的候选结构,这将彻底改变计算筛选的经济学模型。

6.2 迈向物质的大统一模型

当前的科学模型大多仍局限于特定的领域(蛋白质、小分子或晶体材料)。然而,表征对齐的跨模态特性(LLM与3D势函数的共鸣)暗示了构建一个涵盖所有物质形态的大统一模型(Grand Unified Model of Matter)的可行性。

这个终极模型将不再区分有机与无机,不再区分生物与非生物。它将以原子核和电子为基本语汇,在同一个高维潜在空间中统一描述蛋白质的折叠、电池材料的离子传输以及药物分子的靶点结合。我们的分析表明,通往这一圣杯的路径已经清晰:不是设计更复杂的物理方程,而是通过极大规模的数据(涵盖非平衡态、多尺度)和通用的高效架构,让物理定律在神经网络的权重中自然涌现。这就触及了人工智能架构演进的核心命题。或许这正如 图模互补应用范式所阐述的大模型的概率推理能力(Probabilistic Reasoning)需要与知识系统的确定性结构相结合,才能实现真正的深度推理与全局视野。

将这一理论映射到科学AI领域,我们所观察到的柏拉图形式涌现,本质上是神经网络在海量科学数据的驱动下,试图在潜空间中重构出一张隐式的、关于物理实相的高维知识图谱。这种将数据驱动的泛化能力与物理世界的内在结构(知识)进行深度对齐的过程,正是王文广所强调的知识增强(Knowledge Enhancement)在自然科学领域的最高级表现形式——即模型不再仅仅是拟合数据,而是在内化宇宙的知识结构。

6.3 基础设施与硬件的协同进化

随着我们意识到软约束+大规模优于硬约束+小规模,AI芯片和基础设施的设计重点也将发生转移。未来的算力需求将更多地集中在支持大规模并行、高吞吐量的通用矩阵运算上,而不是为特定的等变操作设计专用电路。这将进一步降低科学AI的门槛,使得高性能的材料探索和药物设计能够在通用的云端算力上普及。

6.4 结语

科学基础模型的表征融合不仅仅是一个技术现象,它是人类认知物理世界方式的一次数字化升华。我们正在见证一种全新的机器物理直觉的诞生。这种直觉不再依赖于符号化的公式,而是存在于数千亿参数构成的复杂流形之中。这个流形正在以惊人的速度逼近柏拉图式的物理真理。对于研究者、工程师和决策者而言,拥抱这一趋势,利用表征对齐作为导航灯塔,将是我们驶向科学发现新大陆的关键。

在原子与比特的交汇处,一个新的黄金时代正在以此为基点,向我们走来。

原创声明:本文系作者授权腾讯云开发者社区发表,未经许可,不得转载。

如有侵权,请联系 cloudcommunity@tencent.com 删除。

原创声明:本文系作者授权腾讯云开发者社区发表,未经许可,不得转载。

如有侵权,请联系 cloudcommunity@tencent.com 删除。

评论

登录后参与评论

推荐阅读

目录