基于混合两阶段工作流的异质性治疗效应分析:从统计检验到双重稳健的个体化决策优化

原创基于混合两阶段工作流的异质性治疗效应分析:从统计检验到双重稳健的个体化决策优化

原创

走向未来

发布于 2026-01-12 09:52:13

发布于 2026-01-12 09:52:13

打破平均治疗效应:统计推断与因果机器学习融合的混合两阶段工作流 | 智慧医疗

走向未来

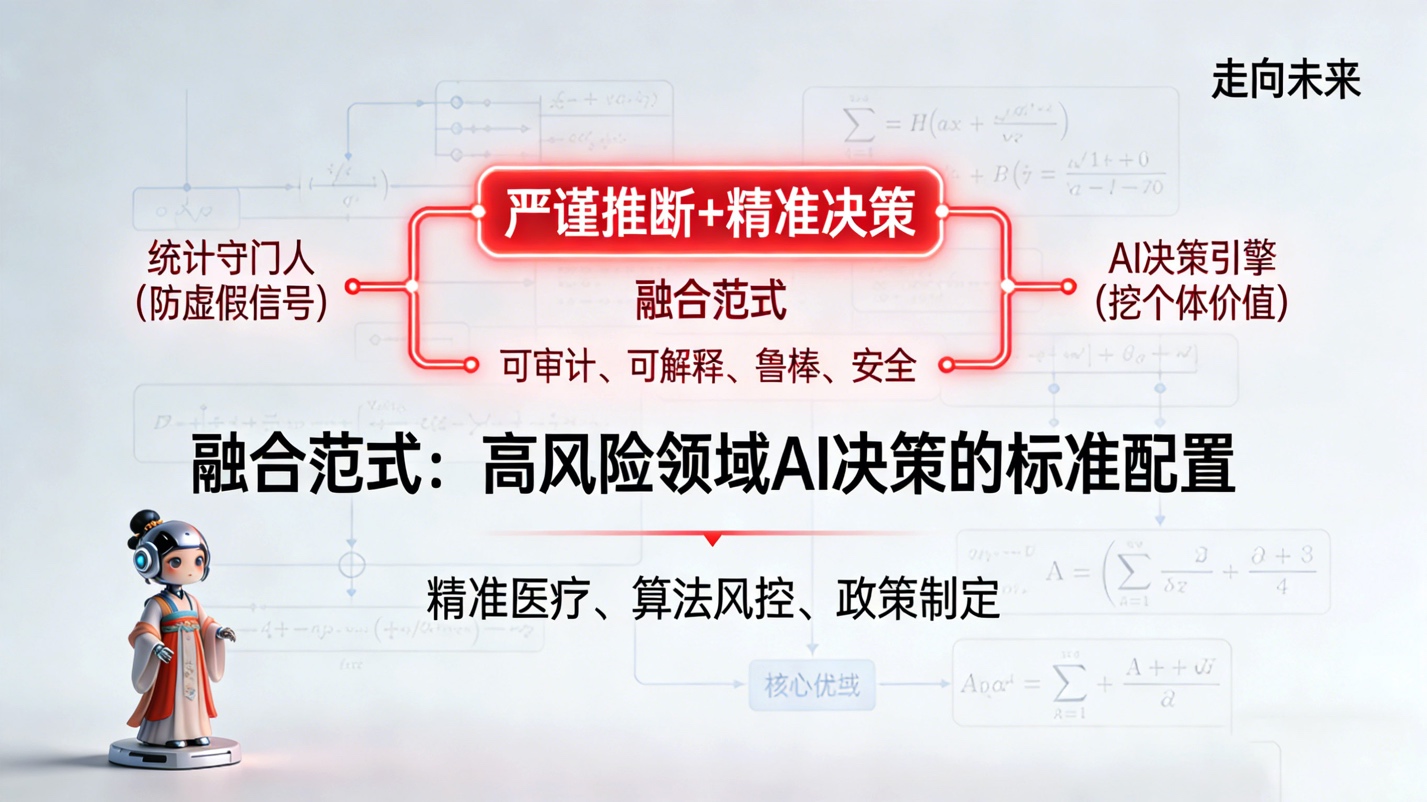

在人工智能与精准医疗深度融合的时代,如何从海量数据中挖掘异质性治疗效应(Heterogeneous Treatment Effects, HTE)并转化为可信赖的个体化决策,是学术界与工业界共同面临的重大挑战。传统的统计学方法侧重于群体层面的推断与假设检验,严谨但缺乏个体预测的灵活性;而现代机器学习方法虽擅长捕捉复杂的高维非线性关系,却往往缺乏统计学上的稳健性保证。

b/001.jpg

本文结合工智能基础设施、大模型架构及智能体系统的最新进展,对普渡大学最新论文《Subgroup Identification and Individualized Treatment Policies: A Tutorial on the Hybrid Two-Stage Workflow》(该论文已收录至走向未来知识星球)进行解读和剖析。文章将详细阐述该工作流如何通过第一阶段的统计守门人机制过滤虚假信号,并在第二阶段利用因果森林(Causal Forests)、双重稳健估计(Doubly Robust Estimation)及 Neyman-Pearson 安全约束构建高可信度的个体化治疗策略。同时,本文还将从产品设计、算力基础设施及经济价值评估的角度,探讨该范式在未来医疗、金融及公共政策领域的广泛应用前景。

1:精准决策的困境与范式重构

1.1 平均人的终结与异质性的挑战

长期以来,循证医学和诸多基于数据的决策体系都建立在平均治疗效应(Average Treatment Effect, ATE)的基础之上。随机对照试验(RCT)被视为黄金标准,其核心逻辑是通过大样本随机化来消除混杂因素,从而得出一个适用于全体受试者的平均结论。然而,随着基因组学、电子病历及穿戴设备数据的爆发式增长,我们越来越清晰地认识到,所谓的平均患者在现实中并不存在。

对于某种创新药物,ATE 为正可能掩盖了其在特定亚组(Subgroup)中的无效甚至有害;反之,一个总体无效的药物,可能对某一特定基因型的患者具有显著疗效。这种治疗反应的差异性,即异质性治疗效应(HTE),是通往精准医学的核心障碍,也是巨大的价值洼地。

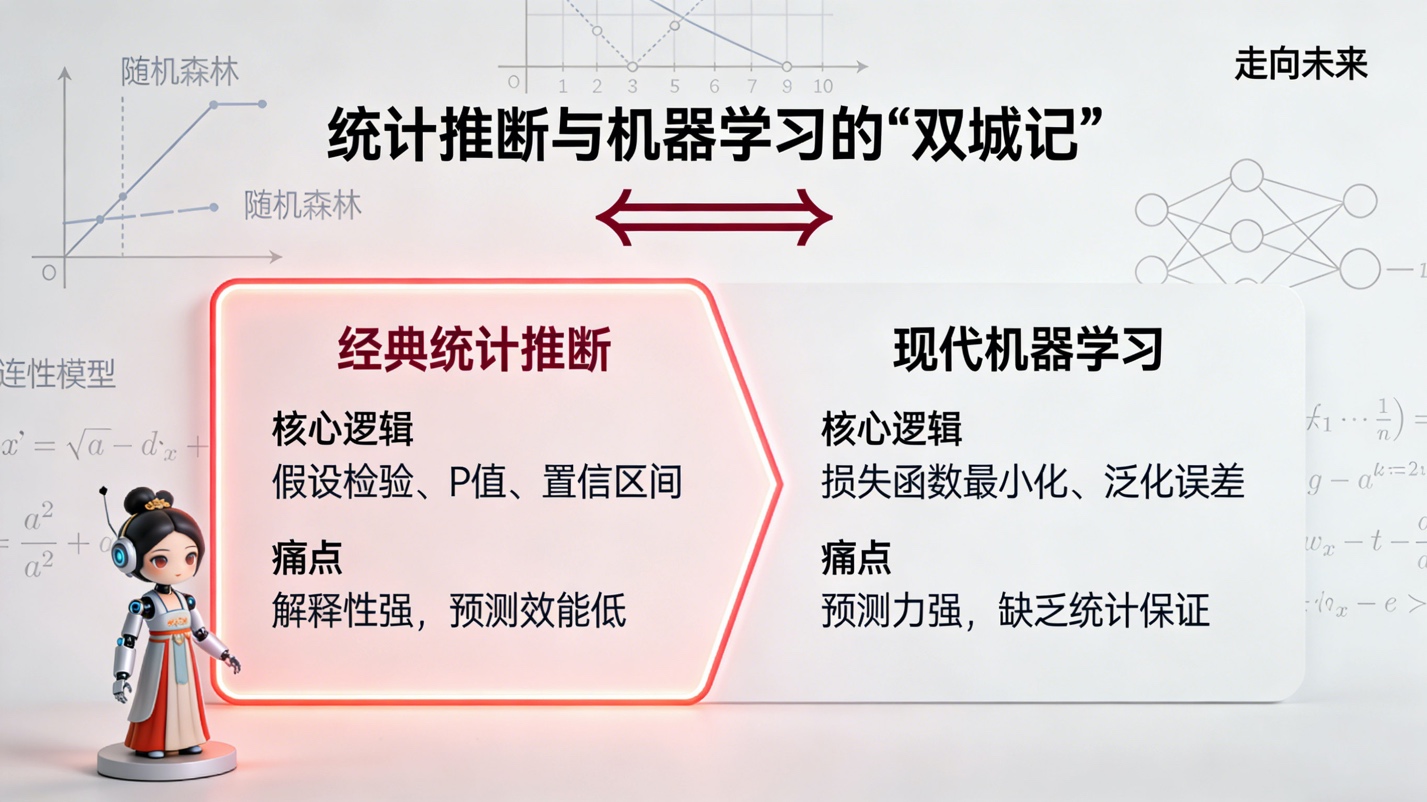

1.2 统计推断与机器学习的双城记

在处理 HTE 问题时,存在两种截然不同且长期割裂的方法论:

b/002.jpg

- 经典统计推断(Inference-Focused):

- 核心逻辑: 强调假设检验(Hypothesis Testing)、P值、置信区间和错误率控制(如 I 类错误)。

- 局限性: 为了保证统计严谨性,往往依赖简单的参数模型(如线性交互项),难以捕捉高维数据中的复杂非线性关系。其目标通常是发现亚组,而非对每个新个体进行精准预测。

- 痛点: 解释性强,但预测效能低,难以直接转化为个体化的行动指南。

- 现代机器学习(Prediction-Focused):

- 核心逻辑: 强调损失函数最小化、泛化误差、预测精度。利用随机森林、梯度提升树(XGBoost)或深度神经网络来估计条件平均治疗效应(CATE)。

- 局限性: 往往缺乏对估计不确定性的量化,容易陷入过拟合,且难以区分相关性与因果性。

- 痛点: 预测力强,但缺乏统计保证,容易在噪声中发现虚假的异质性,导致决策风险。

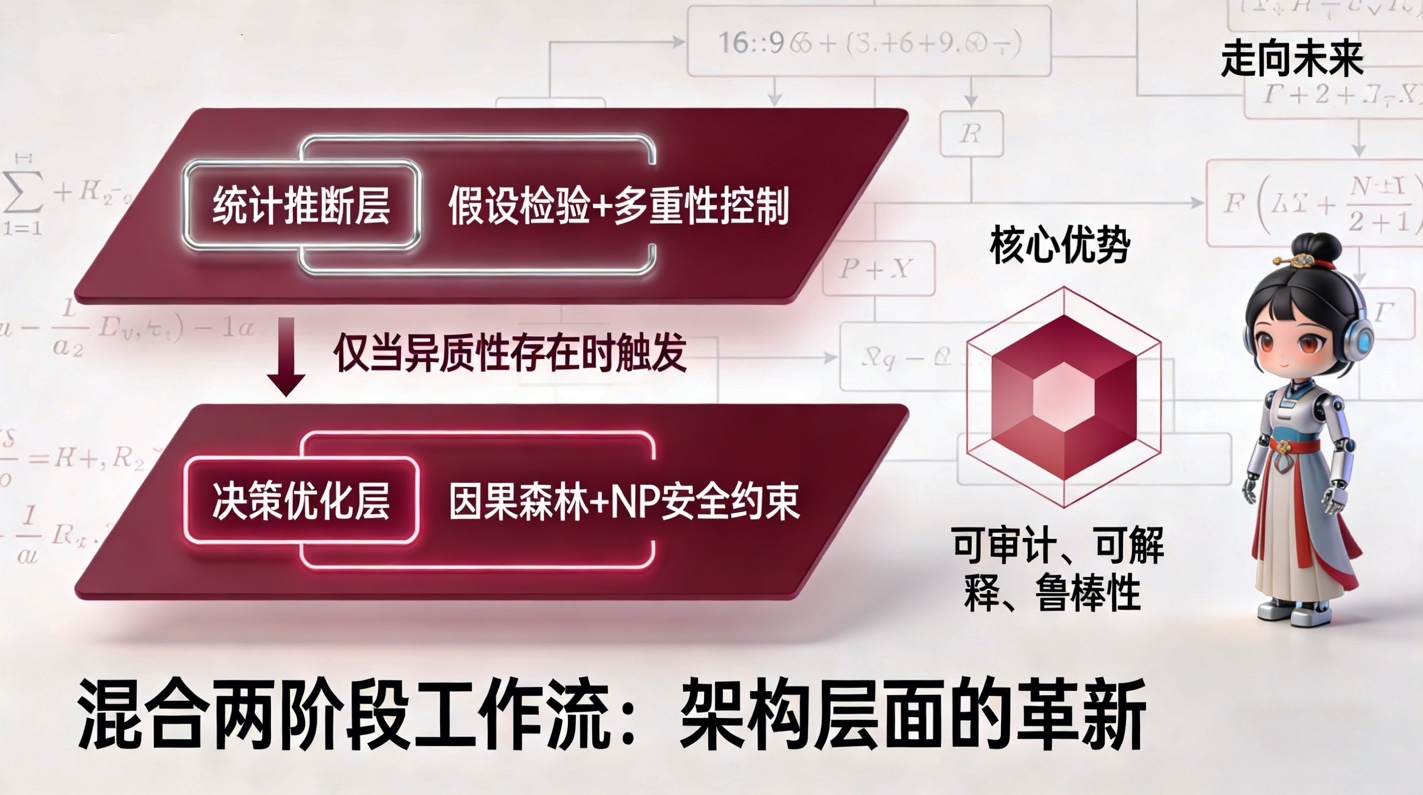

1.3 混合两阶段工作流的提出:架构层面的革新

混合两阶段工作流不仅仅是两种方法的简单叠加,而是一种架构层面的革新。它类似于现代 AI 系统中的守门人(Gatekeeper)机制与专家模型(Expert Model)的结合:

b/004.jpg

- 第一阶段(统计推断层): 作为一个严格的过滤器。利用假设检验和多重性控制(Multiplicity Control),在群体层面判断是否存在可信的异质性。只有通过了这一阶段的检验,系统才会进入下一阶段。这相当于在 AI 系统的输入端设置了一个高阈值的存在性检测。

- 第二阶段(决策优化层): 一旦确认异质性存在,即切换至高维机器学习模式。利用因果森林等先进算法估计个体层面的 CATE,并结合 Neyman-Pearson 准则构建满足安全约束的个体化治疗策略(Individualized Treatment Policy, ITP)。

这种架构设计在保证科学严谨性的前提下,最大化了数据的利用效率,为高风险领域的 AI 决策提供了一个可审计、可解释且鲁棒的标准范式。

2:第一阶段——构建统计学的防波堤

在人工智能产品设计中,防止幻觉和虚假信号是核心诉求。混合工作流的第一阶段正是为了解决这一问题,通过严格的统计学防线,防止因数据挖掘过度而产生的伪科学结论。

2.1 假设检验的三种防御阵型

为了全面捕捉可能存在的异质性,该框架设计了三种不同粒度的假设检验选项,对应不同的先验知识水平和业务需求:

b/006.jpg

- 选项 A:全局异质性检验(Omnibus Test)

- 原假设 (): 治疗效应在整个人群中是恒定的常数()。

- 技术实现: 通过似然比检验(Likelihood Ratio Test, LRT)对比仅包含主效应的模型与包含所有治疗-协变量交互项的模型。

- 战略意义: 这是一个广撒网的策略。如果该检验不显著,意味着数据不支持任何形式的异质性,后续的所有复杂建模都可能是徒劳的噪声拟合。

- 选项 B:存在性亚组检验(Existence of Benefit Subgroups)

- 原假设 (): 能够从治疗中获益超过临床阈值 的人群比例为零()。

- 技术实现: 结合自适应签名设计(Adaptive Signature Design, ASD)等前瞻性设计思路,关注是否存在具有实质性临床价值的亚组。

- 战略意义: 这直接对应产品的商业价值。如果不存在获益超过 的人群,即便存在统计学上的异质性,也可能缺乏实际的开发价值。

- 选项 C:预设交互作用检验(Prespecified Interactions)

- 原假设 (): 特定的生物标志物与治疗之间不存在交互作用。

- 技术实现: 在广义线性模型(GLM)或广义加性模型(GAM)中检验特定的交互项系数。

- 战略意义: 这是基于领域知识(Domain Knowledge)的精准打击。例如,基于药理学机制,预判某基因突变会影响药效。

2.2 错误预算的精算:多重性控制

在 AI 训练中,我们关注过拟合;在统计推断中,我们关注多重假设检验带来的 I 类错误膨胀。第一阶段引入了严格的错误预算分配(Error Budget Allocation)机制。

- Alpha Spending:将总体的显著性水平 (如 0.05)在上述三个选项中进行分配。例如,分配 给全局检验, 给预设交互。

- Holm / Benjamini-Hochberg 过程: 针对同一选项内的多个子假设(如多个生物标志物),采用 Holm 方法控制族错误率(FWER)或 BH 方法控制错误发现率(FDR)。

这种机制确保了结论的稀缺性和可信度。只有当信号强度足以穿透这层层设防的统计壁垒时,我们才认为数据中蕴含着值得挖掘的真实模式。

3:第二阶段——因果机器学习引擎

一旦通过了第一阶段的大门,工作流即进入第二阶段。此时的任务不再是简单的是非判断,而是复杂的量化估计与策略优化。这一阶段是现代 AI 技术的演武场。

3.1 CATE 估计的核心算法:因果森林

传统的监督学习预测的是结果 Y,而我们需要预测的是反事实的差值——条件平均治疗效应(CATE):

由于对于个体而言,Y(1)(受试结果)和 Y(0)(对照结果)无法同时观测,这是一个典型的因果推断缺失数据问题。该工作流推荐使用 因果森林(Causal Forests) 作为核心估计算法,其在底层逻辑上对传统的随机森林进行了深刻改造:

b/009.jpg

- 诚实性原则(Honesty):

- 在构建每一棵决策树时,将数据分为两部分:一部分用于生成树的结构(即决定如何分裂节点),另一部分用于估计叶节点内的治疗效应。

- 技术价值: 这种分离彻底消除了由于在同一数据集上既做模型选择又做参数估计而导致的偏差,是因果推断能具备渐近正态性的关键。

- 分裂准则的重构:

- 传统随机森林分裂旨在降低预测误差(如均方误差 MSE)或不纯度(Gini 系数)。

- 因果森林的分裂准则旨在最大化子节点间治疗效应的差异(Maximize Heterogeneity)。它寻找的是那些能够将对治疗反应强烈和对治疗无反应的人群区分开的特征空间切割方式。

- 正交化(Orthogonalization):

- 受罗宾逊变换(Robinson Transformation)的启发,因果森林通过回归掉协变量 X 对结果 Y 和治疗 A 的主效应,利用残差来估计因果效应。这使得模型对混杂因素具有极强的鲁棒性,类似于深度学习中的残差连接(Residual Connections)思想。

3.2 策略评估的黄金标准:双重稳健估计(Doubly Robust Estimation)

在估计出每个人的 CATE 分数后,我们需要评估基于该分数制定的治疗策略的价值。直接使用模型预测值进行评估会引入偏差,因此工作流引入了 双重稳健(Doubly Robust, DR) 估计量:

- 架构解析: 该公式结合了结果回归模型(Outcome Regression, )和倾向性评分模型(Propensity Score, e(X))。

- 鲁棒性原理: 只要这两个模型中有一个是设定正确的,最终的 CATE 估计就是无偏的。这种双重保险机制在模型误设风险极高的医疗数据中至关重要。

- 交叉拟合(Cross-Fitting): 为了进一步消除过拟合,工作流强制要求使用交叉拟合技术。即:用于评估第 k 份数据的 DR 伪结果时,其内部依赖的 和 模型必须是在除 k 以外的数据上训练得到的。这与 AI 训练中的Hold-out Validation异曲同工,但在因果推断中被执行得更为彻底。

3.3 提升曲线(Uplift Curve)与 AUQC

为了量化模型对个体的排序能力,工作流采用了提升建模(Uplift Modeling)中的核心指标——提升曲线。

通过将人群按预测的 CATE 值从高到低排序,计算累计的 DR 伪结果,我们可以绘制出 Uplift Curve。曲线下的面积(AUQC)提供了一个类似于 AUC 的综合指标,但它衡量的是模型区分获益者与非获益者的能力,而非区分正类与负类的能力。

4:安全约束与决策优化——Neyman-Pearson 准则

在自动驾驶、金融风控及医疗决策等高风险 AI 应用中,单纯追求期望收益最大化往往是不可接受的,必须引入严格的安全性约束。混合两阶段工作流创新性地引入了 Neyman-Pearson (NP) 准则 来解决这一问题。

4.1 并不对称的代价函数

在二分类决策中,我们将错误分为两类:

- I 类错误(假阳性): 错误地治疗了一个不会获益(甚至受害)的患者。

- II 类错误(假阴性): 错过了一个本该获益的患者。

在医疗场景中,这两类错误的代价是极度不对称的。根据不伤害原则(Primum non nocere),I 类错误的代价往往远高于 II 类错误。

4.2 约束优化问题的数学表述

传统的机器学习分类器通常最小化加权错误率,而 NP 准则将其转化为一个带约束的优化问题:

其中,t 是 CATE 的决策阈值,是预设的容忍上限(例如 10%)。

- 替代指标(Surrogates): 由于真实的伤害是不可观测的(我们不知道如果未治疗会怎样),工作流利用交叉拟合的 DR 伪结果构建了代理伤害指标:。

- NP-ROC 边界: 通过在不同阈值下计算伤害率与获益捕获率,构建 NP-ROC 曲线。最优决策点不是曲线上离左上角最近的点,而是满足伤害约束条件下,获益最大的点。

这一机制将 AI 决策从黑盒预测提升到了安全可控的工业级标准,为算法在受监管环境下的落地提供了理论依据。

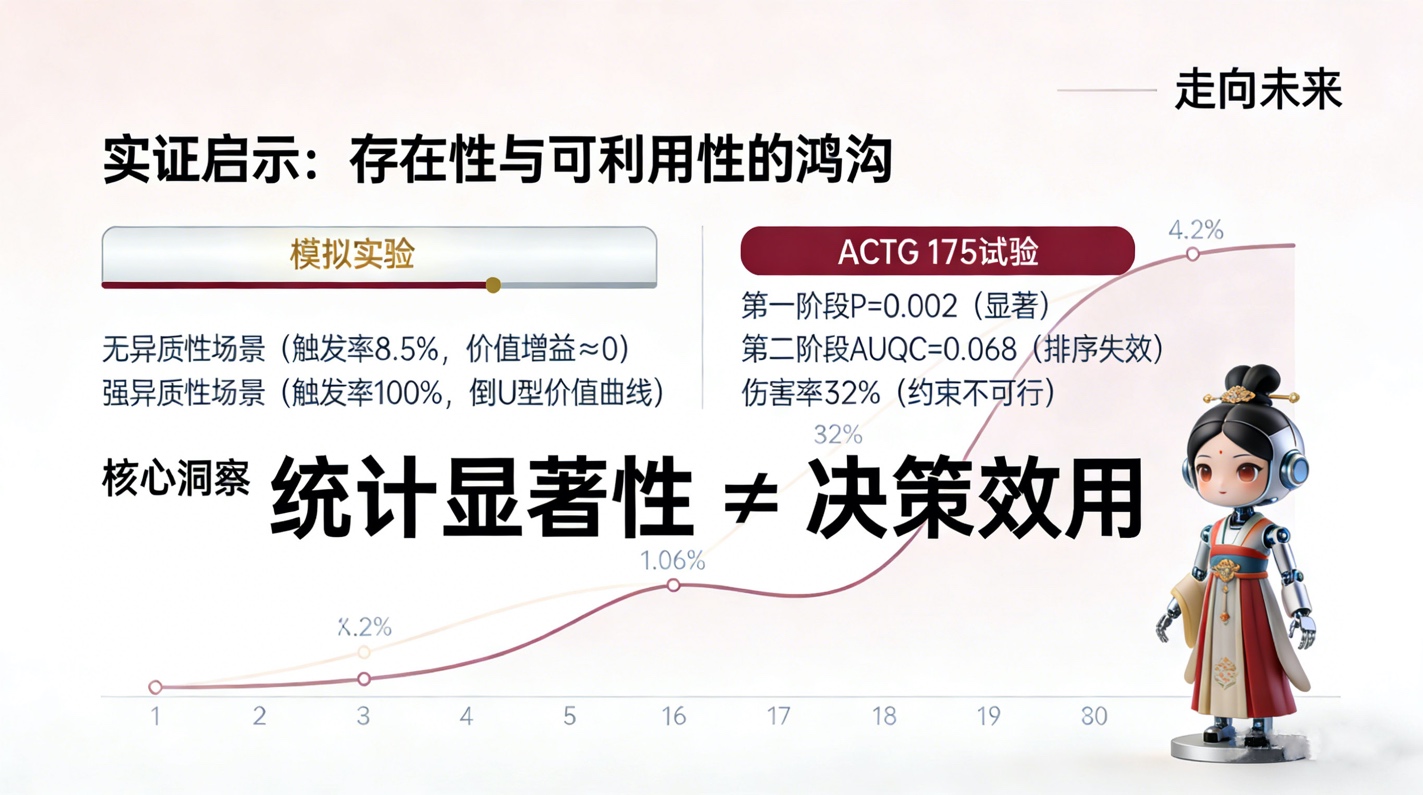

5:实证分析的深刻启示

通过对模拟数据和真实临床试验数据的分析,该工作流展示了极强的鉴别能力,揭示了统计显著性与决策效用之间的鸿沟。

b/010.jpg

5.1 模拟实验:信噪比的试金石

在模拟研究中,设置了三种场景:无异质性(No HTE)、弱异质性(Weak HTE)和强异质性(Strong HTE)。

- 无异质性场景: 第一阶段的全局检验仅在约 8.5% 的情况下被触发(接近预设的 水平),成功拦截了绝大多数虚假信号。第二阶段的价值增益(Value Gain)几乎为零。这证明了守门人机制在防止过度医疗方面的巨大价值。

- 强异质性场景: 第一阶段 100% 触发。第二阶段的策略价值曲线呈现明显的倒 U 型,最优阈值 清晰可见,且带来的价值增益显著。Neyman-Pearson 准则在这种情况下能够通过牺牲少量获益来大幅降低伤害率。

5.2 ACTG 175 试验:当显著并不意味着有用

对 ACTG 175 艾滋病临床试验数据的分析,提供了一个极具警示意义的案例:

- 第一阶段通过: 全局检验显示 P=0.002,显著拒绝了无异质性的原假设。且预设的 Karnofsky 评分与治疗的交互作用也显著。从统计学角度看,异质性是存在的。

- 第二阶段受挫:

- 排序能力差: AUQC 仅为 0.068,提升曲线几乎是一条直线(接近随机排序)。这意味着虽然群体存在异质性,但在现有的协变量维度下,模型无法有效地识别出谁是获益者。

- 策略失效: 策略价值曲线显示,全员治疗(Treat All)几乎是最优解。

- 约束不可行: 在 10% 的伤害容忍度下,没有任何阈值能满足条件(最低伤害率也高达 32%)。

深度洞察: 这一案例深刻揭示了存在性(Existence)与可利用性(Exploitability)的区别。统计学显着性只表明有信号,但信号可能太微弱,或者淹没在巨大的噪声中,或者依赖于未被测量的特征,导致 AI 无法学习到可操作的个体化规则。混合工作流通过第二阶段的验证,避免了仅凭第一阶段的 P 值就盲目开发伴随诊断产品的商业风险。

6:战略价值与未来展望

6.1 从治疗到管理的范式转移

混合两阶段工作流不仅适用于药物研发,更可推广至广泛的资源分配问题。其核心思想是非均匀的资源配置优化。

b/003.jpg

在卫生经济学层面,该工作流能够计算出不治疗(Treat None)或精准治疗(Treat Optimal)相对于全员治疗(Treat All)的成本节约。对于昂贵的基因疗法或免疫疗法,这种基于 CATE 的精准准入机制,将成为医保支付和商业保险定价的核心算法基础。

6.2 AI 基础设施与算力需求

实施这一工作流对 AI 基础设施提出了更高要求:

- 算力密集型: 交叉拟合(Cross-Fitting)和因果森林的训练需要大量的计算资源。特别是当样本量达到百万级(如真实世界证据 RWE 研究)时,需要基于 GPU 加速的分布式计算框架(如 Ray 或 Spark)来并行处理每一折(Fold)的模型训练。

- 技术融合: 这不仅考验算法设计,更对底层的AI芯片和硬件架构提出了挑战。

- 特征工程自动化: 因果森林的性能高度依赖于协变量的质量。结合大语言模型(LLM)从非结构化文本(医生笔记、病理报告)中提取高维特征,将是提升 Stage 2 预测能力的关键突破口。

6.3 迈向智能体医疗(Agentic Healthcare)

展望未来,这一工作流将成为医疗智能体(Medical Agents)的底层决策逻辑:

- 动态策略: 目前的分析是静态的(一次性决策)。未来,结合强化学习(RL),该框架可以扩展为多阶段的动态治疗方案(Dynamic Treatment Regimes, DTR)。

- 人机协作: 智能体可以实时监控患者数据,利用 Stage 2 的模型不断更新 CATE 估计。当预测的获益概率跌破 NP 安全阈值时,智能体自动触发警报或建议停药。

6.4 可审计的 AI(Auditable AI)

在监管层面,FDA 和 EMA 等机构对 AI/ML 医疗器械的黑盒性质始终存疑。混合两阶段工作流提供了一条完美的可审计路径:

- 预先注册(Preregistration): 在 Stage 1 明确定义假设和错误预算,杜绝 P-Hacking。

- 过程透明: Stage 2 的决策阈值选择基于明确的数学准则(如 NP 准则),而非炼丹式的参数调优。

- 结果量化: 输出明确的获益率和伤害率边界。

这种透明度将是 AI 医疗产品获得监管批准和医生信任的基石。

结语

混合两阶段工作流代表了人工智能方法论的一次成熟与升华。它不再盲目崇拜算法的拟合能力,而是谦卑地引入统计学的怀疑精神作为守门人;它也不再固守传统统计的均值陷阱,而是大胆利用机器学习挖掘个体层面的微观价值。

从技术角度看,它是因果推断、集成学习与约束优化的精妙结合;从应用角度看,它是连接数据信号与临床决策的坚实桥梁。在精准医疗、算法风控、政策制定等所有关乎个体命运的高风险领域,这种严谨推断 + 精准决策的融合范式,必将成为未来人工智能系统的标准配置。我们有理由相信,随着算法的迭代和算力的提升,这一工作流将帮助我们更清晰地听懂数据中的噪音,更智慧地做出每一个关乎生命的决策。

原创声明:本文系作者授权腾讯云开发者社区发表,未经许可,不得转载。

如有侵权,请联系 cloudcommunity@tencent.com 删除。

原创声明:本文系作者授权腾讯云开发者社区发表,未经许可,不得转载。

如有侵权,请联系 cloudcommunity@tencent.com 删除。

评论

登录后参与评论

推荐阅读

目录