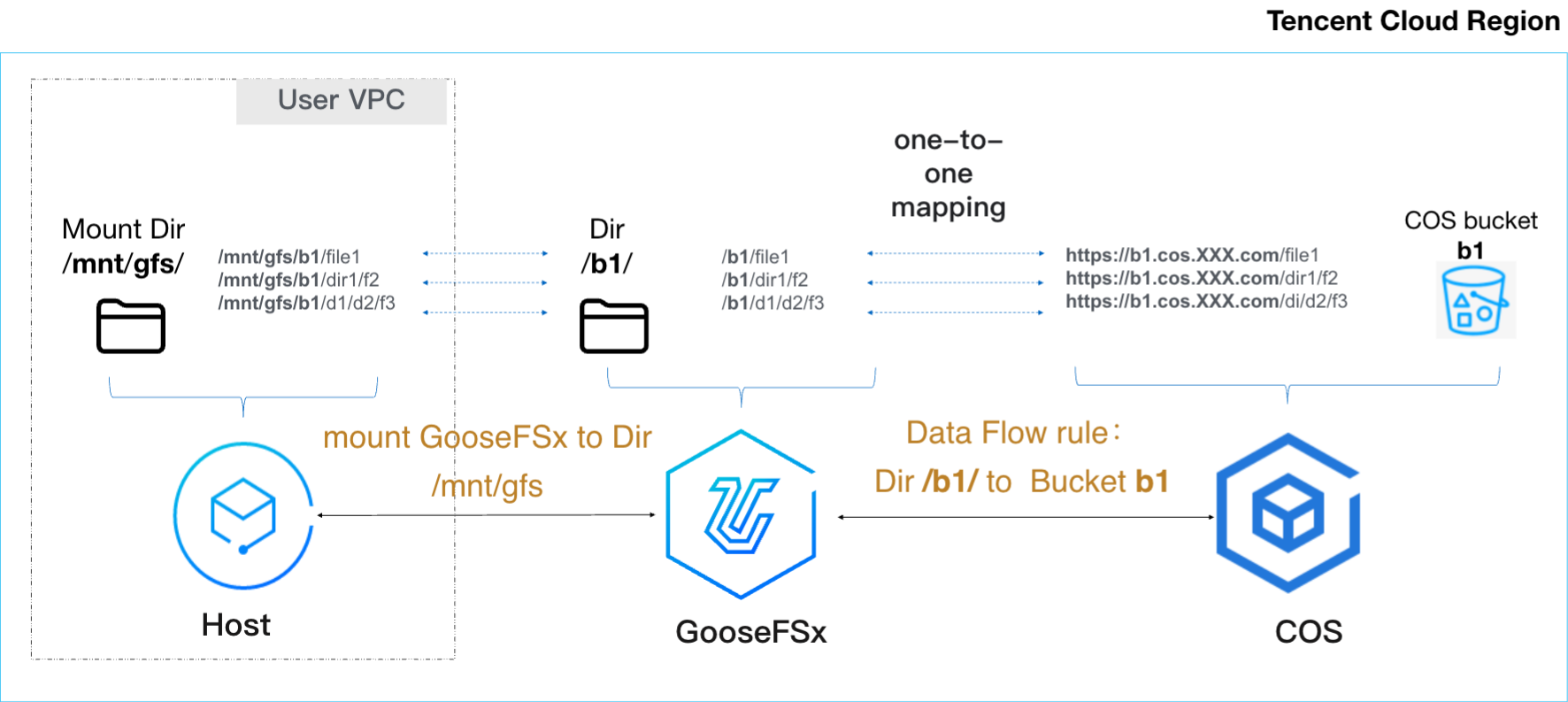

GooseFSx(Data Accelerator Goose FileSystem extreme,GooseFSx)是由腾讯云推出的高性能的 POSIX 语义的数据加速器,可为对象存储(Cloud Object Storage,COS)加速,为高性能计算业务提供极高性能和极低时延,方便用户灵活管理冷、热数据,适用于高性能计算、自动驾驶、机器学习等业务场景。GooseFSx 是全托管服务,简单易用,按小时付费,用完可释放,通过 COS 来持久化保存数据。如下图所示:

GooseFSx 可自动挂载成主机的本地目录(该目录称为挂载目录)。在主机上访问 GooseFSx 挂载目录,如同在本地文件系统访问 GooseFSx。

GooseFSx 为 COS 加速,能够直接从 COS 加载数据,以便主机能够高速访问缓存到 GooseFSx 的数据;能够将 GooseFSx 上产生的计算结果沉降到 COS,实现持久化、低成本保存。

超级目录

超级目录(Fileset)是具备配额、删除文件记录、QoS 等功能的目录,是 GooseFSx 文件系统中一个子文件系统,拥有独立的存储空间和性能管理能力。相比普通目录,超级目录功能更强大,如下表所示:

对比项 | 超级目录 | 普通目录 |

目录配额 | 支持 | 不支持 |

文件删除记录 | 支持 | 不支持 |

父目录 | 根目录或普通目录 | 根目录或普通目录或超级目录 |

目录内容 | 普通目录或文件 | 普通目录或文件或超级目录 |

数量 | 单实例支持100亿级普通目录 |

超级目录,用于在单个 GooseFSx 文件系统内实现精细化的资源管理和策略控制。典型用法是为不同部门、用户或应用分配不同超级目录,避免数据混杂,同时共享同一个 GooseFSx 实例;为每个超级目录分配不同的容量配额或文件数配额,防止单一部门、用户或应用耗尽全局资源;基于超级目录粒度记录访问日志,满足合规要求。

说明:

配额

配额,是存储容量或文件数量的用量限制,支持 GooseFSx 在多部门、多用户或多应用场景下的存储资源分配与管控,便于精细化管理资源,防止单一部门、用户或应用耗尽全局资源。

容量配额,为超级目录的最大可写入容量,达到配额上限后无法再写入新数据。

文件数配额,为超级目录最多可写入的文件与目录数量,达到配额上限后无法再写入新数据。

当设置配额后,在每次写 I/O 操作时,将配额的已用容量和文件数,累加本次操作增加的容量和文件数,检查总使用量是否超出配额,若超出配额,则写 I/O 操作失败,报错:Disk quota exceeded;若未超出配额,则放行。从而保障用量始终在配额范围内,防止超出限制。建议您合理设置配额、并配置告警策略,以便在容量、文件数等临近配额时,及时收到告警信息。

配额分为目录配额和用户配额:

目录配额,是对某个超级目录设置存储容量或文件数量的用量限制;目录配额是针对此目录的所有用户生效。

用户配额,是对某个用户或某个用户组设置存储容量或文件数量的用量限制;用户配额是针对此用户或用户组的所有目录生效。

典型用法,为不同部门、用户设置不同的用户配额,精细化管理和监控不同部门、用户的资源用量;或为不同业务或用户分配不同目录,事先创建好相应的超级目录,设置目录配额。

说明:

删除文件记录

删除文件记录,是记录删除文件或目录的操作记录,包括路径、文件名、时间等信息,是 GooseFSx 提供的审计删除操作的功能。

删除文件记录,用于在数据被误删等场景下,根据删除文件记录、可快速进行问题定位和修复。

根目录和超级目录具备开启或关闭删除文件记录的能力,普通目录不具备开启或关闭删除文件记录的能力。

说明:

开启删除文件记录后,系统将记录该目录下所有的删除行为;关闭删除文件记录后,系统将停止记录该目录下所有的删除行为。可在线开启或关闭删除文件记录。请前往 GooseFSx 挂载目录查看删除文件记录。

删除文件记录保存在根目录的 .audit_log 目录下,文件名是 auditLogFile_<IO_Node_Name>_YYYY-MM-DD_HH:MM:SS,其中,IO_Node_Name 是主机客户端名称,YYYY-MM-DD_HH:MM:SS 是创建文件的时间;当文件大小超过400MB、或记录超过5百万条、或开启删除文件记录,将创建一个新文件。文件按照年/月/日目录结构进行组织,最新的文件软链到顶层目录,软链名是 auditLogFile.latest_<IO_Node_Name>。

POSIX 客户端

GooseFSx POSIX 客户端是已部署 GooseFSx POSIX 客户端软件、并将 GooseFSx 挂载成本地目录的主机。GooseFSx 可自动将主机部署成 POSIX 客户端,实现原理是自动在主机上部署 GooseFSx POSIX 客户端软件,并将 GooseFSx 挂载成主机的本地目录。在 POSIX 客户端上访问 GooseFSx 挂载目录,如同在本地文件系统访问 GooseFSx。如图所示:

在创建 GooseFSx 实例时,将会在您的腾讯云账号下自动创建3台腾讯云云服务器(Cloud Virtual Machine,CVM)实例,实例规格是不小于4C8G,部署成 POSIX 客户端管理节点。POSIX 客户端管理节点随 GooseFSx 实例一同创建和销毁,您无需管理。

注意:

请勿销毁或变更 POSIX 客户端管理节点,否则会导致 POSIX 客户端工作异常。

GooseFSx 配置3台 POSIX 客户端管理节点,以实现高可用。极端情况下,POSIX 客户端管理节点故障,可能会导致 POSIX 客户端无法正常访问GooseFSx,但不会影响已写入 GooseFSx 的数据;当 POSIX 客户端管理节点故障恢复后,POSIX 客户端正常访问 GooseFSx。

POSIX 客户端管理节点,管理 POSIX 客户端的部署、删除等。POSIX 客户端管理节点不参与数据流、不访问数据、不存储数据。

POSIX 客户端管理节点,需要在管控面与 POSIX 客户端互通;为了保障您的 POSIX 客户端的信息安全,将 POSIX 客户端管理节点部署在您的 VPC,保障管控流不会流出您的 VPC。

GooseFSx 支持自动添加 POSIX 客户端,自动将指定主机添加为 GooseFSx POSIX 客户端,省去手动一步步执行命令、将主机添加为 GooseFSx POSIX 客户端。GooseFSx 能够批量添加 POSIX 客户端,一次自动添加多个 POSIX 客户端。GooseFSx 能够自动删除 POSIX 客户端,能够批量删除多个 POSIX 客户端。

GooseFSx 实现 POSIX 客户端集中管理,能实时查询使用 GooseFSx 的 POSIX 客户端,能及时删除不再使用 GooseFSx 的 POSIX 客户端,能立即添加需要使用 GooseFSx 的 POSIX 客户端。

数据流动

数据流动是数据加速器 GooseFSx 与对象存储 COS 之间按需流动数据。GooseFSx 从 COS 预热所需的数据,以便主机访问高速 GooseFSx,实现对 COS 加速;GooseFSx 将产生的计算结果沉降到 COS,实现持久化、低成本存储,或通过 COS 的互联网分发能力共享计算结果。

GooseFSx 可同时与多个同地域 COS 存储桶或跨地域 COS 存储桶流动数据。与跨地域 COS 存储桶流动数据,推荐使用 COS 全球加速域名,速率快、成本低、使用简单。也可使用与跨地域 COS 存储桶互通的网络连接,需要手动配置和管理。

对比项 | COS 全球加速域名 | 自定义接入点 |

工作原理 | 借助腾讯全局流量调度的负载均衡系统,利用全球分布的云机房,选择最优网络访问链路,实现请求就近接入。 | 用户自行采用云联网等互联网络技术,将跨地域 COS 存储桶与关联 VPC 打通网络。 |

速率 | 流动性能高,详情请联系存储架构师。 | 不确定,依赖跨地域互联网络。 |

成本 | 成本低。 | 建议复用已有的跨地域互联网络,若单独创建跨地域互联网络,成本会很高。 |

易用性 | 全自动,使用简单,仅需要 COS 存储桶开启全球加速,GooseFSx 会自动获取和使用 COS 存储桶的全球加速域名。 | 手动管理,例如:创建或配置跨地域互联网络,配置跨地域 COS 存储桶映射到关联 VPC(与 GooseFSx 关联的用户 VPC)的 IP,管理跨地域互通网络的连通和速率等。 |

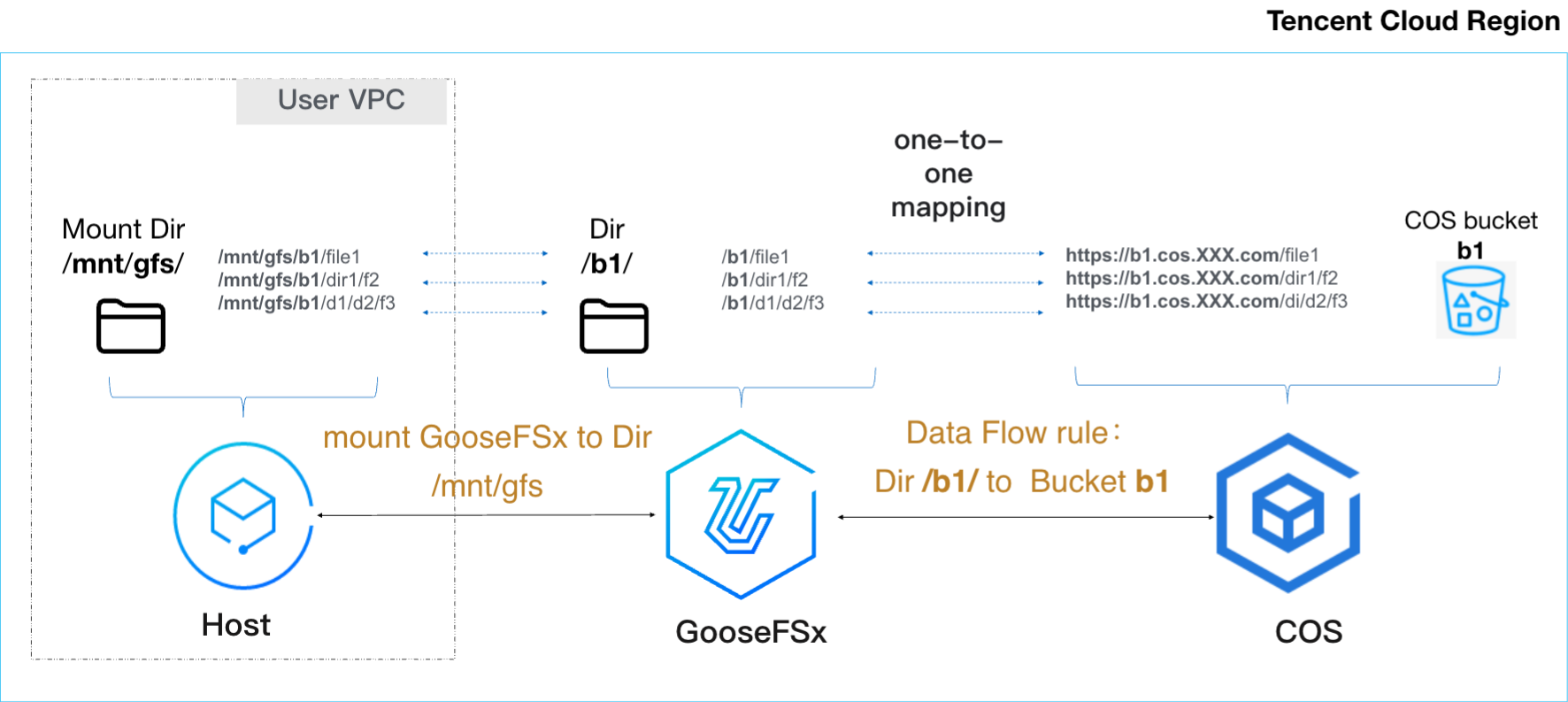

数据流动保持 GooseFSx 目录的数据与 COS 存储桶的数据一一对应,预热时,将 COS 存储桶的对象转换为文件,预热到 GooseFSx 对应目录;沉降时,将 GooseFSx 目录的文件转换为对象,沉降到 COS 存储桶的对应路径。如下图所示:

数据流动规则

数据流动规则,是数据加速器 GooseFSx 目录与对象存储 COS 存储桶之间流动数据的规则。

创建数据流动规则,确定数据加速器 GooseFSx 某目录与对象存储 COS 某存储桶之间数据流动规则,比如,数据流动模式、数据流动带宽等。GooseFSx 可创建多个数据流动规则,同时与多个 COS 存储桶流动数据。详情请参见 数据流动的使用限制。

数据流动模式,如下表所示。

数据流动模式 | 说明 | 使用场景 |

手动模式 | 手动模式是手动触发的、系统自动执行的数据预热或数据沉降。 | 主机高性能访问 GooseFSx,避免同步访问 COS 拖慢性能。 说明: 需要提前将数据预热到 GooseFSx。 |

在创建数据流动规则之前,请确保数据流动带宽不为0;反之,若需要将数据流动带宽缩到0,请先删除所有的数据流动规则。

删除数据流动规则,删除数据加速器 GooseFSx 某目录与对象存储 COS 某存储桶之间数据流动规则,和删除该流动规则对应的数据流动(数据预热和数据沉降),删除流动规则后,不能对该 GooseFSx 目录执行数据流动(数据预热和数据沉降)。

数据流动带宽

数据流动带宽,是数据加速器 GooseFSx 与 COS 进行流动数据的带宽。GooseFSx 数据流动带宽越高,GooseFSx 执行数据流动的速率越快,反之,越慢。为匹配业务需求,可随时扩大或缩小数据流动带宽。

示例说明

数据流动带宽的步长为600MB/s,用户购买 N 个步长后,数据流动带宽将扩大 N * 600MB/s,反之,缩小 N * 600MB/s。

数据流动带宽的最大值约等于 GooseFSx 实例的带宽,因为,数据流动在 GooseFSx 与 COS 存储桶之间传输数据,数据流动带宽不会超过 GooseFSx 实例的最大带宽和 COS 存储桶的最大带宽,而一个 GooseFSx 实例能够同时与多个 COS 存储桶流动数据,所以,数据流动带宽的最大值约等于 GooseFSx 实例的带宽。

数据流动带宽的状态:待扩容、扩容中、缩容中、运行中。

状态 | 说明 | 数据流动 |

待扩容 | 数据流动带宽为0,请先扩容带宽,否则,无法流动数据。 | 不能创建数据流动规则,不能流动数据。 |

扩容中、缩容中 | 正在调整数据流动带宽,不能再次发起扩容或缩容数据流动带宽。 | 可创建数据流动规则,可流动数据,详情请联系存储架构师。 |

运行中 | 正常运行,可扩容或缩容数据流动带宽。 | 可创建数据流动规则,可流动数据。 |

说明:

数据流动费用

数据流动,会产生 GooseFSx 数据流动带宽费用;若开启全球加速访问跨地域 COS 存储桶,会产生全球加速流量费,由 COS 产品收取;会读取 COS,会产生 COS 请求费用,由 COS 产品收取。

场景 | 费用 | 说明 |

与同地域 COS 桶流动数据 | GooseFSx 数据流动带宽费用。 | GooseFSx 数据流动带宽费用,由 GooseFSx 产品收取。 |

与跨地域 COS 桶流动数据 | COS 请求费用。 | COS 请求费用,由 COS 产品收取。 |

与跨地域 COS 桶流动数据 | GooseFSx 数据流动带宽费用。 | GooseFSx 数据流动带宽费用,由 GooseFSx 产品收取。 |

| COS 全球加速流量费用。 | COS 全球加速流量费用,由 COS 产品收取。 |

| COS 请求费用。 | COS 请求费用,由 COS 产品收取。 |

数据预热

数据预热,是从 COS 存储桶预热数据到 GooseFSx 目录,将您指定的数据(整个目录、某个子目录或清单)自动、完整、增量地预热到 GooseFSx 中。

数据预热,保持 GooseFSx 数据与 COS 存储桶的数据一一对应,保持目录和文件的权限不变。例如,COS 存储桶的对象:H1/big/test.dat,预热成 GooseFSx 目录的文件:H1/big/test.dat。

数据预热有:单次任务和周期任务。

单次任务,是用户发起、系统立即执行。

周期任务,是用户配置周期策略、系统自动周期性执行。详情请参见 数据流动周期策略。

数据沉降

数据沉降,是将 GooseFSx 目录的数据沉降到 COS 存储桶,将您指定的数据(整个目录、某个子目录或清单)自动、完整、增量地沉降到 COS 中。

数据沉降,保持 GooseFSx 数据 与 COS 存储桶的数据一一对应,保持目录和文件的权限不变。例如,GooseFSx 目录的文件:H1/big/test.dat,沉降为 COS 存储桶的对象:H1/big/test.dat, 目录沉降为特殊对象。

数据沉降分为:数据沉降和数据沉降并删除本地数据。

类型 | 说明 | 使用场景 |

数据沉降 | 将 GooseFSx 的数据沉降到 COS。 GooseFSx 和 COS 均有一份数据。 | 创建数据流动规则时,数据流动模式选择手动模式。 将计算结果沉降到 COS 长期保存或互联网分发。 |

数据沉降并删除本地数据 | 将 GooseFSx 的数据沉降到 COS,然后删除 GooseFSx 的数据。 GooseFSx 没有此数据,COS 有一份数据。 | 创建数据流动规则时,数据流动模式选择手动模式。 将计算结果沉降到 COS 长期保存或互联网分发,并删除 GooseFSx 的数据、释放 GooseFSx 空间。 |

数据沉降有:单次任务和周期任务。

单次任务,是用户发起、系统立即执行。

周期任务,是用户配置周期策略、系统自动周期性执行。详情请参见 数据流动周期策略。

数据流动周期策略

数据流动周期策略(简称周期策略),用于周期性触发数据流动任务,例如每小时沉降 COS 的周期策略、每间隔1小时触发一次沉降任务,将 GooseFSx 的指定数据集沉降到对应的 COS 桶。适用于定期与 COS 桶同步数据、及时从 COS 桶预热数据等场景。

数据流动周期策略,支持配置多种周期策略:

每小时周期策略:每小时在指定分钟触发数据流动任务。

每天周期策略:每天在指定小时触发数据流动任务。

每周周期策略:每周在指定天触发数据流动任务。

每月周期策略:每月在指定天触发数据流动任务。

云盘多挂

GooseFSx 支持云盘多挂,即将一块云盘同时挂载到多个 GooseFSx 存储节点。云盘多挂容忍任意多个节点同时故障,业务不中断、数据不丢失,极大提升产品可用性(从99.9%提升到99.9999999%)。

云盘多挂工作机制如下:

正常情况下,第一个节点读写此云盘,其他节点不读写此云盘,与云盘单挂工作机制一样。

异常情况下,第一个节点故障,将自动切换到第二个节点读写此云盘。切换过程如下:

自动切换,主机无感,切换过程中的主机请求,通过重试机制发给第二个节点。

瞬间切换,因为多节点共享云盘,切换过程无须同步数据,秒级完成切换。

第二个节点故障,将自动切换到第三个节点,容忍多节点同时故障,从而实现极高可用性。