操作场景

CKafka 连接器提供数据流出能力,您可以将 CKafka 数据分发至 COS 以便于对数据进行分析与下载等操作。

前提条件

该功能目前依赖对象存储(COS)产品,使用时需开通相关产品功能。

已创建好数据流出的目标存储桶。

操作步骤

创建任务

1. 登录 CKafka 控制台。

2. 在左侧导航栏单击连接器 > 任务列表,选择好地域后,单击新建任务。

3. 填写任务名称,任务类型选择数据流出,数据目标类型选择 对象存储(COS),单击下一步。

4. 配置数据源信息。

Topic 类型:选择数据源 Topic。

弹性 Topic:选择提前创建好的弹性 Topic,详情参见 Topic 管理。

CKafka 实例内 Topic:选择在 CKafka 创建好的实例和 Topic,若实例设置了ACL 策略,请确保选中的 topic 有读写权限,详情参见 创建 Topic。

起始位置:选择转储时历史消息的处理方式,topic offset 设置。

5. 设置上述信息后,单击下一步,单击预览 Topic 消息,将会选取源 Topic 中的第一条消息进行解析。

6. (可选)开启对源数据进行数据处理按钮,具体配置方法请参见 简单数据处理。

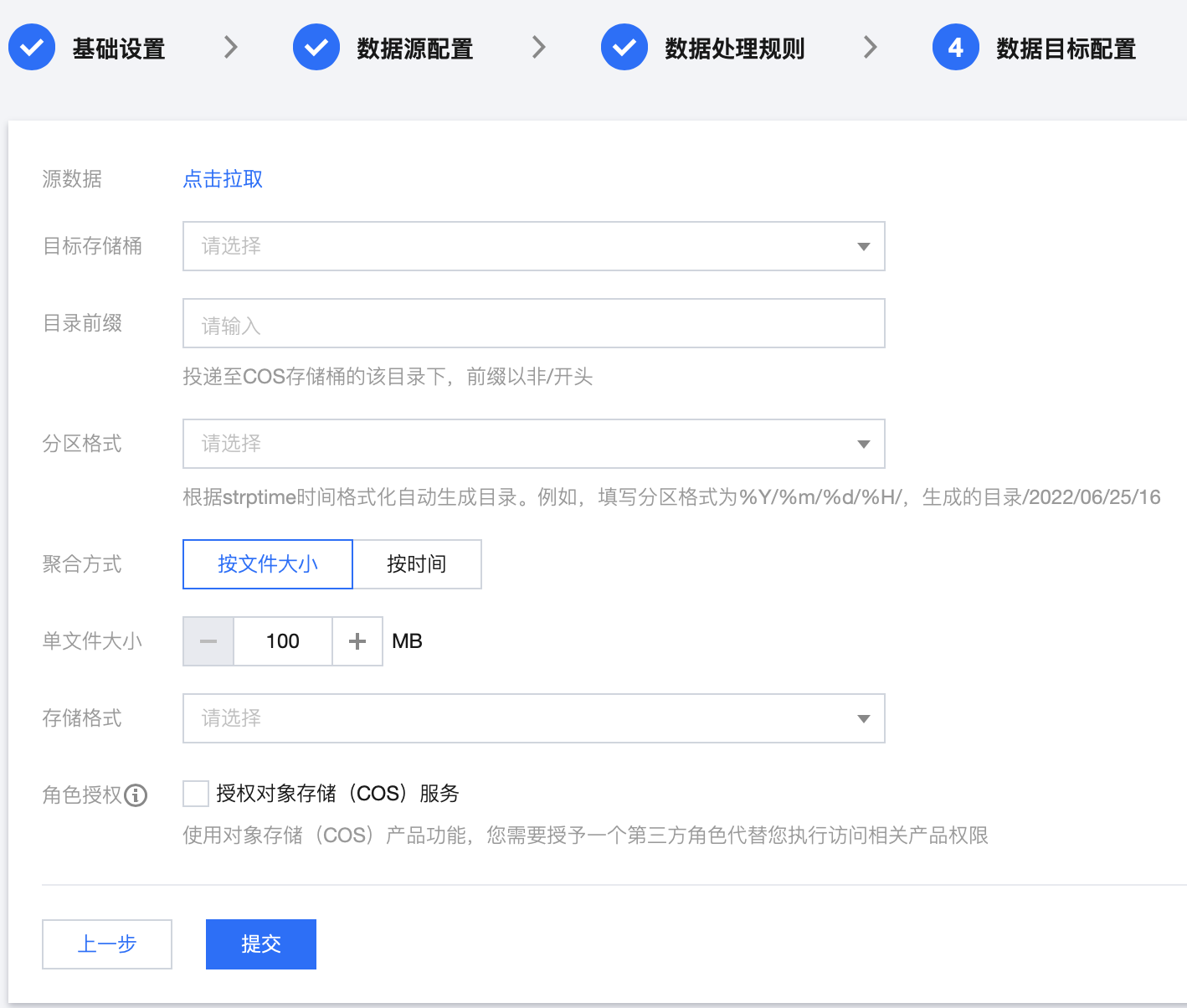

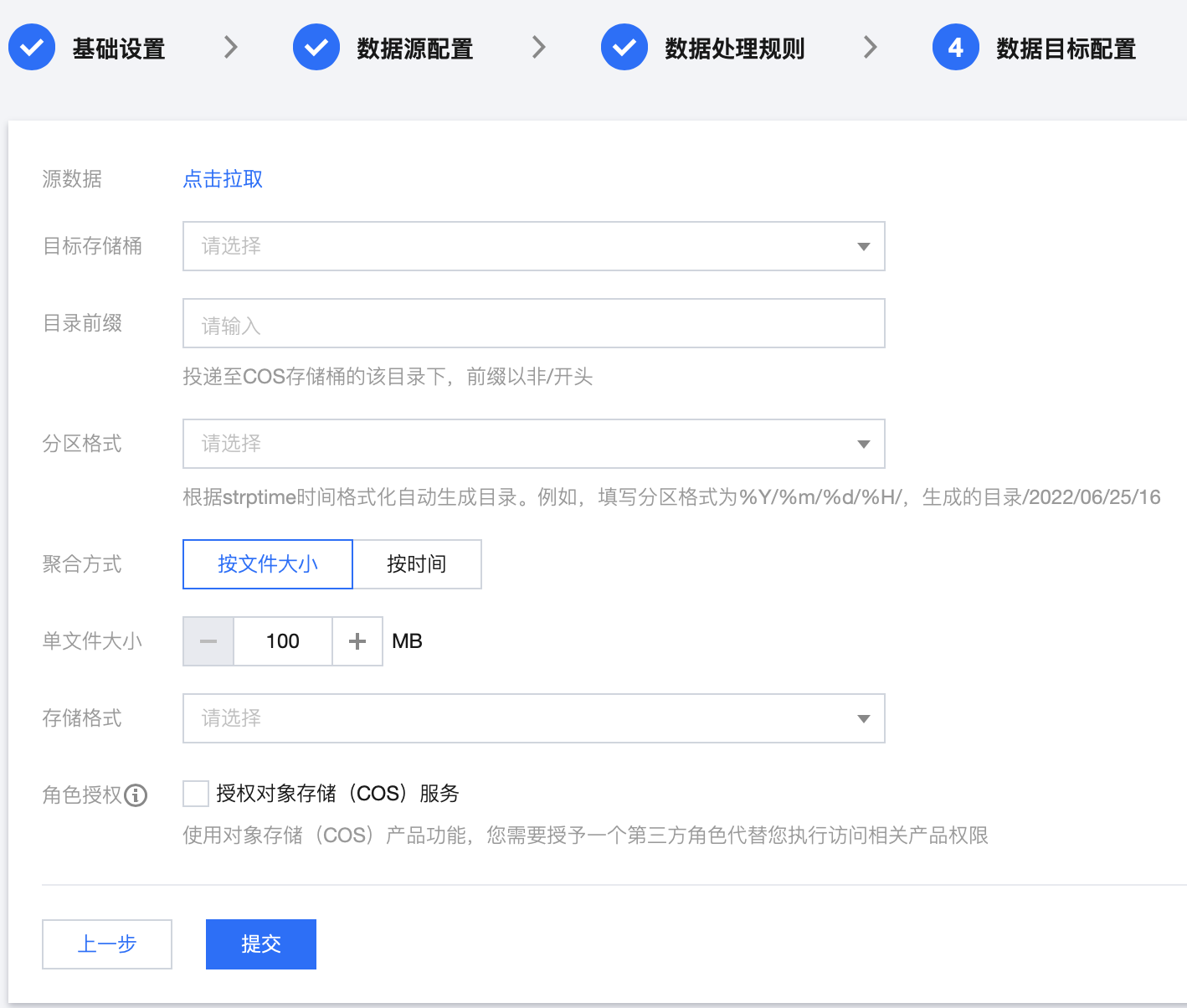

7. 单击下一步,配置数据目标信息。

目标存储桶:选择数据投递的目标存储桶。

目录前缀:支持自定义目录前缀,日志文件会投递至对象存储 Bucket 的该目录下。

分区格式:将投递任务创建时间按照 strftime 的语法自动生成目录 ,其中斜线

/表示一级 COS 目录。

分区格式请按照 strftime 格式 要求填写,不同的分区格式会影响投递到对象存储的文件路径。 以下举例说明分区格式的用法,例如投递至 bucket_test 存储桶,目录前缀为logset/,投递时间 2018/7/31 17:14,则对应的投递文件路径如下:存储桶名称 | 目录前缀 | 分区格式 | COS 文件路径 |

bucket_test | logset/ | %Y/%m/%d | bucket_test:logset/2018/7/31_{random}_{index} |

bucket_test | logset/ | %Y%m%d/%H | bucket_test:logset/20180731/14_{random}_{index} |

bucket_test | logset/ | %Y%m%d/log | bucket_test:logset/20180731/log_{random}_{index} |

聚合方式:

单文件大小:指定在该投递时间间隔中未压缩的投递文件上限,意味着在该时间间隔中,日志文件最大将为您设置的值,超过该上限,将被分成多个日志文件。

按时间:根据消息量的大小,选取汇聚消息的时间间隔,时间间隔为1分钟 - 24小时不等。

存储格式:支持 CSV 和 JSON 格式。

角色授权:使用对象存储(COS)产品功能,您需要授予一个第三方角色代替您执行访问相关产品权限。

8. 单击提交,可以在任务列表看到刚刚创建的任务,在状态栏可以查看任务创建进度。