DeepSeek上架!轻松搞定「开发者」和「企业级」应用

腾讯云震撼上架 DeepSeek 系列模型,限免体验,一键部署即可开启智能之旅。

DeepSeek上架!轻松搞定「开发者」和「企业级」应用

一键部署+限免体验 腾讯云上架DeepSeek系列模型

产品推荐

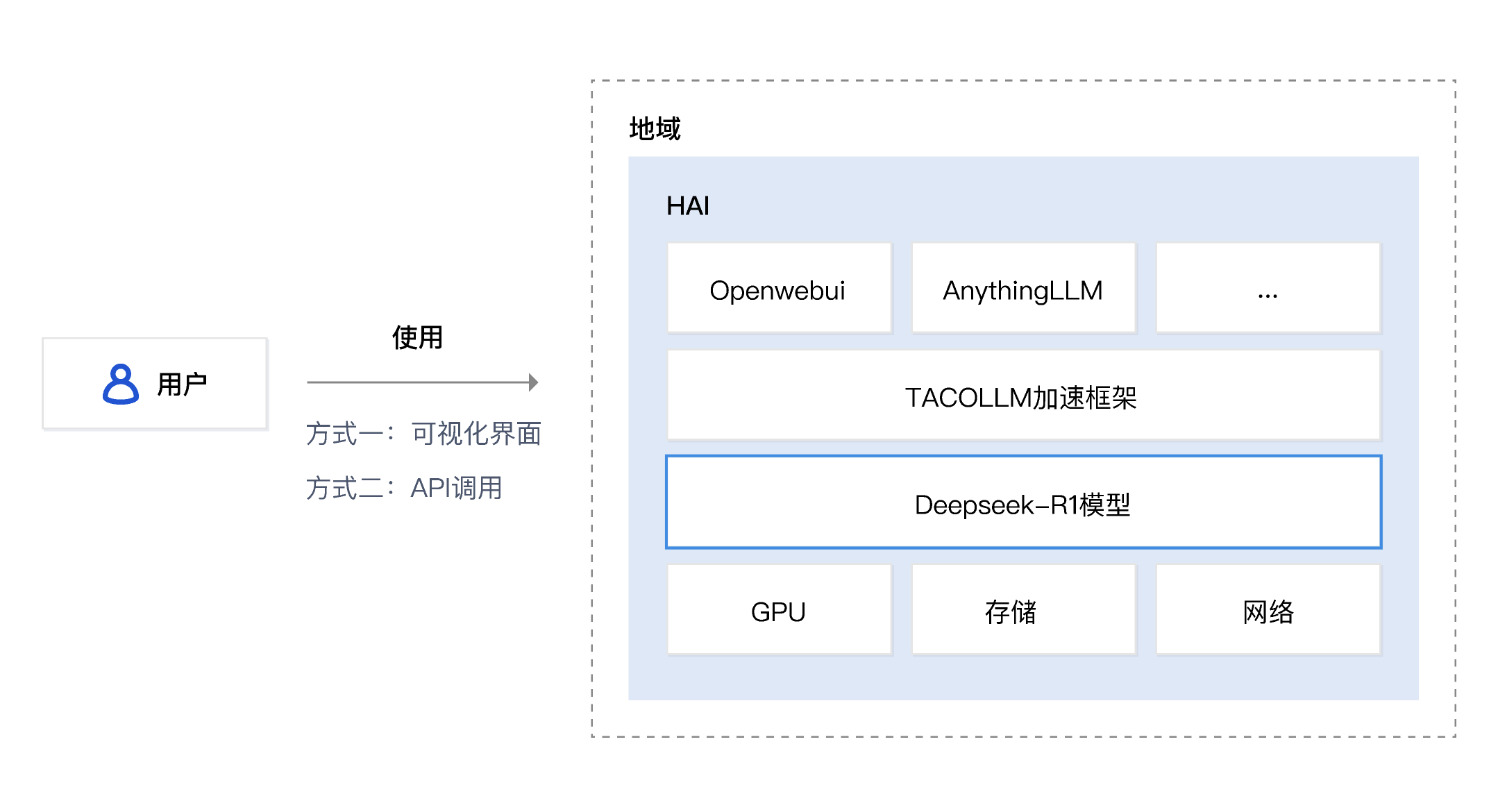

基于 PaaS 部署 DeepSeek-R1 模型

TI平台,提供专属算力、支持全系DS模型、0代码模型部署,模型对话体验、多机分布式部署、私有API自动生成。

适用人群

- 中小企业或者大企业

- 需要自主部署但资源有限

- 需要推理加速、支持并发的用户

部署方案

本方案无须编写代码,可一键部署 DeepSeek 系列模型。在部署V3或R1模型时,如仅需短时体验,对并发/上下文窗口要求不高,可使用单节点部署,部署方式请选择标准部署;其他情况下更推荐多节点部署,部署方式请选择多机分布式部署,节点数至少配置为2个。在部署 1.5B 至 70B 的 DeepSeek 蒸馏版模型时,仅需单节点,部署方式请选择标准部署。

部署时长及费用

- 部署时长:3分钟

隐藏文案

预计费用:按量计费模式下,TI 平台软件订阅费按天结算,具体以账单为准。

-4cf541caee8aad3506d2264bdac5b43fd1c49d62.png)

产品推荐

通过 SaaS 体验 DeepSeek-R1 模型

产品介绍

- 基于 Docker 生态的开源社区,可快速创建开发环境。

体验方式

- Fork 相关代码仓库,在指定分支启动「云原生开发」,输入简单命令即可与DeepSeek互动。

- 支持模型范围:DeepSeek 1.5b、7b、8b、14b、32b、70b、671b

- 免费额度:1600核时/月,相当于一台 8 核 16G 机器,每天使用8小时,连续使用25天。

应用场景:知识引擎结合联网搜索、私域知识,搭建专属应用

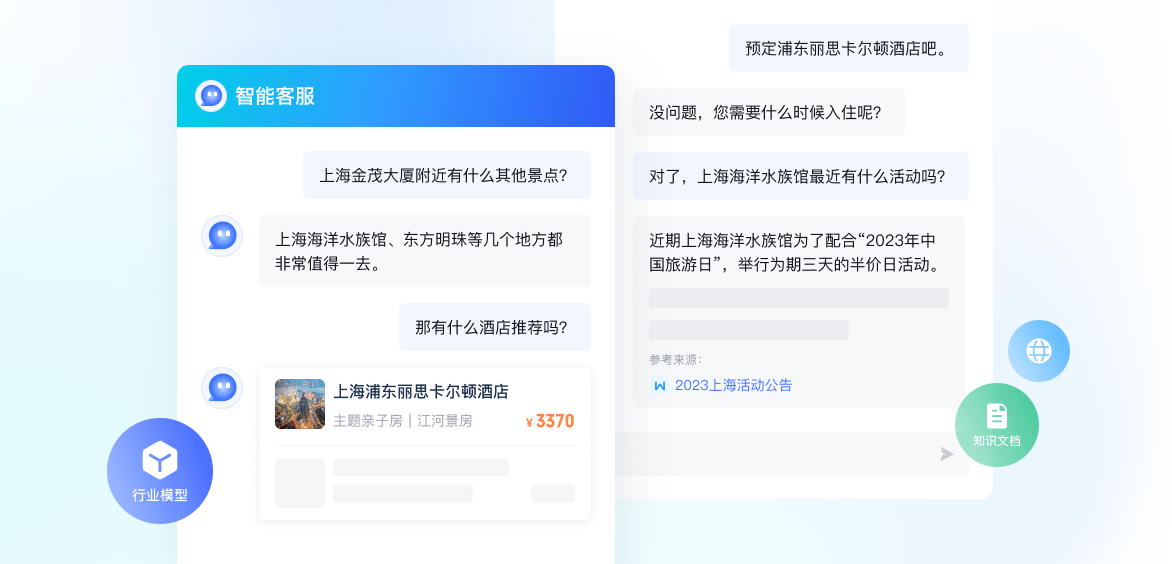

智能客服

- 基于腾讯云行业大模型,通过知识引擎,提供垂直领域的专业化智能客服能力。

- 助力企业及开发者打造场景丰富、功能完善的智能客服解决方案,实现知识生产效率、问题覆盖率、回答准确率跨越式提升。

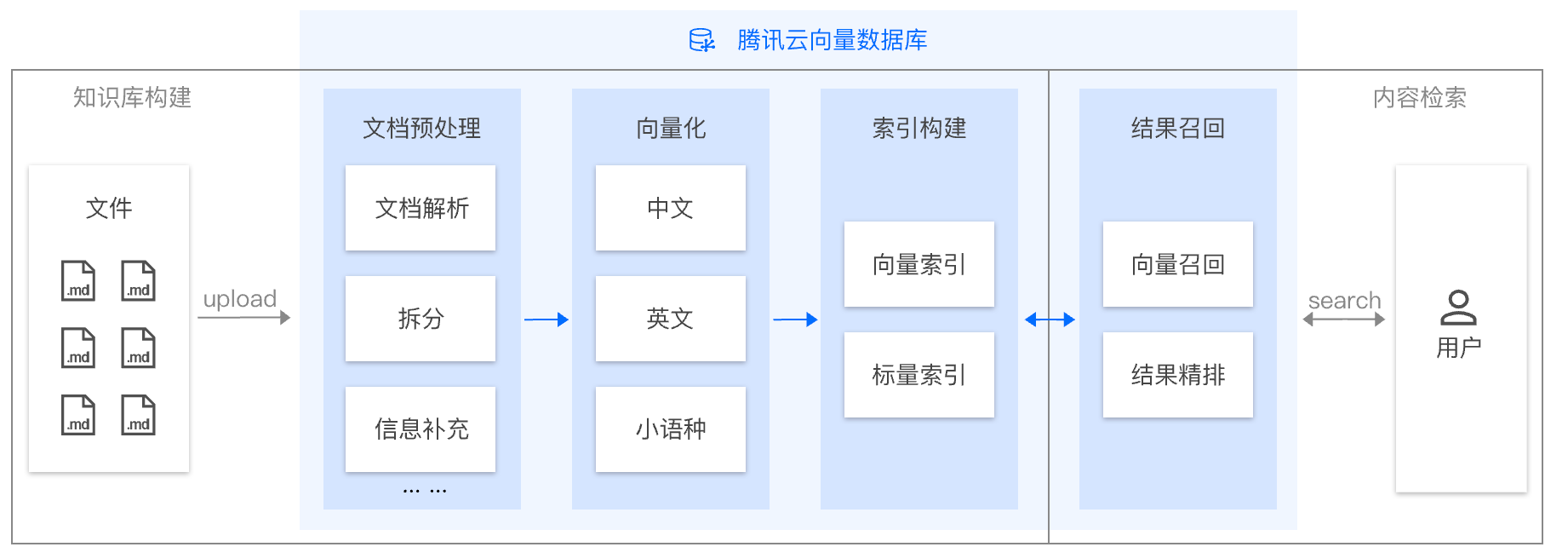

应用场景: 使用向量数据库 / 腾讯云ES,构建高质量国产RAG应用

方案介绍

腾讯云向量数据库作为RAG应用中的核心组件,提供独特的「AI套件」功能,用户仅需上传原始文档即可快速构建知识库,并结合Deepseek模型搭建高质量RAG应用,如:企业内部知识库、内外部智能客服、代码助手…

产品优势

- 「首家」权威认证:国内「首家」获中国信通院认证的企业级自研分布式数据库。

- 内部多年打磨:源自内部OLAMA向量检索引擎,稳定运行于腾讯内部60+个核心业务线,每日支撑超过8500亿次向量检索请求。

- 高性能、低成本:性能领先行业平均水平2倍以上,单QPS成本降低75%,极具性价比。

- 加速业务落地:AI套件提供一站式文档检索解决方案,可快速搭建高质量RAG应用。

-3227451aed20542923f78031ceced39bfbc2db9d.png)

(1)-b00a48655c9f082f9b2d0a221cffbd9e68526e9f.png)