腾讯云AI训练存储场景解决方案

提供高性价比AI训练存储解决方案,提供领先的GPU共享技术和业界唯一的

GPU在离线混部能力,支持物理机、云服务器、容器等产品的计算加速

AI训练存储场景解决方案

支持物理机、云服务器、容器等产品的计算加速

通用AI场景

业务痛点

• AI开发门槛高 :市场亟需机器学习平台产品化,提高模型生产效率

• 资源利用率低:提高模型训练、推理速度难度较高

• 存储性能低: 大规模模型训练对存储的要求非常高

解决方案

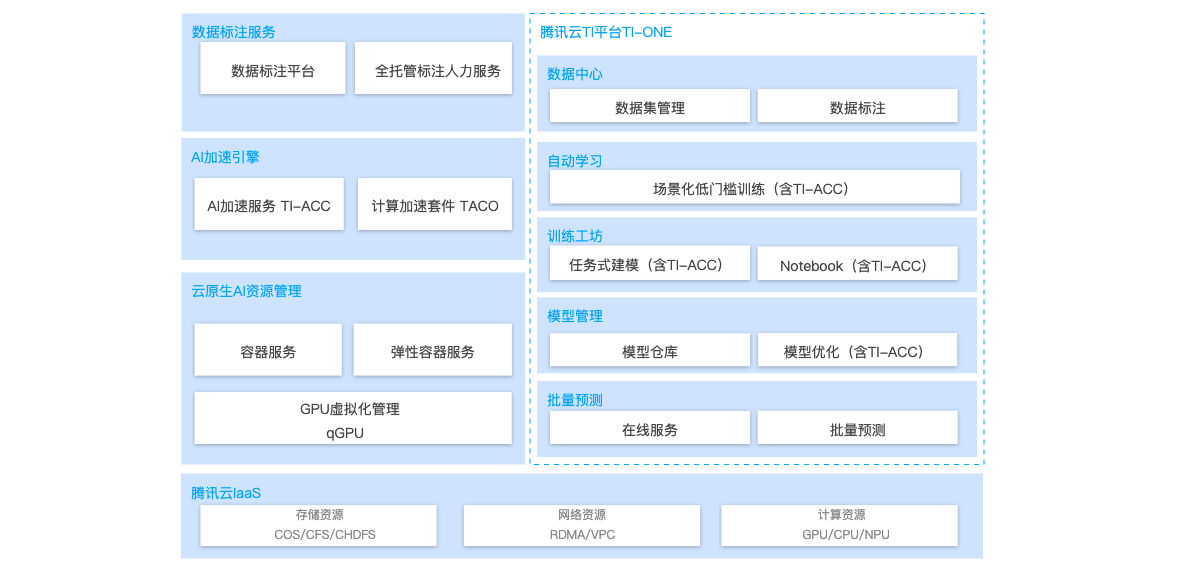

- TI-ONE一站式机器学习平台:基于腾讯先进AI能力和多年技术经验,打通从数据获取、数据处理、算法构建、模型训练、模型评估、模型部署到AI应用开发的全流程链路,实现快速创建和部署AI应用,管理全周期AI。

- AI成本优化解决方案: AI模型训练和推理加速,支持多种框架和场景,显著提高模型训练推理效率。业内领先的GPU虚拟化技术,精细配置 GPU 算力和显存,将GPU 利用率压榨到极致。

- AI存储解决方案:支持大数据文件读取和缓存服务,支持亿级KB小文件、10万级OPS,满足大规模模型的训练要求。

最佳产品推荐

基于实际业务场景,为您精心推荐的爆款产品

TI-ONE一站式机器学习平台

基于腾讯先进 AI 能力和多年技术经验,提供AI模型构建全流程开发的平台工具,解决模型开发效率低,投入周期长的问题。

提高GPU资源利用率

qGPU依托容器服务TKE,可实现对GPU算力与显存的细粒度调度,并支持多容器共享GPU与多容器跨GPU资源分配。

解决模型训练存储和推理的加速

AI模型训练和推理加速,支持多种框架和场景;COS+CFS支持大数据文件读取和缓存服务,支持亿级KB小文件、10万级OPS。

在离线混合部署场景

业务痛点

• 资源利用率低:模型推理过程中GPU利用率低

• 隔离和兼容性差:开源方案资源隔离不精确,兼容性差

• 不支持在离线混布:在线任务不能100%抢占资源,利用率低

解决方案

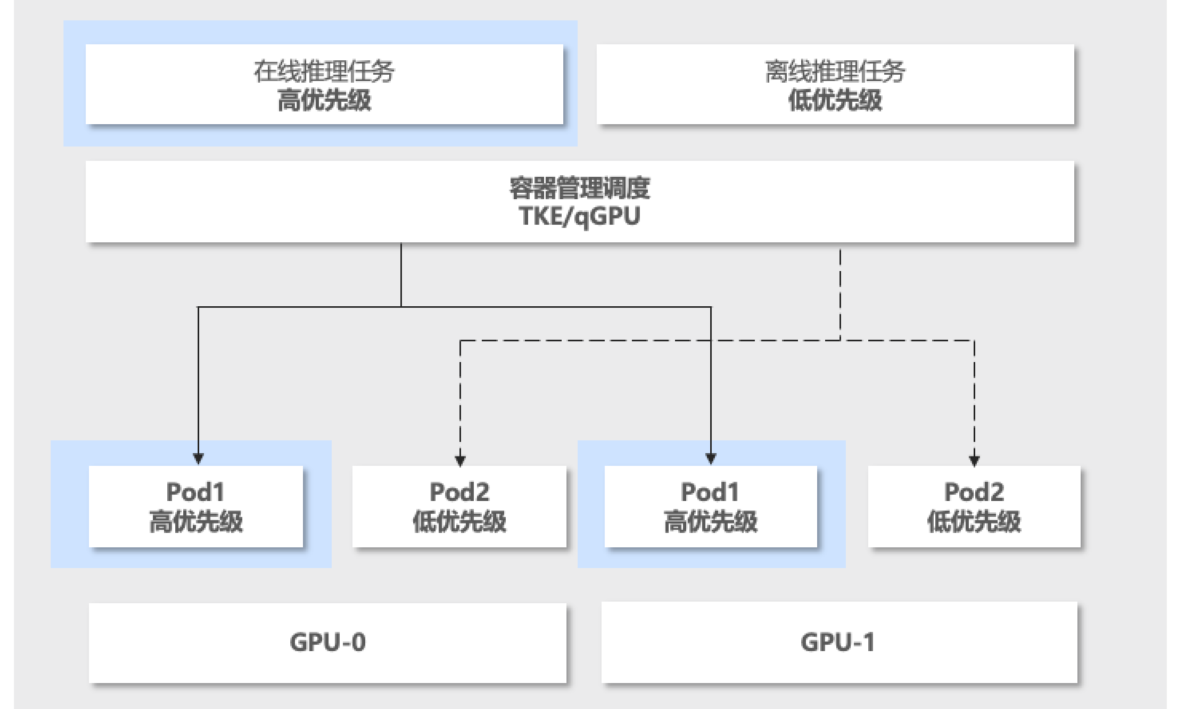

- GPU虚拟化技术:支持多个容器共享 GPU 卡,同一张GPU卡上加载多个模型,保证任务之间良好的隔离性,同时可以提升30%以上的资源利用率。

- 隔离和兼容性:支持容器间算力和显存精细隔离,同时做到故障的严格隔离;对上层业务无感知,不需要重新改动业务。

- 支持在离线混合部署: 支持在线任务100%的资源抢占,业内领先的GPU在离线混和部署技术,使GPU利用率极致提高。

在离线混合部署产品

GPU虚拟化技术支持多容器共享GPU及容器间算力和显存精细隔离,支持在离线混部能力,将GPU利用率压榨到极致

- 同一张GPU卡上支持加载多个模型

- 资源利用率提升30%

- GPU在离线混和部署技术

- 支持在线任务100%资源抢占

开发者首选,DeepSeek部署简单、直观、高效

HAI提供ollama环境,支持1.5B, 7B, 8B, 32B等多个DeepSeek-R1蒸馏模型。查看详情>