腾讯与香港科技大学开源 VideoCrafter 文生视频

原创腾讯与香港科技大学开源 VideoCrafter 文生视频

原创

疯狂的KK

发布于 2024-01-19 17:19:43

发布于 2024-01-19 17:19:43

代码可运行

运行总次数:0

代码可运行

VideoCrafter是一款由腾讯和香港科技大学合作推出的视频生成模型。该模型通过扩散模型来创建和编辑视频,能够从文本描述生成照片和视频。不需要视频编辑或动画经验的人也可以利用VideoCrafter轻松制作专业品质的视频。

该项目提供了两种开放的扩散模型,分别是文本到视频(T2V)和图像到视频(I2V)任务。T2V模型能够生成具有1024576分辨率、逼真且具有电影质量的视频,其质量在同类开源T2V模型中表现优秀。而I2V模型的目标是生成与提供的参考图像内容严格一致的视频,保留其内容、结构和风格。这是第一个能够将给定图像转化为视频剪辑并保持内容保存约束的开源I2V基础模型。

项目地址:

https://github.com/AILab-CVC/VideoCrafter模型下载:

https://pan.quark.cn/s/ab0bdbeb3f8f下载与安装

下载项目

git clone https://github.com/AILab-CVC/VideoCrafter.git安装videocrafter及依赖包

conda create -n videocrafter python=3.8.5

conda activate videocrafter

pip install -r requirements.txt使用步骤

- 创建视频的书面大纲。

- 根据自己的喜好设置视频相关参数,包括分辨率和帧速率。

- 使用“生成”按钮。

- 输入一些文字,VideoCrafter将为您生成视频。

- 生成的视频可以在集成编辑器的帮助下进行修改。

- 在进行调整后,可以将视频保存为多种格式,包括MP4、MOV和AVI。

模型调用

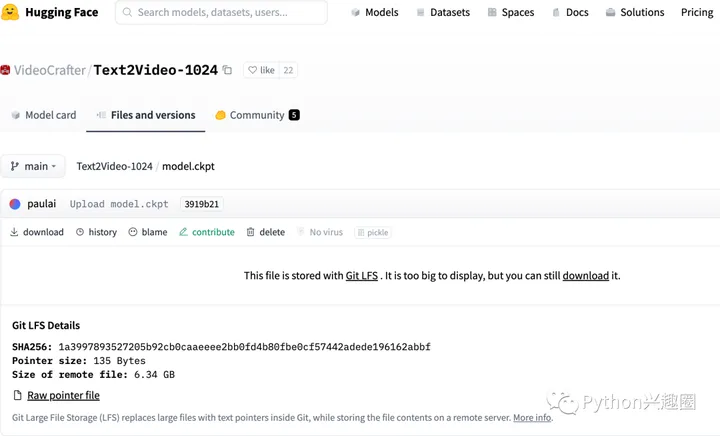

1、通过Hugging Face下载预训练的 T2V 模型,并将其model.ckpt放入checkpoints/base_1024_v1/model.ckpt

2、输入命令

sh scripts/run_text2video.shVideoCrafter的用户友好性使其即使对于从未使用过视频或动画软件的人也可以轻松使用。与商业制作的电影媲美,VideoCrafter的输出质量非常高。无论您想制作解释性视频还是短片,VideoCrafter都能胜任。更重要的是,VideoCrafter是一个免费的开源项目。

原创声明:本文系作者授权腾讯云开发者社区发表,未经许可,不得转载。

如有侵权,请联系 cloudcommunity@tencent.com 删除。

原创声明:本文系作者授权腾讯云开发者社区发表,未经许可,不得转载。

如有侵权,请联系 cloudcommunity@tencent.com 删除。

评论

登录后参与评论

推荐阅读

目录