Step-Video-T2V:全球最强开源视频生成

原创目前阶跃已经成为行业内公认的内卷王之一。其覆盖的领域包含了语音、图片、视频理解和生成等。就在2月中,其就发布了Step-Video-T2V,号称全球最强的开源视频模型。同时一经发布,就已经上线官网,目前所有用户都可以注册进行免费使用,感兴趣的可以来到这个网站进行尝试:

从发布的细节来看,它有以下三个优点:

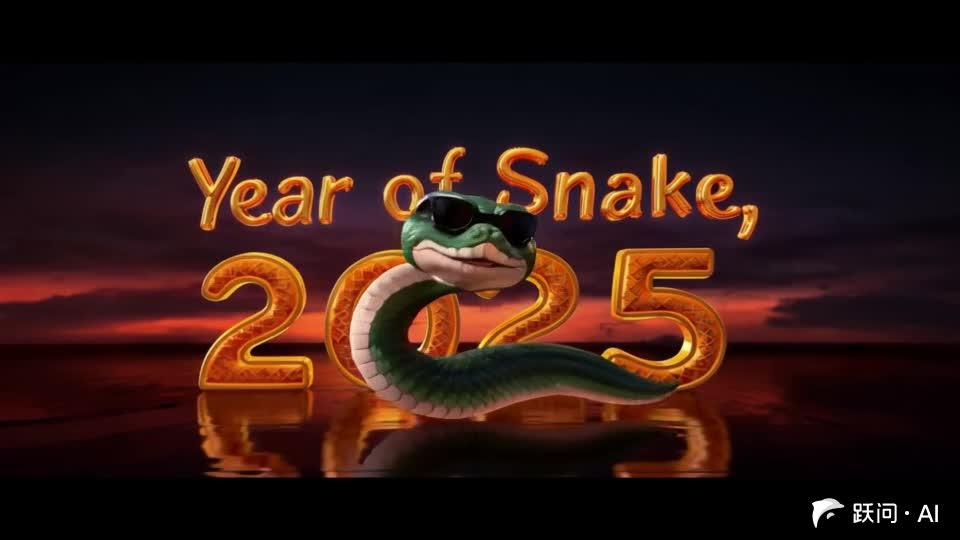

- 领先的文本到视频生成能力:在 运动流畅度、物理合理性、指令遵循性 方面占优。能够生成目前开源模型最长的视频(8s-10s)。比如给定一些特殊的指令,它就能够很好的根据prompt进行生成

采用 3D 动画风格,视频中,慢慢显现出了“Year of Snake, 2025”的字样,天空中绽放出绚烂的烟花。2025字样晶莹剔透泛着金光,地板上反射着它的倒影,背景是黑色的地板。一条卡通蛇戴着一副酷炫的黑色墨镜不断扭动身体,镜片上反射着舞台的灯光。画面采用固定机头,动画风格,展现了蛇年过年喜庆热闹的氛围。

好的标题可以获得更多的推荐及关注者

- 支持中英文文本输入:不仅仅支持英文输入,连中文输入能够很好的hold住

- 生成效果逼真:能够充分理解物理规律。比如“一只狗在水中游泳”,其渐起的水花和狗在水中的姿态都能够很好的模拟出来。

好的标题可以获得更多的推荐及关注者

那么这个模型强大在那里呢?我们可以从其论文中一窥究竟~

1. 技术细节

在公开的技术论文中,首先把目前的视频生成模型划分成两个不同的层级:

- Level-1:翻译级(Translational)视频基础模型:该级别模型能够根据 文本、视觉或多模态输入 生成对应的视频内容,即 跨模态翻译。

- Level-2:可预测(Predictable)视频基础模型:该级别模型可以 预测未来事件,类似 大语言模型(LLM) 对语言推理的作用

层级 | 特点 | 代表模型 | 局限性 |

|---|---|---|---|

Level-1 | - 主要依赖扩散模型(Diffusion-based)- 可处理文本、视觉或多模态输入- 适用于文本到视频、图像到视频、视频风格转换等任务 | Sora, Veo, Kling, Hailuo | - 无法生成复杂动作序列-物理规律建模能力较弱-不具备因果推理能力 |

Level-2 | - 具备因果推理能力- 可以模拟现实世界的物理规律- 适用于长时序预测、推理任务、复杂事件模拟 | 仍在探索阶段,尚未有成熟模型 | - 计算成本高-难以达到 Level-1 级别的生成质量- 仍需突破长时间一致性和复杂推理的难题 |

目前的视频生成模型,大部分都不能够做到生成复杂的一些序列动作,比如像之前Sora这样的模型它对于“体操表演”这种动作也难以控制

而Step-Video-T2V虽然暂时无法达到能够Level-2的水平,但是在视频生成的可控性、物理一致性和长时序建模能力上有一进步的提升。

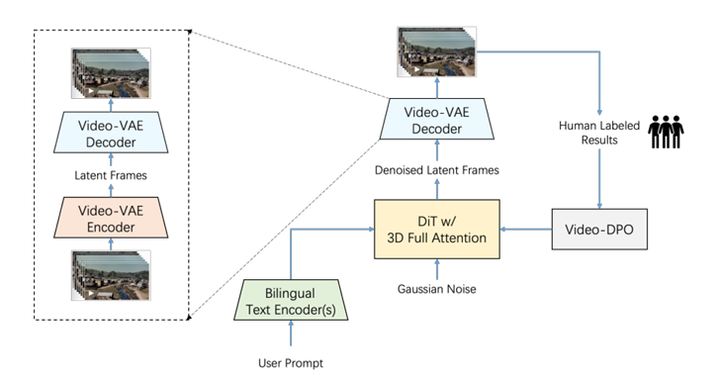

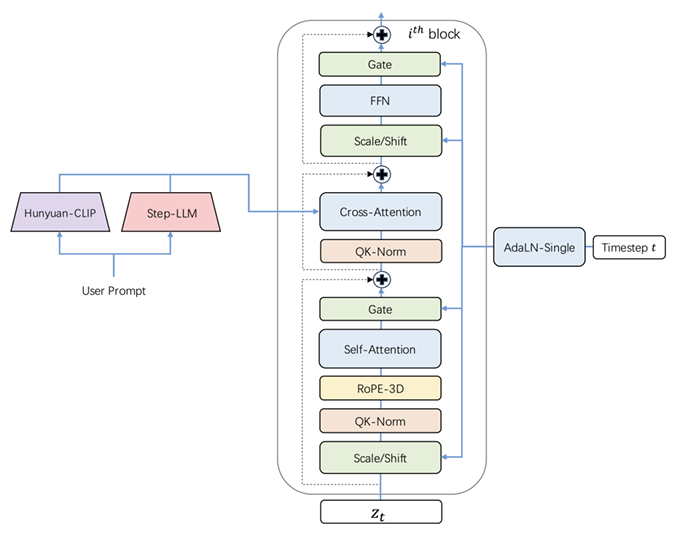

在Step-Video-T2V整体模型架构如下图可以所示

其采用高压缩 Video-VAE(视频变分自编码器)、双语文本编码器、3D 全注意力扩散 Transformer和 基于人类反馈的视频优化(Video-DPO)组合策略,形成一个端到端的文本到视频(T2V)生成框架。

比如当用户的输入prompts由,然后由两个双语预训练文本编码器进行处理,这样的做法是能够原生支持英语和中文。模型采用基于流匹配(Flow Matching)方法训练的 3D 全注意力 DiT(Diffusion Transformer),用于将噪声输入去噪成潜在帧,并结合文本嵌入和时间步长作为条件约束。此外,模型还采用基于人类反馈的视频优化(Video-DPO)方法,以进一步减少伪影(artifacts),确保生成视频更加平滑、真实。

下面我们具体介绍一下每个部分的一些细节

- 高压缩 Video-VAE

在以前的一些视频生成模型里, 像HunyuanVideo和CogVideoX这些,通常采用的是变分自动编码器(VAE)进行空间-时间降采样。这种模型通常将降采样因子设置成为 4×8×8 或 8×8×8。同时为了进一步减少 token 数量,通常使用 Patch 分组技术,将 2×2×1 的潜在 Patch 组合成单独的 token。

尽管这种两阶段的压缩和 token 化方法有效,但它增加了模型架构的复杂性,并可能影响后续扩散阶段的性能。对于基于扩散变换器(diffusion-transformer)的文本到视频生成模型,其效率主要取决于是否能够在压缩的潜在空间中进行操作。由于注意力计算的复杂度随着 token 数量呈二次增长,因此必须通过高效的压缩减少空间-时间冗余,以加速训练和推理,并符合扩散过程本身对紧凑表示的偏好。

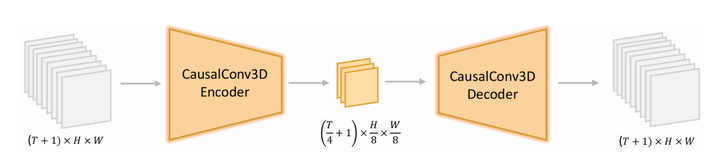

所以阶跃在Step-Video-T2V模型架构上采用了高压缩 Video-VAE(视频变分自编码器)中,利用16×16 空间压缩比 + 8×时间压缩比,将原始视频映射到低维潜在空间,以降低计算成本并提高生成效率。其优点在于,能够在保持高质量视频重建能力的同时,大幅减少数据存储和计算资源需求。

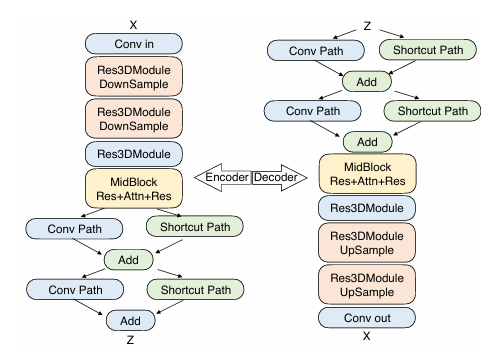

在编码器部分,包含两个Res3DModule和相应的降采样层。随后,MidBlock 结合卷积层与注意力机制,以进一步优化压缩表示。为了支持联合图像与视频建模,同时采用时间因果 3D 卷积

然后还加入了双路径潜在融合(Dual-Path Latent Fusion)方法,通过通道平均(channel averaging)保持低频结构。这种方法允许网络更加高效地利用其参数,从而克服传统 VAE 通常出现的模糊伪影问题。

最后在解码器的过程中,通过在 ResNet 主干网络中,将所有组归一化操作GroupNorm 替换为 空间归一化操作GroupNorm,以避免不同片段之间的时间闪烁问题。

- 双语文本编码器

在传统的视频生成文本编码器中,输入的prompt只能识别单种语言。为了让整体模型学习多种语言的编码。Step-Video-T2V加入了一个双语文本编码器。让模型充分学习到中文和英文的编码输入能力。其采用 Hunyuan-CLIP(视觉对齐) 与 Step-LLM(无长度限制) 两种预训练文本编码器,实现对 中英文提示词 的高效编码。

其中Hunyuan-CLIP:是一个双向 CLIP 模型,主体网络还是采用了Transformer架构,能生成与视觉空间对齐的文本表示,但最大输入长度仅 77 token,处理长文本能力有限。模型在输入的过程中采用的是causal attention,进一步减少了attention的计算量级。这种causal attention,使得整体的模型能够为扩散模型提供更好的文本指导。

而Step-LLM:单向预测模型,无输入长度限制,适用于复杂的长文本。

这样融合的做法,能够使模型能够准确理解和处理不同语言的文本输入,提高跨语言文本到视频生成能力。

- 3D Full Attention(全 3D 注意力)

而为了充分利用文本提示进行视频生成,模型采用了DIT架构和3D Full Attention(全 3D 注意力) 作为核心视频生成模块。自从SORA公布之后,大家都开始发现DIT架构在视频生成中有更强的模型理解能力。因此很多模型都基于DIT架构作为基础。它主要是使用Transformers替换扩散模型中U-Net主干网络。这样做的效果不仅速度更快,而且在不同任务上都取得了很好的效果。

3D全注意力,本质上就是为了能够处理视频而提出来的。它相比于传统的注意力机制,优势在于能够处理所有视频帧,使得时空关系更加紧密,避免出现运动不连续或内容不稳定的问题。

在 Step-Video-T2V 中,全 3D 注意力用于取代传统的 时空注意力(Spatial-Temporal Attention),其核心思想是能够克服传统的 2D 注意力仅在 空间维度(高度 × 宽度) 进行信息传播,不能直接建模 时间信息特点。同时3D 全注意力不仅在 空间维度 建模,也在能够在时间维度(帧序列) 建模,实现真正的时空联合建模。我这里整合了一下不同的attention机制下的不同特点:

意力类型 | 计算方式 | 适用场景 | 优势 |

|---|---|---|---|

空间注意力(2D Attention) | 仅在 (H, W) 计算注意力 | 静态图像生成 | 适用于单帧优化,但无法建模时间信息 |

时空注意力(Spatial-Temporal Attention) | 先计算 (H, W) 再计算 (T) | 短时视频 | 受限于层次化建模,时序一致性不佳 |

3D 全注意力(3D Full Attention) | 在 (T, H, W) 维度同时计算注意力 | 高质量视频生成 | 实现帧间一致性,提高动作流畅性 |

其具体计算方法就是在原来的attention机制上加入一个时间维度T,还包含了传统的一些attention值:Q(查询 Query)、K(键 Key)和V(值 Value)

同时在位置编码上采用了RoPE-3D,用来处理长序列视频,进一步确保长时序视频内容的一致性。

传统的RoPE-1D 仅用于文本数据,而RoPE-3D适用于视频数据,通过旋转变换增强连续性,避免离散位置编码导致的视频不连贯问题

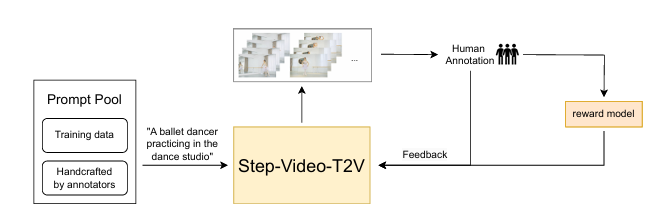

- 基于人类反馈的视频优化(Video-DPO)

这个方法其实优点像OpenAI提出的RLHF(基于人类的反馈强化学习),这个方法本质上也是通过 人工偏好数据 引导模型学习,减少伪影(artifacts)、提升视频流畅性,并增强视频对文本的准确匹配。

DPO(Direct Preference Optimization)是一种无需强化学习的偏好优化方法,最早用于大语言模型(LLM)的对齐训练。例如,在 ChatGPT 的 RLHF 过程中,DPO 通过直接优化偏好排序,而不依赖强化学习中的奖励建模过程。

其核心环节包括了数据收集、偏好优化、训练优化三个。

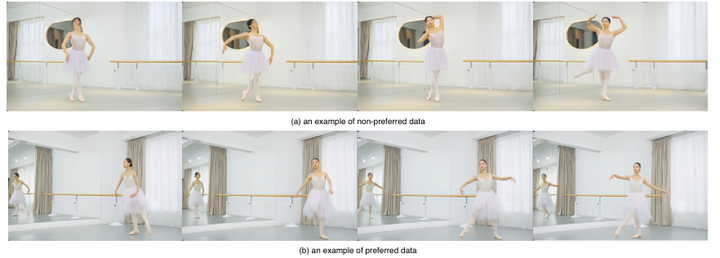

在数据收集阶段,主要是通过多样化的文本提示,利用Step-Video-T2V多次生成,然后让人工进行标注,选择一些更清晰、流畅、无伪影、符合文本描述的视频作为优选样本。比如在下图中,a图的是一个比较好的样本数据。人工同时也会标记质量较低的视频作为反例(non-preferred sample)。

在偏好优化中,使用DPO算法使模型在相同文本提示下,更倾向于生成偏好样本(优质视频),避免生成低质量视频。

而最后在训练过程中,进一步对齐训练数据,同时引入奖励模型强化Step-Video-T2V主模型。这里具体总结了Video-DPO和RLHF方法的一些特点:

对比维度 | Video-DPO | RLHF |

|---|---|---|

优化目标 | 最大化用户偏好的视频概率,同时抑制低质量视频 | 通过强化学习优化奖励模型,引导文本大模型生成符合人类立即额的文本 |

优化方式 | 直接优化模型的生成概率 | 通过 奖励模型 + 策略优化,需要先训练一个奖励模型 |

是否需要奖励模型 | ❌ 不需要,直接使用偏好数据进行优化 | ✅ 需要训练一个奖励模型(Reward Model) |

我们再来看看Step-Video-T2V在不同评测集上的效果。

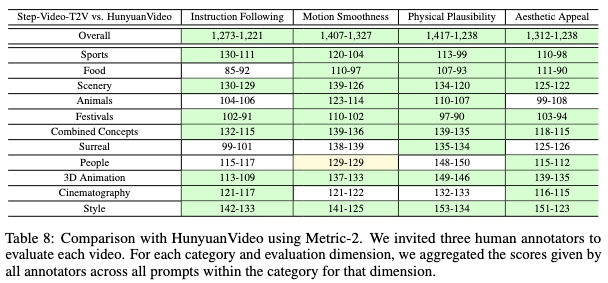

在最新的模型评测榜单中,Step-Video-T2V 在所有类别上超越此前国内开源榜单第一的 HunyuanVideo,特别是在 长时序运动、视觉一致性 方面表现突出

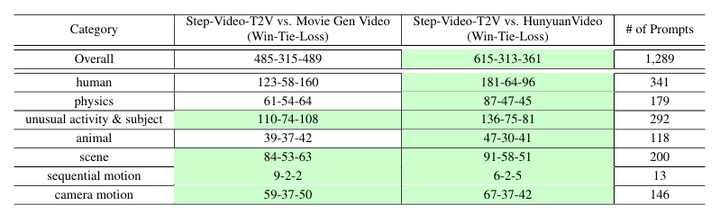

在另一个数据集中Movie Gen Video Bench,是当前文本到视频(T2V)生成任务的一个重要基准。该基准测试包含 1,003 条提示,涵盖多个类别,包括:人类活动、动物、自然景观等。

从上面表格数据可以看出:

- 与 Movie Gen Video 相比,Step-Video-T2V 在多个类别上的表现相当,胜负比几乎持平。

- 相比 HunyuanVideo,Step-Video-T2V 取得了明显优势,尤其在人类活动、特殊活动和物理现象等类别上获胜更多。

原创声明:本文系作者授权腾讯云开发者社区发表,未经许可,不得转载。

如有侵权,请联系 cloudcommunity@tencent.com 删除。

原创声明:本文系作者授权腾讯云开发者社区发表,未经许可,不得转载。

如有侵权,请联系 cloudcommunity@tencent.com 删除。

评论

登录后参与评论

推荐阅读

目录