YashanDB|虚拟内存高出实际内存十几G?原因不只是“占用大”这么简单

原创YashanDB|虚拟内存高出实际内存十几G?原因不只是“占用大”这么简单

原创

【问题分类】资源与性能监控

【关键词】virt 内存、res 内存、glibc、arena 机制、线程池、虚拟内存偏高

背景现象

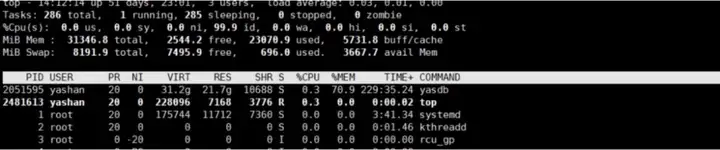

在对 YashanDB 运行状态巡检时,发现以下异常:

虚拟内存(virt)高达 31.2G

实际物理内存占用(res)仅为 21.7G

二者相差近 10G,引发关注

该情况在未运行任何数据库任务时同样存在,初步判断并非实际负载问题。

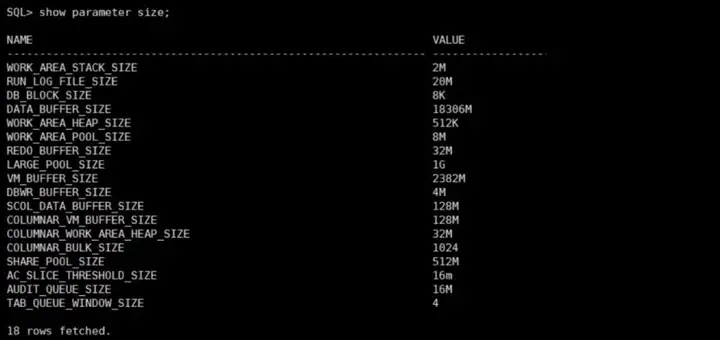

YashanDB 内存配置说明

通过 DBMS_PARAM 高级包生成的默认配置,一般会占用系统总内存的约 80%,主要涉及以下参数:

DATA_BUFFER_SIZE

VM_BUFFER_SIZE

SHARE_POOL_SIZE

LARGE_POOL_SIZE

SCOL_DATA_BUFFER_SIZE

COLUMNAR_VM_BUFFER_SIZE综合计算上述内存块总和为约 22.5G,实际与 RES 读数 21.7G 相符。

那么问题来了:为什么 virt 远大于 res?

根据 Linux 内存机制:

VIRT(虚拟内存):包含程序申请的全部地址空间(包括未实际使用部分),如库映射、代码段、mmap、arena 池、线程栈等

RES(常驻内存):表示真实被加载到物理内存中的部分

所以关键不在于“用了多少”,而在于“申请了多少”。

深层原因分析:glibc Arena 内存池机制

YashanDB 使用的 glibc 分配器默认启用了 Arena 机制,在多线程环境中会导致虚拟内存快速膨胀:

每个 arena 默认 64M

每核最多允许 core × 8 个 arena

比如在 16 核机器上:最多创建 128 个 arena,即最多 8G 虚拟内存

即使线程退出,arena 空间默认不会释放,导致虚拟内存持续偏高

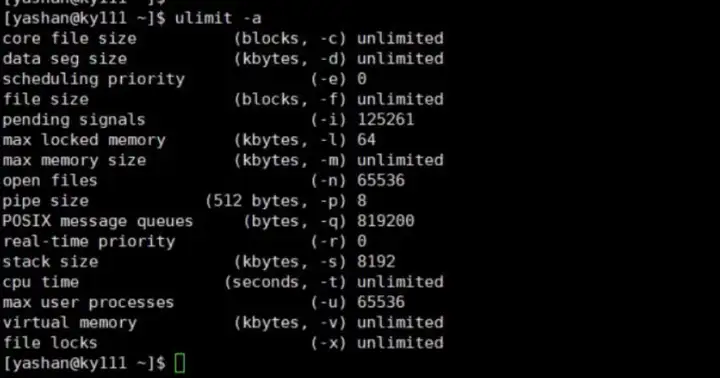

此外,系统还会给每个线程单独分配栈空间(默认 8M),线程数一多,virt 就会进一步拉高。

如何验证问题?

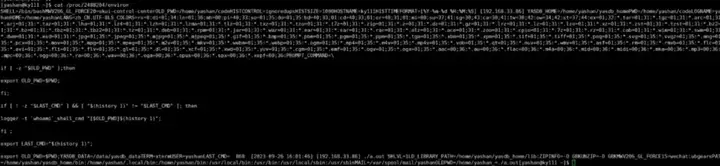

使用系统工具检查:

pmap -p :查看进程详细的内存映射

cat /proc//status:可查看线程数和虚拟内存

ulimit -a:了解默认栈空间配置

cat /proc//environ:可查看 MALLOC_ARENA_MAX 环境变量

测试程序验证表明:

在默认设置下(未限制 arena 数),virt 显著偏高

线程退出后,res 明显下降,但 virt 不变

规避建议:优化内存配置与线程管理

1.限制 arena 数量(减少虚拟内存预分配)

可通过设置环境变量控制:

export MALLOC_ARENA_MAX=42.控制线程栈大小

通过 pthread_attr_setstacksize 降低每线程栈大小(如设为 2M)

使用 pthread_detach() 确保线程退出后资源及时释放

3.结合 ulimit 设置控制默认栈限制

ulimit -s 2048 # 设置默认栈为 2MB总结

虚拟内存高于实际使用,并不意味着“内存泄露”或资源浪费

合理控制 MALLOC_ARENA_MAX 和线程配置,可大幅降低不必要的虚拟内存申请

若系统对内存使用监控较为敏感,建议升级数据库运行环境配置脚本,加入对应限制参数

原创声明:本文系作者授权腾讯云开发者社区发表,未经许可,不得转载。

如有侵权,请联系 cloudcommunity@tencent.com 删除。

原创声明:本文系作者授权腾讯云开发者社区发表,未经许可,不得转载。

如有侵权,请联系 cloudcommunity@tencent.com 删除。