流量大了就加机器?太 Low 了!负载均衡的这些高级玩法,让你部署、测试、安全一步到位!

原创流量大了就加机器?太 Low 了!负载均衡的这些高级玩法,让你部署、测试、安全一步到位!

原创

老码小张

发布于 2025-04-29 10:25:35

发布于 2025-04-29 10:25:35

嘿,各位小伙伴,我是老码小张。

咱们做开发的,特别是刚开始接触后端服务的同学,可能经常遇到这样的场景:用户量一上来,应用响应变慢甚至卡死,老板在后面催,用户在群里骂,咋办?最直接的想法是不是“加机器”?没错,加机器是能解决一部分问题,但这就像头痛医头脚痛医脚,不够优雅,成本也高。

你有没有想过,那些大厂动辄百万、千万 QPS 的系统,是怎么做到丝般顺滑,还能悄无声息地发布新功能、做各种 A/B 测试的?难道他们就是无限堆机器吗?

其实,这里面有个关键角色经常被我们忽视,或者说,我们只用了它最基础的功能,那就是负载均衡器 (Load Balancer)。很多人以为负载均衡就是简单地把流量分发到不同的服务器上,搞个轮询就完事了。如果你也这么想,那可就太小看它了!

今天,咱们就来深挖一下,负载均衡器除了扛流量,还能玩出哪些让你“卧槽”的高级操作,掌握了这些,你也能在部署、测试、安全方面秀翻全场!

首先,别只知道轮询了!负载均衡的基础分发策略得知道

这部分算是基础课,但很重要。负载均衡的核心职责当然是分发流量,避免单点故障,提高系统整体可用性和处理能力。常见的策略有:

- 1. 轮询 (Round Robin): 最简单粗暴,像发扑克牌一样,一人一张,请求依次分给后端服务器。优点是简单,缺点是不考虑服务器当前的负载压力。

- 2. 最少连接 (Least Connections): 稍微智能一点,谁的活少(当前处理的连接数少),新来的请求就交给谁。比较适合请求处理时间长短不一的场景。

- 3. IP 哈希 (IP Hash): 根据请求来源的 IP 地址计算哈希值,然后分发到固定的服务器。这种方式可以保证同一个用户的请求总是落到同一台服务器上,对需要保持会话状态的应用有点用(但有更好的方式,后面会讲)。

- 4. 加权轮询/加权最少连接 (Weighted...): 给不同配置的服务器设置不同的权重,性能好的多分点,性能差的少分点。

这些基础策略是负载均衡的基本功,但真正让它发光发热的,是下面这些进阶玩法。

骚操作一:零停机发布?蓝绿部署 & 金丝雀发布安排上!

每次上线新版本是不是都心惊胆战,生怕搞挂了服务?负载均衡器能帮你实现平滑发布,用户几乎无感知。

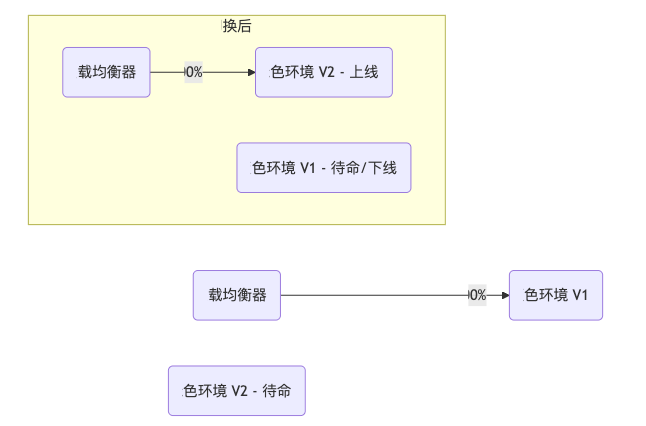

- • 蓝绿部署 (Blue-Green Deployment)简单说,就是搞两套一模一样的环境:一套“蓝色”环境跑着当前线上版本 V1,一套“绿色”环境部署新版本 V2。部署 V2 时,所有流量先进蓝色环境。等 V2 在绿色环境部署测试没问题了,直接在负载均衡器上动动手指,把所有流量“咔嚓”一下切到绿色环境。绿色环境就变成新的线上环境了。如果 V2 有问题,同样在 LB 上一切,流量瞬间回到蓝色环境 V1。

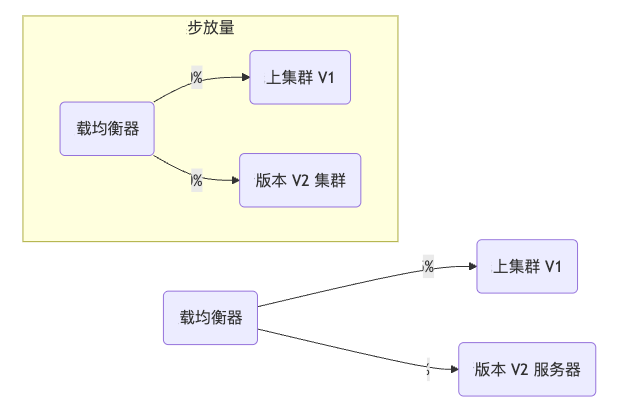

- • 金丝雀发布 (Canary Release)蓝绿部署是一刀切,风险还是有点大。金丝雀发布就更稳妥了。名字来源于以前矿工用金丝雀探测矿井瓦斯,鸟没事人才安全。发布新版本 V2 时,先让负载均衡器把一小部分流量(比如 1% 或 5%)导入到部署了 V2 的服务器上,其他 95% 的流量还走 V1。观察这一小部分用户的反馈和系统指标,如果一切正常,逐步加大 V2 的流量比例,直到 100% 替换掉 V1。有问题?立刻把流量切回 V1,影响范围很小。

蓝绿 vs 金丝雀怎么选?

特性 | 蓝绿部署 | 金丝雀发布 |

|---|---|---|

切换方式 | 瞬间全量切换 | 逐步按比例切换 |

风险 | 相对较高(新版本问题影响所有用户) | 较低(问题只影响少量用户) |

回滚速度 | 非常快(直接切回旧环境) | 快(调整流量比例即可) |

资源需求 | 需要双倍资源(短时间) | 只需要少量额外资源(新版本机器) |

复杂度 | 相对简单 | 稍微复杂(需要精细流量控制) |

适合场景 | 对发布中断容忍度低、需要快速回滚 | 需要控制风险、观察新版本表现 |

骚操作二:A/B 测试?让 LB 帮你偷偷做实验

想知道新设计的按钮用户更喜欢点哪个?或者某个算法优化效果如何?A/B 测试是常用的手段。负载均衡器(特别是 L7 负载均衡器,能看到 HTTP 报文内容)就能帮你实现:

你可以配置规则,让 LB 根据用户的某些特征(比如 User-Agent、请求头里的特定标记、Cookie、用户 ID 范围等)把他们导向不同的后端服务集群,这些集群可能运行着不同界面或逻辑的版本。

比如,用 Nginx 实现一个简单的基于 Cookie 的 A/B 测试分流:

http {

# 定义 A 和 B 两个后端集群

upstream backend_A {

server server_A1;

server server_A2;

}

upstream backend_B {

server server_B1;

server server_B2;

}

# 根据 cookie 'version' 的值来决定路由

map $cookie_version $backend_choice {

default backend_A; # 默认或没有 cookie 去 A

"B" backend_B; # cookie version=B 去 B

}

server {

listen 80;

location / {

# 将请求代理到 map 指令选择的后端

proxy_pass http://$backend_choice;

# ... 其他配置

}

}

}这样,你就可以给一部分用户设置 version=B 的 Cookie,让他们体验新版本,收集数据做对比了。

骚操作三:你的服务挂了吗?健康检查来把关!

只管分发不管死活可不行。负载均衡器会定期检查后端服务器是不是还“活着”,能不能正常处理请求。这就是健康检查 (Health Checks)。

它可以是简单的 PING,也可以是尝试建立 TCP 连接,或者发送一个 HTTP 请求(比如访问 /health 接口)并检查返回的状态码或内容。

如果一台服务器连续几次健康检查失败,LB 就会把它从可用服务器列表里踢出去,不再给它发流量,直到它恢复正常并通过检查。这对于保障服务高可用至关重要!

实践小提示: 健康检查的接口 /health 应该尽量轻量,快速返回,不要涉及复杂的业务逻辑或数据库查询,避免健康检查本身拖垮服务器。

骚操作四:SSL 证书太麻烦?交给 LB 做 SSL 终止!

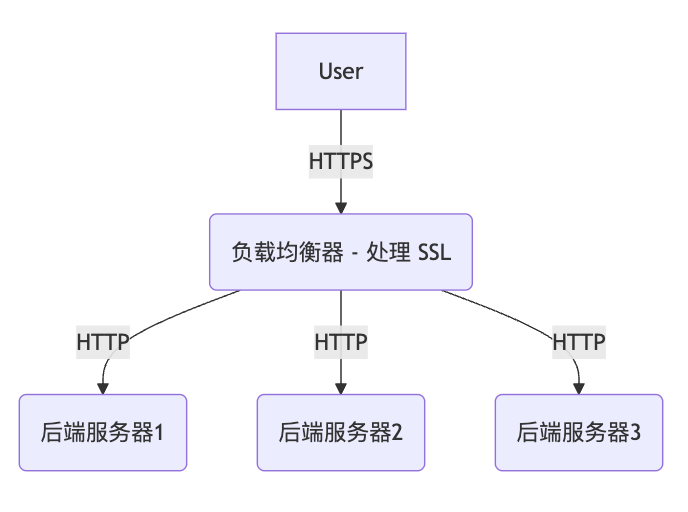

HTTPS 现在是标配了。但每个后端服务器都配置 SSL 证书、处理加解密,挺麻烦的,也消耗 CPU 资源。

可以让负载均衡器来做SSL 终止 (SSL Termination)。就是说,用户的 HTTPS 请求到达 LB 后,LB 负责解密,然后用普通的 HTTP 把请求转发给内部的后端服务器。后端服务器就不用管 SSL 的事了,美滋滋。

好处:

- 1. 简化后端配置: 后端服务器不用配证书了。

- 2. 减轻后端负担: 加解密是 CPU 密集型操作,让专门的 LB(或硬件 LB)处理效率更高。

- 3. 集中管理证书: 所有证书都在 LB 上管理,更新、吊销都方便。

注意点: LB 和后端服务器之间是明文 HTTP 通信,所以要确保这段内部网络是安全的、可信的。

骚操作五:用户会话丢失?试试粘性会话!

有些老应用可能把用户的会话信息(比如购物车)存在单台服务器的内存里。如果用了负载均衡,用户的第一个请求到了服务器 A,第二个请求可能就被分到服务器 B 了,那存在 A 的会话信息就丢了!

这时候可以用粘性会话 (Sticky Sessions),也叫会话保持。LB 会想办法让同一个用户的后续请求,尽量落到第一次处理他请求的那台服务器上。实现方式通常是基于 Cookie(LB 插入一个特殊的 Cookie)或者源 IP 地址(就是前面说的 IP Hash)。

优点: 简单粗暴解决老应用的会话问题。 缺点:

- 1. 可能破坏负载均衡: 如果某个用户请求特别多,或者某个服务器粘住了很多用户,会导致负载不均。

- 2. 后端服务器故障问题: 如果粘住用户的服务器挂了,用户的会话还是会丢失(除非有会话复制机制)。

更好的实践: 尽量设计无状态的应用,把会话信息存到外部存储(如 Redis、Memcached)或数据库里,这样任何一台服务器都能处理用户请求,这才是更现代、更具扩展性的做法。粘性会话更多是作为一种兼容手段。

骚操作六:WAF、DDoS 防护?LB 也能出一份力!

很多现代负载均衡器(特别是商业产品或云厂商提供的 LB)集成了 Web 应用防火墙 (WAF) 功能,可以在流量到达你的应用服务器之前,就过滤掉常见的 Web 攻击,比如 SQL 注入、XSS 攻击等。

同时,负载均衡器作为流量入口,也是抵御 DDoS 攻击的第一道防线。它可以识别和丢弃异常流量,或者配合专门的 DDoS 清洗服务一起工作。

看到这里,是不是觉得以前对负载均衡的认识有点“图样图森破”了?它不仅仅是个流量调度员,更像是个集发布总管、测试助手、安全门卫、性能优化师于一身的多面手!

当然,负载均衡器本身也有不同类型(比如软件的 Nginx、HAProxy,硬件的 F5,云厂商的 ELB/ALB/NLB;还有工作在网络第四层 OSI 模型的 L4 LB 和工作在第七层应用层的 L7 LB),它们的能力和侧重点也不同。L7 LB 因为能理解 HTTP 协议,所以能玩出更多上面提到的高级花样。

选择哪种 LB,用哪些高级功能,取决于你的具体业务场景、技术栈和团队能力。但理解了这些原理和可能性,下次再遇到流量、发布、测试的问题时,你就能多一个强大的武器库来选择了!

希望今天聊的这些对你有启发。

我是老码小张,一个喜欢研究技术原理,并且在实践中不断成长的技术人。希望这篇文章对你有帮助,也欢迎大家留言交流你的看法!

原创声明:本文系作者授权腾讯云开发者社区发表,未经许可,不得转载。

如有侵权,请联系 cloudcommunity@tencent.com 删除。

原创声明:本文系作者授权腾讯云开发者社区发表,未经许可,不得转载。

如有侵权,请联系 cloudcommunity@tencent.com 删除。

评论

登录后参与评论

推荐阅读

目录