LLama4 原生多模态大模型

原创Meta最新发布了原生多模态大模型 Llama 4,一经亮相即登上LMSYS大模型排行榜第二名,仅次于Google的Gemini-2.5-pro,分差仅为22分,实力可见一斑。

此次发布的Llama 4系列共有三个版本,分别命名为Behemoth、Maverick和Scout,我们可以通俗地称之为超大杯、大杯和标准版。其中,Maverick(大杯)和Scout(标准版)已正式开源,用户可在Meta官网及HuggingFace平台下载。

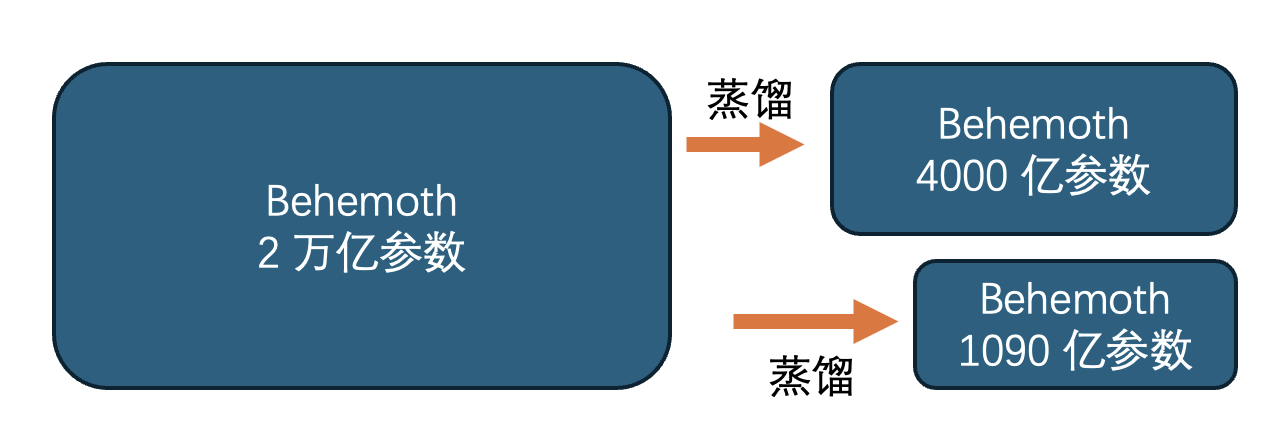

三个模型的关系如下图所示,Maverick和Scout均为从超大杯Behemoth模型上蒸馏而来。

三个模型的具体参数和特点:

1. Llama 4 Scout(标准版):

- 参数规模:170亿活跃参数,总计1090亿。

- 架构特点:MoE(混合专家)架构,共16个专家,每次推理激活2个。

- 上下文窗口:支持长达1000万标记的长序列任务。

- 硬件要求:单个NVIDIA H100 GPU即可运行,适合资源受限的应用场景。

2. Llama 4 Maverick(大杯):

- 参数规模:同样为170亿活跃参数,但总参数量达4000亿。

- 架构特点:128个专家MoE架构,每次推理激活17个专家。

- 上下文窗口:支持长达1000万标记的复杂任务处理。

- 硬件要求:需多GPU联合运行,适用于计算资源丰富的环境。

3. Llama 4 Behemoth(超大杯):

- 参数规模:活跃参数2880亿,总参数量接近2万亿。

- 架构特点:MoE架构,包含16个专家模型。

- 开发状态:目前仍在训练阶段,未公开发布。

- 应用场景:面向科学研究、高级数据分析等高计算复杂推理任务。

三个模型共同的技术特色:

- MoE混合专家架构:仅激活部分参数,大幅提升计算效率。

- 多模态能力:整合文本、图像与视频数据,实现跨模态任务处理。

在模型规模方面,Llama 4系列的确非常庞大,尤其是Behemoth模型,远超业内主流,例如DeepSeek R1参数量仅为6710亿,只有Behemoth的约三分之一。当前行业趋势多偏向小而高效的模型,Llama 4如此庞大的规模实属少见。

性能及价格表现

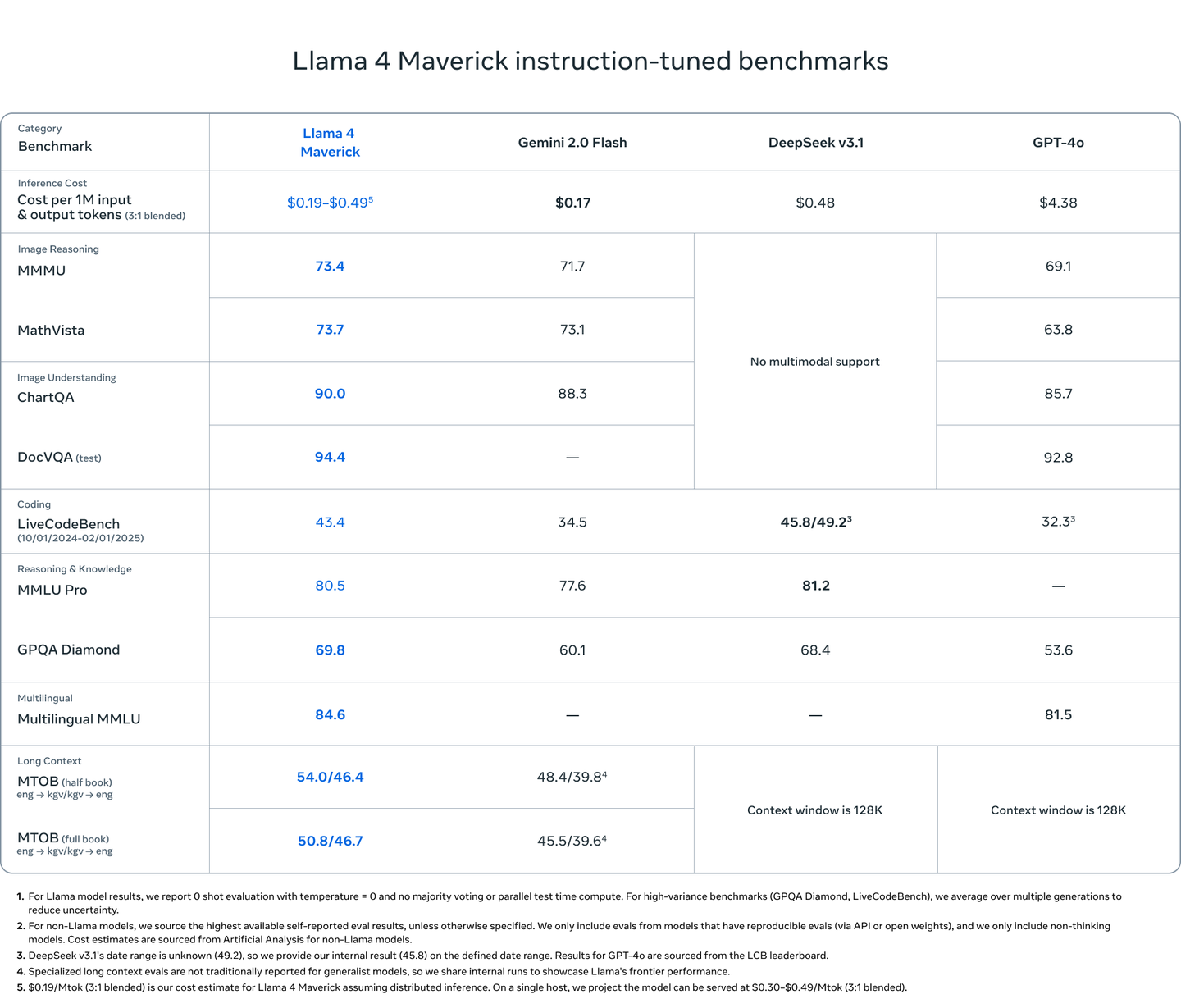

从官方对比来看,在每1M输入输出tokens的价格上,Llama 4 Maverick约为0.19-0.49美元,比DeepSeek v3略便宜,更远低于GPT-4o。

具体表现如下:

- 图像推理任务:Llama 4 Maverick表现突出,尤其在复杂图像理解任务(MMMU)得分高达73.4,视觉数学任务(MathVista)得分为73.7,均领先于Gemini 2.0(73.1)和GPT-4o(63.8)。

- 编程任务:DeepSeek略胜一筹,但Maverick的表现依旧远超GPT-4o。

模型在编码任务中的表现,体现出良好的长序列预测能力,随着序列位置增加,预测的不确定性逐渐降低并趋于稳定,这反映了模型对上下文信息的良好利用。

模型测试案例评估

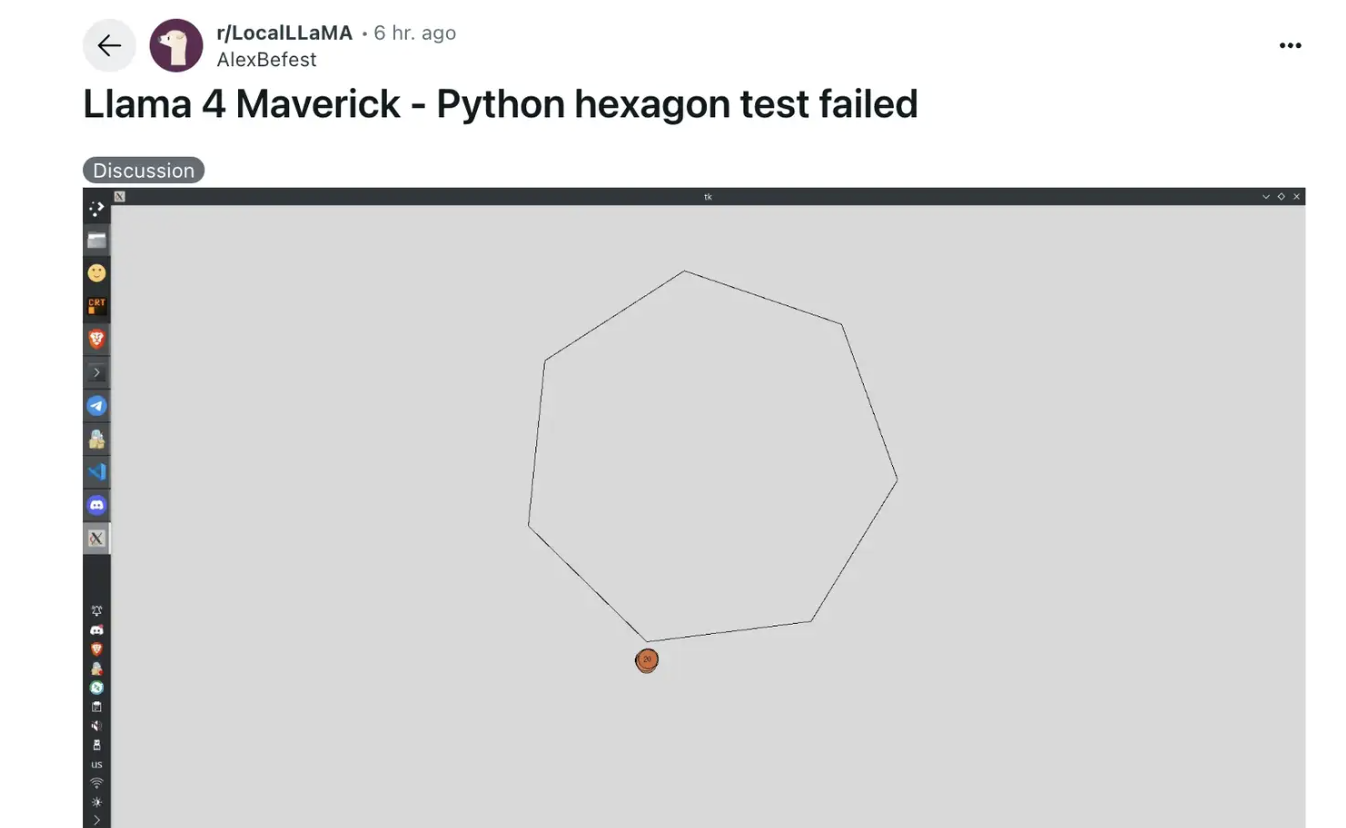

- 案例一:六边形内小球碰撞实验 Maverick在8次请求后才成功,而DeepSeek R1和Gemini 2.5 Pro仅一次请求即成功,表明Maverick的逻辑推理仍需优化。

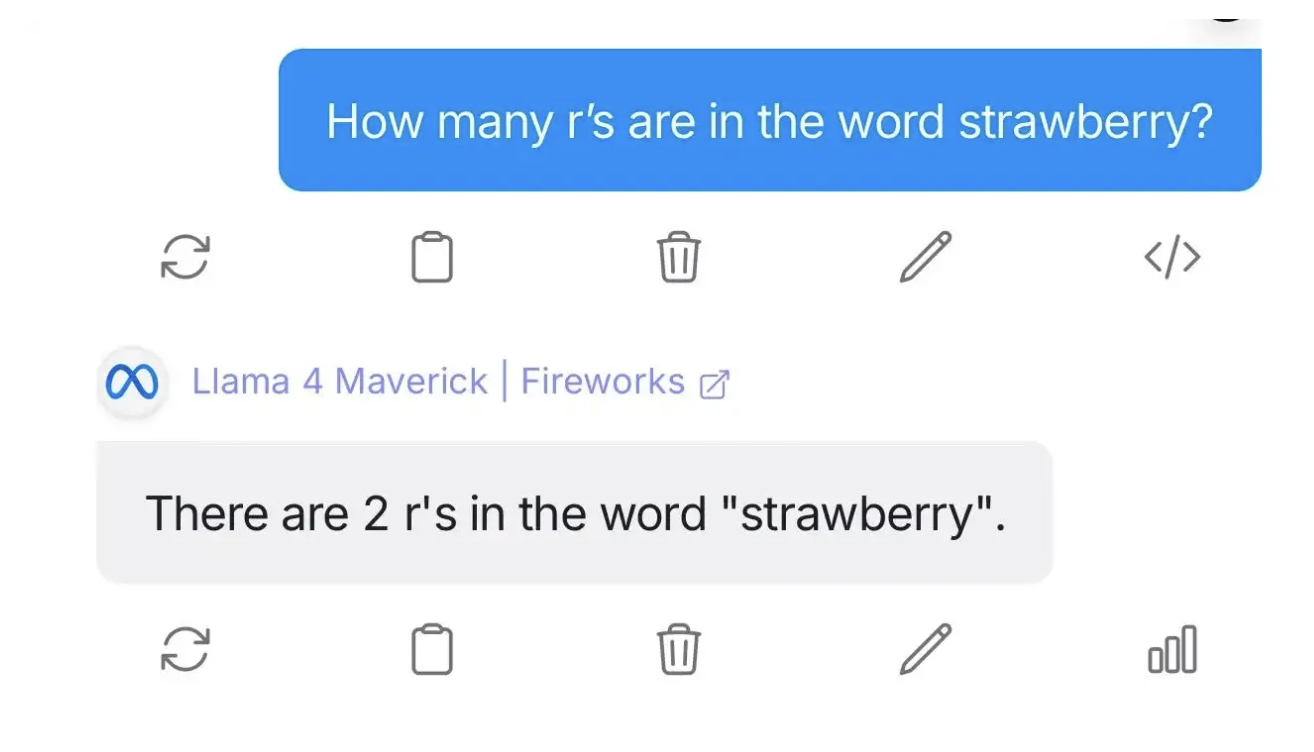

- 案例二:统计"strawberry"中的"r"数量 Maverick错误地回答为2个,表明在细致语言推理方面表现一般。

- 案例三:生成UI代码测试 Maverick未能准确识别实际需求,表明其任务理解与代码生成能力仍有提升空间。

技术细节与训练策略

Llama 4采用了先进的早期融合(early fusion)机制,将文本和视觉token统一集成至模型主干架构,实现了真正的多模态统一训练。视觉部分采用MetaCLIP编码器,与冻结的Llama主模型协同优化。

后训练阶段,Maverick采用了三阶段训练策略:轻量监督微调(SFT)专注难度较高的数据;在线强化学习(RL)提升中高难度提示下的推理能力;轻量偏好优化(DPO)用于提升边缘任务表现。

总结与展望

Llama 4的发布,意味着Meta正式进入原生多模态大模型竞争核心领域。相比Gemini系列、GPT-4o、Claude 3、DeepSeek等主流模型,Llama 4以务实高效的技术路线,突出计算成本、推理效率与多模态能力的平衡。

尤其Maverick模型凭借创新的128专家MoE架构和FP8精度训练,在性能与成本控制方面展现了显著优势。但在精细逻辑推理任务上,Llama 4仍需进一步优化。

总体而言,Llama 4代表了一次平衡创新与实用的成功探索,不盲目追求规模而是注重技术设计的科学性与实际落地能力,未来发展值得期待。

原创声明:本文系作者授权腾讯云开发者社区发表,未经许可,不得转载。

如有侵权,请联系 cloudcommunity@tencent.com 删除。

原创声明:本文系作者授权腾讯云开发者社区发表,未经许可,不得转载。

如有侵权,请联系 cloudcommunity@tencent.com 删除。