错过它=落伍!只用一张照片+14秒,腾讯开源 HunyuanVideo-Avatar 带你玩转多角色数字人

原创错过它=落伍!只用一张照片+14秒,腾讯开源 HunyuanVideo-Avatar 带你玩转多角色数字人

原创

嗨,大家好,我是小华同学,关注我们获得“最新、最全、最优质”开源项目和高效工作学习方法

项目简介 HunyuanVideo-Avatar 是腾讯混元团队最新开放的多模态数字人生成模型:上传一张人物(真人、卡通或 3D 角色)图片,再配上一段音频,模型即可在约 14 秒内输出分辨率最高 720 p、情绪可控、动作丰富且支持多角色同屏的短视频。

为什么值得收藏?

- 全开源:权重 + 推理脚本 + LoRA 微调示例一站式放出,社区二开门槛极低。([Hugging Face][2])

- 一键上手:官方提供单卡/多卡推理、FP8 量化及 ComfyUI 节点,显存 8 G 也能跑通。([GitHub][6], [Hugging Face][7])

- 多角色对话 & 情感对齐,在同类项目里目前独一档。([Generative AI Publication][5], [GitHub][1])

核心功能

功能亮点 | 简要说明 |

|---|---|

一键音驱动数字人 | 输入图片+音频即可生成精准唇形与自然表情,无需视频参考或标注。([Hugging Face][2]) |

多角色同屏对话 | FAA 将各角色脸部掩码分离,允许为每个人注入独立音轨,轻松实现合唱或访谈。([Generative AI Publication][5], [arXiv][4]) |

情感精准迁移 | AEM(Audio Emotion Module)提取音频情绪向量,驱动“喜怒哀乐”细微表情变化。([arXiv][4]) |

角色一致性超高 | Character Image Injection Module 直接在潜空间注入特征,避免“换脸”与破面。([GitHub][1]) |

多风格多景别 | 同时支持写实、卡通、3D、上半身/全身等多类型输入,适配广告、短视频、直播。([Hugging Face][2]) |

高动态背景保真 | 双流-单流 MM-DiT 生成前景动作同时保持背景动态,如海浪、烟火。([Encord][3]) |

FP8 量化推理 | 官方脚本内置 FP8 量化,H100/H200 单卡显存可省约 10 GB。([GitHub][8], [Hugging Face][7]) |

ComfyUI 即插即用 | 社区节点“ComfyUI-HunyuanVideo-Avatar”已上线,拖拽即可生成。([GitHub][6], [Hugging Face][2]) |

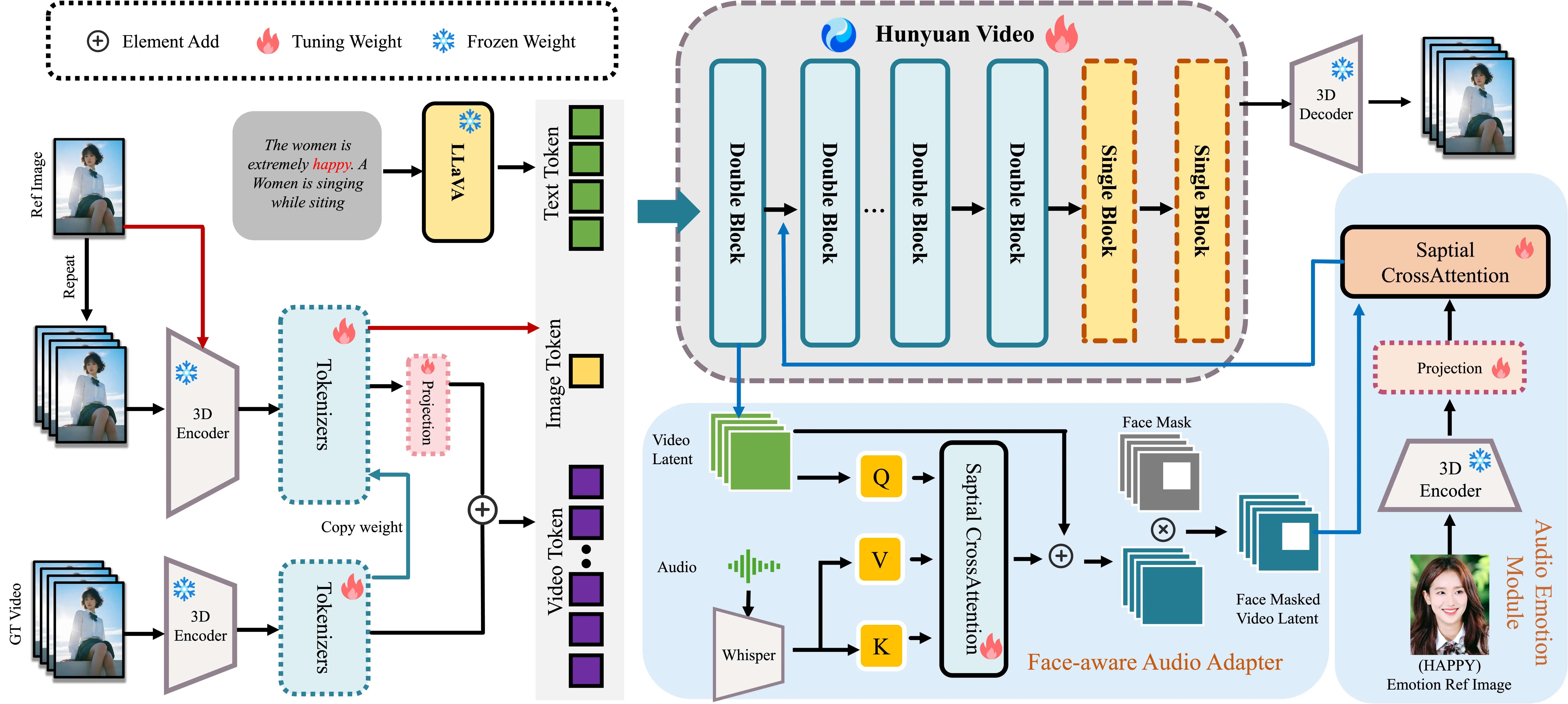

技术架构

模块 | 采用技术/算法 | 作用与优势 |

|---|---|---|

输入编码 | CLIP Vision + Audio Encoder | 统一把图像与音频编码为多模态 Token,实现跨域对齐。([Hugging Face][2]) |

主体生成 | MM-DiT 双流-单流 Transformer | 先独立处理视觉/音频,再融合生成高动态序列帧;兼顾清晰度与动作幅度。([Encord][3], [arXiv][9]) |

角色注入 | Character Image Injection | 消除训练与推理条件不匹配,保证人物纹理、五官一致。([GitHub][1], [arXiv][4]) |

情绪迁移 | Audio Emotion Module | 把情绪 embedding 注入扩散流程,实现细粒度情感控制。([arXiv][4]) |

多人协同 | Face-Aware Audio Adapter | 基于面部掩码的跨注意力机制,多角色声音互不干扰。([Generative AI Publication][5]) |

推理优化 | FP8 量化 & Sliding-Tile Attention | 显存友好,720 p 视频 14 s 内生成完毕。([GitHub][8], [Reddit][10]) |

具体使用方法

# 环境准备(CUDA 11.8)

conda create -n hyvavatar python=3.10 -y

conda activate hyvavatar # :contentReference[oaicite:20]{index=20}

# 克隆仓库并下载权重

git clone https://github.com/Tencent-Hunyuan/HunyuanVideo-Avatar.git

cd HunyuanVideo-Avatar

bash scripts/download_weights.sh # 约 9 GB,含 FP32 & FP8 权重

# 单卡推理示例

python demo/infer_single.py \

--image_path assets/avatar.jpg \

--audio_path assets/voice.wav \

--output results/demo.mp4 \

--fp8 true # 显存≤16 G建议开启

# 多卡并行

python deepspeed_infer.py --gpu 4 ...小贴士:

- 想要情绪更夸张?在

--emotion_scale里加大权重即可。([arXiv][4]) - ComfyUI 用户执行

git clone https://github.com/Yuan-ManX/ComfyUI-HunyuanVideo-Avatar到custom_nodes目录,重启即可拖拽节点使用。([GitHub][6])

应用场景

- 短视频/广告:快速生成带有品牌吉祥物“开口说话”的宣传视频,省去真人拍摄与后期。([Generative AI Publication][5])

- 电商直播:深夜或跨国时段,用数字人代播讲解产品,语音合成即可实时驱动。([animatediff.github.io][11])

- 在线教育:同一张老师照片叠加多语种音频,批量产出教学片段。([Hugging Face][2])

- 播客/MV:把静态封面变成演唱或朗诵画面,增加沉浸感。

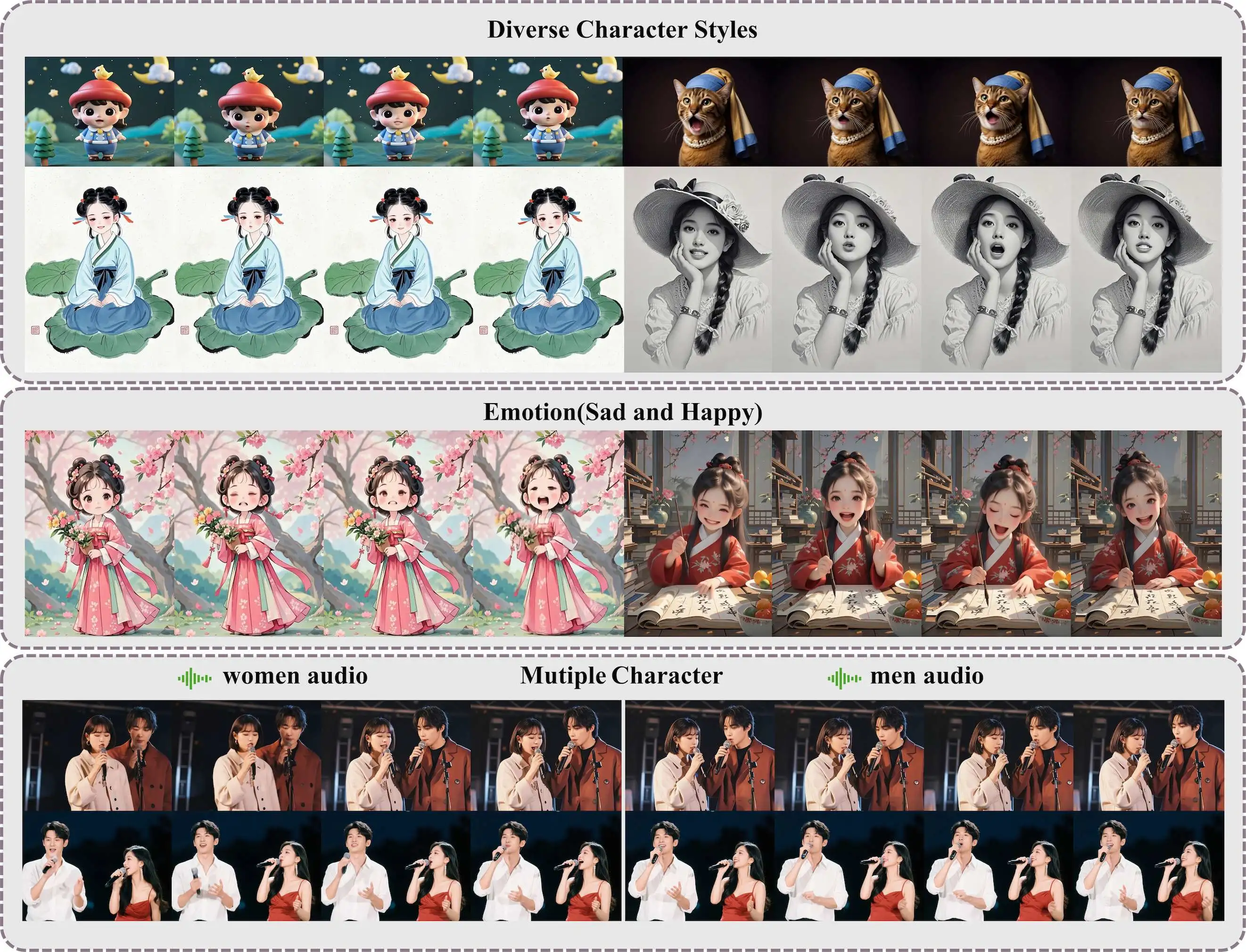

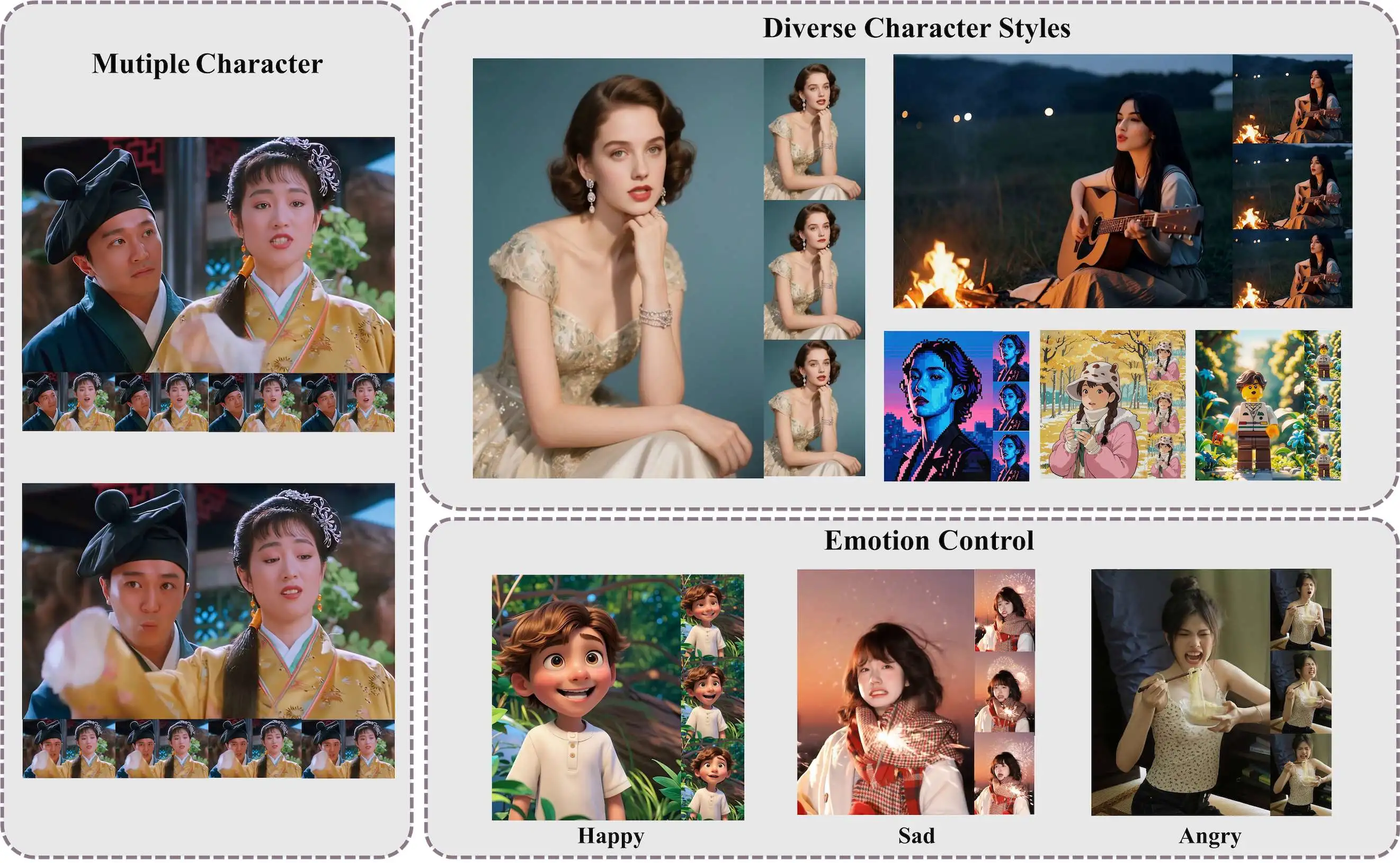

生成效果

添加描述

添加描述

与同类项目对比

项目 | 多角色 | 情绪控制 | 角色一致性 | 输出分辨率 | 完整开源 | 典型场景 | |

|---|---|---|---|---|---|---|---|

HunyuanVideo-Avatar | ✅ FAA | ✅ AEM | ⭐ Character Injection | 720 p | ✅ 权重+脚本 | 短视频、电商、教育 | |

SadTalker | ❌ | ⚠️ 基础 AU 曲线 | ⭐ 头部一致 | 512×512 | ✅ | 讲解视频 | ([GitHub][12]) |

AnimateDiff | ❌ | ❌ | ⚠️ 人物漂移 | 512×768 | ✅ | 动效插画 | ([animatediff.github.io][11]) |

V-Express | ❌ 需关键点 | ⚠️ 表情有限 | ⭐ 头部一致 | 512 p | ✅ | 自定义动作 | ([GitHub][13]) |

优势总结

- 双突破:解决“动得多就糊、清晰就僵硬”两难,动态与一致性兼得。([GitHub][1])

- 友好上手:ComfyUI 节点、FP8 量化、LoRA 微调一条龙。([Hugging Face][7])

- 行业首创多角色音驱动:一行命令即可完成对话/合唱场景。([Generative AI Publication][5])

总结

HunyuanVideo-Avatar 把过去需要专业动捕+后期的数字人视频制作压缩到“上传一张图 + 一段音频 + 等 14 秒”级别,让创作者、运营、开发者都能低成本拥有专属数字人。错过它,你就错过了下一波 AI 视频内容红利!

项目地址

https://github.com/Tencent-Hunyuan/HunyuanVideo-Avatar

原创声明:本文系作者授权腾讯云开发者社区发表,未经许可,不得转载。

如有侵权,请联系 cloudcommunity@tencent.com 删除。

原创声明:本文系作者授权腾讯云开发者社区发表,未经许可,不得转载。

如有侵权,请联系 cloudcommunity@tencent.com 删除。