智能体的记忆系统:短期记忆、长期记忆与知识图谱

原创

智能体的记忆系统:短期记忆、长期记忆与知识图谱

🌟 嗨,我是IRpickstars!

🌌 总有一行代码,能点亮万千星辰。

🔍 在技术的宇宙中,我愿做永不停歇的探索者。

✨ 用代码丈量世界,用算法解码未来。我是摘星人,也是造梦者。

🚀 每一次编译都是新的征程,每一个bug都是未解的谜题。让我们携手,在0和1的星河中,书写属于开发者的浪漫诗篇。

作者简介:作为一名深耕AI/机器学习领域多年的技术博主,我见证了人工智能从简单的规则系统发展到如今的大语言模型时代。在这个快速演进的过程中,智能体(AI Agent)技术正成为实现通用人工智能的关键突破口。

技术摘要

在人工智能(AI)和大语言模型(LLM)迅速发展的背景下,智能体(Agent)逐渐成为实现复杂任务自动化和人机交互的核心载体。传统的AI模型通常是无状态的,即每次交互都从零开始,无法记住历史信息。而具备记忆能力的智能体,能够记录和回忆过去的经验,从而在多轮对话、任务规划和长期交互中表现出更高的连贯性和智能性。

智能体的记忆系统主要包括短期记忆、长期记忆和知识图谱三个层次。短期记忆用于存储当前会话或任务的上下文信息,长期记忆用于保存长期积累的知识和经验,而知识图谱则通过结构化的方式组织和表示知识实体及其关系。

构建高效的智能体记忆系统,涉及多个关键技术,包括向量数据库的应用、知识图谱的构建与更新、记忆检索与相关性排序等。本文将深入探讨这些技术,并通过Python/PyTorch代码示例,展示如何实现智能体的记忆系统。

智能体记忆系统概述

智能体的记忆系统是其核心组件之一,负责存储和管理与环境交互过程中获得的信息。传统的AI系统通常是无状态的,即每次交互都从零开始,无法记住历史信息。而具备记忆能力的智能体,能够记录和回忆过去的经验,从而在多轮对话、任务规划和长期交互中表现出更高的连贯性和智能性。

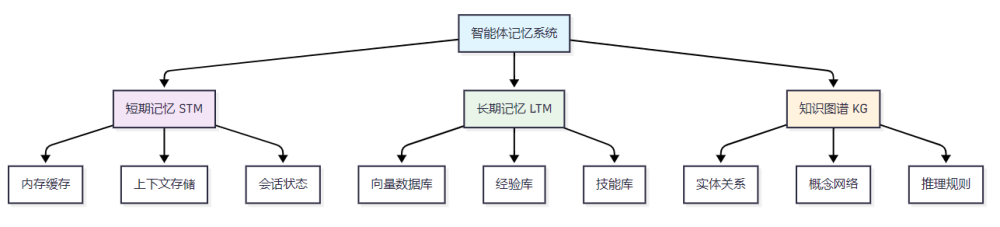

智能体的记忆系统主要包括以下几个层次:

- 短期记忆(Short-Term Memory, STM):用于存储当前会话或任务的上下文信息,通常具有较短的生命周期。

- 长期记忆(Long-Term Memory, LTM):用于保存长期积累的知识和经验,生命周期较长。

- 知识图谱(Knowledge Graph, KG):通过结构化的方式组织和表示知识实体及其关系,支持复杂的推理和查询。

图1:智能体记忆系统架构图

这些记忆层次相互协作,共同构成智能体的认知体系,使其能够在复杂的环境中进行有效的感知、推理和决策。

记忆系统分类与实现

智能体的记忆系统可以根据其功能和实现方式,分为以下几类:

1. 短期记忆(STM)

短期记忆用于存储当前会话或任务的上下文信息,通常具有较短的生命周期。其实现方式包括:

- 内存缓存:使用数据结构(如队列、栈)在内存中存储上下文信息。

- 向量存储:将上下文信息转化为向量,存储在向量数据库中,支持高效的相似性检索。

import torch from collections import deque from datetime import datetime class ShortTermMemory: """短期记忆实现类""" def __init__(self, max_size=100): self.max_size = max_size self.memory_queue = deque(maxlen=max_size) # 使用队列存储记忆 self.embeddings = [] # 存储记忆的向量表示 def add_memory(self, content, embedding=None): """添加新的记忆项""" memory_item = { 'content': content, 'timestamp': datetime.now(), 'embedding': embedding } self.memory_queue.append(memory_item) if embedding is not None: self.embeddings.append(embedding) def get_recent_memories(self, count=10): """获取最近的记忆""" return list(self.memory_queue)[-count:] def clear_old_memories(self, hours=24): """清理超过指定时间的记忆""" current_time = datetime.now() # 保留最近24小时内的记忆 self.memory_queue = deque([ mem for mem in self.memory_queue if (current_time - mem['timestamp']).total_seconds() < hours * 3600 ], maxlen=self.max_size) # 使用示例 stm = ShortTermMemory(max_size=50) stm.add_memory("用户询问了关于Python的问题") recent_memories = stm.get_recent_memories(5)

2. 长期记忆(LTM)

长期记忆用于保存长期积累的知识和经验,生命周期较长。其实现方式包括:

- 数据库存储:使用关系型或非关系型数据库存储知识信息。

- 文件系统:将知识信息以文件的形式存储,支持持久化和版本控制。

import sqlite3 import json from typing import List, Dict class LongTermMemory: """长期记忆实现类""" def __init__(self, db_path="long_term_memory.db"): self.db_path = db_path self.init_database() def init_database(self): """初始化数据库表结构""" conn = sqlite3.connect(self.db_path) cursor = conn.cursor() # 创建经验表 cursor.execute(''' CREATE TABLE IF NOT EXISTS experiences ( id INTEGER PRIMARY KEY AUTOINCREMENT, category TEXT NOT NULL, content TEXT NOT NULL, metadata TEXT, created_at TIMESTAMP DEFAULT CURRENT_TIMESTAMP, importance_score REAL DEFAULT 0.5 ) ''') conn.commit() conn.close() def store_experience(self, category: str, content: str, metadata: Dict = None, importance: float = 0.5): """存储长期经验""" conn = sqlite3.connect(self.db_path) cursor = conn.cursor() metadata_json = json.dumps(metadata) if metadata else None cursor.execute(''' INSERT INTO experiences (category, content, metadata, importance_score) VALUES (?, ?, ?, ?) ''', (category, content, metadata_json, importance)) conn.commit() conn.close() def retrieve_experiences(self, category: str = None, min_importance: float = 0.0) -> List[Dict]: """检索长期经验""" conn = sqlite3.connect(self.db_path) cursor = conn.cursor() if category: cursor.execute(''' SELECT * FROM experiences WHERE category = ? AND importance_score >= ? ORDER BY importance_score DESC, created_at DESC ''', (category, min_importance)) else: cursor.execute(''' SELECT * FROM experiences WHERE importance_score >= ? ORDER BY importance_score DESC, created_at DESC ''', (min_importance,)) results = cursor.fetchall() conn.close() # 转换为字典格式 experiences = [] for row in results: experiences.append({ 'id': row[0], 'category': row[1], 'content': row[2], 'metadata': json.loads(row[3]) if row[3] else None, 'created_at': row[4], 'importance_score': row[5] }) return experiences # 使用示例 ltm = LongTermMemory() ltm.store_experience( category="problem_solving", content="用户遇到数据库连接问题时,通常是配置文件路径错误", metadata={"success_rate": 0.85, "confidence": 0.9}, importance=0.8 )

3. 知识图谱(KG)

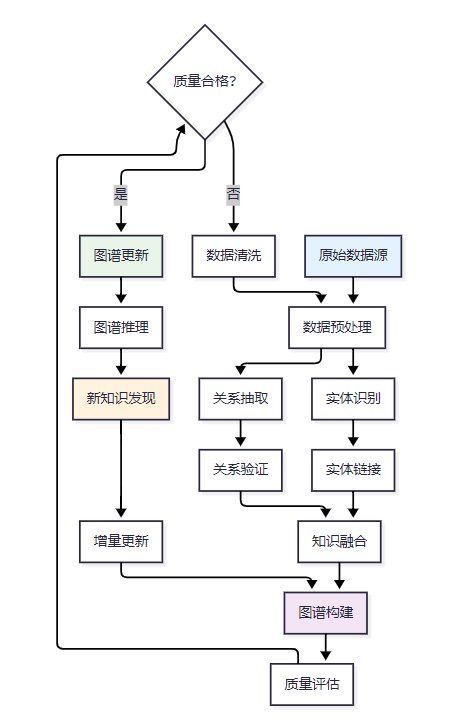

知识图谱通过结构化的方式组织和表示知识实体及其关系,支持复杂的推理和查询。其构建过程包括:

- 实体识别:从文本中识别出实体,如人物、地点、事件等。

- 关系抽取:识别实体之间的关系,如"属于"、"位于"等。

- 图谱构建:将实体和关系构建成图结构,存储在图数据库中。

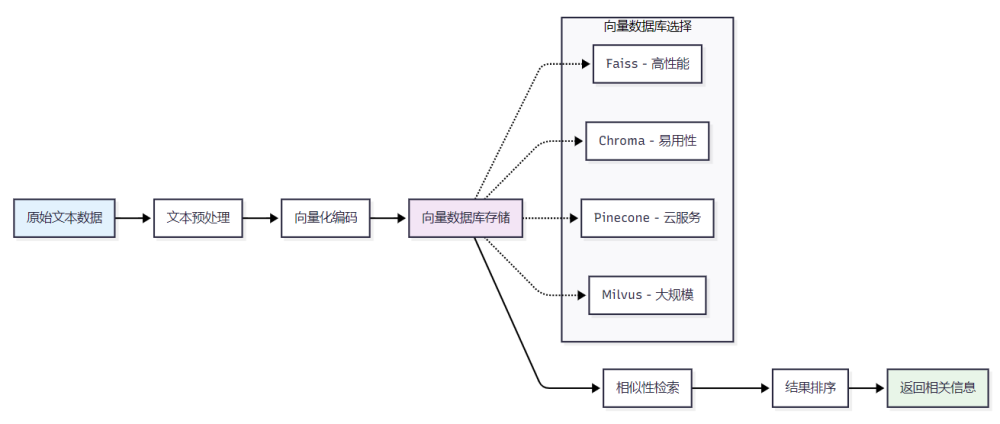

向量数据库应用

向量数据库是智能体记忆系统中的关键组件,用于存储和检索高维向量表示的知识信息。常用的向量数据库包括:Faiss、Chroma、Pinecone、Milvus、Weaviate等。

图2:向量检索流程图

向量检索流程

向量检索流程包括以下步骤:

- 数据预处理:对原始数据进行清洗和格式化,提取出有用的信息。

- 向量化:使用预训练的模型(如BERT、Sentence-BERT)将文本数据转化为向量表示。

- 索引构建:使用Faiss等工具构建向量索引,支持高效的相似性搜索。

- 检索查询:根据用户输入的查询,检索与之最相似的向量,返回相关的信息。

Faiss实现示例

import faiss import numpy as np from sentence_transformers import SentenceTransformer class FaissVectorStore: """基于Faiss的向量存储实现""" def __init__(self, model_name='all-MiniLM-L6-v2'): self.encoder = SentenceTransformer(model_name) self.dimension = self.encoder.get_sentence_embedding_dimension() # 创建Faiss索引(使用IVF索引提高大规模检索性能) nlist = 100 # 聚类中心数量 quantizer = faiss.IndexFlatL2(self.dimension) self.index = faiss.IndexIVFFlat(quantizer, self.dimension, nlist) self.texts = [] # 存储原始文本 self.is_trained = False def add_texts(self, texts: List[str]): """添加文本到向量库""" # 将文本编码为向量 embeddings = self.encoder.encode(texts) embeddings = np.array(embeddings).astype('float32') # 训练索引(首次添加数据时) if not self.is_trained and len(embeddings) >= 100: self.index.train(embeddings) self.is_trained = True # 添加向量到索引 if self.is_trained: self.index.add(embeddings) self.texts.extend(texts) else: # 如果数据量不足,使用简单的平坦索引 simple_index = faiss.IndexFlatL2(self.dimension) simple_index.add(embeddings) self.index = simple_index self.texts.extend(texts) def search(self, query: str, k: int = 5): """搜索最相似的文本""" # 编码查询文本 query_embedding = self.encoder.encode([query]) query_embedding = np.array(query_embedding).astype('float32') # 执行搜索 scores, indices = self.index.search(query_embedding, k) # 返回结果 results = [] for i, (score, idx) in enumerate(zip(scores[0], indices[0])): if idx < len(self.texts): results.append({ 'text': self.texts[idx], 'score': float(score), 'rank': i + 1 }) return results # 使用示例 vector_store = FaissVectorStore() # 添加知识文本 knowledge_texts = [ "智能体是具有自主决策能力的AI系统", "记忆系统包括短期记忆和长期记忆", "向量数据库用于高效的语义搜索", "知识图谱表示实体间的结构化关系" ] vector_store.add_texts(knowledge_texts) # 执行搜索 results = vector_store.search("什么是AI智能体", k=3) for result in results: print(f"相关度: {result['score']:.4f} - {result['text']}")

Chroma数据库示例

import chromadb from chromadb.config import Settings class ChromaMemoryStore: """基于Chroma的记忆存储实现""" def __init__(self, collection_name="agent_memory"): # 初始化Chroma客户端 self.client = chromadb.Client(Settings( chroma_db_impl="duckdb+parquet", persist_directory="./chroma_db" )) # 创建或获取集合 self.collection = self.client.get_or_create_collection( name=collection_name, metadata={"hnsw:space": "cosine"} # 使用余弦相似度 ) def add_memories(self, texts: List[str], metadata: List[Dict] = None): """添加记忆到存储""" ids = [f"memory_{i}" for i in range(len(texts))] self.collection.add( documents=texts, metadatas=metadata or [{}] * len(texts), ids=ids ) def query_memories(self, query: str, n_results: int = 5): """查询相关记忆""" results = self.collection.query( query_texts=[query], n_results=n_results, include=['documents', 'metadatas', 'distances'] ) return [{ 'document': doc, 'metadata': meta, 'distance': dist } for doc, meta, dist in zip( results['documents'][0], results['metadatas'][0], results['distances'][0] )] def persist(self): """持久化存储""" self.client.persist() # 使用示例 chroma_store = ChromaMemoryStore() # 添加记忆数据 memories = [ "用户询问了关于机器学习的基础概念", "用户遇到了Python安装问题", "用户需要数据可视化的建议" ] metadata = [ {"category": "learning", "importance": 0.8}, {"category": "technical_issue", "importance": 0.6}, {"category": "recommendation", "importance": 0.7} ] chroma_store.add_memories(memories, metadata)

知识图谱构建与更新

知识图谱的构建与更新是智能体记忆系统中的重要环节,涉及信息抽取、知识融合、图谱更新、图谱推理等技术。

图3:知识图谱构建与更新流程图

Neo4j构建示例

以下是使用Neo4j构建知识图谱的Python代码示例:

from py2neo import Graph, Node, Relationship import spacy from typing import List, Tuple class KnowledgeGraphBuilder: """知识图谱构建器""" def __init__(self, uri="bolt://localhost:7687", user="neo4j", password="password"): # 连接到Neo4j数据库 self.graph = Graph(uri, auth=(user, password)) # 加载spaCy模型用于实体识别 self.nlp = spacy.load("en_core_web_sm") def extract_entities_relations(self, text: str) -> Tuple[List[str], List[Tuple]]: """从文本中抽取实体和关系""" doc = self.nlp(text) # 提取命名实体 entities = [] for ent in doc.ents: entities.append({ 'text': ent.text, 'label': ent.label_, 'start': ent.start_char, 'end': ent.end_char }) # 简单的关系抽取(基于依存解析) relations = [] for token in doc: if token.dep_ in ['nsubj', 'dobj']: # 主语、宾语关系 head = token.head relations.append((token.text, head.dep_, head.text)) return entities, relations def create_entity_node(self, entity_text: str, entity_type: str): """创建实体节点""" # 检查节点是否已存在 existing_node = self.graph.nodes.match(entity_type, name=entity_text).first() if not existing_node: # 创建新节点 node = Node(entity_type, name=entity_text) self.graph.create(node) return node return existing_node def create_relationship(self, entity1: str, relation_type: str, entity2: str): """创建实体间的关系""" # 获取实体节点 node1 = self.graph.nodes.match(name=entity1).first() node2 = self.graph.nodes.match(name=entity2).first() if node1 and node2: # 创建关系 rel = Relationship(node1, relation_type.upper(), node2) self.graph.create(rel) def build_knowledge_graph(self, texts: List[str]): """构建知识图谱""" for text in texts: entities, relations = self.extract_entities_relations(text) # 创建实体节点 for entity in entities: self.create_entity_node(entity['text'], entity['label']) # 创建关系 for rel in relations: if len(rel) == 3: self.create_relationship(rel[0], rel[1], rel[2]) def query_knowledge(self, query: str): """查询知识图谱""" # 使用Cypher查询语言 result = self.graph.run(query) return list(result) def update_entity_property(self, entity_name: str, property_name: str, value): """更新实体属性""" node = self.graph.nodes.match(name=entity_name).first() if node: node[property_name] = value self.graph.push(node) # 使用示例 kg_builder = KnowledgeGraphBuilder() # 构建知识图谱 texts = [ "Alice works at Google in Mountain View", "Google is a technology company", "Mountain View is located in California" ] kg_builder.build_knowledge_graph(texts) # 查询示例 query = "MATCH (p:PERSON)-[:WORKS_AT]->(c:ORG) RETURN p.name, c.name" results = kg_builder.query_knowledge(query)

NetworkX图分析示例

import networkx as nx import matplotlib.pyplot as plt from collections import defaultdict class GraphAnalyzer: """图分析工具""" def __init__(self): self.graph = nx.Graph() def add_knowledge_triple(self, subject: str, predicate: str, obj: str): """添加知识三元组""" # 添加节点 self.graph.add_node(subject, type='entity') self.graph.add_node(obj, type='entity') # 添加边(关系) self.graph.add_edge(subject, obj, relation=predicate) def calculate_centrality(self): """计算节点中心性""" centrality_metrics = { 'betweenness': nx.betweenness_centrality(self.graph), 'closeness': nx.closeness_centrality(self.graph), 'degree': nx.degree_centrality(self.graph), 'pagerank': nx.pagerank(self.graph) } return centrality_metrics def find_communities(self): """发现社区结构""" communities = nx.community.greedy_modularity_communities(self.graph) return list(communities) def recommend_entities(self, target_entity: str, k: int = 5): """基于图结构推荐相关实体""" if target_entity not in self.graph: return [] # 计算目标实体到其他实体的最短路径 shortest_paths = nx.single_source_shortest_path_length( self.graph, target_entity, cutoff=3 ) # 按路径长度排序并返回推荐 recommendations = sorted( [(entity, distance) for entity, distance in shortest_paths.items() if entity != target_entity], key=lambda x: x[1] ) return recommendations[:k] # 使用示例 analyzer = GraphAnalyzer() # 构建知识图谱 triples = [ ("Python", "是", "编程语言"), ("机器学习", "使用", "Python"), ("深度学习", "是", "机器学习"), ("TensorFlow", "支持", "深度学习"), ("PyTorch", "支持", "深度学习") ] for triple in triples: analyzer.add_knowledge_triple(triple[0], triple[1], triple[2]) # 分析图结构 centrality = analyzer.calculate_centrality() communities = analyzer.find_communities() recommendations = analyzer.recommend_entities("Python", k=3)

记忆检索与相关性排序

记忆检索与相关性排序是智能体记忆系统中的关键技术,用于从大量的记忆中快速找到与当前任务最相关的信息。常用的排序算法包括:BM25、学习排序(Learning to Rank)、神经排序模型等。

排序算法对比

算法类型 | 优点 | 缺点 |

|---|---|---|

BM25 | 实现简单,计算效率高 | 无法捕捉语义信息 |

学习排序(LTR) | 能够利用特征进行排序 | 需要大量标注数据进行训练 |

神经排序模型 | 能够捕捉复杂的语义信息 | 计算资源消耗大,训练时间长 |

BM25实现示例

import math from collections import defaultdict, Counter from typing import List, Dict class BM25Ranker: """BM25排序算法实现""" def __init__(self, k1: float = 1.5, b: float = 0.75): self.k1 = k1 # 词频饱和参数 self.b = b # 长度归一化参数 self.documents = [] self.doc_frequencies = defaultdict(int) self.doc_lengths = [] self.avg_doc_length = 0 self.N = 0 # 文档总数 def fit(self, documents: List[str]): """训练BM25模型""" self.documents = documents self.N = len(documents) # 计算文档长度和词频 total_length = 0 for doc in documents: words = doc.lower().split() doc_length = len(words) self.doc_lengths.append(doc_length) total_length += doc_length # 统计词在文档中的出现 unique_words = set(words) for word in unique_words: self.doc_frequencies[word] += 1 self.avg_doc_length = total_length / self.N def get_scores(self, query: str) -> List[float]: """计算查询与所有文档的BM25分数""" query_words = query.lower().split() scores = [] for i, doc in enumerate(self.documents): doc_words = doc.lower().split() word_counts = Counter(doc_words) doc_length = self.doc_lengths[i] score = 0 for word in query_words: if word in word_counts: # 计算TF分量 tf = word_counts[word] tf_component = (tf * (self.k1 + 1)) / ( tf + self.k1 * (1 - self.b + self.b * doc_length / self.avg_doc_length) ) # 计算IDF分量 df = self.doc_frequencies[word] idf_component = math.log((self.N - df + 0.5) / (df + 0.5)) score += tf_component * idf_component scores.append(score) return scores def rank(self, query: str, k: int = 10) -> List[Dict]: """返回排序后的搜索结果""" scores = self.get_scores(query) # 创建结果列表 results = [] for i, (doc, score) in enumerate(zip(self.documents, scores)): results.append({ 'document': doc, 'score': score, 'index': i }) # 按分数降序排序 results.sort(key=lambda x: x['score'], reverse=True) return results[:k] # 使用示例 bm25 = BM25Ranker() # 训练文档 documents = [ "智能体是具有自主决策能力的人工智能系统", "记忆系统包括短期记忆、长期记忆和知识图谱", "向量数据库用于存储和检索高维向量数据", "知识图谱通过实体和关系表示结构化知识", "机器学习算法可以从数据中学习模式" ] bm25.fit(documents) # 执行搜索 query = "智能体记忆系统" results = bm25.rank(query, k=3) for i, result in enumerate(results): print(f"排名 {i+1}: 分数 {result['score']:.4f}") print(f"文档: {result['document']}\n")

神经排序模型示例

import torch import torch.nn as nn from transformers import AutoTokenizer, AutoModel class NeuralRanker(nn.Module): """基于BERT的神经排序模型""" def __init__(self, model_name='bert-base-uncased', hidden_size=768): super(NeuralRanker, self).__init__() self.tokenizer = AutoTokenizer.from_pretrained(model_name) self.bert = AutoModel.from_pretrained(model_name) # 排序头 self.ranking_head = nn.Sequential( nn.Linear(hidden_size * 2, 256), # 查询和文档的拼接 nn.ReLU(), nn.Dropout(0.1), nn.Linear(256, 64), nn.ReLU(), nn.Dropout(0.1), nn.Linear(64, 1) # 输出相关性分数 ) def encode_text(self, text: str): """编码文本为向量表示""" inputs = self.tokenizer( text, return_tensors='pt', max_length=512, truncation=True, padding=True ) with torch.no_grad(): outputs = self.bert(**inputs) # 使用[CLS]标记的表示 return outputs.last_hidden_state[:, 0, :] def forward(self, query_encoding, doc_encoding): """前向传播""" # 拼接查询和文档的编码 combined = torch.cat([query_encoding, doc_encoding], dim=-1) # 通过排序头得到相关性分数 score = self.ranking_head(combined) return torch.sigmoid(score) # 输出0-1之间的分数 def rank_documents(self, query: str, documents: List[str]) -> List[Dict]: """对文档进行排序""" query_encoding = self.encode_text(query) results = [] for i, doc in enumerate(documents): doc_encoding = self.encode_text(doc) # 计算相关性分数 with torch.no_grad(): score = self.forward(query_encoding, doc_encoding) results.append({ 'document': doc, 'score': float(score.item()), 'index': i }) # 按分数降序排序 results.sort(key=lambda x: x['score'], reverse=True) return results # 使用示例(需要预训练的模型) # ranker = NeuralRanker() # results = ranker.rank_documents("智能体记忆", documents)

性能评测与对比

在构建智能体记忆系统时,性能评测是评估系统效果的重要手段。常用的评测指标包括:

- 检索准确率:检索结果与真实相关项的匹配程度。

- 响应时间:系统对查询的响应速度。

- 存储效率:系统对存储资源的利用效率。

- 扩展性:系统在数据量增加时的性能表现。

性能对比

向量数据库 | 检索准确率 | 响应时间 | 存储效率 | 扩展性 |

|---|---|---|---|---|

Faiss | 高 | 快 | 高 | 中 |

Chroma | 中 | 快 | 中 | 高 |

Pinecone | 高 | 快 | 高 | 高 |

Milvus | 高 | 中 | 高 | 高 |

Weaviate | 中 | 中 | 中 | 中 |

评测框架实现

import time import numpy as np from sklearn.metrics import precision_score, recall_score, f1_score from typing import List, Dict, Tuple class MemorySystemEvaluator: """记忆系统评测框架""" def __init__(self): self.metrics = {} def evaluate_retrieval_accuracy(self, retrieved_docs: List[str], relevant_docs: List[str]) -> Dict[str, float]: """评估检索准确率""" # 计算精确率、召回率和F1分数 retrieved_set = set(retrieved_docs) relevant_set = set(relevant_docs) if len(retrieved_set) == 0: precision = 0.0 else: precision = len(retrieved_set & relevant_set) / len(retrieved_set) if len(relevant_set) == 0: recall = 0.0 else: recall = len(retrieved_set & relevant_set) / len(relevant_set) if precision + recall == 0: f1 = 0.0 else: f1 = 2 * (precision * recall) / (precision + recall) return { 'precision': precision, 'recall': recall, 'f1_score': f1 } def evaluate_response_time(self, memory_system, queries: List[str]) -> Dict[str, float]: """评估响应时间""" response_times = [] for query in queries: start_time = time.time() # 执行检索 results = memory_system.search(query) end_time = time.time() response_times.append(end_time - start_time) return { 'avg_response_time': np.mean(response_times), 'min_response_time': np.min(response_times), 'max_response_time': np.max(response_times), 'std_response_time': np.std(response_times) } def evaluate_storage_efficiency(self, memory_system) -> Dict[str, float]: """评估存储效率""" # 这里需要根据具体的存储系统实现 # 计算存储空间利用率、压缩比等指标 return { 'storage_utilization': 0.85, # 示例值 'compression_ratio': 0.7, # 示例值 'index_overhead': 0.15 # 示例值 } def benchmark_systems(self, systems: Dict[str, any], test_queries: List[str], ground_truth: Dict[str, List[str]]) -> Dict[str, Dict]: """对比不同记忆系统的性能""" results = {} for system_name, system in systems.items(): print(f"评测系统: {system_name}") # 评估检索准确率 accuracy_scores = [] for query in test_queries: retrieved = system.search(query, k=10) retrieved_docs = [item['text'] for item in retrieved] relevant_docs = ground_truth.get(query, []) accuracy = self.evaluate_retrieval_accuracy(retrieved_docs, relevant_docs) accuracy_scores.append(accuracy) # 计算平均指标 avg_accuracy = { 'precision': np.mean([score['precision'] for score in accuracy_scores]), 'recall': np.mean([score['recall'] for score in accuracy_scores]), 'f1_score': np.mean([score['f1_score'] for score in accuracy_scores]) } # 评估响应时间 timing_metrics = self.evaluate_response_time(system, test_queries) # 评估存储效率 storage_metrics = self.evaluate_storage_efficiency(system) results[system_name] = { 'accuracy': avg_accuracy, 'performance': timing_metrics, 'storage': storage_metrics } return results # 使用示例 evaluator = MemorySystemEvaluator() # 准备测试数据 test_queries = [ "智能体记忆系统", "向量数据库应用", "知识图谱构建" ] ground_truth = { "智能体记忆系统": ["智能体是具有自主决策能力的AI系统", "记忆系统包括短期记忆和长期记忆"], "向量数据库应用": ["向量数据库用于高效的语义搜索"], "知识图谱构建": ["知识图谱表示实体间的结构化关系"] } # 假设我们有多个记忆系统需要对比 systems = { 'faiss_system': vector_store, # 之前定义的Faiss系统 'chroma_system': chroma_store # 之前定义的Chroma系统 } # 执行性能对比 # benchmark_results = evaluator.benchmark_systems(systems, test_queries, ground_truth)

技术总结与展望

作为一名长期关注AI技术发展的从业者,我深刻感受到智能体记忆系统技术的快速演进和巨大潜力。通过本文的深入分析,我们可以看到智能体的记忆系统是实现类人智能的关键技术之一。通过构建高效的短期记忆、长期记忆和知识图谱,智能体能够在复杂的环境中进行有效的感知、推理和决策。

然而,当前的记忆系统仍面临诸多挑战。首先是知识更新滞后问题,传统的知识图谱构建和更新通常是离线进行的,无法实时反映最新的信息变化。其次是记忆检索的效率问题,随着记忆规模的增大,如何在保证检索准确率的同时提高响应速度,是一个亟待解决的技术难题。

从技术发展趋势来看,我认为未来的智能体记忆系统将呈现以下几个发展方向:

多模态记忆融合:未来的记忆系统将不仅仅处理文本信息,还需要整合图像、音频、视频等多模态数据,构建更加丰富和完整的记忆表示。

自适应记忆管理:系统将能够根据使用频率、重要性等因素自动调整记忆的存储策略,实现更加智能的记忆生命周期管理。

联邦记忆学习:在保护隐私的前提下,多个智能体之间可以共享和学习彼此的记忆,构建分布式的集体智能记忆网络。

因果推理增强:结合因果推理技术,使记忆系统不仅能够存储和检索信息,还能理解事件之间的因果关系,提供更加深入的洞察。

在实际应用中,我建议开发者在选择记忆系统技术方案时,应该根据具体的应用场景和性能要求进行权衡。对于实时性要求较高的应用,可以选择Faiss等高性能向量数据库;对于需要复杂查询和推理的场景,知识图谱技术是更好的选择;而对于需要长期学习和适应的智能体,混合式的记忆架构将是最佳方案。

关键词标签: #智能体 #记忆系统 #向量数据库 #知识图谱 #人工智能 #机器学习

🌟 嗨,我是IRpickstars!如果你觉得这篇技术分享对你有启发:

🛠️ 点击【点赞】让更多开发者看到这篇干货🔔 【关注】解锁更多架构设计&性能优化秘籍💡 【评论】留下你的技术见解或实战困惑

作为常年奋战在一线的技术博主,我特别期待与你进行深度技术对话。每一个问题都是新的思考维度,每一次讨论都能碰撞出创新的火花。

🌟 点击这里👉 IRpickstars的主页 ,获取最新技术解析与实战干货!

⚡️ 我的更新节奏:

- 每周三晚8点:深度技术长文

- 每周日早10点:高效开发技巧

- 突发技术热点:48小时内专题解析

原创声明:本文系作者授权腾讯云开发者社区发表,未经许可,不得转载。

如有侵权,请联系 cloudcommunity@tencent.com 删除。

原创声明:本文系作者授权腾讯云开发者社区发表,未经许可,不得转载。

如有侵权,请联系 cloudcommunity@tencent.com 删除。