7步告诉你如何有效验证 AI 生成的代码

原创7步告诉你如何有效验证 AI 生成的代码

原创用户11680974

发布于 2025-11-05 18:27:59

发布于 2025-11-05 18:27:59

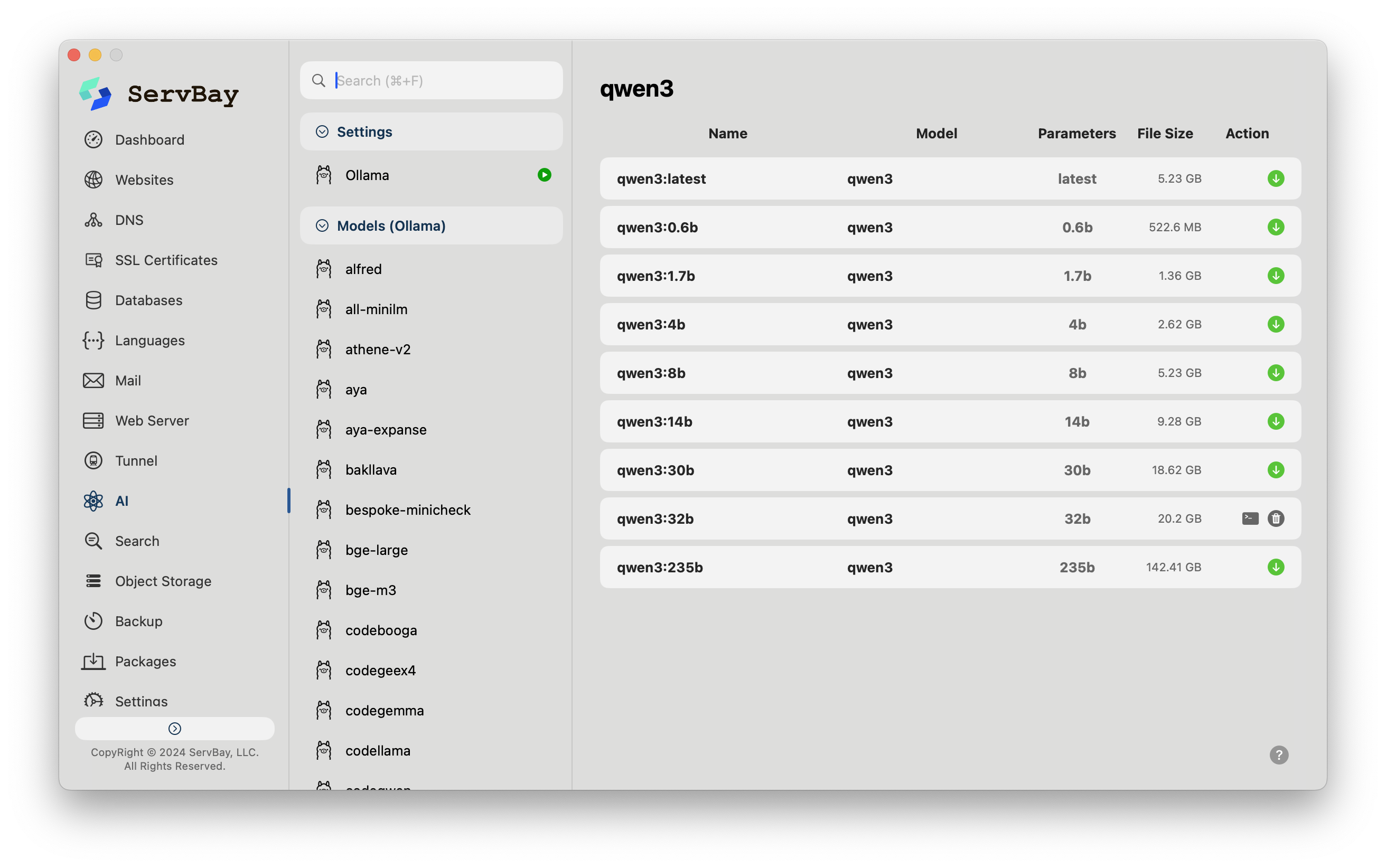

随着AI 编程助手的越来越多,越来越给力,软件开发中使用AI的门槛已几乎消失。相信也有一些团队会在本地部署AI模型。这样不仅可以避免公共API的延迟和数据隐私问题,通过像 ServBay 这样的工具,开发者点击一下,就能在本地机器上搭建起一个完整的AI环境,直接生成代码。

这种便利性带来了AI生成代码量的激增,加速了开发进程,但同时也引起一些问题,一段由AI生成的、语法无误的代码,距离生产环境部署的标准还有多远?

如果不管这些,那可能会对项目的稳定性和安全性造成直接威胁。逻辑上的微小偏差、隐藏的安全后门,或是难以察觉的性能衰减,都可能在代码合并后成为棘手的难题。

因此,我们需要的不是拒绝AI,而是一套将其生产力安全地融入工程实践的验证方法。

验证AI代码的重要性

AI编码助手正在成为开发工作流的标准组成部分。它们生成代码的速度远超人工审查的速度,这使得潜在的风险被放大了。未经审视的AI代码主要带来三类风险:

- 安全性的缺失:AI从海量开源数据中学习,不可避免地会学到一些过时或不安全的编码模式,这些模式可能会被加到新代码中,造成安全漏洞。

- 逻辑的完备性不足:AI擅长处理典型场景,但在处理复杂的边界条件或异常流程时,其生成的逻辑可能存在缺陷,导致程序在特定情况下崩溃或行为异常。

- 长期维护的成本:AI倾向于提供“能用”的解决方案,但可能缺乏对项目整体架构和代码规范的考量,导致生成的代码可读性差、耦合度高,最终演变为技术债务。

虽然问题是有,但咱也不能因噎废食,完全不用AI了。而是需要建立一套严谨的验证SOP。

7步建立验证流程

第一步:从交互开始,构建高质量的生成起点

代码验证的第一步,始于与AI的交互。我们向AI发出的提示词(Prompt),要非常精确。其中需要清晰地界定:

- 功能目标与核心约束

- 输入/输出的数据结构

- 预期的错误处理机制

- 性能基线要求

在获得生成结果后,不要直接复制粘贴。首要任务是逐行阅读,确保自己能完全理解并复述每一段代码的意图。这是对代码所有权的基本确认。

第二步:功能验证,代码是否真的完成了任务

这是最直接的检验步骤:代码是不是真正的完成了要完成的任务?全面而细致的单元测试是验证功能正确性的关键。测试用例的设计应超越正常工作路径,深入到各种边缘地带:

- 覆盖所有正常的功能分支。

- 测试临界值,如数组为空、数值为零或达到上限。

- 模拟无效输入,检验程序的容错能力。

自动化测试框架在此阶段至关重要,它可以系统性地执行这些检查,量化代码的可靠性。

第三步:安全审查,堵上看不见的漏洞

安全是所有的底线。对于AI生成的代码,必须要以怀疑的眼光进行审查,尤其是在处理外部输入的关键节点上:

- 任何用户输入都必须经过严格的清洗与验证。

- 数据库交互需警惕SQL注入风险。

- 文件系统和网络API的调用,要防范权限绕过和路径穿越。

引入静态代码分析工具(SAST)可以自动化地发现大部分已知的漏洞模式,但这不能替代有经验的开发者对认证、授权等核心安全逻辑的人工审计。

第四步:可维护性评估,代码是资产还是负债?

一段代码的生命周期远不止于它的首次运行。今天合并的代码,在未来数月甚至数年里,都需要被理解、修改和扩展。因此,评估其可维护性至关重要:

- 复杂度:代码的逻辑是否过于复杂?过高的圈复杂度往往是bug的温床。

- 清晰度:命名是否规范?函数和变量的意图是否一目了然?

- 一致性:代码风格是否与项目现有规范保持一致?

利用Linter和代码质量分析工具,可以量化这些指标,为代码审查提供客观依据。

第五步:性能测试,在高负载下能否稳健运行?

AI模型在生成代码时,首要目标是功能正确性,而非极致的性能。因此,生成的代码可能存在性能隐患,例如,使用了低效的算法,或产生了不必要的内存分配。

通过性能剖析工具(Profiler),我们可以精确测量:

- 关键函数的执行耗时。

- 程序的内存占用峰值与GC行为。

- 数据库查询的效率。

这一步确保了新代码的并入不会拖慢整个系统的响应速度。

第六步:集成测试,在新环境中能否协同工作?

代码在孤立环境下测试通过,只是第一步。它最终需要与系统中其他模块协同工作。集成测试的目的,就是验证这种协同能力。

但问题是,现代应用往往是多语言、多服务的复杂系统。

搭建一个能真实反映生产环境的测试环境,本身就是一个不小的负担。此时,一个灵活的本地开发套件就显得尤为宝贵。

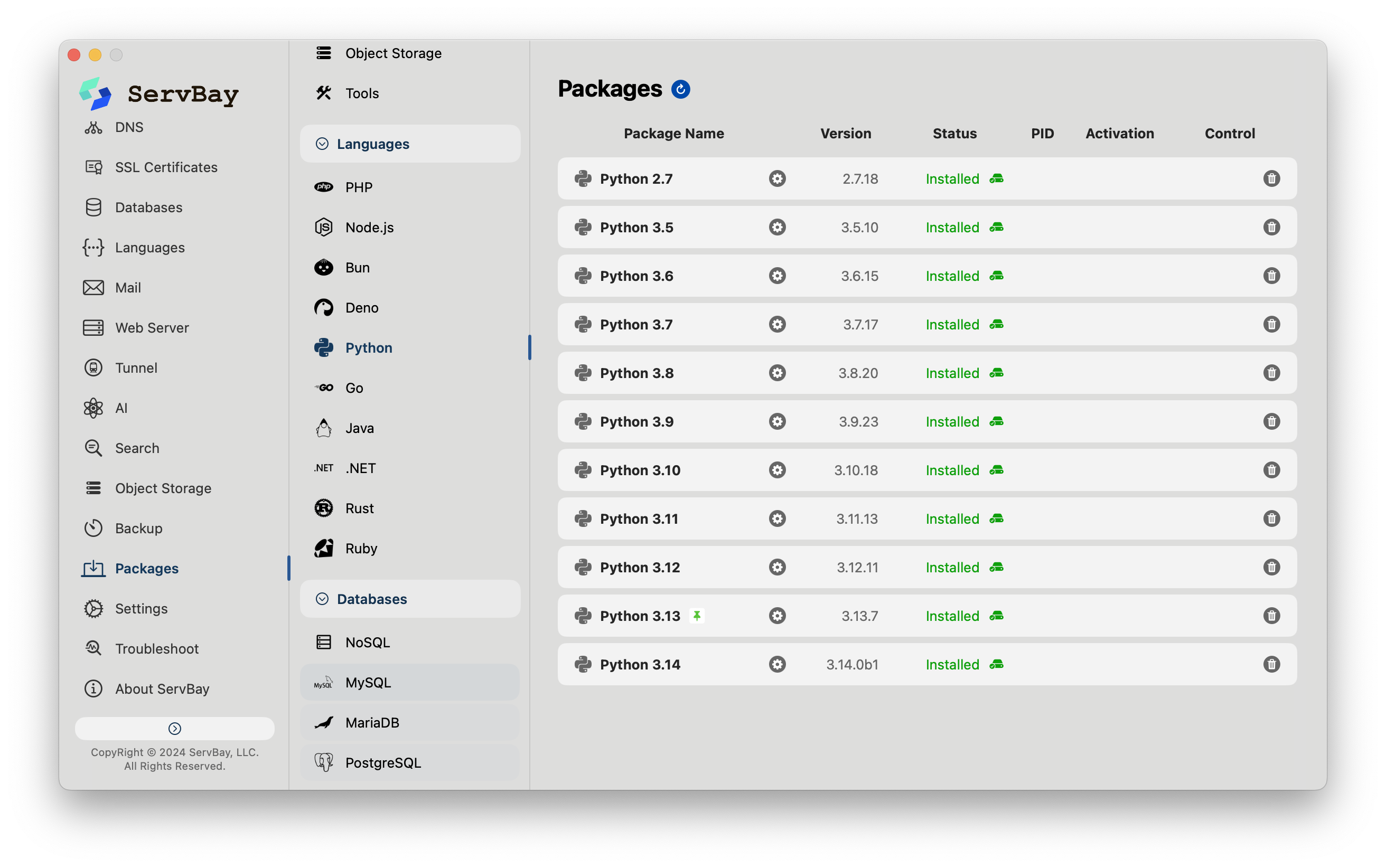

例如,ServBay 支持一键安装和管理多种语言(Golang, Node.js, Python等)的不同版本,并允许它们同时运行。这为开发者和测试人员提供了一个高效的方式来模拟复杂的生产依赖,从而在合并前彻底检验AI代码的兼容性和集成效果。

最后一步:人工代码审查,注入领域知识与架构智慧

所有自动化工具都无法替代资深开发者的判断力。这是验证流程的收官环节,也是注入人性的环节。人工审查的重点在于:

- 业务逻辑对齐:代码的实现是否精准地反映了业务需求?

- 架构契合度:代码是否遵循了项目既定的设计模式和架构原则?

- 前瞻性考量:当前实现是否为未来的功能扩展留下了空间?

这是将AI的计算能力与人类的经验智慧相结合的关键一步。

将验证内化为开发习惯

将AI生成的代码看作一位有才华但经验尚浅的初级同事提交的成果。它需要引导、需要审视、更需要通过一套严格的流程来保证质量。

将上述验证环节固化为团队的检查清单,并尽可能地集成到CI/CD流程中。这不仅不会拖慢开发节奏,反而会在长期内节省下大量用于调试和重构的时间。

通过这种方式,我们才能真正驾驭AI,使其成为提升工程质量与效率的可靠伙伴。

原创声明:本文系作者授权腾讯云开发者社区发表,未经许可,不得转载。

如有侵权,请联系 cloudcommunity@tencent.com 删除。

原创声明:本文系作者授权腾讯云开发者社区发表,未经许可,不得转载。

如有侵权,请联系 cloudcommunity@tencent.com 删除。

评论

登录后参与评论

推荐阅读

目录