构建AI智能体:MCP 生态的革命:FastMCP 如何重新定义 AI 工具开发

原创构建AI智能体:MCP 生态的革命:FastMCP 如何重新定义 AI 工具开发

原创

未闻花名

发布于 2025-12-11 08:10:56

发布于 2025-12-11 08:10:56

一、理想遇见现实

结合近几期,我们在了解了 MCP协议的基本概念后,有了一定的了解和认知:一个标准化的协议,让大型语言模型能够安全、可靠地调用外部工具和函数。MCP 确实为解决 AI 应用开发中的核心痛点提供了优雅的方案——它打破了供应商锁定的困局,建立了统一的工具交互标准,为 AI 应用的可移植性和可维护性奠定了坚实基础。

然而,当我们从协议规范转向实际开发时,一些现实的挑战开始浮现。MCP 协议本身是一个标准,而非一个完整的开发框架。这意味着开发者需要手动处理大量的底层细节:JSON-RPC 消息的序列化与反序列化、工具 Schema 的手动定义、错误处理机制的重复实现、资源管理的复杂性等。每个工具都需要繁琐的注册流程,类型安全的缺失让调试变得困难,而异步并发处理更是增加了开发的复杂度。

在实际项目中,我们会发现,虽然 MCP 协议在架构设计上很优秀,但直接基于原始协议进行开发却充满了重复劳动。想象一下,每次添加一个新工具,都需要手动编写完整的JSON Schema,定义参数验证逻辑,处理错误响应格式,这种开发体验既低效又容易出错。更重要的是,现代Python开发已经形成了一套成熟的实践标准:类型提示、异步编程、依赖注入、自动文档生成等。而原始的 MCP 开发方式与这些现代实践之间存在明显的鸿沟。

二、协议遇见框架

正是基于这样的背景,FastMCP 应运而生。它不是一个全新的协议,而是建立在 MCP 协议之上的高性能 Python 框架。FastMCP的核心设计哲学可以概括为“保留 MCP 的全部能力,提供 Pythonic 的开发体验"。

如果说 MCP 协议定义了做什么,那么 FastMCP 就解决了怎么做的问题。它巧妙地将 MCP 的标准化要求与 Python 的开发习惯相结合,通过装饰器、类型提示、依赖注入等现代 Python 特性,让 MCP 服务器的开发变得直观而高效。

FastMCP 最引人注目的特点就是其极简的 API 设计。回想一下传统 MCP 开发中需要手动注册工具、定义 Schema 的繁琐过程,FastMCP 通过一个简单的 @mcp.tool 装饰器就实现了相同的功能。我们只需要专注于编写普通的 Python 函数,FastMCP 会自动处理类型推导、Schema 生成、协议适配等底层细节。

三、MCP简单回顾

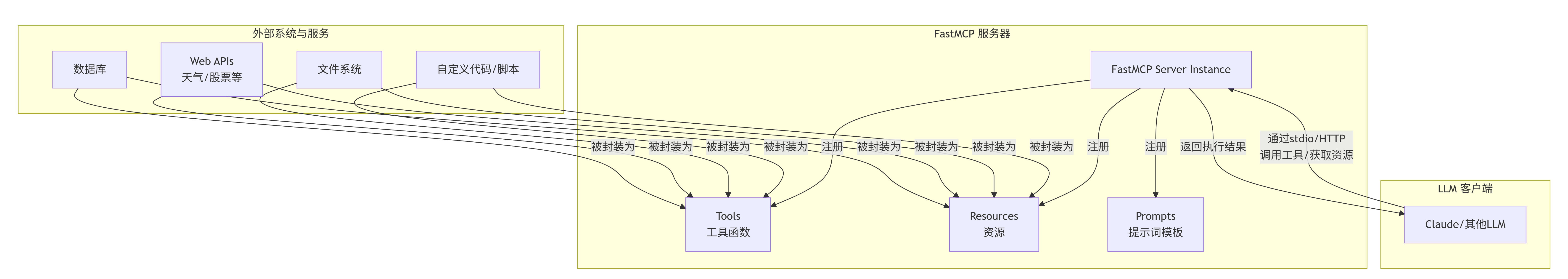

MCP(Model Context Protocol,模型上下文协议)是一个开放标准,它允许AI模型与外部工具、数据源和服务进行安全、标准化的交互。它定义了 AI 模型如何与外部工具和服务进行标准化通信的开放协议,旨在为AI模型提供标准化的工具调用接口。可以把MCP想象成AI模型的“万能遥控器”,让AI能够使用各种外部工具,从而扩展其能力。

MCP 协议给 AI 和外部资源的交互定了 3 个核心 "沟通方式":

- 工具(Tools):能让 AI 执行操作的功能按钮,比如调用计算器做加法、用地图查路线,就像给 AI 装了可动手的 "工具手"。

- 资源(Resources):给 AI 提供数据的信息库,比如公司的客户资料、官网的产品说明,这些都是只读的信息,不会被 AI 修改。

- 提示(Prompts):可重复使用的对话模板,比如客服 AI 常用的 "售后问题应答框架",不用每次都重新设计提问方式。

有了 MCP 协议,不同的 AI 和工具之间就有了统一的语言,但这套规则只是纸上的说明书,要让它真正能用,还需要像 FastMCP 这样的落地工具。

四、什么是FastMCP

1. 基本概念

FastMCP 是一个专为Python开发者设计的MCP服务器框架。它的核心价值在于:

- 极简API:通过装饰器(如 @tool)快速将普通Python函数转换为MCP工具。

- 高性能:基于异步I/O(asyncio),能够高效处理并发请求。

- 内置功能:原生支持资源(Resources)管理、提示词模板(Prompts)等MCP核心概念。

- 开发友好:提供清晰的类型提示、简单的运行方式和易于调试的结构。

2. 核心组件

一个典型的FastMCP应用包含以下核心组件:

- MCP Server:由FastMCP创建的应用实例,负责与LLM客户端通信。

- Tools(工具):服务器向客户端公开的可调用函数。它们是AI智能体的手和脚。

- Resources(资源):服务器向客户端提供的可读数据源(如文件、数据库连接)。它们是AI智能体的眼睛。

- Prompts(提示词):服务器预定义的、参数化的文本模板,客户端可以调用它们来快速构建高质量的提示。

下图清晰地展示了FastMCP在AI应用中的角色和数据流:

2.1 工具(Tools):AI的行动单元

工具是MCP的核心,使用 @mcp.tool 装饰器,我们可以将任何异步函数转变为工具,FastMCP会自动处理函数的JSON Schema生成。

关键点:

- 类型提示:强烈建议使用Python类型提示(如 str, int, List),这有助于自动生成更准确的Schema。

- 文档字符串(Docstring):函数的Docstring会被用作工具的“描述”,LLM依靠这个描述来决定是否以及如何调用该工具。描述应清晰、简洁。

- 异步:为了性能,工具函数应是异步的(async def)。

2.2 资源(Resources):AI的信息源

资源提供了对数据源的统一访问,它们本质上是具名的URI,通过 @mcp.resource 装饰器注册。当客户端请求一个资源时,服务器会返回其内容。

常见用途:

- 提供静态参考数据。

- 提供对特定文件或目录的访问。

- 作为访问数据库的入口点(虽然复杂操作仍应由工具完成)。

2.3 提示词(Prompts):AI的思维模板

提示词模板允许你预定义一些高质量的提示结构,客户端可以传入参数进行动态填充。这保证了提示词的一致性和质量。

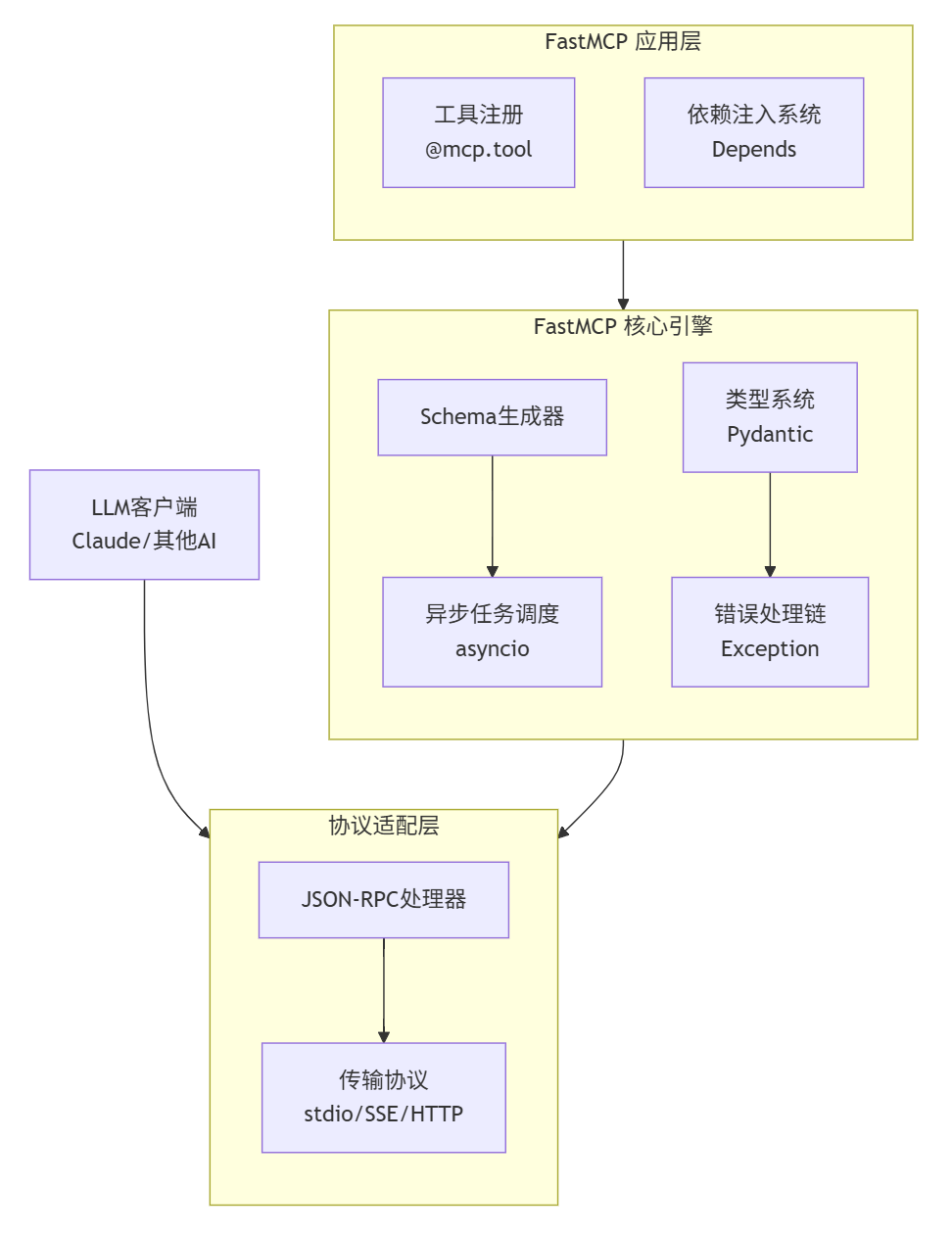

3. 架构流程

详细说明:

3.1 第一层:FastMCP 应用层 (Application Layer)

这是开发者直接交互的层面,体现了 FastMCP 的"开发友好"设计哲学。

3.1.1 工具注册 (@mcp.tool)

- 功能定位:开发者接口,将普通 Python 函数转化为 MCP 工具

- 工作方式:通过装饰器模式,以声明式方法暴露业务逻辑

- 核心价值:极大简化工具注册流程、自动提取函数文档和类型提示、提供直观的 API 设计体验

3.1.2 依赖注入系统 (Depends())

- 功能定位:资源管理和依赖解耦

- 工作方式:基于 Python 的类型提示和依赖声明

- 核心价值:自动管理数据库连接、配置信息等资源、支持依赖链的自动解析和注入、提供资源生命周期的自动化管理

3.2 第二层:FastMCP 核心引擎 (Core Engine)

这是框架的大脑,负责将应用层的声明转化为可执行逻辑。

3.2.1 Schema 生成器

- 输入:应用层收集的函数签名和类型信息

- 处理过程:

- 解析 Python 类型提示

- 提取参数约束条件

- 生成符合 JSON Schema 规范的描述

- 输出:标准化的工具 Schema,供 LLM 理解工具能力

3.2.2 类型系统 (Pydantic)

- 基础功能:基于 Pydantic 提供运行时类型验证

- 高级特性:

- 复杂类型的自动序列化/反序列化

- 自定义验证器的支持

- 数据转换和标准化

- 错误处理:在参数验证阶段捕获类型错误,提供友好错误信息

3.2.3 异步任务调度 (asyncio)

- 执行模型:基于 asyncio 的事件循环

- 并发处理:

- 管理多个并发的工具调用

- 处理 I/O 密集型操作的异步等待

- 优化资源利用率和响应速度

- 任务生命周期:从接收到请求到返回响应的完整管理

3.2.4 错误处理链

- 分层处理:

- 参数验证错误

- 业务逻辑错误

- 系统级错误(网络、数据库等)

- 统一格式化:将所有异常转化为标准的 MCP 错误响应

- 错误恢复:提供重试、降级等容错机制

3.3 第三层:协议适配层 (Protocol Adaptation Layer)

这是与外部世界通信的桥梁,确保 FastMCP 与 MCP 生态系统的无缝集成。

3.3.1 JSON-RPC 处理器

- 协议兼容:完整实现 MCP 规范的 JSON-RPC 2.0

- 消息处理:

- 请求消息的解析和验证

- 响应消息的构造和序列化

- 通知和批处理的支持

- 方法路由:将不同的 MCP 方法(tools/call, resources/list 等)路由到对应的处理器

处理的消息类型:

- tools/list - 列出可用工具

- tools/call - 调用具体工具

- resources/list - 列出可用资源

- prompts/list - 列出提示词模板

3.3.2 传输协议适配

- 多协议支持:

- stdio (标准输入输出):用于 Claude Desktop 等桌面集成

- SSE (Server-Sent Events):用于 Web 环境的长连接

- HTTP (RESTful API):用于传统的请求-响应模式

- 协议抽象:为上层提供统一的接口,屏蔽底层传输差异

- 连接管理:处理连接建立、维护和关闭的全生命周期

4. 完整数据流

4.1 请求接收

LLM客户端 → 传输协议 → JSON-RPC处理器 → 解析为内部请求对象4.2 业务处理

内部请求 → 异步任务调度 → Schema验证 → 依赖注入 → 工具执行4.3 响应返回

执行结果 → 错误处理链 → 结果格式化 → JSON-RPC响应 → 传输协议 → LLM客户端五、FastMCP的工作原理

以下将通过 “AI 调用计算器工具” 这一最简单场景,提供可直接运行的基础代码,并逐行拆解逻辑,帮你快速理解 FastMCP 的核心用法。

1. 代码示例

首先看一段完整代码,功能是:搭建一个 FastMCP 服务器,提供 “加法计算” 工具,让 AI 能通过请求调用这个工具完成计算。

# 1. 导入 FastMCP 核心类

from fastmcp import FastMCP

# 2. 初始化 FastMCP 服务器实例

mcp_server = FastMCP(

name="CalculatorServer", # 服务器名称(自定义,用于标识服务)

description="提供基础加法计算的 FastMCP 服务", # 服务描述(可选,方便协作)

version="1.0.0" # 服务版本(可选,用于迭代管理)

)

# 3. 定义“加法工具”并注册到服务器

@mcp_server.tool(

description="计算两个整数的和,输入两个整数a和b,返回它们的加和结果" # 工具描述(给AI看,帮AI判断是否调用)

)

def add(a: int, b: int) -> int:

"""实际执行加法的函数逻辑"""

return a + b

# 4. 启动 FastMCP 服务器

if __name__ == "__main__":

mcp_server.run(

host="0.0.0.0", # 允许外部设备访问(本地调试用"127.0.0.1")

port=8000 # 服务端口(自定义,确保未被占用)

)2. 代码说明

2.1 导入核心类:from fastmcp import FastMCP

- 作用:从 FastMCP 库中导入最核心的 FastMCP 类,这个类就像 “服务器的骨架”,包含了搭建服务、注册工具、启动服务的所有基础能力。

- 类比:相当于买完电脑后,先安装 “操作系统”,后续所有功能都基于这个系统展开。

2.2 初始化服务器:mcp_server = FastMCP(...)

- 核心逻辑:创建一个 FastMCP 服务器实例,给服务 “起名字、写说明”,方便后续识别和管理。

- 参数拆解:

- name="AICalculatorServer":服务的唯一标识(比如 “AI 计算器服务器”),AI 或其他服务调用时会用到这个名称。

- description="提供基础加法计算的 FastMCP 服务":可选参数,用自然语言描述服务功能,团队协作时别人能快速知道这个服务是做什么的。

- version="1.0.0":可选参数,标记服务版本(比如后续加了 “减法” 功能,可升级为 2.0.0),避免版本混乱。

- 类比:相当于给电脑设置 “设备名称” 和 “系统版本”,让别人知道这台电脑的用途和配置。

2.3 注册工具:@mcp_server.tool(...) 装饰器 + 函数

这是 FastMCP 的核心步骤 —— 把普通 Python 函数,变成 AI 能调用的 “MCP 标准工具”,关键在 @mcp_server.tool 这个 “魔法装饰器”。

2.3.1 装饰器参数:@mcp_server.tool(description="...")

- 作用:给工具写 “使用说明书”,告诉 AI 这个工具能做什么、需要什么输入。

- 为什么需要:AI 无法直接 “看懂” 函数代码,只能通过 description 判断:“我现在需要算加法,这个工具正好能做,那我就调用它”。

- 示例解读:“计算两个整数的和,输入两个整数a和b,返回它们的加和结果” 这句话,明确告诉 AI 工具的用途(算加法)、输入(a 和 b,都是整数)、输出(加和结果)。

2.3.2 工具函数:def add(a: int, b: int) -> int: return a + b

- 函数定义:普通的 Python 加法函数,但有两个关键细节是 FastMCP 要求的:

- 参数类型标注:a: int, b: int 明确输入是整数 ——FastMCP 会自动校验 AI 传来的参数类型(比如 AI 传了字符串 “3”,会自动报错,避免计算出错)。

- 返回值类型标注:-> int 明确输出是整数 —— 帮助 AI 理解返回结果的格式,方便后续处理。

- 函数逻辑:return a + b 就是实际的加法计算,这里可以替换成任何你需要的逻辑(比如减法、乘法)。

- 类比:相当于给电脑装 “计算器软件”,@mcp_server.tool 是给软件贴 “功能标签”,add 函数是软件的实际计算功能。

2.4. 启动服务器:mcp_server.run(...)

- 核心逻辑:让搭建好的服务 “跑起来”,开始监听 AI 的调用请求。

- 参数拆解:

- host="0.0.0.0":允许同一网络下的其他设备(比如你的手机、同事的电脑)访问这个服务;如果只是自己本地调试,改写成 host="127.0.0.1" 更安全(仅限自己电脑访问)。

- port=8000:服务的 “端口号”,相当于服务器的 “门牌号”——AI 调用时需要指定 “IP + 端口”(比如 http://127.0.0.1:8000)才能找到这个服务,注意要选一个没被其他软件占用的端口(比如 8001、8080 都可以)。

- 运行效果:执行代码后,控制台会显示类似这样的信息,说明服务启动成功:

INFO: Uvicorn running on http://0.0.0.0:8000 (Press CTRL+C to quit)

INFO: Started server process [11520]3. 服务验证

服务启动后,可通过 “查看自动生成的接口文档” 快速验证,步骤如下:

- 打开浏览器,输入地址 http://127.0.0.1:8000/docs(如果 host 是 0.0.0.0,也可以用电脑的局域网 IP 访问)。

- 页面会显示 FastMCP 自动生成的 Swagger 文档,能看到:

- 服务名称、版本、描述;

- 已注册的 add 工具;

- 可直接在页面上 “测试调用”(输入 a=3、b=5,点击 “Execute”,会返回结果 8)。

- 测试成功,说明服务搭建没问题,AI 后续就能通过同样的接口调用这个加法工具。

3.1 结果标准化

此处返回的结果为了让 AI 能看懂结果,FastMCP 将工具返回的结果(或错误信息)转换成 MCP 标准的 JSON 格式:

- 成功响应示例:

{

"request_id": "abc123", // 与请求中的 ID 对应,方便追踪

"status": "success", // 状态:success(成功)/ error(失败)

"result": 8, // 工具执行结果(add 函数的返回值)

"timestamp": "2024-05-20T10:30:00Z" // 结果生成时间

}- 失败响应示例(如参数类型错误):

{

"request_id": "abc123",

"status": "error",

"error": {

"code": "PARAM_TYPE_ERROR", // 错误码

"message": "参数 b 类型错误,期望 int,实际是 str" // 错误描述

},

"timestamp": "2024-05-20T10:30:00Z"

}3.2 解析展示

- FastMCP 动作:通过 HTTP 协议,将标准化的 JSON 结果返回给 AI 端;

- AI 端解析:AI 读取结果中的 status 和 result(或 error):

- 若 status=success,则用 result=8 生成回答(如 “3 加 5 的结果是 8”);

- 若 status=error,则根据 error.message 调整请求(如修正参数类型后重新调用)。

- 类比:相当于 “计算器 APP 显示计算结果 8,用户看到结果后知道最终答案”。

4. 功能扩展

理解基础逻辑后,添加新工具非常简单,只需复制 “装饰器 + 函数” 的结构即可。比如添加减法工具:

# 新增减法工具

@mcp_server.tool(

description="计算两个整数的差,输入被减数a和减数b,返回a-b的结果"

)

def subtract(a: int, b: int) -> int:

return a - b- 重启服务后,访问 http://127.0.0.1:8000/docs,就能看到 subtract 工具,同样可以测试调用。

5. 示例总结

通过这个示例能发现:FastMCP 的核心是用装饰器简化 MCP 协议的复杂逻辑,让我们不用关注底层通信细节,只需专注工具要实现什么功能,这也是它能大幅降低 AI 连接工具门槛的关键。

FastMCP 之所以能简化 “AI 连接工具” 的过程,核心是在流程中做了 3 个关键 “减负” 动作:

- 自动协议转换:开发者不用手动写 MCP 协议的请求 / 响应格式,FastMCP 自动完成 “普通函数→MCP 工具”“工具结果→MCP 标准结果” 的转换;

- 自动校验防错:从请求格式、工具存在性到参数类型,全流程自动校验,避免开发者手动写大量判断逻辑;

- 低门槛集成:只需装饰器 + 普通函数,就能搭建合规的 MCP 服务,不用理解底层的 HTTP 通信、协议规范等复杂知识。

六、总结

从 MCP 到 FastMCP 的演进,本质上是从协议遵从到开发体验优化的转变。MCP 协议确保了互操作性和标准化,而 FastMCP 则在这一基础上提供了令人愉悦的开发体验。这种演进反映了软件开发的一个普遍规律:优秀的协议或标准需要配以同样优秀的实现框架,才能真正发挥其潜力。FastMCP 正是这样一个桥梁,它连接了 MCP 协议的严谨性与 Python 开发的灵活性,让我们能够在遵循标准的同时,享受现代开发工具带来的便利。

FastMCP作为一个轻量级、高性能的MCP服务器框架,成功地降低了为LLM构建外部工具的门槛。通过其直观的装饰器API和对MCP协议的完整支持,能够更快速地将现有的Python代码和能力暴露给AI智能体,从而创造出功能强大、安全可控的AI应用。

原创声明:本文系作者授权腾讯云开发者社区发表,未经许可,不得转载。

如有侵权,请联系 cloudcommunity@tencent.com 删除。

原创声明:本文系作者授权腾讯云开发者社区发表,未经许可,不得转载。

如有侵权,请联系 cloudcommunity@tencent.com 删除。

评论

登录后参与评论

推荐阅读

目录