二手车业务数字化平台架构实践

原创摘要

本文以某大型汽车企业的二手车业务管理平台为实际案例,深入剖析汽车行业数字化转型中的整体架构设计理念与落地实践。文章重点阐述三大核心架构原则:业务单元彻底拆分、数据全链路打通、外部系统深度集成。通过微服务化改造、事件驱动架构、容器化部署等现代化技术手段,成功实现了系统可用性从 95% 提升至 99.5%、并发能力提升 400%、API 响应时间降低 80% 的显著成效。

一、传统架构痛点

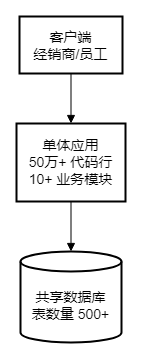

在数字化转型前,该汽车企业的业务管理平台采用传统单体架构,整个系统包含超过 50 万行代码,所有业务模块(订单管理、拍卖系统、车辆管理、返利计算、经销商管理等)都紧密耦合在同一个应用程序中,共享单一数据库。这种架构在早期业务规模较小时能够快速满足需求,但随着业务快速增长和市场竞争加剧,单体架构的弊端逐渐显现。

三大核心痛点:

1. 部署耦合 - 任何改动都需整体发布

单体应用中,即使只修改一个小功能(如修改返利计算规则),也必须重新构建整个应用并全量部署。这导致每次发布都需要停机维护窗口,影响所有用户使用。更严重的是,一个模块的 Bug 可能导致整个系统宕机,风险极高。

在实际运营中,每次发布需要协调所有业务团队进行回归测试,发布窗口往往需要预约到深夜或周末,严重影响业务迭代速度。版本发布周期被拉长至 2-4 周,无法满足业务快速试错的需求。

2. 性能瓶颈 - 单点故障影响全局

拍卖业务具有明显的峰值特征,拍卖会期间大量经销商同时在线出价,系统并发请求激增。但由于所有模块共享相同的计算资源和数据库连接池,拍卖的流量高峰会挤占其他业务的资源,导致订单查询、车辆浏览等日常操作也变得缓慢甚至超时。

数据库层面,所有业务混用同一个数据库实例,拍卖的频繁写入操作与订单的复杂查询相互竞争,经常出现死锁和慢查询。系统整体并发能力被限制在约 200 TPS,高峰期响应时间恶化至 800ms 以上,用户体验极差。

3. 数据孤岛 - 信息分散难以统一管理

由于历史原因,企业内部存在多个独立系统:CRM 系统、中台车型配置系统、财务系统、物流系统等。这些系统各自维护车辆信息、客户信息、订单状态,但缺乏统一的数据视图。一辆车的状态可能在拍卖系统显示"已成交",但车辆系统仍显示"待拍卖",订单系统尚未生成对应订单,导致数据不一致。

销售人员在处理客户咨询时,需要登录多个系统查询信息并手工核对数据,效率低下且容易出错。数据不一致问题每月高达 50 例以上,需要专人进行数据对账和修复,耗费大量人力成本。

二、核心架构原则

基于对传统架构痛点的深刻理解,我们提出了三大核心架构原则,作为数字化转型的指导思想。

2.1 业务单元彻底拆分

核心理念:将单体应用按业务领域拆分成独立的微服务,每个服务拥有独立的数据库、独立的部署流程、独立的技术选型权。"彻底拆分"意味着不仅仅是代码层面的模块化,而是从数据库、部署、团队组织等多个维度实现完全解耦。

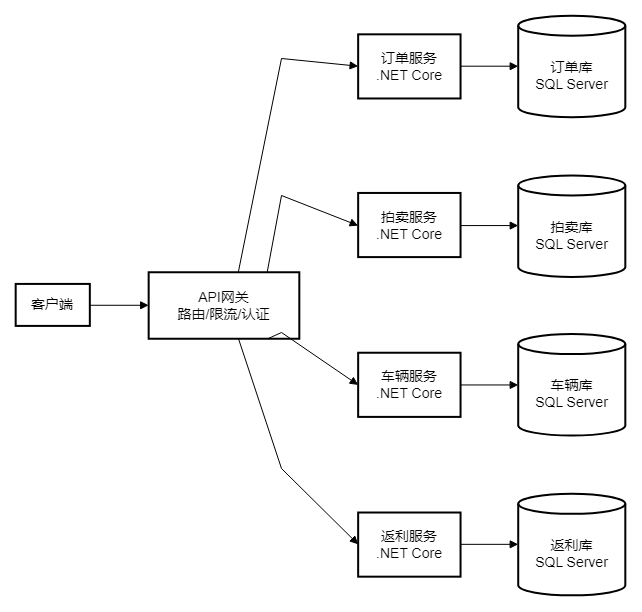

目标架构

架构设计说明:

API 网关作为系统唯一入口,负责统一的认证鉴权、流量控制、请求路由。后端按业务领域拆分为四个核心微服务:

● 订单服务:处理订单创建、支付、状态流转等核心交易逻辑

● 拍卖服务:实现实时竞拍、出价历史、拍卖会管理等高并发场景

● 车辆服务:管理车辆库存、车辆状态、车辆主数据

● 返利服务:计算返利金额、审批流程、返利发放

每个服务拥有独立的数据库实例,避免了数据库层面的耦合和资源竞争。服务间通过 RESTful API 或消息队列进行通信,而非直接访问其他服务的数据库。

拍卖业务流程(实战案例)

拍卖业务是最先进行微服务改造的模块,因为它具有以下特点:业务边界清晰、性能要求高、流量波动大、对其他模块依赖较少。以下是拍卖从出价到成交的完整流程。

流程详解:

步骤 1-4:出价阶段(高频实时操作)

经销商在拍卖页面点击出价,前端通过 WebSocket 连接将出价请求发送到拍卖系统。系统首先进行业务校验:出价金额是否符合最低加价幅度(如每次至少加价 1000 元)、经销商账户余额是否充足、是否在拍卖时间窗口内等。

校验通过后,系统使用 Redis 分布式锁确保出价的原子性(同一时刻只有一个出价能够成功),将出价记录写入 Redis 缓存以支持快速查询,同时异步持久化到数据库。出价结果通过 SignalR 实时推送给所有在线经销商,实现"你出价-我立刻收到通知-我可以继续加价"的流畅体验。

步骤 5-8:成交阶段(跨服务协调)

拍卖倒计时结束后,系统确定最高出价者为中标经销商。此时需要协调多个服务完成后续操作:

① 调用车辆服务 API 将车辆状态从"拍卖中"改为"已成交",防止车辆被重复拍卖 ② 调用订单服务 API 创建订单,记录成交价格、买方、卖方等信息 ③ 如果任何一步失败,触发补偿操作(如解锁车辆、取消订单)

步骤 9-10:通知阶段(异步解耦)

通知操作(发送邮件、短信)是耗时且非核心的业务逻辑,因此采用消息队列异步处理。拍卖系统将通知消息发送到 RabbitMQ,立即返回成功响应给前端,由独立的通知服务消费队列并发送通知。即使邮件服务暂时不可用,也不会影响拍卖主流程。

架构收益(实测数据):

指标 | 改造前(单体) | 改造后(微服务) | 提升幅度 |

|---|---|---|---|

拍卖并发能力 | 50 TPS | 200 TPS | ↑ 300% |

系统响应时间 | 800ms(P99) | 150ms(P99) | ↓ 81% |

独立部署周期 | 2周 | 2天 | ↓ 85% |

单场拍卖容量 | 50 人同时在线 | 200 人同时在线 | ↑ 300% |

拍卖系统拆分后,可以独立部署和扩容,高峰期通过 Kubernetes HPA(水平自动扩容)自动增加 Pod 副本数,无需停机即可应对流量激增。其他业务模块的发布也不再影响拍卖系统的稳定运行。

2.2 数据全链路打通

核心理念:在微服务架构下,数据分散在各个服务的独立数据库中,如何确保数据一致性和完整性是最大挑战。"数据全链路打通"意味着通过事件驱动架构和主数据管理,实现数据在不同服务间的实时同步和统一视图,消除数据孤岛。

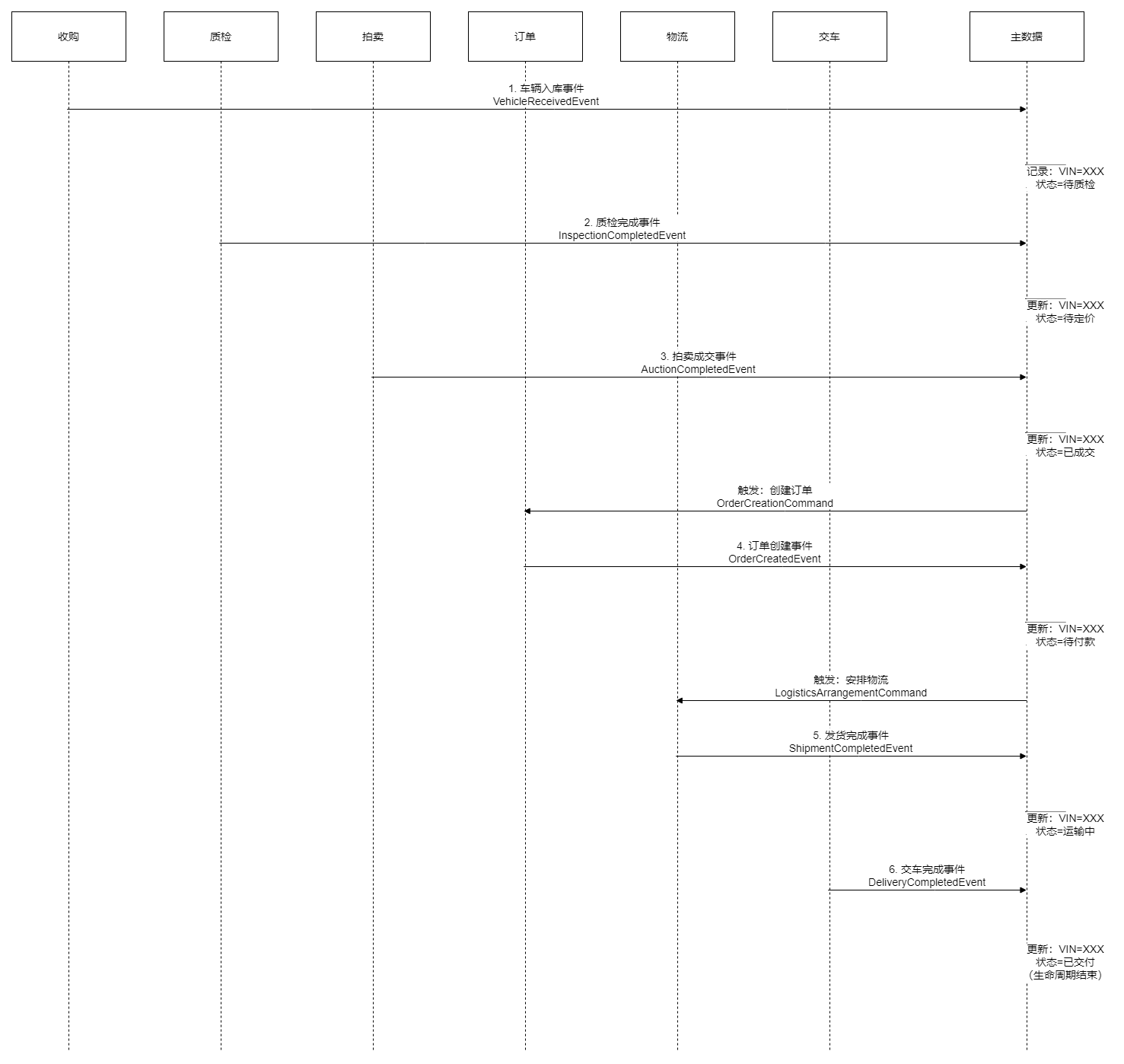

车辆生命周期数据流

一辆二手车从收购到最终交付给客户,会经历多个业务环节,每个环节由不同的微服务负责。通过事件驱动架构,车辆状态变更能够实时传播到所有相关系统。

架构详解:

主数据服务(Master Data Management)

主数据服务维护车辆的"黄金记录"(Golden Record),即车辆的权威状态和完整信息。它通过订阅其他服务发布的事件,实时更新车辆状态,并提供统一的查询接口。

例如,质检服务完成车辆检测后,发布 InspectionCompletedEvent 事件到消息队列,主数据服务监听该事件并更新车辆状态为"待定价"。同时,主数据服务还会记录状态变更的时间戳和操作人,形成完整的车辆生命周期轨迹。

事件驱动的好处:

① 解耦:质检服务无需关心谁需要车辆状态信息,只需发布事件即可

② 可扩展:未来新增的服务(如财务系统)可以订阅同一事件,无需修改现有代码

③可追溯:事件流形成不可变的审计日志,支持故障排查和业务分析

事件驱动架构

技术选型:

● 消息队列:RabbitMQ,支持多种消息模式(发布/订阅、工作队列、RPC)

● 事件格式:JSON,包含事件类型、业务数据、时间戳、关联 ID 等标准字段

● 消息可靠性:生产者确认、消费者 ACK、死信队列、消息持久化

实施要点:

1. 事件命名规范:使用领域语言,如 VehicleReceivedEvent、AuctionCompletedEvent

2. 事件版本管理:事件结构变更时保持向后兼容,或使用版本号区分

3. 幂等性设计:消费者需要处理重复消息(如通过消息 ID 去重)

4. 监控告警:监控消息堆积、消费延迟、失败率等指标

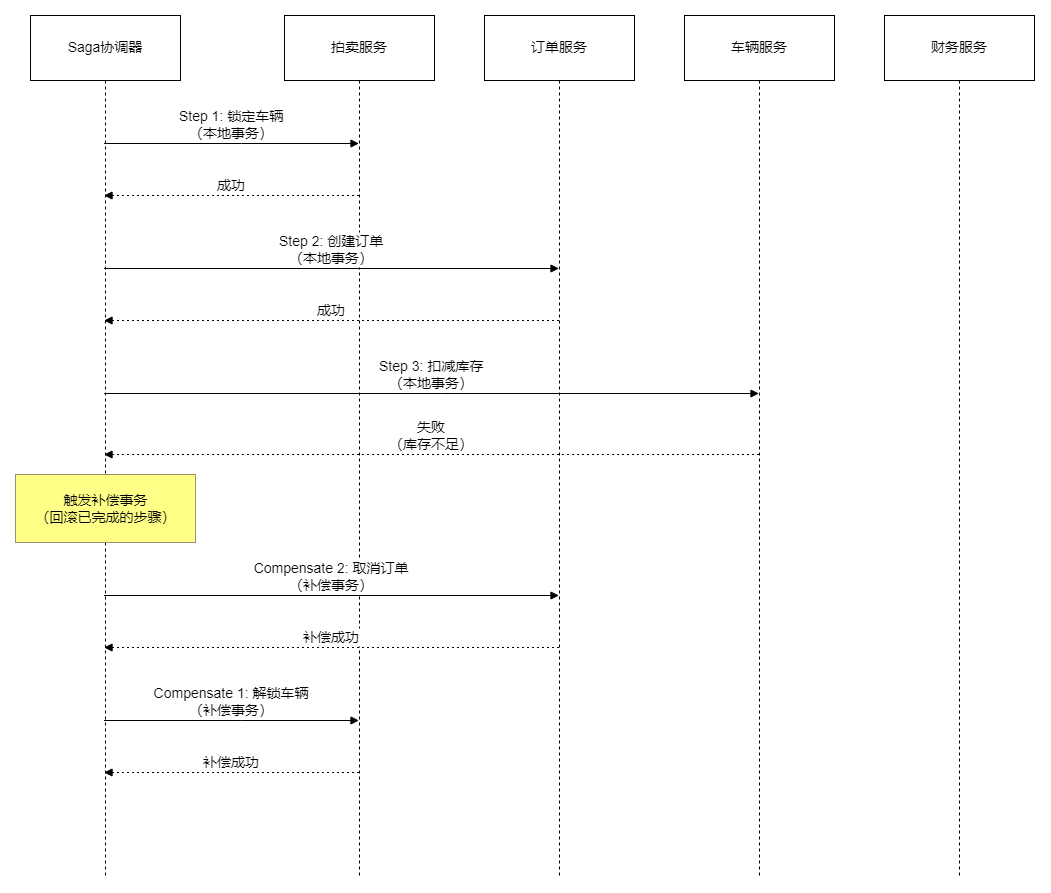

分布式事务(Saga 模式)

在微服务架构下,一个业务操作可能涉及多个服务的数据修改。传统的分布式事务(如两阶段提交)性能开销大且不适合高并发场景。Saga 模式通过一系列本地事务和补偿事务来保证最终一致性。

Saga 实战案例:拍卖成交后的多服务协调

拍卖结束后,需要依次完成以下操作:

1. 拍卖服务:锁定车辆,标记为已成交

2. 订单服务:创建订单

3. 车辆服务:扣减库存(如果车辆来自库存池)

4. 财务服务:生成应收单

如果任何一步失败,Saga 协调器会按相反顺序执行补偿操作:

● 如果订单创建失败 → 解锁车辆

● 如果扣减库存失败 → 取消订单 → 解锁车辆

● 如果生成应收单失败 → 恢复库存 → 取消订单 → 解锁车辆

Saga 实施要点:

1. 补偿逻辑设计:每个正向操作都需要设计对应的补偿操作

2. 状态持久化:协调器需要持久化 Saga 执行状态,以支持失败重试

3. 超时处理:设置合理的超时时间,避免无限等待

4. 监控告警:监控 Saga 执行成功率、平均耗时、补偿频率

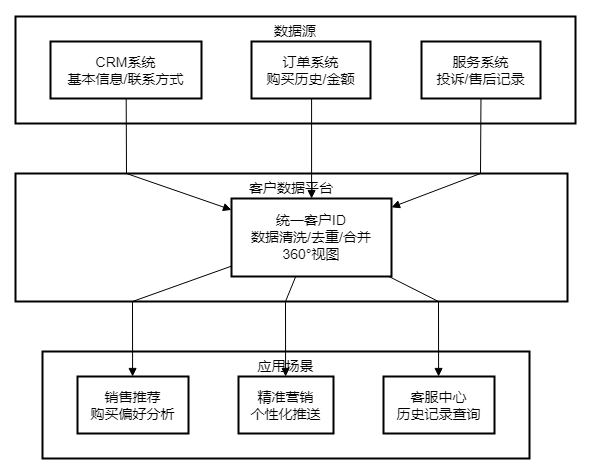

客户360°视图(Customer Data Platform)

客户数据平台(CDP)的价值:

在传统架构中,客户信息分散在 CRM、订单、服务等多个系统中,且存在数据不一致问题:

● CRM 中客户手机号是 157****1299

● 订单系统中同一客户手机号是 191****0935

● 无法识别这是同一个客户

CDP 通过多种匹配规则(手机号、身份证号、邮箱、企业名称等)将分散的客户数据进行去重和合并,形成"统一客户 ID"(Unified Customer ID)。每个客户在 CDP 中只有一条黄金记录,包含完整的属性和标签。

实际应用场景:

1. 销售推荐:销售人员查看客户资料时,能看到客户的购买历史、偏好车型、历史报价,从而提供更精准的推荐

2. 精准营销:市场部门发起促销活动时,能够按标签筛选目标客户(如"购买过豪华车型"且"近三个月未再次购买"的客户),提高转化率

3. 客服中心:客户来电咨询时,客服能立即看到客户的完整历史记录(购买记录、投诉记录、售后服务记录),快速定位问题

数据打通收益(实测数据):

指标 | 改造前(单体) | 改造后(微服务) | 提升幅度 |

|---|---|---|---|

数据不一致案例 | 50 例/月 | 2-3 例/月 | ↓ 95% |

客户信息查询响应 | 5-10 秒 | <100ms | ↓ 98% |

数据对账工作量 | 3-5 人天/周 | 0.5 人天/周 | ↓ 87% |

客户投诉处理时长 | 平均 2 小时 | 平均 30 分钟 | ↓ 75% |

2.3 外部系统深度集成

核心理念:汽车行业的数字化平台不是孤立的系统,需要与企业内部的中台系统、集团级的身份认证系统、外部的第三方服务(支付、物流、云存储)深度集成。"深度集成"意味着不仅仅是数据对接,还包括认证鉴权统一、服务编排、异常处理等。

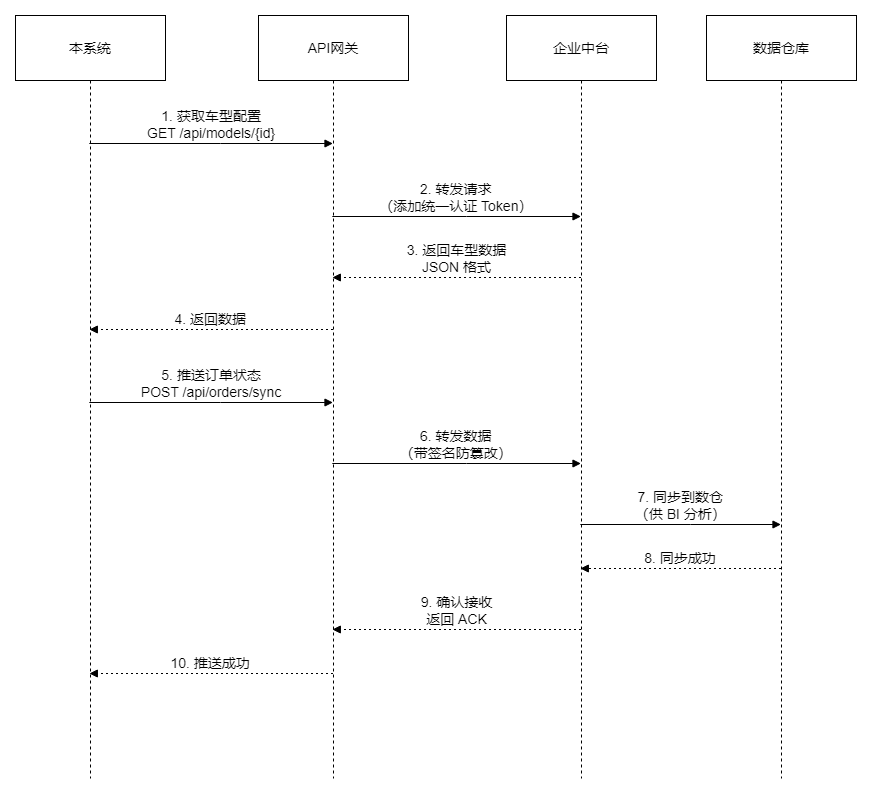

企业中台集成

企业中台系统(如车型配置中台、数据中台)是集团统一建设的共享服务平台,各业务系统需要从中台获取车型信息、价格信息、库存信息等。集成方式采用 API 网关 + RESTful API。

集成要点:

1. 统一认证:所有调用中台的请求需要携带统一认证 Token,由 API 网关统一管理

2. 数据格式约定:中台和业务系统之间的数据格式需要严格约定(如日期格式、枚举值定义)

3. 容错处理:中台服务不可用时,业务系统需要降级处理(如使用缓存数据、提示用户稍后重试)

4. 监控告警:监控中台接口调用成功率、响应时间,及时发现问题

实际案例:车型配置同步

业务系统需要从中台获取最新的车型配置信息(如某款车型的颜色选项、内饰选项、官方指导价)。中台每天凌晨更新车型数据,业务系统通过定时任务调用中台 API 拉取增量数据并更新本地缓存。

如果中台服务暂时不可用,业务系统使用本地缓存的车型数据,并在页面上提示"车型信息可能不是最新,请以实际为准"。同时发送告警给运维人员,确保问题及时修复。

SSO 单点登录(统一身份认证)

企业内部有多个业务系统(本系统、中台系统、OA 系统、HR 系统),每个系统独立维护用户账号会导致用户体验差(需要记住多套账号密码)且存在安全风险。通过 SSO 单点登录,用户只需登录一次即可访问所有系统。

SSO 实施方案:

1. 认证中心:基于 IdentityServer4 或类似开源框架构建,支持 OAuth2.0 / OpenID Connect 协议

2. 企业目录:对接集团 AD(Active Directory)或 LDAP,统一用户管理

3. Token 格式:JWT(JSON Web Token),包含用户 ID、角色、权限等信息

4. 安全机制:Token 签名防篡改

a. Token 有效期(如 2 小时)+ 刷新机制

b. HTTPS 加密传输

c. 跨域请求防护(CORS)

用户体验提升:

改造前,用户访问本系统、中台系统、OA 系统需要分别登录三次,且账号密码可能不一致。改造后,用户只需在认证中心登录一次,后续访问任何系统都自动通过认证,显著提升用户体验。

第三方服务集成

系统集成了 7 大类第三方服务,覆盖支付、存储、认证、AI 识别等核心场景。支付服务对接招商银行 API 处理订单支付和退款,采用异步回调机制确保支付状态实时同步。云存储使用华为云 OBS 存储车辆图片和合同文件,通过预签名 URL 实现安全访问控制。身份认证对接企业 AD 实现 SSO 单点登录,支持 LDAP 和 SAML 2.0 协议。AI 能力集成阿里云 OCR 服务,自动识别身份证、行驶证等证件信息,大幅提升录入效率。物流追踪对接顺丰 API,通过定时轮询机制实时获取车辆运输轨迹。短信通知和地图服务分别使用阿里云和高德地图的标准 SDK 接入。

集成收益(实测数据):

指标 | 改造前(单体) | 改造后(微服务) | 提升幅度 |

|---|---|---|---|

数据同步延迟 | 24 小时 | 5 分钟 | ↓ 99% |

人工维护工作 | 需要人工导入/导出 | 自动同步 | 100% 自动化 |

数据准确率 | 95% | 99.9% | ↑ 4.9% |

支付成功率 | 92% | 98.5% | ↑ 7% |

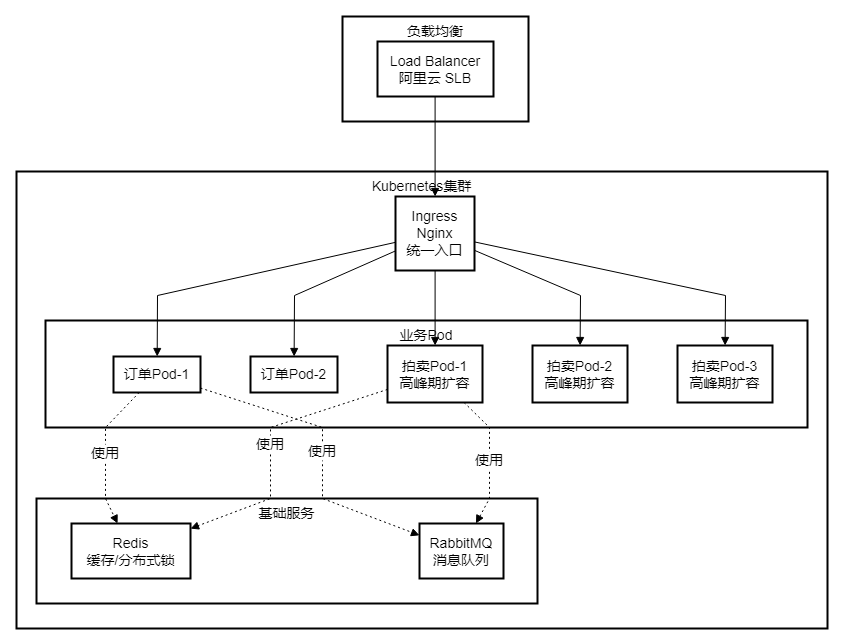

三、容器化部署架构

3.1 Kubernetes 集群架构

为了支持微服务的弹性扩展和高可用部署,系统采用 Kubernetes(K8s)作为容器编排平台。K8s 提供了自动化部署、扩缩容、故障恢复等能力,是微服务架构的最佳实践。

架构说明:

1. 负载均衡层

阿里云 SLB(Server Load Balancer)作为系统的最外层入口,接收所有外部流量。SLB 支持健康检查、会话保持、流量分发等功能,确保高可用。

2. Ingress 层

Ingress 是 K8s 的统一入口,基于 Nginx 实现。它负责:

● 路由规则:根据 URL 路径将请求转发到不同的服务(如 /api/orders 转发到订单服务,/api/auctions 转发到拍卖服务)

● SSL 终止:在 Ingress 层处理 HTTPS 加密,后端服务使用 HTTP 通信

● 限流保护:对异常流量进行限流,防止 DDoS 攻击

3. 业务 Pod 层

每个微服务部署为多个 Pod 副本,通过 K8s Service 进行负载均衡。订单服务部署 2 个副本,拍卖服务在高峰期自动扩容至 3-5 个副本。

4. 基础服务层

Redis 和 RabbitMQ 作为有状态服务,使用 K8s StatefulSet 部署,挂载持久化存储(PVC)确保数据不丢失。

K8s 关键配置:

每个微服务部署为 Deployment 资源,配置基础副本数(如拍卖服务 2 个副本)和资源限额(CPU 500m-1000m,内存 512Mi-1Gi)。通过存活探针(Liveness Probe)和就绪探针(Readiness Probe)实现健康检查,确保故障 Pod 自动重启和流量准确转发。HPA(水平自动扩容)根据 CPU 使用率动态调整副本数:平时保持 2 个 Pod 满足日常需求,当 CPU 超过 70% 时自动扩容至 5-10 个 Pod 应对高峰流量,流量回落后自动缩容节约资源。

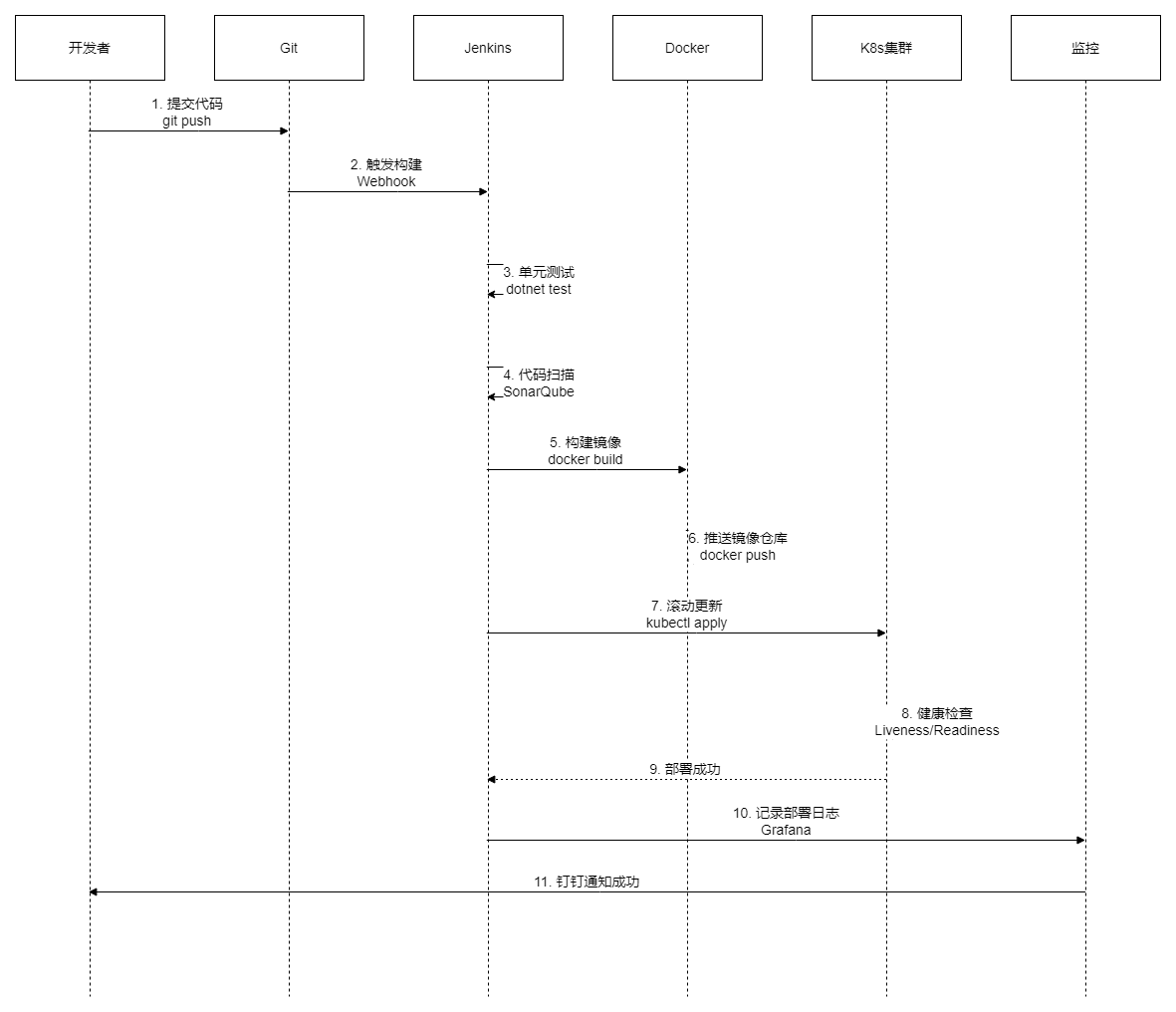

3.2 CI/CD 流水线

为了支持快速迭代和频繁发布,系统构建了完整的 CI/CD 流水线,实现从代码提交到生产环境部署的全自动化。

流水线详解:

步骤 1-2:代码提交触发

开发者提交代码到 Git 仓库(GitLab),GitLab 通过 Webhook 自动触发 Jenkins 构建任务。支持多分支构建:

● dev 分支 → 自动部署到开发环境

● uat 分支 → 自动部署到测试环境

● master 分支 → 需人工审批后部署到生产环境

步骤 3-4:质量检查

● 单元测试:运行 dotnet test,执行所有单元测试用例,代码覆盖率需达到 60% 以上

● 代码扫描:使用 SonarQube 进行静态代码分析,检查代码规范、安全漏洞、代码坏味道

如果测试失败或代码质量不达标,流水线中断,开发者收到通知并修复问题。

步骤 5-6:镜像构建

Jenkins 执行 Docker 构建命令,将应用程序打包成 Docker 镜像,并推送到私有镜像仓库(Harbor)。镜像使用语义化版本号标记(如 v1.2.3),方便回溯。

步骤 7-9:滚动更新

Jenkins 调用 kubectl apply 命令,将新版本镜像部署到 K8s 集群。K8s 采用滚动更新策略:

1. 启动 1 个新版本 Pod

2. 等待新 Pod 通过健康检查(Readiness Probe)

3. 将流量切换到新 Pod

4. 停止 1 个老版本 Pod

5. 重复步骤 1-4,直到所有 Pod 都更新完成

滚动更新确保服务不中断,用户无感知。

步骤 10-11:监控通知

部署完成后,Jenkins 将部署信息(版本号、部署时间、操作人)记录到 Grafana,并通过钉钉机器人通知团队成员。如果部署失败,立即触发告警。

CI/CD 带来的效率提升:

指标 | 改造前(单体) | 改造后(微服务) | 提升幅度 |

|---|---|---|---|

部署时间 | 60 分钟 | 15 分钟 | ↓ 75% |

发布频率 | 每月 1 次 | 每天多次 | ↑ 30 倍 |

回滚时间 | 30 分钟(重新部署) | 5 分钟(kubectl rollback) | ↓ 83% |

人为操作错误 | 偶尔发生 | 几乎为零 | ↓ 95% |

四、监控与运维

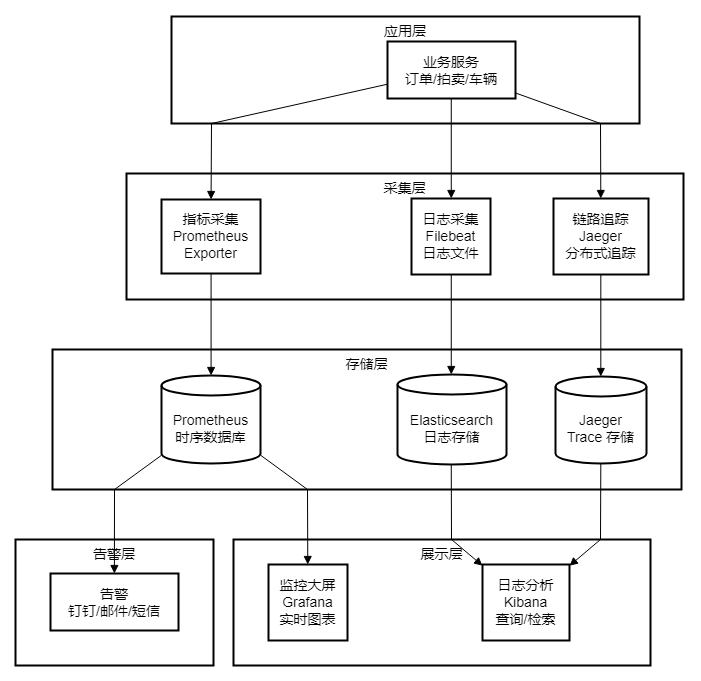

4.1 监控架构

现代微服务架构需要完善的可观测性体系,包括指标监控(Metrics)、日志分析(Logs)、链路追踪(Traces)三大支柱。

三大支柱详解:

1. 指标监控(Prometheus + Grafana)

Prometheus 负责采集和存储时序数据,包括:

● 系统指标:CPU、内存、磁盘、网络

● 应用指标:QPS(每秒请求数)、响应时间、错误率

● 业务指标:拍卖场次、成交量、订单金额

Grafana 将这些指标可视化为实时大屏,运维人员能直观地看到系统运行状况。

2. 日志分析(ELK Stack)

Filebeat 采集应用程序日志文件,发送到 Elasticsearch 集中存储。Kibana 提供强大的查询和分析能力:

● 按关键词搜索日志(如查询某个订单号的所有日志)

● 按时间范围筛选日志(如查看最近 1 小时的错误日志)

● 日志聚合分析(如统计错误日志的 Top 10 错误类型)

3. 链路追踪(Jaeger)

在微服务架构下,一个用户请求可能涉及多个服务的调用(如拍卖成交 → 车辆服务 → 订单服务 → 财务服务)。Jaeger 通过 Trace ID 将这些调用串联起来,形成完整的调用链路,帮助排查性能瓶颈和错误根因。

例如,用户投诉"拍卖页面加载很慢",通过 Jaeger 可以看到:

● 总响应时间:1200ms

● 其中调用车辆服务耗时:50ms

● 调用订单服务耗时:1100ms(瓶颈!)

● 进一步分析订单服务的慢查询 SQL

4.2 告警流程

监控系统不仅要采集数据,更重要的是在检测到异常时及时告警,并尽可能自动修复。

告警规则配置:

Prometheus 配置了三类核心告警规则,覆盖应用层和基础设施层的关键指标。错误率告警监控 HTTP 5xx 错误,当 5 分钟内错误率超过 5% 时触发 Critical 级别告警,确保服务质量问题第一时间响应。响应时间告警监控 P99 响应时间,超过 1 秒阈值持续 5 分钟触发 Warning 级别告警,提示潜在的性能瓶颈。Pod 重启告警监控容器异常重启频率,最近 1 小时内重启超过 0.5 次/小时即发出警告,帮助及时发现应用稳定性问题。告警规则支持聚合和去重,避免告警风暴影响值班人员判断。

自动修复机制:

系统针对常见性能问题建立了三层自动修复能力。当 CPU 使用率超过 80% 持续 5 分钟时,触发自动扩容增加 Pod 副本分担负载。Pod 健康检查连续失败 3 次时,K8s 自动重启 Pod 恢复服务。请求量突增触发流量熔断时,API 网关自动启动限流保护核心服务。

告警分级策略:Critical 级别告警(如服务不可用、错误率超 10%)通过电话和钉钉立即通知值班人员,要求 5 分钟内响应。Warning 级别告警(如响应时间变慢、CPU 使用率偏高)通过钉钉消息通知,白天工作时间处理即可。Info 级别事件(如部署成功、定时任务执行)仅记录日志不发送通知,避免信息过载。

五、典型业务场景

5.1 拍卖成交全流程

拍卖是整个平台最复杂的业务场景,涉及实时竞价、多服务协调、异步通知等多个环节。以下展示一次完整的拍卖成交流程。

场景解读:

竞价阶段(步骤 1-2)

两位经销商通过 WebSocket 实时连接拍卖系统,出价操作响应时间在 100ms 以内。每次出价后,系统立即推送最新状态给所有在线经销商,营造紧张刺激的竞拍氛围。

拍卖系统使用 Redis 分布式锁确保同一时刻只有一个出价能够成功,避免并发冲突。所有出价记录都写入数据库,形成完整的出价历史供审计使用。

成交阶段(步骤 3-5)

拍卖倒计时结束后(如 10:00:00 整),系统锁定最高出价者为中标经销商。此时需要协调多个服务:

锁定车辆:调用车辆服务 API,将车辆状态从"拍卖中"改为"已成交",防止车辆被重复拍卖;

创建订单:调用订单服务 API,生成订单记录,包含买方、卖方、成交价格、车辆信息等;

生成应收单:订单服务进一步调用财务系统,生成应收单,记录经销商应支付的金额;

这三个操作通过 Saga 模式协调,如果任何一步失败,触发补偿事务回滚已完成的操作。

物流阶段(步骤 6-7)

订单创建成功后,自动触发物流服务安排发运。物流系统根据经销商地址、车辆位置计算最优运输路线,并生成物流单。经销商通过邮件和短信收到发货通知,包含物流单号和预计到达时间。

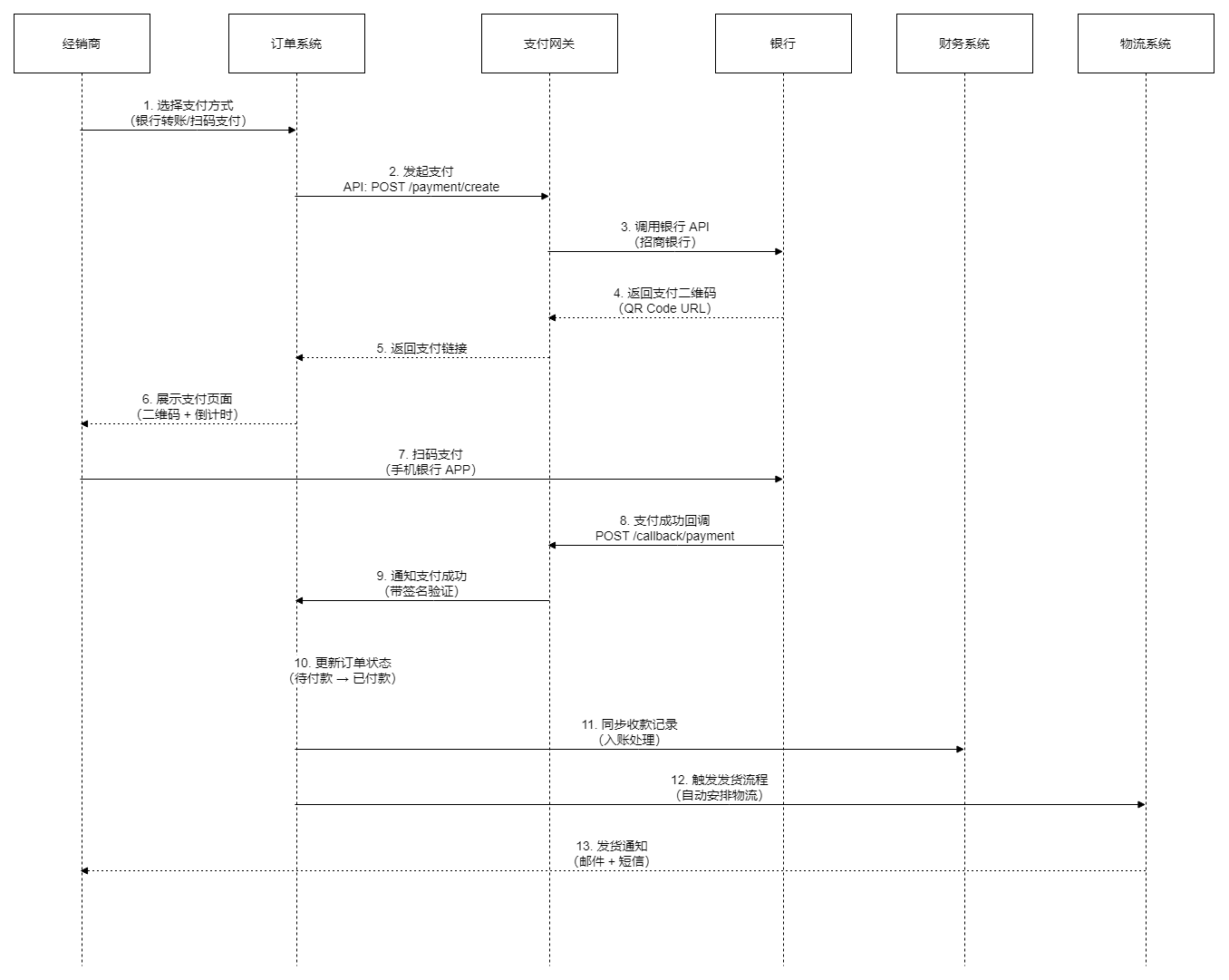

5.2 订单支付流程

支付流程详解:

步骤 1-6:支付发起

经销商在订单详情页点击"立即支付",选择支付方式(银行转账或扫码支付)。系统生成支付订单,调用招商银行 API 获取支付二维码,前端展示二维码和 30 分钟倒计时。

步骤 7-9:支付完成

经销商使用手机银行 APP 扫码支付,银行处理支付请求并扣款。支付成功后,银行通过异步回调通知我们的支付网关,支付网关验证签名后通知订单系统。

异步回调的挑战:

银行回调可能出现以下情况:

● 重复回调:银行可能多次推送同一支付结果,需要幂等性处理

● 延迟回调:支付成功到回调到达可能有几秒到几分钟的延迟

● 回调失败:网络问题导致回调未到达,需要主动查询支付结果

解决方案:

● 幂等性:使用支付订单号作为唯一键,重复回调不会重复入账

● 主动查询:回调超时(如 5 分钟未收到),系统主动调用银行查询接口

● 补偿机制:对账任务每日凌晨执行,比对银行流水和系统记录,修复遗漏

5.3 返利计算流程

返利规则引擎:

返利政策涉及项目类型、车型、客户等级、成交价比例等多个维度。

传统硬编码方式每次调整政策都需要修改代码。

规则引擎将规则配置化后,业务人员可通过后台界面灵活调整。规则引擎采用 JSON 格式定义条件和动作,支持等于、大于、小于等多种运算符。例如:留学生项目且车价超过 20 万的订单,返利计算包含固定金额 5000 元加成交价 2% 的比例返利。当成交价为 30 万元时,系统自动计算返利总额为 11000 元(5000 + 30 万 × 2%)。

六、核心要点总结

6.1 三大架构原则

业务单元彻底拆分:按业务领域拆分服务(订单、拍卖、车辆、返利),每个服务独立数据库独立部署独立技术选型,带来并发能力提升 400%、部署周期缩短 85%、故障有效隔离的价值。

数据全链路打通:打通车辆状态、订单状态、客户信息等核心数据,通过事件驱动加主数据平台加 Saga 分布式事务实现,数据不一致率降低 95%、查询速度提升 98%。

外部系统深度集成:集成企业中台、SSO 认证、第三方服务(支付物流云存储),通过 API 网关加统一认证加异常处理实现,数据同步延迟从 24 小时降至 5 分钟、人工维护工作减少 100%。

6.2 关键成功因素

组织保障:成立数字化转型专项委员会由 CTO 牵头业务技术运维共同参与,明确架构师和各微服务负责人建立清晰责任矩阵,定期召开架构评审会议,并及时解决跨团队协作问题。

技术选型:选择经过生产验证的成熟技术栈(K8s、RabbitMQ、Prometheus)避免过度创新降低技术风险,关注社区活跃度确保长期技术支持。

人员能力:对技术团队进行微服务容器化 DevOps 等技术培训,引入外部咨询公司专家进行架构设计评审和技术指导,注重知识库的建立和最佳实践的经验沉淀。

风险控制:采用灰度发布策略先小流量验证再全量上线,保留快速回滚机制紧急情况下 5 分钟内回滚,建立完善监控告警体系第一时间发现问题。

原创声明:本文系作者授权腾讯云开发者社区发表,未经许可,不得转载。

如有侵权,请联系 cloudcommunity@tencent.com 删除。

原创声明:本文系作者授权腾讯云开发者社区发表,未经许可,不得转载。

如有侵权,请联系 cloudcommunity@tencent.com 删除。

评论

登录后参与评论

推荐阅读

目录