AI音乐与智能技术的双向奔赴

原创AI音乐与智能技术的双向奔赴

原创

七条猫

发布于 2025-12-27 16:24:51

发布于 2025-12-27 16:24:51

深夜两点,电脑屏幕发出的蓝光映照着疲惫的脸庞。作为一名在音乐爱好者,我依然清晰地记得第一次听到AI生成的旋律时的那种震撼——那不是简单的音符堆砌,而是一种有着呼吸感的、仿佛被赋予了灵魂的声响。

那一刻,我突然意识到,我们站在了一个新的历史节点上。音乐,这门人类最古老的艺术形式之一,正在与最前沿的人工智能技术发生着前所未有的化学反应。我打算自己试试用AI生成音乐,啊哈哈哈

一、 从自动钢琴到算法作曲:音乐与机器的百年纠葛

如果说现在的人工智能音乐创作是"智能"的体现,那么早在两百年前,人类就已经开始尝试让机器"演奏"音乐了。1780年代发明的机械人偶"The Mechanical Turk"能够下棋,而到了19世纪,自动钢琴(Player Piano)的出现,让纸带上的孔洞成为了最早的"音乐编程语言"。

image.png

这些纸带上打出的孔,记录着音符的时长、力度和音高,这不正是今天MIDI(乐器数字接口)数据的物理形态吗?可以说,音乐的数字化和算法化,早在计算机诞生之前就已经埋下了种子。

真正的转折点出现在20世纪50年代。1957年,Lejaren Hiller和Leonard Isaacson在伊利诺伊大学使用ILLIAC I计算机创作了《伊利亚克组曲》(Illiac Suite),这是历史上第一篇完全由计算机生成的音乐作品。当时的做法非常"暴力"——他们用马尔可夫链来模拟音符的转移概率,虽然听起来有些生硬,但证明了机器可以遵循一定规则创造出结构完整的乐章。

二、 理解音乐的"语法":AI如何学会创作

要让AI创作音乐,首先需要让AI"听懂"音乐。这并不是说AI要像人类一样产生情感共鸣,而是要理解音乐背后的数学规律和结构逻辑。

音乐本质上是一种时间序列数据。音频信号是连续的波形,而乐谱则是离散的符号表示。这就引出了两种主流的技术路径:

2.1 基于符号的创作路径

这条路类似于自然语言处理(NLP)中的文本生成。把音符、和弦、节奏看作是"词汇"和"句子",然后训练模型去预测下一个音符的概率分布。

最著名的技术莫过于Magenta项目的MusicVAE模型。VAE(变分自编码器)将音乐片段编码到一个潜空间中,在这个空间里,相似风格的音乐会聚集在一起,我们可以进行插值运算,生成介于两种风格之间的新音乐。

但这套方法有个致命的缺陷:它丢失了音乐中最重要的东西——表现力。同样的C大调音阶,在钢琴大师手中和初学者手中完全是两个概念。力度、踏板、滑音、颤音这些细微的差别,在MIDI符号中往往被简化或忽略。

2.2 基于音频的深度学习路径

另一条路是直接处理原始音频波形。Google的AudioLM、Meta的MusicGen都是这方面的代表。它们直接学习音频的声学特征,生成听起来更加真实的音乐。

这种方法的优势在于保留了音乐的"质感",但计算成本极高。一段30秒的音频,采样率44.1kHz,就意味着130多万个数据点需要处理。而且,生成的音乐往往缺乏清晰的结构——你可能得到一段很棒的旋律,但它的A段B段划分是混乱的。

image.png

表:两种主流AI音乐生成技术路径对比

维度 | 符号路径(MIDI/乐谱) | 音频路径(原始波形) |

|---|---|---|

数据表示 | 离散、结构化 | 连续、高维 |

计算效率 | 高,生成速度快 | 低,需要大量算力 |

音乐表现力 | 弱,缺乏音色细节 | 强,保留声学特征 |

结构可控性 | 高,方便指定和弦、节奏 | 低,难以精确控制 |

适用场景 | 编曲辅助、风格迁移 | 音效生成、背景音乐 |

三、 现实场景:AI在音乐产业链中的渗透

理论再美好,最终都要落地到实际应用中。从我个人的观察来看,AI在音乐产业中的应用已经渗透到了各个环节。

3.1 创作辅助:作曲家的"超级插件"

去年我有机会和一位独立音乐人合作,他使用的是一款名为"BandLab"的创作工具。当他哼唱出一段旋律时,系统会自动生成和弦伴奏,并且提供多种风格选择——流行、爵士、电子、民谣。更神奇的是,他可以通过简单的滑块调整"悲伤程度"、"能量感"、"复杂度"这些抽象的维度。

这背后其实是基于深度学习的内容生成模型,但用户体验设计得极其人性化。音乐人不再是"提示词工程师",而是真正的"指挥家",AI是他的超级乐团。

下面是一个简单的Python示例,展示如何使用MIDI库处理音符数据,这是AI音乐工具的基础逻辑:

from midiutil import MIDIFile

def create_simple_melody(output_file):

# 创建一个MIDI文件对象,包含1个音轨

midi = MIDIFile(1)

# 设置音轨参数

track = 0

time = 0 # 开始时间(以拍为单位)

tempo = 120 # 速度(BPM)

midi.addTempo(track, time, tempo)

# 定义一个简单的旋律(音高、时长、力度)

melody = [

(60, 1, 100), # C4,1拍,力度100

(62, 1, 90), # D4,1拍,力度90

(64, 1, 95), # E4,1拍,力度95

(65, 2, 110), # F4,2拍,力度110

(64, 1, 90), # E4,1拍,力度90

(62, 1, 85), # D4,1拍,力度85

(60, 4, 100), # C4,4拍,力度100

]

channel = 0

for pitch, duration, volume in melody:

midi.addNote(track, channel, pitch, time, duration, volume)

time += duration

# 保存文件

with open(output_file, "wb") as f:

midi.writeFile(f)

# 生成一个简单的MIDI文件

create_simple_melody("simple_melody.mid")这段代码展示了MIDI文件的基本结构:音符、音高、时长、力度。AI音乐生成模型最终输出的,本质上就是这种结构化的数据,然后由合成器将其转化为声音。

3.2 音乐制作:智能混音与母带

在录音棚里,混音师的工作曾经是高度依赖经验和听力的黑魔法。但现在,像iZotope这样的公司推出的AI插件,可以自动检测频谱冲突、动态平衡各个乐器的音量,甚至一键完成母带处理。

image.png

3.3 音乐版权:AI带来的法律迷雾

这是最棘手的部分。当AI学习了披头士的作品后生成了一首歌,这首歌的版权属于谁?是AI模型的使用者、模型开发者,还是被训练的原作者?

2023年,一位名为"Ghostwriter"的音乐人使用AI模仿Drake和The Weeknd的声音发布了歌曲《Heart on My Sleeve》,这首歌在流媒体平台大火后被强制下架。这件事暴露了现有版权法的滞后性——声音克隆技术已经足够成熟,但法律还不知道如何界定"声音的版权"。

四、 技术挑战:当前AI音乐的"失真"之处

作为技术人员,我们既要看到AI的强大,也要诚实地面对它的局限性。

第一个问题是长程依赖的把握不足。 音乐作品通常有着长达几分钟甚至几十分钟的结构。主歌、副歌、桥段之间需要有呼应和对比。目前的AI模型(即便是Transformer架构)在处理超过30秒的结构时,往往会"忘记"之前的主题,导致作品听起来像是拼凑的片段。

第二个问题是情感表达的空洞。 AI可以模仿悲伤的调式、缓慢的速度,但它无法理解"悲伤"是什么。它只是在统计学上学习到"当人类表达悲伤时,通常会使用这些音乐元素"。这种模仿是表面的,缺乏真正打动人心的内核。

第三个问题是风格的同质化。 由于大部分模型都是在主流流行音乐数据上训练的,生成的作品往往有"网红感"——好听但千篇一律。要生成具有强烈个人风格的作品,需要特定的微调和大量的个性化数据。

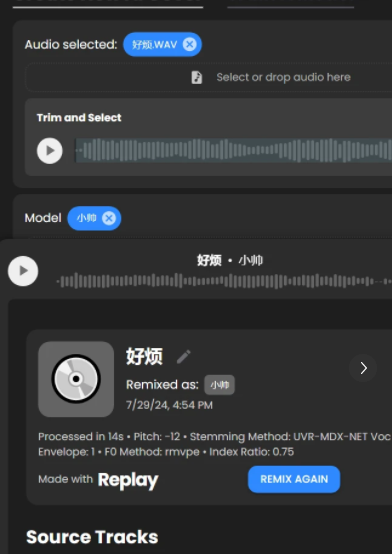

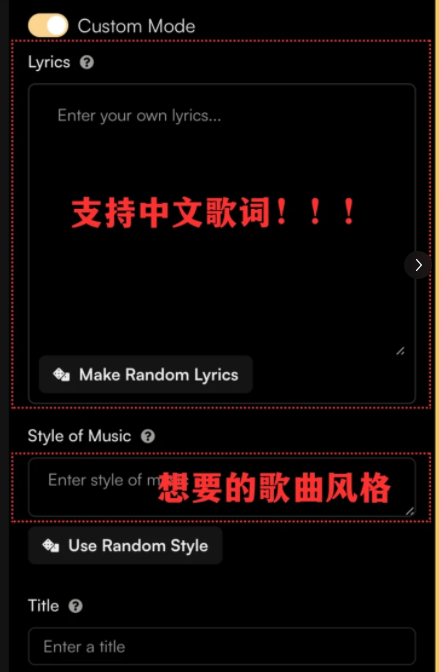

五、 现场体验:我的一次AI音乐创作实验

为了更直观地理解AI音乐创作,上个月我做了一个实验。我使用了开源的MusicGen模型,输入了一段关于"雨夜城市中的孤独感"的文字描述。

生成的音乐确实让我惊讶。钢琴的音色带着一点颗粒感,背景中有模糊的环境噪音,节奏缓慢而犹豫。特别是第18秒出现的一个小二度音程,听起来像是一声叹息。

但当我试着延长到3分钟时,问题出现了。音乐开始重复,结构变得松散,最后部分完全失去了开头的氛围。这让我意识到,目前的AI更像是一个"乐句生成器"而非真正的"作曲家"。

真正优秀的作曲,需要有人类的那种"全局观"——知道什么时候该铺垫,什么时候该爆发,什么时候该留白。这种能力来自于对人类情感和社会文化的深刻理解,这是纯数据驱动的模型目前难以企及的。

image.png

六、 未来展望:人机协作的音乐新范式

展望未来,我认为AI不会取代音乐家,而是会重塑音乐创作的方式。

协作创作将成为主流。 音乐人提供创意的种子、情感的方向、审美的判断,AI负责快速的素材生成、和声填充、变体探索。就像计算器没有让数学家失业一样,AI音乐工具会让音乐家的创意更加自由。

个性化音乐将成为可能。 想象一下,你的运动APP可以根据你当前的心率、步频、实时情绪,生成最适合你的背景音乐。这种音乐是独一无二的,只属于当下的你。

音乐教育将发生变革。 传统的音乐理论学习枯燥乏味,而AI可以作为陪练,实时反馈你的演奏,甚至为你生成定制化的练习曲目。学习音乐不再是少数人的特权。

结语

写到这里,我戴上耳机,播放了刚才用AI生成的"雨夜城市"。虽然它有瑕疵,有重复,但那其中确实有一种打动我的东西。

音乐是人类的通用语言,而AI是新时代的乐器。当这把乐器落入真正热爱音乐的人手中,它将演奏出怎样的乐章?我们也许还无法完全想象,但未来已来,而它听起来,充满了无限的可能。

原创声明:本文系作者授权腾讯云开发者社区发表,未经许可,不得转载。

如有侵权,请联系 cloudcommunity@tencent.com 删除。

原创声明:本文系作者授权腾讯云开发者社区发表,未经许可,不得转载。

如有侵权,请联系 cloudcommunity@tencent.com 删除。

评论

登录后参与评论

推荐阅读

目录