Azure DataBricks性能

Azure DataBricks性能

提问于 2022-04-17 10:13:38

我的要求是处理大约1TB存储在Azure container.The容器中的数据,其中包含数百万json文件,这些文件本质上是多部分的。

为此,我使用了HdInsight,它能够在大约45分钟内处理数据:

工作节点(1-4)- 16核- 112 gb头节点-2-4核心28 gb

我们计划迁移到Azure Databricks星团

所用集群的配置

工作节点(4-10)自动示波器-8核56 10内存优化头节点-4核28 10

但是这会持续运行超过2.5小时,但是进程仍然没有完成,而且我可以看到它最大限度地使用了4个工作节点,但没有扩大到利用剩余的辅助节点来加快进程。

如果我在这里做错事,谁能帮上忙。

回答 1

Stack Overflow用户

发布于 2022-04-18 08:37:56

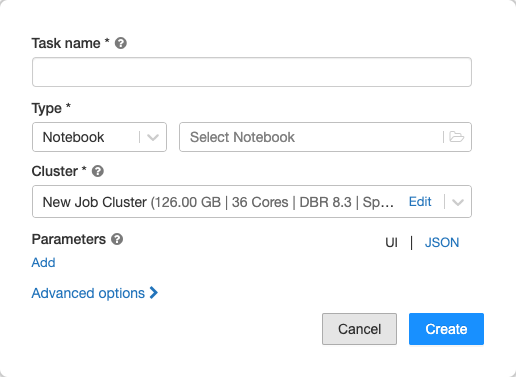

您在创建任务时提到的任务类型是什么?

在类型下拉菜单中,选择Notebook、JAR、 Submit、Python或管道E 212。

如果您选择了星火提交,那么自动标度是不支持的。

对于自动标度,您需要选择其他选项。

此外,自动标度的行为取决于它是优化的还是标准,以及是应用于通用集群还是应用于作业集群。

我建议您查阅有关聚类大小和自动标度的正式文档,以便对此有更好的了解。

页面原文内容由Stack Overflow提供。腾讯云小微IT领域专用引擎提供翻译支持

原文链接:

https://stackoverflow.com/questions/71901024

复制相关文章

相似问题