图像数字化与声音数字化(PCM)有何区别?

我试着理解声音和图像的数字化。据我所知,他们都需要把模拟信号转换成数字信号。两者都应该使用采样和量化。

- 声音:我们在轴y上有振幅,在轴x上有时间。在图像数字化过程中,轴x和y上是什么?

- 是图像数字化的一种采样率标准吗?它使用44千赫的CD(声音数字化)。图像的采样率是如何使用的?

- 量化:声音--我们使用比特深度--这意味着振幅-图像的水平--图像:也使用比特深度,但它意味着我们能够识别多少个整数?(这是真的吗?) digitalization?

和

- 还有什么区别?

回答 2

Stack Overflow用户

发布于 2020-02-11 17:06:37

图像的获取可以概括为空间采样和转换/量化步骤。(x,y)上的空间采样是由像素大小决定的。数据(在第三轴上,z)是由芯片上的光电效应产生的电子数。这些电子被转换成ADU (模拟数字单元),然后转换成比特。量化的是灰度级的光强,例如8位上的数据将给出2^8 = 256级灰度。

图像由于空间采样(分辨率)和强度量化(灰度级)而丢失信息。

除非你是在谈论视频,否则图像不会以赫兹(1/time)为单位采样,而是在1//距离内采样。重要的是验证Shannon-Nyquist定理以避免混叠.你能得到的空间频率直接取决于光学设计。为了避免混叠,必须分别选择像素大小。

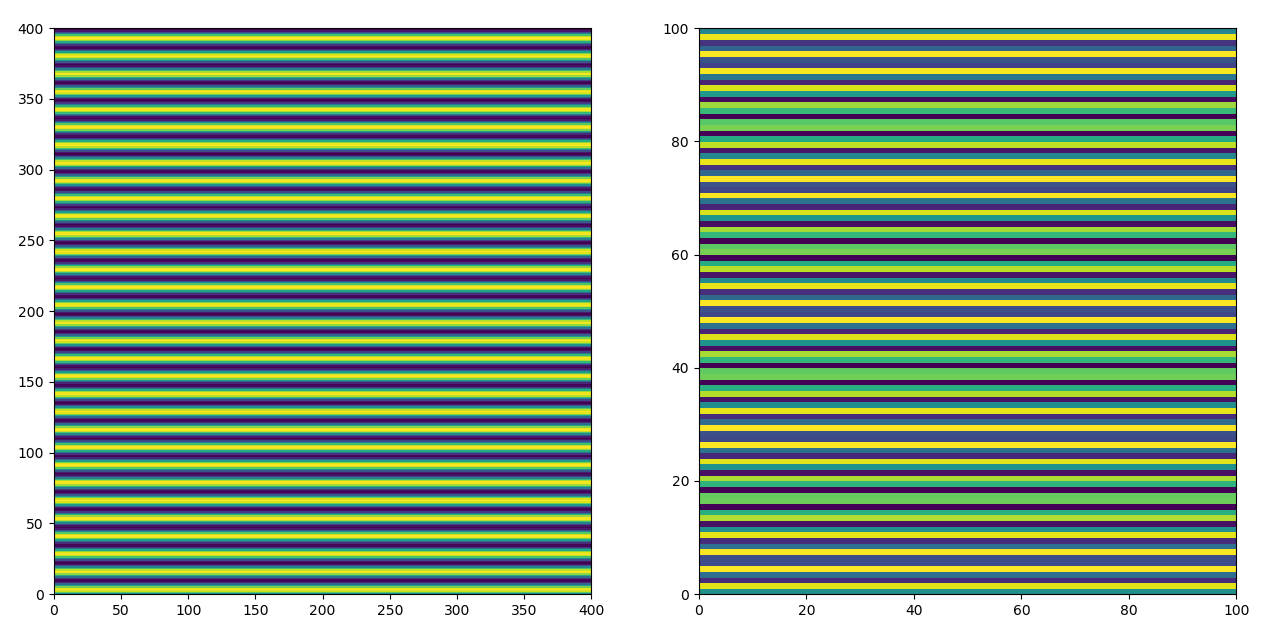

编辑:在下面的示例中,我绘制了一个正弦函数(白色/黑色条纹)。在左边,信号被正确地采样,在右边,它被欠采样到4倍。它是相同的信号,但是由于像素更大(更小的采样),你会得到你的数据的混叠。这里的条纹是水平的,但垂直条纹的效果也是一样的。

Stack Overflow用户

发布于 2020-02-11 18:03:19

对于图像采样的空间轴,没有统一的标准。一个2000万像素的传感器或照相机将产生与200万像素传感器或相机完全不同的空间分辨率(以每毫米像素为单位,或以每度视角为像素)。这些图像通常会被重标到另一个非标准分辨率的观看(72 ppi,300 ppi,"Retina",SD/HDTV,CCIR-601,"4k“等)。

对于音频,48k开始变得比44.1ksps更常见。(在iPhones等上)

(“标准的好处是有这么多标准”)

原始格式的幅度缩放也没有单一的标准。当转换或重新转换为存储格式时,8位、10位和12位量化是RGB颜色分离最常见的方法。(JPEG、PNG等格式)

音频和图像之间的通道格式是不同的。X,Y,其中X是时间,Y是振幅,只对单声道很好。立体声通常需要T,L,R的时间,左,右通道。图像通常以X,Y,R,G,B或5维张量表示,其中X,Y是空间位置坐标,RGB是该位置的颜色强度。图像强度可能有一定的相关性(取决于伽马校正,等等)。每百叶窗持续时间的入射光子数,在一定可见的EM频率范围内,每个入射固体角度到某个透镜。

音频的低通滤波器和图像的Bayer滤波器通常被用来使信号更接近于带宽限制,这样就可以用较少的混叠噪声/伪影来采样信号。

https://stackoverflow.com/questions/60173434

复制相似问题