当cassandra快照发生太多打开的文件时

当cassandra快照发生太多打开的文件时

提问于 2013-02-05 02:12:36

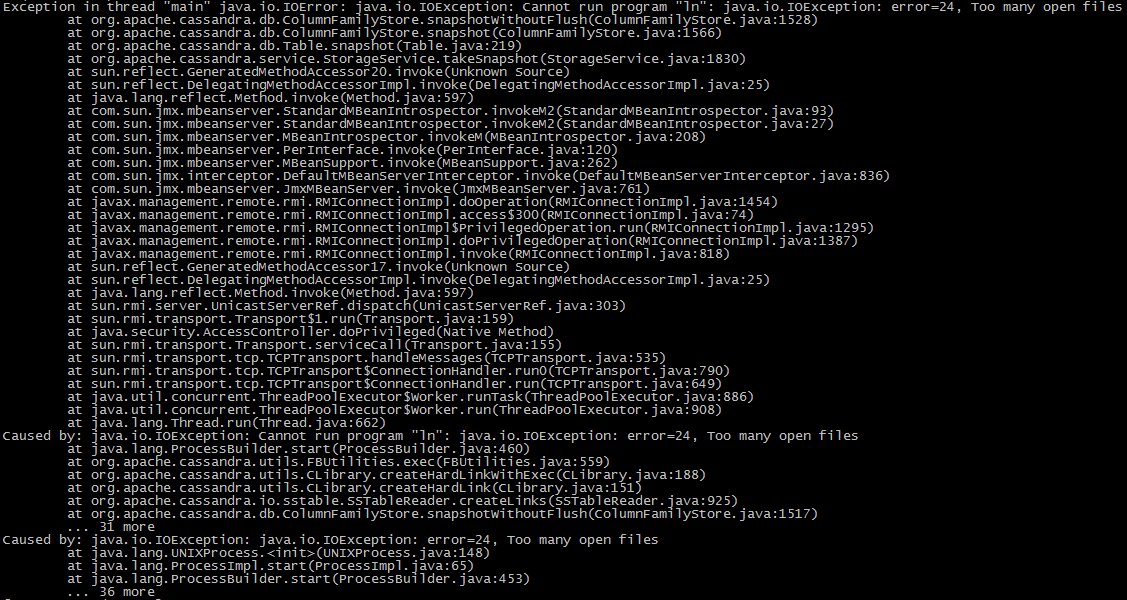

当我尝试使用cassandra快照时,出现了java错误。

根@cassandra mytest]# /usr/local/apache-cassandra-1.1.7/bin/nodetool -h localhost mytest

因此,我在/etc/security/limits.conf s.conf中添加了

下面是:http://www.datastax.com/docs/1.1/troubleshooting/index#java-reports-an-error-saying-there-are-too-many-open-files

- 软nofile 32768

- 硬nofile 32768

- 根软nofile 32768

- 根硬nofile 32768

- 软模无限

- 硬记忆无限

- 根软记忆无限

- 根硬记忆无限

- 软如无限

- 难如无限

- 根软如无限

- 根硬如无限

但仍然出现了错误。

请你告诉我。

我用CentOS。

ps。我遵循这一原则:

在CentOS、RHEL、OEL上,将系统限制从/etc/security/limits.d/90-nproc.conf中的10240更改改为10240,然后启动新的外壳以使这些更改生效。*软网络10240

但我找不到“/etc/security/limits.d s.d/90-nproc.conf”

对不起。我的英语很差。

Stack Overflow用户

发布于 2013-02-05 05:19:04

除了limits.conf之外,还需要执行以下操作:

编辑/etc/pam.d/login,,添加行:

session required /lib/security/pam_limits.so请试一试,让我知道结果。

页面原文内容由Stack Overflow提供。腾讯云小微IT领域专用引擎提供翻译支持

原文链接:

https://stackoverflow.com/questions/14699057

复制相关文章

相似问题