为什么KNN精度低,但精度高?

为什么KNN精度低,但精度高?

提问于 2014-02-04 08:30:50

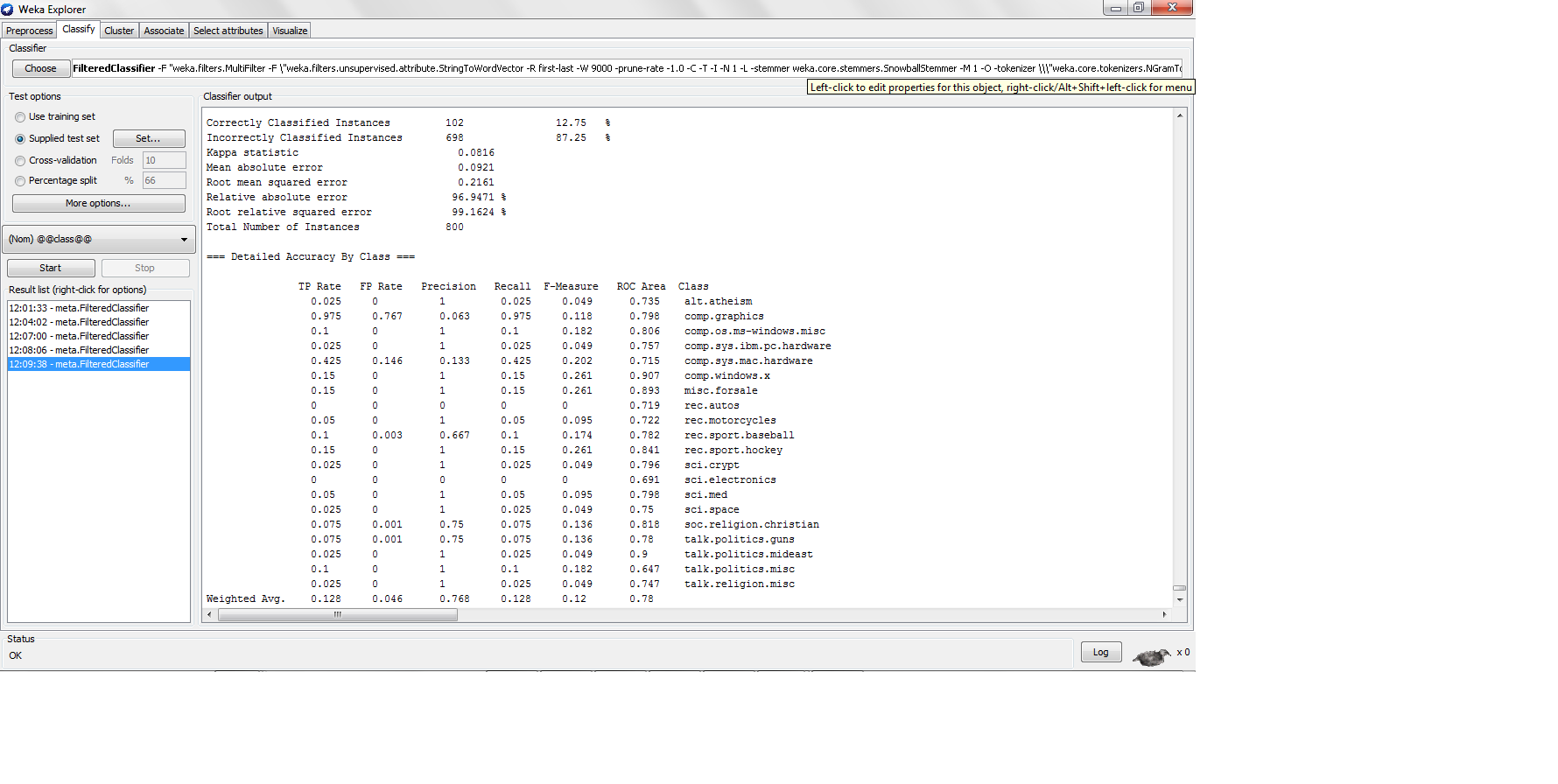

我使用k-nn对20 nn数据集进行了分类,每个类别中有200个实例,其中有80-20次列车测试分割,其中我发现了以下结果

这里的精度很低,但是当精度那么低时,精度又有多高呢?精度公式TP/(TP + FP)不是吗?如果是的话,高精度的分类器需要生成高的真正,这将导致高精度,但是than是如何以太低的真阳性率产生高精度的?

回答 1

Stack Overflow用户

回答已采纳

发布于 2014-02-04 14:42:32

召回率等于真阳性率。文本分类任务(尤其是信息检索,但文本分类也是如此)显示出在查全率和准确性之间的权衡。当精确度很高时,回忆往往是低的,相反。这是因为您可以对分类器进行调优,以将或多或少的实例分类为正实例。分类为正的实例越少,查准率就越高,召回率就越低。

为了确保有效性度量与准确性相关,您应该关注F-度量,即平均回忆和精度(F-度量= 2*r*p / (r+p))。

非懒惰分类器遵循一个训练过程,在这个过程中,他们试图优化准确性或错误。K-NN,懒惰,没有一个训练过程,因此,它没有试图优化任何有效的措施。您可以使用不同的K值,直观地说,K越大,回忆越高,精确度越低,反之亦然。

页面原文内容由Stack Overflow提供。腾讯云小微IT领域专用引擎提供翻译支持

原文链接:

https://stackoverflow.com/questions/21547423

复制相关文章

相似问题