为什么在神经网络中每个层有多个层和多个节点?

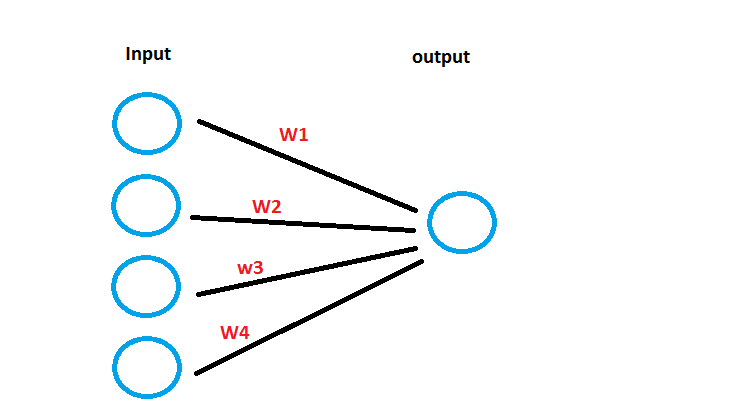

我刚刚开始学习神经网络,到目前为止,我对机器学习的知识只是线性和logistic回归。根据我对后一种算法的理解,在给定输入倍数的情况下,学习算法的工作是为每一输入求出适当的权重,从而最终得到一个多项式,该多项式可以描述线性回归情况下的数据,也可以像logistic回归那样分离数据。如果我在神经网络中代表同样的机制,根据我的理解,它会是这样的,

输入层的多个节点和输出层中的单个节点。在这里,我可以将错误按比例传播到每个输入。最后,我到达了一个多项式X1W1 + X2W2+....XnWn,它描述了数据。在我看来,除了输入层,每个层有多个节点,似乎使学习过程并行,这样我就可以更快地到达结果。这几乎就像运行多个学习算法,每个算法都有不同的起点,以查看哪一个算法收敛得更快。至于多个层次,我不知道它对学习结果有什么机制和优势。

回答 1

Stack Overflow用户

发布于 2017-01-01 15:02:43

为什么在神经网络中每个层有多个层和多个节点?

我们至少需要一个具有非线性激活的隐藏层才能学习非线性函数。通常,人们认为每个层都是一个抽象级别。对于计算机视觉,输入层包含图像,输出层包含每个类的一个节点。第一个隐藏层检测边缘,第二个隐藏层可能检测圆圈/矩形,然后出现更复杂的模式。

有一个理论结果表明,只有一个隐层的MLP,只要有足够的神经元,就可以满足每个感兴趣函数的任意低误差。但是,参数的数量可能比添加更多的层要大得多。

基本上,通过在每一层添加更多的隐藏层/更多的神经元,您可以为模型添加更多的参数。因此,您可以让模型适应更复杂的函数。然而,据我所知,对添加一个进一步的层/节点所做的事情并没有定量的理解。

在我看来,你可能想要一个神经网络的概括性介绍。我推荐Tho14a的第4.3章和第4.4章以及LBH15。

Tho14a M. Thoma,“手写数学符号的在线识别”,德国Karlsruhe,2014年11月。在网上。可用:https://arxiv.org/abs/1511.09030 LBH15 Y. LeCun,第521卷,Y. Bengio,no. 7553,和G. Hinton,第436-444页,“深入学习”,“自然”,2015年5月。在网上。可用:http://www.nature.com/nature/journal/v521/n7553/abs/nature14539.html

https://stackoverflow.com/questions/41410317

复制相似问题