火花远程开发环境

火花远程开发环境

提问于 2017-08-28 03:52:46

我想要远程星火开发环境。

一台机器是我的开发机器,java,eclipse,windows 10。

此外,我有另一台机器已经安装了闭锁(火花上的纱线)。

我试过这个

String appName = "test" + new Date(System.currentTimeMillis());

String master = "spark://*:6066";

String host = "*";

String jar = "C:\\Users\\default.DESKTOP-0BP338U\\Desktop\\workspace\\workspace_study\\spark-start-on-yarn\\target\\spark-start-on-yarn-0.0.1-SNAPSHOT.jar";

SparkConf conf = new SparkConf().setAppName(appName).setMaster(master)

.set("spark.driver.host", host)

.setJars(new String[]{jar});

JavaSparkContext sc = new JavaSparkContext(conf);但是连接被拒绝了。

如何在我的A机上开发和测试火花程序?

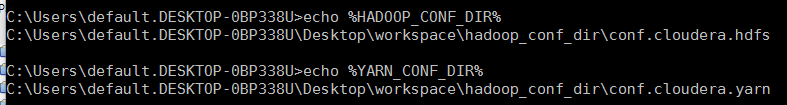

我添加了环境变量

这是我的密码

SparkConf conf = new SparkConf()

.setAppName(new Date(System.currentTimeMillis()).toString())

.setMaster("yarn");

JavaSparkContext sc = new JavaSparkContext(conf);

List<Integer> data = Arrays.asList(1,2,3,4,1,2,3,4,5,1,4,1,1,1,4,2,2,4,1,1,3,4,2,3);

JavaRDD<Integer> distData = sc.parallelize(data);

JavaPairRDD<Integer, Integer> pairs = distData.mapToPair(s -> new Tuple2<Integer, Integer>(s, 1));

JavaPairRDD<Integer, Integer> counts = pairs.reduceByKey((a, b) -> a + b);

System.out.println("================= " + counts);

sc.close();

sc.stop();错误是"SparkException :云不解析主网址:‘纱线’“

我错过了什么?请帮帮我..。

回答 1

Stack Overflow用户

回答已采纳

发布于 2017-08-28 04:01:45

你需要

- 下载Hadoop集群的

HADOOP_CONF_DIR配置文件。 - 在

HADOOP_CONF_DIR机器中设置环境变量。或者,如果这不起作用,那么您可以将XML文件放在您的src/main/resources文件夹中,以便将它们包含在类路径中。 - 使用

setMaster("yarn-client")

确保

HADOOP_CONF_DIR或YARN_CONF_DIR指向包含Hadoop集群(客户端)配置文件的目录。这些信任被用来写入HDFS并连接到纱线ResourceManager)

从外部机器运行星火

- 使用您的

/user本地用户名创建一个HDFS 文件夹。这是HDFS权限所需要的。 - 开发,最好使用Maven/Gradle来管理您的Java库。您还需要使用Cloudera Maven存储库为您提供了各自的Hadoop版本

你也不需要setJars()。你的应用程序应该自己连接并运行。

页面原文内容由Stack Overflow提供。腾讯云小微IT领域专用引擎提供翻译支持

原文链接:

https://stackoverflow.com/questions/45911587

复制相关文章

相似问题