Tensorboard和Dropout层

Tensorboard和Dropout层

提问于 2017-09-16 23:53:55

我有一个非常基本的查询。我已经做了4个几乎相同(差异是输入形状) CNN,并合并了他们,同时连接到一个前向网络的完全连接的层。

几乎相同的CNN代码:

model3 = Sequential()

model3.add(Convolution2D(32, (3, 3), activation='relu', padding='same',

input_shape=(batch_size[3], seq_len, channels)))

model3.add(MaxPooling2D(pool_size=(2, 2)))

model3.add(Dropout(0.1))

model3.add(Convolution2D(64, (3, 3), activation='relu', padding='same'))

model3.add(MaxPooling2D(pool_size=(2, 2)))

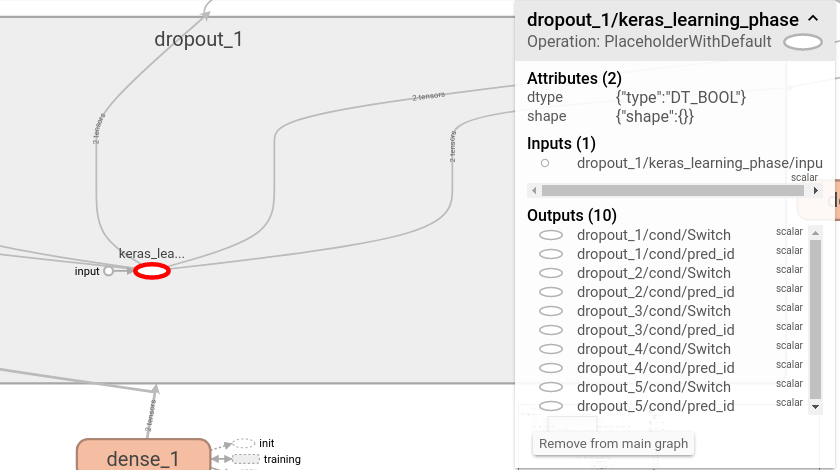

model3.add(Flatten())但在拉伸板上,我看到所有的Dropout层都是相互连接的,Dropout1的颜色与Dropout 2,3,4等颜色不同,它们都是相同的颜色。

回答 1

Stack Overflow用户

回答已采纳

发布于 2018-04-10 15:32:31

我知道这是个老问题,但我自己也有同样的问题,我刚刚意识到发生了什么

只有在我们训练模型的时候才会应用辍学。这应该在我们评估/预测的时候停止。为此,keras创建一个learning_phase占位符,如果我们正在训练模型,则设置为1.0。此占位符在您创建的第一个Dropout层中创建,并在所有这些层之间共享。这就是你在那里看到的!

页面原文内容由Stack Overflow提供。腾讯云小微IT领域专用引擎提供翻译支持

原文链接:

https://stackoverflow.com/questions/46259467

复制相关文章

相似问题