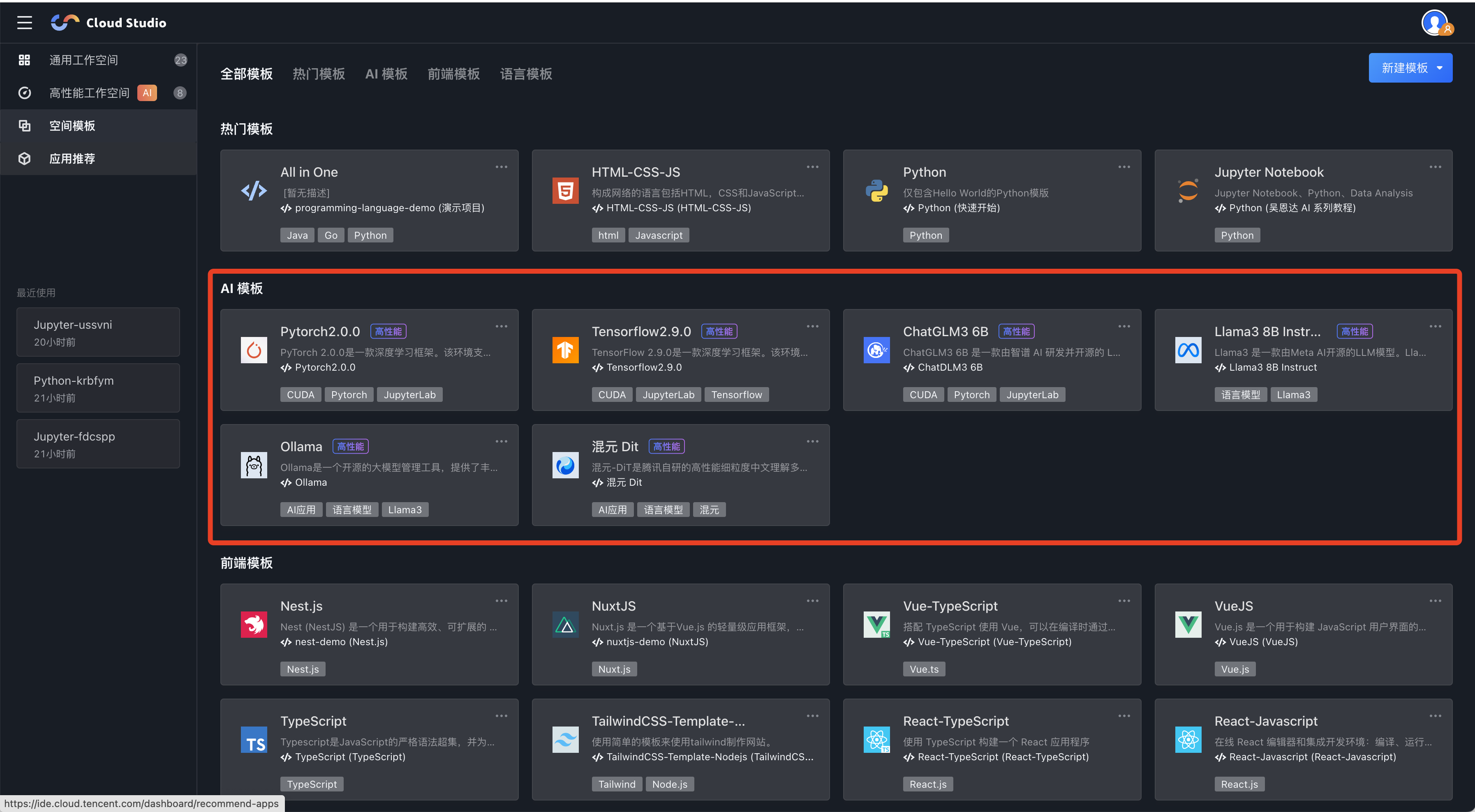

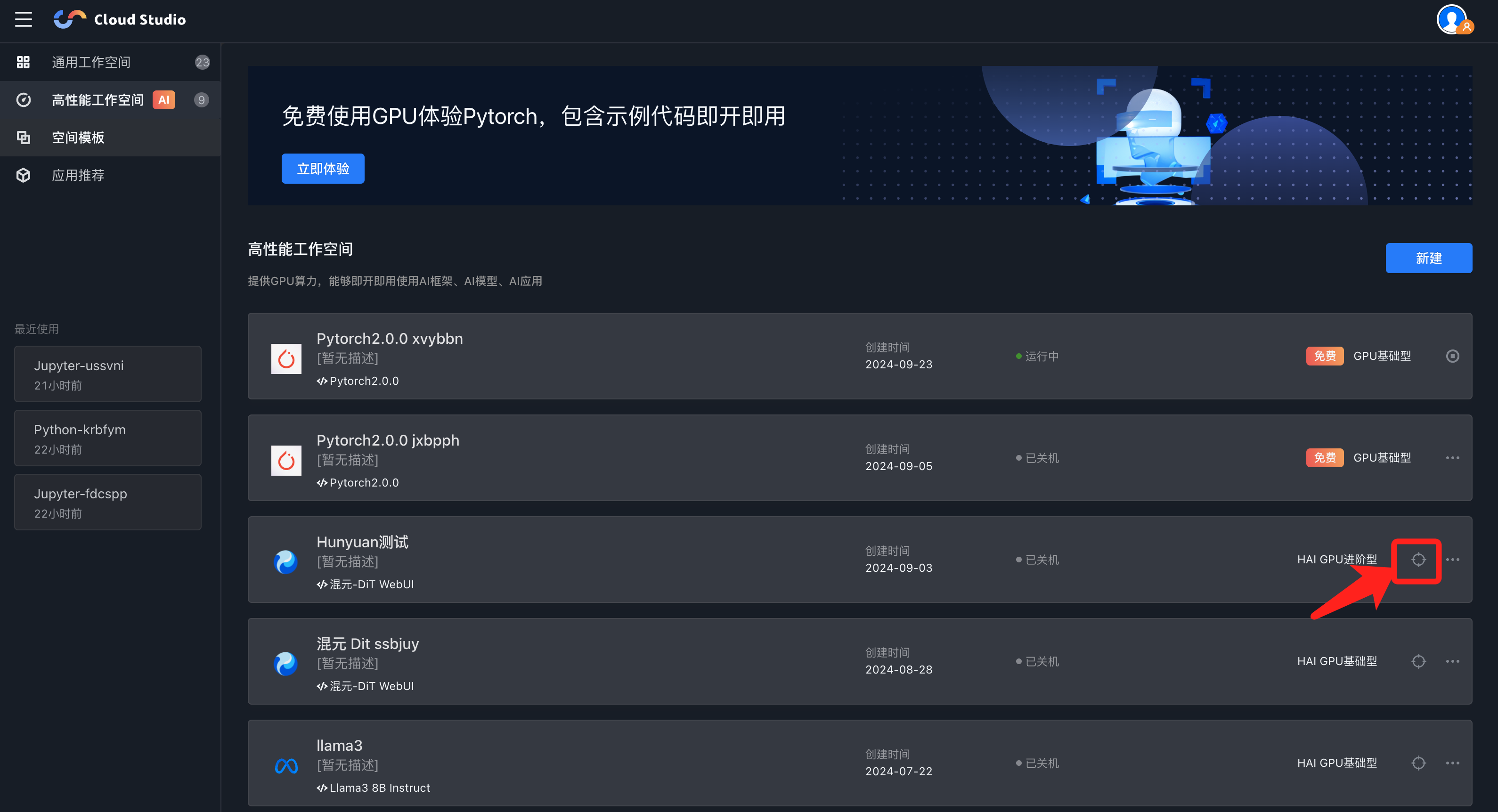

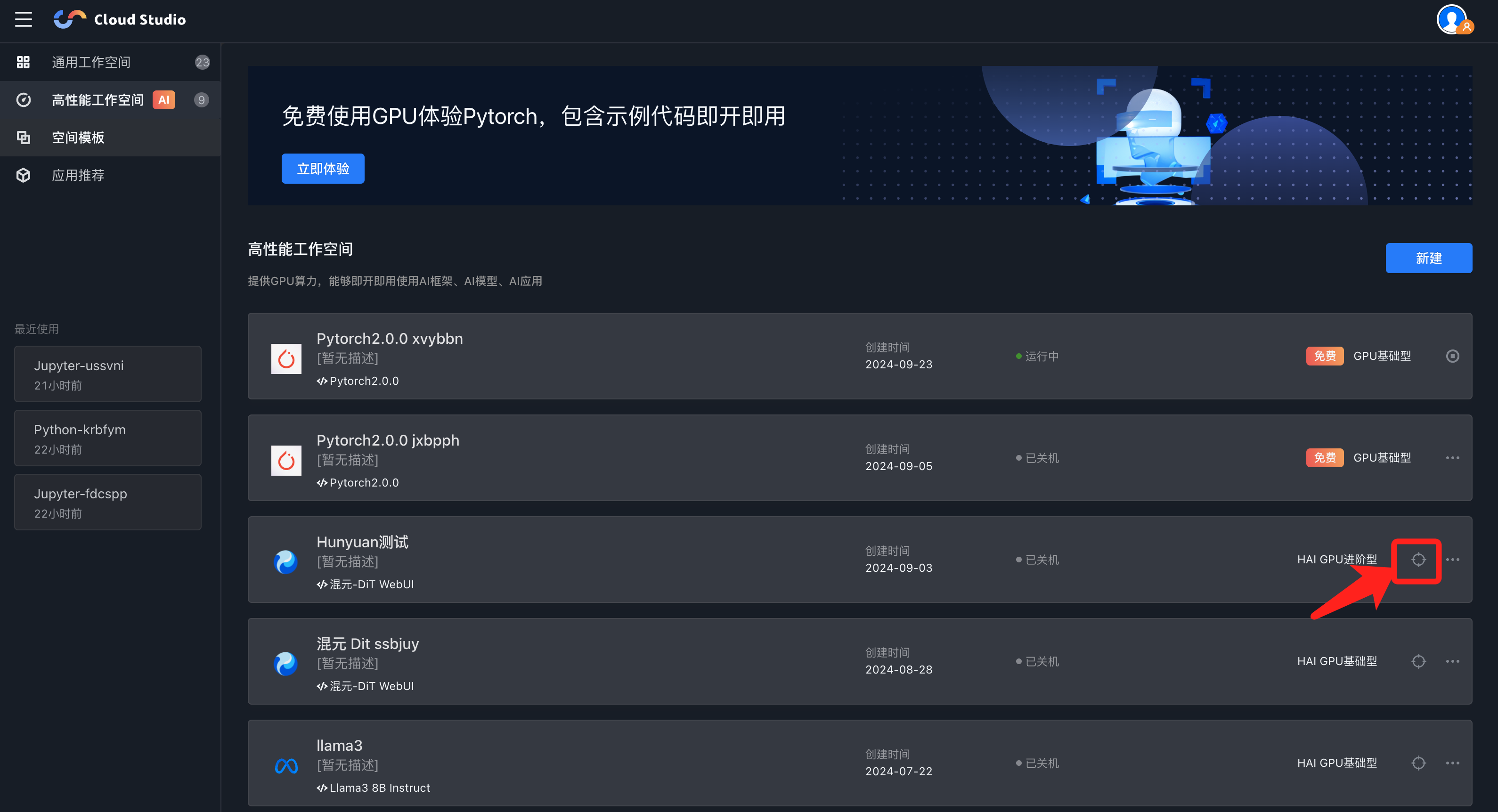

开始:创建 GPU 工作空间

注意:

免费基础型设置了平台共享的一定额度的预热量,创建后即可获得已开机的 HAI GPU 工作空间。若额度用完,则需要等待 HAI GPU 启动后方可使用,通常需要2 - 5分钟。

由于 HAI GPU 算力数量有限,可能会出现无法创建或开机的情况。可以选择 HAI 进阶型创建,切换不同地域查看算力库存情况。

编写代码

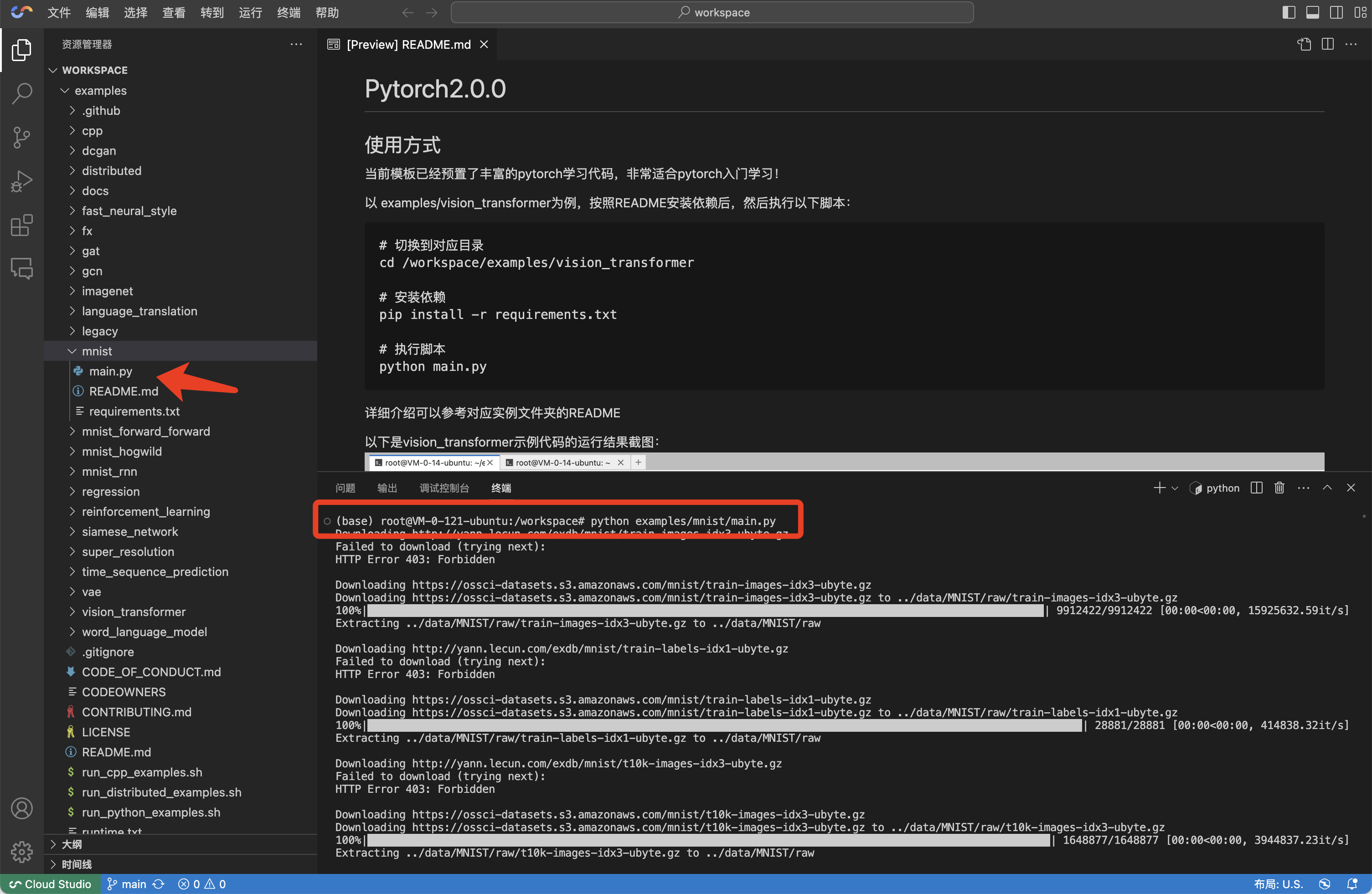

大部分模板在空间创建后有预设实例代码,可跟随 Readme 文档使用。空间内的文件结构基本遵循如下规则:

root/├── workspace/ # Cloud Studio 内置示例文件,仅该文件夹变更支持持久化│ └── Readme.md│ └── examples/ # Cloud Studio 示例代码│ ├── ...│ └── ...├── qcloud_hai/ # HAI 其他进程,如ComfyUI、WebUI等│ └── ...├── root/ # 一般模型文件存放在该文件夹│ └── llama3 # 仅示例,不同模版内容不同│ └── ...├── ...

以 Pytorch 模板为例:

查看 web 预览效果

方法一:通过公网 IP 拼接端口号访问

可以通过指定 IP 及端口号创建服务后,通过公网 IP 拼接端口号查看 web 预览效果。

注意:

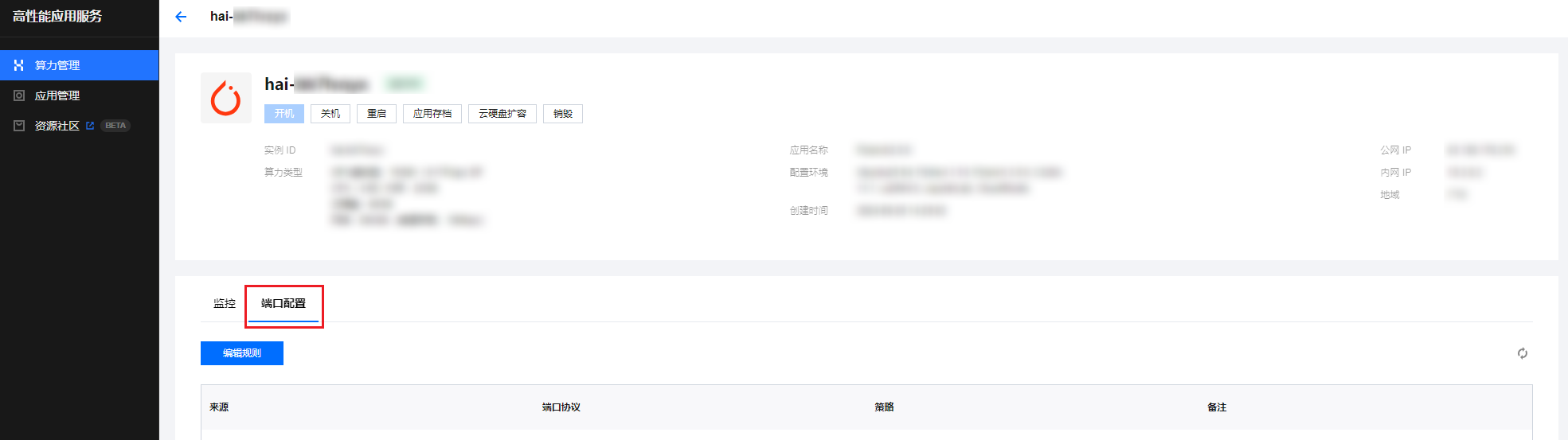

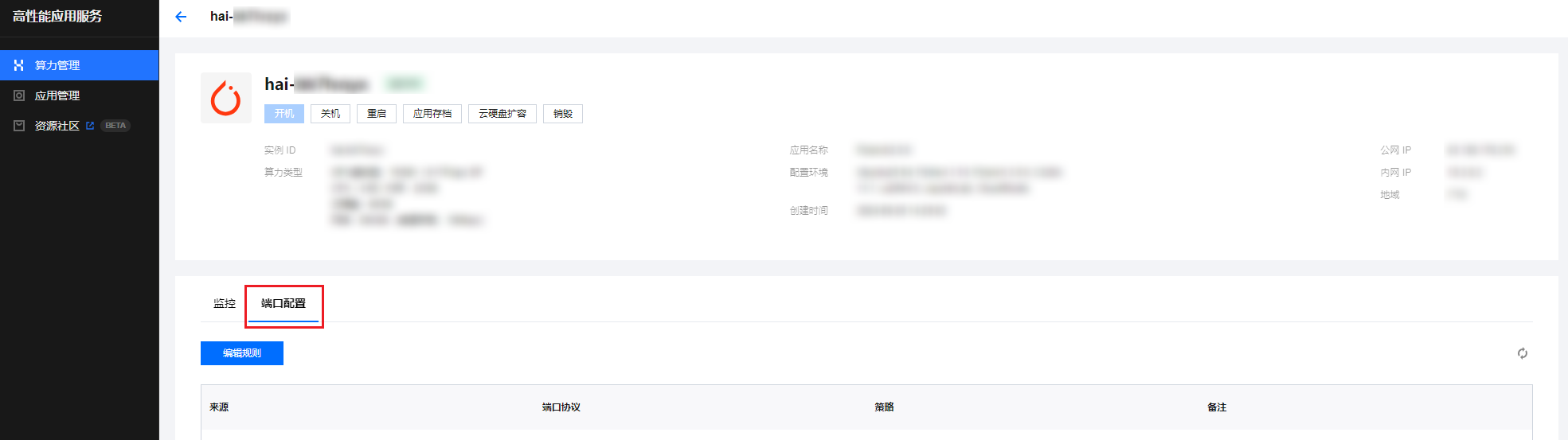

由于目前仅 HAI 进阶型及其他非免费版本可自定义开放端口,以下方法仅限 HAI 进阶型及其他非免费版本可用。

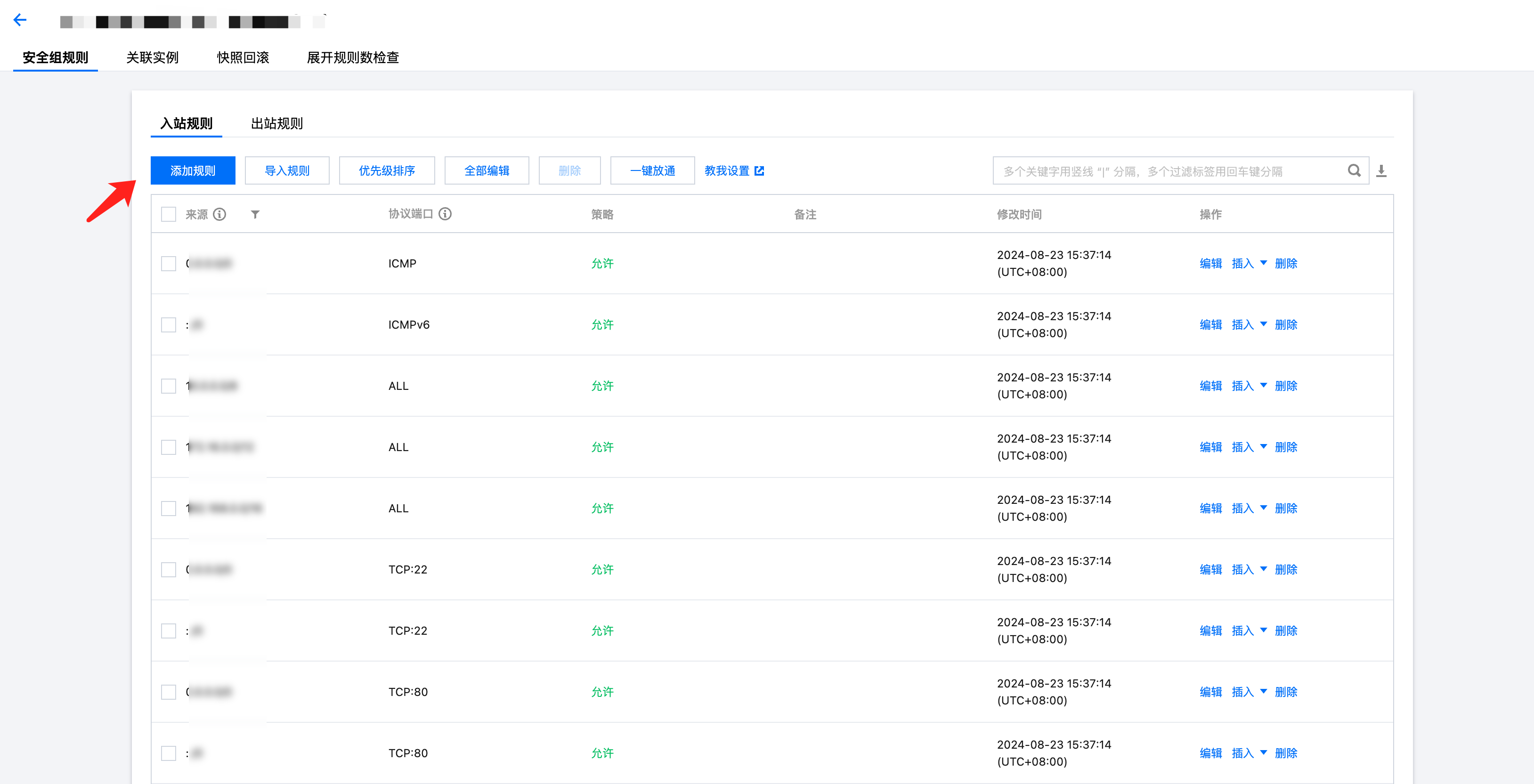

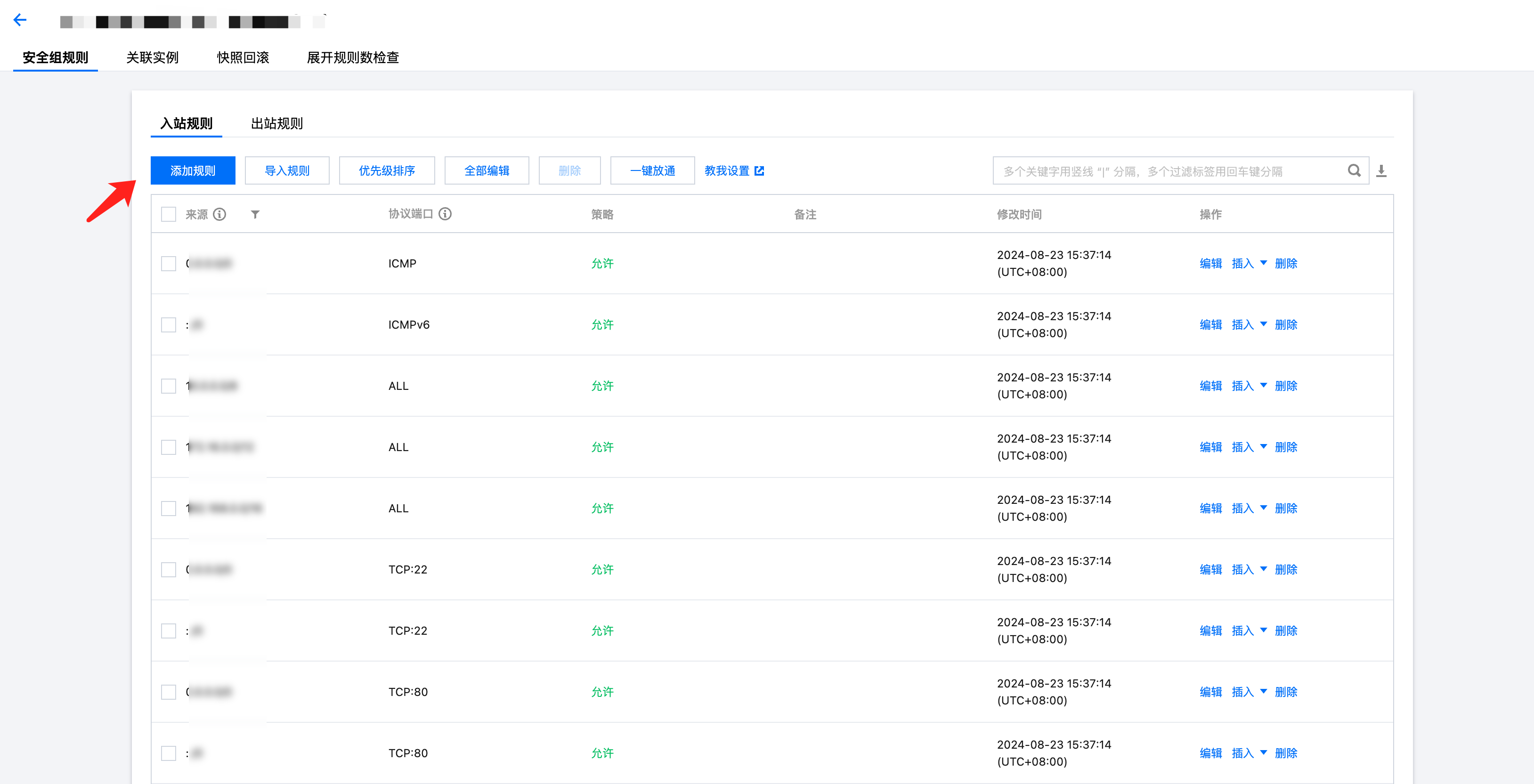

配置端口

启动服务

以创建 TensorBoard 服务为例,在启动服务时指定 host 与 port:

tensorboard --logdir=runs --host=0.0.0.0 --port=8080

回到 HAI 控制台或使用

curl ifconfig.me或curl https://api.ipify.org/查询当前机器的公网 IP。并前往浏览器输入公网 IP与端口号,访问服务。{公网IP}:{port}如:127.0.0.1:8080

方法二:通过 Cloud Studio 提供的端口转发服务访问

如果仅需要短时间预览,可使用下方规格拼接:

https://${X_IDE_SPACE_KEY}--${PORT}.${REGION}.cloudstudio.work/ # 举例:hfrsgm--8434.ap-guangzhou.cloudstudio.work/

其中

${X_IDE_SPACE_KEY}和${REGION}可以通过浏览器地址查询到,${PORT}为启动服务的端口号。#假设浏览器地址为https://hfrsgm.ap-guangzhou.cloudstudio.work/#启动了一个AnythingLLM的服务并使用6889端口,则预览地址为https://hfrsgm--6889.ap-guangzhou.cloudstudio.work/

以 DeepSeek 模板为例,端口号如下:

ollama —— 6399AnythingLLM 预览页面 —— 6889Open WebUI 预览页面 —— 6699

其他常见问题