参数说明

离线类型 | 读/写 | 配置内容 | 适用场景 | 描述 |

MySQL | 读 | splitFactor=5 | 单表 | - |

| | ignoreRegex=true | 单表 | 添加该参数后,选择或输入的表名称含有特殊符号时将作为实际表名进行数据同步,不进行正则匹配。不添加该参数,则默认对含有特殊符号的表名进行正则匹配 注:需要手动输入带特殊字符的表,并根据数据库自身特性在表名上添加反单引号或双引号 |

TDSQL MySQL | 读 | splitFactor=5 | 单表 | - |

| | ignoreRegex=true | 单表 | 添加该参数后,选择或输入的表名称含有特殊符号时将作为实际表名进行数据同步,不进行正则匹配。不添加该参数,则默认对含有特殊符号的表名进行正则匹配 注:需要手动输入带特殊字符的表,并根据数据库自身特性在表名上添加反单引号或双引号 |

TDSQL-C MySQL | 读 | ignoreRegex=true | 单表 | 添加该参数后,选择或输入的表名称含有特殊符号时将作为实际表名进行数据同步,不进行正则匹配。不添加该参数,则默认对含有特殊符号的表名进行正则匹配 注:需要手动输入带特殊字符的表,并根据数据库自身特性在表名上添加反单引号或双引号 |

Doris | 读 | query_timeout=604800 | 单表 | 查询的超时时间,以秒为单位 |

| | exec_mem_limit=4294967296 | 单表 | 设置执行内存限制,用于限制查询执行过程中的内存使用 |

| | parallel_fragment_exec_instance_num=8 | 单表 | 指定并行片段执行的实例数 |

| 写 | sameNameWildcardColumn=true | 单表 | mysql-doris 配置* 支持同名字段映射 |

| | loadProps={"format":"csv","column_separator":"\\\\x01","row_delimiter":"\\\\x03"} | 单表 | CSV 格式写入。相对默认的 JSON 格式写入性能更高。需要配合行分割符\\x03一起使用。分割符不支持\\r、\\b,十六进制的隐藏字符需要以\\\\形式输入 |

| | replaceDelimiter=替换符 | 单表 | 如果数据项中包含作为分割符的字符,将数据导入时,按照分割符分隔数据会导致字段错位。添加该参数可以将数据项中与指定行分割符或列分割符一致的字符先替换为用户自定义的字符(替换操作会改变数据),再按照行分割符或列分割分隔数据。不添加该参数时,直接按照分割符分隔数据。 |

Hive | 读 | mapreduce.job.queuename=root.default | 单表 | 用于指定作业(job)提交到哪个队列(queue)中执行 |

| | hive.execution.engine=mr | 单表 | Hive 中的一个配置参数,用于指定 Hive 查询的执行引擎,当前默认 mr,无需修改。 |

| | 注意: 设置高级参数时,mapreduce.job.queuename=root.default 和 hive.execution.engine=mr 两个参数需要一起使用,使用单个参数无法生效。 | | |

| 写 | compress=none/snappy/lz4/bzip2/gzip/deflate | 单表 | 默认为 none。只对 textfile 格式有效,对 orc/parquet 无效(orc/parquet 需要在建表语句指定压缩) |

| | format=orc/parquet | 单表 | hdfs 临时文件的格式,默认为 orc,跟最终 hive 表格式无关 |

| | partition=static | 单表 | 静态分区模式。适用于单分区写入,更节省内存 |

DLC | 读 | fs.cosn.trsf.fs.ofs.data.transfer.thread.count=8 | 单表 | 通过该参数可以设置读数据时的并行线程数,若不设置则默认值为32 |

| | fs.cosn.trsf.fs.ofs.prev.read.block.count=4 | 单表 | 通过该参数可以设置预读数据块的数量,若不设置则默认值为4 |

Mongodb | 读 | batchSize=1000 | 单表 | 批量读取的条数 |

| 写 | replaceKey=id | 单表 | 写入模式为覆盖写入时,用来作为更新的业务主键 |

| | batchSize=2000 | 单表 | 批量写入的条数,若不设置,默认为1000 |

COS | 读 | ignoreDirEmpty=true | 单表 | 添加该参数后,在数据同步模式下源端文件路径下没有文件或只有空文件时任务不报错。不添加该参数则默认 ignoreDirEmpty=false,源端文件路径下没有文件或只有空文件时任务报错。 |

| | ignoreFileNotFound=true | 单表 | 添加该参数后,在数据同步或文件传输模式下源端文件或文件路径不存在时任务不报错。不添加该参数则默认 ignoreFileNotFound=false,源端文件或文件路径不存在时任务报错。 |

| | transEmpFile=true | 单表 | 添加该参数后,在文件传输模式下支持将空文件同步至FTP/SFTP/HDFS/S3/COS 目标端。不添加该参数则默认transEmpFile=false,在文件传输模式下不同步空文件。 |

| 写 | splitFileSize=134217728 | 单表 | 单文件切分大小 针对 hive on cos 不生效 支持 text、orc、parquet 类型的文件 |

| | hadoopConfig={} | 单表 | 支持添加配置到 hadoopConfig 中 |

| | saveEmpFile=true | 单表 | 添加该参数后,在数据同步模式下源端无数据时目标端生成的空文件保留。不添加该参数则默认 saveEmpFile=false,在数据同步模式下源端无数据时目标端不保留生成的空文件。 |

HDFS | 读 | ignoreDirEmpty=true | 单表 | 添加该参数后,在数据同步模式下源端文件路径下没有文件或只有空文件时任务不报错。不添加该参数则默认ignoreDirEmpty=false,源端文件路径下没有文件或只有空文件时任务报错。 |

| | ignoreFileNotFound=true | 单表 | 添加该参数后,在数据同步或文件传输模式下源端文件或文件路径不存在时任务不报错。不添加该参数则默认ignoreFileNotFound=false,源端文件或文件路径不存在时任务报错。 |

| | transEmpFile=true | 单表 | 添加该参数后,在文件传输模式下支持将空文件同步至FTP/SFTP/HDFS/S3/COS 目标端。不添加该参数则默认transEmpFile=false,在文件传输模式下不同步空文件。 |

| 写 | splitFileSize=134217728 | 单表 | 单文件切分大小 hive on hdfs 不生效 支持 text、orc、parquet 类型的文件 |

| | writeMode=overwrite | 单表 | 该参数适用于文件传输方式。添加该参数后,会在写入前清理目标端与源端重名的文件。若不添加该参数,则在文件传输方式下默认 writeMode=nonconflict,即遇到源端与目标端重名文件时跳过写入 |

| | saveEmpFile=true | 单表 | 添加该参数后,在数据同步模式下源端无数据时目标端生成的空文件保留。不添加该参数则默认 saveEmpFile=false,在数据同步模式下源端无数据时目标端不保留生成的空文件。 |

SFTP/FTP | 读 | ignoreFileNotFound=true | 单表 | 添加该参数后,在数据同步或文件传输模式下源端文件或文件路径不存在时任务不报错。不添加该参数则默认 ignoreFileNotFound=false,源端文件或文件路径不存在时任务报错。 |

| | transEmpFile=true | 单表 | 添加该参数后,在文件传输模式下支持将空文件同步至FTP/SFTP/HDFS/S3/COS 目标端。不添加该参数则默认transEmpFile=false,在文件传输模式下不同步空文件。 |

| 写 | deleteEmpFile=true | 单表 | 添加该参数后,在数据同步模式下源端无数据时目标端生成的空文件不保留。不添加该参数则默认 deleteEmpFile=false,在数据同步模式下源端无数据时保留目标端生成的空文件。 |

DLC | 写 | fs.cosn.trsf.fs.ofs.data.transfer.thread.count=8 | 单表 | 通过该参数可以设置写数据时的并行线程数,若不设置则默认值为32 |

Hbase | 写 | hbase.client.keyvalue.maxsize=10485760 | 单表 | 用于限制单个 KeyValue 对象的最大大小,默认 10MB |

StarRocks | 读 | splitFactor=5 | 单表 | - |

| | query_timeout=604800 | 单表 | 查询的超时时间,以秒为单位 |

| | exec_mem_limit=4294967296 | 单表 | 设置执行内存限制,用于限制查询执行过程中的内存使用 |

| | parallel_fragment_exec_instance_num=8 | 单表 | 指定并行片段执行的实例数 |

| 写 | loadProps={"format":"csv","column_separator":"\\\\x01","row_delimiter":"\\\\x03"} | 单表 | CSV 格式写入。相对默认的 JSON 格式写入性能更高。需要配合行分割符 \\x03 一起使用。分割符不支持 \\r、\\b,十六进制的隐藏字符需要以 \\\\ 形式输入 |

| | replaceDelimiter=替换符 | 单表 | 如果数据项中包含作为分割符的字符,将数据导入时,按照分割符分隔数据会导致字段错位。添加该参数可以将数据项中与指定行分割符或列分割符一致的字符先替换为用户自定义的字符(替换操作会改变数据),再按照行分割符或列分割分隔数据。不添加该参数时,直接按照分割符分隔数据。 |

Elasticsearch | 写 | compression=true | 单表 | HTTP 请求,开启压缩 |

| | multiThread=true | 单表 | HTTP 请求,是否有多线程 |

| | ignoreWriterError | 单表 | 忽略写入错误,不重试,继续写入 |

| | ignoreParseError=false | 单表 | 忽略解析数据格式错误,继续写入 |

| | alias | 单表 | Elasticsearch 的别名类似于数据库的视图机制,为索引 my_index 创建一个别名 my_index_alias,对 my_index_alias 的操作与 my_index 的操作一致。配置alias表示在数据导入完成后,为指定的索引创建别名。 |

| | aliasMode=append | 单表 | 数据导入完成后增加别名的模式,包括 append(增加模式)和exclusive(只留这一个),append 表示追加当前索引至别名 alias映射中(一个别名对应多个索引),exclusive 表示首先删除别名 alias,再添加当前索引至别名 alias 映射中(一个别名对应一个索引)。后续会转换别名为实际的索引名称,别名可以用来进行索引迁移和多个索引的查询统一,并可以用来实现视图的功能。 |

| | nullToDate=null | 单表 | null 值转 date 类型,填充 null |

Kafka | 写 | kafkaConfig={} | 单表 | 支持 Kafka Producer 配置项 |

元数据字段 | 读/写 | 配置内容 |

Kafka | 读 | __key__ 表示消息的 key

__value__ 表示消息的完整内容

__partition__ 表示当前消息所在分区

__headers__ 表示当前消息 headers 信息

__offset__ 表示当前消息的偏移量

__timestamp__ 表示当前消息的时间戳

|

Elasticsearch | 读 | _id 支持获取 _id 信息 |

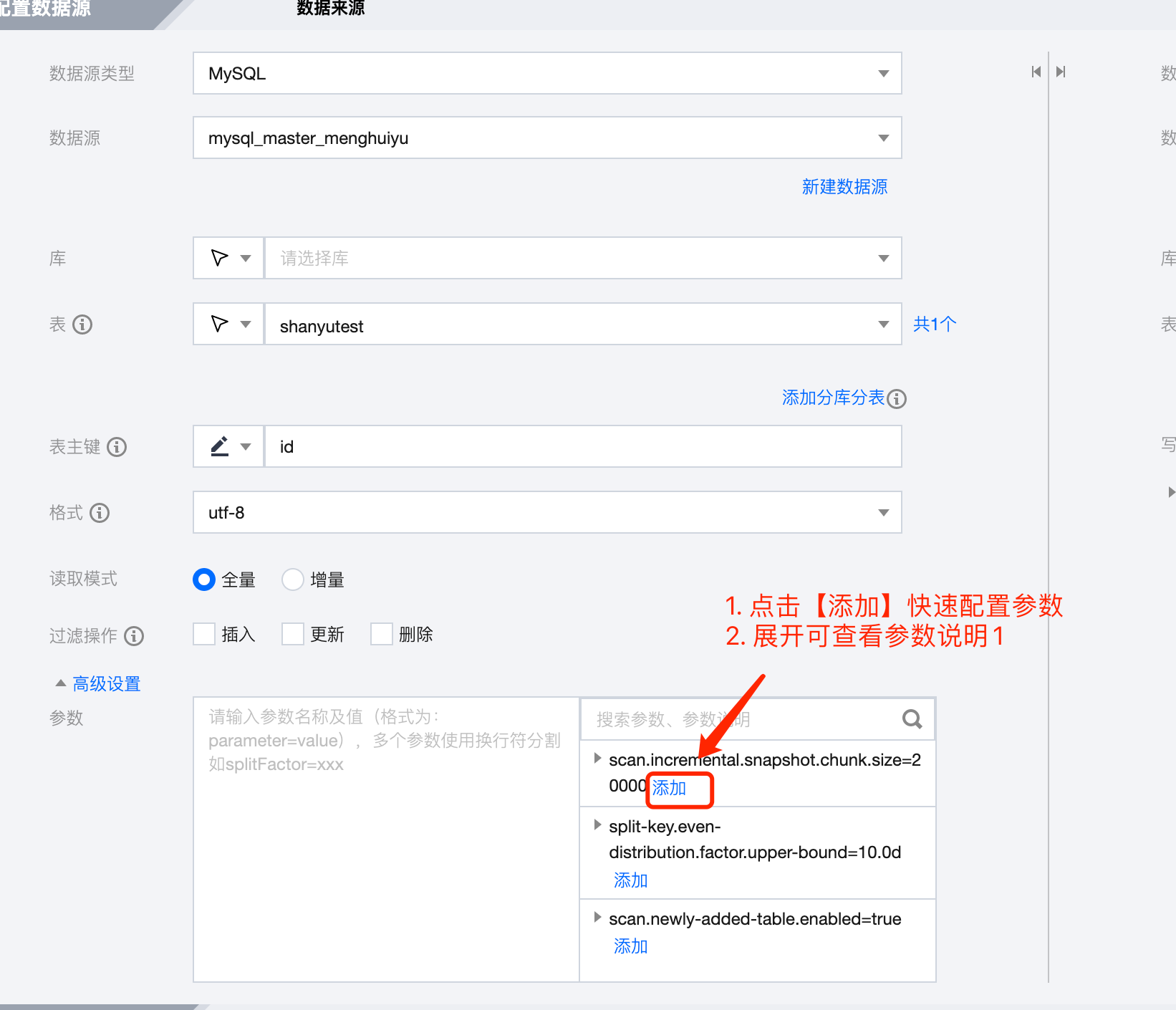

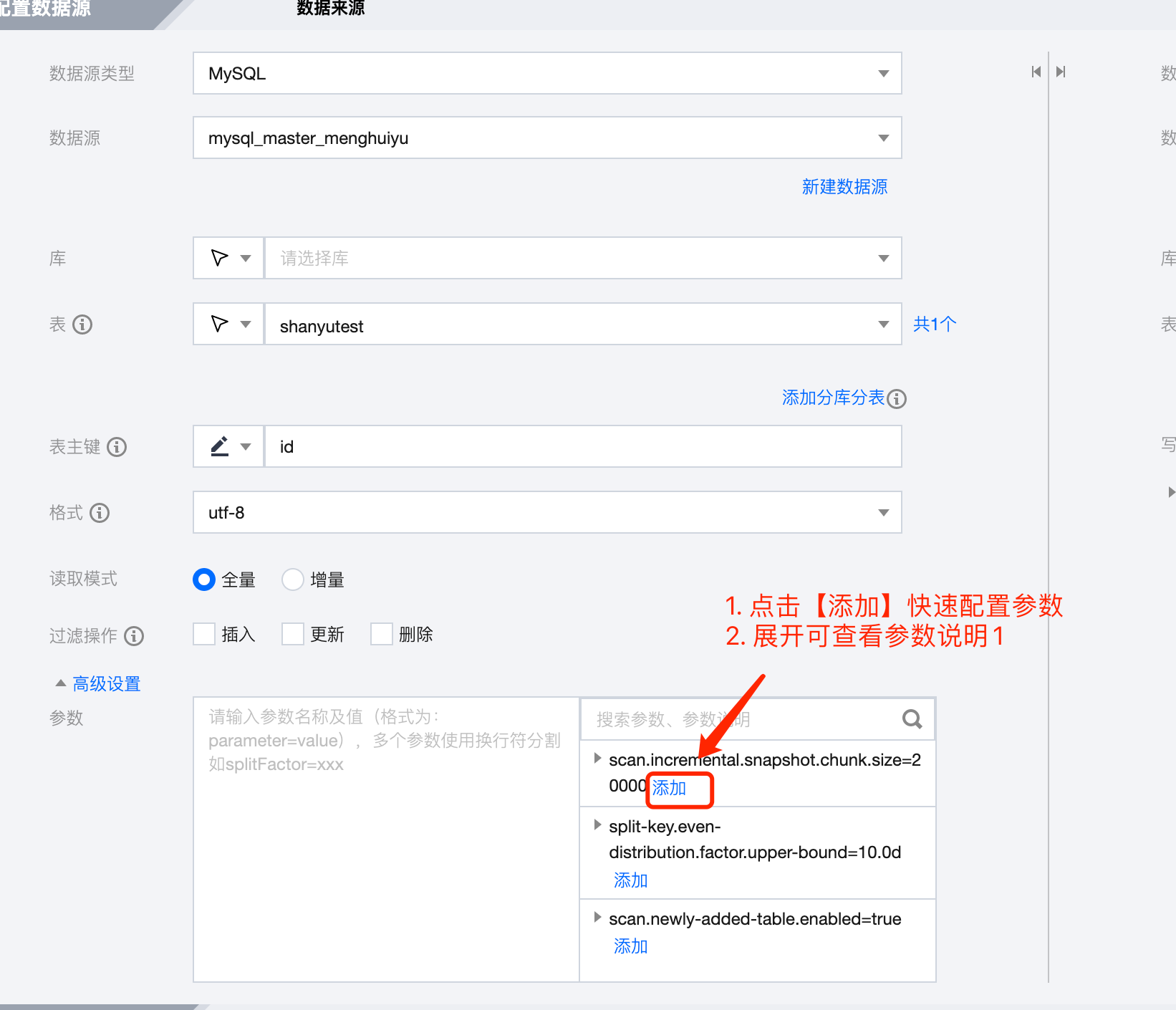

配置方式