腾讯云知识引擎原子能力 DeepSeek OpenAI 对话接口兼容了 OpenAI 的接口规范,这意味着您可以直接使用 OpenAI 官方提供的 SDK 来调用。您仅需要将 base_url 和 api_key 替换成相关配置,不需要对应用做额外修改,即可无缝将您的应用切换到相应的大模型。

base_url:

https://api.lkeap.cloud.tencent.com/v1api_key:需在控制台 API key 页面进行创建,操作步骤请参见 API key 管理。

接口请求地址完整路径:

https://api.lkeap.cloud.tencent.com/v1/chat/completions说明:

默认单账号下的模型限制为:

QPM (Queries Per Minute): 15,000

TPM (Tokens Per Minute): 1,200,000

在线体验

已支持的模型

DeepSeek R1-0528 模型

模型 | model 参数值 | 参数量 | 最大上下文长度 | 最大输入长度 | 最大输出长度 | 思维链最大输出长度 |

DeepSeek-R1-0528 | deepseek-r1-0528 | 671B | 128k | 96k | 16k (不含思维链长度) 默认4k | 32k |

DeepSeek V3-0324 模型

模型 | model 参数值 | 参数量 | 最大上下文长度 | 最大输出长度 |

DeepSeek-V3-0324 | deepseek-v3-0324 | 671B | 128k | 16k 默认4k |

DeepSeek V3.1 模型

模型 | model 参数值 | 参数量 | 最大上下文长度 | 最大输入长度 | 最大输出长度 | 思维链最大输出长度 |

DeepSeek-V3.1 | deepseek-v3.1 | 685B | 128k | 96k | 32k 默认4k | 32k |

DeepSeek-V3.1-Terminus | deepseek-v3.1-terminus | 685B | 128k | 96k | 32k 默认4k | 32k |

DeepSeek-V3.2 模型

模型 | model 参数值 | 参数量 | 最大上下文长度 | 最大输入长度 | 最大输出长度 | 思维链最大输出长度 |

DeepSeek-V3.2 | deepseek-v3.2 | 685B | 128k | 96k | 32k 默认4k | 32k |

说明:

model 参数值:调用模型时携带的“Model”字段,如 deepseek-v3.1。

DeepSeek-R1-0528(model 参数值为 deepseek-r1-0528)

DeepSeek-R1-0528为671B 模型,架构优化与训练策略升级后,相比上一版本在代码生成、长文本处理和复杂推理领域提升明显。

DeepSeek-V3-0324(model 参数值为 deepseek-v3-0324)

DeepSeek-V3-0324 为671B 参数 MoE 模型,在编程与技术能力、上下文理解与长文本处理等方面优势突出。

DeepSeek-V3.1(model 参数值为 deepseek-v3.1)

DeepSeek-V3.1 为685B 参数 MoE 模型,支持混合推理架构,有更高的思考效率和更强的 Agent 能力。

DeepSeek-V3.1-Terminus(model 参数值为 deepseek-v3.1-terminus)

DeepSeek-V3.1-Terminus 为685B 参数 MoE 模型,在保持模型原有能力的基础上,优化了语言一致性和 Agent 能力等问题,输出效果相比前一版本更加稳定。

DeepSeek-V3.2(model 参数值为 deepseek-v3.2)

DeepSeek-V3.2 为685B 参数 MoE 模型,其引入的稀疏注意力架构使长文本处理更高效,并在推理评测中达到GPT-5水平。

注意:

默认单账号下 DeepSeek-V3.2 模型的限制为:

QPM:15,000

TPM:300,000

快速开始

如果您首次使用知识引擎原子能力,请参考 API key 管理 进行知识引擎原子能力的开通,并将示例代码中的 model 参数修改为上表中您需要调用的模型名称。

由于 deepseek-r1 模型的思考过程可能较长,可能导致响应慢或超时,建议您优先使用流式输出方式调用。

安装SDK

您需要确保已安装 Python 3.8或以上版本。

安装或更新 OpenAI Python SDK

运行以下命令:

pip install -U openai

如果运行失败,请将 pip 改为pip3。

示例代码片段

非流式请求

import osfrom openai import OpenAIclient = OpenAI(# 请用知识引擎原子能力API Key将下行替换为:api_key="sk-xxx",api_key="LKEAP_API_KEY", # 如何获取API Key:https://cloud.tencent.com/document/product/1772/115970base_url="https://api.lkeap.cloud.tencent.com/v1",)completion = client.chat.completions.create(model="deepseek-r1-0528", # 此处以 deepseek-r1-0528 为例,可按需更换模型名称。messages=[{'role': 'user', 'content': '请解释一下RESTful API的设计原则'}])print(completion.choices[0].message.content)

import OpenAI from "openai";const openai = new OpenAI({// 请用知识引擎原子能力API Key将下行替换为:apiKey: "sk-xxx",apiKey: "LKEAP_API_KEY", // 如何获取API Key:https://cloud.tencent.com/document/product/1772/115970baseURL: "https://api.lkeap.cloud.tencent.com/v1"});const completion = await openai.chat.completions.create({model: "deepseek-r1-0528", // 此处以 deepseek-r1-0528 为例,可按需更换模型名称。messages: [{ role: "user", content: "请解释一下RESTful API的设计原则" }],});console.log(completion.choices[0].message.content)

curl https://api.lkeap.cloud.tencent.com/v1/chat/completions \\-H "Content-Type: application/json" \\-H "Authorization: Bearer sk-xxxxxxxxxxx" \\-d '{"model": "deepseek-r1-0528","messages": [{"role": "user","content": "请解释一下RESTful API的设计原则"}],"stream": false}'

多轮对话

腾讯云知识引擎原子能力 DeepSeek API 支持使用多轮对话功能,多轮对话功能可以满足如追问、采集等连续多轮对话才能完成交流的场景。服务端不记录用户请求的上下文,用户在每次请求时,需要将之前所有对话的历史拼接好之后,再传递到对话 API。

from openai import OpenAIclient = OpenAI(# 请用知识引擎原子能力API Key将下行替换为:api_key="sk-xxx",api_key="LKEAP_API_KEY", # 如何获取API Key:https://cloud.tencent.com/document/product/1772/115970base_url="https://api.lkeap.cloud.tencent.com/v1",)# 初始对话上下文 - 技术问答示例messages = [{'role': 'user', 'content': '请解释一下RESTful API的设计原则'},{'role': 'assistant', 'content': 'RESTful API的核心原则包括:统一接口、无状态、可缓存、分层系统等'},{'role': 'user', 'content': '能详细说明一下统一接口这个原则吗?'}]print("第一轮对话 - 技术概念探讨")completion = client.chat.completions.create(model="deepseek-r1-0528", # 此处以 deepseek-r1-0528 为例,可按需更换模型名称。messages=messages)print(completion.choices[0].message.content)# 更新对话上下文messages.append({'role': 'assistant', 'content': completion.choices[0].message.content})messages.append({'role': 'user', 'content': '这些原则在实际项目中如何应用?'})print("第二轮对话 - 实践应用")completion = client.chat.completions.create(model="deepseek-r1",messages=messages)print(completion.choices[0].message.content)

import OpenAI from "openai";const openai = new OpenAI({// 请用知识引擎原子能力API Key将下行替换为:apiKey: "sk-xxx",apiKey: "LKEAP_API_KEY", // 如何获取API Key:https://cloud.tencent.com/document/product/1772/115970baseURL: "https://api.lkeap.cloud.tencent.com/v1"});const completion = await openai.chat.completions.create({model: "deepseek-r1-0528", // 此处以 deepseek-r1-0528 为例,可按需更换模型名称。messages: [{ role: "user", content: "请解释一下RESTful API的设计原则"},{ role: "assistant", content: "RESTful API的核心原则包括:统一接口、无状态、可缓存、分层系统等"},{ role: "user", content: "能详细说明一下统一接口这个原则吗?" }],});console.log(completion.choices[0].message.content)

curl https://api.lkeap.cloud.tencent.com/v1/chat/completions \\-H "Content-Type: application/json" \\-H "Authorization: Bearer sk-xxxxxxxxxxx" \\-d '{"model": "deepseek-r1-0528","messages": [{"role": "user","content": "请解释一下RESTful API的设计原则"},{"role": "assistant","content": "RESTful API的核心原则包括:统一接口、无状态、可缓存、分层系统等"},{"role": "user","content": "能详细说明一下统一接口这个原则吗?"}],"stream": true}'

流式输出

deepseek-v3-0324 和 deepseek-r1-0528 模型均支持流式输出;在输出内容比较长的场景下,为降低超时风险,推荐您使用流式输出方式。

from openai import OpenAIimport os# 初始化OpenAI客户端client = OpenAI(# 请用知识引擎原子能力API Key将下行替换为:api_key="sk-xxx",api_key="LKEAP_API_KEY", # 如何获取API Key:https://cloud.tencent.com/document/product/1772/115970base_url="https://api.lkeap.cloud.tencent.com/v1",)def main():reasoning_content = "" # 思维链回答answer_content = "" # 最终回答is_answering = False # 是否思考中的标记符# 发送请求stream = client.chat.completions.create(model="deepseek-r1-0528", # 此处以 deepseek-r1-0528 为例,可按需更换模型名称messages=[{"role": "user", "content": "请解释一下RESTful API的设计原则"}],stream=True)for chunk in stream:delta = chunk.choices[0].delta# 处理空内容情况if not getattr(delta, 'reasoning_content', None) and not getattr(delta, 'content', None):continue# 处理开始回答的情况if not getattr(delta, 'reasoning_content', None) and not is_answering:is_answering = True# 处理思维链回答if getattr(delta, 'reasoning_content', None):reasoning_content += delta.reasoning_content# 处理最终回答elif getattr(delta, 'content', None):print(delta.content, end='', flush=True)answer_content += delta.contentif __name__ == "__main__":try:main()except Exception as e:print(f"发生错误:{e}")

import OpenAI from "openai";const openai = new OpenAI({// 请用知识引擎原子能力API Key将下行替换为:apiKey: "sk-xxx",apiKey: "LKEAP_API_KEY", //如何获取API Key:https://cloud.tencent.com/document/product/1772/115970baseURL: "https://api.lkeap.cloud.tencent.com/v1"});async function main() {let reasoningContent = ""; // 思维链回答let answerContent = ""; // 最终回答let isAnswering = false; // 是否思考中的标记符const completion = await openai.chat.completions.create({model: "deepseek-r1-0528", // 此处以 deepseek-r1-0528 为例,可按需更换模型名称messages: [{ role: 'user', content: '请解释一下RESTful API的设计原则' }],stream: true,});for await (const chunk of completion) {const delta = chunk.choices[0].delta;// 处理空内容情况if (!delta.reasoning_content && !delta.content) {continue;}// 处理开始回答的情况if (!delta.reasoning_content && !isAnswering) {isAnswering = true;}// 处理思维链回答if (delta.reasoning_content) {reasoningContent += delta.reasoning_content;}// 处理最终内容else if (delta.content) {process.stdout.write(delta.content);answerContent += delta.content;}}}main().catch(console.error);

curl https://api.lkeap.cloud.tencent.com/v1/chat/completions \\-H "Content-Type: application/json" \\-H "Authorization: Bearer sk-xxxxxxxxxxx" \\-d '{"model": "deepseek-r1-0528","messages": [{"role": "user","content": "请解释一下RESTful API的设计原则"}],"stream": true}'

DeepSeek V3.1/DeepSeek-V3.2

deepseek-v3.1 和 deepseek-v3.2 模型均支持思考模式与非思考模式,可通过参数开启或关闭思维链。

import osfrom openai import OpenAIclient = OpenAI(# 请用知识引擎原子能力API Key将下行替换为:api_key="sk-xxx",api_key="LKEAP_API_KEY", # 如何获取API Key:https://cloud.tencent.com/document/product/1772/115970base_url="https://api.lkeap.cloud.tencent.com/v1",)completion = client.chat.completions.create(model="deepseek-v3.1",messages=[{'role': 'user','content': '请解释一下RESTful API的设计原则'}],extra_body={"thinking": {# "type": "disabled" 不带思维链# "type": "enabled" 包含思维链"type": "enabled"}})print(completion.choices[0].message.content)

import OpenAI from "openai";const openai = new OpenAI({// 请用知识引擎原子能力API Key将下行替换为:apiKey: "sk-xxx",apiKey: "LKEAP_API_KEY", // 如何获取API Key:https://cloud.tencent.com/document/product/1772/115970baseURL: "https://api.lkeap.cloud.tencent.com/v1"});const completion = await openai.chat.completions.create({model: "deepseek-v3.1",messages: [{ role: "user", content: "请解释一下RESTful API的设计原则" }],thinking: {type: "enabled"},});console.log(completion.choices[0].message.content)

curl https://api.lkeap.cloud.tencent.com/v1/chat/completions \\-H "Content-Type: application/json" \\-H "Authorization: Bearer sk-xxxxxxxxxxx" \\-d '{"model": "deepseek-v3.1","messages": [{"role": "user","content": "请解释一下RESTful API的设计原则"}],"thinking": {"type": "enabled"},"stream": false}'

注意事项

稳定性

若执行后出现“concurrency exceeded”的响应,则表明您的请求遭遇了限流。这通常是由于服务器资源暂时不足所致。建议您稍后再试,届时服务器负载可能已得到缓解。

DeepSeek-R1-0528

不推荐设置 System Prompt。

参数配置说明 | 具体参数和功能 |

不支持设置的功能 | Function Calling、对话前缀续写、上下文硬盘缓存 |

不支持的参数 | logprobs、top_logprobs、stop |

支持的参数 | top_p、temperature、max_tokens、presence_penalty、frequency_penalty、json_object、json_schema |

参数默认值 | temperature:0.6(取值范围是[0:2]),top_p:0.6(取值范围是(0:1]) |

DeepSeek-V3-0324

参数配置说明 | 具体参数和功能 |

不支持设置的功能 | 对话前缀续写、上下文硬盘缓存 |

不支持的参数 | logprobs、top_logprobs |

支持的参数 | top_p、temperature、max_tokens、presence_penalty、frequency_penalty、stop、Function Calling、json_object |

参数默认值 | temperature:0.6(取值范围是[0:2]),top_p:0.6(取值范围是(0:1]) |

DeepSeek-V3.1

推荐使用 deepseek-v3.1-terminus 版本。

参数配置说明 | 具体参数和功能 |

不支持设置的功能 | 对话前缀续写、上下文硬盘缓存 |

不支持的参数 | logprobs、top_logprobs |

支持的参数 | top_p、temperature、max_tokens、Function Calling、presence_penalty、frequency_penalty、stop、thinking、json_object |

参数默认值 | temperature:0.6(取值范围是[0:2]),top_p:0.6(取值范围是(0:1]) |

DeepSeek-V3.2

参数配置说明 | 具体参数和功能 |

不支持设置的功能 | 对话前缀续写、上下文硬盘缓存 |

不支持的参数 | logprobs、top_logprobs |

支持的参数 | top_p、temperature、max_tokens、presence_penalty、frequency_penalty、stop、thinking、json_object、json_schema、Function Calling |

参数默认值 | temperature:0.6(取值范围是[0:2]),top_p:0.6(取值范围是(0:1]) |

敬请关注后续动态。

联网搜索

本接口支持联网搜索,前提是开启 DeepSeek API 的服务。若需要使用相关联网搜索功能,首先需要开启联网搜索后付费开关或者购买搜索服务的资源包,然后通过传入 enable_search 参数体验 DeepSeek 的联网搜索能力(仅支持流式输出场景)。

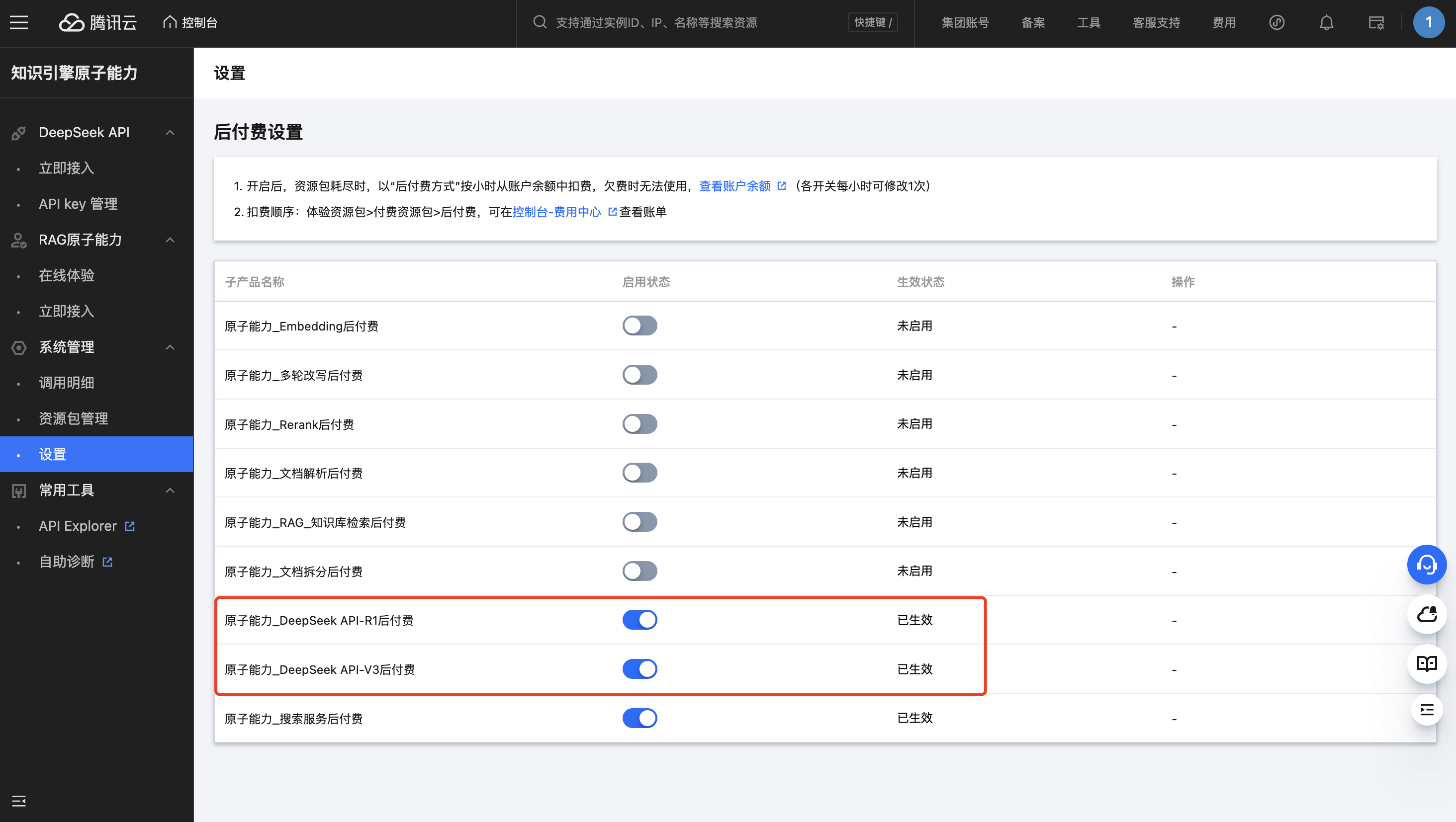

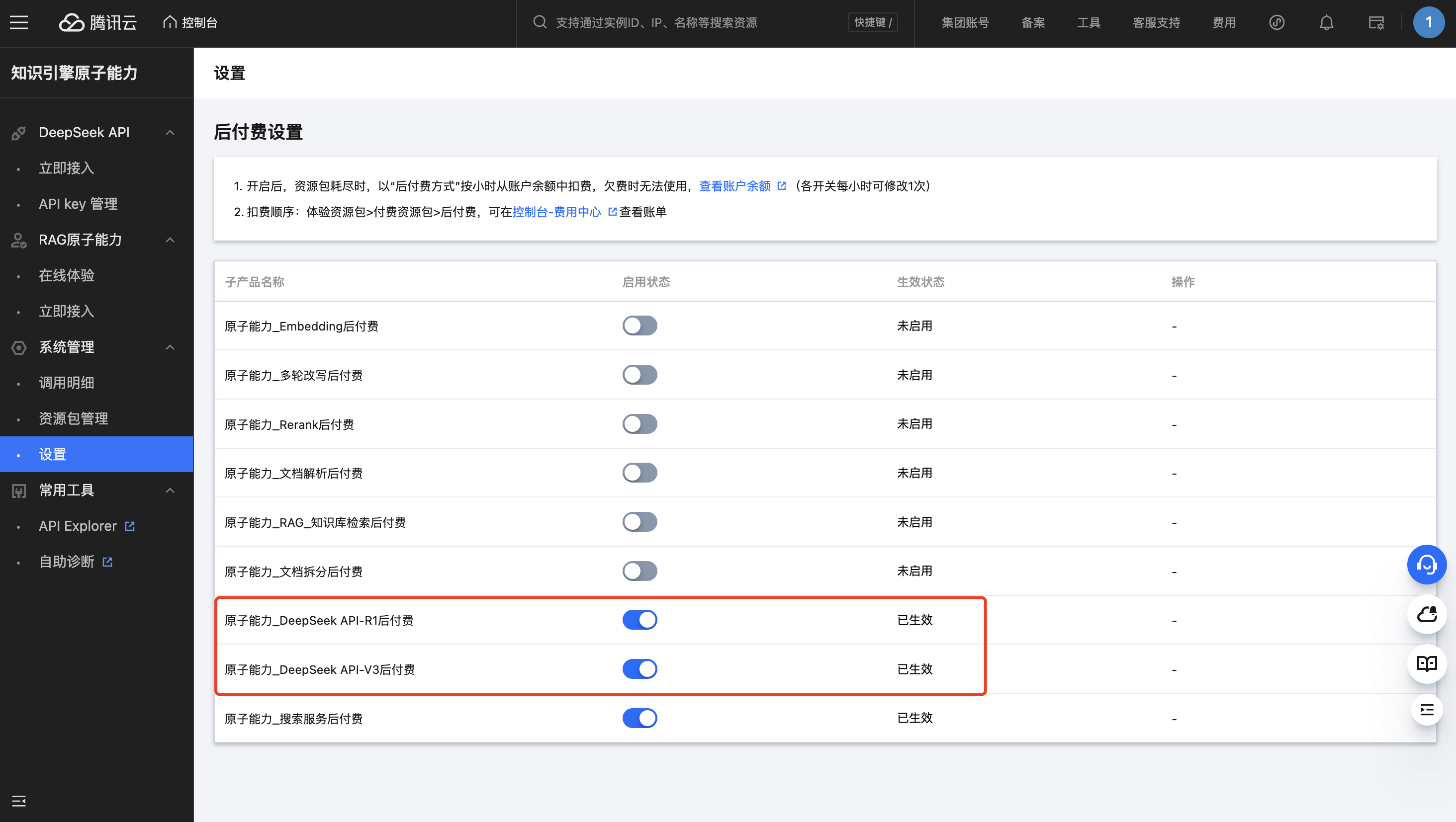

1. 首先开启 DeepSeek API 的服务,进入 原子能力控制台 开启 DeepSeek 的后付费开关。

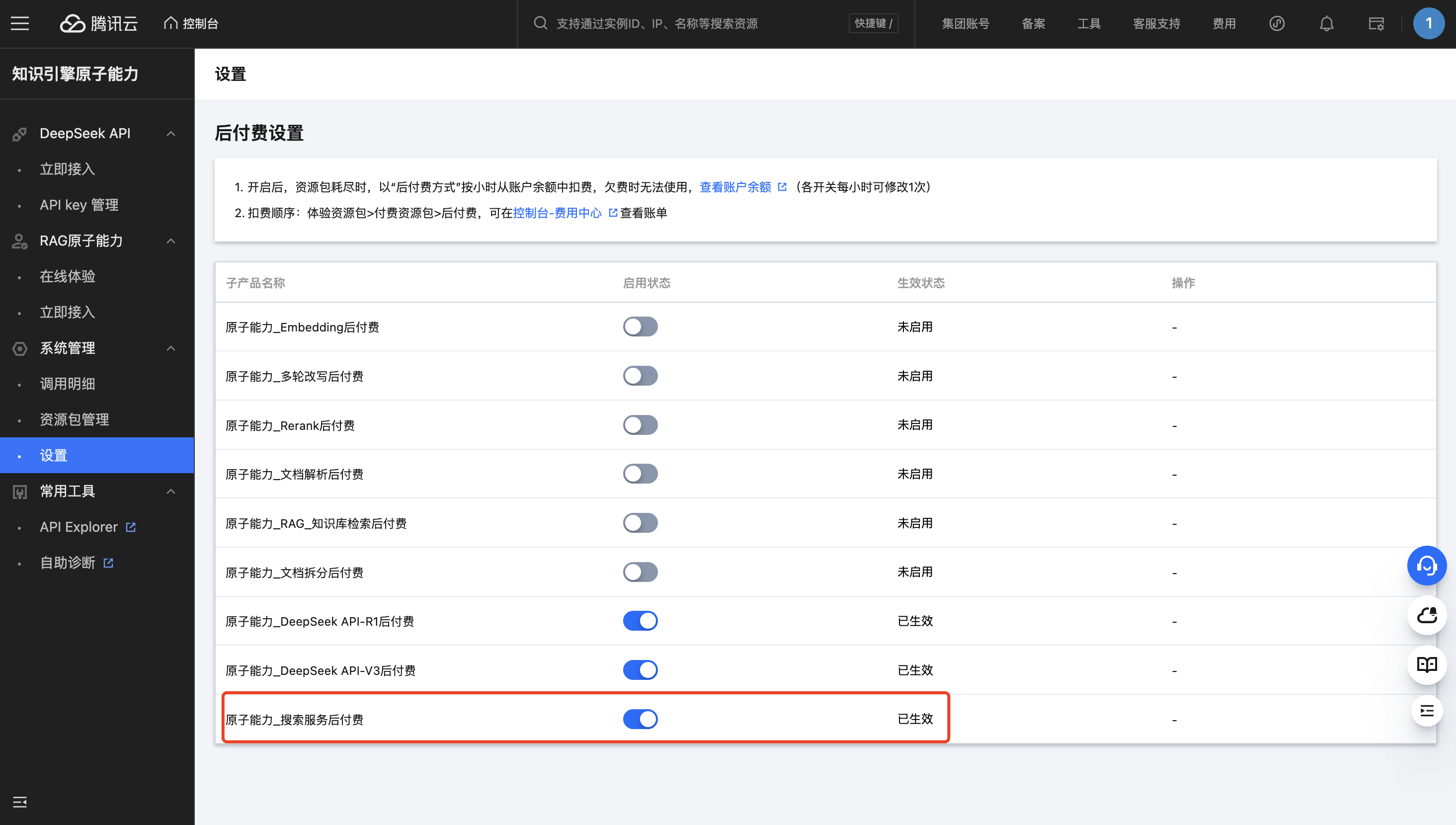

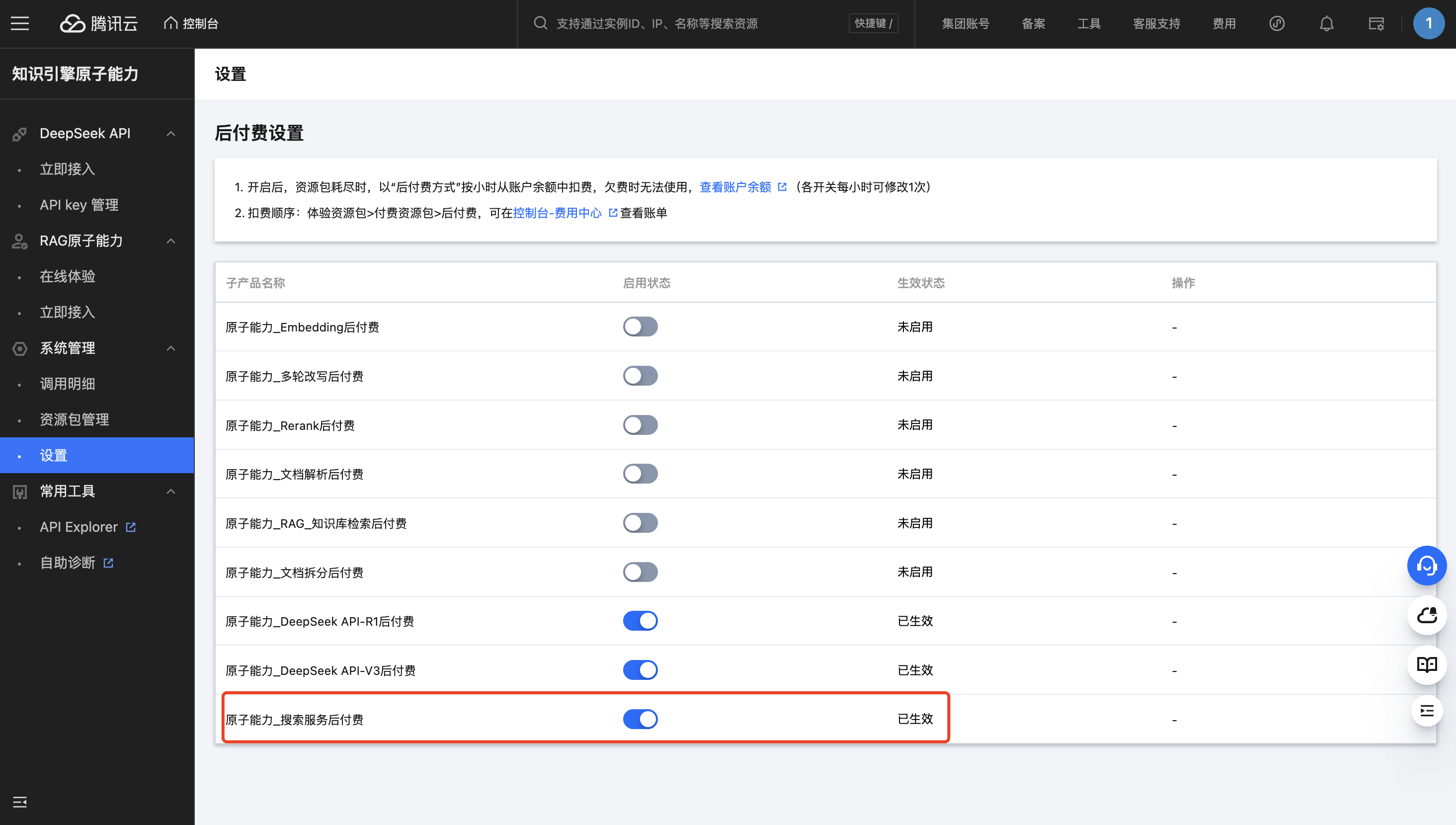

2. 进入 原子能力控制台 打开联网搜索后付费开关或者购买搜索服务的资源包。

开启搜索服务的后付费开关:

购买搜索服务的资源包:

3. 调用 DeepSeek API 接口的时候,增加 enable_search 参数体验带联网搜索能力的 DeepSeek API。

输入示例:

import osfrom openai import OpenAIclient = OpenAI(# 请用知识引擎原子能力API Key将下行替换为:api_key="sk-xxx",api_key="LKEAP_API_KEY", # 如何获取API Key:https://cloud.tencent.com/document/product/1772/115970base_url="https://api.lkeap.cloud.tencent.com/v1",)completion = client.chat.completions.create(model="deepseek-v3-0324", # 此处以deepseek-v3-0324为例,可按需更换模型名称。messages=[{"role": "user","content": "深圳今日天气"}],extra_body={"enable_search": True, # 开启联网搜索})print(completion.choices[0].message.content)

import OpenAI from "openai";const openai = new OpenAI({// 请用知识引擎原子能力API Key将下行替换为:apiKey: "sk-xxx",apiKey: "LKEAP_API_KEY", // 如何获取API Key:https://cloud.tencent.com/document/product/1772/115970baseURL: "https://api.lkeap.cloud.tencent.com/v1"});const completion = await openai.chat.completions.create({model: "deepseek-v3-0324", // 此处以deepseek-v3-0324为例,可按需更换模型名称。messages: [{ role: "user", content: "深圳今日天气" }],enable_search: true, // 开启联网搜索});console.log(completion.choices[0].message.content)

curl https://api.lkeap.cloud.tencent.com/v1/chat/completions \\-H "Content-Type: application/json" \\-H "Authorization: Bearer sk-xxxxxxxxxxx" \\-d '{"model": "deepseek-r1-0528","messages": [{"role": "user","content": "深圳今日天气"}],"enable_search": true,"stream": false}'

输出示例:

{'id': '0c9eba283a56d0add6084e24263056b7', 'choices': [{'finish_reason': 'stop', 'index': 0, 'logprobs': None, 'message': {'content': '根据深圳市气象局(台)的预报,2025年4月29日深圳的天气情况如下:\\n\\n今天深圳多云间阴天,早晚有轻雾,部分时间可见阳光,偏东风最大阵风6-7级,气温22-29℃。相对湿度在40%-70%之间。\\n\\n具体来说,今天的气温预计在22℃到29℃之间,风向为偏东风,风力为2-3级,沿海、高地和海区阵风可达5-6级。此外,今天日出时间为05:52,日落时间为18:49。\\n\\n需要注意的是,今天早晚有轻雾,部分时间可见阳光,建议关注清劲偏东风的影响。\\n\\n总结:今天深圳的天气以多云间阴天为主,气温适中,早晚有轻雾,风力较大,适合外出但需注意防风。', 'refusal': None, 'role': 'assistant', 'annotations': None, 'audio': None, 'function_call': None, 'tool_calls': None, 'search_results': [{'index': 1, 'url': 'http://weather.sz.gov.cn/?COLLCC=2354144265&', 'name': '深圳市气象局(台)', 'snippet': '深圳市气象局(台) 今日预报 实况 29.4℃ 12-20时 多云;气温27-30℃;东风2-3级,沿海、高地和海区阵风5-6级;相对湿度40%-70%。 05:52 日出 18:49 日落 6天 距立夏剩 06:40 月出 20:41 月落 4月29日12时56分 深圳福田国家基本气象站 东南偏东风 小于三级 相对湿度 0mm 24小时降雨量 十天预报 逐时预报 展开 【天气提示】 预计29日多云间阴天,早晚有轻雾,部分时间可见阳光,偏东风最大阵风6-7级,气温22-29℃;30日多云到阴天,局地有短时阵雨,早晚清凉;展望五一假期,初期和末期有(雷)阵雨,局地雨势较大,中期以多云为主,间中有短时阵雨,午间较热。建议关注29日清劲偏东风的影响。 明天 4-30 周四 5-1 周五 5-2 周六 5-3 周日 5-4 周一 5-5 周二 5-6 周三 5-7 周四 5-8 13时 多云 14时 多云 15时 多云 16时 多云 17时 多云 18时 多云 19时 多云 20时 多云 21时 少云 热 点 推 荐 工作动态 公告公示 重要资讯 公开目录 媒体聚焦 庆祝中华全国总工会成立100周年暨全国劳动模范和先进工作者表彰大会隆重举行 习近平发表重要讲话 04/29 广交会上看外贸新动能 04/29 新,高质量发展看动能 04/29 一季度规模以上工业企业利润由降转增 04/29 暴涨96%!一季度“中国游 中国购”持续升温 04/29 李强主持召开国务院常务会议 部署开展美丽河湖保护与建设行动 研究进一步加强困境儿童福利保障有关举措 讨论《中华人民共和国医疗保障法(草案)》 决定核准浙江三门三期工程等核电项目 04/28 经济日报:消费市场保持升温势头|中国经济新看点 04/27 规范涉企执法,怎样防止问题反弹、提振企业信心?', 'icon': '', 'site': 'weather.sz.gov.cn', 'published_time': 1745856000}]}}], 'created': 1745929940, 'model': 'deepseek-v3-aisearch', 'object': 'chat.completion', 'service_tier': None, 'system_fingerprint': None, 'usage': {'completion_tokens': 189, 'prompt_tokens': 3366, 'total_tokens': 3555, 'completion_tokens_details': None, 'prompt_tokens_details': None}}

深度思考

只要调用 deepseek-r1-0528 模型即代表开启深度思考(深度思考过程通过 reasoning_content 返回)。

查看更多完整示例

错误码

错误码 | 错误信息 | 说明 |

20024 | invalid params | |

20031 | not enough quota | |

20033 | invalid model | 模型名称错误,请检查模型名称。 |

20034 | concurrency rate limit exceeded | 并发限流错误。这通常是由于服务器资源暂时不足所致。建议您稍后再试,届时服务器负载可能已得到缓解。 |

20052 | concurrency exceeded | 模型服务负载过高限流错误,请稍后重试。 |

20057 | model engine error | 模型引擎错误,请您稍后重试,或者联系平台技术同学处理。 |

20059 | input length too long | 输入长度超过上下文长度,请减小输入内容的长度。 |

20062 | internet search not enough quota | |

20072 | tpm rate limit exceeded | TPM 限流错误。 |

错误示例

{"error":{"message":"not enough quota","type":"runtime_error","param":null,"code":"20031"}}

安全审查示例

finish_reason = content_filter 表示输出内容触发了安全审核机制。这通常发生在系统检测到某些输入或输出内容可能包含敏感信息或不适当的语言,因此自动启动了审核流程以确保内容的安全性和适宜性。在这种情况下,系统会对相关内容进行仔细审查,以防止不当信息的传播。

非流式输出示例:

{"id":"26a58a8ab6e7712937ad542436b4b97a","object":"chat.completion","created":1740379897,"model":"deepseek-r1-0528","choices":[{"index":0,"message":{"role":"assistant","content":"你好,我无法给到相关内容。"},"finish_reason":"content_filter"}],"usage":{"prompt_tokens":0,"completion_tokens":0,"total_tokens":0}}

流式输出示例:

data: {"id":"d2d486bfdb31b1b6f55c8b5cbeb492d3","object":"chat.completion.chunk","created":1740379627,"model":"deepseek-r1-0528","choices":[{"index":0,"delta":{"role":"assistant","content":"你好,我无法给到相关内容。"},"finish_reason":"content_filter"}],"usage":{"prompt_tokens":0,"completion_tokens":0,"total_tokens":0}}