本文介绍如何通过新版容器服务控制台快速创建标准 TKE 集群,可在集群创建后再添加 Worker Node。

前提条件

创建集群前,您需要完成以下工作:

集群创建过程中将使用私有网络、子网、安全组等多种资源。资源所在地域具备一定的配额限制,详情请参见 购买集群配额限制。

通过控制台创建集群

2. 单击集群列表上方的新建。

3. 在集群类型中,选择标准集群,单击创建。

1. (必填)填写集群信息

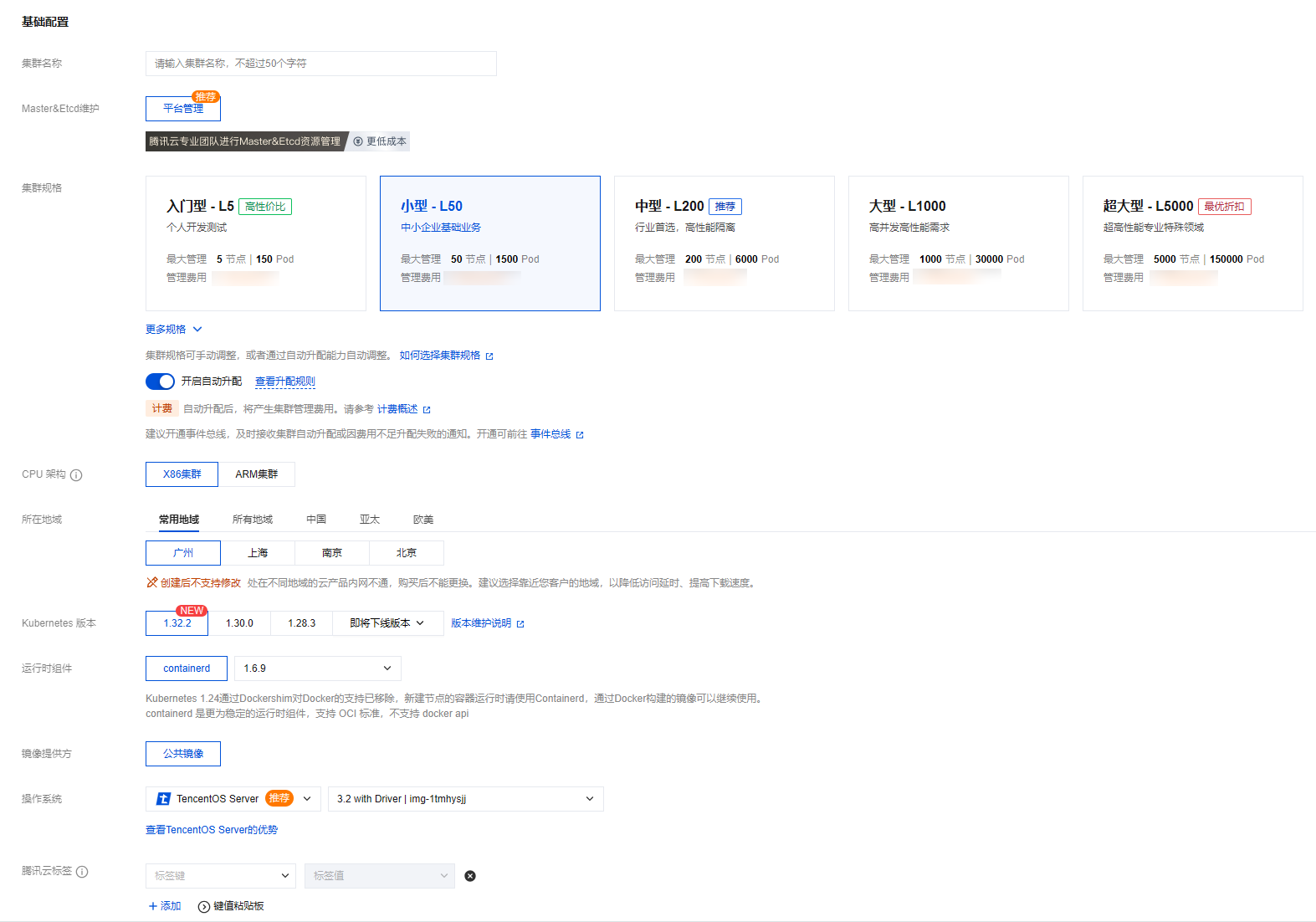

在集群信息页面,设置集群的基础配置。

基础配置核心参数说明

参数名称 | 使用说明 |

集群名称 | 输入要创建的集群名称,不超过50个字符。 |

Master&Etcd 维护 | 平台管理:由腾讯云专业团队维护集群控制面组件,需支付一定的管理费用,详情请参见 集群管理费用。 自行维护(已停止新建):需用户自行购买、维护和管理控制面资源,平台不提供服务保障。 |

集群规格 | |

CPU 架构 | 满足如下条件的集群支持 x86 和 arm 架构混合部署,可通过节点池对 worker 进行分别管理。 1. k8s >= 1.24,containerd= 1.6.9 版本; 2. 集群网络模式非 Cilium-Overlay; 3. 集群未开启双栈功能。 |

所在地域 | |

Kubernetes 版本 | |

运行时组件 | 推荐您选择 containerd 支持的最新版本。(Kubernetes 1.24通过 Dockershim 对 Docker 的支持已移除,TKE 新建节点的容器运行时仅支持 Containerd 1.6.9。) |

操作系统 | |

腾讯云标签 | 为集群绑定标签后可实现资源的分类管理,在集群内创建的云资源会默认继承集群标签。 |

高级设置参数说明

参数名称 | 使用说明 |

节点 hostname 命名模式 | 主机和节点命名规则,支持设置“自动命名(默认为内网 IP)”和“手动命名”。 |

自定义参数 | 设置和管理 Kubernetes 控制面组件(APIServer、KubeControllerManager、KubeScheduler)的参数。详情请参见 自定义 Kubernetes 组件启动参数。 |

新增资源所属项目 | |

删除保护 | 开启后可阻止通过控制台或云 API 误删除本集群。 |

数据加密 | 开启可对 ETCD 中存储的 Secret 数据进行加密。 |

2. (必填)填写网络配置

网络配置核心参数说明

参数名称 | 使用说明 |

VPC 网络 | |

容器网络插件 | CNI(Container Network Interface)网络插件是一种用于 Kubernetes 集群的网络解决方案,提供灵活、可扩展和高性能的网络连接。CNI TKE 网络插件遵循 CNI 规范,允许 Kubernetes 集群与各种网络解决方案无缝集成,以满足不同的业务需求和性能要求。TKE 提供了三种网络 CNI 插件方案:VPC-CNI、Global Router 和 Cilium-Overlay,详情请参见 如何选择容器网络模式。 注意: TKE 推荐用户在公有云场景下使用 “VPC-CNI” 网络方案,在注册节点场景下使用 “Cilium-Overlay” 网络方案。 VPC-CNI 网络方案 TKE 默认推荐用户使用VPC-CNI 方案。VPC-CNI 网络方案是 TKE 基于腾讯云 VPC 实现的容器网络接口 CNI,可以将 VPC 原生的弹性网卡直接分配给 Pod,实现 Pod 之间的网络互联,适用于对时延有较高需求的场景。该网络模式下,容器与节点分布在同一网络平面,容器 IP 为 IPAMD 组件分配的弹性网卡 IP。详情请参见 VPC-CNI 方案介绍。 Global Router 网络方案 Global Router 网络方案是 TKE 基于腾讯云 VPC 的全局路由能力实现的容器网络接口 CNI。其中 Pod CIDR 网段独立于 VPC 的 CIDR 网段,不同节点的 Pod CIDR 信息会通过全局路由方式下发到 VPC,实现跨节点 Pod 的互访。详情请参见 Global Router 方案介绍。 Cilium-Overlay 网络方案 Cilium-Overlay 网络方案是 TKE 基于 Cilium VXLan 实现的容器网络插件,实现分布式云场景中,注册节点添加到 TKE 集群的网络管理。详情请参见 Cilium-Overlay 方案介绍。 |

高级设置参数说明

参数名称 | 使用说明 |

Dataplane v2 | 开启 Dataplane v2 后不再安装 kube-proxy,默认采用 cilium 进行转发。 |

Kube-proxy 转发模式 | 可选择 iptables 或 ipvs。 iptables 适用于集群内少量 service 的场景。注意一经选择将不支持更改。 ipvs 适用于将在集群中运行大规模服务的场景,开启后不能关闭。详情请参见 集群启用 IPVS。 |

忽略 Service IP 冲突校验 | 忽略后当前集群不会和相同 VPC 下其他集群做 Service CIDR 冲突校验,将导致当前集群和相同 VPC 下其他集群 Service 无法互通。 |

Pod 数量上限/节点 | 自定义设置 Pod 数量上限。 |

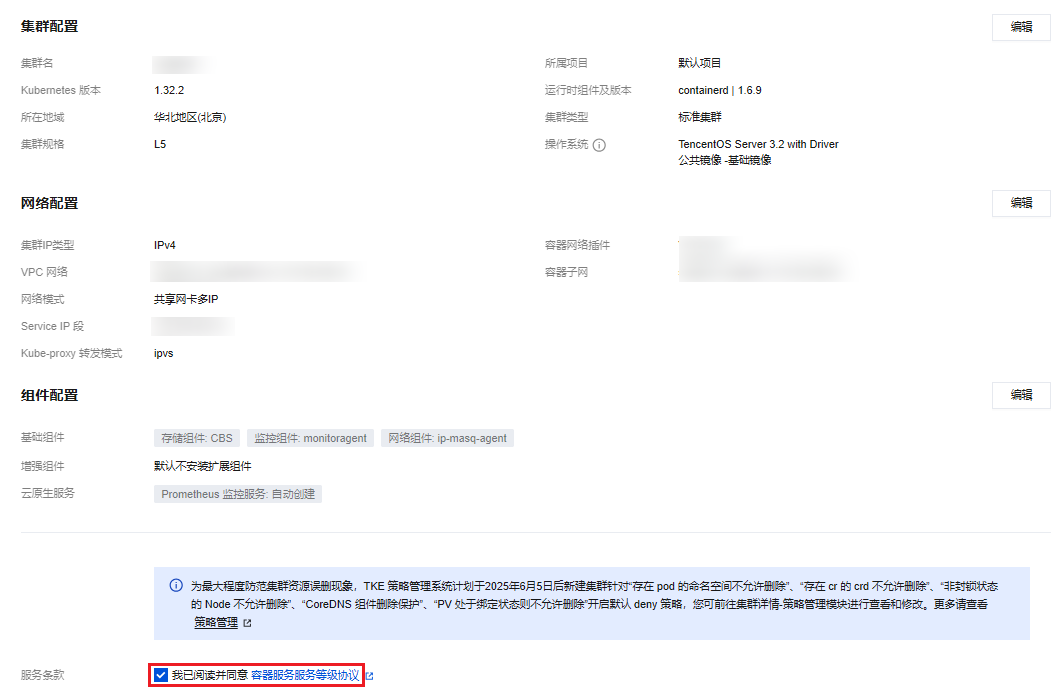

3. (选填)填写组件配置

在组件配置页面,设置集群的组件和云原生服务。

说明:

基础组件参数说明

参数名称 | 使用说明 |

存储组件 | |

监控组件 | monitoragent 组件负责采集容器、Pod、节点维度的监控数据,对接基础监控提供容器运维所需的基础监控大盘和告警功能。 |

网络组件 | ip-masq-agent 组件负责管理容器出站流量的源 IP 伪装规则,通过动态配置 iptables 确保 Pod 访问集群外目标时使用节点 IP 作为源地址。 |

增强组件参数说明

云原生服务参数说明

参数名称 | 使用说明 |

Prometheus 监控服务 | |

日志服务 |

4. 信息确认

单击完成即可创建一个不包含 Worker Node 的 TKE 标准集群。