任务创建失败怎么处理?

转储的任务创建失败时,在控制台中会有一个提示。

一般情况下,能够通过这个提示检查:

1. 出现“连接XXX失败,请检查用户名、密码是否有误”,检查输入的用户名密码是否有误,然后重新创建任务输入正确的参数来解决创建失败的问题。

2. 出现“连接失败,请检查端口是否允许连接”,检查端口是否允许连接,可参见 Mongo Stream 数据变更记录分析 内的安全组开放端口。

3. 出现“数据库不存在这个表,表:xxx”,检查该数据库是否存在这个表。

4. 出现“createLink fail”,出现打通网络失败时,需要 联系我们 查看原因。

任务状态异常如何处理?

转储的任务发生异常时,在控制台中会有一个提示。

一般情况下,客户能通过异常信息的提示排查问题:

1. 出现“源 CKafka 实例不存在”或“目标 CKafka 实例不存在”时,查看是否当前实例被删除或者出现异常。

2. 出现“源 Topic 不存在”或“目标 Topic 不存在”时,查看是否为 CKafka 实例内的 Topic 是否被删除。

3. 出现“请检查账号、密码是否有误”,检查用户名密码是否更改过,需要重新去更改任务内的用户名密码。

任务并发度是什么?

每个任务(指非数据上报的任务)都会有一个并发度的概念,任务创建的时候默认的并发度是1。在任务运行过程中,系统会自动检测数据的堆积情况:

1. 当出现数据堆积时,系统会自动扩容并发度,加大数据的吞吐。

2. 当数据量低的时候,系统会缩容并发度,避免不必要的损耗。

在数据处理和数据转储的场景中:并发度最小是1,最大是 kafka topic 的分区数。

在数据接入场景中,并发度会根据上游引擎来调整,最小是1,最大暂无上限,视具体需求而定。

Mongo 接入的原理是什么?

Change Stream 是 MongoDB 记录数据变更的一种方式。当数据库中有任何数据发生变化,应用端都可以通过 change stream 机制得到变更信息。我们可以将其理解为在应用中执行的触发器。至于应用想得到什么数据,以什么形式得到数据,则可以通过聚合框架加以过滤和转换。

Mongo的数据是分区有序的吗?

MongoDB 的数据默认情况下,是按照 MongoDB 的 object id 作为 key,写入到分区中的。所以在分区不变的情况下,是可以分区有序的。如果订阅过程中,扩容了分区,就会出现重新 hash 的情况,会出现消费时短暂的同一行记录的变更数据没有顺序。

Role 角色缺失怎么处理?

1. 在账号列表下找到访问管理。

2. 在左侧导航栏选择角色,单击新建角色。

3. 角色载体选择腾讯云产品服务。

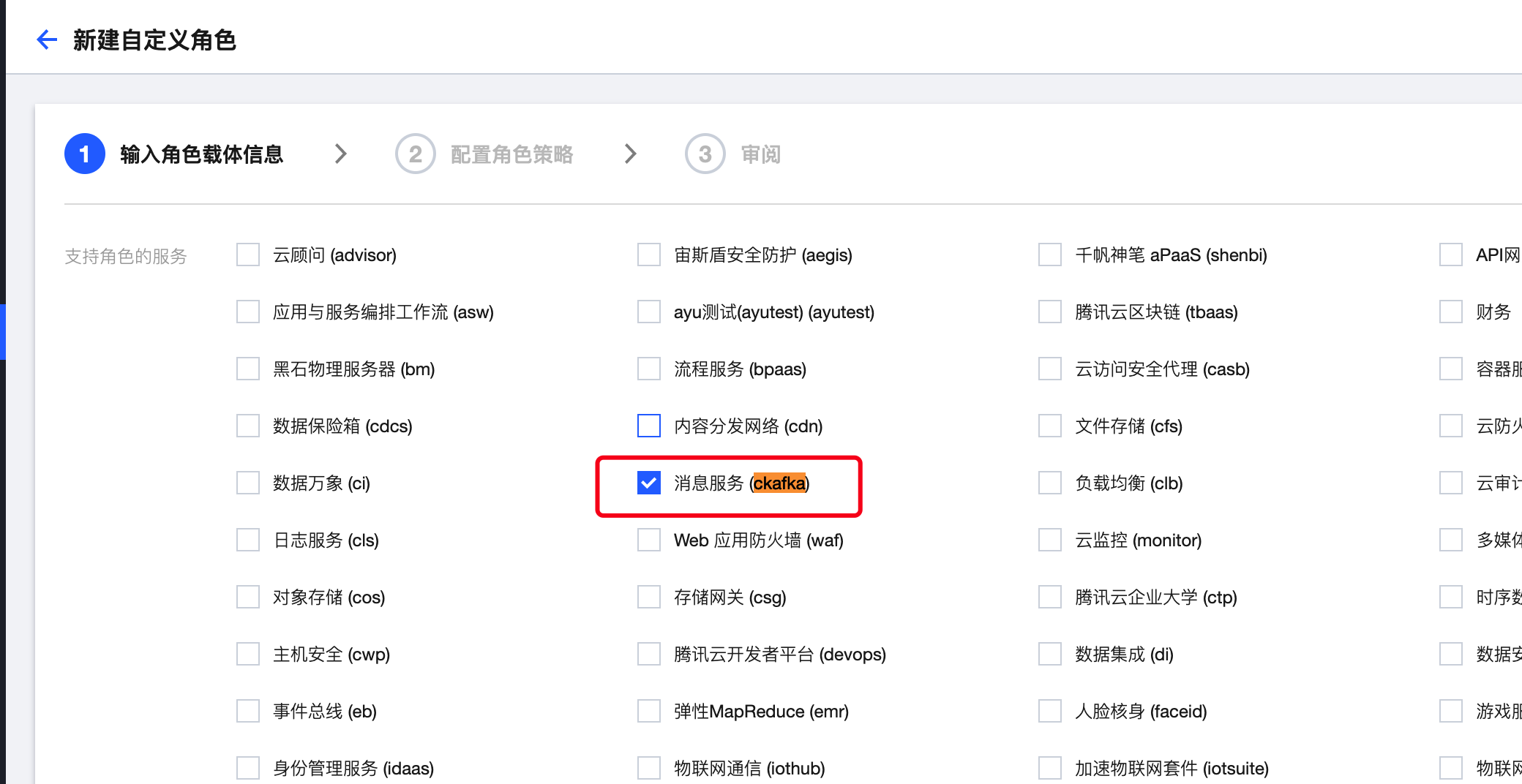

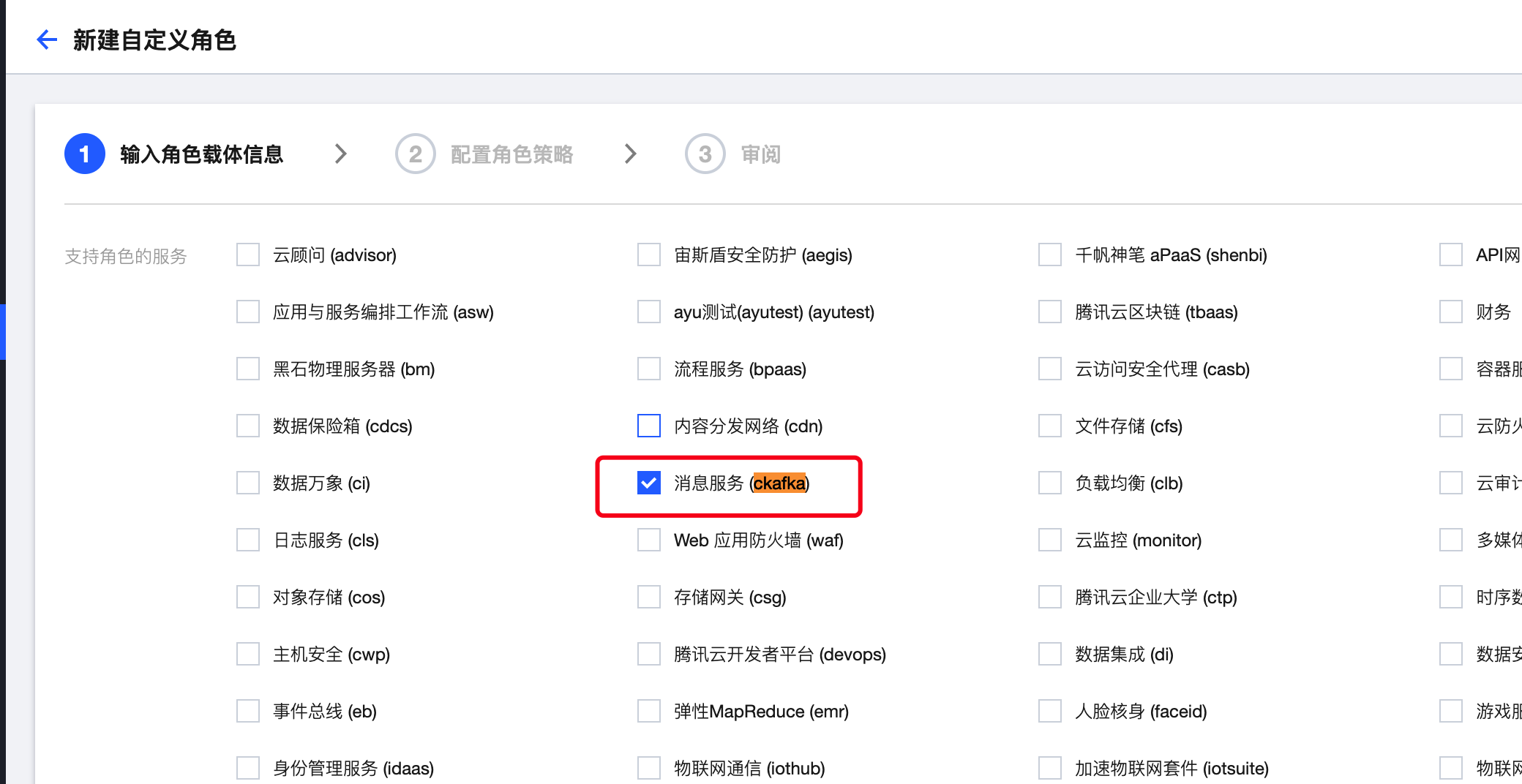

4. 在输入角色载体信息中找到消息服务(ckafka)。

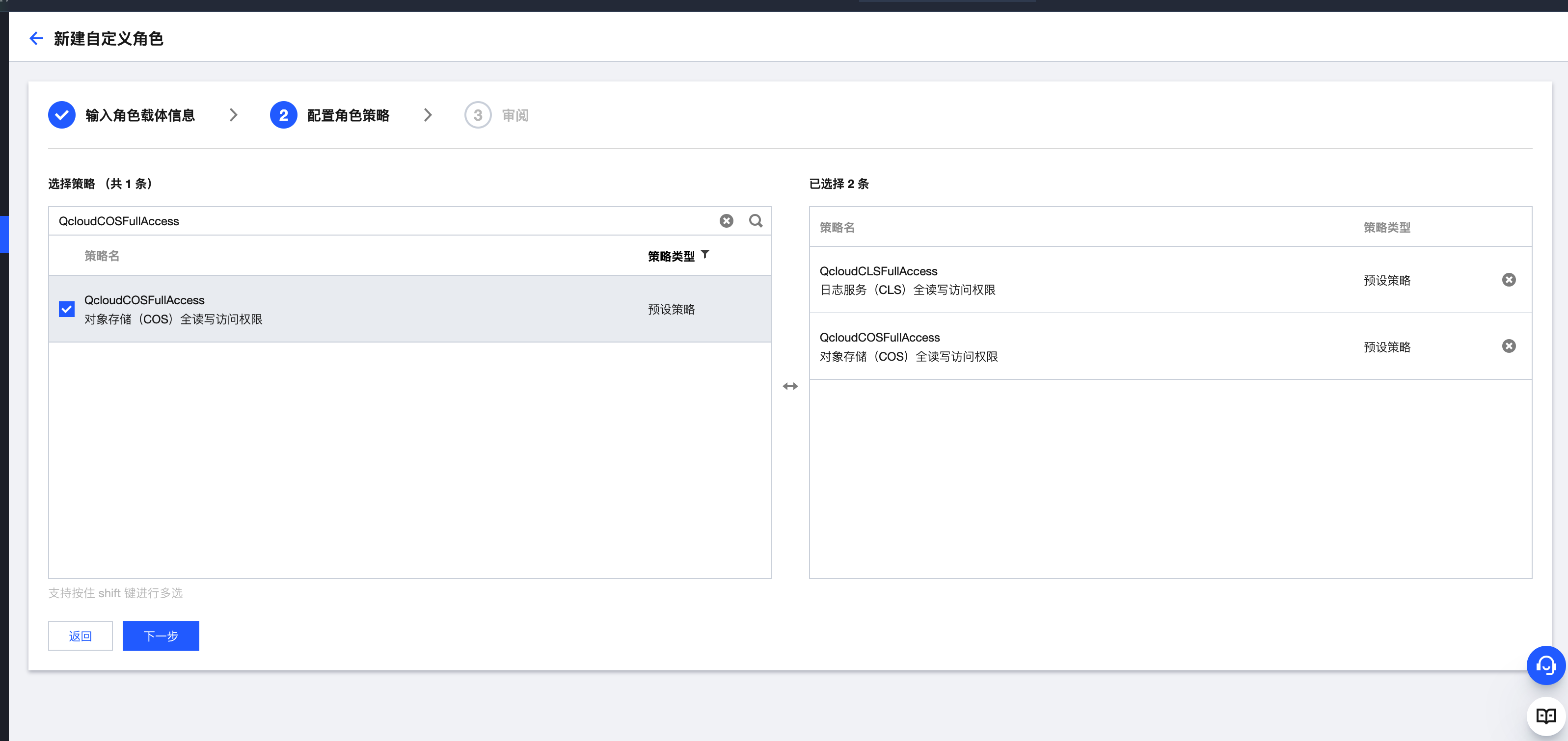

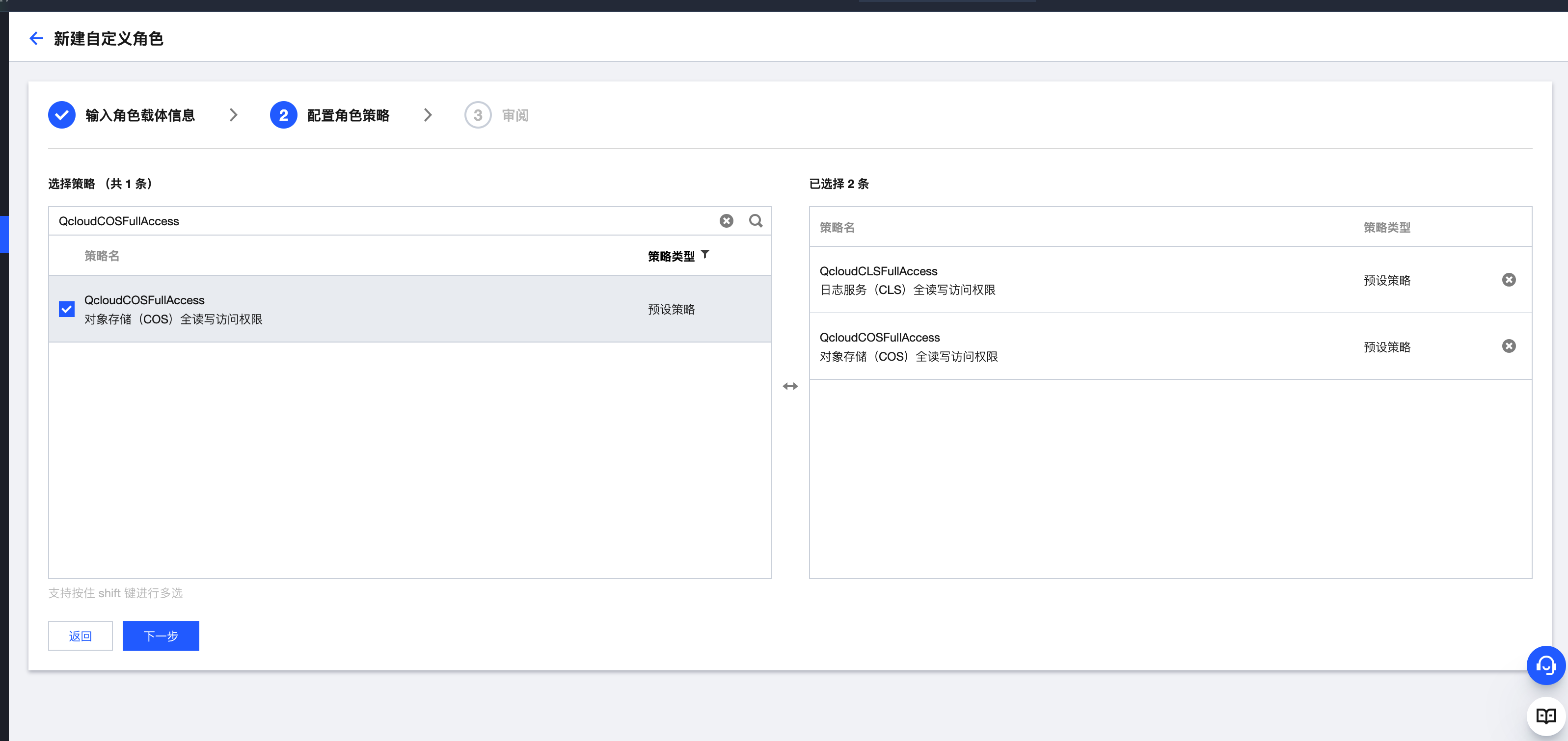

5. 配置角色策略中,按照客户需要转储的服务,选择 QcloudCLSFullAccess、QcloudCOSFullAccess 等策略后单击下一步。

6. 在审阅页面输入角色名DIP_QcsRole,描述设置为当前角色为 CKafka 中连接器的服务角色,该角色将在已关联策略的权限范围内访问您的其他云服务资源。

7. 完成后使用 CKafka 转储数据。