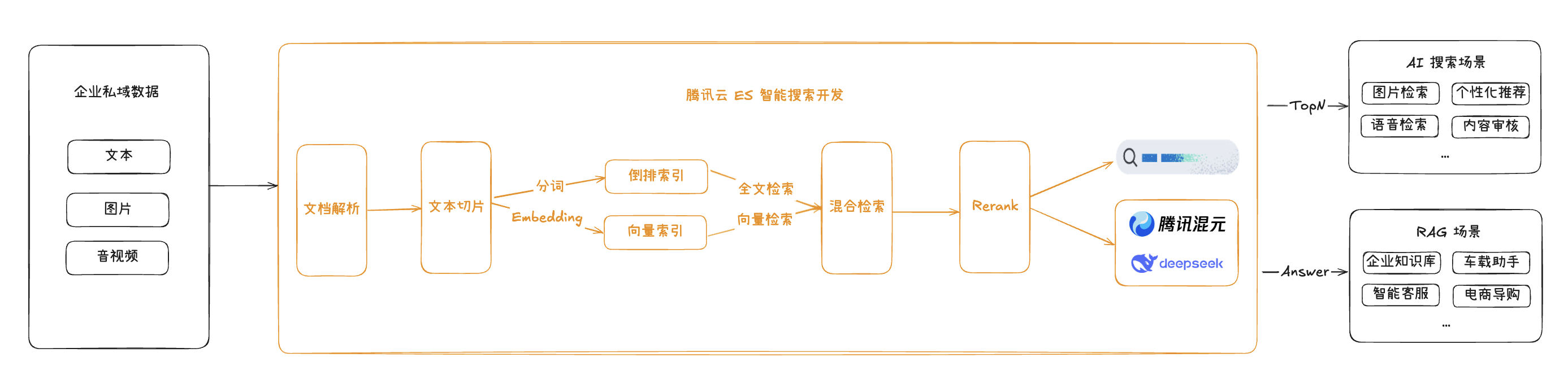

腾讯云 ES 发布的新特性智能搜索开发,进一步优化了对全文与向量混合搜索的能力支持,从原始文档解析、向量化等原子能力,到查询性能、混合排序效率、搜索结果精准度等提供了全方位的支持和优化,让搜索有了更多想象空间。 在此基础上,还可以与混元、DeepSeek 等大语言模型无缝集成,从而帮助企业进一步高效、灵活地构建知识问答等 RAG 应用,在关键环节也可介入调优,整体流程如下:

原子服务

目前智能搜索开发提供以下类型的原子服务:

类型 | 描述 | 服务 | 说明 | 接口 |

文档解析 | 本服务可将 PDF、DOC、PPT、XLS、HTML、TXT、PNG 等多格式文档转换为标准格式,满足企业级知识库建设、技术文档迁移、内容平台结构化存储等需求。 | doc-llm | 腾讯优图实验室推出的精品OCR大模型,覆盖论文、书籍、说明书、试卷、PPT、海报等众多场景,可满足各行业的文档处理需求。 | 实时文档解析ParseDocument 文档解析(异步)ParseDocumentAsync 获取文档解析结果 |

文本切片 | 文本切片是将长文本分割为短片段的技术,用于适配模型输入、提升处理效率或信息检索,平衡片段长度与语义连贯性,适用于 NLP、数据分析等场景,本服务支持语义切分。 | doc-chunk | 基于分隔符、文本长度进行切片,适用规则性较强的文本,仅支持Markdown与TXT格式文件输入。 | 在线文本切片 |

| | doc-tree-chunk | 腾讯自研文档拆分模型,支持多种文件类型,能够解析并深入理解图表中的信息,语义切分成文本块。 | 文档切片(异步) 获取文档切片结果 |

Embedding | 将文本、图片等多模态数据转化为稠密或稀疏的向量形式的服务,支持多款不同语言、输入长度、维度的文本向量模型,可用于信息检索、分类和相似性比较等场景。 | 768 维,最大 512 token 经典轻量级中文 Embedding 模型,适合资源有限、轻量级 RAG。 | 获取特征向量 | |

| | 896 维,最大 131072 token 微信自研多语言模型,支持多语言。 | | |

| | 1024 维,最大 8194 token 经典 Bge Embedding 模型,支持 100+ 语言,适合多语言检索场景。 | | |

| | 1792 维,最大 512 token 腾讯内部自研,曾登顶中文CMTEB榜单,适合高精度中文检索。 | | |

| | WeCLIPv2-Base | 768维,最大 72 token 微信自研图文 Embedding 模型,在中文场景下表现优秀,适合文搜图、图搜图等场景 | 获取多模态特征向量 |

| | WeCLIPv2-Large | | |

重排序 | 在 RAG 场景中,可通过 RAG 排序服务找到相关性更高的内容,引入排序服务可有效提升检索和大模型生成准确率,同时减少大模型成本。 | 单个 doc 最大 514 token 经典 Bge 重排序模型,通过交叉编码提升Top-K结果相关性,支持中文、英文,适合检索结果精排后进行问答。 | 重排序 | |

| | 单个 doc 最大 8192 token 升级版 Bge 重排模型,有更大的文本长度,同时支持多语言。 | | |

大模型生成 | 本服务支持一系列高性能的大语言模型,包括 DeepSeek 系列和自主研发的混元大模型,通过深度优化和精确训练,目前已具备强大的自然语言处理能力和高效的文本理解能力,结合混合搜索等先进搜索技术,快速高效实现 RAG,有效解决幻觉和知识更新问题。 | 最大输入 128k,最大输出 8k 擅长复杂需求拆解、技术方案直译,提供精准结构化分析及可落地方案,实现了与GPT-4o和Claude Sonnet 3.5等模型相媲美的性能。 | 大模型生成 | |

| | 最大输入 128k,最大输出 8k 通用型AI模型,拥有庞大参数规模及强大多任务泛化能力,擅长开放域对话、知识问答、创意生成等多样化需求。 | | |

| | 最大输入 128k,最大输出 8k deepseek-r1 32b 参数蒸馏模型,使用成本更低,性价比较高。 | | |

| | hunyuan-turbo | 最大输入 28k,最大输出 4k 腾讯新一代旗舰大模型,混元Turbo模型,在语言理解、文本创作、数学、推理和代码等领域都有较大提升,具备强大的知识问答能力。 | |

| | hunyuan-large | 最大输入 28k,最大输出 4k 腾讯开发的开源业界参数规模最大、效果最好的 transformer 结构的 MoE 模型,适用对模型效果、复杂指令有较高的要求的场景。 | |

| | hunyuan-large-longcontext | 最大输入 128k,最大输出 6k 擅长处理长文任务如文档摘要和文档问答等,同时也具备处理通用文本生成任务的能力。在长文本的分析和生成上表现优异,能有效应对复杂和详尽的长文内容处理需求。 | |

| | hunyuan-standard | 最大输入 30k,最大输出 2k 在通用效果提升的基础上,训练数据中融合了医疗、金融领域的长文数据、长文翻译数据和长文多文档问答等高质量精标数据。 | |

| | hunyuan-standard-256K | 最大输入 250k,最大输出 6k 256k极长窗口特化版,复用7B-MoE框架压缩显存占用,支持百页文献级处理,适用绝大部分场景,同时兼顾效果及推理性能。 | |

联网搜索 | 整合 Sogou、Bing 以及 Baidu 联网搜索,涵盖网页、新闻、学术论文等多源数据,支持指定域名搜索,旨在提供高质量的公共互联网信息,突破本地数据局限。 | sogou | 本服务基于原搜狗网页 3.0 版本提供稳定的联网搜索服务,曾为全球首个网页收录量达到 100亿的中文搜索引擎。 | - |

| | bing | 微软旗下多语言搜索引擎,实时新闻索引(1小时内更新),学术资源整合能力强。 | 本服务为第三方服务厂商提供,受限于第三方服务,目前已暂时关停,原服务自动切到sogou。 |

| | baidu | 全球最大中文搜索引擎,在字词结合的中文处理技术上具有深厚积累。 | 本服务为第三方服务厂商提供,受限于第三方服务,目前已暂时关停,原服务自动切到sogou。 |

应用场景

文本搜索:依托倒排索引与分词优化,腾讯云 ES 支持亿级数据毫秒级检索,具备拼写纠错、同义词扩展及高亮显示功能,广泛应用于电商商品搜索、新闻推荐等场景,精准匹配用户查询意图。

多模态搜索:提供多模态数据向量化服务,结合腾讯云ES的混合搜索能力,支持文本、图像等混合数据等联合检索,如图搜图、文搜图、文搜视频等场景,突破单一模态限制。

知识库问答:通过自然语言处理与语义分析,快速匹配用户问题与知识库内容,将用户问题与检索的内容交给大模型进行总结生成,适用于企业FAQ、客户机器人等场景,实现高效知识检索与精准答案推送。

AI 助手:为 AI 助手提供实时知识库检索和对话上下文管理,通过搜索增强与多轮对话支持,提升虚拟助手、智能客服等应答能力。

优势特性

文本/向量混合搜索:独有文本与向量的混合搜索能力,支持多模态数据联合检索,通过倒排索引优化与向量算法扩展,实现复杂场景下的精准匹配与召回扩大。

开放的原子服务:提供文档解析、文本切片、Embedding、Rerank、LLM 生成以及联网搜索原子服务,集成 ES Inference API,降低 RAG、AI 搜索应用等开发门槛。

灵活搭建AI应用:高度灵活的写入/检索工作流自定义能力,支持调用内置原子服务和自定义服务,快速构建智能问答、AI 搜索等场景。

高性能与稳定性:千亿级向量规模支持,毫秒级响应延迟,自研存储优化节省 70%-90% 资源,结合分布式架构与多可用区容灾,保障高并发场景稳定运行。

权威认证:作为国内首个端到端 RAG 技术标准制定者和测评通过者(信通院认证),腾讯云 ES 过去一年已助力微信读书 AI 问书、ima、腾讯会议智能助手等顶流应用落地。