前提条件

创建作业

开发 Python 作业

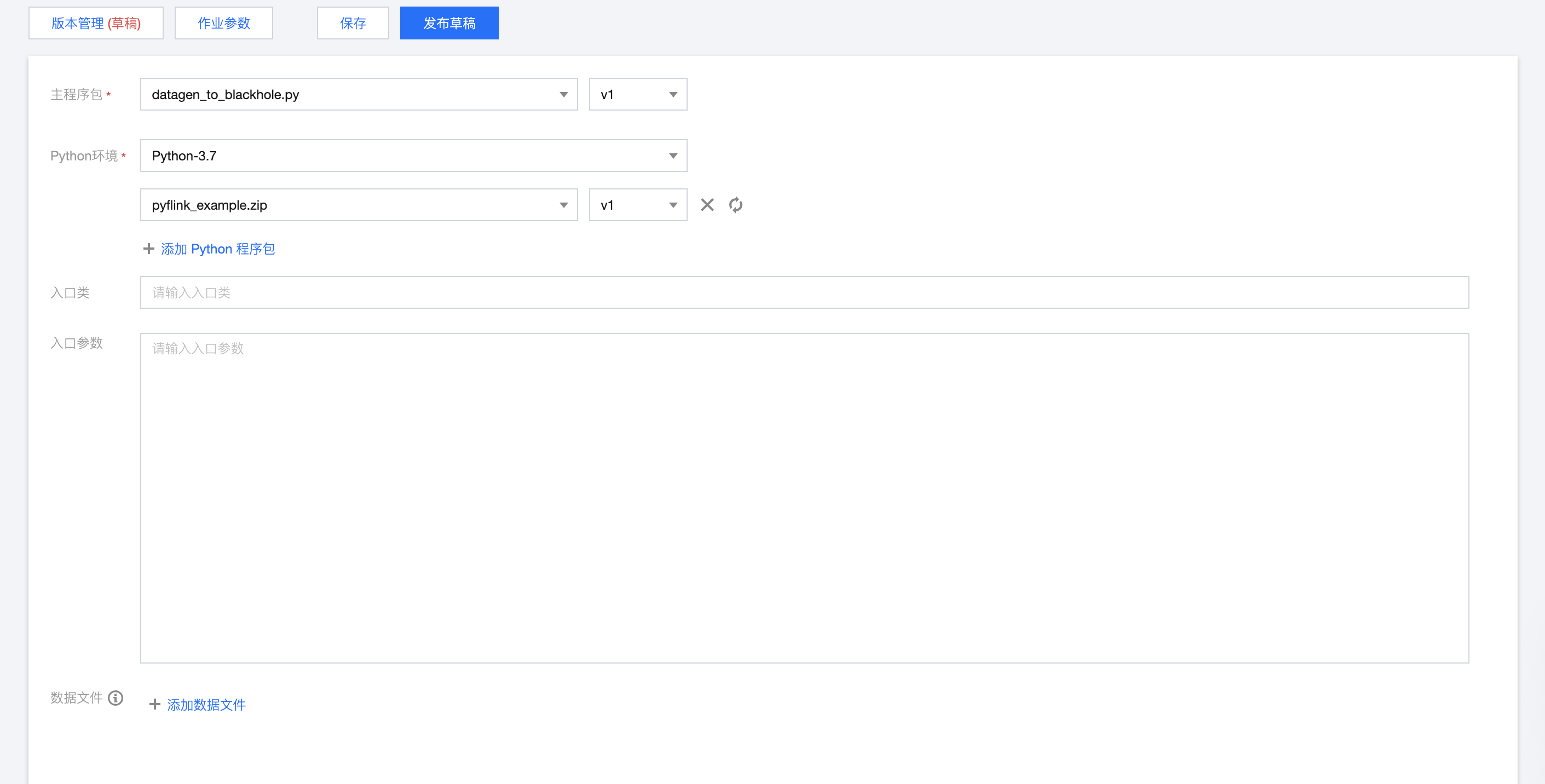

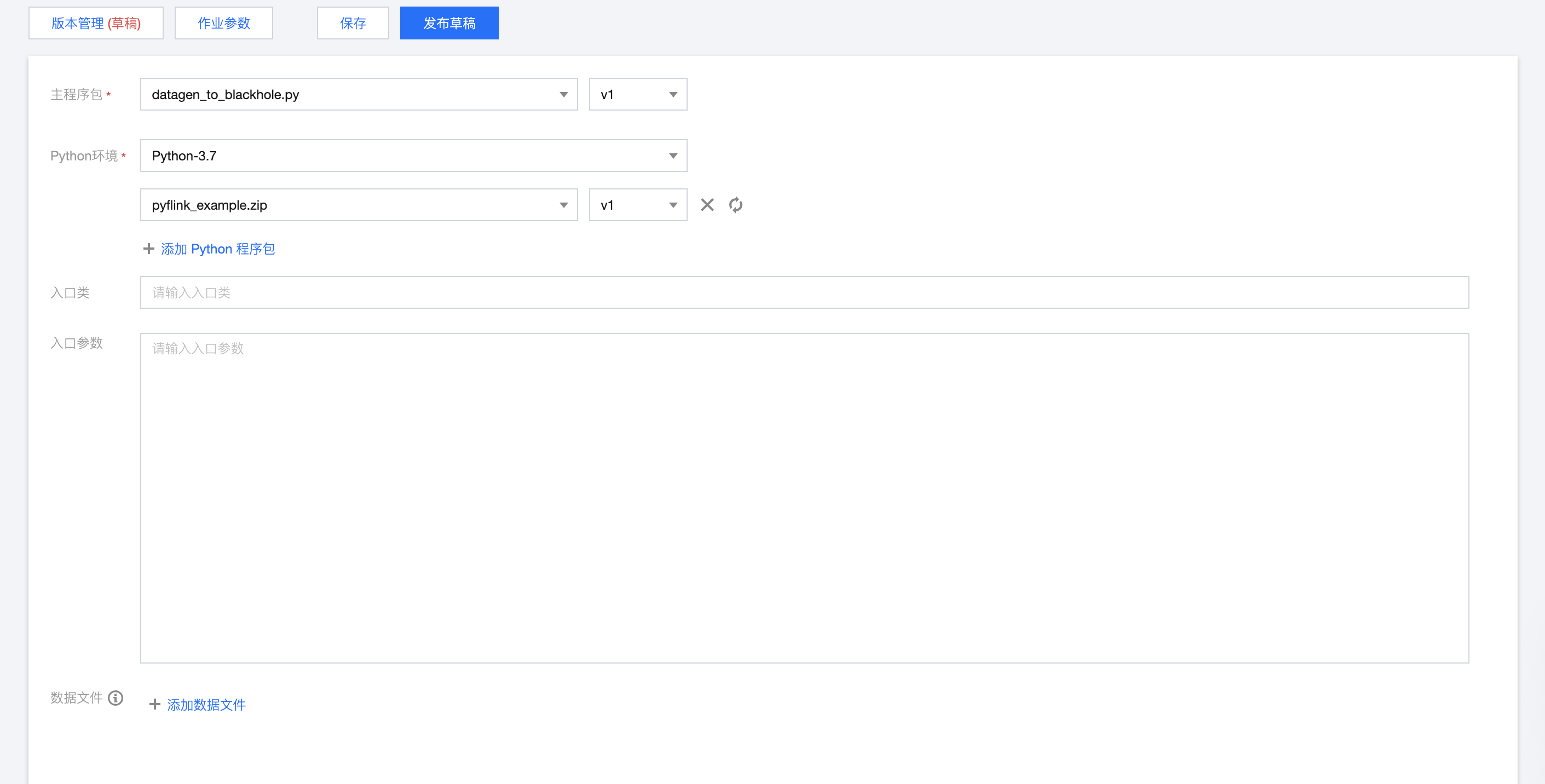

Python 作业的开发页面如下所示:

在开发调试页面,选择主程序包及其版本,并输入入口类和入口类参数,选择好平台提供的 Python 环境,单击作业参数并在侧边弹出的参数界面中设置参数值,然后单击保存,保存作业配置和参数信息。

主程序包可以是单独的 Python 文件或者是 Zip 程序包。如果主程序包为 Python 文件,则入口类不需要填写;主程序包为 Zip,则需要指定其入口类。

数据文件会被解压到 Python worker 进程的工作目录下。如果数据文件所在的压缩包名称为 archive.zip,则在 Python 自定义函数中可以编写以下代码来访问 archive.zip 数据文件。

def my_udf():with open("archive.zip/mydata/data.txt") as f:...

使用限制

目前流计算 Oceanus 支持运行基于开源 Flink 1.13、Flink 1.16 开发的 Python 作业,且预装了 Python 3.7 版本的环境。业务代码开发指南请参见 Flink 社区官方文档:Flink Python API 开发指南。

作业参数

作业参数可以在开发调试页面中单击作业参数,并在侧边弹出的参数界面中设置参数值,然后单击确定,保存作业参数信息。下文会有各参数的详细介绍说明,以帮助您更好地配置各作业参数。

内置 Connector

由系统提供可让用户选择的 Connector。例如,在 Python 作业中需要使用来自 Ckafka 的数据流,则必须要在此处选择 Ckafka 相应的 Connector。内置 Connector 的使用说明可参考 上下游开发指南。

运行日志采集

显示当前作业的运行日志采集配置,默认为采集到集群绑定的默认日志服务。作业的运行日志将自动采集到作业所在的集群绑定的日志集和日志主题,可在日志页面中查看。

高级参数

规格配置

算子默认并行度

当没有在 JAR 包中通过代码显式定义算子并行度时,作业将采用用户指定的算子默认并行度。并行度与 TaskManager 规格大小决定作业所占用的计算资源。1 个并行度将占用 1 个 TaskManager 规格大小的CU 计算资源(当 TaskManager 规格大小为 1 时,1 个并行度将占用 1 CU 计算资源。当 TaskManager 规格大小为 0.5时,1个并行度将占用 0.5 CU 计算资源)。

从快照恢复作业

作业运行时,支持从历史快照恢复。运行作业时,提示如下:

对于没有历史快照的作业,无法使用历史快照运行。