关注我们,一起学习~

标题:Transfer Learning on Heterogeneous Feature Spaces for Treatment Effects Estimation

地址:https://arxiv.org/pdf/2210.06183.pdf

代码:https://github.com/vanderschaarlab;https://github.com/ioanabica/HTCE-learners

会议:NIPS 2022

学校:牛津,剑桥,加州大学洛杉矶分校,图灵研究所

1. 导读

本文考虑通过利用来自具有不同特征空间的源域的相关信息来改进对感兴趣的目标域的条件平均干预效果(CATE)的估计的问题。这种用于CATE估计的异质迁移学习问题在诸如医疗保健等领域普遍存在,希望在这些领域评估新患者群体治疗的有效性,而对于这些患者群体,数据是有限的。在本文中,通过引入模块来解决这个问题,这些模块使用表征学习来处理异构特征空间,以及具有共享和私有层的灵活多任务架构来跨域在潜在结果函数之间传递信息。

文中提出了一个模块,该模块可用于在源域和目标域之间迁移信息,该模块有三种结合方式分别和现有的因果效应估计方式相对应,分别是单步,两步以及域内。单步即考虑的是slearner,tlearner这种;两步考虑的是类似于DML,DRL这些需要两步计算的方式;域内是类似于TARNet,CFRNet这种直接在一个模型中计算的方式。

2. 问题构建

令随机变量为

X_i \in \mathcal{X},

W_i \in \{0, 1\}表示干预,

Y_i表示离散的或连续的效果。令

\pi(x)=p(W=1|X=x)表示干预机制。不同个体可以有两种输出,即干预和不干预情况下的效果

Y_i(0),Y_i(1),可以整体表示为

Y_i=W_iY_i(1)+(1-W_i)Y_i(0)。令

\mu_1(x)=\mathbb{E}[Y(1)|X=x],

\mu_0=\mathbb{E}[Y(0)|X=x]。我们的目标是估计CATE,公式如下,

\tau(x)=\mathbb{E}[Y(1)-Y(0) \mid X=x]=\mu_{1}(x)-\mu_{0}(x)

假设源数据集为

\mathcal{D}^{R}=\{(X_i^R,W_i,Y_i)\}_{i=1}^{N_R},目标数据集为

\mathcal{D}^{T}=\{(X_i^T,W_i,Y_i)\}_{i=1}^{N_T},不同域的数据具有不同的特征空间

X_i^R\in \mathbb{R}^{D_R},

X_i^T\in \mathbb{R}^{D_T}。并且源域和目标域具有不同的分布

p(X^R) \neq p(X^T),不同的干预分配机制

p(W=1|X^R) \neq p(W=1|X^T),以及不同的条件分布

p(Y(w)|X^R) \neq p(Y(w)|X^T)。这导致了不同的联合分布

p(X^R,W,Y) \neq p(X^T,W,Y)。尽管如此,本文隐含地假设跨域的这些条件分布之间存在共享结构,以实现迁移。目标是估计目标域的条件平均干预效果(CATE):

\tau^T(x)=\mu^T_{1}(x^T)-\mu^T_{0}(x^T)

3. 为CATE迁移学习器构建模块

在本节中,提出了为CATE学习器提供灵活迁移方法的模块。有三方面挑战,

- (1)处理源域和目标域之间的异构特征空间

- (2)在跨域间共享信息

- (3)在单个域内共享信息

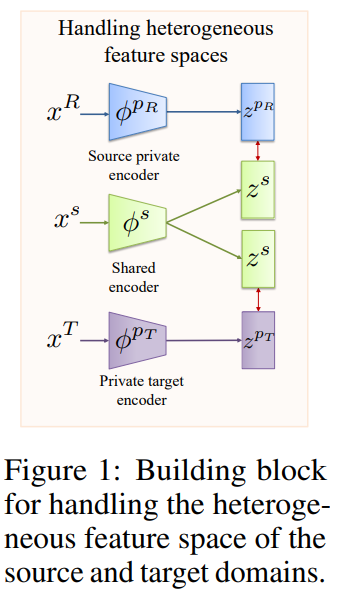

3.1 处理源域和目标域的异构特征空间

考虑以下源域和目标域协变量

X^R=(X^s,X^{p_R}),

X^T=(X^s,X^{p_T})的拆分,这样就有了一组特征专用于自己源域和目标域

X^{p_R} \in \mathbb{R}^{D_{p_R}},

X^{p_T} \in \mathbb{R}^{D_{p_T}}和一组共享特征

X^s\in \mathbb{R}^{D_S},使用几个编码器来创建一个通用表征,该表征可以用作不同迁移CATE学习器的输入。

令

\phi^{p_{R}}\left(x^{R}\right): \mathbb{R}^{D_{R}} \rightarrow \mathbb{R}^{D_{p}} ,\phi^{p_{T}}\left(x^{T}\right): \mathbb{R}^{D_{T}} \rightarrow \mathbb{R}^{D_{p}}特定域的编码器,将特征映射到相同维度,即

\phi^{p_{T}}\left(x^{T}\right)=z^{p_{T}}, \phi^{p_{R}}\left(x^{R}\right)=z^{p_{R}} .。令

\phi^{s}\left(x^{s}\right): \mathbb{R}^{D_{S}} \rightarrow \mathbb{R}^{D_{s}}为共享特征编码器,表示为

\phi^{s}\left(x^{s}\right)=z^{s}。

如图1所示,源域的特征

x^R被编码为

[z^s\|z^{p_R}],目标域特征

x^T被编码为

[z^s\|z^{P_T}]。为了抑制冗余并确保

z=^p,z^s编码出输入特征中的不同信息,作者使用正则化损失来增强它们的正交性,公式如下,其中

\zeta表示不同的表征矩阵,矩阵的行为一个样本表征。

\mathcal{L}_{\mathrm{orth}_{z}}=\left\|\zeta^{s \top} \zeta^{p_{R}}\right\|_{F}^{2}+\left\|\zeta^{s \top} \zeta^{p_{T}}\right\|_{F}^{2}

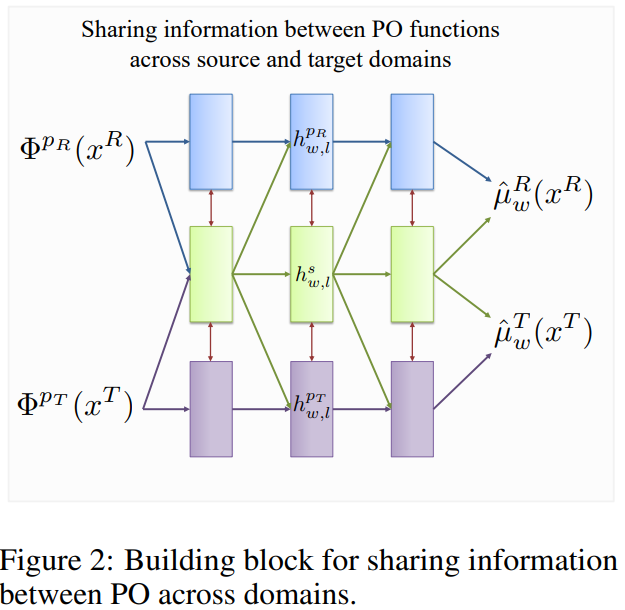

2.2 跨域潜在效果响应函数中的共享信息

本节提出了一种跨域函数之间共享信息的模块,受到FlexTENet架构和多任务学习的启发,包含每个域的私有层(子空间)以及共享层。

如图2所示,对于每个干预

w\in \{0,1\},都构建一个如上图的结构,源域和目标域包含L层,然后有共享信息和特定域的信息,即三个分支。第

l+1层的输入为

\tilde{h}_{w,l+1}^{p_R}=[h_{w,l}^s\|h_{w,l}^{p_R}],

\tilde{h}_{w,l+1}^{p_T}=[h_{w,l}^s\|h_{w,l}^{p_T}],

\tilde{h}_{w,l+1}^{s}=[h_{w,l}^s],经过L层后可以得到最终的输出。

令

g^R_w,

g^T_w分别为源域和目标域中预测潜在效果的函数,

g_w^R(\Phi^R(x^R))=\psi(h_{w,L}^{p_R}+h_{w,L}^s),

g_w^T(\Phi^T(x^T))=\psi(h_{w,L}^{p_T}+h_{w,L}^s)。其中

\Phi为输入表征,以目标域为例

\Phi^R(x^R)=[z^s\|z^{p_R}],

\psi为线性函数和sigmoid函数。损失函数构建为下式,

\mathcal{L}_{y}=\sum_{i=1}^{N_{R}} l\left(y_{i}, g_{w_{i}}^{R}\left(\Phi_{w_{i}}^{R}\left(x_{i}^{R}\right)\right)\right)+\sum_{i=1}^{N_{T}} l\left(y_{i}, g_{w_{i}}^{T}\left(\Phi_{w_{i}}^{T}\left(x_{i}^{T}\right)\right)\right)

并且可以构建正交损失函数为下式,其中m为每一层对应表征矩阵的维度,θ为参数。

\mathcal{L}_{\text {orthpo }}=\sum_{w \in\{0,1\}} \sum_{l=1}^{L}\left\|\theta_{w, l}^{s} \theta_{w, l, 1: m_{l-1}^{s}}^{p_{R}}\right\|_{F}^{2}+\left\|\theta_{w, l}^{s} \theta_{w, l, 1: m_{w, l-1}^{s}}^{p_{T}}\right\|_{F}^{2}

3. 异构迁移因果效应学习器

基于上面提出的模块,现在为标准meta learner和基于神经网络(NN)的CATE估计器提出了一种迁移学习替代方案,称之为异构迁移因果效应(HTCE)学习器。

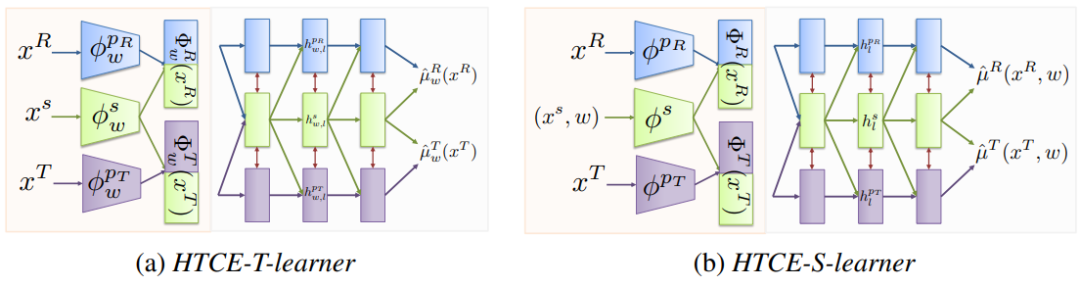

3.1 对于meta learner

基于现有的因果效应估计方式,可以将实现方式分为单步和两步两种。

3.1.1 单步

单步的方式,估计

\hat{\mu}_1和

\hat{\mu}_0,然后计算CATE为

\tau(x)=\hat{\mu}_1(x) - \hat{\mu}_0(x)。

对于HTCE-T-Learner(图3a),构建一个模型,其中

(g_0^R,g_1^R)和

(g_0^T,g_1^T)之间没有参数共享。考虑异质特征空间的特定干预的编码器

\phi_w^{p_R},

\phi_w^{p_T},

\phi_w^{s},然后可以得到相应的表征

\Phi_w^R(x^R)=[\phi_w^s(x^s)\| \phi_w^{p_R}(x^R)],

\Phi_w^T(x^T)=[\phi_w^s(x^s)\| \phi_w^{p_T}(x^T)],预测函数表示为

\left(g_{1}^{R}\left(\Phi_{1}^{R}\left(x^{R}\right)\right), g_{1}^{T}\left(\Phi_{1}^{T}\left(x^{T}\right)\right)\right),

\left(g_{0}^{R}\left(\Phi_{0}^{R}\left(x^{R}\right)\right), g_{0}^{T}\left(\Phi_{0}^{T}\left(x^{T}\right)\right)\right)。为了实现迁移,使用2.2中的模块进行信息共享。对于HTCE-S-Learner(图3b),将干预w拼接到共享输入特征

x^s。这部分得到的表征为

\Phi^R(x^R,w)=[\phi^s(x^s,w)\| \phi^{p_R}(x^{p_R})],

\Phi^T(x^T,w)=[\phi^s(x^s,w)\| \phi^{p_T}(x^{p_T})]。

3.1.2 两步

两步学习器由第一阶段和第二阶段组成,第一阶段用于估计伪结果。如DRL,DML等。这里以DRL为例,构建HTCE-DR-Learner(图4)。对于估计第一阶段的参数,使用了一种类似于HTCE-T-learner的方法,其中每个分支都有自己的参数。为了处理异质特征空间,考虑了潜在结果函数的特定干预的特征编码器

\phi_w^{p_R},\phi_w^{p_T},\phi_w^{s}和用于倾向估计的特征编码器

\phi_{\pi}^{p_R},\phi_{\pi}^{p_T},\phi_{\pi}^{s},从而得到

\Phi^R_w(x^R)=[\phi_w^s(x^s)\|\phi_w^{p_R}(x^R)],

\Phi^T_w(x^T)=[\phi_w^s(x^s)\|\phi_w^{p_T}(x^T)],

\Phi^R_{\pi}(x^R)=[\phi_{\pi}^s(x^s)\|\phi_{\pi}^{p_R}(x^R)],

\Phi^T_{\pi}(x^T)=[\phi_{\pi}^s(x^s)\|\phi_{\pi}^{p_T}(x^T)]。同样结合前面的共享参数的模块,可以得到

(g_w^R(\Phi_w^R(x^R)),g_w^T(\Phi_w^T(x^T))),

(g_{\pi}^R(\Phi_{\pi}^R(x^R)),g_{\pi}^T(\Phi_{\pi}^T(x^T)))。从而基于第一步来得到伪输出

\hat{Y}_{DR,\hat{\eta}},公式如下,

\tilde{Y}_{D R, \eta}=\left(\frac{W}{\hat{\pi}(x)}-\frac{1-W}{1-\hat{\pi}(x)}\right) Y+\left[\left(1-\frac{W}{\hat{\pi}(x)}\right) \hat{\mu}_{1}(x)-\left(1-\frac{1-W}{1-\hat{\pi}(x)}\right) \hat{\mu}_{0}(x)\right]

第二阶段基于伪输出来拟合,也是同样类似的过程,这里不赘述。

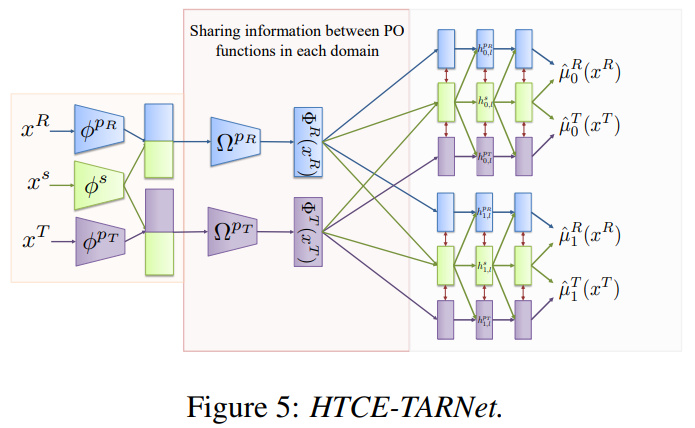

3.2 域内共享信息

这种类型以TARNet为例,这里设计三个编码器

\phi^{p_R},\phi^{s},\phi^{p_T},在不同域的不同干预中共享信息。然后,构建另一个模块,该模块使用多层神经网络表示特定于域的编码器

\Omega^{p_T},

\Omega^{p_R}。这些特定于域的表征层用于共享信息。然后可以得到

\Phi^{R}\left(x^{R}\right)=\Omega^{p_{R}}\left(\left[\phi^{S}\left(x^{s}\right) \| \phi^{p_{R}}\left(x^{R}\right)\right]\right),

\Phi^{T}\left(x^{T}\right)=\Omega^{p_{T}}\left(\left[\phi^{S}\left(x^{s}\right) \| \phi^{p_{T}}\left(x^{T}\right)\right]\right)

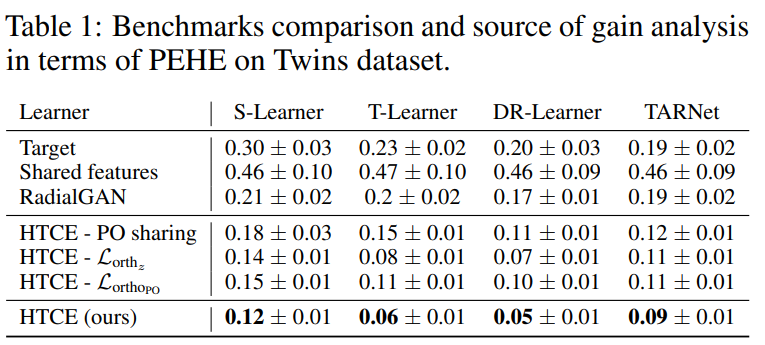

4. 结果